Utilizza spark-bigquery-connector

con Apache Spark

per leggere e scrivere dati da e in BigQuery.

Questo tutorial mostra un'applicazione PySpark che utilizza

spark-bigquery-connector.

Utilizzare il connettore BigQuery con il tuo workload

Consulta Versioni di runtime di Serverless per Apache Spark per determinare la versione del connettore BigQuery installata nella versione di runtime del workload batch. Se il connettore non è elencato, consulta la sezione successiva per istruzioni su come renderlo disponibile per le applicazioni.

Come utilizzare il connettore con la versione 2.0 di Spark Runtime

Il connettore BigQuery non è installato nella versione 2.0 di Spark Runtime. Quando utilizzi Spark runtime versione 2.0, puoi rendere disponibile il connettore per la tua applicazione in uno dei seguenti modi:

- Utilizza il parametro

jarsper indicare un file JAR del connettore quando invii il carico di lavoro batch di Google Cloud Serverless per Apache Spark. L'esempio seguente specifica un file JAR del connettore (per un elenco dei file JAR del connettore disponibili, consulta il repository GoogleCloudDataproc/spark-bigquery-connector su GitHub).- Esempio di Google Cloud CLI:

gcloud dataproc batches submit pyspark \ --region=region \ --jars=gs://spark-lib/bigquery/spark-bigquery-with-dependencies_2.13-version.jar \ ... other args

- Esempio di Google Cloud CLI:

- Includi il file JAR del connettore nell'applicazione Spark come dipendenza (vedi Compilazione rispetto al connettore)

Calcola i costi

Questo tutorial utilizza componenti fatturabili di Google Cloud, tra cui:

- Serverless per Apache Spark

- BigQuery

- Cloud Storage

Utilizza il Calcolatore prezzi per generare una stima dei costi in base all'utilizzo previsto.

BigQuery I/O

Questo esempio legge i dati da BigQuery in un DataFrame Spark per eseguire un conteggio delle parole utilizzando l'API dell'origine dati standard.

Il connettore scrive l'output di conteggio delle parole in BigQuery nel seguente modo:

Memorizzazione nel buffer dei dati in file temporanei nel bucket Cloud Storage

Copia dei dati in un'unica operazione dal bucket Cloud Storage in BigQuery

Eliminazione dei file temporanei in Cloud Storage dopo il completamento dell'operazione di caricamento BigQuery (i file temporanei vengono eliminati anche dopo la chiusura dell'applicazione Spark). Se l'eliminazione non va a buon fine, dovrai eliminare eventuali file Cloud Storage temporanei indesiderati, che in genere si trovano in

gs://YOUR_BUCKET/.spark-bigquery-JOB_ID-UUID.

Configura la fatturazione

Per impostazione predefinita, il progetto associato alle credenziali o al account di servizio viene fatturato per l'utilizzo dell'API. Per fatturare un progetto diverso, imposta la seguente

configurazione: spark.conf.set("parentProject", "<BILLED-GCP-PROJECT>").

Puoi anche aggiungere un'operazione di lettura o scrittura, come segue:

.option("parentProject", "<BILLED-GCP-PROJECT>").

Invia un carico di lavoro batch di conteggio parole PySpark

Esegui un workload batch Spark che conta il numero di parole in un set di dati pubblico.

- Apri un terminale locale o Cloud Shell.

- Crea

wordcount_datasetcon lo strumento a riga di comando bq in un terminale locale o in Cloud Shell.bq mk wordcount_dataset

- Crea un bucket Cloud Storage con

Google Cloud CLI.

gcloud storage buckets create gs://YOUR_BUCKET

YOUR_BUCKETcon il nome del bucket Cloud Storage che hai creato. - Crea il file

wordcount.pylocalmente in un editor di testo copiando il seguente codice PySpark.#!/usr/bin/python """BigQuery I/O PySpark example.""" from pyspark.sql import SparkSession spark = SparkSession \ .builder \ .appName('spark-bigquery-demo') \ .getOrCreate() # Use the Cloud Storage bucket for temporary BigQuery export data used # by the connector. bucket = "YOUR_BUCKET" spark.conf.set('temporaryGcsBucket', bucket) # Load data from BigQuery. words = spark.read.format('bigquery') \ .option('table', 'bigquery-public-data:samples.shakespeare') \ .load() words.createOrReplaceTempView('words') # Perform word count. word_count = spark.sql( 'SELECT word, SUM(word_count) AS word_count FROM words GROUP BY word') word_count.show() word_count.printSchema() # Saving the data to BigQuery word_count.write.format('bigquery') \ .option('table', 'wordcount_dataset.wordcount_output') \ .save()

- Invia il carico di lavoro batch PySpark:

gcloud dataproc batches submit pyspark wordcount.py \ --region=REGION \ --deps-bucket=YOUR_BUCKET

... +---------+----------+ | word|word_count| +---------+----------+ | XVII| 2| | spoil| 28| | Drink| 7| |forgetful| 5| | Cannot| 46| | cures| 10| | harder| 13| | tresses| 3| | few| 62| | steel'd| 5| | tripping| 7| | travel| 35| | ransom| 55| | hope| 366| | By| 816| | some| 1169| | those| 508| | still| 567| | art| 893| | feign| 10| +---------+----------+ only showing top 20 rows root |-- word: string (nullable = false) |-- word_count: long (nullable = true)

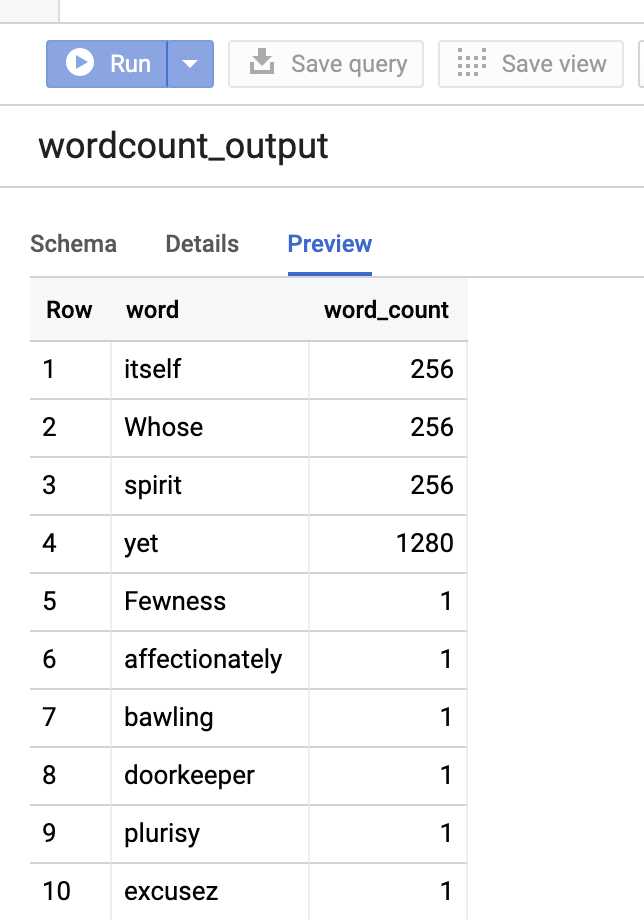

Per visualizzare l'anteprima della tabella di output nella console Google Cloud , apri la pagina BigQuery del tuo progetto, seleziona la tabellawordcount_outpute poi fai clic su Anteprima.

Per ulteriori informazioni

- BigQuery Storage e Spark SQL - Python

- Creare un file di definizione della tabella per un'origine dati esterna

- Utilizzare dati partizionati esternamente