Questa pagina mostra come risolvere i problemi relativi al networking di Dataflow.

Per ulteriori informazioni sulla configurazione del networking per i job Dataflow, consulta Configurare l'accesso a internet e le regole firewall e Specificare una rete e una subnet.

Impossibile creare PoolableConnectionFactory

Si verifica il seguente errore quando il job Dataflow deve connettersi a un database esterno:

java.sql.SQLException: Cannot create PoolableConnectionFactory

(The connection attempt failed.)

Questo problema si verifica quando il worker Dataflow non riesce a stabilire una connessione con il server di database, spesso a causa di una regola di uscita o di un firewall.

Per identificare la causa principale del problema, crea ed esegui test di connettività. I test di connettività possono aiutarti a identificare dove viene bloccato il traffico.

Per aggiornare le regole di uscita, vedi Regola di uscita firewall di esempio.

Timeout della connessione quando si utilizza Cloud NAT

Il seguente errore può verificarsi quando il job Dataflow tenta di connettersi a un servizio esterno tramite un gateway Cloud NAT:

java.net.ConnectTimeoutException: Connection timed out

Questo problema può verificarsi se il job Dataflow è configurato per utilizzare indirizzi IP esterni quando la rete è configurata anche per utilizzare Cloud NAT per il traffico in uscita. Quando i worker Dataflow hanno indirizzi IP esterni, tentano di instradare il traffico a internet direttamente anziché tramite il gateway Cloud NAT, il che può causare timeout della connessione se le regole firewall impediscono questo accesso diretto.

Per risolvere il problema, configura i worker Dataflow in modo che non utilizzino indirizzi IP esterni. Questa configurazione consente di assicurarsi che il traffico in uscita venga instradato tramite il gateway Cloud NAT configurato. Per saperne di più, consulta la documentazione di Cloud NAT.

Per informazioni su come disattivare gli indirizzi IP esterni, consulta Configura l'accesso a internet e le regole firewall.

I riferimenti tra progetti per questa risorsa non sono consentiti

Si verifica il seguente errore quando esegui un job Dataflow su una rete VPC condiviso:

Invalid value for field 'resource.properties.networkInterfaces[0].subnetwork':

'https://www.googleapis.com/compute/v1/projects/PROJECT/regions/REGION/subnetworks/SUBNETWORK'.

Cross-project references for this resource are not allowed.

Questo problema si verifica se specifichi una subnet in una rete VPC condiviso, ma il progetto di servizio non è collegato al progetto host VPC condiviso.

Per risolvere il problema, un amministratore del VPC condiviso deve collegare il progetto di servizio al progetto host.

L'istanza deve trovarsi nella stessa regione della subnet

Il seguente errore si verifica quando esegui un job Dataflow con una subnet specificata:

Failed to start the VM, launcher-ID, used for launching because of status code: INVALID_ARGUMENT, reason: Invalid Error:

Message: Invalid value for field 'resource.networkInterfaces[0].subnetwork': 'https://www.googleapis.com/compute/v1/projects/PROJECT/regions/REGION/subnetworks/SUBNETWORK'. Instance must be in the same region as the subnetwork.

HTTP Code: 400.

Questo problema si verifica quando il job e la subnet specificata nel job si trovano in regioni diverse.

Per risolvere il problema, esegui il job nella regione in cui si trova la subnet.

Ad esempio, se la tua subnet si trova in us-central1, esegui il job nella regione

us-central1.

Lo spazio IP è esaurito

Quando crei un job Dataflow o attivi un'operazione di scalabilità automatica, queste operazioni potrebbero non riuscire e viene visualizzato il seguente messaggio:

IP_SPACE_EXHAUSTED: Instance 'INSTANCE_NAME' creation failed: IP space of 'projects/PROJECT/regions/REGION/subnetworks/SUBNETWORK' is exhausted.

Per risolvere questo errore, puoi provare una delle seguenti strategie:

- Riduci il numero di richieste di worker per il job Dataflow.

Puoi fornire un numero specifico di worker impostando l'opzione pipeline

num_workersoppure puoi impostare un limite superiore al numero di worker utilizzando l'opzione pipelinemax_num_workers. Per ulteriori informazioni, consulta Opzioni pipeline. - Se possibile, aumenta le dimensioni della subnet del job Dataflow. Per informazioni sull'espansione di una subnet esistente, consulta la documentazione di Virtual Private Cloud.

- Utilizza una subnet diversa con indirizzi IP disponibili sufficienti per il job Dataflow.

- Se possibile, crea una subnet dedicata con un numero sufficiente di indirizzi IP per i job Dataflow.

L'interfaccia di rete deve specificare una subnet se la risorsa di rete è in modalità subnet personalizzata

Si verifica il seguente errore quando esegui un job Dataflow:

Workflow failed. Causes: Invalid Error: Message: Invalid value for field

'resource.properties.networkInterfaces[0].subnetwork': ''. Network interface

must specify a subnet if the network resource is in custom subnet mode. HTTP

Code: 400

Questo problema si verifica se la rete VPC denominata default è stata

convertita da una rete VPC in modalità automatica a una rete VPC in modalità personalizzata.

Per risolvere il problema, specifica il parametro della subnet quando utilizzi una rete VPC in modalità personalizzata. Per ulteriori informazioni, vedi Specificare una rete e una subnet.

La rete non è raggiungibile

Si verifica il seguente errore quando gli indirizzi IP esterni sono disattivati e tenti di eseguire un job Dataflow:

NewConnectionError(''<pip._vendor.urllib3.connection.HTTPSConnection object at ID>:

Failed to establish a new connection: [Errno 101] Network is unreachable

Questo problema si verifica perché la configurazione della pipeline non consente connessioni a indirizzi IP esterni, ma la pipeline deve connettersi a un IP esterno per essere eseguita. Le seguenti opzioni della pipeline disabilitano le connessioni IP esterne:

Java

--usePublicIps=false

Python

--no_use_public_ips=true

Vai

--no_use_public_ips=true

API

options = PipelineOptions(use_public_ips=False)

Per identificare dove viene bloccato il traffico, crea ed esegui test di connettività.

Per risolvere il problema senza consentire connessioni a indirizzi IP esterni, apporta una o più delle seguenti modifiche.

- Configura una soluzione NAT, ad esempio Cloud NAT.

- Configura l'accesso privato Google.

- Se non riesci a configurare una soluzione NAT, puoi utilizzare container personalizzati per fornire le dipendenze della pipeline Python.

Per ulteriori informazioni sulla configurazione dell'accesso a internet per Dataflow, consulta Accesso a internet per Dataflow.

La rete o la subnet non è accessibile al account di servizio Dataflow o non esiste

Si verifica uno dei seguenti errori quando tenti di eseguire un job Dataflow. Il job non riesce.

Workflow failed. Causes: Network default is not accessible to Dataflow Service

account or does not exist

Workflow failed. Causes: Subnetwork SUBNETWORK is not

accessible to Dataflow Service account or does not exist

Il problema può verificarsi per i seguenti motivi:

- Ometti i parametri di subnet e rete quando crei il job Dataflow, ma nel tuo progetto non esiste una rete VPC in modalità automatica denominata

default. Potresti non avere una rete predefinita se è stata eliminata o se un vincolo dei criteri dell'organizzazione ti impedisce di crearne una. - La subnet non è presente.

- Il parametro della subnet è specificato in modo errato.

- Le autorizzazioni richieste per il account di servizio Dataflow non sono presenti.

- Se utilizzi un VPC condiviso, il valore del progetto host deve essere il progetto in cui è ospitato il VPC. Per saperne di più sul VPC condiviso, consulta Panoramica del VPC condiviso.

Per risolvere il problema, segui le linee guida per specificare una rete e una subnet.

Timeout RPC o connessione non riuscita sulle porte 12345 o 12346

Quando esegui un job Dataflow che non utilizza Streaming Engine o Dataflow Shuffle, si verifica uno dei seguenti errori. Il job si blocca o non riesce.

Per i lavori di streaming:

Rpc to WORKER_HARNESS:12345 completed with error

UNAVAILABLE: failed to connect to all addresses; last error : UNKNOWN:

ipv4:WORKER_IP_ADDRESS:12345: Failed to connect to remote

host: FD Shutdown

Per i job batch:

(g)RPC timed out when SOURCE_WORKER_HARNESS talking to

DESTINATION_WORKER_HARNESS:12346.

Questo problema si verifica se manca una regola firewall che consenta il traffico di rete sulle porte TCP

12345 e 12346. Quando il job utilizza più worker, questi

non possono comunicare tra loro.

Per risolvere il problema, consulta i passaggi per la risoluzione dei problemi in DEADLINE_EXCEEDED o Server Unresponsive.

Un singolo worker viene avviato e arrestato ripetutamente

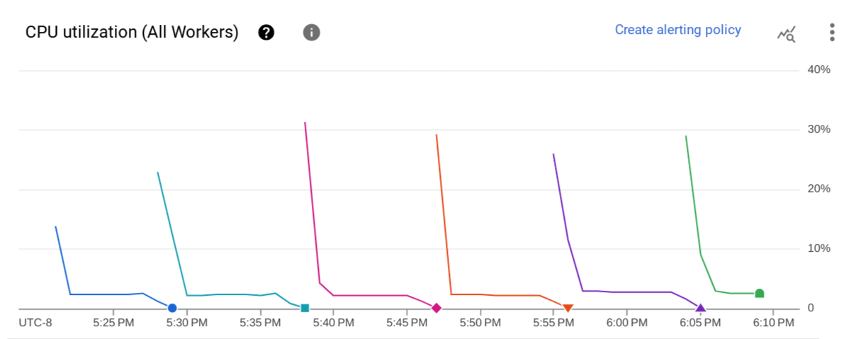

Si verifica il seguente problema quando avvii un job Dataflow. Nella pagina Metriche job del job Dataflow, il grafico Utilizzo CPU (tutti i worker) mostra che un worker viene avviato e arrestato ripetutamente dopo alcuni minuti. È disponibile un solo lavoratore alla volta.

Si verifica il seguente errore:

The Dataflow job appears to be stuck because no worker activity has been seen

in the last 1h. Please check the worker logs in Stackdriver Logging.

Non vengono creati log dei worker.

Nei log dei job potrebbero essere visualizzati più messaggi simili al seguente:

Autoscaling: Raised the number of workers to 1 based on the rate of progress in

the currently running stage(s).

Questo problema si verifica se la rete VPC non ha una route predefinita a internet e una route predefinita alla subnet.

Per risolvere il problema, aggiungi route predefinite alla tua rete VPC. Per ulteriori informazioni, consulta Accesso a internet per Dataflow.

Questo problema può verificarsi anche se l'account di servizio worker gestito dall'utente e il job Dataflow si trovano in progetti diversi. Per ulteriori informazioni su come evitare questo problema quando utilizzi service account tra progetti, consulta le indicazioni fornite nei passaggi 3 e 4 di Specifica un service account worker gestito dall'utente.

Se la tua rete VPC ha route predefinite e il account di servizio worker gestito dall'utente e il job Dataflow si trovano nello stesso progetto, accedi alla VM worker del job Dataflow e controlla i log nella directory /var/log/dataflow per identificare il problema.

La subnet non dispone dell'accesso privato Google

Si verifica il seguente errore quando avvii un job Dataflow in cui gli indirizzi IP esterni sono disattivati:

Workflow failed. Causes: Subnetwork SUBNETWORK on project

PROJECT_ID network NETWORK in

region REGION does not have Private Google Access, which

is required for usage of private IP addresses by the Dataflow workers.

Questo problema si verifica se disattivi gli indirizzi IP esterni senza attivare l'accesso privato Google.

Per risolvere il problema, abilita l'accesso privato Google per la subnet utilizzata dal job Dataflow.

Impossibile creare Dataflow con un intervallo IP specificato

Dataflow non supporta l'assegnazione di un intervallo IP statico alle VM worker. Come soluzione alternativa, puoi creare una subnet con un intervallo di indirizzi IP specifico e distribuire il job Dataflow in quella subnet.

Per saperne di più sull'utilizzo delle subnet con Dataflow, consulta Specificare una rete e una subnet.

Per informazioni sulla configurazione degli intervalli IP nelle subnet, consulta Configura intervalli IP alias.

Per eseguire la pipeline nella subnet, consulta Eseguire la pipeline con la subnet specificata.

Potresti anche dover creare una regola NAT e un router. Per saperne di più, consulta Cloud NAT.

Passaggi successivi

Per ulteriori passaggi per la risoluzione dei problemi di rete, consulta Risolvere i problemi di connettività interna tra le VM.