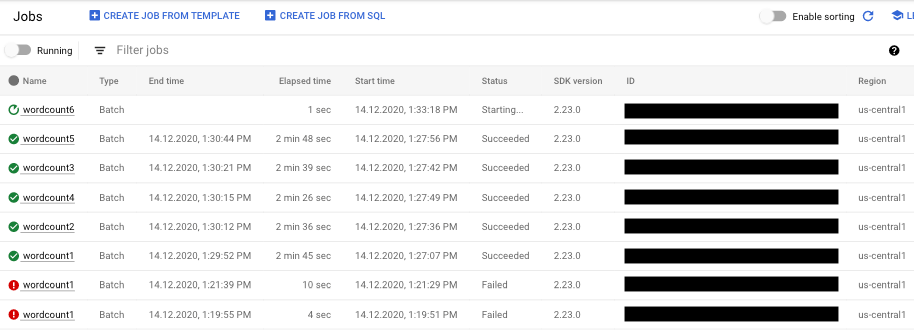

Para ver uma lista dos seus trabalhos do Dataflow, aceda à página Dataflow > Trabalhos na Google Cloud consola.

É apresentada uma lista de tarefas do Dataflow juntamente com o respetivo estado.

Uma tarefa pode ter os seguintes estados:

- —: a interface de monitorização ainda não recebeu um estado do serviço Dataflow.

- Em execução: a tarefa está em execução.

- A iniciar…: a tarefa é criada, mas o sistema precisa de algum tempo para se preparar antes do lançamento.

- Na fila: um trabalho FlexRS está na fila ou um trabalho de modelo flexível está a ser iniciado (o que pode demorar vários minutos).

- A cancelar…: a tarefa está a ser cancelada.

- Cancelada: a tarefa foi cancelada.

- A drenar…: a tarefa está a ser drenada.

- Esgotado: o trabalho está esgotado.

- A atualizar...: o trabalho está a ser atualizado.

- Atualizado: a tarefa é atualizada.

- Sucedido: o trabalho foi concluído com êxito.

- Falhou: a tarefa não foi concluída.

Aceda aos visualizadores de tarefas

Para aceder aos gráficos de monitorização da tarefa, clique no nome da tarefa na interface de monitorização do Dataflow. É apresentada a página Detalhes da tarefa, que contém as seguintes informações:

- Gráfico de tarefas: representação visual do seu pipeline

- Detalhes da execução: ferramenta para otimizar o desempenho do pipeline

- Métricas de tarefas: métricas sobre a execução da sua tarefa

- Custo: métricas sobre o custo estimado da sua tarefa

- Escala automática: métricas relacionadas com eventos de escala automática de tarefas de streaming

- Painel de informações do trabalho: informações descritivas sobre o seu pipeline

- Registos de tarefas: registos gerados pelo serviço Dataflow ao nível da tarefa

- Registos do trabalhador: registos gerados pelo serviço Dataflow ao nível do trabalhador

- Diagnósticos: tabela que mostra onde ocorreram erros ao longo da cronologia escolhida e possíveis recomendações para o seu pipeline

- Amostragem de dados: ferramenta que lhe permite observar os dados em cada passo de um pipeline

Na página Detalhes da tarefa, pode alternar a vista da tarefa com os separadores Gráfico de tarefas, Detalhes de execução, Métricas de tarefas, Custo e Ajuste automático de escala.

Use a Google Cloud CLI para listar trabalhos

Também pode usar a CLI do Google Cloud para obter uma lista das suas tarefas do Dataflow.

Para apresentar uma lista das tarefas do Dataflow no seu projeto, use o comando

dataflow jobs list:

gcloud dataflow jobs list

O comando devolve uma lista dos seus trabalhos atuais. Segue-se um exemplo de resultado:

ID NAME TYPE CREATION_TIME STATE REGION 2015-06-03_16_39_22-4020553808241078833 wordcount-janedoe-0603233849 Batch 2015-06-03 16:39:22 Done us-central1 2015-06-03_16_38_28-4363652261786938862 wordcount-johndoe-0603233820 Batch 2015-06-03 16:38:28 Done us-central1 2015-05-21_16_24_11-17823098268333533078 bigquerytornadoes-johndoe-0521232402 Batch 2015-05-21 16:24:11 Done europe-west1 2015-05-21_13_38_06-16409850040969261121 bigquerytornadoes-johndoe-0521203801 Batch 2015-05-21 13:38:06 Done us-central1 2015-05-21_13_17_18-18349574013243942260 bigquerytornadoes-johndoe-0521201710 Batch 2015-05-21 13:17:18 Done europe-west1 2015-05-21_12_49_37-9791290545307959963 wordcount-johndoe-0521194928 Batch 2015-05-21 12:49:37 Done us-central1 2015-05-20_15_54_51-15905022415025455887 wordcount-johndoe-0520225444 Batch 2015-05-20 15:54:51 Failed us-central1 2015-05-20_15_47_02-14774624590029708464 wordcount-johndoe-0520224637 Batch 2015-05-20 15:47:02 Done us-central1

Para apresentar mais informações sobre uma tarefa, use o comando

dataflow jobs describe:

gcloud dataflow jobs describe JOB_ID

Substituir JOB_ID pela tarefa ID. O resultado deste comando tem um aspeto semelhante ao seguinte:

createTime: '2015-02-09T19:39:41.140Z' currentState: JOB_STATE_DONE currentStateTime: '2015-02-09T19:56:39.510Z' id: 2015-02-09_11_39_40-15635991037808002875 name: tfidf-bchambers-0209193926 projectId: google.com:clouddfe type: JOB_TYPE_BATCH

Para formatar o resultado em JSON, execute o comando com a opção --format=json:

gcloud --format=json dataflow jobs describe JOB_ID

Arquive (oculte) tarefas do Dataflow de uma lista

Quando arquiva uma tarefa do Dataflow, esta é removida da lista de tarefas na página Tarefas do Dataflow na consola. O trabalho é movido para uma lista de trabalhos arquivados. Só pode arquivar tarefas concluídas, o que inclui tarefas nos seguintes estados:

JOB_STATE_CANCELLEDJOB_STATE_DRAINEDJOB_STATE_DONEJOB_STATE_FAILEDJOB_STATE_UPDATED

Para mais informações sobre a validação destes estados, consulte o artigo Detetar a conclusão da tarefa do Dataflow.

Para obter informações de resolução de problemas quando está a arquivar tarefas, consulte o artigo Erros de arquivo de tarefas em "Resolva problemas do Dataflow".

Todas as tarefas arquivadas são eliminadas após um período de retenção de 30 dias.

Arquive um trabalho

Siga estes passos para remover um trabalho concluído da lista de trabalhos principal na página Trabalhos do Dataflow.

Consola

Na Google Cloud consola, aceda à página Tarefas do Dataflow.

É apresentada uma lista de tarefas do Dataflow juntamente com o respetivo estado.

Selecione uma tarefa.

Na página Detalhes da tarefa, clique em Arquivar. Se o trabalho não tiver sido concluído, a opção Arquivar não está disponível.

REST

Para arquivar uma tarefa através da API, use o método

projects.locations.jobs.update.

Neste pedido, tem de especificar um objeto JobMetadata atualizado. No objeto JobMetadata.userDisplayProperties, use o par chave-valor "archived":"true".

Além do objeto JobMetadata atualizado, o seu pedido API também tem de incluir o parâmetro de consulta updateMask no URL do pedido:

https://dataflow.googleapis.com/v1b3/[...]/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Antes de usar qualquer um dos dados do pedido, faça as seguintes substituições:

- PROJECT_ID: o ID do seu projeto

- REGION: uma região do Dataflow

- JOB_ID: o ID da sua tarefa do Dataflow

Método HTTP e URL:

PUT https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Corpo JSON do pedido:

{

"job_metadata": {

"userDisplayProperties": {

"archived": "true"

}

}

}

Para enviar o seu pedido, escolha uma destas opções:

curl

Guarde o corpo do pedido num ficheiro com o nome request.json,

e execute o seguinte comando:

curl -X PUT \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived"

PowerShell

Guarde o corpo do pedido num ficheiro com o nome request.json,

e execute o seguinte comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method PUT `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived" | Select-Object -Expand Content

Deve receber uma resposta JSON semelhante à seguinte:

{

"id": "JOB_ID",

"projectId": "PROJECT_ID",

"currentState": "JOB_STATE_DONE",

"currentStateTime": "2025-05-20T20:54:41.651442Z",

"createTime": "2025-05-20T20:51:06.031248Z",

"jobMetadata": {

"userDisplayProperties": {

"archived": "true"

}

},

"startTime": "2025-05-20T20:51:06.031248Z"

}

gcloud

Este comando arquiva uma única tarefa. A tarefa tem de estar num estado terminal para poder arquivá-la. Caso contrário, o pedido é rejeitado. Depois de enviar o comando, tem de confirmar que quer executá-lo.

Antes de usar qualquer um dos dados de comandos abaixo, faça as seguintes substituições:

JOB_ID: o ID da tarefa do Dataflow que quer arquivar.REGION: opcional. A região do Dataflow da sua tarefa.

Execute o seguinte comando:

Linux, macOS ou Cloud Shell

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Windows (PowerShell)

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Windows (cmd.exe)

gcloud dataflow jobs archive JOB_ID --region=REGION_ID

Deve receber uma resposta semelhante à seguinte:

Archived job [JOB_ID].

createTime: '2025-06-29T11:00:02.432552Z'

currentState: JOB_STATE_DONE

currentStateTime: '2025-06-29T11:04:25.125921Z'

id: JOB_ID

jobMetadata:

userDisplayProperties:

archived: 'true'

projectId: PROJECT_ID

startTime: '2025-06-29T11:00:02.432552Z'

Veja e restaure trabalhos arquivados

Siga estes passos para ver trabalhos arquivados ou restaurar trabalhos arquivados para a lista de trabalhos principal na página Trabalhos do Dataflow.

Consola

Na Google Cloud consola, aceda à página Tarefas do Dataflow.

Clique no botão ativar/desativar Arquivado. É apresentada uma lista de tarefas do Dataflow arquivadas.

Selecione uma tarefa.

Para restaurar a tarefa para a lista de tarefas principal na página Tarefas do Dataflow, na página Detalhes da tarefa, clique em Restaurar.

REST

Para restaurar uma tarefa arquivada através da API, use o método

projects.locations.jobs.update.

Neste pedido, tem de especificar um objeto JobMetadata atualizado. No objeto JobMetadata.userDisplayProperties, use o par de chave-valor "archived":"false".

Além do objeto JobMetadata atualizado, o seu pedido API também tem de incluir o parâmetro de consulta updateMask no URL do pedido:

https://dataflow.googleapis.com/v1b3/[...]/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Antes de usar qualquer um dos dados do pedido, faça as seguintes substituições:

- PROJECT_ID: o ID do seu projeto

- REGION: uma região do Dataflow

- JOB_ID: o ID da sua tarefa do Dataflow

Método HTTP e URL:

PUT https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived

Corpo JSON do pedido:

{

"job_metadata": {

"userDisplayProperties": {

"archived": "false"

}

}

}

Para enviar o seu pedido, escolha uma destas opções:

curl

Guarde o corpo do pedido num ficheiro com o nome request.json,

e execute o seguinte comando:

curl -X PUT \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived"

PowerShell

Guarde o corpo do pedido num ficheiro com o nome request.json,

e execute o seguinte comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method PUT `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://dataflow.googleapis.com/v1b3/projects/PROJECT_ID/locations/REGION/jobs/JOB_ID/?updateMask=job_metadata.user_display_properties.archived" | Select-Object -Expand Content

Deve receber uma resposta JSON semelhante à seguinte:

{

"id": "JOB_ID",

"projectId": "PROJECT_ID",

"currentState": "JOB_STATE_DONE",

"currentStateTime": "2025-05-20T20:54:41.651442Z",

"createTime": "2025-05-20T20:51:06.031248Z",

"jobMetadata": {

"userDisplayProperties": {

"archived": "false"

}

},

"startTime": "2025-05-20T20:51:06.031248Z"

}