Este artículo forma parte de una serie en la que se trata la recuperación ante desastres (DR) en Google Cloud. En esta parte, se analiza el proceso para diseñar la arquitectura de cargas de trabajo con Google Cloud y los componentes básicos resilientes a las interrupciones en la infraestructura de nube.

La serie consta de estas partes:

- Guía de planificación para la recuperación ante desastres

- Componentes básicos de la recuperación ante desastres

- Situaciones de recuperación ante desastres para datos

- Situaciones de recuperación ante desastres para aplicaciones

- Arquitectura de recuperación ante desastres para cargas de trabajo con restricciones de localidad

- Casos de uso de recuperación ante desastres: aplicaciones de análisis de datos con restricciones de localidad

- Arquitectura de recuperación ante desastres para interrupciones de la infraestructura de nube (este documento)

Introducción

A medida que las empresas trasladan las cargas de trabajo a la nube pública, necesitan traducir sus conocimientos de cómo compilar sistemas locales resilientes en la infraestructura de hiperescalamiento de los proveedores de servicios en la nube, como Google Cloud. En este artículo, se asignan conceptos estándar de la industria sobre la recuperación ante desastres, como el RTO (objetivo de tiempo de recuperación) y el RPO (objetivo de punto de recuperación) a la infraestructura de Google Cloud.

La orientación de este documento sigue uno de los principios clave de Google para lograr una disponibilidad de servicio muy alta: planificar la falla. Si bienGoogle Cloud proporciona un servicio extremadamente confiable, ocurrirán desastres naturales, cortes de fibra y errores complejos de infraestructura; estos pueden causar interrupciones. La planificación para las interrupciones permite que losGoogle Cloud clientes compilen aplicaciones que se ejecuten de manera predecible durante estos eventos inevitables mediante el uso de Google Cloud productos con mecanismos de DR “integrados”.

La recuperación ante desastres es un tema amplio que cubre mucho más que las fallas de infraestructura, como los errores de software o la corrupción de datos, y debes tener un plan integral de extremo a extremo. Sin embargo, este artículo se centra en una parte de un plan de DR general: cómo diseñar aplicaciones que sean resilientes a las interrupciones de la infraestructura de nube. En concreto, se explica lo siguiente:

- La Google Cloud infraestructura, cómo se manifiestan los eventos de desastre comoGoogle Cloud interrupciones y cómo Google Cloud está diseñado para minimizar la frecuencia y el alcance de las interrupciones

- Una guía de planificación de la arquitectura que proporciona un framework para categorizar y diseñar aplicaciones según los resultados de confiabilidad deseados

- Una lista detallada de productos Google Cloud seleccionados que ofrecen funciones de DR integradas que tal vez quieras usar en tu aplicación

Para obtener más detalles sobre la planificación general de la DR y el uso de Google Cloud como componente de tu estrategia de DR local, consulta la guía de planificación para la recuperación ante desastres. Aunque la alta disponibilidad es un concepto muy relacionado con la recuperación ante desastres, no se aborda en este artículo. Si deseas obtener más detalles sobre la arquitectura de una alta disponibilidad, consulta el Well-Architected Framework.

Nota sobre la terminología: Este artículo hace referencia a la disponibilidad cuando se describe la capacidad de un producto de que se acceda a él de manera significativa y se use a lo largo del tiempo, mientras que la confiabilidad se refiere a un conjunto de atributos que incluye la disponibilidad, además de funciones como la durabilidad y la corrección.

Cómo Google Cloud está diseñado para ofrecer resiliencia

Centros de datos de Google

Los centros de datos tradicionales se basan en maximizar la disponibilidad de componentes individuales. En la nube, la escala permite a operadores como Google distribuir servicios en muchos componentes mediante tecnologías de virtualización y, por lo tanto, superar la confiabilidad tradicional de los componentes. Esto significa que puedes dejar de enfocar la mentalidad de la arquitectura de confiabilidad en los innumerables detalles que te preocupaban en las instalaciones locales. En lugar de preocuparte por los distintos modos de falla de los componentes, como el enfriamiento y la entrega de energía, puedes planificar en torno a los productos de Google Cloud y sus métricas de confiabilidad indicadas. Estas métricas reflejan el riesgo de interrupción agregado de toda la infraestructura subyacente. De esta manera, puedes enfocarte mucho más en el diseño, la implementación y las operaciones de la aplicación en lugar de la administración de infraestructura.

Google diseña su infraestructura para cumplir con los objetivos de disponibilidad agresivos en función de nuestra vasta experiencia en el desarrollo y la ejecución de centros de datos modernos. Google es uno de los líderes mundiales en el diseño de centros de datos. Desde la energía hasta el enfriamiento y las redes, cada tecnología de los centros de datos tiene sus propias redundancias y mitigaciones, incluidos los planes de FMEA. Los centros de datos de Google se construyen de manera que se equilibren estos diferentes riesgos y se les presente a los clientes un nivel esperado constante de disponibilidad para los productos de Google Cloud . Google usa su experiencia para modelar la disponibilidad de la arquitectura general del sistema físico y lógico a fin de garantizar que el diseño del centro de datos cumpla con las expectativas. Los ingenieros de Google hacen grandes esfuerzos operativos para garantizar que se cumplan esas expectativas. Es normal que la disponibilidad real exceda nuestros objetivos de diseño por un margen amplio.

Cuando se extraen todos estos riesgos y mitigaciones de los centros de datos en los productos para los usuarios, Google Cloud te evita esas responsabilidades operativas y de diseño. En cambio, puedes enfocarte en la confiabilidad integrada en el diseño de las regiones y las zonas deGoogle Cloud .

Regiones y zonas

Las regiones son áreas geográficas independientes que constan de zonas. Las zonas y las regiones son abstracciones lógicas de los recursos físicos subyacentes. Para obtener más información sobre las consideraciones específicas de la región, consulta Geografía y regiones.

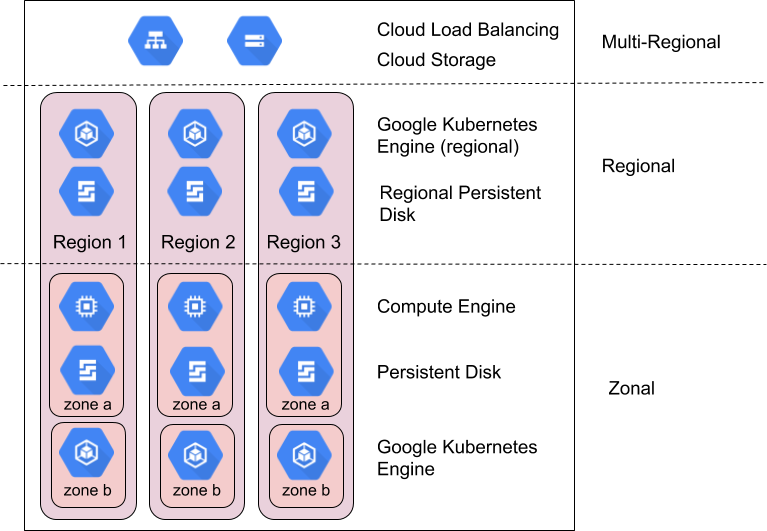

Los productos deGoogle Cloud se dividen en recursos zonales, regionales y multirregionales.

Los recursos zonales se alojan en una sola zona. Una interrupción del servicio en esa zona puede afectar a todos los recursos de esa zona. Por ejemplo, una instancia de Compute Engine se ejecuta en una zona única y especificada. Si una falla de hardware interrumpe el servicio en esa zona, esa instancia de Compute Engine no estará disponible mientras dure la interrupción.

Los recursos regionales se implementan de forma redundante en varias zonas dentro de una región. Esto les brinda mayor confiabilidad en comparación con los recursos zonales.

Los recursos multirregionales se distribuyen dentro de las regiones y entre ellas. En general, los recursos multirregionales son más confiables que los regionales. Sin embargo, a este nivel, los productos deben optimizar la disponibilidad, el rendimiento y la eficiencia de los recursos. Como resultado, es importante comprender las compensaciones de cada producto multirregional que decidas usar. Estas compensaciones se documentan de forma específica para cada producto más adelante en este documento.

Cómo aprovechar las zonas y las regiones para lograr la confiabilidad

Las SRE de Google administran y escalan productos para usuarios globales de alta confiabilidad, como Gmail y Búsqueda, mediante una variedad de técnicas y tecnologías que aprovechan sin problemas la infraestructura de procesamiento en todo el mundo. Esto incluye el redireccionamiento del tráfico desde ubicaciones no disponibles mediante el balanceo de cargas global, la ejecución de varias réplicas en varias ubicaciones en todo el planeta y la replicación de datos en distintos lugares. Estas mismas capacidades están disponibles para los clientes de Google Clouda través de productos como Cloud Load Balancing, Google Kubernetes Engine (GKE) y Spanner.

Google Cloud generalmente diseña productos para ofrecer los siguientes niveles de disponibilidad para zonas y regiones:

| Recurso | Ejemplos | Objetivo del diseño de disponibilidad | Tiempo de inactividad implícito |

|---|---|---|---|

| Zonal | Compute Engine, Persistent Disk | 99.9% | 8.75 horas al año |

| Regional | Cloud Storage regional, Persistent Disk replicado, GKE regional | 99.99% | 52 minutos al año |

Compara los objetivos del diseño de disponibilidad de Google Cloud con el nivel aceptable de tiempo de inactividad para identificar los recursos de Google Cloud apropiados. Si bien los diseños tradicionales se enfocan en mejorar la disponibilidad a nivel del componente para mejorar la disponibilidad resultante de la aplicación, los modelos de la nube se enfocan en la composición de los componentes a fin de lograr este objetivo. Muchos productos dentro deGoogle Cloud usan esta técnica. Por ejemplo, Spanner ofrece una base de datos multirregional que compone varias regiones para entregar una disponibilidad del 99.999%.

La composición es importante porque, sin ella, la disponibilidad de la aplicación no puede superar la de los productos de Google Cloud que usas. De hecho, a menos que la aplicación nunca falle, tendrá una disponibilidad menor que los productos deGoogle Cloud subyacentes. En el resto de esta sección, se muestra cómo puedes usar una composición de productos zonales y regionales para lograr una mayor disponibilidad de la aplicación que la que proporcionan una sola zona o región. En la próxima sección, se proporciona una guía práctica para aplicar estos principios a tus aplicaciones.

Planifica los alcances de interrupción de zonas

Las fallas de infraestructura suelen causar interrupciones del servicio en una sola zona. Dentro de una región, las zonas están diseñadas para minimizar el riesgo de fallas correlacionadas con otras zonas, y una interrupción del servicio en una zona no suele afectar el servicio desde otra zona en la misma región. Una interrupción con alcance a una zona no siempre implica que toda la zona no esté disponible; solo define el límite del incidente. Es posible que una interrupción zonal no tenga ningún efecto tangible en los recursos específicos de esa zona.

Es un caso menos frecuente, pero también es importante tener en cuenta que varias zonas, en algún momento, experimentarán una interrupción correlacionada en una sola región. Cuando dos o más zonas experimentan una interrupción, se aplica la estrategia de alcance de la interrupción regional que aparece a continuación.

Los recursos regionales están diseñados para ser resistentes a las interrupciones zonales mediante la entrega del servicio desde una composición de varias zonas. Si se interrumpe una de las zonas que respaldan un recurso regional, el recurso queda disponible de manera automática desde otra zona. Revisa con cuidado la descripción de la capacidad del producto en el apéndice para obtener más detalles.

Google Cloud solo ofrece algunos recursos zonales, como las máquinas virtuales (VM) de Compute Engine y Persistent Disk. Si planeas usar recursos zonales, tendrás que realizar tu propia composición de recursos diseñando, compilando y probando la conmutación por error y la recuperación entre recursos zonales ubicados en varias zonas. Estas son algunas de las estrategias:

- Enrutar con rapidez el tráfico a máquinas virtuales en otra zona mediante Cloud Load Balancing cuando una verificación de estado determina que una zona tiene problemas

- Usar plantillas de instancias o grupos de instancias administrados de Compute Engine para ejecutar y escalar instancias de VM idénticas en varias zonas

- Usar Persistent Disk regional para replicar de forma síncrona los datos en otra zona de una región. Consulta Opciones de alta disponibilidad con PD regionales para obtener más detalles.

Planifica los alcances de interrupción regional

Una interrupción regional es una interrupción del servicio que afecta a más de una zona en una sola región. Estas son interrupciones más grandes y menos frecuentes, y pueden ser consecuencia de desastres naturales o fallas en la infraestructura a gran escala.

Si un producto regional está diseñado para proporcionar una disponibilidad del 99.99%, una interrupción puede traducirse a casi una hora de inactividad para un producto específico cada año. Por lo tanto, es posible que tus aplicaciones esenciales necesiten contar con un plan de DR multirregional si no esta duración de interrupción es inaceptable.

Los recursos multirregionales están diseñados para ser resistentes a las interrupciones regionales mediante la entrega del servicio en varias regiones. Como se describió antes, los productos multirregionales compensan la latencia, la coherencia y el costo. La compensación más común se da entre la replicación de datos síncrona y la replicación asíncrona. La replicación asíncrona ofrece menos latencia al costo de riesgo de pérdida de datos durante una interrupción. Por lo tanto, es importante verificar la descripción de la capacidad del producto en el apéndice para obtener más detalles.

Si quieres usar recursos regionales y seguir siendo resiliente ante las interrupciones regionales, debes diseñar tu propia composición de recursos. Para ello, diseña, compila y prueba la conmutación por error y la recuperación entre los recursos regionales ubicados en varias regiones. Además de las estrategias zonales anteriores, que también puedes aplicar a otras regiones, ten en cuenta lo siguiente:

- Los recursos regionales deben replicar los datos en una región secundaria, en una opción de almacenamiento multirregional, como Cloud Storage, o en una opción de nube híbrida, como GKE Enterprise.

- Una vez que tengas una mitigación regional ante interrupciones, pruébala con frecuencia. Si hay algo peor que pensar que eres resistente a una interrupción de una sola región, es descubrir que ese no es el caso cuando ocurre de verdad.

Enfoque deGoogle Cloud resiliencia y disponibilidad

Google Cloud supera con regularidad sus objetivos de diseño de disponibilidad, pero no debes suponer que este rendimiento anterior sólido es la disponibilidad mínima que puedes diseñar. En cambio, debes seleccionar dependencias Google Cloud cuyos objetivos para los que se diseñaron superan la confiabilidad prevista de la aplicación, de modo que el tiempo de inactividad de la aplicación más el tiempo de inactividad de Google Cloud entreguen el resultado que buscas.

Un sistema bien diseñado puede responder la pregunta “¿Qué sucede cuando una zona o región tiene una interrupción de 1, 5, 10 o 30 minutos?” Esto se debe tener en cuenta en muchas capas, incluidas las siguientes:

- ¿Qué experimentarán mis clientes durante una interrupción?

- ¿Cómo detecto que hay una interrupción en curso?

- ¿Qué sucede con mi solicitud durante una interrupción?

- ¿Qué sucede con mis datos durante una interrupción?

- ¿Qué le sucede a mis otras aplicaciones como consecuencia de una interrupción (debido a las dependencias cruzadas)?

- ¿Qué debo hacer para recuperarme después de que se resuelve una interrupción? ¿Quién lo hace?

- ¿A quién debo notificar sobre una interrupción? ¿En qué período?

Guía paso a paso para diseñar la recuperación ante desastres para aplicaciones en Google Cloud

En las secciones anteriores, se explicó cómo Google compila la infraestructura de nube y algunos enfoques para abordar las interrupciones zonales y regionales.

En esta sección, te ayudamos a desarrollar un framework para aplicar el principio de composición a tus aplicaciones en función de los resultados de confiabilidad deseados.

Las aplicaciones del cliente en Google Cloud que se establecen objetivos de recuperación ante desastres, como el RTO y el RPO, deben diseñarse de manera que las operaciones críticas para el negocio, sujetas al RTO y al RPO, solo dependan de los componentes del plano de datos que son responsables del procesamiento continuo de las operaciones del servicio. En otras palabras, estas operaciones fundamentales para el cliente no deben depender de las operaciones del plano de administración, que administran el estado de configuración y la configuración de envío al plano de control y al plano de datos.

Por ejemplo, Google Cloud los clientes que deseen lograr el RTO para operaciones fundamentales no deben depender de una API de creación de VM o de la actualización de un permiso de IAM.

Paso 1: Reúne los requisitos existentes

El primer paso es definir los requisitos de disponibilidad para tus aplicaciones. La mayoría de las empresas ya tienen algún nivel de orientación de diseño en este espacio, que se puede desarrollar de forma interna o derivar de leyes u otros requisitos legales. En general, esta guía de diseño se codifica en dos métricas clave: el objetivo de tiempo de recuperación (RTO) y el objetivo de punto de recuperación (RPO). En términos comerciales, el RTO se traduce como “cuánto tiempo transcurre después de un desastre hasta que vuelvo a estar activo y listo para ejecutar”. El RPO se traduce como “cuántos datos puedo perder si ocurre un desastre”.

A lo largo de la historia, las empresas definieron los requisitos de RTO y RPO para un rango amplio de eventos de desastres, desde fallas de componentes hasta terremotos. Esto tenía sentido en el mundo local en el que los planificadores debían asignar los requisitos de RTO y RPO a través de toda la pila de software y hardware. En la nube, ya no necesitas definir tus requisitos con tanto detalles porque el proveedor se encarga de eso. En cambio, puedes definir tus requisitos de RTO y RPO en términos del alcance de la pérdida (zonas o regiones completas) sin especificar los motivos subyacentes. Para Google Cloud esto simplifica la recopilación de requisitos a 3 situaciones: una interrupción zonal, una interrupción regional o la interrupción de varias regiones, que es muy poco probable.

Ya que se reconoce que no todas las aplicaciones tienen la misma importancia, la mayoría de los clientes clasifican sus aplicaciones en niveles de importancia, en los que se puede aplicar un requisito específico de RTO y RPO. Cuando se combinan, el RTO, el RPO y la importancia de la aplicación optimizan el proceso de diseñar la arquitectura de una aplicación determinada y dan respuesta a las siguientes preguntas:

- ¿La aplicación debe ejecutarse en varias zonas en la misma región o en varias zonas en varias regiones?

- ¿De qué Google Cloud productos puede depender la aplicación?

Este es un ejemplo del resultado del ejercicio de recopilación de requisitos:

El RTO y el RPO por importancia de la aplicación para la organización de ejemplo:

| Importancia de la aplicación | % de apps | Apps de ejemplo | Interrupción zonal | Interrupción regional |

|---|---|---|---|---|

| Nivel 1

(más importante) |

5% | Por lo general, aplicaciones globales y externas orientadas al cliente, como los pagos en tiempo real y las vidrieras de comercio electrónico. | RTO de cero

RPO de cero |

RTO de cero

RPO de cero |

| Nivel 2 | 35% | Por lo general, aplicaciones regionales o las aplicaciones internas importantes como CRM o ERP. | RTO de 15 min

RPO de 15 min |

RTO de 1 h

RPO de 1 h |

| Nivel 3

(menos importante) |

60% | Por lo general, las aplicaciones de equipos o departamentos, como la oficina administrativa, las reservas, los viajes internos, la contabilidad y el departamento de RR.HH. | RTO de 1 h

RPO de 1 h |

RTO de 12 horas

RPO de 12 h |

Paso 2: Asignación de capacidades a los productos disponibles

El segundo paso es comprender las capacidades de resiliencia de los productos de Google Cloudque usarán tus aplicaciones. La mayoría de las empresas revisan la información relevante de los productos y, luego, agregan orientación sobre cómo modificar las arquitecturas a fin de adaptarse a las brechas entre las capacidades de los productos y los requisitos de resiliencia. En esta sección, se abarcan algunas áreas comunes y recomendaciones sobre las limitaciones de datos y aplicaciones en este espacio.

Como se mencionó antes, los productos habilitados para DR de Google están pensados, a grandes rasgos, para dos tipos de alcances de interrupción: regional y zonal. Cuando se trata de DR, se debe planificar de la misma manera para las interrupciones parciales y las interrupciones totales. Esto brinda una matriz inicial de alto nivel de qué productos son adecuados para cada situación de forma predeterminada:

Google Cloud Funciones generales de los productos

(consulta el Apéndice para conocer las funciones específicas de productos)

| Todos los Google Cloud productos | Productos Google Cloud regionales con replicación automática entre zonas | Productos multirregionales o globales Google Cloud con replicación automática en todas las regiones | |

|---|---|---|---|

| Error de un componente dentro de una zona | Cubierto* | Cubierto | Cubierto |

| Interrupción zonal | No cubierto | Cubierto | Cubierto |

| Interrupción regional | No cubierto | No cubierto | Cubierto |

* Todos Google Cloud los productos son resilientes a la falla de componentes, excepto en los casos específicos que se indican en la documentación del producto. Por lo general, son situaciones en las que el producto ofrece acceso directo o asignación estática a un hardware de especialidad, como la memoria o los discos de estado sólido (SSD).

Cómo el RPO limita las opciones de producto

En la mayoría de las implementaciones de nube, la integridad de los datos es el aspecto más significativo desde el punto de vista arquitectónico para un servicio. Al menos algunas aplicaciones tienen un requisito de RPO de cero, lo que significa que no se deberían perder datos en caso de que ocurra una interrupción. Por lo general, esto requiere que los datos se repliquen de forma síncrona en otra zona o región. La replicación síncrona tiene compensaciones de costo y latencia, por lo que, si bien muchos Google Cloud productos proporcionan replicación síncrona entre zonas, solo unos pocos la proporcionan en regiones. Esta compensación entre el costo y la complejidad significa que no es inusual que diferentes tipos de datos dentro de una aplicación tengan diferentes valores de RPO.

En los datos con un RPO mayor que cero, las aplicaciones pueden aprovechar la replicación asíncrona. La replicación asíncrona es aceptable cuando los datos perdidos se pueden volver a crear con facilidad o se pueden recuperar de una fuente de datos dorada si es necesario. También puede ser una opción razonable cuando una pequeña pérdida de datos es una compensación aceptable en el contexto de las duraciones previstas para las interrupciones zonales y regionales. También es relevante que, durante una interrupción transitoria, los datos escritos en la ubicación afectada, pero que aún no se replicaron en otra ubicación, por lo general estén disponibles después de que se resuelva la interrupción. Esto significa que el riesgo de pérdida permanente de los datos es menor que el riesgo de perder el acceso a los datos durante una interrupción.

Acciones clave: Determina si realmente necesitas un RPO de cero y, si es así, si puedes hacerlo para un subconjunto de datos; esto aumenta de forma notable el rango de servicios habilitados para DR disponibles. En Google Cloud, alcanzar un RPO de cero implica usar, en su mayoría, productos regionales para la aplicación, que, en la configuración predeterminada, son resilientes a las interrupciones a escala zonal, pero no a escala regional.

Cómo el RTO limita las opciones del producto

Uno de los principales beneficios de la computación en la nube es la capacidad de implementar la infraestructura a pedido. Sin embargo, no es lo mismo que la implementación instantánea. El valor de RTO de tu aplicación debe adaptarse al RTO combinado de los productos de Google Cloud que usa la aplicación y a las acciones que deban realizar los ingenieros o SRE para reiniciar las VMs o los componentes de la aplicación. Un RTO medido en minutos significa diseñar una aplicación que se recupere de forma automática de un desastre sin intervención humana o con pasos mínimos, como presionar un botón para una conmutación por error. El costo y la complejidad de este tipo de sistema siempre han sido muy altos, pero los productos de Google Cloud , como los balanceadores de cargas y los grupos de instancias, hacen que este diseño sea mucho más accesible y sencillo. Por lo tanto, debes tener en cuenta la conmutación por error y la recuperación automatizadas para la mayoría de las aplicaciones. Ten en cuenta que diseñar un sistema para este tipo de conmutación por error en caliente en todas las regiones es complicado y costoso; solo una fracción muy pequeña de los servicios importantes justifican esta capacidad.

La mayoría de las aplicaciones tendrá un RTO de entre una hora y un día, lo que permite una conmutación por error cálida en una situación de desastre, con algunos componentes de la aplicación que se ejecutan todo el tiempo en modo de espera, como las bases de datos, mientras que otros se escalan horizontalmente durante un desastre real, como los servidores web. En el caso de estas aplicaciones, debes considerar la automatización para los eventos de escalamiento horizontal. Los servicios con un RTO de más de un día son los de menor importancia y a menudo se pueden recuperarse desde una copia de seguridad o volver a crearse desde cero.

Acciones clave: Determina si en verdad necesitas un RTO de (alrededor de) cero para la conmutación por error regional y, de ser así, si puedes hacerlo para un subconjunto de los servicios. Esto cambia el costo de ejecutar y mantener tu servicio.

Paso 3: Desarrolla tus propias arquitecturas y guías de referencia

El último paso recomendado es compilar tus propios patrones de arquitectura específicos de la empresa para ayudar a tus equipos a estandarizar su enfoque sobre la recuperación ante desastres. La mayoría de los Google Cloud clientes producen una guía para sus equipos de desarrollo que hace coincidir sus expectativas individuales de resiliencia empresarial con las dos categorías principales de situaciones de interrupción en Google Cloud. Esto permite que los equipos clasifiquen con facilidad qué productos habilitados para DR son adecuados en cada nivel de importancia.

Crea lineamientos para productos

La tabla de RTO y RPO de ejemplo anterior es una guía hipotética que detalla qué productos se permitirían de forma predeterminada para cada nivel de importancia. Ten en cuenta que, de forma predeterminada, ciertos productos se identificaron como no adecuados. Siempre puedes agregar tus propios mecanismos de replicación y conmutación por error para habilitar la sincronización entre zonas o regiones, pero este ejercicio está más allá del alcance de este artículo. En las tablas, también encontrarás vínculos a más información sobre cada producto para ayudarte a comprender sus capacidades en relación con la administración de las interrupciones zonales y regionales.

Patrones de arquitectura de muestra para la organización de ejemplo: Resiliencia para las interrupciones zonales:

| Google Cloud Producto | ¿El producto cumple con los requisitos de interrupción zonal para la organización de ejemplo (con la configuración adecuada del producto)? | ||

|---|---|---|---|

| Nivel 1 | Nivel 2 | Nivel 3 | |

| Compute Engine | No | No | No |

| Dataflow | No | No | No |

| BigQuery | No | No | Sí |

| GKE | Sí | Sí | Sí |

| Cloud Storage | Sí | Sí | Sí |

| Cloud SQL | No | Sí | Sí |

| Spanner | Sí | Sí | Sí |

| Cloud Load Balancing | Sí | Sí | Sí |

Esta tabla es un ejemplo basado solo en los niveles hipotéticos descritos con anterioridad.

Patrones de arquitectura de muestra para la organización de ejemplo: Resiliencia para las interrupciones regionales:

| Google Cloud Producto | ¿El producto cumple con los requisitos de interrupción regional para la organización de ejemplo (con la configuración adecuada del producto)? | ||

|---|---|---|---|

| Nivel 1 | Nivel 2 | Nivel 3 | |

| Compute Engine | Sí | Sí | Sí |

| Dataflow | No | No | No |

| BigQuery | No | No | Sí |

| GKE | Sí | Sí | Sí |

| Cloud Storage | No | No | No |

| Cloud SQL | No | Sí | Sí |

| Spanner | Sí | Sí | Sí |

| Cloud Load Balancing | Sí | Sí | Sí |

Esta tabla es un ejemplo basado solo en los niveles hipotéticos descritos con anterioridad.

A fin de mostrar cómo se usarían estos productos, en las siguientes secciones, se explican algunas arquitecturas de referencia para cada uno de los niveles hipotéticos de importancia de la aplicación. Estas son descripciones de alto nivel hechas de manera deliberada para explicar las decisiones clave de la arquitectura y no representan un diseño de solución completo.

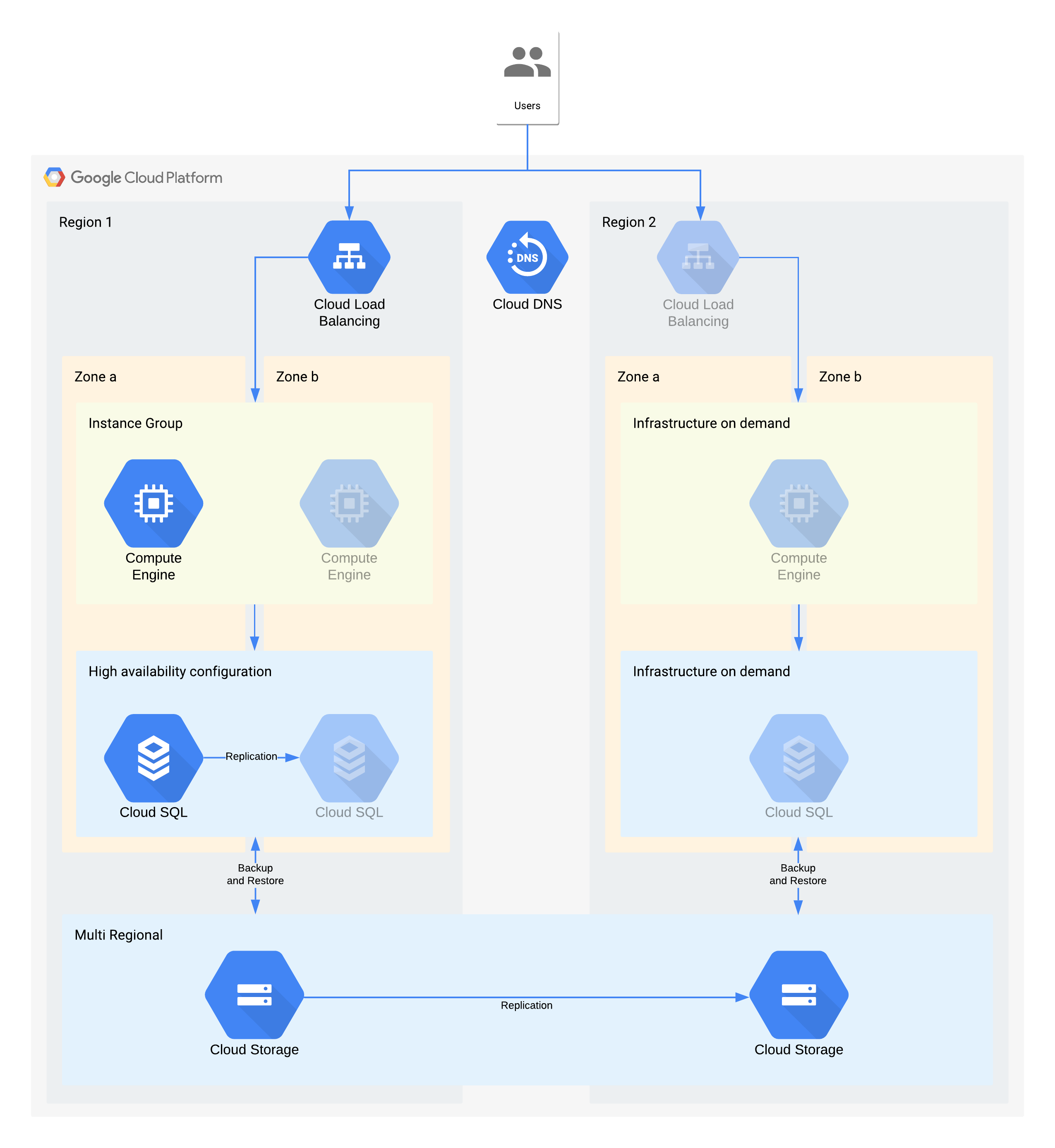

Arquitectura de ejemplo de nivel 3

| Importancia de la aplicación | Interrupción zonal | Interrupción regional |

|---|---|---|

| Nivel 3 (menos importante) |

RTO de 12 horas RPO de 24 horas |

RTO de 28 días RPO de 24 horas |

(Los íconos en gris muestran la infraestructura que se habilitará para permitir la recuperación)

En esta arquitectura, se describe una aplicación tradicional de cliente y servidor: los usuarios internos se conectan a una aplicación que se ejecuta en una instancia de procesamiento respaldada por una base de datos para el almacenamiento continuo.

Es importante tener en cuenta que esta arquitectura admite valores de RTO y RPO superiores a los necesarios. Sin embargo, también debes considerar quitar pasos manuales adicionales cuando podrían resultar costosos o poco confiables. Por ejemplo, recuperar una base de datos a partir de una copia de seguridad nocturna podría admitir el RPO de 24 horas, pero esto suele requerir una persona capacitada, como un administrador de la base de datos que podría no estar disponible, en especial si varios servicios se vieron afectados al mismo tiempo. Con la infraestructura a pedido de Google Cloud, puedes compilar esta capacidad sin hacer una compensación de costo mayor, por lo que esta arquitectura usa la alta disponibilidad de Cloud SQL en lugar de una copia de seguridad o el restablecimiento manual para interrupciones zonales.

Decisiones clave de arquitectura para la interrupción zonal: RTO de 12 horas y RPO de 24 horas:

- Se usa un balanceador de cargas interno para proporcionar un punto de acceso escalable para los usuarios, lo que permite la conmutación por error automática a otra zona. Aunque el RTO es de 12 horas, los cambios manuales en las direcciones IP o incluso las actualizaciones del DNS pueden tardar más tiempo del esperado.

- Un grupo de instancias administrado regional se configura con varias zonas, pero con recursos mínimos. Esto optimiza el costo, pero permite que las máquinas virtuales se escalen horizontalmente con rapidez en la zona de la copia de seguridad.

- Una configuración de Cloud SQL de alta disponibilidad proporciona conmutación por error automática a otra zona. Las bases de datos son mucho más difíciles de volver a crear y restablecer en comparación con las máquinas virtuales de Compute Engine.

Decisiones clave de arquitectura para la interrupción regional: RTO de 28 días y RPO de 24 horas:

- Un balanceador de cargas se construiría en la región 2 solo en caso de que se produzca una interrupción regional. Se usa Cloud DNS para proporcionar una capacidad de conmutación por error regional, organizada y manual, ya que la infraestructura en la región 2 solo estará disponible en caso de que se produzca una interrupción regional.

- Un grupo de instancias administrado nuevo se construiría solo en caso de que se produzca una interrupción regional. Esto optimiza el costo y es poco probable que se invoque debido a la corta duración de la mayoría de las interrupciones regionales. Ten en cuenta que, a fin de simplificar el diagrama, no se muestran ni las herramientas asociadas necesarias para volver a implementar ni la copia de las imágenes de Compute Engine necesarias.

- Se volvería a crear una instancia de Cloud SQL nueva y se restablecerían los datos desde una copia de seguridad. Una vez más, el riesgo de una interrupción prolongada en una región es muy baja, por lo que esta es otra compensación de optimización de costos.

- Se usa Cloud Storage multirregional para almacenar estas copias de seguridad. Esto brinda resiliencia zonal y regional automática dentro de RTO y RPO.

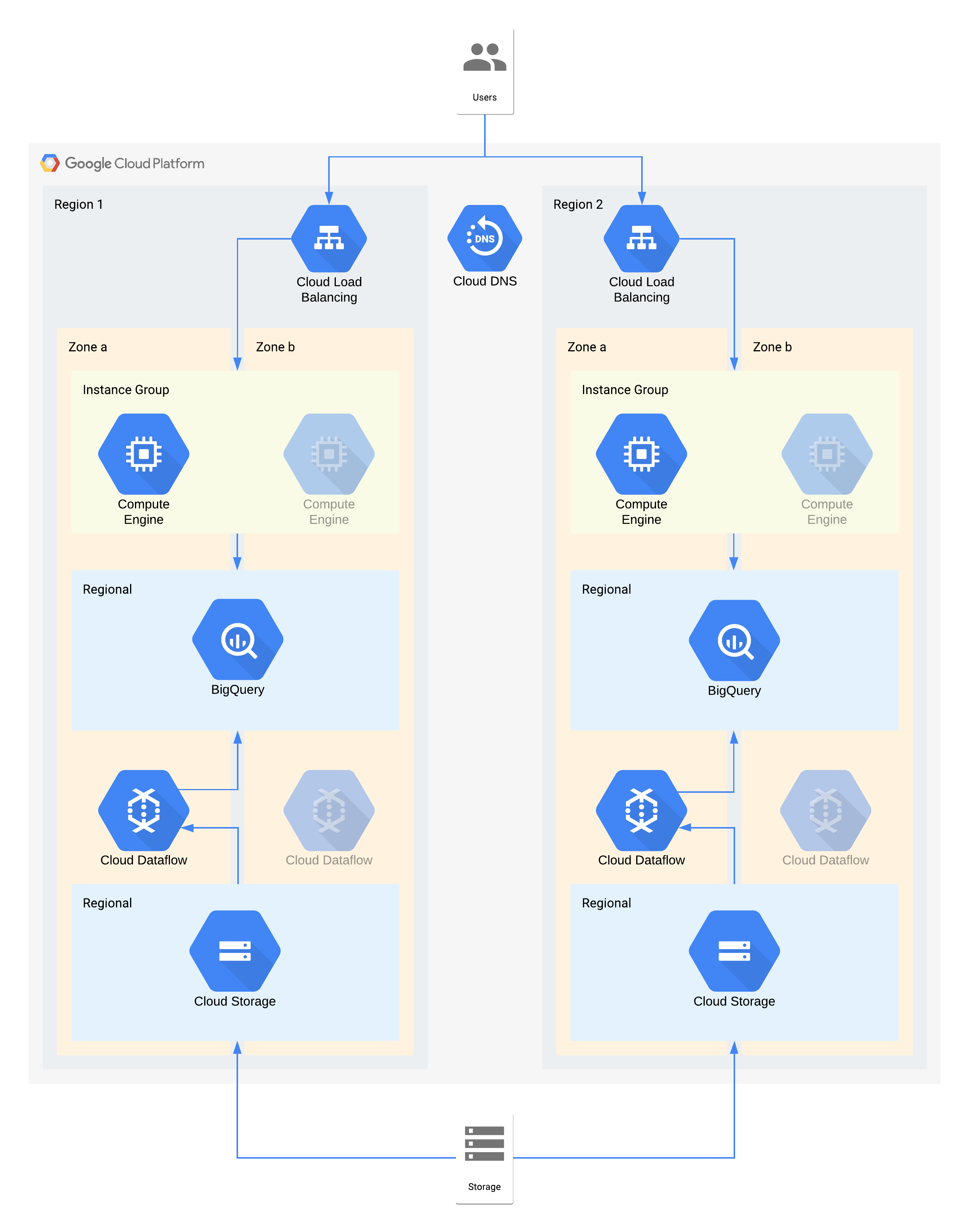

Arquitectura de ejemplo de nivel 2

| Importancia de la aplicación | Interrupción zonal | Interrupción regional |

|---|---|---|

| Nivel 2 | RTO de 4 horas RPO de cero |

RTO de 24 horas RPO de 4 horas |

En esta arquitectura, se describe un almacén de datos con usuarios internos que se conectan a una capa de visualización de instancias de procesamiento, y una capa de transformación y transferencia de datos que propaga el almacén de datos de backend.

Algunos componentes individuales de esta arquitectura directamente no admiten el RPO requerido para su nivel. Sin embargo, debido a cómo se usan en conjunto, el servicio general cumple con el RPO. En este caso, como Dataflow es un producto zonal, sigue las recomendaciones para el diseño de alta disponibilidad a fin de evitar la pérdida de datos durante una interrupción. Sin embargo, la capa de Cloud Storage es la fuente dorada de estos datos y admite un RPO de cero. Como resultado, puedes volver a transferir cualquier dato perdido a BigQuery mediante la zona B en caso de una interrupción en la zona A.

Decisiones clave de arquitectura para la interrupción zonal: RTO de 4 horas y RPO de cero:

- Se usa un balanceador de cargas para proporcionar un punto de acceso escalable para los usuarios, lo que permite la conmutación por error automática a otra zona. Aunque el RTO es de 4 horas, los cambios manuales en las direcciones IP o incluso las actualizaciones del DNS pueden tardar más tiempo del esperado.

- Se configura un grupo de instancias administrado regional para la capa de procesamiento de visualización de datos con varias zonas, pero con recursos mínimos. Esto optimiza el costo, pero permite que las máquinas virtuales se escalen horizontalmente con rapidez.

- Se usa Cloud Storage regional como capa de etapa de pruebas para la transferencia inicial de datos, lo que proporciona resiliencia zonal automática.

- Se usa Dataflow para extraer datos de Cloud Storage y transformarlos antes de cargarlos en BigQuery. En caso de que ocurra una interrupción zonal, este es un proceso sin estado que se puede reiniciar en otra zona.

- BigQuery proporciona el backend del almacén de datos para el frontend de visualización de datos. Si se produce una interrupción zonal, se volverán a transferir los datos que se hayan perdido desde Cloud Storage.

Decisiones clave de arquitectura para la interrupción regional: RTO de 24 horas y RPO de 4 horas:

- Se usa un balanceador de cargas en cada región a fin de proporcionar un punto de acceso escalable para los usuarios. Se usa Cloud DNS para proporcionar capacidad de conmutación por error regional, organizada y manual, ya que la infraestructura en la región 2 solo estará disponible en caso de que se produzca una interrupción regional.

- Se configura un grupo de instancias administrado regional para la capa de procesamiento de visualización de datos con varias zonas, pero con recursos mínimos. No será accesible hasta que se vuelva a configurar el balanceador de cargas. Sin embargo, no se requiere una intervención manual.

- Se usa Cloud Storage regional como capa de etapa de pruebas para la transferencia inicial de datos. Se carga al mismo tiempo en ambas regiones para cumplir con los requisitos de RPO.

- Se usa Dataflow para extraer datos de Cloud Storage y transformarlos antes de cargarlos en BigQuery. Si se produce una interrupción regional, BigQuery se propagaría con los datos más recientes de Cloud Storage.

- BigQuery proporciona el backend del almacén de datos. En las operaciones normales, esto se actualiza de manera intermitente. Si se produce una interrupción regional, se vuelven a transferir los datos más recientes desde Cloud Storage mediante Dataflow.

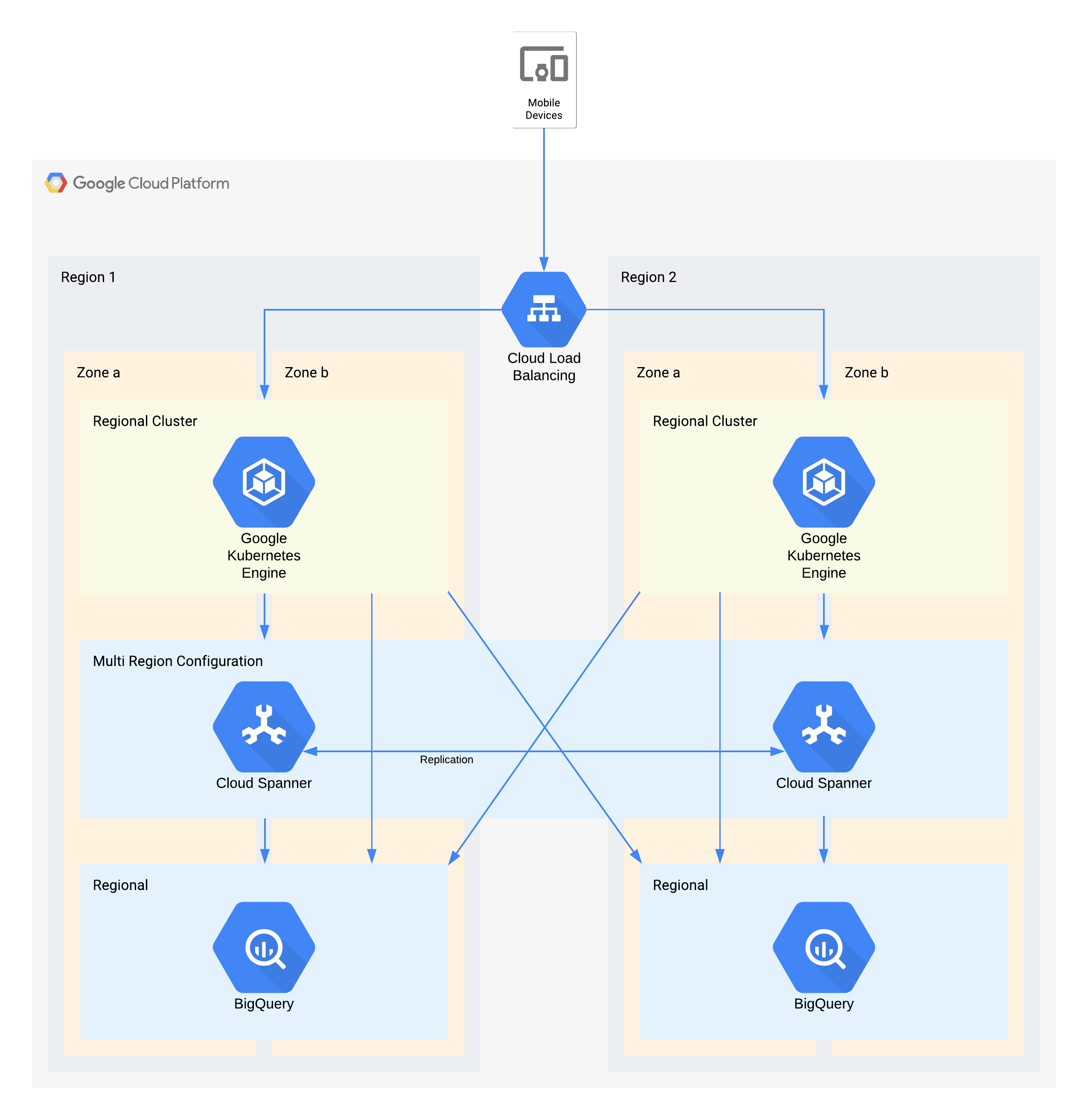

Arquitectura de ejemplo de nivel 1

| Importancia de la aplicación | Interrupción zonal | Interrupción regional |

|---|---|---|

| Nivel 1 (más importante) |

RTO de cero RPO de cero |

RTO de 4 horas RPO de 1 hora |

En esta arquitectura, se describe una infraestructura de backend de apps para dispositivos móviles con usuarios externos que se conectan a un conjunto de microservicios que se ejecutan en GKE. Spanner proporciona la capa de almacenamiento de datos de backend para los datos en tiempo real, y los datos históricos se transmiten a un data lake de BigQuery en cada región.

Otra vez, algunos componentes individuales de esta arquitectura no admiten directamente el RPO requerido para su nivel. Sin embargo, debido a cómo se usan en conjunto, el servicio general sí lo admite. En este caso, BigQuery se usa para consultas analíticas. Cada región recibe datos de forma simultánea desde Spanner.

Decisiones clave de arquitectura para la interrupción zonal: RTO de cero y RPO de cero:

- Se usa un balanceador de cargas para proporcionar un punto de acceso escalable para los usuarios, lo que permite la conmutación por error automática a otra zona.

- Se usa un clúster de GKE regional para la capa de aplicación que se configura con varias zonas. Esto logra el RTO de cero dentro de cada región.

- Se usa Spanner multirregional como capa de persistencia de datos, lo que proporciona resiliencia automática de los datos de la zona y coherencia en la transacción.

- BigQuery proporciona la capacidad de crear estadísticas para la aplicación. Cada región recibe datos provenientes de Spanner de manera independiente y la aplicación accede a ellos de la misma forma.

Decisiones clave de arquitectura para la interrupción regional: RTO de 4 horas y RPO de 1 hora:

- Se usa un balanceador de cargas para proporcionar un punto de acceso escalable para los usuarios, lo que permite la conmutación por error automática a otra región.

- Se usa un clúster de GKE regional para la capa de aplicación que se configura con varias zonas. Si se produce una interrupción regional, el clúster en la región alternativa se escala de manera automática para tomar la carga de procesamiento adicional.

- Se usa Spanner multirregional como capa de persistencia de datos, lo que proporciona resiliencia automática de los datos de la región y coherencia en la transacción. Este es el componente clave para lograr la RPO de 1 hora.

- BigQuery proporciona la capacidad de crear estadísticas para la aplicación. Cada región recibe datos provenientes de Spanner de manera independiente y la aplicación accede a ellos de la misma forma. Esta arquitectura compensa el componente de BigQuery, lo que le permite cumplir con los requisitos generales de la aplicación.

Apéndice: Referencia del producto

En esta sección, se describen la arquitectura y las capacidades de DR de los productos de Google Cloudque se usan con mayor frecuencia en las aplicaciones de los clientes y que se pueden aprovechar con facilidad para cumplir con tus requisitos de DR.

Temas comunes

Muchos productos de Google Cloud ofrecen configuraciones regionales o multirregionales. Los productos regionales son resilientes a las interrupciones zonales, mientras que los productos globales y multirregionales son resilientes a las interrupciones regionales. En general, esto significa que, durante una interrupción, la aplicación experimenta interrupciones mínimas. Google logra estos resultados a través de algunos enfoques arquitectónicos comunes, que reflejan la guía de arquitectura anterior.

Implementación redundante: Los backends de la aplicación y el almacenamiento de datos se implementan en varias zonas dentro de una región y en varias regiones dentro de una ubicación multirregional. Para obtener más información sobre las consideraciones específicas de la región, consulta Geografía y regiones.

Replicación de datos: Los productos usan la replicación síncrona o asíncrona en las ubicaciones redundantes.

La replicación síncrona significa que, cuando tu aplicación realiza una llamada a la API para crear o modificar los datos que almacenó el producto, recibe una respuesta correcta solo una vez que el producto escribió los datos en varias ubicaciones. La replicación síncrona garantiza que no pierdas el acceso a ninguno de tus datos durante una interrupción en la infraestructura de Google Cloud porque todos están disponibles en una de las ubicaciones de backend disponibles.

Aunque esta técnica proporciona la máxima protección de los datos, puede tener compensaciones en términos de latencia y rendimiento. Los productos multirregionales que usan la replicación síncrona experimentan esta compensación de manera más significativa, por lo general, en décimas o centésimas de milisegundos de latencia adicional.

La replicación asíncrona significa que, cuando tu aplicación realiza una llamada a la API para crear o modificar los datos que almacenó el producto, recibe una respuesta correcta una vez que el producto escribió los datos en una sola ubicación. Luego de la solicitud de escritura, el producto replica los datos en ubicaciones adicionales.

Esta técnica proporciona una latencia menor y una capacidad de procesamiento más alta en la API que la replicación síncrona, pero a expensas de la protección de los datos. Si la ubicación en la que escribiste los datos sufre una interrupción antes de que se complete la replicación, perderás el acceso a esos datos hasta que la interrupción en la ubicación se resuelva.

Controla las interrupciones con el balanceo de cargas: Google Cloud usa el balanceo de cargas de software para enrutar las solicitudes a los backends de aplicaciones adecuados. En comparación con otros enfoques como el balanceo de cargas de DNS, este enfoque reduce el tiempo de respuesta del sistema a una interrupción. Cuando se produce una Google Cloud interrupción en la ubicación, el balanceador de cargas detecta rápidamente que el backend implementado en esa ubicación se encuentra “en mal estado” y dirige todas las solicitudes a un backend en una ubicación alternativa. Esto permite que el producto siga entregando las solicitudes de tu aplicación durante una interrupción en la ubicación. Cuando se resuelve la interrupción en la ubicación, el balanceador de cargas detecta la disponibilidad de los backends del producto en esa ubicación y reanuda el envío de tráfico hacia allí.

Access Context Manager

Access Context Manager permite a las empresas configurar niveles de acceso que se asignan a una política que se define en los atributos de la solicitud. Las políticas se duplican de forma regional.

En el caso de una interrupción zonal, las solicitudes a zonas no disponibles se entregan de forma automática y transparente desde otras zonas disponibles en la región.

En el caso de una interrupción regional, los cálculos de políticas de la región afectada no estarán disponibles hasta que la región vuelva a estar disponible.

Transparencia de acceso

La Transparencia de acceso permite a los administradores de la organización Google Cloud definir un control de acceso detallado basado en atributos para proyectos y recursos en Google Cloud. En ocasiones, Google debe acceder a los datos de los clientes con fines administrativos. Cuando accedemos a los datos de los clientes, la Transparencia de acceso proporciona registros de acceso a los clientes afectados de Google Cloud. Estos registros de Transparencia de acceso ayudan a garantizar el compromiso de Google con la seguridad y la transparencia de los datos en el control de datos.

La Transparencia de acceso es resistente a las interrupciones zonales y regionales. Si ocurre una interrupción zonal o regional, la Transparencia de acceso continúa procesando registros de acceso administrativos en otra zona o región.

AlloyDB para PostgreSQL

AlloyDB para PostgreSQL es un servicio de base de datos completamente administrado y compatible con PostgreSQL. AlloyDB para PostgreSQL ofrece alta disponibilidad en una región a través de los nodos redundantes de su instancia principal que se encuentran en dos zonas diferentes de la región. La instancia principal mantiene la disponibilidad regional mediante la activación de una conmutación por error automática a la zona en espera si la zona activa encuentra un problema. Regional Storage garantiza la durabilidad de los datos en caso de pérdida de una zona.

Como método adicional de recuperación ante desastres, AlloyDB para PostgreSQL usa la replicación entre regiones a fin de proporcionar capacidades de recuperación ante desastres mediante la replicación asíncrona de los datos de tu clúster principal en clústeres secundarios ubicados en regiones Google Cloud separadas.

Interrupción zonal: Durante el funcionamiento normal, solo uno de los dos nodos de una instancia principal de alta disponibilidad está activo y entrega todas las escrituras de datos. Este nodo activo almacena los datos en la capa de almacenamiento regional independiente del clúster.

AlloyDB para PostgreSQL detecta de forma automática las fallas a nivel de zona y activa una conmutación por error para restablecer la disponibilidad de la base de datos. Durante la conmutación por error, AlloyDB para PostgreSQL inicia la base de datos en el nodo en espera, que ya está aprovisionada en una zona diferente. Las conexiones de bases de datos nuevas se enrutan de forma automática a esta zona.

Desde la perspectiva de una aplicación cliente, una interrupción zonal se parece a una interrupción temporal de la conectividad de red. Una vez que se completa la conmutación por error, un cliente puede volver a conectarse a la instancia en la misma dirección mediante las mismas credenciales, sin pérdida de datos.

Interrupción regional: La replicación entre regiones usa la replicación asíncrona, que permite que la instancia principal confirme las transacciones antes de que se confirmen en las réplicas. La diferencia de tiempo entre el momento en que una transacción se confirma en la instancia principal y en que se confirma en la réplica se conoce como demora de replicación. La diferencia de tiempo entre el momento en que la instancia principal genera el registro de escritura anticipada (WAL) y el momento en que este llega a la réplica se conoce como demora de vaciado. El retraso de replicación y el retraso de vaciado dependen de la configuración de la instancia de la base de datos y de la carga de trabajo generada por el usuario.

Si se produce una interrupción regional, puedes ascender clústeres secundarios en una región diferente a un clúster principal independiente que admite escritura. Este clúster promocionado ya no replica los datos del clúster principal original con el que estaba asociado antes. Debido al retraso de vaciado, puede que se pierdan datos, ya que podría haber transacciones en la instancia principal original que no se propagaron al clúster secundario.

El RPO de replicación entre regiones se ve afectado por el uso de CPU del clúster principal y la distancia física entre la región del clúster principal y la región del clúster secundario. A fin de optimizar el RPO, recomendamos probar la carga de trabajo con una configuración que incluya una réplica para establecer un límite seguro de transacciones por segundo (TPS), que es el TPS continuo más alto que no acumula demora de vaciado. Si la carga de trabajo excede el límite seguro de TPS, la demora de vaciado se acumula, lo que puede afectar el RPO. Para limitar el retraso de la red, elige pares de regiones dentro del mismo continente.

Para obtener más información sobre la supervisión del retraso de la red y otras métricas de AlloyDB para PostgreSQL, consulta Supervisa instancias.

IA para prevención del lavado de dinero

La IA para la prevención del lavado de dinero (AML AI) proporciona una API para ayudar a las instituciones financieras globales a detectar de manera más eficaz y eficiente el lavado de dinero. La IA para la prevención del lavado de dinero es una oferta regional, lo que significa que los clientes pueden elegir la región, pero no las zonas que la conforman. Las cargas de los datos y el tráfico se balancean de forma automática entre zonas de una región. Las operaciones (por ejemplo, para crear una canalización o ejecutar una predicción) se escalan de forma automática en segundo plano y se balancean las cargas entre las zonas según sea necesario.

Interrupción zonal: AML AI almacena los datos para sus recursos de forma regional, replicados de forma síncrona. Cuando una operación de larga duración finaliza de forma correcta, se puede confiar en los recursos, sin importar las fallas zonales. El procesamiento también se replica entre zonas, pero el objetivo es la replicación en un balanceo de cargas y no una alta disponibilidad, por lo que una falla zonal durante una operación puede provocar un error en la operación. Si eso sucede, reintentar la operación puede solucionar el problema. Durante una interrupción zonal, los tiempos de procesamiento pueden verse afectados.

Interrupción regional: Los clientes eligen la región de Google Cloud en la que desean crear sus recursos de AML AI. Los datos nunca se replican en otras regiones. AML AI nunca enruta el tráfico del cliente a una región diferente. En el caso de una falla regional, Cloud Run volverá a estar disponible en cuanto se resuelva la interrupción.

Claves de API

Las claves de API proporcionan una administración de recursos escalable para las claves de API de un proyecto. Las claves de API son un servicio global, lo que significa que se pueden ver y acceder a ellas desde cualquier ubicación de Google Cloud . Sus datos y metadatos se almacenan de manera redundante en varias zonas y regiones.

Las claves de API son resilientes a las interrupciones zonales y regionales. En el caso de una interrupción zonal o regional, las claves de API continúan entregando solicitudes desde otra zona en la misma región o en región diferente.

Para obtener más información sobre las claves de API, consulta Descripción general de las claves de API.

Apigee

Apigee proporciona una plataforma segura, escalable y confiable para desarrollar y administrar APIs. Apigee ofrece implementaciones tanto en una sola región como en varias regiones.

Interrupción zonal: Los datos de tiempo de ejecución del cliente se replican en varias zonas de disponibilidad. Por lo tanto, una interrupción en una sola zona no afecta a Apigee.

Interrupción regional: En el caso de las instancias de Apigee de una sola región, si una región deja de funcionar, las instancias de Apigee no estarán disponibles en esa región y no se podrán restablecer en otras regiones. En el caso de las instancias de Apigee multirregionales, los datos se replican de forma asíncrona en todas las regiones. Por lo tanto, la falla de una región no reduce el tráfico por completo. Sin embargo, es posible que no puedas acceder a los datos no confirmados en la región con errores. Puedes desviar el tráfico de las regiones en mal estado. Para lograr una conmutación por error automática del tráfico, puedes configurar el enrutamiento de red con grupos de instancias administrados (MIG).

AutoML Translation

AutoML Translation es un servicio de traducción automática que te permite importar tus propios datos (pares de oraciones) a fin de entrenar modelos personalizados para tus necesidades específicas del dominio.

Interrupción zonal: AutoML Translation tiene servidores de procesamiento activos en varias zonas y regiones. También admite la replicación de datos síncrona entre zonas dentro de las regiones. Estas características ayudan a AutoML Translation a lograr una conmutación por error instantánea sin perder datos para las fallas zonales y sin la necesidad de entradas o ajustes de los clientes.

Interrupción regional: En el caso de una falla regional, AutoML Translation no está disponible.

AutoML Vision

AutoML Vision forma parte de Vertex AI. Ofrece un marco de trabajo unificado para crear conjuntos de datos, importar datos, entrenar modelos y publicarlos para la predicción en línea y la predicción por lotes.

AutoML Vision es una oferta regional. Los clientes pueden elegir la región desde la que quieren iniciar un trabajo, pero no pueden elegir las zonas específicas dentro de esa región. El servicio balancea automáticamente las cargas de trabajo en diferentes zonas dentro de la región.

Interrupción zonal: AutoML Vision almacena los metadatos de los trabajos de forma regional y escribe de forma síncrona en las zonas dentro de la región. Los trabajos se inician en una zona específica, según la selección de Cloud Load Balancing.

Trabajos de entrenamiento de AutoML Vision: Una interrupción zonal provoca que fallen todos los trabajos en ejecución y que el estado del trabajo se actualice a con errores. Si un trabajo falla, vuelve a intentarlo de inmediato. El trabajo nuevo se enruta a una zona disponible.

Trabajos de predicción por lotes de AutoML Vision: La predicción por lotes se basa en la predicción por lotes de Vertex AI. Cuando se produce una interrupción zonal, el servicio vuelve a intentar el trabajo de forma automática y lo enruta a las zonas disponibles. Si varios reintentos fallan, el estado del trabajo se actualiza a con errores. Las solicitudes posteriores de los usuarios para ejecutar el trabajo se enrutan a una zona disponible.

Interrupción regional: Los clientes eligen la Google Cloud región en la que desean ejecutar sus trabajos. Los datos nunca se replican en otras regiones. En el caso de una falla regional, el servicio de AutoML Vision no está disponible en esa región. Volverá a estar disponible cuando se resuelva la interrupción. Recomendamos que los clientes usen varias regiones para ejecutar sus trabajos. En caso de que se produzca una interrupción regional, dirige los trabajos a una región disponible diferente.

Lote

Batch es un servicio completamente administrado que permite poner en cola, programar y ejecutar trabajos por lotes en Google Cloud. La configuración de los lotes se define a nivel de la región. Los clientes deben elegir una región para enviar sus trabajos por lotes, no una zona en una región. Cuando se envía un trabajo, Batch escribe datos de clientes de forma síncrona en múltiples zonas. Sin embargo, los clientes pueden especificar las zonas en las que las VMs de Batch ejecutan trabajos.

Falla zonal: Cuando una sola zona falla, las tareas que se ejecutan en esa zona también fallan. Si las tareas tienen una configuración de reintento, Batch realiza la conmutación por error automáticamente en otras zonas activas de la misma región. La conmutación por error automática está sujeta a la disponibilidad de recursos en zonas activas de la misma región. Los trabajos que requieren recursos zonales (como VMs, GPU o discos persistentes zonales) y que solo están disponibles en la zona con errores, se ponen en cola hasta que la zona con errores se recupera o hasta que se alcanza el tiempo de espera de la cola de los trabajos. Cuando sea posible, recomendamos que los clientes permitan que Batch elija recursos zonales para ejecutar sus trabajos. Esto ayuda a garantizar que los trabajos sean resistentes a una interrupción zonal.

Falla regional: En caso de una falla regional, el plano de control del servicio no está disponible en la región. El servicio no replica datos ni redirecciona solicitudes en todas las regiones. Recomendamos que los clientes usen varias regiones para ejecutar sus trabajos y redireccionar los trabajos a una región diferente si una región falla.

Protección de datos y contra amenazas de Chrome Enterprise Premium

La protección de datos y contra amenazas de Chrome Enterprise Premium forma parte de la solución Chrome Enterprise Premium. Extiende Chrome con una variedad de funciones de seguridad, como protección contra software malicioso y phishing, Prevención de pérdida de datos (DLP), informes de seguridad y reglas de filtrado de URL.

Los administradores de Chrome Enterprise Premium pueden habilitar el almacenamiento del contenido principal del cliente que incumpla las políticas de DLP o de software malicioso en los eventos de registro de reglas de Google Workspace o en Cloud Storage para su investigación futura. Los eventos de registro de reglas de Google Workspace se basan en una base de datos de Spanner multirregional. Chrome Enterprise Premium puede tardar varias horas en detectar incumplimientos de políticas. Durante este período, los datos sin procesar están sujetos a la pérdida de datos debido a una interrupción zonal o regional. Una vez que se detecta un incumplimiento, el contenido que incumple tus políticas se escribe en los eventos de registro de reglas de Google Workspace o en Cloud Storage.

Interrupción zonal y regional: Dado que la protección contra amenazas y de datos de Chrome Enterprise Premium es multizonal y multirregional, puede sobrevivir a una pérdida completa e imprevista de una zona o una región sin pérdida de disponibilidad. Proporciona este nivel de confiabilidad redireccionando el tráfico a su servicio en otras zonas o regiones activas. Sin embargo, debido a que la protección de datos y contra amenazas de Chrome Enterprise Premium puede tardar varias horas en detectar incumplimientos de DLP y software malicioso, los datos sin procesar en una zona o región específica están sujetos a pérdida por una interrupción zonal o regional.

BigQuery

BigQuery es un almacén de datos en la nube sin servidores, rentable y altamente escalable, diseñado para lograr agilidad empresarial. BigQuery es compatible con los siguientes tipos de ubicaciones para conjuntos de datos del usuario:

- Una región: una ubicación geográfica específica, como Iowa (

us-central1) o Montreal (northamerica-northeast1). - Una multirregión: un área geográfica grande que contiene dos o más lugares geográficos, como los Estados Unidos (

US) o Europa (EU).

En cualquier caso, los datos se almacenan de manera redundante en dos zonas dentro de una sola región de la ubicación seleccionada. Los datos escritos en BigQuery se escriben en las zonas principal y secundaria. Esto protege contra la falta de disponibilidad de una zona única dentro de la región, pero no contra una interrupción regional.

Autorización binaria

La autorización binaria es un producto de seguridad de la cadena de suministro de software para GKE y Cloud Run.

Todas las políticas de autorización binaria se replican en varias zonas dentro de cada región. La replicación ayuda a las operaciones de lectura de la política de autorización binaria a recuperarse de fallas de otras regiones. La replicación también hace que las operaciones de lectura sean tolerantes a fallas zonales dentro de cada región.

Las operaciones de aplicación de la autorización binaria son resilientes ante las interrupciones zonales, pero no son resilientes ante las interrupciones regionales. Las operaciones de aplicación se ejecutan en la misma región que el clúster de GKE o el trabajo de Cloud Run que realiza la solicitud. Por lo tanto, en el caso de una interrupción regional, no hay nada en ejecución para realizar solicitudes de aplicación de la autorización binaria.

Administrador de certificados

El Administrador de certificados te permite adquirir y administrar certificados de seguridad de la capa de transporte (TLS) para usarlos con diferentes tipos de Cloud Load Balancing.

En el caso de una interrupción zonal, el Administrador de certificados regional y global es resistente a las fallas zonales porque los trabajos y las bases de datos son redundantes en varias zonas dentro de una región. En el caso de una interrupción regional, el Administrador de certificados global es resistente a las fallas regionales porque los trabajos y las bases de datos son redundantes en varias regiones. El Administrador de certificados regional es un producto regional, por lo que no puede resistir una falla regional.

Sistema de detección de intrusiones de Cloud

El Sistema de detección de intrusiones de Cloud (IDS de Cloud) es un servicio zonal que proporciona extremos de IDS con alcance zonal, que procesan el tráfico de las VMs en una zona específica y, por lo tanto, no tolera las interrupciones zonales o regionales.

Interrupción zonal: IDS de Cloud está vinculado a instancias de VM. Si un cliente planea mitigar las interrupciones zonales mediante la implementación de VMs en varias zonas (de forma manual o a través de grupos de instancias administrados regionales), también deberá implementar extremos de IDS de Cloud en esas zonas.

Interrupción regional: IDS de Cloud es un producto regional. No proporciona ninguna funcionalidad entre regiones. Una falla regional inhabilitará todas las funciones de IDS de Cloud en todas las zonas de esa región.

Google Security Operations SIEM

Google Security Operations SIEM (que forma parte de Google Security Operations) es un servicio completamente administrado que ayuda a los equipos de seguridad a detectar amenazas, investigarlas y responder a ellas.

Google Security Operations SIEM tiene ofertas regionales y multirregionales.

En las ofertas regionales, las cargas de los datos y el tráfico se balancean automáticamente entre las zonas de la región elegida, y los datos se almacenan de manera redundante en todas las zonas de disponibilidad dentro de la región.

Las multirregiones tienen redundancia geográfica. Esa redundancia proporciona un conjunto más amplio de protecciones que el almacenamiento regional. También ayuda a garantizar que el servicio siga funcionando incluso si se pierde una región completa.

La mayoría de las rutas de transferencia de datos replican los datos del cliente de forma síncrona en varias ubicaciones. Cuando los datos se replican de forma asíncrona, hay un período (un objetivo de punto de recuperación o RPO) durante el cual los datos aún no se replican en varias ubicaciones. Este es el caso cuando se realiza la transferencia con feeds en implementaciones multirregionales. Después del RPO, los datos están disponibles en varias ubicaciones.

Interrupción zonal:

Implementaciones regionales: Las solicitudes se entregan desde cualquier zona dentro de la región. Los datos se replican de forma síncrona en varias zonas. En caso de una interrupción en la zona completa, las zonas restantes continúan entregando el tráfico y procesando los datos. El aprovisionamiento redundante y el ajuste de escala automático para el SIEM de Operaciones de seguridad de Google ayudan a garantizar que el servicio permanezca operativo en las zonas restantes durante estos cambios de carga.

Implementaciones multirregionales: Las interrupciones zonales son equivalentes a las interrupciones regionales.

Interrupción regional:

Implementaciones regionales: Google Security Operations SIEM almacena todos los datos del cliente en una sola región y el tráfico nunca se enruta entre regiones. En el caso de una interrupción regional, el SIEM de Google Security Operations no estará disponible en la región hasta que se resuelva la interrupción.

Implementaciones multirregionales (sin feeds): Las solicitudes se entregan desde cualquier región de la implementación multirregional. Los datos se replican de forma síncrona en varias regiones. En caso de una interrupción en la región completa, las regiones restantes continúan entregando tráfico y procesando los datos. El aprovisionamiento redundante y el ajuste de escala automático para Google Security Operations SIEM ayudan a garantizar que el servicio permanezca operativo en las regiones restantes durante estos cambios de carga.

Implementaciones multirregionales (con feeds): Las solicitudes se entregan desde cualquier región de la implementación multirregional. Los datos se replican de forma asíncrona en varias regiones con el RPO proporcionado. En caso de una interrupción en toda la región, solo los datos almacenados después del RPO estarán disponibles en las regiones restantes. Es posible que no se repliquen los datos dentro del período del RPO.

Cloud Asset Inventory

Cloud Asset Inventory es un servicio global, resiliente y de alto rendimiento que mantiene un repositorio de Google Cloud metadatos de recursos y políticas. Cloud Asset Inventory proporciona herramientas de búsqueda y análisis que te ayudan a realizar un seguimiento de los elementos implementados en organizaciones, carpetas y proyectos.

En el caso de una interrupción zonal, Cloud Asset Inventory continúa entregando solicitudes desde otra zona en la misma región o en una diferente.

En el caso de una interrupción regional, Cloud Asset Inventory continúa entregando solicitudes desde otras regiones.

Bigtable

Bigtable es un servicio de base de datos NoSQL de alto rendimiento completamente administrado para grandes cargas de trabajo estadísticas y operativas.

Descripción general de la replicación de Bigtable

Bigtable ofrece una función de replicación flexible y completamente configurable que puedes usar para aumentar la disponibilidad y la durabilidad de los datos si los copias en clústeres desde varias regiones o varias zonas dentro de la misma región. Bigtable también puede proporcionar una conmutación por error automática para tus solicitudes cuando usas la replicación.

Cuando se usan configuraciones multizonales o multirregionales con el enrutamiento de varios clústeres, en el caso de una interrupción zonal o regional, Bigtable redirige automáticamente el tráfico y entrega solicitudes desde el clúster disponible más cercano. Debido a que la replicación de Bigtable es asíncrona y tiene coherencia eventual, los cambios muy recientes en los datos en la ubicación de la interrupción podrían no estar disponibles si aún no se replicaron en otras ubicaciones.

Consideraciones de rendimiento

Cuando las demandas de recursos de CPU superan la capacidad del nodo disponible, Bigtable siempre prioriza la entrega de solicitudes entrantes antes que el tráfico de replicación.

Si quieres obtener más información sobre cómo usar la replicación de Bigtable con tu carga de trabajo, consulta la descripción general de la replicación de Cloud Bigtable y los ejemplos de configuración de replicación.

Los nodos de Bigtable se usan para entregar solicitudes entrantes y realizar la replicación de datos de otros clústeres. Además de mantener cantidades suficientes de nodos por clúster, también debes asegurarte de que tus aplicaciones usen un diseño de esquema adecuado para evitar hotspots, que puede causar un uso de CPU excesivo o desequilibrado y mayor latencia de replicación.

Si deseas obtener más información sobre cómo diseñar el esquema de tu aplicación para maximizar el rendimiento y la eficiencia de Bigtable, consulta Prácticas recomendadas para el diseño de esquemas.

Supervisión

Bigtable proporciona varias formas de supervisar de forma visual la latencia de replicación de tus instancias y clústeres con los gráficos para la replicación disponibles en la Google Cloud console.

También puedes supervisar las métricas de replicación de Bigtable de manera programática mediante la API de Cloud Monitoring.

Certificate Authority Service

Certificate Authority Service (servicio de CA) permite que los clientes simplifiquen, automaticen y personalicen la implementación, la administración y la seguridad de las autoridades certificadoras (CA) privadas y que emitan certificados a gran escala de forma resiliente.

Interrupción zonal: El servicio de CA es resistente a las fallas zonales porque su plano de control es redundante en varias zonas dentro de una región. Si hay una interrupción zonal, el servicio de CA continúa entregando solicitudes desde otra zona en la misma región sin interrupción. Debido a que los datos se replican de forma síncrona, no hay pérdida ni corrupción de datos.

Interrupción regional: El servicio de CA es un producto regional, por lo que no puede resistir una falla regional. Si necesitas resiliencia ante fallas regionales, crea CA de emisión en dos regiones diferentes. Crea la CA emisora principal en la región en la que necesitas certificados. Crea una CA de resguardo en una región diferente. Usa el resguardo cuando la región de la CA subordinada principal tenga una interrupción. Si es necesario, ambas CA pueden encadenar hasta la misma CA raíz.

Facturación de Cloud

La API de Cloud Billing permite a los desarrolladores administrar la facturación de sus proyectos deGoogle Cloud de manera programática. La API de Cloud Billing está diseñada como un sistema global con actualizaciones escritas de forma síncrona en varias zonas y regiones.

Falla zonal o regional: La API de Cloud Billing conmutará por error de forma automática a otra zona o región. Las solicitudes individuales pueden fallar, pero una política de reintento debe permitir que los intentos posteriores tengan éxito.

Cloud Build

Cloud Build es un servicio que ejecuta tus compilaciones en Google Cloud.

Cloud Build está compuesto por instancias regionalmente aisladas que replican datos de forma síncrona en todas las zonas de la región. Te recomendamos que uses regiones Google Cloud específicas en lugar de la región global y te asegures de que los recursos que usa tu compilación (incluidos los buckets de registros, los repositorios de Artifact Registry, etcétera) estén alineados con la región en la que se ejecuta tu compilación.

En el caso de una interrupción zonal, las operaciones del plano de control no se ven afectadas. Sin embargo, las compilaciones que se ejecutan actualmente dentro de la zona con errores se retrasarán o se perderán de forma permanente. Las compilaciones activadas recientemente se distribuirán de forma automática a las zonas de funcionamiento restantes.

En el caso de una falla regional, el plano de control estará sin conexión y las compilaciones que se encuentran en ejecución se retrasarán o se perderán de forma permanente. Los activadores, los grupos de trabajadores y los datos de compilación nunca se replican en otras regiones. Te recomendamos que prepares activadores y grupos de trabajadores en varias regiones para facilitar la mitigación de una interrupción.

Cloud CDN

Cloud CDN distribuye y almacena en caché contenido en muchas ubicaciones de la red de Google a fin de reducir la latencia de entrega para los clientes. El contenido almacenado en caché se entrega en función del mejor esfuerzo: cuando la caché de Cloud CDN no puede entregar una solicitud, la solicitud se reenvía a los servidores de origen, como las VM de backend o los buckets de Cloud Storage, donde se almacena el contenido original.

Cuando falla una zona o región, las memorias caché de las ubicaciones afectadas no están disponibles. Las solicitudes entrantes se enrutan a las ubicaciones perimetrales y las cachés de Google disponibles. Si estas memorias caché no pueden entregar la solicitud, reenviarán la solicitud a un servidor de origen disponible. Siempre que el servidor pueda entregar la solicitud con datos actualizados, no habrá pérdida de contenido. Una mayor tasa de errores de caché hará que los servidores de origen experimenten un volumen de tráfico mayor que el normal a medida que se llenan las memorias caché. Las solicitudes posteriores se entregan desde las memorias caché que no se ven afectadas por la interrupción de la zona o la región.

Para obtener más información sobre Cloud CDN y el comportamiento de la caché, consulta la documentación de Cloud CDN.

Cloud Composer

Cloud Composer es un servicio de organización de flujo de trabajo administrado que te permite crear, programar, supervisar y administrar flujos de trabajo que abarcan nubes y centros de datos locales. Los entornos de Cloud Composer se compilan en el proyecto de código abierto de Apache Airflow.

La disponibilidad de la API de Cloud Composer no se ve afectada por la falta de disponibilidad zonal. Durante una interrupción zonal, conservas el acceso a la API de Cloud Composer, incluida la capacidad de crear entornos nuevos de Cloud Composer.

Un entorno de Cloud Composer tiene un clúster de GKE como parte de su arquitectura. Durante una interrupción zonal, se pueden interrumpir los flujos de trabajo en el clúster:

- En Cloud Composer 1, el clúster del entorno es un recurso zonal, por lo que una interrupción zonal puede hacer que el clúster deje de estar disponible. Es posible que los flujos de trabajo que se ejecutan al momento de la interrupción se detengan antes de completarse.

- En Cloud Composer 2, el clúster del entorno es un recurso regional. Sin embargo, los flujos de trabajo que se ejecutan en nodos en las zonas que se ven afectadas por una interrupción zonal pueden detenerse antes de completarse.

En ambas versiones de Cloud Composer, una interrupción zonal puede hacer que los flujos de trabajo ejecutados de forma parcial dejen de ejecutarse, incluidas las acciones externas que configuraste para que realice el flujo de trabajo. Según el flujo de trabajo, esto puede causar inconsistencias externas, por ejemplo, si el flujo de trabajo se detiene en la mitad de una ejecución de varios pasos para modificar los almacenes de datos externos. Por lo tanto, debes considerar el proceso de recuperación cuando diseñes tu flujo de trabajo de Airflow, incluido cómo detectar estados de flujos de trabajo ejecutados de manera parcial y reparar cualquier cambio parcial en los datos.

En Cloud Composer 1, durante una interrupción zonal, puedes elegir iniciar un entorno de Cloud Composer nuevo en otra zona. Debido a que Airflow mantiene el estado de los flujos de trabajo en su base de datos de metadatos, la transferencia de esta información a un entorno de Cloud Composer nuevo puede tomar pasos adicionales y preparación.

En Cloud Composer 2, puedes abordar las interrupciones zonales mediante la configuración de la recuperación ante desastres con instantáneas de entorno con anticipación. Durante una interrupción zonal, puedes cambiar a otro entorno si transfieres el estado de tus flujos de trabajo con una instantánea de entorno. Solo Cloud Composer 2 admite la recuperación ante desastres con instantáneas de entorno.

Cloud Data Fusion

Cloud Data Fusion es un servicio de integración de datos empresariales completamente administrado para compilar y administrar canalizaciones de datos con rapidez. Proporciona tres ediciones.

Las interrupciones zonales afectan las instancias de la edición Developer.

Las interrupciones regionales afectan las instancias de las ediciones Basic y Enterprise.

Para controlar el acceso a los recursos, puedes diseñar y ejecutar canalizaciones en entornos independientes. Esta separación te permite diseñar una canalización una vez y, luego, ejecutarla en varios entornos. Puedes recuperar canalizaciones en ambos entornos. Para obtener más información, consulta Crea una copia de seguridad y restablece los datos de las instancias.

Los siguientes consejos se aplican a las interrupciones regionales y zonales.

Interrupciones en el entorno de diseño de la canalización

En el entorno de diseño, guarda borradores de las canalizaciones en caso de una interrupción. Según los requisitos específicos de RTO y RPO, puedes usar los borradores guardados para restablecer la canalización en una instancia de Cloud Data Fusion diferente durante una interrupción.

Interrupciones en el entorno de ejecución de la canalización

En el entorno de ejecución, inicia la canalización de forma interna con los activadores o los programas de Cloud Data Fusion o de forma externa con herramientas de organización, como Cloud Composer. Para poder recuperar las opciones de configuración del entorno de ejecución de las canalizaciones, crea una copia de seguridad de estas y de los parámetros de configuración, como los complementos y los programas. En una interrupción, puedes usar la copia de seguridad para replicar una instancia en una región o una zona no afectadas.

Otra forma de prepararse para las interrupciones es tener varias instancias en las regiones con la misma configuración y el mismo conjunto de canalizaciones. Si usas una organización externa, se pueden balancear las cargas de las canalizaciones en ejecución de forma automática entre las instancias. Ten especial cuidado para asegurarte de que no hayan recursos (como fuentes de datos o herramientas de organización) vinculados a una sola región y que usen todas las instancias, ya que esto podría convertirse en un punto central de falla en una interrupción. Por ejemplo, puedes tener varias instancias en diferentes regiones y usar Cloud Load Balancing y Cloud DNS para dirigir las solicitudes de ejecución de canalización a una instancia que no se ve afectada por una interrupción (consulta las arquitecturas de nivel uno y de nivel tres de ejemplo).

Interrupciones de otros servicios de datos de Google Cloud en la canalización

Tu instancia puede usar otros Google Cloud servicios como fuentes de datos o entornos de ejecución de canalizaciones, como Dataproc, Cloud Storage o BigQuery. Esos servicios pueden estar en diferentes regiones. Cuando se requiere una ejecución interregional, una falla en cualquiera de las regiones genera una interrupción. En esta situación, sigue los pasos para la recuperación ante desastres estándar y ten en cuenta que la configuración interregional con servicios esenciales en diferentes regiones es menos resiliente.

Cloud Deploy

Cloud Deploy proporciona entrega continua de cargas de trabajo en servicios de entorno de ejecución, como GKE y Cloud Run. El servicio consta de instancias regionales que replican datos de forma síncrona en todas las zonas de la región.