Ein Dataset enthält repräsentative Beispiele für den Inhaltstyp, den Sie mit Labels versehen möchten. Außerdem enthält es die Labels des Begrenzungsrahmens, die Ihr Modell verwenden soll. Das Dataset dient als Eingabe zum Trainieren eines Modells.

Die wesentlichen Schritte zum Erstellen eines Datasets sind:

- Erstellen Sie ein Dataset und geben Sie an, ob für jedes Element mehrere Labels zulässig sein sollen.

- Sie importieren Datenelemente in das Dataset.

Achten Sie vor dem Training darauf, dass Sie Ihre Daten vor dem Training des Modells vorbereiten.

Ein Projekt kann mehrere Datasets enthalten, die jeweils zum Trainieren eines separaten Modells verwendet werden. Sie können eine Liste der verfügbaren Datasets abrufen und nicht mehr benötigte Datasets löschen.

Dataset erstellen

Der erste Schritt zum Erstellen eines Modells besteht darin, ein leeres Dataset zu erstellen, das mit den Trainingsdaten für das Modell gefüllt wird.

Web-UI

Mit der AutoML Video Object Tracking-UI können Sie ein neues Dataset erstellen und Elemente von derselben Seite in dieses Dataset importieren.- Öffnen Sie die AutoML Video Object Tracking-UI.

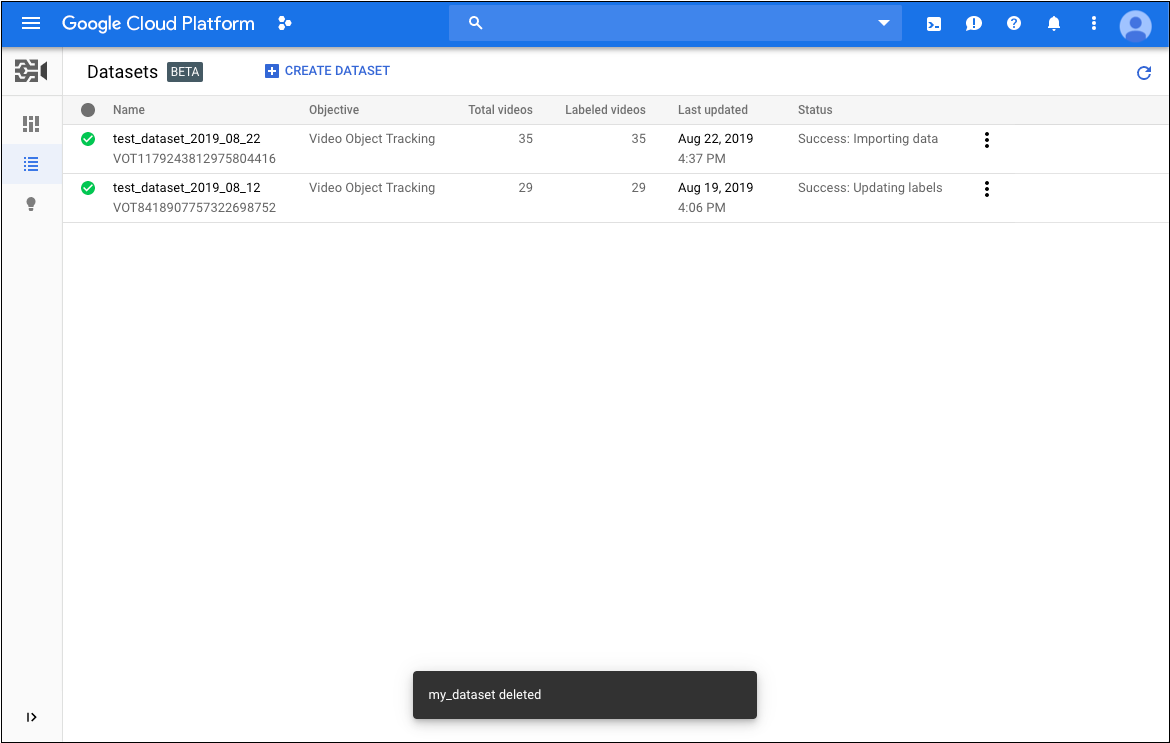

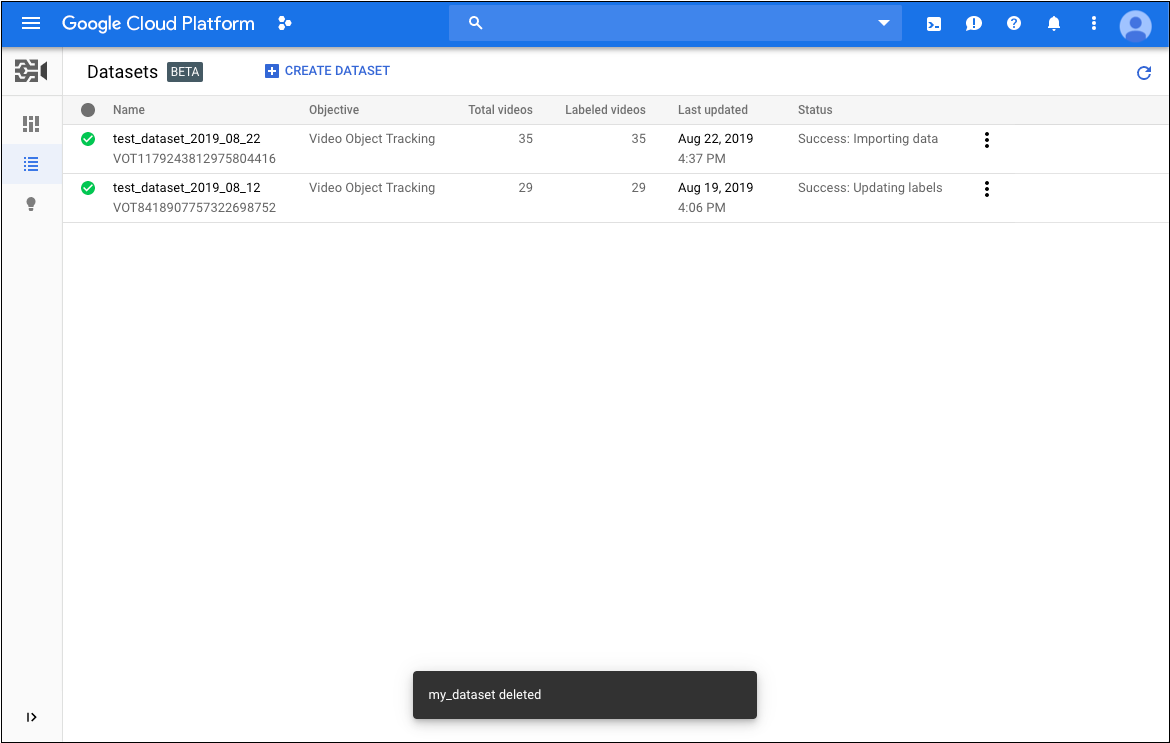

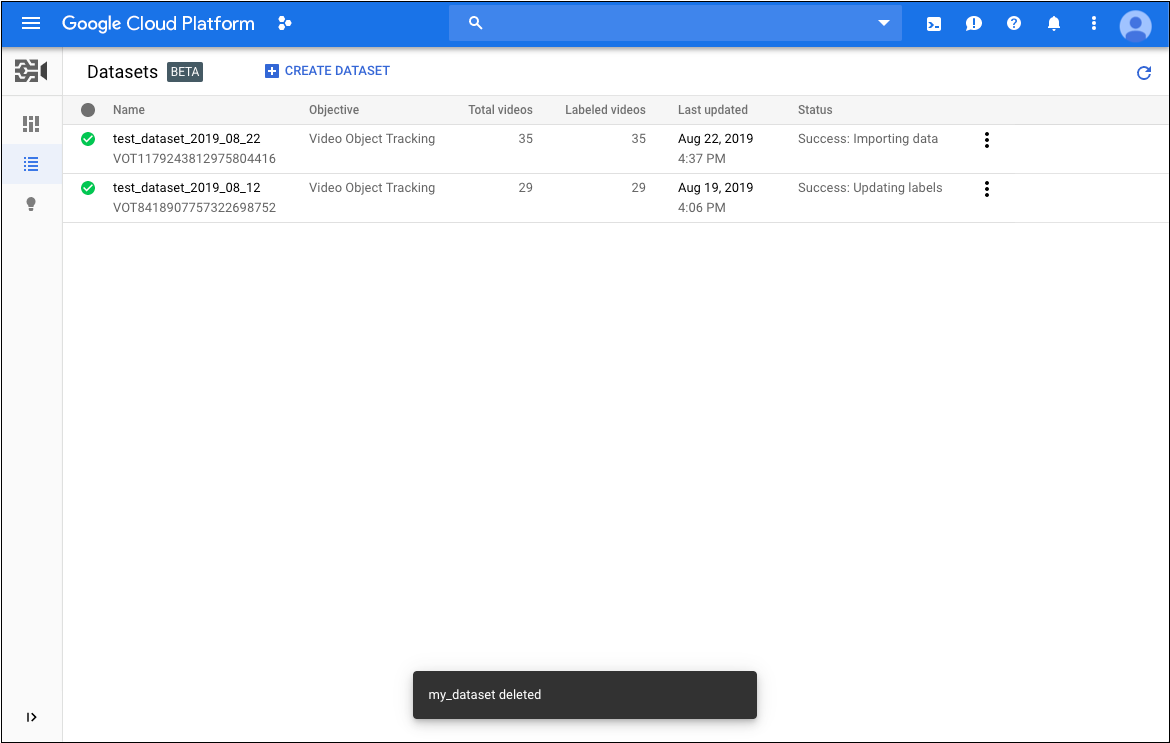

Auf der Seite Datasets wird der Status zuvor erstellter Datasets für das aktuelle Projekt angezeigt.

Wenn Sie ein Dataset für ein anderes Projekt hinzufügen möchten, wählen Sie das betreffende Projekt in der Drop-down-Liste rechts oben in der Titelleiste aus.

Wenn Sie ein Dataset für ein anderes Projekt hinzufügen möchten, wählen Sie das betreffende Projekt in der Drop-down-Liste rechts oben in der Titelleiste aus. - Klicken Sie auf der Seite Datasets auf Dataset erstellen.

- Führen Sie im Dialogfeld Neues Dataset erstellen die folgenden Aufgaben aus:

- Geben Sie einen Namen für das Dataset an.

- Wählen Sie Videoobjekt-Tracking aus.

- Klicken Sie auf Dataset erstellen.

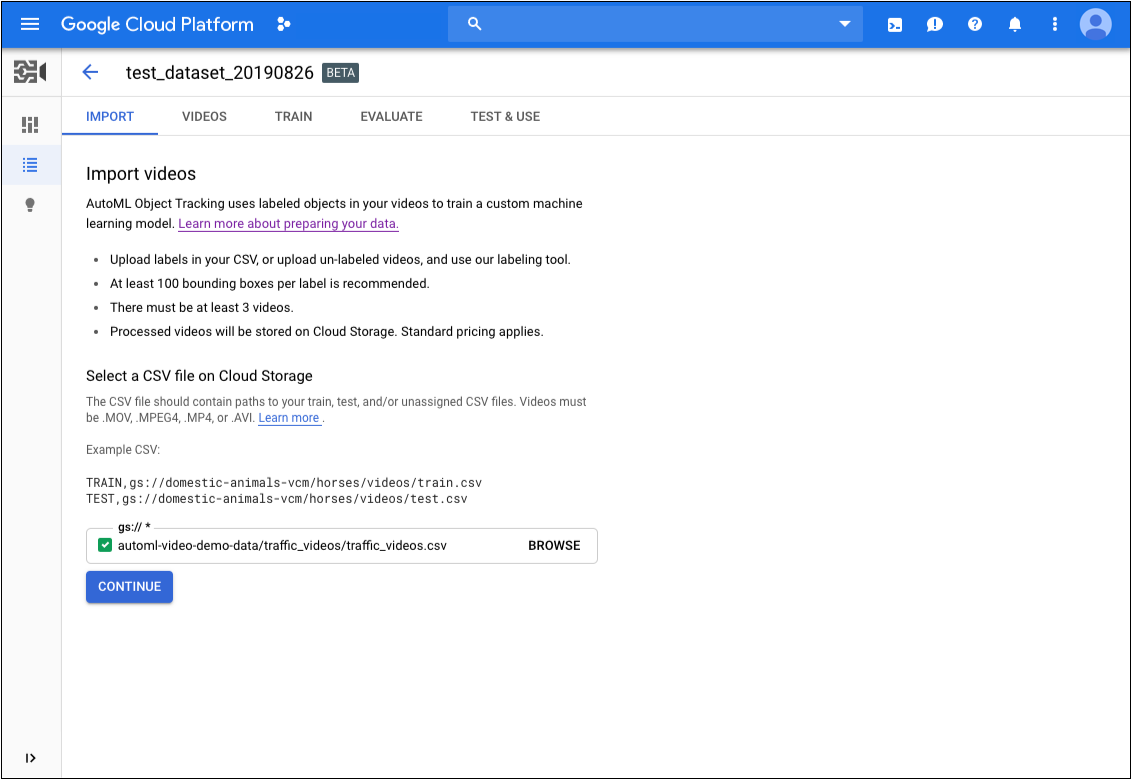

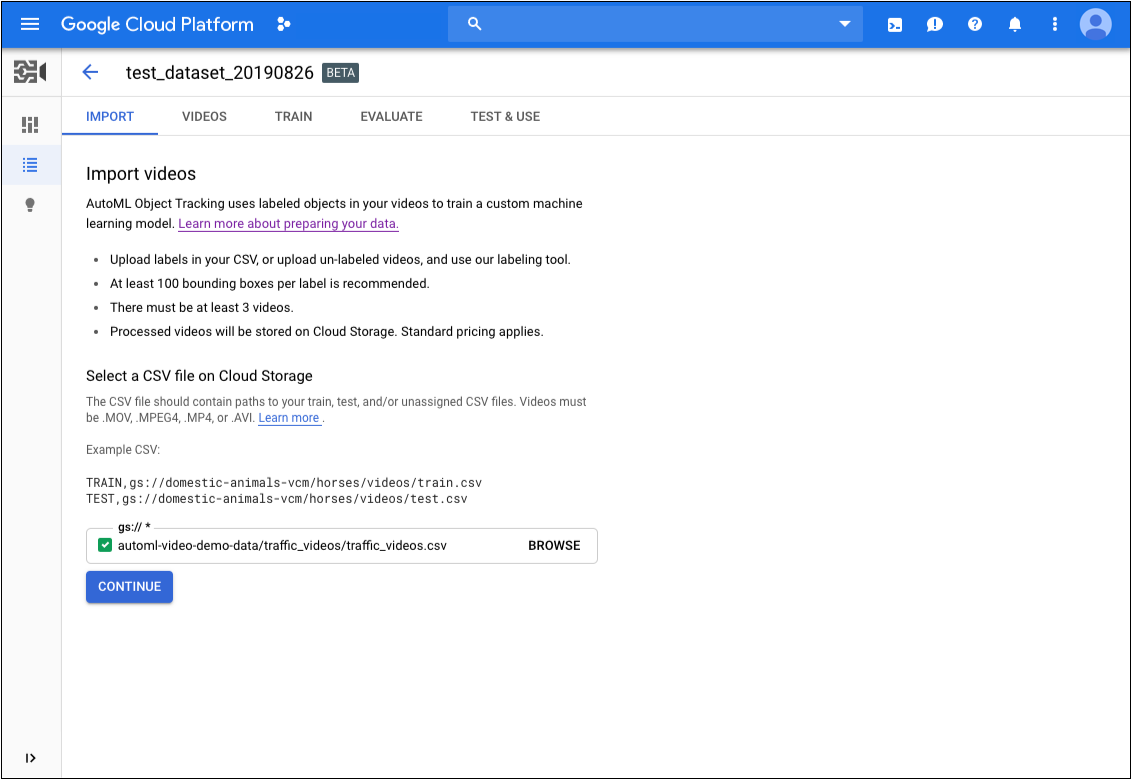

- Geben Sie auf der Seite für Ihr Dataset den Cloud Storage-URI der CSV-Datei, die die URIs Ihrer Trainingsdaten enthält, ohne das Präfix

gs://am Anfang an. - Klicken Sie auch auf der Seite für Ihr Dataset auf Weiter, um mit dem Import zu beginnen.

REST UND BEFEHLSZEILE

Im folgenden Beispiel wird ein Dataset mit dem Namen my_dataset01 erstellt, das Anwendungsfälle für das Objekt-Tracking unterstützt. Das neu erstellte Dataset enthält keine Daten, solange noch keine Elemente darin importiert wurden.

Speichern Sie den Wert für "name" des neuen Datasets aus der Antwort für die Verwendung in anderen Vorgängen, z. B. für das Importieren von Elementen in Ihr Dataset und das Trainieren eines Modells.

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- dataset-name: Der Name des Ziel-Datasets.

Beispiel:my_dataset_01 - Hinweis:

- project-number: Nummer Ihres Projekts

- location-id: Die Cloud-Region, in der die Annotation erfolgen soll. Unterstützte Cloud-Regionen sind:

us-east1,us-west1,europe-west1,asia-east1. Wenn keine Region angegeben ist, wird eine Region basierend auf dem Speicherort der Videodatei festgelegt.

HTTP-Methode und URL:

POST https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets

JSON-Text der Anfrage:

{

"displayName": "dataset-name",

"videoObjectTrackingDatasetMetadata": { }

}

Wenn Sie die Anfrage senden möchten, wählen Sie eine der folgenden Optionen aus:

curl

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

curl -X POST \

-H "Authorization: Bearer "$(gcloud auth application-default print-access-token) \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets"

PowerShell

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

$cred = gcloud auth application-default print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets" | Select-Object -Expand Content

VOT12345....

Java

Node.js

Python

Elemente in ein Dataset importieren

Nachdem Sie ein Dataset erstellt haben, können Sie Daten mit Labels aus CSV-Dateien importieren, die in einem Cloud Storage-Bucket gespeichert sind. Weitere Informationen zum Vorbereiten von Daten und Erstellen einer CSV-Datei für den Import finden Sie unter Trainingsdaten vorbereiten.

Sie können Elemente in ein leeres Dataset importieren oder zusätzliche Elemente in ein vorhandenes Dataset importieren.

Web-UI

Normalerweise importieren Sie Ihre Daten beim Erstellen des Datasets.Wenn Sie jedoch Ihre Daten nach dem Erstellen des Datasets importieren möchten, gehen Sie so vor:

- Öffnen Sie die AutoML Video Object Tracking-UI.

Auf der Seite Datasets wird der Status zuvor erstellter Datasets für das aktuelle Projekt angezeigt.

- Klicken Sie in der Liste auf das Dataset, in das Sie Daten importieren möchten.

- Geben Sie auf dem Tab Import den Cloud Storage-URI der CSV-Datei an, die die URIs Ihrer Trainingsdaten enthält, ohne das Präfix

gs://am Anfang. - Klicken Sie auch auf dem Tab Importieren für Ihr Dataset auf Weiter, um den Import zu starten.

REST UND BEFEHLSZEILE

Verwenden Sie zum Importieren Ihrer Trainingsdaten die MethodeimportData. Bei dieser Methode müssen Sie zwei Parameter angeben:

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- dataset-id: die ID Ihres Datasets. Die ID ist das letzte Element des Datasetnamens. Beispiel:

- Dataset-Name:

projects/project-number/locations/location-id/datasets/3104518874390609379 - Dataset-ID:

3104518874390609379

- Dataset-Name:

- bucket-name: Ersetzen Sie diesen Wert durch den Namen des Cloud Storage-Buckets, in dem Sie die CSV-Datei mit der Liste der Modelltrainingsdateien gespeichert haben.

- csv-file-name: Ersetzen Sie diesen Wert durch die CSV-Datei mit der Liste der Modelltrainingsdateien.

- Hinweis:

- project-number: Nummer Ihres Projekts

- location-id: Die Cloud-Region, in der die Annotation erfolgen soll. Unterstützte Cloud-Regionen sind:

us-east1,us-west1,europe-west1,asia-east1. Wenn keine Region angegeben ist, wird eine Region basierend auf dem Speicherort der Videodatei festgelegt.

HTTP-Methode und URL:

POST https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets/dataset-id:importData

JSON-Text der Anfrage:

{

"inputConfig": {

"gcsSource": {

"inputUris": ["gs://bucket-name/csv-file-name.csv"]

}

}

}

Wenn Sie die Anfrage senden möchten, wählen Sie eine der folgenden Optionen aus:

curl

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

curl -X POST \

-H "Authorization: Bearer "$(gcloud auth application-default print-access-token) \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets/dataset-id:importData"

PowerShell

Speichern Sie den Anfragetext in einer Datei mit dem Namen request.json und führen Sie den folgenden Befehl aus:

$cred = gcloud auth application-default print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets/dataset-id:importData" | Select-Object -Expand Content

VOT7506374678919774208 enthält.

Java

Node.js

Python

Trainingselemente mit Labels versehen

Jedes Element in einem Dataset muss mindestens einen Begrenzungsrahmen und ein Kategorielabel enthalten, damit es dem Trainieren eines Modells von Nutzen sein kann. Sie können Labels für Ihre Trainingselemente auf zwei verschiedene Arten angeben:

- Fügen Sie Ihrer CSV-Datei Labels und Begrenzungsrahmen hinzu.

- Wenden Sie Labels und Begrenzungsrahmen auf Ihre Elemente in der AutoML Video Object Tracking-UI an.

Weitere Informationen zum Labeling von Elementen in einer CSV-Datei finden Sie unter Trainingsdaten vorbereiten.

Wenn Sie Elemente in der AutoML Video Object Tracking-UI mit einem Label versehen und Details zum Dataset abrufen möchten, wählen Sie auf der Seite mit der Dataset-Liste das Dataset aus. Der Anzeigename des ausgewählten Datasets wird in der Titelleiste angezeigt. Die einzelnen Elemente im Dataset werden zusammen mit ihren Labels aufgelistet. Die Navigationsleiste auf der linken Seite fasst die Anzahl der Elemente mit und ohne Label zusammen. Sie können damit auch die Liste der Elemente nach Label filtern.

![]()

Führen Sie folgende Schritte aus, um Videos, die keine Labels haben, Labels und Begrenzungsrahmen zuzuweisen oder Videolabels und Begrenzungsrahmen zu ändern:

- Klicken Sie auf der Seite für das Dataset auf das Video, für das Sie Labels hinzufügen möchten.

Gehen Sie auf der Seite für das Video folgendermaßen vor:

- Führen Sie das Video aus, bis das Element angezeigt wird, das Sie mit einem Label versehen möchten.

- Ziehen Sie den Cursor, um einen Begrenzungsrahmen um das Element zu zeichnen.

- Wählen Sie nach dem Zeichnen des Begrenzungsrahmens das Label aus, das Sie verwenden möchten.

- Klicken Sie auf Speichern.

![]()

Wenn Sie ein neues Label für das Dataset hinzufügen müssen, klicken Sie auf der Seite für das Dataset oberhalb der Liste der vorhandenen Labels auf die drei Punkte neben Labels filtern und dann auf Neues Label hinzufügen.

Labels in Daten ändern

Sie können auch die Labels ändern, die auf Videos in einem Dataset angewendet werden. Führen Sie in der AutoML Video Object Tracking-UI folgende Schritte aus:

- Klicken Sie auf der Seite für das Dataset auf das Video, dessen Labels Sie ändern möchten.

Gehen Sie auf der Seite für das Video folgendermaßen vor:

- Wählen Sie links in der Liste der Labels das Label aus, das Sie ändern möchten.

- Klicken Sie in der Vorschau des Videos mit der rechten Maustaste auf den Begrenzungsrahmen im Video und wählen Sie das gewünschte Label aus.

- Klicken Sie auf Speichern.

![]()

Datasets auflisten

Ein Projekt kann zahlreiche Datasets enthalten. In diesem Abschnitt wird beschrieben, wie Sie eine Liste der verfügbaren Datasets für ein Projekt abrufen.

Web-UI

Wenn Sie über die AutoML Video Object Tracking-UI eine Liste der verfügbaren Datasets ansehen möchten, rufen Sie die Seite Datasets auf.![]()

Wenn Sie die Datasets für ein anderes Projekt anzeigen möchten, wählen Sie das Projekt in der Drop-down-Liste oben rechts in der Titelleiste aus.

REST UND BEFEHLSZEILE

Verwenden Sie die folgendencurl- oder PowerShell-Befehle, um eine Liste Ihrer Datasets und die Anzahl der in das Dataset importierten Beispielvideos abzurufen.

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- project-number: Die Nummer Ihres Projekts

- location-id: Die Cloud-Region, in der die Annotation stattfinden soll. Unterstützte Cloud-Regionen sind:

us-east1,us-west1,europe-west1,asia-east1. Wenn keine Region angegeben ist, wird eine Region basierend auf dem Speicherort der Videodatei festgelegt.

HTTP-Methode und URL:

GET https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets

Senden Sie die Anfrage mithilfe einer der folgenden Optionen:

curl

Führen Sie diesen Befehl aus:

curl -X GET \

-H "Authorization: Bearer "$(gcloud auth application-default print-access-token) \

"https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets "

PowerShell

Führen Sie diesen Befehl aus:

$cred = gcloud auth application-default print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets " | Select-Object -Expand Content

VOT3940649673949184000 die Vorgangs-ID des lang andauernden Vorgangs, der für die Anfrage erstellt und in der Antwort beim Start des Vorgangs angegeben wurde.

Java

Node.js

Python

Dataset löschen

Im folgenden Code wird gezeigt, wie ein Dataset gelöscht wird.

Web-UI

-

Rufen Sie in der AutoML Video Object Tracking-UI die Seite Modelle auf.

- Klicken Sie auf das Dreipunkt-Menü ganz rechts in der zu löschenden Zeile und wählen Sie Dataset löschen aus.

- Klicken Sie im Bestätigungsdialogfeld auf Bestätigen.

REST UND BEFEHLSZEILE

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- project-number: Die Nummer Ihres Projekts

- location-id: Die Cloud-Region, in der die Annotation stattfinden soll. Unterstützte Cloud-Regionen sind:

us-east1,us-west1,europe-west1,asia-east1. Wenn keine Region angegeben ist, wird eine Region basierend auf dem Speicherort der Videodatei festgelegt. - datase-id: Ersetzen Sie diesen Wert durch die ID Ihrer Dataset-ID.

HTTP-Methode und URL:

DELETE https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/datasets/dataset-id

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten einen Statuscode für erfolgreiche Ausführung (2xx) und eine leere Antwort erhalten.

Java

Node.js

Python