Dieser Leitfaden für Einsteiger bietet eine Einführung in die Kerntechnologien der generativen KI und erläutert, wie sie zusammen für Chatbots und Anwendungen genutzt werden. Generative KI (auch genAI oder gen KI genannt) ist ein Bereich des maschinellen Lernens (ML), der ML-Modelle zum Generieren neuer Inhalte entwickelt und verwendet.

Generative KI-Modelle werden aufgrund ihrer Größe und dem Umstand, dass sie natürliche Sprache verstehen und generieren können, oft als Large Language Models (LLM) bezeichnet. Abhängig von den Daten, mit denen die Modelle trainiert werden, können diese Modelle Inhalte aus verschiedenen Modalitäten verstehen und generieren, darunter Text, Bilder, Videos und Audio. Modelle, die mit mehreren Datenmodalitäten arbeiten, werden als multimodale Modelle bezeichnet.

Google bietet die Gemini-Familie von generativen KI-Modellen an, die für multimodale Anwendungsfälle entwickelt wurden und Informationen aus verschiedenen Modalitäten verarbeiten können, darunter Bilder, Videos und Text.

Inhaltserstellung

Damit generative KI-Modelle Inhalte generieren können, die in realen Anwendungen nützlich sind, benötigen diese die folgenden Funktionen:

Neue Aufgaben ausführen:

Modelle für generative KI sind für allgemeine Aufgaben konzipiert. Wenn ein Modell Aufgaben ausführen soll, die für Ihren Anwendungsfall spezifisch sind, müssen Sie es anpassen können. In Vertex AI können Sie Ihr Modell durch die Modellabstimmung anpassen.

Auf externe Informationen zugreifen:

Generative KI-Modelle werden mit riesigen Datenmengen trainiert. Damit diese Modelle nützlich sind, müssen sie auf Informationen außerhalb ihrer Trainingsdaten zugreifen können. Wenn Sie beispielsweise einen Kundenservice-Chatbot erstellen möchten, der auf einem Modell für generative KI basiert, muss das Modell Zugriff auf Informationen zu den von Ihnen angebotenen Produkten und Dienstleistungen haben. In Vertex AI verwenden Sie die Funktionen für Fundierungs- und Funktionsaufrufe, um dem Modell den Zugriff auf externe Informationen zu erleichtern.

Schädliche Inhalte blockieren:

Generative KI-Modelle können Ausgaben generieren, die Sie nicht erwarten, einschließlich Text, der anstößig oder insensitiv ist. Zur Gewährleistung der Sicherheit und zur Verhinderung von Missbrauch benötigen die Modelle Sicherheitsfilter, um Prompts und Antworten zu blockieren, die als potenziell schädlich eingestuft werden. Vertex AI hat integrierte Sicherheitsfeatures, die die verantwortungsvolle Nutzung unserer generativen KI-Dienste fördern.

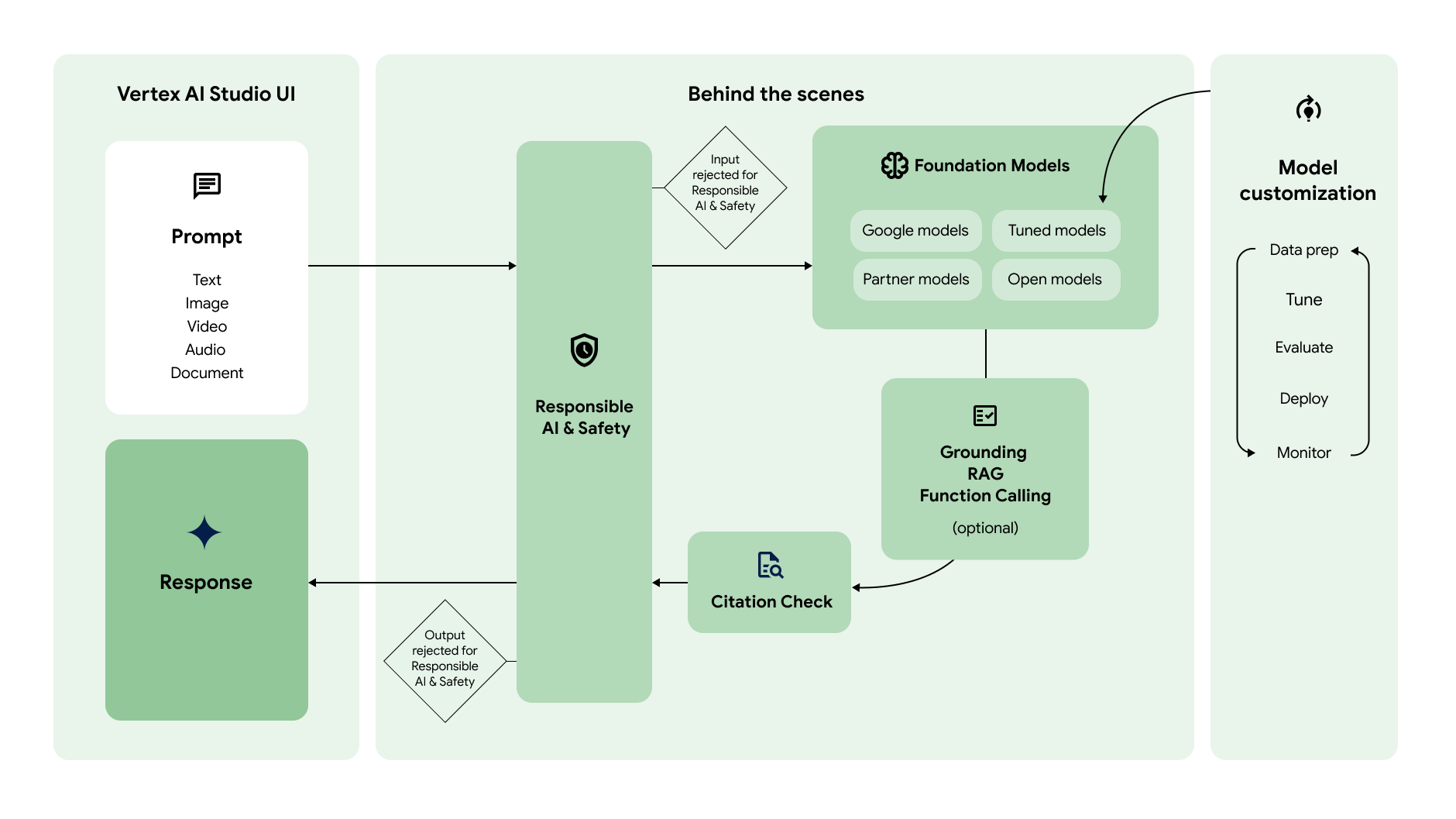

Das folgende Diagramm zeigt, wie diese verschiedenen Funktionen zusammenarbeiten, um die gewünschten Inhalte zu generieren:

Prompt

|

|

Der Generative AI-Workflow beginnt in der Regel mit Prompts. Ein Prompt ist eine Anfrage in natürlicher Sprache, die an ein generatives KI-Modell gesendet wird, um eine Antwort auszulösen. Je nach Modell kann ein Prompt Text, Bilder, Videos, Audio, Dokumente und andere oder sogar mehrere Modalitäten (multimodal) enthalten. Das Erstellen eines Prompts zum Abrufen der gewünschten Antwort vom Modell ist eine Methode, die als Prompt-Design bezeichnet wird. Das Prompt-Design ist zwar ein Versuch-und-Irrtums-Prozess, aber es gibt Prompt-Design-Prinzipien und -Strategien, mit denen Sie das Modell dazu bewegen können, sich wie gewünscht zu verhalten. Vertex AI Studio bietet ein Tool zur Prompt-Verwaltung, mit dem Sie Ihre Prompts verwalten können. |

Basismodelle

|

|

Prompts werden zur Antwortgenerierung an ein generatives KI-Modell gesendet. Vertex AI bietet eine Vielzahl von generativen KI-Foundation Models, auf die über eine verwaltete API zugegriffen werden kann. Dazu gehören:

Die Modelle unterscheiden sich in Größe, Modalität und Kosten. In Model Garden können Sie Google-Modelle sowie Open-Source-Modelle und Modelle von Google-Partnern untersuchen. |

Modellanpassung

|

|

Sie können das Standardverhalten der Grundlagenmodelle von Google so anpassen, dass sie die gewünschten Ergebnisse konsistent mit komplexen Prompts generieren. Dieser Anpassungsprozess wird als Modellabstimmung bezeichnet. Durch die Modelloptimierung können Sie die Kosten und Latenz Ihrer Anfragen reduzieren, indem Sie die Prompts vereinfachen. Vertex AI bietet auch Tools zur Modellbewertung, mit denen Sie die Leistung Ihres feinabgestimmten Modells bewerten können. Sobald Ihr abgestimmtes Modell produktionsbereit ist, können Sie es auf einem Endpunkt bereitstellen und die Leistung wie in standardmäßigen MLOps-Workflows überwachen. |

Auf externe Informationen zugreifen

|

|

Vertex AI bietet mehrere Möglichkeiten, dem Modell Zugriff auf externe APIs und Echtzeitinformationen zu gewähren.

|

Zitationsprüfung

|

|

Nachdem die Antwort generiert wurde, prüft Vertex AI, ob Zitationen in die Antwort aufgenommen werden müssen. Wenn ein beträchtlicher Teil des Antworttextes aus einer bestimmten Quelle stammt, wird diese Quelle den Zitationsmetadaten in der Antwort hinzugefügt. |

Verantwortungsbewusste KI und Sicherheit

|

|

Die letzte Prüfungsebene, die den Prompt und die Antwort durchlaufen, bevor sie zurückgegeben werden, sind die Sicherheitsfilter. Vertex AI prüft sowohl die Prompts als auch die Antwort darauf, wie stark der Prompt oder Antwort zu einer Sicherheitskategorie gehört. Wenn der Schwellenwert für eine oder mehrere Kategorien überschritten wird, wird die Antwort blockiert und Vertex AI gibt eine Fallback-Antwort zurück. |

Antwort

|

|

Wenn der Prompt und die Antwort die Sicherheitsfilterprüfungen bestehen, wird die Antwort zurückgegeben. Normalerweise wird die Antwort alle auf einmal zurückgegeben. Mit Vertex AI können Sie Antworten jedoch auch schrittweise empfangen, während sie generiert werden. Dazu muss das Streaming aktiviert sein. |

Jetzt starten

Mit einer der folgenden Kurzanleitungen können Sie mit generativer KI in Vertex AI beginnen:

- Text mit der Vertex AI Gemini API generieren:Mit dem SDK Anfragen an die Vertex AI Gemini API senden

- Prompts mit der Vertex AI Studio-Promptgalerie an Gemini senden:Prompts ohne Einrichtung testen

- Bild mit Imagen generieren und Wasserzeichen prüfen:Mit Imagen in Vertex AI ein Bild mit Wasserzeichen erstellen