Solução de problemas do TensorFlow: TPU

Este guia, junto com as perguntas frequentes, oferece ajuda para resolver problemas para usuários que estão treinando modelos do TensorFlow no Cloud TPU. Se você estiver resolvendo problemas de treinamento do PyTorch ou do JAX, consulte os documentos de solução de problemas para essas estruturas:

Para guias mais gerais sobre como usar o Cloud TPU, consulte:

Visão geral

Os problemas comuns encontrados com as Cloud TPUs se enquadram nas seguintes categorias:

Problema ao se conectar ao servidor da TPU

Esta seção descreve como resolver situações em que o TensorFlow para de responder ou exibe um erro ao se conectar à TPU. A etapa de compilação do gráfico da TPU pode levar muito tempo nos modelos grandes. Portanto, execute o script por pelo menos cinco minutos antes de confirmar que ele parou de responder.

A primeira etapa é verificar se o problema está no próprio servidor ou no canal de treinamento do TensorFlow. Para isso, execute o programa do TensorFlow e verifique se ele funciona corretamente. Se ainda houver problemas de conexão, isso confirma que o problema está no servidor da TPU. Nesse caso:

Execute o comando a seguir para listar as TPUs disponíveis. Substitua zone e project-id pelo ID da zona e do projeto.

(vm)$ gcloud compute tpus tpu-vm list --zone zone --project project-id

Isso exibe um resultado como este:

NAME ZONE ACCELERATOR_TYPE NETWORK_ENDPOINT NETWORK RANGE STATUS TPU_NAME us-central1-b v2-8 10.240.1.2:8470 default 10.240.1.0 READY

Verifique se a TPU está listada como

READY.Se a TPU não constar como

READYou se você ainda estiver com problemas de conexão, reinicie manualmente o servidor com:(vm)$ gcloud compute tpus tpu-vm stop TPU_NAME && gcloud compute tpus tpu-vm start TPU_NAME

Isso pode levar vários minutos.

Execute novamente o comando

gcloud compute tpus tpu-vm liste espere a TPU entrar no estadoREADY. Isso pode levar alguns minutos.Tente executar o programa novamente.

Se você ainda tiver problemas, peça ajuda usando um dos mecanismos descritos em Como receber suporte.

Se o código for executado corretamente, mas o modelo ainda parar de responder,

o problema provavelmente está no pipeline de treinamento.

Para depurar isso, comece substituindo a TPUStrategy no código pela

estratégia padrão. Quando você usa a estratégia padrão, onde quer que use

strategy.scope() ou strategy.run(), o modelo é executado

na CPU (ou GPU, se presente) em vez

de no TPU. Se o modelo for executado na CPU e não na TPU, haverá um problema específico da TPU. Se ainda não funcionar, a prática recomendada é depurar

o problema na CPU.

Perda da conexão ssh durante o treinamento

Sua conexão ssh com o Cloud TPU pode expirar durante

um treinamento de longa duração, principalmente se você estiver usando o Cloud Shell.

Nesse ponto, não há saída para o console do TPU, e pode parecer

que a TPU parou de treinar. Para evitar isso, execute a

sessão de treinamento com um multiplexador de terminais ou uma ferramenta de gerenciamento de sessões, como

tmux ou screen. Isso vai manter a conexão ssh

ativa, independentemente da duração do treinamento.

Como depurar erros comuns

Esta seção descreve como resolver erros comuns que podem ocorrer ao treinar modelos no Cloud TPU.

Não é possível criar uma TPU

Ao criar um Cloud TPU, você pode encontrar o seguinte erro:

googleapiclient.errors.HttpError: < HttpError 403 when requesting https://content-tpu.googleapis.com/v1/projects/{PROJECT}/locations/{ZONE}/nodes/{TPU_NAME}?alt=json returned "Request had insufficient authentication scopes."

Esse é um problema de permissão e pode ser resolvido executando o seguinte comando:

gcloud auth login --update-adc

Esse comando atualiza as credenciais padrão do app (ADC, na sigla em inglês) e resolve o problema. Para mais informações, consulte gcloud auth login.

Formas dinâmicas incompatíveis

Mensagem de erro

ValueError: shape [Shape] must have a fixed size for dimension d that is known at graph construction time.

Framework e configurações afetados

Essa mensagem só ocorre durante a compilação do XLA com o TensorFlow.

Detalhes

Para executar um modelo na TPU, o Cloud TPU o compila usando o compilador XLA. Essa etapa de compilação aumenta bastante a velocidade de treinamento e o uso de memória. No entanto, as formas ou tamanhos de dimensão de todos os tensores no grafo precisam ser estáticos. Isso significa que seus valores precisam ser conhecidos no momento da compilação do grafo. Se não for possível determinar formas nesse momento, a compilação da TPU falhará com um erro como o mostrado anteriormente.

Uma operação comum que retorna uma forma dinâmica é dataset.batch(batch_size),

já que o número de amostras restantes em um fluxo pode ser menor que

o tamanho do lote. Portanto, ao realizar treinamentos na TPU, defina

drop remainder=True para dataset.batch.

Isso pode eliminar as últimas amostras de um arquivo para garantir

que cada lote tenha uma forma estática de batch_size. Exemplo:

dataset = tf.data.Dataset.range(8)

dataset = dataset.batch(3, drop_remainder=True)

Operação do TensorFlow indisponível

Mensagem de erro

NotFoundError: No registered 'OpName' OpKernel for XLA_TPU_JIT devices compatible with node

Framework e configurações afetados

Essa mensagem pode ocorrer durante o treinamento com o TensorFlow.

Detalhes

O modelo usa uma operação do TensorFlow que não está disponível na TPU.

Para conferir uma lista de operações disponíveis na TPU, planos para compatibilidade futura e sugestões de soluções alternativas, consulte o guia sobre operações disponíveis do TensorFlow.

Mensagem de erro de falta de memória

Mensagem de erro

ResourceExhaustedError: Ran out of memory in memory space hbm; used: YYY; limit: 7.48G.

Framework e configurações afetados

Essa mensagem pode ocorrer durante o treinamento com o TensorFlow, PyTorch ou JAX.

Detalhes

Cada Cloud TPU é formado por oito núcleos, os TPUs v2 têm 8 GB e os TPUs v3 têm 16 GB de RAM (ou HBM, memória de alta largura de banda). Essa memória é usada para armazenar os tensores de peso (variáveis), bem como os de resultados intermediários necessários para o cálculo do gradiente. Se o modelo for muito grande para caber na RAM da TPU, a inicialização vai falhar, e a mensagem de erro será exibida. Consulte a seção sobre como reduzir o uso de memória para encontrar mais ajuda.

Dicas para reduzir o uso de memória:

- Verificar se há preenchimento excessivo do tensor

- Use o formato bfloat16

- Se os tamanhos de entrada ou o modelo forem muito grandes, talvez seja possível usar o paralelismo experimental de modelos do TensorFlow para lidar com o tamanho do modelo.

Problemas que interrompem a execução

Quando há erro no TensorFlow durante a execução da TPU, o script às vezes

deixa de responder em vez de ser encerrado e voltar para o shell. Se isso acontecer,

pressione CTRL+C no teclado para acionar SIGQUIT e encerrar

o Python imediatamente.

Da mesma forma, pressionar CTRL+C durante a execução da TPU não encerra o TensorFlow

imediatamente. Em vez disso, ele aguarda o fim do ciclo de iteração atual para

se encerrar corretamente.

Se ocorrer algum novo erro ao se reconectar à TPU após encerrar dessa maneira, redefina manualmente o servidor da TPU usando os comandos:

gcloud compute tpus tpu-vm stop tpu-name --zone=zone gcloud compute tpus tpu-vm start tpu-name --zone=zone

em que tpu-name é retirado da primeira coluna exibida pelo comando gcloud compute tpus tpu-vm list e zone é a zona mostrada na segunda coluna.

Preenchimento excessivo do tensor

Possível causa do problema de memória

Os tensores na memória da TPU são preenchidos. Isso significa que a TPU arredonda os tamanhos dos tensores armazenados na memória para executar cálculos com mais eficiência. O preenchimento acontece de modo evidente no nível do hardware e não afeta os resultados. No entanto, em alguns casos, o preenchimento aumenta bastante o uso de memória e o tempo de execução.

Como reduzir o uso de memória

O software da TPU exibe os tensores na memória para aumentar a eficiência computacional e minimizar o preenchimento. Esse processo de exibição da memória é complexo. No entanto, para conseguir os melhores resultados, o modelo precisa cumprir a regra geral a seguir. Para reduzir a sobrecarga de memória e aumentar a eficiência computacional, é necessário que:

o tamanho total do lote seja um múltiplo de 64 (8 por núcleo de TPU) e as dimensões do recurso sejam um múltiplo de 128;

ou

o tamanho total do lote seja um múltiplo de 1024 (128 por núcleo de TPU) e as dimensões do recurso sejam um múltiplo de 8.

Usando um tamanho de lote de 1024 e dimensões de recurso que sejam um múltiplo de 128, você garante a melhor eficiência, mesmo que isso não seja possível em todos os modelos. Para maior clareza, a "dimensão de recurso" se refere ao tamanho oculto de uma camada totalmente conectada ou ao número de canais de saída em uma convolução. Nem todas as camadas seguem essa regra, especialmente a primeira e a última da rede. Isso não é um problema, e é esperado que a maioria dos modelos exija uma certa quantidade de preenchimento.

Como reduzir o uso da memória

Se ocorrer um erro de falta de memória ao executar o modelo na TPU, você precisará reduzir o uso da memória.

As maneiras mais eficazes de reduzir o uso de memória são:

- Reduzir o preenchimento excessivo do tensor

- Reduzir o tamanho do lote

Tamanho do lote ou modelo muito grande

Possível causa do problema de memória

Ao treinar uma rede neural em uma CPU, GPU ou TPU, o uso da memória é proveniente do:

- O uso da memória é proporcional ao número de pesos no modelo.

- armazenamento de ativações intermediárias da transmissão para frente necessário para calcular a transmissão para trás. O uso da memória é diretamente proporcional aos tamanhos do lote e da camada e ao número de camadas.

Portanto, a memória exigida por um modelo é muito dependente do tamanho do lote.

A memória exigida por um modelo depende do número de camadas na rede.

O tempo de execução da TPU tenta otimizar operadores para ajustar o modelo na memória. Isso é chamado de rematerialização, semelhante à criação de checkpoints de gradiente (ambos em inglês). No entanto, nem sempre é possível fazer isso.

Como reduzir o uso de memória

Reduza lentamente o tamanho do lote até que ele caiba na memória, verificando se ele é múltiplo de 64. O tamanho do lote por núcleo precisa ser múltiplo de 8. Lembre-se de que tamanhos de lote maiores são mais eficientes na TPU. O tamanho total de 1024 (128 por núcleo) costuma ser um bom ponto de partida.

Se não for possível executar o modelo na TPU mesmo com um tamanho de lote pequeno (por exemplo, 64), reduza o número de camadas ou os tamanhos delas.

Como melhorar a velocidade do treinamento

Nesta seção, descrevemos várias maneiras possíveis de melhorar a velocidade do treinamento caso você consiga executar o modelo na TPU, mas a velocidade é mais lenta que o esperado. Consulte o guia de desempenho para outras sugestões sobre como melhorar o desempenho do treinamento.

Poucas etapas por execução em cada loop de treinamento

Descrição do problema de desempenho

A transmissão do argumento steps_per_execution para Model.compile controla

quantas etapas de treinamento são executadas entre os callbacks do host.

Cada callback de host requer bastante comunicação

entre a CPU do host do servidor da TPU e o dispositivo TPU. Portanto, se steps_per_execution

for muito pequeno, o treinamento poderá ficar lento.

Como saber se o modelo foi afetado

Se um perfil de TPU revelar callbacks de CPU do host frequentes entre as etapas do dispositivo de TPU,

o treinamento poderá se beneficiar de um valor steps_per_execution maior.

Como mitigar

Defina steps_per_execution como um valor maior. steps_per_execution pode ser definido como um valor grande, mas lembre-se de que

as mensagens de registro e o salvamento de um ponto de verificação só podem ocorrer depois que o

número especificado de etapas for executado.

Gargalo de processamento de entrada

Descrição do problema de desempenho

Enquanto a TPU realiza o treinamento em um determinado bloco de dados, a função de processamento de entrada prepara o próximo bloco na CPU. Se a função de entrada levar mais tempo que a função de modelo, o TPU ficará ocioso enquanto a função de entrada estiver recuperando dados.

Como saber se o modelo foi afetado

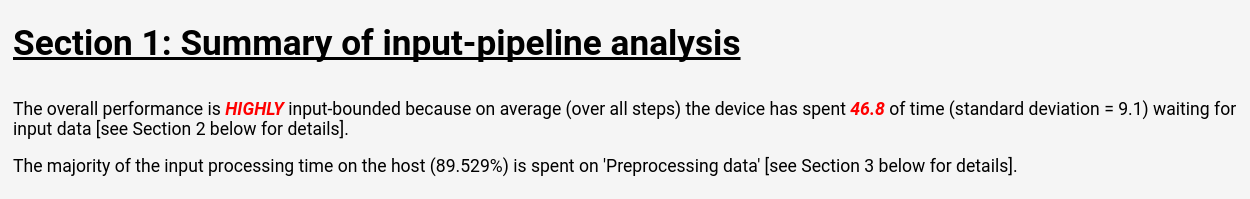

Siga as instruções em Ferramentas da Cloud TPU: analisador do canal de entrada para ver a respectiva análise no TensorBoard:

A página de análise do canal de entrada exibe um resumo claro que mostra se o modelo tem gargalo do processamento de entrada. Ela também mostra o tempo de execução por operação, o que permite identificar as operações problemáticas.

Como mitigar

Há várias mitigações possíveis no carregamento de dados com a API Dataset:

- Armazenar os dados como uma coleção de estruturas

tf.train.Exampleem arquivosTFRecorde carregá-los comTFRecordDataset. Consulte o tutorial da API Dataset (em inglês) ou do ResNet para ver exemplos. - Use

dataset.cache()oudataset.prefetch()para armazenar em buffer os dados de entrada. Isso evita que lentidões esporádicas no acesso aos arquivos criem um gargalo. - Especificar o parâmetro

num_parallel_callsda funçãodataset.map()para ativar operaçõesmap()com várias linhas de execução. Uma heurística para o valor denum_parallel_callsé usar o número de núcleos de CPU disponíveis. - O pré-processamento de dados off-line é caro, mas pode ser pago uma única vez para que não seja necessário gerá-lo em todos os períodos de cada treinamento.

Todo o processamento de entrada é executado em CPUs localizadas no servidor da TPU, não na máquina local. Portanto, a velocidade da máquina local não é um fator.

Tempos de etapa lentos e baixa utilização da MXU

Descrição do problema de desempenho

A Cloud TPU realiza convoluções e multiplicações de matrizes a velocidades incrivelmente altas. A maioria das outras operações do TensorFlow conta com implementações eficientes na TPU. No entanto, essa não é a principal qualidade da TPU em relação a outros hardwares. Portanto, é necessário que as convoluções ou multiplicações de matrizes sejam predominantes no modelo para aproveitar ao máximo a TPU.

Como saber se o modelo foi afetado

Os sintomas que você vai notar nesse caso são tempos de etapa lentos, associados a baixa utilização da MXU, mostrados quando você cria o perfil de desempenho.

Como mitigar

Tente reduzir o número de operações que não são multiplicações de matriz. Depois de reduzir o número de multiplicações de matriz, faça uma nova comparação para saber se o desempenho é aceitável nas TPUs.

Preenchimento excessivo do tensor

Descrição do problema de desempenho

A TPU preenche os tensores na memória para poder usar as unidades computacionais com eficiência. O preenchimento pode aumentar o uso da memória e da respectiva largura de banda. Consulte a seção sobre preenchimento de tensor para entender e solucionar os problemas relacionados.

Baixa taxa de transferência e uso de memória

Descrição do problema de desempenho

Como regra geral, o uso de lotes maiores aumenta a velocidade de treinamento na TPU em termos de amostras/segundo.

Como saber se o modelo foi afetado

O tamanho do lote de qualquer modelo precisa sempre ser pelo menos 64 (8 por núcleo de TPU), já que a TPU preenche os tensores nesse tamanho. O tamanho ideal ao treinar na TPU é de 1024 (128 por núcleo de TPU). Isso elimina as ineficiências relacionadas à transferência de memória e preenchimento.

Como mitigar

A prática recomendada é usar o maior tamanho de lote que se encaixe na memória e seja múltiplo de 64. Para isso, o jeito mais fácil é começar com 1024. Se ocorrer um erro de falta de memória, reduza o tamanho do lote até que o modelo seja executado com êxito. Alterar o tamanho do lote de um modelo requer o ajuste de outros hiperparâmetros para conseguir a mesma acurácia, como a taxa de aprendizado. No entanto, isso precisa ser avaliado de acordo com o caso.

Tamanhos de camada muito pequenos

Descrição do problema de desempenho

Mesmo quando as convoluções ou multiplicações de matrizes são predominantes no modelo, a TPU pode não funcionar com eficiência total se os tensores de entrada forem pequenos. Em comparação a outros hardwares, a TPU é executada com mais eficiência quando o tamanho do lote e os tamanhos da camada são grandes. Por exemplo, dimensão ≥ 512.

Como saber se o modelo foi afetado

Como regra geral, os tamanhos de camada menores que 128 geram baixa eficiência na TPU. Isso acontece porque 128 é a dimensão integrada da unidade de multiplicação de matriz da TPU. Nas camadas completamente conectadas, o tamanho mínimo oculto de 512 é recomendado para gerar alta eficiência. As camadas convolucionais normalmente não precisam ser tão grandes quanto as completamente conectadas para atingir o mesmo nível de eficiência.

Como mitigar

Se a principal motivação para tamanhos de camadas pequenas no modelo for a velocidade de treinamento, realize novamente a comparação de modelos com camadas maiores na TPU. Por exemplo, aumentar o tamanho de saída de uma camada de 256 para 512 pode aumentar o tempo de treinamento em apenas 20%, mesmo que o modelo esteja realizando o dobro das computações.

Perfil de modelo no nível operacional

Geralmente, é bom medir o uso de memória e tempo de execução no nível operacional para identificar gargalos de desempenho. Para ver instruções sobre como fazer isso,

consulte o guia Ferramentas da Cloud TPU: visualizador de rastros.

Como depurar quedas na acurácia do modelo

Um dos objetivos do ecossistema da Cloud TPU é que qualquer modelo treinado em uma CPU ou GPU atinja uma precisão muito semelhante no treinamento na TPU, com pequenos ajustes em hiperparâmetros como o tamanho do lote e a taxa de aprendizado. No entanto, os usuários às vezes observam uma queda na acurácia ao treinar modelos na TPU. A depuração desses problemas pode ser muito frustrante devido à natureza aleatória do treinamento da rede neural. Veja nesta seção orientações sobre como identificar a principal causa de qualquer queda na acurácia ao fazer a portabilidade um modelo para a TPU.

Noções básicas sobre fragmentação de dados (paralelismo)

Um dos principais objetivos do TensorFlow é fazer as operações produzirem resultados quase idênticos, sejam elas executadas em CPU, GPU ou TPU. Há certas exceções, como as operações aleatórias. Em geral, se você encontrar qualquer diferença significativa entre a saída de operações não aleatórias na TPU e na CPU, denuncie como um bug.

No entanto, para o pipeline de treinamento como um todo, há uma diferença significativa entre o treinamento na CPU/GPU e na TPU. Ao treinar em uma TPU,

o TensorFlow executa a fragmentação de dados.

Cada Cloud TPU contém 8 núcleos que funcionam como unidades de processamento independentes. Em cada etapa do treinamento, todos os núcleos da TPU recebem um lote

de dados, calculam os gradientes de peso, trocam esses gradientes com os

outros núcleos da TPU

e, em seguida, calculam a atualização de peso. Por padrão, a média de perda é calculada nos núcleos, mas é possível somá-la alterando o parâmetro de CrossShardOptimizer.

Se for possível calcular a perda total do modelo como a média ou soma de perdas independentes por amostra, este procedimento será matematicamente similar ao treinamento em um único lote grande.

A operação mais comum que não é independente por amostra é a normalização de lote, que é executada em cada lote por núcleo separadamente. Por exemplo, se o tamanho total do lote for 128, o tamanho por núcleo será 16. Cada um dos 8 núcleos executará a normalização de lote nas 16 amostras. Em alguns casos, foi realizada uma normalização em lotes pequenos (por exemplo, menos de 32) para reduzir a precisão. No cenário ideal, o tamanho total do lote deve ser grande. Por exemplo, de 256 a 1.024. Se esse tamanho for muito grande para caber na memória, será necessário avaliar o efeito da fragmentação de acordo com o caso.

Como depurar o treinamento da TPU de vários núcleos

Se o modelo tem a mesma perda na CPU e na TPU de núcleo único, o problema é provavelmente um dos seguintes:

(a) A degradação é por conta da variância aleatória natural ao treinar modelos neurais com diferentes inicializações.

(b) A degradação é por conta de um problema relacionado à fragmentação de dados na TPU.

Para determinar se (a) é o problema, treine novamente o modelo completo na CPU/GPU e na TPU de vários núcleos usando a mesma inicialização de peso.

Se você tiver certeza de que a queda na precisão tem significância estatística, estes são os problemas mais prováveis relacionados à fragmentação de dados:

- Se o modelo usa a normalização de lote, um tamanho total de lote menor que 256 (por exemplo, menos de 32 por núcleo) pode reduzir a acurácia.

- As funções de perda em lote são afetadas pela fragmentação. Essas funções costumam ser muito especializadas. Por exemplo, Karras e outros autores (2017) (em inglês) usam um discriminador de lotes ao treinar uma rede adversária generativa.

Solução de problemas de configuração do gcloud

- Problema

gcloud components updateexibe a seguinte mensagem de erro:

ERROR: (gcloud.components.update) You cannot perform this action because the Cloud SDK component manager is disabled for this installation.

- Solução

Para usar a CLI do Google Cloud, você precisa usar uma instalação que não seja gerenciada por um gerenciador de pacotes.

Execute o comando a seguir para remover a instalação atual da CLI gcloud:

sudo apt-get remove google-cloud-sdk

Siga as instruções para instalar a CLI do Google Cloud.

- Problema

O comando

gcloud compute tpus tpu-vm ssh TPU_NAME --zone ZONEmostra a seguinte mensagem de erro:Waiting for SSH key to propagate. ssh: connect to host 34.91.136.59 port 22: Connection timed out ssh: connect to host 34.91.136.59 port 22: Connection timed out ssh: connect to host 34.91.136.59 port 22: Connection timed out ERROR: (gcloud.compute.tpus.tpu-vm.ssh) Could not SSH into the instance. It is possible that your SSH key has not propagated to the instance yet. Try running this command again. If you still cannot connect, verify that the firewall and instance are set to accept ssh traffic.

- Solução

Ocorreu um erro na propagação da chave SSH. Tente mover as chaves geradas automaticamente para um local de backup para forçar

gclouda recriá-las:mv ~/.ssh/google_compute_engine ~/.ssh/old-google_compute_engine mv ~/.ssh/google_compute_engine.pub ~/.ssh/old-google_compute_engine.pub

Registros de depuração

Os frameworks do Cloud TPU com suporte, JAX, PyTorch e TensorFlow,

acessam TPUs usando uma biblioteca compartilhada chamada libtpu, presente em

todas as VMs de TPU. Essa biblioteca inclui o compilador XLA usado para compilar

programas de TPU, o ambiente de execução de TPU usado para executar programas

compilados e o driver de TPU usado pelo ambiente de execução para acesso de baixo nível à TPU.

A biblioteca libtpu registra informações que podem ser úteis para depuração.

Por padrão, esses registros são gravados em /tmp/tpu_logs em cada VM do Cloud TPU.

As variáveis de ambiente a seguir podem ser definidas antes do treinamento

para modificar o comportamento de registro:

- TPU_LOG_DIR: o diretório em que os registros são gravados

- O local do diretório é

/tmp/tpu_logspor padrão. O diretório será criado se ele ainda não existir, mas nenhum diretório pai será criado. Se houver um erro ao encontrar ou criar o diretório especificado, uma mensagem será mostrada no stderr, mas não vai interromper o programa e o registro será desativado. Defina o nome do diretório como "desativado" para desativar completamente a geração de registros no disco. - TPU_MIN_LOG_LEVEL: a gravidade mínima que será registrada no disco

- As opções são 0 (INFO), 1 (WARNING), 2 (ERROR) e 3 (FATAL). O padrão é 0.

- TPU_STDERR_LOG_LEVEL: a gravidade mínima que será registrada em stderr, além do disco, se aplicável

- As opções são as mesmas de TPU_MIN_LOG_LEVEL. O padrão é 3.

- TPU_MAX_LOG_SIZE_MB: o tamanho máximo em megabytes de cada arquivo de registro

- Um novo arquivo de registro será iniciado automaticamente quando o anterior atingir aproximadamente esse tamanho. O padrão é 1.024.