In dieser Anleitung werden Best Practices und typische Unternehmensarchitekturen für das Design von Virtual Private Clouds (VPCs) mit Google Cloudvorgestellt. Dieser Leitfaden richtet sich an Cloudnetzwerk- und Systemarchitekten, die bereits mit Google Cloud Netzwerkkonzepten vertraut sind.

Allgemeine Grundsätze und erste Schritte

Entscheidungsträger, Zeitpläne und Vorarbeiten ermitteln

Frühzeitig VPC-Netzwerkdesign in Betracht ziehen

Weniger ist oft mehr

Klare Namenskonventionen verwenden

Entscheidungsträger, Zeitpläne und Vorarbeiten ermitteln

Als ersten Schritt bei der Gestaltung Ihres VPC-Netzwerks sollten Sie die Entscheidungsträger, Zeitpläne und Vorarbeiten ermitteln, um sicherzustellen, dass Sie die Anforderungen der Beteiligten erfüllen können.

Zu den Interessengruppen zählen möglicherweise Anwendungsinhaber, Sicherheitsarchitekten, Lösungsarchitekten und Betriebsleiter. Abhängig davon, ob Sie das VPC-Netzwerk für ein Projekt, einen Geschäftsbereich oder die gesamte Organisation planen, können die Beteiligten variieren.

Zu den Vorarbeiten zählt unter anderem, das Team mit Konzepten und Begriffen rund um das VPC-Netzwerkdesign vertraut zu machen. Nützliche Dokumentationen:

- Dokumentation zu Resource Manager

- Dokumentation zur Identitäts- und Zugriffsverwaltung

- Virtual Private Cloud-Dokumentation

Frühzeitig VPC-Netzwerkdesign in Betracht ziehen

Planen Sie das VPC-Netzwerkdesign bereits früh während des Entwurfs der organisatorischen Einrichtung in Google Cloud. Es kann Ihre Organisation beeinträchtigen, wenn Sie später grundlegende Dinge ändern müssen, z. B. die Segmentierung Ihres Netzwerks oder den Standort Ihrer Arbeitslasten.

VPC-Netzwerkkonfigurationen können erhebliche Auswirkungen auf das Routing, die Skalierung und die Sicherheit haben. Eine sorgfältige Planung und ein eingehendes Verständnis Ihrer jeweiligen Ziele erleichtern es, eine solide architektonische Grundlage für inkrementelle Arbeitslasten zu schaffen.

Weniger ist oft mehr

Halten Sie das Design der VPC-Netzwerktopologie einfach, um eine möglichst gut verwaltbare, zuverlässige und einfach verständliche Architektur zu gewährleisten.

Klare Namenskonventionen verwenden

Achten Sie auf einfache, intuitive und konsistente Namenskonventionen. Wichtig ist, dass die Administratoren und Endnutzer den Zweck jeder Ressource verstehen und wissen, wo sie diese finden und wie sie sich von anderen Ressourcen unterscheidet.

Verwenden Sie für lange Wörter gängige Abkürzungen. Vertraute Begriffe verbessern außerdem die Lesbarkeit.

Erwägen Sie beim Festlegen Ihrer Namenskonventionen die nachfolgend aufgeführten Komponenten:

- Name des Unternehmens: Acme Unternehmen:

acmeco - Geschäftseinheit: Personalabteilung:

hr - Anwendungscode: Vergütungssystem:

comp - Regionscode: nordamerica-northeast1:

na-ne1, europe-west1:eu-we1 - Umgebungscodes:

dev,test,uat,stage,prod

In diesem Beispiel heißt die Entwicklungsumgebung für das Vergütungssystem der Personalabteilung acmeco-hr-comp-eu-we1-dev.

Berücksichtigen Sie für andere gängige Netzwerkressourcen die folgenden Muster:

Syntax für VPC-Netzwerk

:{company name}-{description(App or BU)-label}-{environment-label}-{seq#}

Beispiel:acmeco-hr-dev-vpc-1Subnetz

Syntax:{company-name}-{description(App or BU)-label}-{region-label}-{environment-label}-{subnet-label}

Beispiel:acmeco-hr-na-ne1-dev-vpc-1-subnet-1

Hinweis: Wenn ein Subnetz nur Ressourcen in einer Zone enthält, können Sie „zone-label“ anstelle von „region-label“ verwenden.Syntax der Firewallregel

:{company-name}-{description(App or BU)-label}{source-label}-{dest-label}-{protocol}-{port}-{action}

Beispiel:acmeco-hr-internet-internal-tcp-80-allow-ruleSyntax der IP-Route

:{priority}-{VPC-label}-{tag}-{next hop}

Beispiel:1000-acmeco-hr-dev-vpc-1-int-gw

Adressen und Subnetze

In VPC-Netzwerken des Unternehmens Subnetze im benutzerdefinierten Modus verwenden

Anwendungen in weniger Subnetzen mit größeren Adressbereichen gruppieren

VPC-Netzwerke im benutzerdefinierten Modus verwenden

Während VPC-Netzwerke im automatischen Modus für eine erste Erkundung hilfreich sein können, sind für die meisten Produktionsumgebungen VPC-Netzwerke im benutzerdefinierten Modus besser geeignet.

Wir empfehlen Unternehmen aus folgenden Gründen, von Beginn an VPC-Netzwerke im benutzerdefinierten Modus zu verwenden:

- VPC-Netzwerke lassen sich im benutzerdefinierten Modus einfacher in vorhandene IP-Adressverwaltungsschemas einbinden. Da alle Netzwerke im automatischen Modus die gleichen internen IP-Bereiche verwenden, können sich die IP-Bereiche im automatischen Modus überschneiden, wenn die Netzwerke mit Ihren lokalen Unternehmensnetzwerken verbunden werden.

- Zwei VPC-Netzwerke im automatischen Modus lassen sich nicht mit VPC-Netzwerk-Peering miteinander verbinden, da ihre Subnetze identische primäre IP-Bereiche nutzen.

- Subnetze im automatischen Modus haben alle den gleichen Namen wie das Netzwerk. Sie können für Subnetze im benutzerdefinierten Modus eindeutige, beschreibende Namen verwenden, um die VPC-Netzwerke leichter verständlich und verwaltbar zu machen.

- Wenn eine neue Google Cloud Region eingeführt wird, erhalten VPC-Netzwerke im automatischen Modus automatisch ein neues Subnetz in dieser Region. VPC-Netzwerke im benutzerdefinierten Modus erhalten nur dann neue Subnetze, wenn Sie sie angeben. Dies kann sowohl aus Gründen der Souveränität als auch von IP-Adressverwaltung wichtig sein.

Wenn keine Ressourcen vorhanden sind, können Sie das default-Netzwerk löschen. Sie können ein VPC-Netzwerk erst löschen, wenn zuvor alle davon abhängigen Ressourcen, einschließlich VM-Instanzen, entfernt wurden.

Ausführliche Informationen zu den Unterschieden zwischen VPC-Netzwerken im automatischen und benutzerdefinierten Modus finden Sie im Überblick zum VPC-Netzwerk.

Anwendungen in weniger Subnetzen mit größeren Adressbereichen gruppieren

Unternehmensnetzwerke sind mitunter aus verschiedenen Gründen in viele kleine Adressbereiche unterteilt. Dies kann beispielsweise der Fall sein, wenn eine Anwendung identifiziert oder isoliert oder die Broadcast-Domain klein gehalten werden soll.

Es wird jedoch empfohlen, Anwendungen desselben Typs in den Regionen, in denen Sie arbeiten möchten, in weniger, leichter verwaltbare Subnetze mit größeren Adressbereichen zu gruppieren.

Im Gegensatz zu anderen Netzwerkumgebungen, in denen eine Subnetzmaske verwendet wird, ermöglichtGoogle Cloud dank eines softwarebasierten Netzwerks (SDN) die uneingeschränkte Erreichbarkeit zwischen allen VMs im globalen VPC-Netzwerk. Die Anzahl der Subnetze hat keinen Einfluss auf das Routingverhalten.

Sie können mithilfe von Dienstkonten oder Netzwerktags spezielle Routingrichtlinien oder Firewallregeln anwenden. Die Identität in Google Cloud beruht nicht ausschließlich auf der IP-Adresse des Subnetzes.

Bestimmte VPC-Features wie Cloud NAT, Privater Google-Zugriff, VPC-Flusslogs und Alias-IP-Bereiche werden pro Subnetz konfiguriert. Wenn Sie diese Features präziser steuern möchten, verwenden Sie zusätzliche Subnetze.

Einzelnes VPC-Netzwerk und freigegebene VPC

Für Ressourcen mit gängigen Anforderungen mit einer einzelnen VPC beginnen

Zur Verwaltung mehrerer Arbeitsgruppen eine freigegebene VPC verwenden

Netzwerknutzerrolle auf Subnetzebene zuweisen

Nur ein Hostprojekt verwenden, wenn Ressourcen mehrere Netzwerkschnittstellen erfordern

Mehrere Hostprojekte verwenden, wenn Ressourcen das Kontingent eines einzelnen Projekts überschreiten

Mehrere Hostprojekte verwenden, wenn für jede VPC separate Verwaltungsrichtlinien benötigt werden

Für Ressourcen mit gängigen Anforderungen mit einem einzelnen VPC-Netzwerk beginnen

In vielen einfachen Anwendungsfällen reichen die Features eines einzelnen VPC-Netzwerks aus. Sie sind im Vergleich zu den komplexeren Alternativen leichter erstellbar, verwaltbar und verständlich. Wenn Sie Ressourcen mit gemeinsamen Anforderungen und Merkmalen in einem VPC -Netzwerk gruppieren, können Sie mögliche Probleme auf die jeweilige VPC eingrenzen.

Ein Beispiel für diese Konfiguration finden Sie in der Referenzarchitektur unter Ein Projekt, ein VPC-Netzwerk.

Zu den Faktoren, die Sie zum Erstellen zusätzlicher VPC-Netzwerke führen können, gehören Skalierung, Netzwerksicherheit, finanzielle Überlegungen, Betriebsanforderungen sowie Identitäts- und Zugriffsverwaltung (IAM).

Zur Verwaltung mehrerer Arbeitsgruppen eine freigegebene VPC verwenden

Freigegebene VPCs ermöglichen es Organisationen mit mehreren Teams, die architektonische Einfachheit eines einzelnen VPC-Netzwerks effektiv auf mehrere Arbeitsgruppen auszudehnen. Im einfachsten Szenario stellen Sie ein freigegebenes VPC-Hostprojekt mit einem einzelnen freigegebenen VPC-Netzwerk bereit. Anschließend hängen Sie Teamdienstprojekte an das Hostprojektnetzwerk an.

In dieser Konfiguration sind die Netzwerkrichtlinie und -steuerung für alle Netzwerkressourcen zentralisiert und einfach verwaltbar. Die für die Dienstprojekte zuständigen Teams können Ressourcen konfigurieren und verwalten, die keine Netzwerkressourcen sind. Dadurch lassen sich die Verantwortlichkeiten der verschiedenen Teams der Organisation klar trennen.

Die Ressourcen dieser Projekte können mithilfe interner IP-Adressen sicher und effizient über Projektgrenzen hinweg miteinander kommunizieren. Freigegebene Netzwerkressourcen wie Subnetze, Routen und Firewalls lassen sich von einem zentralen Hostprojekt aus verwalten, um konsistente Netzwerkrichtlinien für alle Projekte zu erzwingen.

Als Beispiel für diese Konfiguration dient die unter Ein Hostprojekt, mehrere Dienstprojekte, eine freigegebene VPC erläuterte Referenzarchitektur.

Rolle "Netzwerknutzer" auf Subnetzebene zuweisen

Der Administrator der zentralen freigegebene VPC kann Mitgliedern die Rolle des Netzwerknutzers (networkUser) entweder für eine spezifische Dienstprojektautorisierung auf der Subnetzebene oder für alle Subnetze auf der Hostprojektebene zuweisen.

Gemäß dem Prinzip der geringsten Berechtigungen wird empfohlen, die Netzwerknutzerrolle den erforderlichen Nutzern, Dienstkonten oder Gruppen auf der Subnetzebene zuzuweisen.

Da Subnetze regional sind, können Sie mit dieser detaillierten Steuerung angeben, welche Regionen jedes Dienstprojekt verwenden darf.

Die Architektur freigegebener VPCs bietet Ihnen außerdem die Flexibilität, mehrere freigegebene VPC-Hostprojekte in Ihrer Organisation bereitzustellen. Jedes freigegebene VPC-Hostprojekt kann dann ein oder mehrere freigegebene VPC-Netzwerke aufnehmen. In dieser Konfiguration können in unterschiedlichen Umgebungen unterschiedliche Richtlinien erzwungen werden.

Weitere Informationen finden Sie unter IAM-Rollen für netzwerkbezogene Jobfunktionen.

Nur ein Hostprojekt verwenden, wenn Ressourcen mehrere Netzwerkschnittstellen erfordern

Wenn im Rahmen eines Dienstprojekts Ressourcen für mehrere isolierte VPC-Netzwerke bereitzustellen sind, muss das Hostprojekt alle VPC-Netzwerke enthalten, in denen die Dienste bereitgestellt werden. Dies ist beispielsweise bei VM-Instanzen mit mehreren Netzwerkschnittstellen der Fall. Der Grund dafür ist, dass pro Hostprojekt nur ein Dienstprojekt angehängt werden darf.

Mehrere Hostprojekte verwenden, wenn Ressourcenanforderungen das Kontingent eines einzelnen Projekts überschreiten

Wenn die aggregierten Ressourcenanforderungen aller VPC-Netzwerke nicht innerhalb des Kontingents eines Projekts erfüllt werden können, ist eine Architektur mit mehreren Hostprojekten mit einem freigegebenen VPC-Netzwerk pro Hostprojekt gegenüber einem einzelnen Hostprojekt mit mehreren freigegebenen VPC-Netzwerken vorzuziehen. Dabei ist wichtig, die Skalierungsanforderungen zu bewerten, da für eine solche Architektur mehrere VPC-Netzwerke im Hostprojekt erforderlich sind und Kontingente auf Projektebene erzwungen werden.

Ein Beispiel für diese Konfiguration finden Sie in der Referenzarchitektur unter Mehrere Hostprojekte, mehrere Dienstprojekte und mehrere freigegebene VPCs.

Mehrere Hostprojekte verwenden, wenn Sie separate Verwaltungsrichtlinien für jedes VPC-Netzwerk benötigen

Da Projekte jeweils ein eigenes Kontingent haben, empfiehlt sich zum Aggregieren der Ressourcen, für jedes VPC-Netzwerk ein separates, freigegebenes VPC-Hostprojekt zu verwenden. Auf diese Weise erhält jedes VPC-Netzwerk separate IAM-Berechtigungen für die Netzwerk- und Sicherheitsverwaltung, da IAM-Berechtigungen ebenfalls auf Projektebene implementiert werden. Wenn Sie beispielsweise zwei VPC-Netzwerke (VPC-Netzwerk A und VPC-Netzwerk B) in demselben Hostprojekt bereitstellen, gilt die Netzwerkadministratorrolle (networkAdmin) für beide VPC-Netzwerke.

Entscheiden, ob mehrere VPC-Netzwerke erstellt werden sollen

Einzelnes VPC-Netzwerk pro Projekt erstellen, um VPC-Netzwerkkontingente zu Projekten zuzuordnen

VPC-Netzwerk für jedes unabhängige Team erstellen, mit freigegebenen Diensten in einem gemeinsamen VPC-Netzwerk

Für unabhängige IAM-Steuerung VPC-Netzwerke in unterschiedlichen Projekten erstellen

Sensible Daten in einem eigenen VPC-Netzwerk isolieren

Einzelnes VPC-Netzwerk pro Projekt erstellen, um VPC-Ressourcenkontingente zu Projekten zuzuordnen

Kontingente sind auf Projekt- oder Netzwerkebene angewendete Einschränkungen. Alle Ressourcen haben ein anfängliches Standardkontingent, das Sie vor einer unerwarteten Ressourcennutzung schützen soll. Es gibt jedoch zahlreiche Gründe, warum Ihr Kontingent erhöht werden sollte. Für die meisten Ressourcen können Sie zusätzliche Kontingente anfordern.

Wenn Sie die standardmäßigen VPC-Ressourcenkontingente voraussichtlich überschreiten werden, empfiehlt es sich, jeweils nur ein VPC-Netzwerk pro Projekt zu erstellen. So ist es einfacher, Kontingenterhöhungen auf Projektebene den jeweiligen VPC-Netzwerken zuzuordnen, als wenn Sie mehrere VPC-Netzwerke innerhalb eines Projekts haben.

Limits schützen Systemressourcen insgesamt. Limits lassen sich im Allgemeinen nicht einfach erhöhen. Wenden Sie sich in diesem Fall an das Support- oder Vertriebsteam vonGoogle Cloud .

Die aktuellen Kontingente und Limits für VPC-Ressourcen finden Sie hier.

Das Google-Supportteam kann bestimmte Skalierungslimits erhöhen. Mitunter müssen Sie jedoch mehrere VPCs erstellen, um Ihre Skalierungsanforderungen zu erfüllen. Wenn Ihr VPC-Netzwerk über die Grenzen hinaus skaliert werden muss, besprechen Sie Ihren Fall mit denGoogle Cloud -Vertriebs- und Supportteams, um den besten Ansatz für Ihre Anforderungen zu finden.

VPC-Netzwerk für jedes autonome Team mit freigegebenen Diensten in einem gemeinsamen VPC-Netzwerk erstellen

Bei einigen großen Unternehmens-Deployments sind autonome Teams involviert, die jeweils die vollständige Kontrolle über ihre VPC-Netzwerke benötigen. Damit Sie diese Anforderung erfüllen, erstellen Sie für jede Geschäftseinheit eine VPC mit freigegebenen Diensten in einer gemeinsamen VPC (z. B. Analysetools, CI/CD-Pipeline, Build-Maschinen, DNS-/Verzeichnisdienste).

VPC-Netzwerke in unterschiedlichen Projekten für unabhängige IAM-Steuerelemente erstellen

Ein VPC-Netzwerk ist eine Ressource auf Projektebene mit detaillierten IAM-Steuerelementen (Identity and Access Management) auf Projektebene, einschließlich der folgenden Rollen:

networkAdminsecurityAdminnetworkUsernetworkViewer

Standardmäßig werden IAM-Steuerelemente auf Projektebene bereitgestellt und jede IAM-Rolle gilt für alle VPCs innerhalb des Projekts.

Wenn Sie unabhängige IAM-Steuerelemente pro VPC-Netzwerk benötigen, erstellen Sie Ihre VPC-Netzwerke in verschiedenen Projekten.

Wenn Sie IAM-Rollen für Compute Engine-Ressourcen wie VM-Instanzen, Laufwerke und Images benötigen, verwenden Sie IAM-Richtlinien für Compute Engine-Ressourcen.

Sensible Daten im jeweiligen VPC-Netzwerk isolieren

Für Unternehmen, die mit Complianceinitiativen, sensiblen oder streng regulierten Daten zu tun haben, die Compliancestandards wie HIPAA oder PCI-DSS unterliegen, sind häufig weitere Sicherheitsmaßnahmen sinnvoll. Eine Methode zur Verbesserung der Sicherheit und zum leichteren Nachweis der Compliance besteht darin, jede der Umgebungen in einem eigenen VPC-Netzwerk zu isolieren.

Mehrere VPC-Netzwerke verbinden

VPC-Verbindungsmethode entsprechend Ihrem Budget sowie Ihren Leistungs- und Sicherheitsanforderungen auswählen

Network Connectivity Center-VPC-Spokes verwenden:

VPC-Netzwerk-Peering verwenden, wenn Sie NVAs einfügen müssen oder Ihre Anwendung Private Service Connect nicht unterstützt.

Externes Routing verwenden, wenn keine Kommunikation mit privaten IP-Adressen erforderlich ist

VPC-Netzwerke, die Dienstzugriffspunkte hosten, die nicht transitiv über Network Connectivity Center erreichbar sind, mithilfe von Cloud VPN verbinden

Mit virtuellen Appliances mit mehreren NICs Traffic zwischen VPC-Netzwerken über ein Cloud-Gerät steuern

VPC-Verbindungsmethode entsprechend Ihrem Budget sowie Ihren Leistungs- und Sicherheitsanforderungen auswählen

Der nächste Schritt nach der Entscheidung, mehrere VPC-Netzwerke zu implementieren, besteht darin, diese VPC-Netzwerke zu verbinden. VPC-Netzwerke sind isolierte Mandantenbereiche innerhalb des Andromeda-SDN von Google, aber es gibt mehrere Möglichkeiten, die Kommunikation zwischen ihnen zu ermöglichen. In den folgenden Abschnitten finden Sie Best Practices zur Auswahl der geeigneten VPC-Verbindungsmethode.

Die jeweiligen Vor- und Nachteile sind unten in der Tabelle zusammengefasst. In den weiteren Abschnitten folgen die Best Practices für die Auswahl einer VPC-Verbindungsmethode.

| Vorteile | Nachteile | |

|---|---|---|

| VPC-Spokes des Network Connectivity Centers |

|

|

| VPC-Netzwerk-Peering |

|

|

| Externes Routing (öffentliche IP oder NAT-Gateway) |

|

|

| Cloud VPN |

|

|

| Mehrere Netzwerkschnittstellen (NICs) |

|

|

Network Connectivity Center-VPC-Spokes verwenden

Wir empfehlen die Verwendung von Network Connectivity Center-VPC-Spokes, wenn Sie VPC-Netzwerke miteinander verbinden müssen. Network Connectivity Center-VPC-Spokes ermöglichen die Wiederverwendung von Adressen in VPCs im selben Projekt und in derselben Organisation oder in einem anderen Projekt und einer anderen Organisation.

VPC-Spokes des Network Connectivity Centers sind aus folgenden Gründen die bevorzugte Methode zum Verbinden von VPC-Netzwerken:

- Die Datenebene ist verteilt, sodass es keinen Gateway-Engpass gibt. Traffic wird über VPC-Netzwerke hinweg weitergeleitet, als ob sich die VMs im selben VPC-Netzwerk befinden.

- Netzwerkübergreifende Verbindungen zwischen verschiedenen Organisationen. Netzwerke umfassen sowohl VPCs als auch externe Netzwerke.

- Bis zu 250 VPC-Netzwerke pro Hub.

- Transitive Erreichbarkeit von Dienstzugriffspunkten über VPCs hinweg.

- Integriertes VPC-NAT, um die Wiederverwendung von IP-Adressen in VPCs zu ermöglichen.

- Definierte Regeln für die Netzwerkerreichbarkeit mit voreingestellten Topologien und Präfixfiltern.

VPC-Netzwerk-Peering verwenden, wenn Sie NVAs einfügen müssen oder Ihre Anwendung Private Service Connect nicht unterstützt

Wir empfehlen, VPC Network Peering zu verwenden, wenn Sie NVAs (Network Virtual Appliances) wie Firewall-VMs einfügen müssen. Möglicherweise müssen Sie NVAs für Traffic einfügen, der mehrere VPC-Netzwerke durchläuft, oder für private Verbindungen zu Diensten, die nicht mit Private Service Connect veröffentlicht werden.

Wenn Sie VPC-Netzwerk-Peering verwenden, achten Sie darauf, dass die Gesamtzahl der Ressourcen, die für alle direkt verbundenen Peers benötigt werden, die Limits für VM-Instanzen, die Anzahl der Peering-Verbindungen und die internen Weiterleitungsregeln nicht überschreitet.

Mit VPC-Netzwerk-Peering können zwei VPC-Netzwerke intern über das SDN von Google miteinander verbunden werden, unabhängig davon, ob sie zum selben Projekt oder zur selben Organisation gehören. Mit dem VPC-Netzwerk-Peering werden die Steuerungsebene und die Datenflussverteilung zwischen Peers zusammengeführt. Sie profitieren dadurch von denselben Weiterleitungseigenschaften, wie wenn sich alle VMs in derselben VPC befinden. Beim Peering von VPC-Netzwerken kann auf alle Subnetze, Alias-IP-Bereiche und internen Weiterleitungsregeln zugegriffen werden. Außerdem hat jedes VPC-Netzwerk ihre eigene verteilte Firewall. Das VPC-Netzwerk-Peering ist nicht transitiv.

Externes Routing verwenden, wenn keine Kommunikation mit privaten IP-Adressen erforderlich ist

Wenn keine Kommunikation mit privaten IP-Adressen erforderlich ist, können Sie ein externes Routing mit externen IP-Adressen oder ein NAT-Gateway verwenden.

Wenn ein VPC-Netzwerk bereitgestellt wird, wird eine Route zum Standard-Internetgateway von Google mit der Priorität 1.000 bereitgestellt. Wenn diese Route vorhanden ist und einer VM eine externe IP-Adresse zugewiesen wird, können VMs ausgehenden Traffic über das Internetgateway von Google senden. Sie können Dienste auch hinter einer der zahlreichen öffentlichen Load-Balancing-Lösungen von Google bereitstellen, mit denen die Dienste extern erreichbar sind.

Extern adressierte VMs kommunizieren unabhängig von Region und Network Service Tiers privat über das Google-Backbonenetzwerk. Verwenden Sie Google Cloud Firewallregeln, um extern eingehenden Traffic zu Ihren VMs zu steuern.

Externes Routing eignet sich gut zu Skalierungszwecken. Wichtig zu wissen ist jedoch, welche Kosten durch das öffentliche Routing anfallen. Weitere Informationen finden Sie in der Netzwerkpreisdokumentation.

VPC-Netzwerke mit Dienstzugriffspunkten verbinden, die über Network Connectivity Center nicht transitiv erreichbar sind

HA VPN bietet einen verwalteten Dienst zum Verbinden von VPC-Netzwerken. Dazu werden IPsec-Tunnel zwischen Endpunktgruppen erstellt. Wenn Sie Ihre Cloud Router mit benutzerdefiniertem Route Advertisement-Modus konfigurieren, können Sie das transitive Routing zwischen VPC-Netzwerken und Hub-and-Spoke-Topologien aktivieren, wie weiter unten in diesem Dokument beschrieben. Mit dem Network Connectivity Center können Sie HA VPN-Tunnel als Transitnetzwerk zwischen lokalen Netzwerken verwenden, wie in der Cloud VPN-Dokumentation erläutert.

Cloud VPN unterstützt keine großen MTU-Werte. Weitere Informationen finden Sie unter Überlegungen zur MTU.

Traffic zwischen VPC-Netzwerken über ein Cloud-Gerät mithilfe von virtuellen Appliances steuern

VMs mit mehreren Netzwerkschnittstellen sind für VPC-Netzwerke gängig, für deren Kommunikation untereinander erhöhte Sicherheit oder zusätzliche Dienste erforderlich sind. Der Grund dafür ist, dass die Kommunikation zwischen VPC-Netzwerken mit diesen VM-Instanzen überbrückt werden kann.

Eine VM darf pro verbundenem VPC-Netzwerk nur eine Schnittstelle haben. Zum Bereitstellen einer VM in mehreren VPC-Netzwerken benötigen Sie die entsprechende IAM-Berechtigung für jedes VPC-Netzwerk, zu dem die VM eine Verbindung herstellt.

Beachten Sie beim Bereitstellen einer VM mit mehreren NICs Folgendes:

- Eine VM mit mehreren NICs kann maximal acht Schnittstellen haben.

- Die Subnetz-IP-Bereiche der Schnittstellen dürfen sich nicht überschneiden.

Dienstverbindung

Mit Private Service Connect können Nutzer privat aus ihrem VPC-Netzwerk auf Dienste zugreifen, ohne dass ein netzwerkorientiertes Bereitstellungsmodell erforderlich ist. Ebenso können Ersteller diese Dienste in ihren eigenen separaten VPC-Netzwerken hosten und ihren Nutzern innerhalb derselben Organisation oder organisationsübergreifend eine private Verbindung bieten. Private Service Connect ermöglicht die Verbindung zu verwalteten Diensten von Google und Drittanbietern. Dadurch entfällt die Notwendigkeit der Zuweisung von Subnetzen für den Zugriff auf private Dienste und das VPC-Netzwerk-Peering.

Private Service Connect bietet ein dienstorientiertes Sicherheitsmodell mit den folgenden Vorteilen:

- Keine gemeinsamen Abhängigkeiten

- Ausdrückliche Autorisierung

- Leistung bei Leitungsgeschwindigkeit

Es gibt unterschiedliche Private Service Connect-Typen, die unterschiedliche Funktionen und Kommunikationsmodi bieten:

- Private Service Connect-Endpunkte: Endpunkte werden mit Weiterleitungsregeln bereitgestellt, die dem Nutzer eine IP-Adresse zur Verfügung stellen, die dem Private Service Connect-Dienst zugeordnet ist.

- Private Service Connect-Back-Ends: Back-Ends werden mithilfe von Netzwerk-Endpunktgruppen (NEGs) bereitgestellt, mit denen Nutzer Traffic an ihren Load Balancer weiterleiten können, bevor der Traffic einen Private Service Connect-Dienst erreicht. Wenn die Back-Ends mit einem HTTPS-Load-Balancer bereitgestellt werden, können sie Zertifikate unterstützen.

- Private Service Connect-Schnittstellen: Über Schnittstellen können Nutzer und Ersteller Traffic initiieren, was eine bidirektionale Kommunikation ermöglicht. Schnittstellen können im selben VPC-Netzwerk wie Endpunkte und Back-Ends verwendet werden.

Eine Alternative zu Private Service Connect ist der Zugriff auf private Dienste, mit dem Nutzer die Erstellerdienste über VPC-Netzwerk-Peering verbinden können. Wenn Sie den Zugriff auf private Dienste verwenden, empfehlen wir, die IP-Zuweisung für jeden Diensterstellerdienst, IP-Überschneidungen und das gemeinsame Kontingent zu berücksichtigen.

Hybrides Design: Lokale Umgebung vernetzen

Nach Möglichkeit dynamisches Routing verwenden

Ein VPC-Verbindungsnetzwerk verwenden, um eine Hub-and-Spoke-Architektur mit mehreren VPC-Netzwerken zu skalieren

Wenn Hybridkonnektivität erforderlich ist und Sie entsprechend Ihren Bandbreiten-, Leistungs- und Sicherheitsanforderungen eine Lösung ausgewählt haben, folgt die Überlegung, wie Sie die Lösung in Ihr VPC-Design einbinden.

Mithilfe einer freigegebenen VPC erübrigt sich die Replikation derselben Lösung für jedes Projekt. Wenn Sie beispielsweise eine Cloud Interconnect-Lösung in eine freigegebene VPC einbinden, können alle VMs – unabhängig von der Region oder vom Dienstprojekt – auf die Cloud Interconnect-Verbindung zugreifen.

Nach Möglichkeit dynamisches Routing verwenden

Dynamisches Routing ist für alle Hybridlösungen verfügbar, einschließlich Hochverfügbarkeits-VPN, klassisches VPN, Dedicated Interconnect und Partner Interconnect. Beim dynamischen Routing wird der Cloud Router von Google als BGP-Speaker (Border Gateway Protocol) für ein dynamisches eBGP-Routing (externes BGP) verwendet.

Der Cloud Router befindet sich nicht auf der Datenebene, sondern erstellt nur Routen im SDN.

Beim dynamischen Routing werden keine Tags verwendet. Außerdem bewirbt der Cloud Router gelernte Präfixe nicht wieder.

Sie können für jedes VPC-Netzwerk wahlweise den regionalen oder globalen Cloud Router-Modus aktivieren. Beim regionalen Routing bewirbt der Cloud Router nur Subnetze, die sich in derselben Region wie der Cloud Router befinden. Beim globalen Routing hingegen werden alle Subnetze des angegebenen VPC-Netzwerks unabhängig von der Region beworben. Für außerhalb der Region beworbene und erkannte Routen werden jedoch Strafen auferlegt. Dies erhält die Symmetrie innerhalb der Region aufrecht, da lokale Verbindungen immer bevorzugt werden. Zur Berechnung wird ein Strafmesswert (MED) addiert, der 200 + TTL in Millisekunden zwischen Regionen entspricht.

Statisches Routing

Statisches Routing ist nur im klassischen VPN verfügbar. Damit kann in einem Cloud VPN-Tunnel ein Routenpunkt als nächster Hop festgelegt werden.

Standardmäßig gilt eine statische Route unabhängig von der Region für alle VMs im Netzwerk. Beim statischen Routing können Netzwerkadministratoren mithilfe von Instanztags auch gezielt festlegen, für welche VMs die Route gilt. Die Tags können Sie bei der Routenerstellung angeben.

Statische Routen gelten global im VPC-Netzwerk mit derselben Routenpriorität. Wenn Sie also mehrere Tunnel in mehreren Regionen mit demselben Präfix und derselben Priorität haben, verwendet eine VM in allen Tunneln einen Hash-basierten ECMP mit fünf Tupeln. Zur Optimierung können Sie eine bevorzugte Route innerhalb der Region erstellen. Referenzieren Sie hierfür Instanztags für jede Region und erstellen Sie bevorzugte Routen.

Wenn ausgehender Traffic nicht über das Standard-Internetgateway von Google geleitet werden soll, können Sie eine bevorzugte statische Standardroute festlegen, um den gesamten Traffic lokal über einen Tunnel zurückzusenden.

Ein VPC-Verbindungsnetzwerk verwenden, um eine Hub-and-Spoke-Architektur mit mehreren VPC-Netzwerken zu skalieren

Wenn Sie eine Hub-and-Spoke-Architektur mit mehreren VPC-Netzwerken skalieren müssen, konfigurieren Sie die zentralisierte Hybridkonnektivität in einem oder mehreren dedizierten VPC-Netzwerken und fügen Sie dann die Hybridverbindungen und alle VPC-Spokes einem Network Connectivity Center-Hub hinzu. Sie müssen den Routenaustausch mit VPC-Spokes aktivieren. Mit dieser Konfiguration können statische Routen oder dynamisch erkannte Routen in VPC-Spokes exportiert werden, um eine zentrale Konfiguration und Skalierung Ihres VPC-Netzwerkdesigns zu ermöglichen.

Das folgende Diagramm zeigt ein zentralisiertes Hybridkonnektivitätsdesign mit dem Network Connectivity Center:

Alternativ können Sie VPC-Netzwerk-Peering und benutzerdefinierte beworbene Routen verwenden, um Zugriff auf freigegebene Hybridverbindungen zu ermöglichen, wenn Sie die Ressourcenlimits nicht überschreiten und NVAs verwenden müssen.

Das folgende Diagramm zeigt die zentralisierte Hybridkonnektivität mit VPC-Netzwerk-Peering-Routen:

Dieses zentralisierte Design unterscheidet sich vom herkömmlichen Deployment von Hybridkonnektivität, bei dem in jedem VPC-Netzwerk VPN-Tunnel oder VLAN-Anhänge verwendet werden.

Netzwerksicherheit

Klare Sicherheitsziele identifizieren

Externen Zugriff beschränken

Dienstperimeter für sensible Daten definieren

Traffic nach Möglichkeit mit Google Cloud Firewallregeln verwalten.

Nach Möglichkeit weniger, aber dafür umfassendere Firewallregelsätze verwenden

VMs nach Möglichkeit mithilfe von Dienstkonten isolieren

Bei Verwendung von Tags Sicherheitsrichtlinien automatisch überwachen

Anwendungen mit zusätzlichen Tools sichern und schützen

Google Cloud bietet für die Infrastruktur und Dienste robuste Sicherheitsfunktionen, angefangen beim physischen Schutz der Rechenzentren und speziell angefertigter Sicherheitshardware bis hin zu dedizierten Sicherheitsteams. Die Sicherung IhrerGoogle Cloud -Ressourcen ist jedoch eine Aufgabe, die in gemeinsamer Verantwortung gelöst werden muss. Sie sind für den Schutz Ihrer Anwendungen und Daten durch geeignete Maßnahmen zuständig.

Klare Sicherheitsziele identifizieren

Bevor Sie cloudnative oder cloudfähige Sicherheitskontrollen bewerten, sollten Sie eine Reihe klarer Sicherheitsziele des Produkts vorgeben, die von allen Beteiligten als grundlegender Bestandteil anerkannt werden. Bei diesen Zielen sollten die Erreichbarkeit, Dokumentation und Iteration im Vordergrund stehen und während der gesamten Entwicklung berücksichtigt und optimiert werden.

Externen Zugriff beschränken

Wenn Sie eine Google Cloud -Ressource erstellen, die ein VPC-Netzwerk verwendet, wählen Sie ein Netzwerk und ein Subnetz aus, in dem sich die Ressource befindet. Der Ressource wird eine interne IP-Adresse aus einem der IP-Bereiche zugewiesen, die dem Subnetz zugeordnet sind. Ressourcen in einem VPC-Netzwerk können über interne IP-Adressen miteinander kommunizieren, sofern die Firewallregeln dies zulassen.

Beschränken Sie den Internetzugriff auf wirklich erforderliche Ressourcen. Ressourcen, die nur eine private, interne IP-Adresse haben, können über Private Service Connect oder den privaten Google-Zugriff dennoch auf viele Google APIs und Google-Dienste zugreifen. Ein privater Zugriff ermöglicht Ressourcen die Interaktion mit wichtigen Google- und Google Cloud -Diensten, ohne die Isolation vom öffentlichen Internet aufzuheben.

Außerdem können Sie die Organisationsrichtlinien verwenden, um einzuschränken, welche Ressourcen externe IP-Adressen verwenden dürfen.

Wenn Sie VMs den Zugriff auf das Internet erlauben möchten, verwenden Sie Secure Web Proxy, wenn der Traffic über HTTP(S) heruntergeladen werden kann und Sie Identitätskontrollen implementieren möchten. Verwenden Sie andernfalls Cloud NAT.

Dienstperimeter für sensible Daten definieren

Bei Arbeitslasten, die sensible Daten involvieren, können Sie mithilfe von VPC Service Controls Dienstperimeter für Ihre VPC-Ressourcen und die von Google verwalteten Dienste konfigurieren und Datenbewegungen über die Perimetergrenze hinweg steuern. VPC Service Controls bietet Ihnen die Möglichkeit, Projekte und Ihr lokales Netzwerk innerhalb eines Perimeters zusammenzufassen, um den Datenzugriff über von Google verwaltete Dienste zu verhindern. Innerhalb von Dienstperimetern können sich keine Projekte anderer Organisationen befinden. Die Projekte und Dienste in unterschiedlichen Dienstperimetern können jedoch über Perimeter-Bridges miteinander kommunizieren.

Traffic nach Möglichkeit mit Google Cloud Firewallregeln verwalten

Google Cloud Die VPC enthält eine zustandsorientierte Firewall, die horizontal skalierbar ist und auf alle VMs verteilt angewendet wird. Weitere Informationen finden Sie in der Übersicht zu Cloud NGFW.

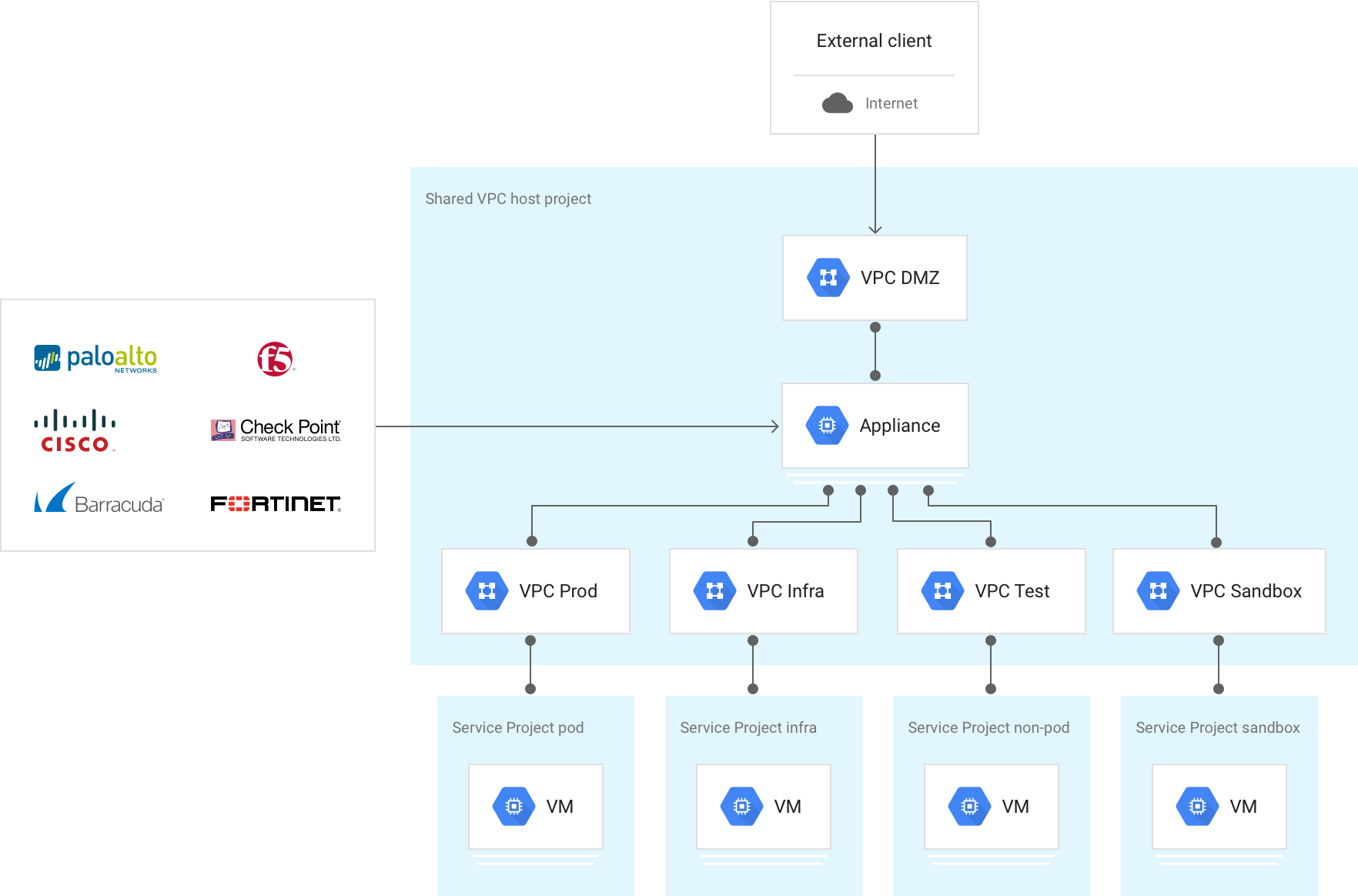

Der Google Cloud Marketplace bietet eine große Auswahl an Lösungen von Drittanbietern, einschließlich VMs, die Folgendes bieten: erweiterte Sicherheit wie Schutz vor Informationslecks, Exploits von Anwendungen und Eskalation von Berechtigungen, Erkennung bekannter und unbekannter Bedrohungen und Anwendung von URL-Filterung. Die Richtlinienimplementierung eines einzigen Anbieters für Cloud-Dienstanbieter und lokale Umgebungen bietet auch operative Vorteile.

Die für die Weiterleitung des Traffics an diese VMs festgelegten Routen haben in der Regel entweder dieselbe Priorität, um den Traffic mit einem 5-Tupel-Hash zu verteilen, oder unterschiedliche Prioritäten, um einen redundanten Pfad zu erstellen. Im folgenden Diagramm sehen Sie, dass mehrere Pfade zum Dev-Subnetz (Dev-subnet) führen.

Für die meisten Lösungen sind mehrere VMs mit Netzwerkschnittstelle erforderlich. Da eine VM nicht mehr als eine Schnittstelle pro VPC-Netzwerk haben kann, muss jede Schnittstelle beim Erstellen einer VM mit mehreren Schnittstellen an ein separates VPC-Netzwerk angehängt werden.

Auch die Skalierung spielt aus folgenden Gründen eine wichtige Rolle beim Deployment von Drittanbieterlösungen in Ihrem VPC-Netzwerk:

- Limits: Die meisten VM-basierten Appliances müssen in den Datenpfad eingefügt werden. Dies erfordert eine VM mit mehreren Netzwerkschnittstellen, die mehrere VPC-Netzwerke verbindet, die sich im selben Projekt befinden. Da VPC-Ressourcenkontingente auf Projektebene festgelegt werden, ist die aggregierte Ressourcennutzung in allen VPC-Netzwerken begrenzt.

- Leistung: Die vollständige horizontale Skalierbarkeit einer VPC durch einen einzelnen VM-basierten Engpass einzuschränken widerspricht den Methoden für das Clouddesign. Um dies zu vermeiden, können Sie mehrere virtuelle Appliances für Netzwerke in einer verwalteten Instanzgruppe hinter einem internen Passthrough-Network Load Balancer platzieren.

Sie können diese Faktoren in Architekturen mit umfangreichen Anforderungen berücksichtigen. Übertragen Sie hierfür Sicherheitskontrollen an Ihre Endpunkte. Härten Sie zuerst Ihre VMs und wenden Sie Google Cloud-Firewallregeln an. Sie können zu diesem Zweck auch hostbasierte Agents für die Endpunktüberprüfung nutzen, mit denen die Weiterleitungsarchitektur Ihres VPC-Netzwerk über VMs mit mehreren Netzwerkschnittstellen beibehalten wird.

Ein weiteres Beispiel für diese Konfiguration finden Sie in der Referenzarchitektur unter Zustandsorientierte L7-Firewall zwischen VPCs.

Nach Möglichkeit weniger, aber dafür umfassendere Firewallregelsätze verwenden

Auf einer beliebigen VM kann nur eine bestimmte Anzahl von Regeln programmiert werden. Sie haben jedoch die Möglichkeit, mehrere Regeln in einer komplexen Regeldefinition zu kombinieren. Wenn beispielsweise alle VMs im VPC-Netzwerk zehn eingehende TCP-Ports explizit zulassen müssen, haben Sie zwei Möglichkeiten: Sie schreiben zehn separate Regeln, die jeweils einen einzelnen Port definieren, oder eine einzelne Regel, die alle zehn Ports enthält. Effizienter ist es, eine Regel für alle zehn Ports zu definieren.

Erstellen Sie einen generischen Regelsatz für das gesamte VPC-Netzwerk und wenden Sie dann für kleinere Gruppen von VMs mithilfe von Zielen speziellere Regelsätze an. Beginnen Sie also mit allgemeineren Regeln und definieren Sie dann schrittweise spezifischere Regeln:

- Wenden Sie Firewallregeln an, die für alle VMs im VPC-Netzwerk gelten.

- Wenden Sie Firewallregeln an, die für mehrere VMs, wie etwa eine Dienstinstanzgruppe oder ein Subnetz, gelten.

- Wenden Sie Firewallregeln auf einzelne VMs an, wie etwa ein NAT-Gateway oder einen Bastion Host.

VMs nach Möglichkeit mithilfe von Dienstkonten isolieren

Viele Organisationen haben Umgebungen, in denen für eine Teilmenge der VMs in einem VPC-Netzwerk bestimmte Regeln erforderlich sind. Hierfür bietet sich wahlweise die Subnetzisolierung oder die Zielfilterung an.

Subnetzisolierung

Bei der Subnetzisolierung bildet das Subnetz die Sicherheitsgrenze, auf die Google Cloud Firewallregeln angewendet werden. Dieser Ansatz ist in lokalen Netzwerkkonstrukten üblich. Er gilt auch, wenn IP-Adressen und die Netzwerkplatzierung Teil der VM-Identität sind.

Sie können die VMs in einem bestimmten Subnetz mithilfe eines eindeutigen Tags, eines Netzwerktags oder eines Dienstkontos auf diese Instanzen identifizieren. So können Sie Firewallregeln erstellen, die nur für die VMs in einem Subnetz gelten – denen ein Tag, ein Netzwerk-Tag oder ein Dienstkonto zugewiesen wurde. Sie können beispielsweise eine Firewallregel erstellen, die die gesamte Kommunikation zwischen VMs in einem Subnetz zulässt. Hierfür konfigurieren Sie die Regel auf der Seite "Firewallregeln" in folgender Weise:

- Ziele: Specified target tags

- Zieltags: subnet-1

- Quellfilter: Subnets

- Subnetze: Subnetz nach Name auswählen, z. B. subnet-1

Zielfilterung

Bei der Zielfilterung befinden sich alle VMs entweder im selben Subnetz oder sind Teil einer beliebigen Gruppe von Subnetzen. Die Subnetzmitgliedschaft wird bei diesem Ansatz nicht als Teil der Instanzidentität für Firewallregeln betrachtet. Stattdessen können Sie den Zugriff zwischen VMs im selben Subnetz mit Tags, Netzwerktags oder Dienstkonten einschränken. Auf jede Gruppe von VMs, die dieselben Firewallregeln verwenden, wird dasselbe Netzwerktag angewendet.

Stellen Sie sich zur Veranschaulichung eine dreistufige Anwendung (Web, Anwendung, Datenbank) vor, für die alle Instanzen im selben Subnetz bereitgestellt werden. Die Webebene kann mit Endnutzern und der Anwendungsebene und die Anwendungsebene mit der Datenbankebene kommunizieren. Ansonsten ist keine Kommunikation zwischen Ebenen zulässig. Die Instanzen, auf denen die Webebene ausgeführt wird, haben das Netzwerktag web, die Instanzen, auf denen die Anwendungsebene ausgeführt wird, haben das Netzwerktag app und die Instanzen, auf denen die Datenbankebene ausgeführt wird, haben das Netzwerktag db.

Dieser Ansatz wird durch die folgenden Firewallregeln implementiert:

| Regel 1: Endnutzer zulassen → Webebene | Ziele: Angegebene Zieltags Zieltags: web Quellfilter: IP-Bereiche Quell-IP-Bereiche: 0.0.0.0/0 |

| Regel 2: Webebene zulassen → Anwendungsebene | Ziele: Angegebene Zieltags Zieltags: app Quellfilter: Quelltags Quelltags: web |

| Regel 3: Anwendungsebene zulassen → Datenbankebene | Ziele: Angegebene Zieltags Zieltags: db Quellfilter: Quelltags Quelltags: app |

Obwohl Tags auf diese Weise für die Zielfilterung verwendet werden können, empfehlen wir nach Möglichkeit die Verwendung von Tags oder Dienstkonten. Zieltags sind nicht zugriffsgesteuert und können von einem Nutzer während der Ausführung von VMs mit der Rolle instanceAdmin geändert werden. Tags und Dienstkonten sind zugriffsgesteuert. Dies bedeutet, dass ein Nutzer ausdrücklich zur Verwendung eines Dienstkontos berechtigt sein muss.

Jede Instanz kann nur ein Dienstkonto, aber mehrere Tags haben. Außerdem können die einer VM zugewiesenen Dienstkonten nur geändert werden, wenn die VM angehalten wird.

Bei Verwendung von Tags Sicherheitsrichtlinien automatisch überwachen

Denken Sie bei der Verwendung von Netzwerktags daran, dass diese von Instanzadministratoren geändert werden können. Dies ermöglicht ein Umgehen der Sicherheitsrichtlinien. Wenn Sie Netzwerktags in einer Produktionsumgebung verwenden, sollten Sie daher als Ausgleich für fehlende IAM-Governance hinsichtlich der Netzwerktags ein Automatisierungsframework verwenden.

Anwendungen mit zusätzlichen Tools sichern und schützen

Verwenden Sie neben den Firewallregeln die folgenden zusätzlichen Tools, um Ihre Anwendungen zu sichern und zu schützen:

- Verbessern Sie mit einem Google Cloud globalen HTTP(S)-Load-Balancer die Hochverfügbarkeit und Protokollnormalisierung.

- Binden Sie Google Cloud Armor in den HTTP(S)-Load-Balancer ein, um DDoS-Schutz bereitzustellen und IP-Adressen am Netzwerkrand zu blockieren oder zuzulassen.

- Mithilfe von IAP (IAP) können Sie den Anwendungszugriff steuern. Prüfen Sie hierfür die Nutzeridentität und den Kontext von Anfragen und bestimmen Sie, ob einem Nutzer Zugriff gewährt werden soll.

- Stellen Sie mit Security Command Center eine zentrale Oberfläche bereit, über die Sie den Sicherheitsstatus prüfen sowie Anomalien und Sicherheitslücken erkennen können.

Netzwerkdienste: NAT und DNS

Feste externe IP-Adressen mit Cloud NAT verwenden

IP-Adressen in mehreren VPCs mit Cloud NAT wiederverwenden

Private DNS-Zonen für die Namensauflösung verwenden

Für feste externe IP-Adressen Cloud NAT verwenden

Wenn Sie feste externe IP-Adressen aus einem Bereich von VMs benötigen, verwenden Sie Cloud NAT. Feste ausgehende IP-Adressen können beispielsweise erforderlich sein, wenn ein Drittanbieter Anfragen von bestimmten externen IP-Adressen zulässt. Mit Cloud NAT können Sie für die ausgehende Kommunikation eine kleine Anzahl von NAT-IP-Adressen pro Region verwenden.

Cloud NAT lässt auch zu, dass die VM-Instanzen ohne eigene externe IP-Adresse über das Internet kommunizieren. Google Cloud Firewallregeln sind zustandsbehaftet. Wenn eine Verbindung zwischen einer Quelle und einem Ziel oder einem Ziel und einem anderen Ziel zugelassen wird, ist somit der gesamte Traffic in beide Richtungen zulässig, solange die Verbindung aktiv ist. Dies bedeutet, dass Firewallregeln eine bidirektionale Kommunikation erlauben, sobald eine Sitzung eingerichtet wurde.

IP-Adressen mit Cloud NAT in mehreren VPCs wiederverwenden

IP-Adressen können in mehreren VPCs wiederverwendet werden, wenn Cloud NAT für Network Connectivity Center aktiviert ist. Inter-VPC Cloud NAT ist verfügbar, wenn VPCs über Network Connectivity Center-VPC-Spokes verbunden sind. Wenn sich die VPC-IP-Adressen mit Bereichen in externen Netzwerken überschneiden, aktivieren Sie Hybrid NAT. Nur Verbindungen, die von Arbeitslasten in Google Cloud zu externen Netzwerken initiiert werden, werden übersetzt.

Für die Namensauflösung private DNS-Zonen verwenden

Verwenden Sie private Zonen in Cloud DNS, damit Ihre Dienste mit DNS innerhalb Ihres VPC-Netzwerks unter Verwendung ihrer internen IP-Adressen aufgelöst werden können, ohne dass diese Zuordnung nach außen erfolgt.

Verwenden Sie Split-Horizon-DNS, um Dienste anderen IP-Adressen von innerhalb des VPC-Netzwerks anstatt von außerhalb zuzuordnen. Sie können beispielsweise einen Dienst aus dem öffentlichen Internet mithilfe von Netzwerk-Load-Balancing bereitstellen lassen und denselben Dienst gleichzeitig durch internes Load-Balancing mit demselben DNS-Namen innerhalb des VPC-Netzwerks bereitstellen.

API-Zugriff für von Google verwaltete Dienste

Nach Möglichkeit das Standard-Internetgateway verwenden

Explizite Routen für Google APIs hinzufügen, wenn Sie die Standardroute ändern müssen

Instanzen bereitstellen, die im selben Subnetz Google APIs verwenden

Nach Möglichkeit das Standard-Internetgateway verwenden

Der Zugriff von Ressourcen innerhalb des VPC-Netzwerks auf Google APIs erfolgt über den nächsten Standard-Internetgateway. Trotz des Namens des Gateways für den nächsten Hop bleibt der Trafficpfad von Instanzen zu den Google APIs im Google-Netzwerk.

Standardmäßig können nur VM-Instanzen mit einer externen IP-Adresse mit Google APIs und Diensten kommunizieren. Wenn Sie Zugriff von Instanzen ohne externe IP-Adresse benötigen, richten Sie Private Service Connect-Endpunkte ein oder verwenden Sie für jedes Subnetz den privaten Google-Zugriff. Die Kommunikationsgeschwindigkeit von Google APIs bleibt dabei erhalten.

In Google Kubernetes Engine (GKE) wird der private Google-Zugriff in Subnetzen, in denen Knoten bereitgestellt werden, automatisch aktiviert. Alle Knoten in diesen Subnetzen ohne externe IP-Adresse können auf von Google verwaltete Dienste zugreifen.

Explizite Routen für Google APIs hinzufügen, wenn Sie die Standardroute ändern müssen

Wenn Sie die Standardroute ändern müssen, fügen Sie explizite Routen für Google API-Ziel-IP-Bereiche hinzu.

Konfigurieren Sie in Umgebungen, in denen die Standardroute (0.0.0.0/0) nicht das Standard-Internetgateway für den nächsten Hop verwendet, explizite Routen für die von Google APIs verwendeten Ziel-IP-Adressbereiche. Legen Sie als nächsten Hop der expliziten Routen das Standard-Internetgateway fest. Dies ist beispielsweise empfehlenswert, wenn Sie den gesamten Traffic auf einem lokalen Gerät prüfen möchten.

Instanzen bereitstellen, die im selben Subnetz Google APIs verwenden

Stellen Sie Instanzen bereit, die Zugriff auf Google APIs und Dienste im selben Subnetz benötigen. Aktivieren Sie für Instanzen ohne externe IP-Adressen den privaten Google-Zugriff. Alternativ können Sie Private Service Connect-Endpunkte einrichten.

Wenn Sie von Ihrer lokalen Umgebung aus über den privaten Google-Zugriff auf Google APIs zugreifen, verwenden Sie Privaten Google-Zugriff für lokale Hosts konfigurieren, um über private IP-Adressbereiche auf einige Google-Dienste zuzugreifen. Prüfen Sie vor dem Aktivieren dieses Features, welche Dienste unterstützt werden, da über die von diesem Dienst bereitgestellten IP-Adressen nicht auf andere Google APIs zugegriffen werden kann. Zum Aktivieren dieses Features kann eine zusätzliche DNS-Konfiguration, etwa der DNS-Ansichten, erforderlich sein.

Wenn Sie von Ihrer lokalen Umgebung über Private Service Connect-Endpunkte auf Google APIs zugreifen, finden Sie weitere Informationen unter Über lokale Hosts auf den Endpunkt zugreifen.

Logging, Monitoring und Sichtbarkeit

Logging für bestimmte Anwendungsfälle und vorgesehene Zielgruppen anpassen

Intervall der Logaggregation für VPC-Netzwerke mit lang andauernden Verbindungen erhöhen

Volumen durch VPC-Flusslog-Sampling reduzieren.

Zusätzliche Metadaten entfernen, wenn Sie nur IP- und Portdaten benötigen Network Intelligence Center verwenden, um Informationen zu Ihren Netzwerken zu erhalten

Logging für bestimmte Anwendungsfälle und vorgesehene Zielgruppen anpassen

Verwenden Sie VPC-Flusslogs für die Netzwerküberwachung, die Forensik, Echtzeit-Sicherheitsanalysen und die Kostenoptimierung. Sie können VPC-Flusslogs auf der VPC-Subnetzebene aktivieren oder deaktivieren. Wenn für ein Subnetz VPC-Flusslogs aktiviert sind, werden Daten von allen VM-Instanzen in diesem Subnetz erfasst.

In diesen Logs wird eine Stichprobe der von VM-Instanzen gesendeten und empfangenen Netzwerkflüsse aufgezeichnet. Anhand Ihrer Logging-Anwendungsfälle können Sie feststellen, für welche Subnetze ein Logging erforderlich ist und wie lange.

Flusslogs werden nach Verbindung in 5-Sekunden-Intervallen von Compute Engine-VMs aggregiert und in Echtzeit exportiert. Sie können Flusslogs in Cloud Logging anzeigen und an ein beliebiges Ziel exportieren, das vom Cloud Logging-Export unterstützt wird.

In Logging wird auf der Seite "Logs injection" (Logaufnahme) das Logvolumen in Ihrem Projekt verfolgt. Außerdem können Sie hier alle Logaufnahmen deaktivieren oder für Sie irrelevante Logeinträge ausschließen bzw. verwerfen. Dadurch minimieren Sie die Kosten für Logs über Ihr monatliches Kontingent hinaus.

Logs sind für den Betrieb und die Sicherheit wichtig. Sie sind jedoch nur nützlich, wenn sie auch geprüft werden, um gegebenenfalls Maßnahmen ergreifen zu können. Passen Sie Logs zur Optimierung des Betriebs und der Sicherheit Ihrer VPC-Netzwerke für die gewünschte Zielgruppe an.

Weitere Informationen finden Sie unter VPC-Flusslogs verwenden.

Intervall der Logaggregation für VPC-Netzwerke mit lang andauernden Verbindungen erhöhen

Legen Sie für VPC-Netzwerke mit meist langlebigen Verbindungen das Logaggregationsintervall auf 15 Minuten fest, um die Anzahl der generierten Logs erheblich zu reduzieren und eine schnellere und einfachere Analyse zu ermöglichen.

Ein Beispiel für einen Workflow, für den das Logaggregationsintervall verlängert werden kann, ist die Netzwerküberwachung. Diese beinhaltet die folgenden Aufgaben:

- Netzwerkdiagnose ausführen

- Flusslogs nach VMs und Anwendungen filtern, um Trafficänderungen zu verstehen

- Trafficanstieg zur Vorhersage der Kapazität analysieren

Volumen durch VPC-Flusslog-Sampling reduzieren

Reduzieren Sie durch das VPC-Flusslog-Sampling das Volumen der VPC-Flusslogs. Sie können dennoch weiter detaillierte Beispiele und allgemeine Zusammenfassungen ansehen.

Ein Beispiel für einen Workflow, bei dem sich durch Sampling das Volumen reduzieren lässt, ist das Untersuchen der Netzwerkauslastung und die Kostenoptimierung des Netzwerkverkehrs. Dieser Workflow beinhaltet die folgenden Aufgaben:

- Traffic zwischen Regionen und Zonen schätzen

- Internettraffic in bestimmte Länder schätzen

- Top Talkers identifizieren

Zusätzliche Metadaten entfernen, wenn Sie nur IP- und Portdaten benötigen

Wenn Sie hinsichtlich der Sicherheit nur an IP-Adressen und Ports interessiert sind, entfernen Sie die zusätzlichen Metadaten, um das Datenvolumen in Cloud Logging zu reduzieren.

Ein Beispiel für einen Workflow, bei dem Metadaten entfernt werden können, ist die Netzwerkforensik. Diese beinhaltet die folgenden Aufgaben:

- Ermitteln, welche IP-Adressen mit wem und wann kommuniziert haben

- Manipulierte IP-Adressen identifizieren, die durch Analysieren von Netzwerkflüssen ermittelt wurden

Network Intelligence Center verwenden, um Informationen zu Ihren Netzwerken zu erhalten

Das Network Intelligence Center bietet eine zentrale Konsole für die Verwaltung von Google Cloud Netzwerksichtbarkeit, Monitoring und Fehlerbehebung. In den folgenden Abschnitten finden Sie Details zu den Komponenten des Network Intelligence Center.

Netzwerktopologie

Mit Netzwerktopologie können Sie Ihre Netzwerktopologie visualisieren.

Konnektivitätstests

Mit Konnektivitätstests können Sie Verbindungsprobleme mit Ihren VPC-Netzwerken diagnostizieren.

Dashboard zur Leistungsüberwachung

Verwenden Sie das Leistungs-Dashboard, um die Leistung des physischen Netzwerks zu prüfen, das Ihren virtuellen VPC-Netzwerken zugrunde liegt.

Firewall Insights

Mit Firewall Insights können Sie sich einen Überblick über Ihre Firewallregeln und deren Interaktion verschaffen.

Network Analyzer

Mit dem Network Analyzer können Sie Ihre VPC-Netzwerkkonfigurationen überwachen und Fehlkonfigurationen und suboptimale Konfigurationen erkennen.

Flow Analyzer

Mit Flow Analyzer können Sie VPC-Trafficflüsse besser nachvollziehen.

Referenzarchitekturen

In diesem Abschnitt werden zur Veranschaulichung einiger der Best Practices in diesem Dokument verschiedene Architekturen vorgestellt.

Einzelnes Projekt und einzelnes VPC-Netzwerk

Diese anfängliche Referenzarchitektur umfasst alle Komponenten, die für das Deployment hochverfügbarer Architekturen in mehreren Regionen erforderlich sind. Sie bietet eine Isolierung auf Subnetzebene sowie eine SLA mit 99,99 % Verfügbarkeit für die Verbindung zu Ihren lokalen Rechenzentren.

Einzelnes Hostprojekt, mehrere Dienstprojekte, einzelne freigegebene VPC

Diese Architektur baut auf der anfänglichen Referenzarchitektur auf. Über freigegebene VPC-Hostprojekte und Projekte mit mehreren Diensten können Administratoren Verwaltungsaufgaben wie das Erstellen und Verwalten von Instanzen an Dienstprojektadministratoren delegieren, ohne die zentrale Steuerung von Netzwerkressourcen wie Subnetzen, Routen und Firewalls aus der Hand zu geben.

Mehrere Hostprojekte, mehrere Dienstprojekte, mehrere freigegebene VPCs

Das folgende Diagramm zeigt eine Architektur für die VPC-Isolierung, die auf unserem Hochverfügbarkeitsdesign aufbaut und gleichzeitig die Produktion von anderen Projekten trennt. Es gibt viele Gründe, die VPC-Isolierung in Betracht zu ziehen, wie etwa Überprüfungsanforderungen (z. B. PCI), zwischen Umgebungen erforderliche Kontingente oder einfach eine weitere logische Isolierungsebene. Für die Redundanz benötigen Sie pro Standort nur zwei Interconnect-Verbindungen. Sie können jedoch mehreren VPC-Netzwerken oder Regionen davon diverse Interconnect-Anhänge hinzufügen.

Durch die Isolierung kann abhängig davon, wo Kerndienste wie Proxys, Authentifizierung und Verzeichnisdienste platziert werden sollen, auch eine Replikation erforderlich sein. Die Verwendung eines VPC-Netzwerk für freigegebene Dienste kann dazu beitragen, diese Replikation zu vermeiden. Außerdem können Sie diese Dienste über das Network Connectivity Center für andere VPC-Netzwerke freigeben und gleichzeitig die Verwaltung und Bereitstellung zentralisieren.

Zustandsorientierte L7-Firewall zwischen VPC-Netzwerken

Diese Architektur verfügt über mehrere VPC-Netzwerke, die von einer L7-Firewall-Appliance der nächsten Generation (NGFW) überbrückt werden, die als Multi-NIC-Brücke zwischen VPC-Netzwerken fungiert.

Ein nicht vertrauenswürdiges, externes VPC-Netzwerk wird eingeführt, um Hybridverbindungen und internetbasierte Verbindungen zu beenden, die zur Prüfung am Außenabschnitt der L7 NGFW enden. Dieses Design gibt es in zahlreichen Varianten. Das Hauptprinzip besteht jedoch darin, den Traffic durch die Firewall zu filtern, bevor er vertrauenswürdige VPC-Netzwerke erreicht.

Bei diesem Design muss sich jedes VPC-Netzwerk in dem Projekt befinden, in das Sie die VM-basierte NGFW einfügen. Da Kontingente auf Projektebene erzwungen werden, müssen Sie die Summe aller VPC-Ressourcen berücksichtigen.

Mehrere VPC-Netzwerke, die über Network Connectivity Center miteinander verbunden sind

Diese Architektur umfasst mehrere VPC-Netzwerke, die über Network Connectivity Center miteinander verbunden sind. Ein Transit-VPC-Netzwerk wird eingeführt, um Hybrid-Interconnects zu beenden und die Hybridkonnektivität für alle anderen VPCs freizugeben. So müssen keine VLAN-Anhänge für jedes VPC-Netzwerk erstellt werden. Bei diesem Ansatz werden die externe Konnektivität und die zugehörigen Routing-Überlegungen konsolidiert. Ebenso können ein oder mehrere VPC-Netzwerke für freigegebene Dienste eingeführt werden, um gemeinsame Dienste wie Proxys, Authentifizierung und Verzeichnisdienste zu hosten. Dieses Design gibt es in zahlreichen Varianten. Das Hauptprinzip besteht jedoch darin, die verschiedenen Dienste und Verbindungstypen als Spokes eines Network Connectivity Center-Hubs zu behandeln, der Any-to-Any-Konnektivität zwischen diesen bietet. Diese Referenzarchitektur wird ausführlich unter Cross-Cloud-Netzwerk-Inter-VPC-Konnektivität mit Network Connectivity Center beschrieben.

Nächste Schritte

- Cloudübergreifendes Netzwerk für verteilte Anwendungen

- VPC Deep Dive and Best Practices (Cloud NEXT' 18 Video)

- Hybrid- und Multi-Cloud-Netzwerktopologien

- Ressourcenhierarchie für Ihre Google Cloud Landing-Zone festlegen

- Best Practices für die Auswahl der Region in Compute Engine

- Google Cloud für Rechenzentrumsexperten: Netzwerk

- Virtual Private Cloud-Dokumentation

- GKE-Netzwerkübersicht

- Referenzarchitekturen, Diagramme und Best Practices zu Google Cloud kennenlernen. Weitere Informationen zu Cloud Architecture Center