Datastream admite la transmisión de datos de bases de datos de Oracle, MySQL y PostgreSQL directamente a los conjuntos de datos de BigQuery. Sin embargo, si necesitas más control sobre la lógica de procesamiento de transmisiones, como la transformación de datos o la configuración manual de claves primarias lógicas, puedes integrar Datastream con las plantillas de trabajos de Dataflow.

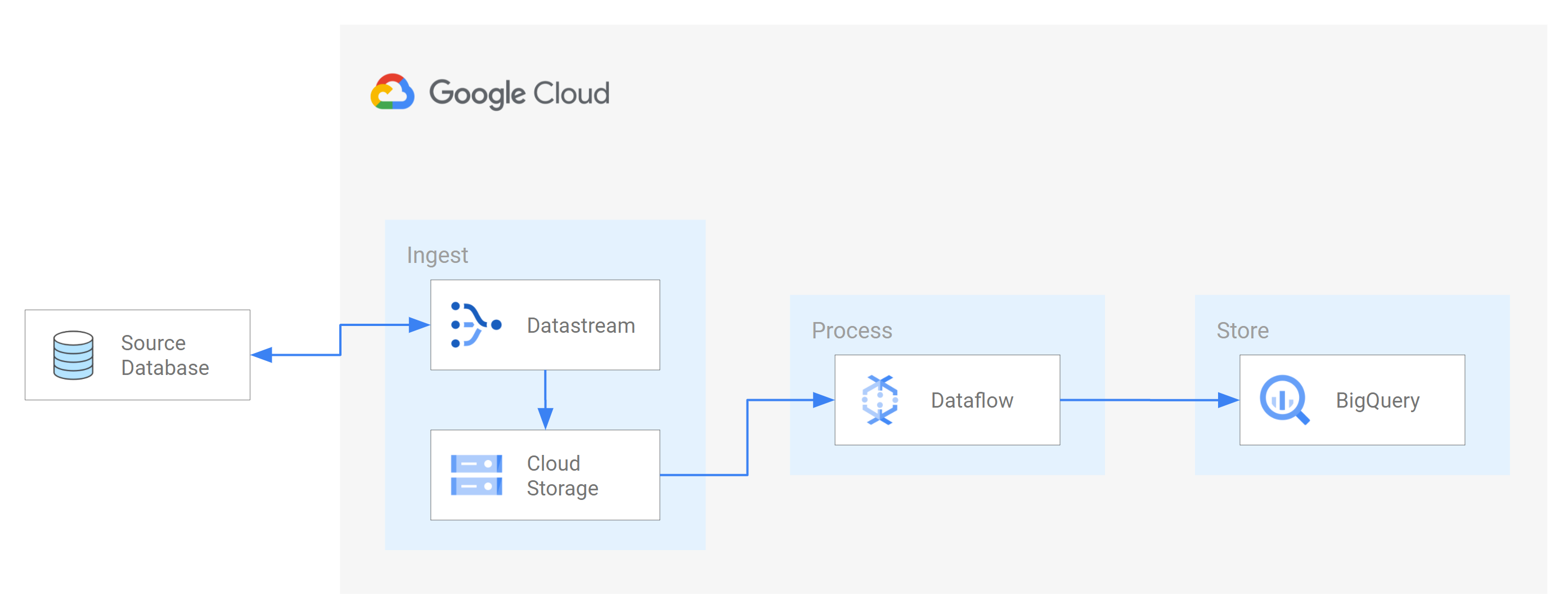

En este instructivo, se muestra cómo Datastream se integra con Dataflow a través de plantillas de trabajos de Dataflow para transmitir vistas materializadas actualizadas en BigQuery para estadísticas.

En las organizaciones con muchas fuentes de datos aisladas, el acceso a los datos empresariales en toda la organización, especialmente en tiempo real, puede ser limitado y lento. Esto restringe la capacidad de introspección de la organización.

Datastream proporciona acceso casi en tiempo real a los datos de cambio de varias fuentes de datos locales y basadas en la nube. Datastream proporciona una experiencia de configuración en la que no tienes que realizar mucha configuración para transmitir datos, ya que Datastream lo hace por ti. Datastream también tiene una API de consumo unificada que democratiza el acceso de tu organización a los datos empresariales disponibles más recientes para crear situaciones integradas.

Una de estas situaciones es la transferencia de datos desde una base de datos de origen a un servicio de almacenamiento o una cola de mensajes basados en la nube. Después de que Datastream transmite los datos, estos se transforman en un formato que pueden leer otras aplicaciones y servicios. En este instructivo, Dataflow es el servicio web que se comunica con el servicio de almacenamiento o la cola de mensajes para capturar y procesar datos en Google Cloud.

Aprenderás a usar Datastream para transmitir cambios (datos que se insertan, actualizan o borran) desde una base de datos de MySQL de origen a una carpeta en un bucket de Cloud Storage. Luego, configuras el bucket de Cloud Storage para que envíe notificaciones que Dataflow usa para conocer los archivos nuevos que contienen los cambios de datos que Datastream transmite desde la base de datos de origen. Luego, un trabajo de Dataflow procesa los archivos y transfiere los cambios a BigQuery.

Objetivos

En este instructivo, harás lo siguiente:- Crea un bucket en Cloud Storage. Este es el bucket de destino en el que Datastream transmite los esquemas, las tablas y los datos desde una base de datos de MySQL de origen.

- Habilita las notificaciones de Pub/Sub para el bucket de Cloud Storage. De esta manera, configuras el bucket para que envíe notificaciones que Dataflow usa para conocer los archivos nuevos que están listos para procesarse. Estos archivos contienen los cambios en los datos que Datastream transmite desde la base de datos de origen al bucket.

- Crear conjuntos de datos en BigQuery BigQuery usa conjuntos de datos para contener los datos que recibe de Dataflow. Estos datos representan los cambios en la base de datos de origen que Datastream transmite al bucket de Cloud Storage.

- Crear y administrar perfiles de conexión para una base de datos de origen y un bucket de destino en Cloud Storage Una transmisión en Datastream usa la información de los perfiles de conexión para transferir datos de la base de datos de origen al bucket.

- Crea e inicia una transmisión. Esta transmisión transfiere datos, esquemas y tablas desde la base de datos de origen al bucket.

- Verifica que Datastream transfiera los datos y las tablas asociados con un esquema de la base de datos de origen al bucket.

- Crea un trabajo en Dataflow. Después de que Datastream transmita los cambios de datos de la base de datos de origen al bucket de Cloud Storage, se enviarán notificaciones a Dataflow sobre los archivos nuevos que contienen los cambios. El trabajo de Dataflow procesa los archivos y transfiere los cambios a BigQuery.

- Verifica que Dataflow procese los archivos que contienen los cambios asociados con estos datos y transfiera los cambios a BigQuery. Como resultado, tendrás una integración de extremo a extremo entre Datastream y BigQuery.

- Limpia los recursos que creaste en Datastream, Cloud Storage, Pub/Sub, Dataflow y BigQuery para que no consuman tu cuota y no se te facture por ellos en el futuro.

Costos

En este documento, usarás los siguientes componentes facturables de Google Cloud:

- Datastream

- Cloud Storage

- Pub/Sub

- Dataflow

- BigQuery

Para generar una estimación de costos en función del uso previsto, usa la calculadora de precios.

Antes de comenzar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

- Habilita la API de Datastream.

- Asegúrate de tener el rol de administrador de Datastream otorgado a tu cuenta de usuario.

- Asegúrate de tener una base de datos de MySQL de origen a la que Datastream pueda acceder. Además, verifica que tengas datos, tablas y esquemas en la base de datos.

- Configura tu base de datos MySQL para permitir conexiones entrantes desde las direcciones IP públicas de Datastream. Para obtener una lista de todas las regiones de Datastream y sus direcciones IP públicas asociadas, consulta Listas de IP permitidas y regiones.

- Configura la captura de datos modificados (CDC) para la base de datos de origen. Para obtener más información, consulta Configura una base de datos MySQL de origen.

Asegúrate de cumplir con todos los requisitos previos para habilitar las notificaciones de Pub/Sub para Cloud Storage.

En este instructivo, crearás un bucket de destino en Cloud Storage y habilitarás las notificaciones de Pub/Sub para el bucket. De esta manera, Dataflow puede recibir notificaciones sobre los archivos nuevos que Datastream escribe en el bucket. Estos archivos contienen los cambios en los datos que Datastream transmite desde la base de datos de origen al bucket.

Requisitos

Datastream ofrece una variedad de opciones de origen, opciones de destino y métodos de conectividad de red.

En este instructivo, suponemos que usas una base de datos MySQL independiente y un servicio de Cloud Storage de destino. En el caso de la base de datos de origen, deberías poder configurar tu red para agregar una regla de firewall de entrada. La base de datos de origen puede ser local o estar en un proveedor de servicios en la nube. Para el destino de Cloud Storage, no se requiere ninguna configuración de conectividad.

Debido a que no podemos saber los detalles de tu entorno, no podemos proporcionar pasos detallados cuando se trata de tu configuración de red.

En este instructivo, seleccionarás lista de IP permitidas como el método de conectividad de red. El uso de listas de IP permitidas es una función de seguridad que se usa a menudo para controlar y limitar el acceso a los datos en tu base de datos de origen a usuarios de confianza. Puedes usar las listas de IP permitidas para crear listas de direcciones IP o rangos de IP de confianza desde los que tus usuarios y otros Google Cloud servicios, como Datastream, pueden acceder a estos datos. Para usar listas de IP permitidas, debes abrir la base de datos o firewall de origen para las conexiones entrantes desde Datastream.

Crea un bucket en Cloud Storage

Crea un bucket de destino en Cloud Storage en el que Datastream transmita los esquemas, las tablas y los datos desde una base de datos de MySQL de origen.

En la Google Cloud consola, ve a la página Navegador de Cloud Storage.

Haz clic en Crear bucket. Aparecerá la página Crear un bucket.

En el campo de texto de la región Nombre de tu bucket, ingresa un nombre único para tu bucket y, luego, haz clic en Continuar.

Acepta la configuración predeterminada para cada región restante de la página. Al final de cada región, haz clic en Continuar.

Haz clic en Crear.

Habilita las notificaciones de Pub/Sub para el bucket de Cloud Storage

En esta sección, habilitarás las notificaciones de Pub/Sub para el bucket de Cloud Storage que creaste. De esta manera, configuras el bucket para que notifique a Dataflow sobre cualquier archivo nuevo que Datastream escriba en el bucket. Estos archivos contienen los cambios en los datos que Datastream transmite desde una base de datos de MySQL de origen al bucket.

Accede al bucket de Cloud Storage que creaste. Aparecerá la página Detalles del bucket.

Haz clic en Activar Cloud Shell.

En el símbolo del sistema, ingresa el siguiente comando:

gcloud storage buckets notifications create gs://bucket-name --topic=my_integration_notifs --payload-format=json --object-prefix=integration/tutorial/Opcional: Si aparece una ventana Autorizar Cloud Shell, haz clic en Autorizar.

Verifica que veas las siguientes líneas de código:

Created Cloud Pub/Sub topic projects/project-name/topics/my_integration_notifs Created notification config projects/_/buckets/bucket-name/notificationConfigs/1

En la consola de Google Cloud , ve a la página Temas de Pub/Sub.

Haz clic en el tema my_integration_notifs que creaste.

En la página my_integration_notifs, ve a la parte inferior. Verifica que la pestaña Suscripciones esté activa y que aparezca el mensaje No hay suscripciones para mostrar.

Haz clic en Crear suscripción.

En el menú que aparece, selecciona Crear suscripción.

En la página Agregar suscripción al tema, haz lo siguiente:

- En el campo ID de suscripción, ingresa

my_integration_notifs_sub. - Establece el valor de Plazo de confirmación en

120segundos. Esto le permite a Dataflow tener tiempo suficiente para confirmar los archivos que procesó y ayuda a mejorar el rendimiento general del trabajo de Dataflow. Para obtener más información sobre las propiedades de suscripción de Pub/Sub, consulta Propiedades de suscripción. - Deja todos los demás valores predeterminados en la página.

- Haz clic en Crear.

- En el campo ID de suscripción, ingresa

Más adelante en este instructivo, crearás un trabajo de Dataflow. Como parte de la creación de este trabajo, asignas Dataflow como suscriptor de la suscripción my_integration_notifs_sub. De esta manera, Dataflow puede recibir notificaciones sobre los archivos nuevos que Datastream escribe en Cloud Storage, procesar los archivos y transferir los cambios de datos a BigQuery.

Crea conjuntos de datos en BigQuery

En esta sección, crearás conjuntos de datos en BigQuery. BigQuery usa conjuntos de datos para contener los datos que recibe de Dataflow. Estos datos representan los cambios en la base de datos de MySQL de origen que Datastream transmite a tu bucket de Cloud Storage.

Ve a la página Espacio de trabajo de SQL de BigQuery en la consola de Google Cloud .

En el panel Explorador, junto al Google Cloud nombre de tu proyecto, haz clic en Ver acciones.

En el menú que aparece, selecciona Crear conjunto de datos.

En la ventana Crear conjunto de datos, haz lo siguiente:

- En el campo ID del conjunto de datos, ingresa un ID para el conjunto de datos. Para este instructivo, ingresa

My_integration_dataset_logen el campo. - Deja todos los demás valores predeterminados en la ventana.

- Haz clic en Crear conjunto de datos.

- En el campo ID del conjunto de datos, ingresa un ID para el conjunto de datos. Para este instructivo, ingresa

En el panel Explorador, junto al nombre de tu proyecto Google Cloud , haz clic en Expand node y, luego, verifica que veas el conjunto de datos que creaste.

Usa los pasos en este procedimiento para crear un segundo conjunto de datos: My_integration_dataset_final.

Junto a cada conjunto de datos, expande Expandir nodo.

Verifica que cada conjunto de datos esté vacío.

Después de que Datastream transmita los cambios de datos de la base de datos de origen a tu bucket de Cloud Storage, un trabajo de Dataflow procesará los archivos que contienen los cambios y transferirá los cambios a los conjuntos de datos de BigQuery.

Crea perfiles de conexión en Datastream

En esta sección, crearás perfiles de conexión en Datastream para una base de datos de origen y un destino. Como parte de la creación de los perfiles de conexión, selecciona MySQL como el tipo de perfil para tu perfil de conexión de origen y Cloud Storage como el tipo de perfil para tu perfil de conexión de destino.

Datastream usa la información definida en los perfiles de conexión para conectarse tanto al origen como al destino, de modo que pueda transmitir datos desde la base de datos de origen a tu bucket de destino en Cloud Storage.

Crea un perfil de conexión de origen para tu base de datos de MySQL

En la consola de Google Cloud , ve a la página Perfiles de conexión de Datastream.

Haga clic en Crear perfil.

Para crear un perfil de conexión de origen para tu base de datos de MySQL, en la página Crear un perfil de conexión, haz clic en el tipo de perfil MySQL.

En la sección Define connection settings de la página Create MySQL profile, proporciona la siguiente información:

- En el campo Nombre del perfil de conexión, ingresa

My Source Connection Profile. - Conserva el ID del perfil de conexión generado automáticamente.

Selecciona la región en la que deseas almacenar el perfil de conexión.

Ingresa los Detalles de conexión:

- En el campo Nombre de host o IP, ingresa un nombre de host o una dirección IP pública que Datastream pueda usar para conectarse a la base de datos de origen. Proporcionas una dirección IP pública porque usas la lista de IP permitidas como el método de conectividad de red para este instructivo.

- En el campo Puerto, ingresa el número de puerto reservado para la base de datos de origen. En el caso de una base de datos de MySQL, el puerto predeterminado suele ser

3306. - Ingresa un nombre de usuario y una contraseña para autenticarte en tu base de datos de origen.

- En el campo Nombre del perfil de conexión, ingresa

En la sección Define connection settings, haz clic en Continue. La sección Protege la conexión a la fuente de la página Crear perfil de MySQL está activa.

En el menú Tipo de encriptación, selecciona Ninguno. Para obtener más información sobre este menú, consulta Crea un perfil de conexión para la base de datos de MySQL.

En la sección Protege tu conexión a la fuente, haz clic en Continuar. La sección Define el método de conectividad de la página Crear perfil de MySQL está activa.

En el menú desplegable Método de conectividad, elige el método de red que deseas usar para establecer la conectividad entre Datastream y la base de datos de origen. En este instructivo, selecciona Lista de IP permitidas como el método de conectividad.

Configura tu base de datos de origen para permitir conexiones entrantes desde las direcciones IP públicas de Datastream que aparecen.

En la sección Define connectivity method, haz clic en Continue. La sección Probar perfil de conexión de la página Crear perfil de MySQL está activa.

Haz clic en Ejecutar prueba para verificar que la base de datos de origen y Datastream puedan comunicarse entre sí.

Verifica que veas el estado Prueba correcta.

Haz clic en Crear.

Crea un perfil de conexión de destino para Cloud Storage

En la consola de Google Cloud , ve a la página Perfiles de conexión de Datastream.

Haga clic en Crear perfil.

Para crear un perfil de conexión de destino para Cloud Storage, en la página Crear un perfil de conexión, haz clic en el tipo de perfil Cloud Storage.

En la página Crear perfil de Cloud Storage, proporciona la siguiente información:

- En el campo Nombre del perfil de conexión, ingresa

My Destination Connection Profile. - Conserva el ID del perfil de conexión generado automáticamente.

- Selecciona la región en la que deseas almacenar el perfil de conexión.

En el panel Detalles de la conexión, haz clic en Explorar para seleccionar el bucket de Cloud Storage que creaste antes en este instructivo. Este es el bucket al que Datastream transfiere los datos de la base de datos de origen. Después de realizar la selección, haz clic en Seleccionar.

Tu bucket aparece en el campo Nombre del bucket del panel Detalles de la conexión.

En el campo Prefijo de la ruta del perfil de conexión, proporciona un prefijo para la ruta que deseas agregar al nombre del bucket cuando Datastream transmita datos al destino. Asegúrate de que Datastream escriba datos en una ruta de acceso dentro del bucket, no en la carpeta raíz del bucket. Para este instructivo, usa la ruta de acceso que definiste cuando configuraste tu notificación de Pub/Sub. Ingresa

/integration/tutorialen el campo.

- En el campo Nombre del perfil de conexión, ingresa

Haz clic en Crear.

Después de crear un perfil de conexión de origen para tu base de datos de MySQL y un perfil de conexión de destino para Cloud Storage, puedes usarlos para crear una transmisión.

Crea un flujo en Datastream

En esta sección, crearás una transmisión. Esta transmisión usa la información de los perfiles de conexión para transferir datos de una base de datos de MySQL de origen a un bucket de destino en Cloud Storage.

Define la configuración de la transmisión

En la consola de Google Cloud , ve a la página Flujos de Datastream.

Haz clic en Crear flujo.

Proporciona la siguiente información en el panel Define stream details de la página Create stream:

- En el campo Nombre del flujo, ingresa

My Stream. - Conserva el ID de transmisión generado automáticamente.

- En el menú Región, selecciona la región en la que creaste los perfiles de conexión de origen y destino.

- En el menú Tipo de origen, selecciona el tipo de perfil MySQL.

- En el menú Tipo de destino, selecciona el tipo de perfil Cloud Storage.

- En el campo Nombre del flujo, ingresa

Revisa los requisitos previos necesarios que se generan automáticamente para reflejar cómo se debe preparar tu entorno para una transmisión. Estos requisitos previos pueden incluir cómo configurar la base de datos de origen y cómo conectar Datastream al bucket de destino en Cloud Storage.

Haz clic en Continuar. Aparecerá el panel Definir perfil de conexión de MySQL de la página Crear transmisión.

Especifica la información sobre el perfil de conexión de origen

En esta sección, selecciona el perfil de conexión que creaste para tu base de datos de origen (el perfil de conexión de origen). Para este instructivo, es Mi perfil de conexión de origen.

En el menú Perfil de conexión de origen, selecciona tu perfil de conexión de origen para la base de datos de MySQL.

Haz clic en Ejecutar prueba para verificar que la base de datos de origen y Datastream puedan comunicarse entre sí.

Si la prueba falla, aparecerá el problema asociado con el perfil de conexión. Consulta la página Diagnostica problemas para conocer los pasos de solución de problemas. Realiza los cambios necesarios para corregir el problema y, luego, vuelve a probar.

Haz clic en Continuar. Aparecerá el panel Configurar origen de transmisión de la página Crear transmisión.

Configura la información sobre la base de datos de origen de la transmisión

En esta sección, configurarás la información sobre la base de datos de origen de la transmisión especificando las tablas y los esquemas de la base de datos de origen que Datastream:

- Puede transferir al destino.

- No puede transferir al destino.

También determinas si Datastream reabastece los datos históricos, así como la transmisión de los cambios continuos al destino o la transmisión solo de los cambios a los datos.

Usa el menú Objetos que se incluyen para especificar las tablas y esquemas en tu base de datos de origen que Datastream puede transferir a una carpeta en el bucket de destino en Cloud Storage. El menú solo se carga si tu base de datos tiene hasta 5,000 objetos.

En este instructivo, quieres que Datastream transfiera todas las tablas y los esquemas. Por lo tanto, selecciona Todas las tablas de todos los esquemas en el menú.

Verifica que el panel Seleccionar objetos que se excluyen esté configurado como Ninguno. No quieres restringir que Datastream transfiera tablas y esquemas de la base de datos de origen a Cloud Storage.

Verifica que el panel Elige el modo de reabastecimiento para los datos históricos esté configurado como Automático. Datastream transmite todos los datos existentes, además de los cambios en los datos, del origen al destino.

Haz clic en Continuar. Aparecerá el panel Definir perfil de conexión de Cloud Storage de la página Crear transmisión.

Selecciona un perfil de conexión de destino

En esta sección, seleccionarás el perfil de conexión que creaste para Cloud Storage (el perfil de conexión de destino). Para este instructivo, es My Destination Connection Profile.

En el menú Perfil de conexión de destino, selecciona tu perfil de conexión de destino para Cloud Storage.

Haz clic en Continuar. Aparecerá el panel Configurar destino del flujo de la página Crear flujo.

Configura la información sobre el destino de la transmisión

En esta sección, configurarás la información sobre el bucket de destino de la transmisión. Esta información incluye lo siguiente:

- Es el formato de salida de los archivos escritos en Cloud Storage.

- Es la carpeta del bucket de destino en la que Datastream transfiere esquemas, tablas y datos de la base de datos de origen.

En el campo Formato de salida, selecciona el formato de los archivos escritos en Cloud Storage. Datastream admite dos formatos de salida: Avro y JSON. Para este instructivo, Avro es el formato de archivo.

Haz clic en Continuar. Aparecerá el panel Revisa los detalles de la transmisión y créala de la página Crear transmisión.

Crea la transmisión

Verifica los detalles sobre la transmisión y los perfiles de conexión de origen y de destino que usa la transmisión para transferir datos de una base de datos de MySQL de origen a un bucket de destino en Cloud Storage.

Para validar la transmisión, haz clic en Ejecutar validación. Cuando se valida una transmisión, Datastream verifica que la fuente esté configurada correctamente, valida que la transmisión pueda conectarse tanto a la fuente como al destino y verifica la configuración de extremo a extremo de la transmisión.

Después de pasar todas las verificaciones de validación, haz clic en Crear.

En el cuadro de diálogo ¿Crear flujo?, haz clic en Crear.

Inicia la transmisión

En este instructivo, crearás e iniciarás una transmisión por separado en caso de que el proceso de creación de la transmisión genere una mayor carga en tu base de datos de origen. Para posponer esa carga, crea la transmisión sin iniciarla y, luego, iníciala cuando tu base de datos pueda controlarla.

Al iniciar la transmisión, Datastream puede transferir datos, esquemas y tablas desde la base de datos de origen al destino.

En la consola de Google Cloud , ve a la página Flujos de Datastream.

Selecciona la casilla de verificación junto a la transmisión que deseas iniciar. En este instructivo, es Mi transmisión.

Haz clic en Iniciar.

En el cuadro de diálogo, haz clic en Iniciar. El estado de la transmisión cambia de

Not startedaStartingy, luego, aRunning.

Después de iniciar una transmisión, puedes verificar que Datastream haya transferido datos de la base de datos de origen al destino.

Verifica la transmisión

En esta sección, confirmarás que Datastream transfiera los datos de todas las tablas de una base de datos de MySQL de origen a la carpeta /integration/tutorial de tu bucket de Cloud Storage de destino.

En la consola de Google Cloud , ve a la página Flujos de Datastream.

Haz clic en la transmisión que creaste. En este instructivo, es Mi transmisión.

En la página Detalles de la transmisión, haz clic en el vínculo bucket-name/integration/tutorial, donde bucket-name es el nombre que le asignaste a tu bucket de Cloud Storage. Este vínculo aparece después del campo Ruta de escritura de destino. La página Detalles del bucket de Cloud Storage se abre en una pestaña separada.

Verifica que veas carpetas que representen tablas de la base de datos de origen.

Haz clic en una de las carpetas de la tabla y, luego, en cada subcarpeta hasta que veas los datos asociados con la tabla.

Crea un trabajo de Dataflow

En esta sección, crearás un trabajo en Dataflow. Después de que Datastream transmita los cambios de datos de una base de datos de MySQL de origen a tu bucket de Cloud Storage, Pub/Sub enviará notificaciones a Dataflow sobre los archivos nuevos que contienen los cambios. El trabajo de Dataflow procesa los archivos y transfiere los cambios a BigQuery.

En la consola de Google Cloud , ve a la página Trabajos de Dataflow.

Haz clic en Crear trabajo a partir de una plantilla.

En el campo Nombre del trabajo de la página Crear un trabajo a partir de una plantilla, ingresa un nombre para el trabajo de Dataflow que estás creando. Para este instructivo, ingresa

my-dataflow-integration-joben el campo.En el menú Extremo regional, selecciona la región en la que deseas almacenar el trabajo. Esta es la misma región que seleccionaste para el perfil de conexión de origen, el perfil de conexión de destino y la transmisión que creaste.

En el menú Plantilla de Dataflow, selecciona la plantilla que usas para crear el trabajo. Para este instructivo, selecciona Datastream to BigQuery.

Después de realizar esta selección, aparecerán campos adicionales relacionados con esta plantilla.

En el campo Ubicación del archivo para la salida del archivo de Datastream en Cloud Storage, ingresa el nombre de tu bucket de Cloud Storage con el siguiente formato:

gs://bucket-name.En el campo Suscripción a Pub/Sub que se usa en una política de notificaciones de Cloud Storage, ingresa la ruta de acceso que contiene el nombre de tu suscripción a Pub/Sub. En este instructivo, ingresa

projects/project-name/subscriptions/my_integration_notifs_sub.En el campo Formato de archivo de salida de Datastream (avro/json)., ingresa

avroporque, para este instructivo, Avro es el formato de los archivo que Datastream escribe en Cloud Storage.En el campo Nombre o plantilla para el conjunto de datos que contiene las tablas de etapa de pruebas., ingresa

My_integration_dataset_log, ya que Dataflow usa este conjunto de datos para almacenar en etapa intermedia los cambios de datos que recibe de Datastream.En el campo Plantilla para que el conjunto de datos contenga tablas de réplica., ingresa

My_integration_dataset_finalporque este es el conjunto de datos en el que se combinan los cambios que se almacenan en etapa intermedia en el conjunto de datos My_integration_dataset_log para crear una réplica uno a uno de las tablas de la base de datos de origen.En el campo Directorio de la cola de mensajes no entregados, ingresa la ruta de acceso que contiene el nombre de tu bucket de Cloud Storage y una carpeta para una cola de mensajes no entregados. Asegúrate de no usar una ruta de acceso en la carpeta raíz y de que la ruta de acceso sea diferente de la ruta en la que Datastream escribe datos. Los cambios de datos que Dataflow no puede transferir a BigQuery se almacenan en la cola. Puedes corregir el contenido de la cola para que Dataflow pueda volver a procesarlo.

En este instructivo, ingresa

gs://bucket-name/dlqen el campo Directorio de cola de mensajes no entregados (donde bucket-name es el nombre de tu bucket y dlq es la carpeta de la cola de mensajes no entregados).Haga clic en Ejecutar trabajo.

Verifica la integración

En la sección Verifica la transmisión de este instructivo, confirmaste que Datastream transfirió los datos de todas las tablas de una base de datos de MySQL de origen a la carpeta /integration/tutorial de tu bucket de Cloud Storage de destino.

En esta sección, verificarás que Dataflow procese los archivos que contienen los cambios asociados con estos datos y que transfiera los cambios a BigQuery. Como resultado, tendrás una integración de extremo a extremo entre Datastream y BigQuery.

En la consola de Google Cloud , ve a la página Espacio de trabajo de SQL de BigQuery.

En el panel Explorador, expande el nodo junto al nombre de tu proyecto Google Cloud .

Expande los nodos junto a los conjuntos de datos My_integration_dataset_log y My_integration_dataset_final.

Verifica que cada conjunto de datos ahora contenga datos. Esto confirma que Dataflow procesó los archivos que contienen los cambios asociados con los datos que Datastream transmitió a Cloud Storage y transfirió estos cambios a BigQuery.

Limpia

Para evitar que se apliquen cargos a tu cuenta de Google Cloud por los recursos que usaste en este instructivo, usa la consola de Google Cloud para hacer lo siguiente:

- Borra tu proyecto, la transmisión de Datastream y los perfiles de conexión de Datastream.

- Detén el trabajo de Dataflow.

- Borra los conjuntos de datos de BigQuery, el tema y la suscripción de Pub/Sub, y el bucket de Cloud Storage.

Si limpias los recursos que creaste en Datastream, Dataflow, BigQuery, Pub/Sub y Cloud Storage, evitarás que consuman la cuota y no se te cobrará por ellos en el futuro.

Borra tu proyecto

La manera más fácil de eliminar la facturación es borrar el proyecto que creaste para este instructivo.

En la Google Cloud consola, ve a la página Administrar recursos.

En la lista de proyectos, elige el proyecto que deseas borrar y haz clic en Borrar.

Para borrar el proyecto, en el diálogo, escribe el ID del proyecto y, luego, haz clic en Cerrar.

Borra la transmisión

En la consola de Google Cloud , ve a la página Flujos de Datastream.

Haz clic en la transmisión que quieras borrar. En este instructivo, es Mi transmisión.

Haz clic en Pausar.

En el cuadro de diálogo, haz clic en Pausar.

En el panel Estado de la transmisión de la página Detalles de la transmisión, verifica que el estado de la transmisión sea

Paused.Haz clic en Borrar.

En el cuadro de diálogo, ingresa

Deleteen el campo de texto y, luego, haz clic en Borrar.

Borra los perfiles de conexión

En la consola de Google Cloud , ve a la página Perfiles de conexión de Datastream.

Selecciona la casilla de verificación de cada perfil de conexión que desees borrar: Mi perfil de conexión de origen y Mi perfil de conexión de destino.

Haz clic en Borrar.

En el cuadro de diálogo, haz clic en Borrar.

Detenga el trabajo de Dataflow

En la consola de Google Cloud , ve a la página Trabajos de Dataflow.

Haz clic en el trabajo que deseas detener. En este instructivo, es my-dataflow-integration-job.

Haz clic en Detener.

En el cuadro de diálogo Detener trabajo, selecciona la opción Vaciar y, luego, haz clic en Detener trabajo.

Borra los conjuntos de datos de BigQuery

En la consola de Google Cloud , ve a la página Espacio de trabajo de SQL de BigQuery.

En el panel Explorador, expande el nodo junto al nombre de tu proyecto Google Cloud .

Haz clic en el botón Ver acciones a la derecha de uno de los conjuntos de datos que creaste en Crea conjuntos de datos en BigQuery. Este botón tiene forma de elipsis vertical.

Para este instructivo, haz clic en el botón Ver acciones a la derecha de My_integration_dataset_log.

Selecciona Borrar en el menú desplegable que aparece.

En el cuadro de diálogo ¿Borrar el conjunto de datos?, ingresa

deleteen el campo de texto y, luego, haz clic en Borrar.Repite los pasos de este procedimiento para borrar el segundo conjunto de datos que creaste: My_integration_dataset_final.

Borra la suscripción y el tema de Pub/Sub

En la consola de Google Cloud , ve a la página Suscripciones de Pub/Sub.

Haz clic en la casilla de verificación junto a la suscripción que deseas borrar. En este instructivo, haz clic en la casilla de verificación junto a la suscripción my_integration_notifs_sub.

Haz clic en Borrar.

En el cuadro de diálogo Borrar suscripción, haz clic en Borrar.

En la consola de Google Cloud , ve a la página Temas de Pub/Sub.

Haz clic en la casilla de verificación junto al tema my_integration_notifs.

Haz clic en Borrar.

En el cuadro de diálogo Borrar tema, ingresa

deleteen el campo de texto y, luego, haz clic en Borrar.

Borra el bucket de Cloud Storage

En la Google Cloud consola, ve a la página Navegador de Cloud Storage.

Selecciona la casilla de verificación junto a tu bucket.

Haz clic en Borrar.

En el cuadro de diálogo, ingresa

Deleteen el campo de texto y, luego, haz clic en Borrar.

¿Qué sigue?

- Obtén más información sobre Datastream.

- Usa la API de transmisión heredada para realizar capacidades avanzadas con la transmisión de datos a BigQuery.

- Prueba otras Google Cloud funciones. Revisa nuestros instructivos.