Passaggio 3: determina il meccanismo di integrazione

Questa pagina descrive il terzo passaggio per il deployment di Cortex Framework Data Foundation, il componente principale di Cortex Framework. In questo passaggio, configuri l'integrazione con l'origine dati scelta. Se utilizzi dati di esempio, salta questo passaggio.

Panoramica sull'integrazione

Cortex Framework ti aiuta a centralizzare i dati provenienti da varie fonti, insieme ad altre piattaforme. In questo modo, viene creata un'unica fonte attendibile per i tuoi dati. Cortex Data Foundation si integra con ogni origine dati in modi diversi, ma la maggior parte segue una procedura simile:

- Livello Source to Raw:importa i dati dall'origine dati al set di dati non elaborato utilizzando le API. Ciò si ottiene utilizzando pipeline Dataflow attivate tramite i DAG di Cloud Composer.

- Livello non elaborato al livello CDC: applica l'elaborazione CDC al set di dati non elaborato e memorizza l'output nel set di dati CDC. Ciò si ottiene tramite i DAG di Cloud Composer che eseguono SQL BigQuery.

- Livello CDC al livello Reporting:crea le tabelle di report finali dalle tabelle CDC nel set di dati Reporting. Ciò si ottiene creando viste di runtime sopra le tabelle CDC o eseguendo DAG Cloud Composer per i dati materializzati nelle tabelle BigQuery, a seconda della configurazione. Per ulteriori informazioni sulla configurazione, vedi Personalizzazione del file delle impostazioni dei report.

Il file config.json configura le impostazioni necessarie per connettersi alle origini dati per il trasferimento dei dati da vari workload. Consulta le opzioni di integrazione

per ogni origine dati nelle seguenti risorse.

- Operativo:

- Marketing:

- Sostenibilità:

Per ulteriori informazioni sui diagrammi entità-relazione supportati da ciascuna origine dati, consulta la cartella docs nel repository di Cortex Framework Data Foundation.

Deployment di K9

K9 Deployer semplifica l'integrazione di diverse origini dati. Il deployer K9 è un set di dati predefinito all'interno dell'ambiente BigQuery responsabile dell'importazione, dell'elaborazione e della modellazione di componenti riutilizzabili in diverse origini dati.

Ad esempio, la dimensione time è riutilizzabile in tutte le origini dati in cui le tabelle

potrebbero dover prendere risultati analitici basati su un calendario gregoriano. Il deployer K9

combina dati esterni come meteo o Google Trends con altre origini dati

(ad esempio SAP, Salesforce, Marketing). Questo set di dati arricchito consente

approfondimenti più dettagliati e un'analisi più completa.

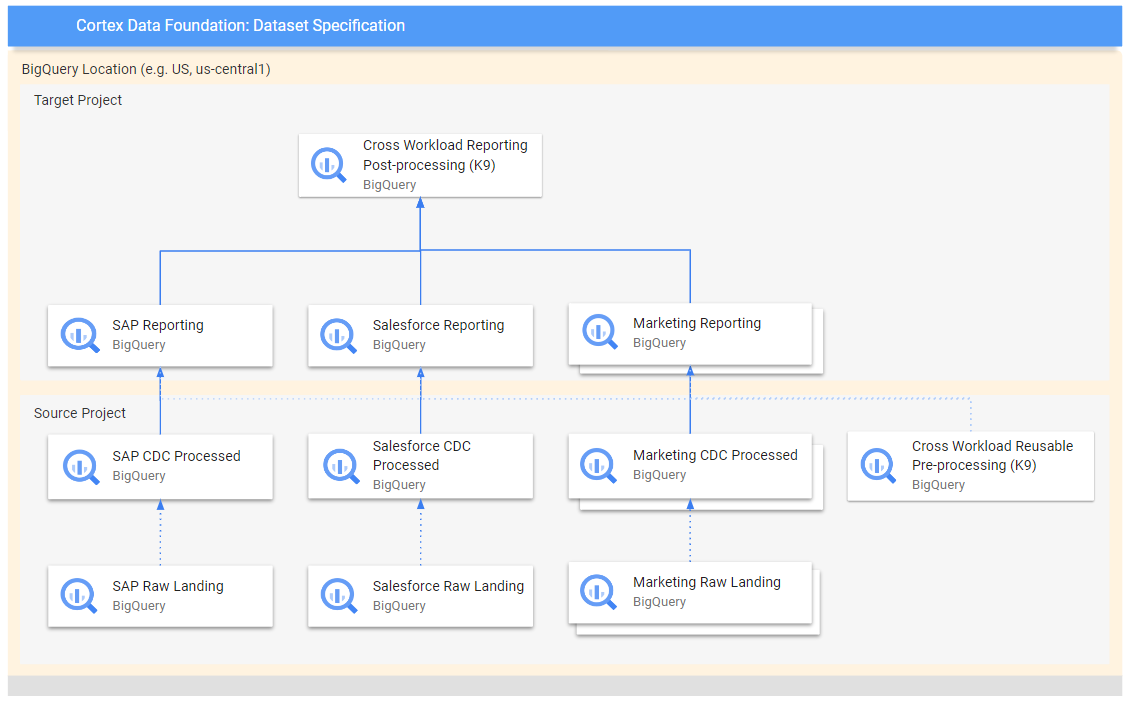

Il seguente diagramma mostra il flusso di dati da diverse origini non elaborate a vari livelli di report:

Nel diagramma, il progetto di origine contiene i dati non elaborati delle origini dati scelte (SAP, Salesforce e Marketing). Il progetto di destinazione contiene dati elaborati, derivati dal processo Change Data Capture (CDC).

Il passaggio K9 di pre-elaborazione viene eseguito prima dell'inizio del deployment di tutti i carichi di lavoro, quindi i modelli riutilizzabili sono disponibili durante il deployment. Questo passaggio trasforma i dati provenienti da varie origini per creare un insieme di dati coerente e riutilizzabile.

I passaggi di post-elaborazione K9 vengono eseguiti dopo che tutti i carichi di lavoro hanno implementato i propri modelli di reporting per consentire il reporting tra carichi di lavoro o l'aumento dei modelli per trovare le dipendenze necessarie all'interno di ogni singolo set di dati di reporting.

Configura il deployment di K9

Configura i grafi aciclici orientati (DAG) e i modelli da generare nel file manifest K9.

Il passaggio di pre-elaborazione K9 è importante perché garantisce che tutti i carichi di lavoro all'interno della pipeline di dati abbiano accesso a dati preparati in modo coerente. In questo modo ridurrai la ridondanza e garantirai la coerenza dei dati.

Per saperne di più su come configurare i set di dati esterni per K9, consulta Configurare i set di dati esterni per K9.

Passaggi successivi

Dopo aver completato questo passaggio, procedi con i seguenti passaggi di deployment:

- Stabilire i carichi di lavoro.

- Clona il repository.

- Determina il meccanismo di integrazione (questa pagina).

- Configurare i componenti.

- Configurare il deployment.

- Esegui il deployment.