Passaggio 6: esegui il deployment

Questa pagina descrive il sesto passaggio per il deployment di Cortex Framework Data Foundation, il componente principale di Cortex Framework. In questo passaggio, esegui il deployment di Cortex Framework Data Foundation.

Procedura di compilazione

Dopo aver configurato il file config.json

come descritto nel passaggio 5: configura la distribuzione,

segui queste istruzioni per creare il processo.

Esegui questo comando per posizionarti nel repository clonato:

cd cortex-data-foundationEsegui il comando di build con il bucket dei log di destinazione:

gcloud builds submit \ --substitutions=_GCS_BUCKET=LOGS_BUCKET_NAME,_BUILD_ACCOUNT='projects/SOURCE_PROJECT/serviceAccounts/CLOUD_BUILD_SA@SOURCE_PROJECT.iam.gserviceaccount.com'Sostituisci quanto segue:

LOGS_BUCKET_NAMEcon il nome del bucket per l'archiviazione dei log. Il service account Cloud Build deve avere l'accesso per scriverli qui.SOURCE_PROJECTcon il progetto di origine.CLOUD_BUILD_SAcon l'ID account di servizio Cloud Build creato nel passaggio 4 del deployment.

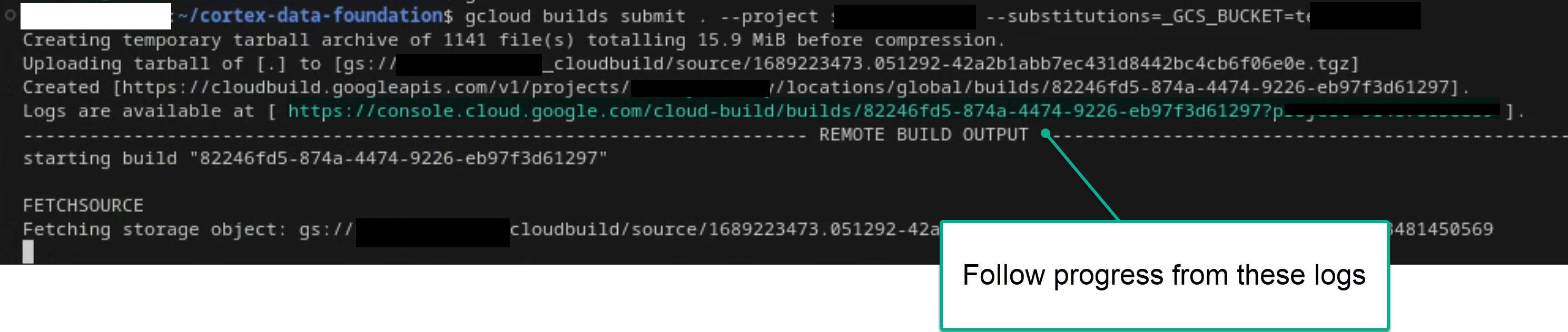

Segui il processo di compilazione principale esaminando i log nel terminale o nella console Cloud Build, se disponi delle autorizzazioni sufficienti. Per ulteriori riferimenti, consulta le immagini seguenti.

Figura 1. Esempio di visualizzazione dell'avanzamento dei log nel terminale.

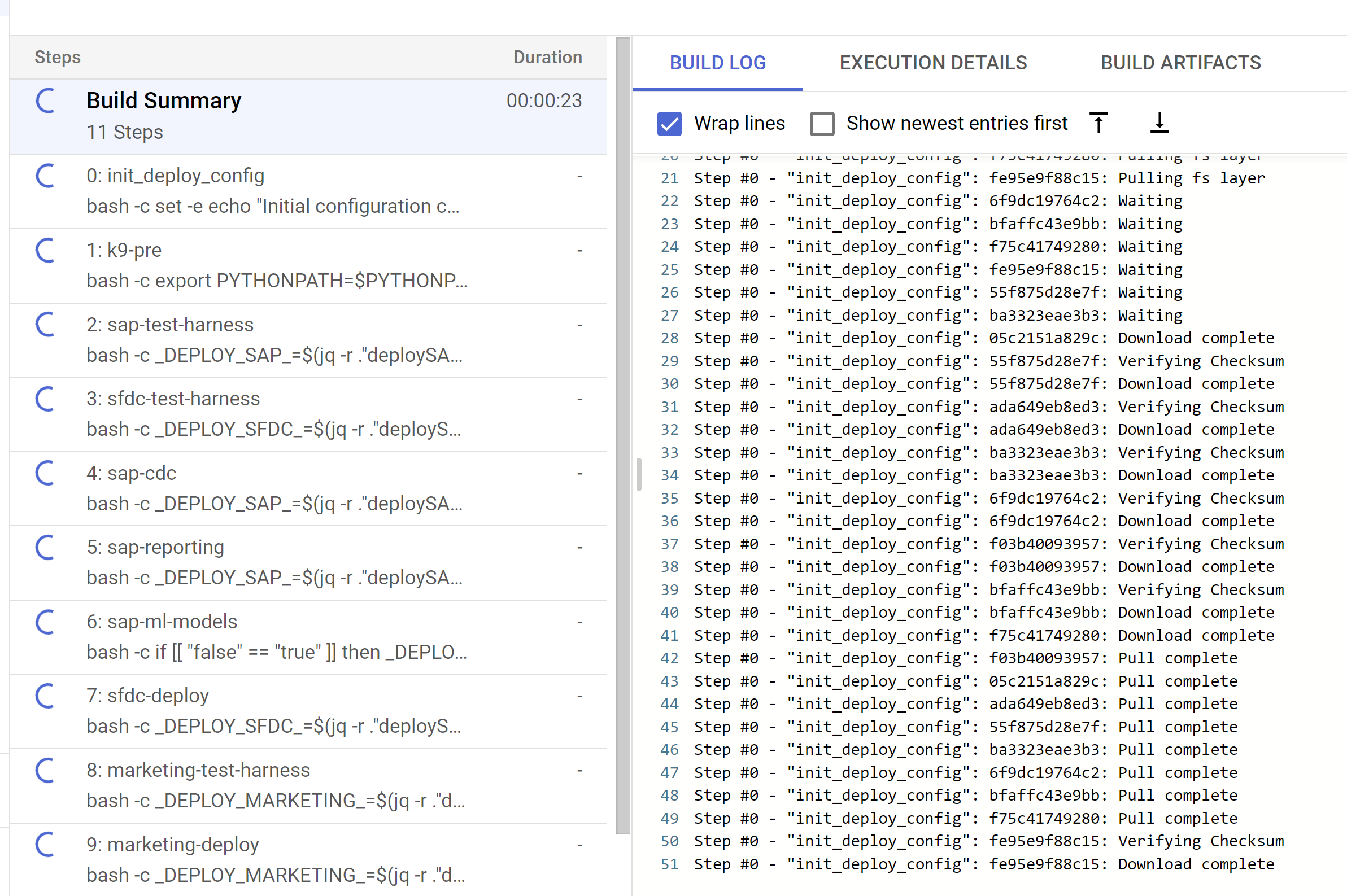

Figura 2. Esempio di visualizzazione dell'avanzamento dei log nella console. Tieni traccia dei passaggi di creazione secondari attivati dalla console Cloud Build o all'interno dei log creati dai passaggi. Per ulteriori riferimenti, vedi le immagini che seguono.

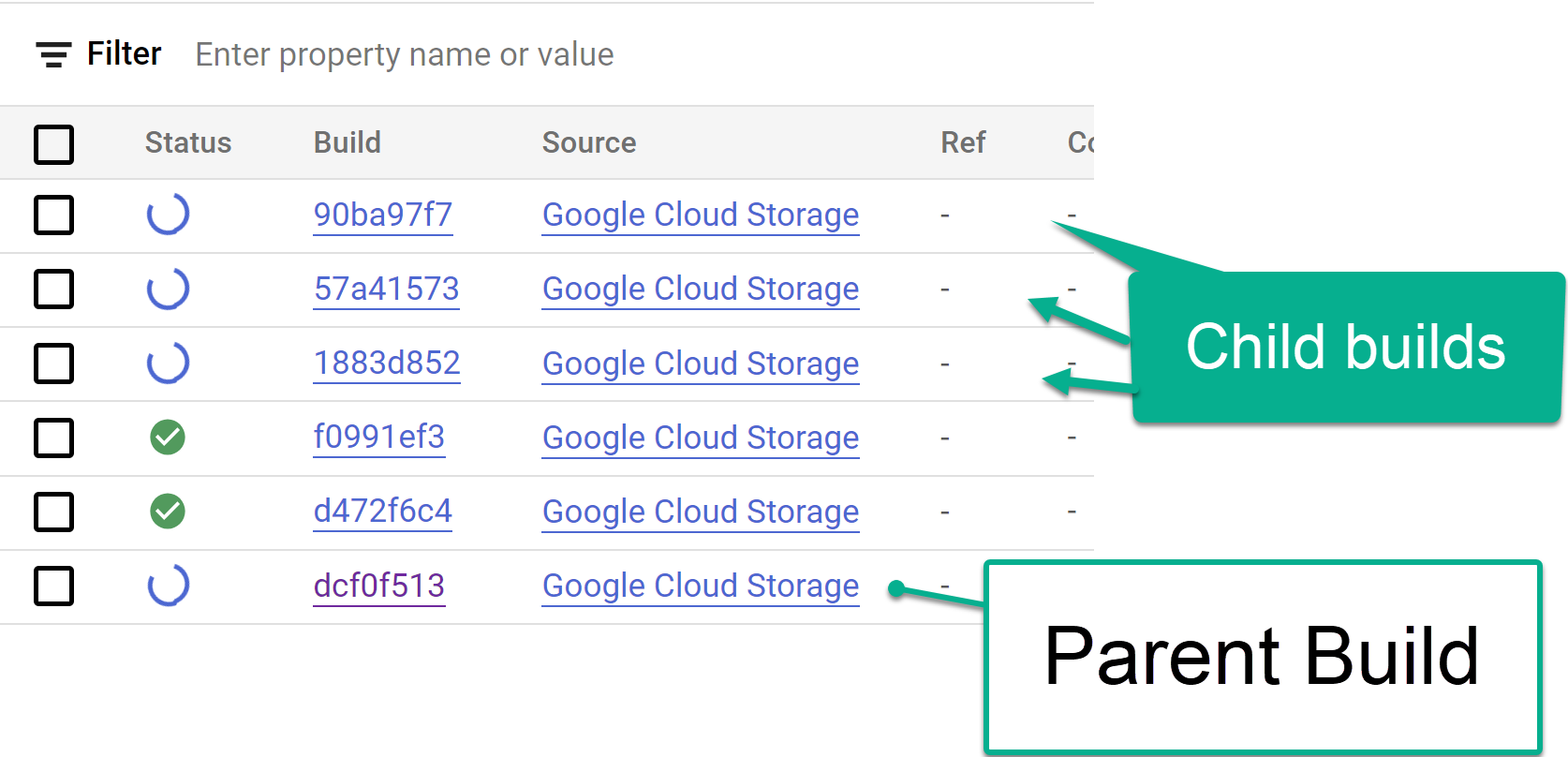

Figura 3. Esempio di monitoraggio dei passaggi di compilazione secondari nella console.

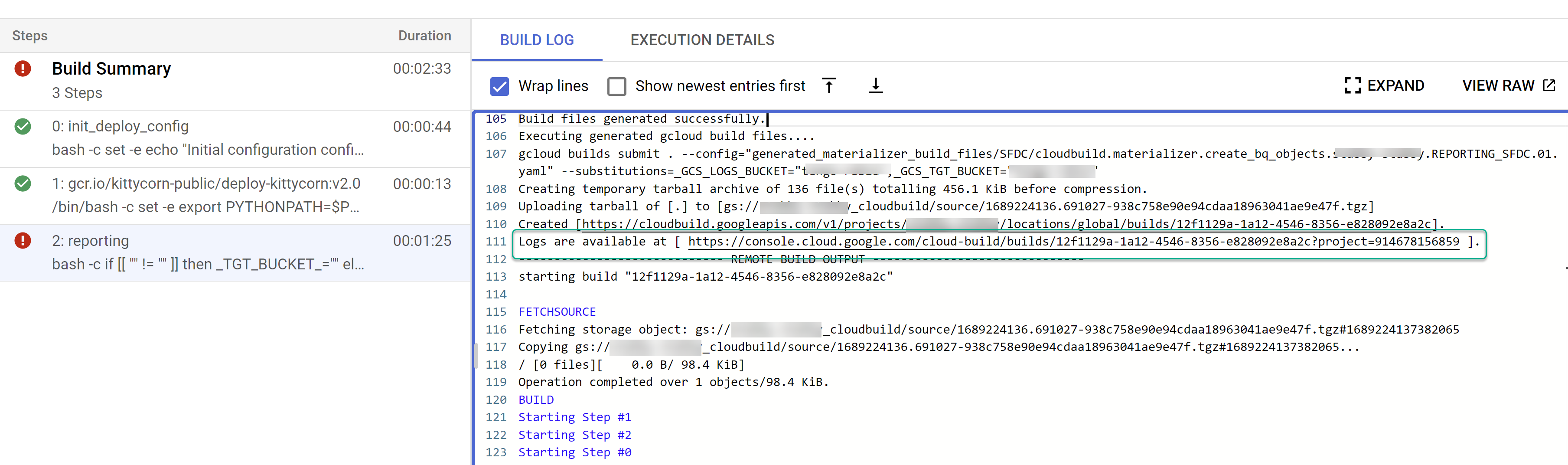

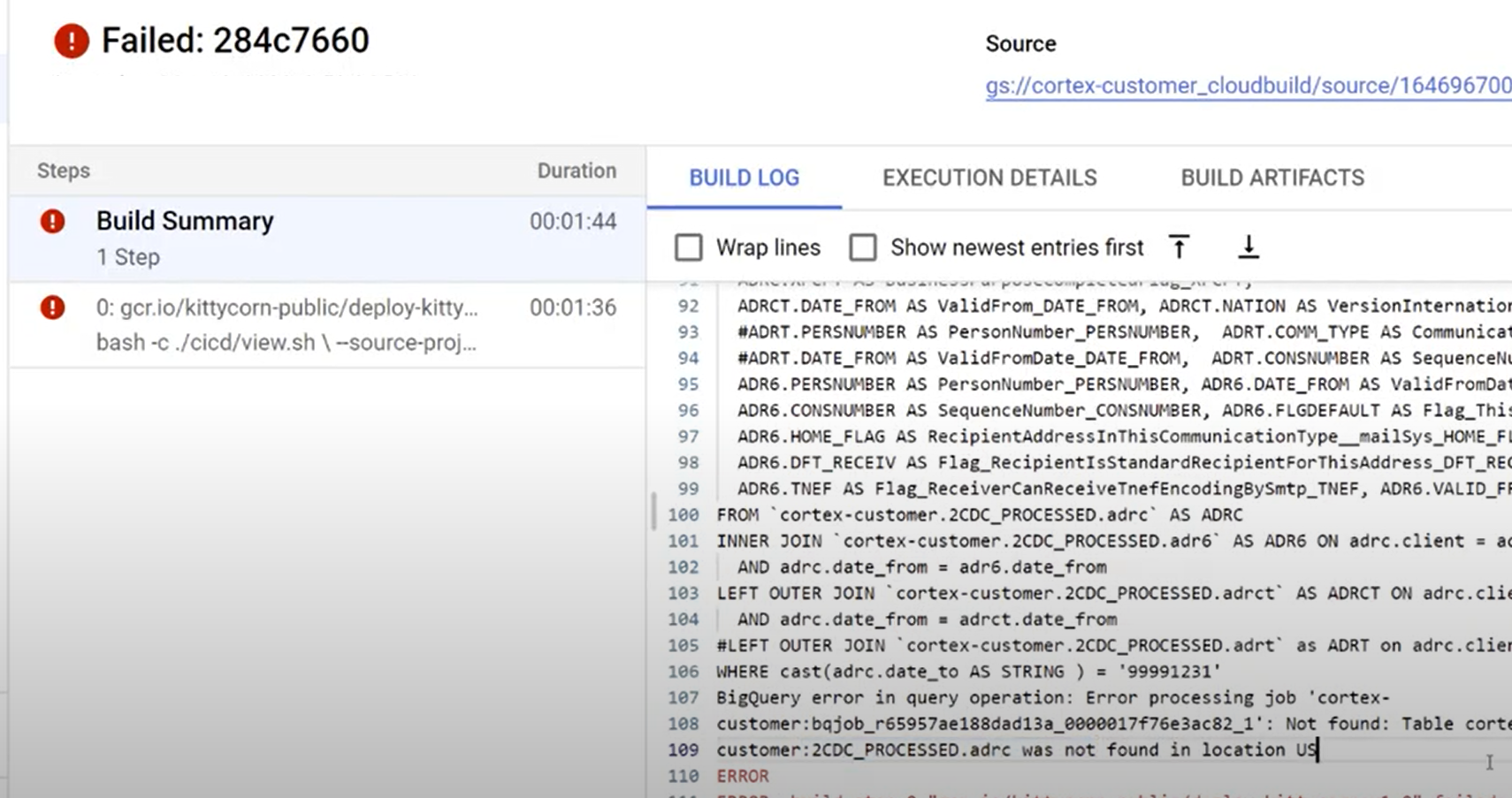

Figura 4. Esempio di monitoraggio dei passaggi della build secondaria nei log. Identifica eventuali problemi con le singole build. Correggi gli errori, se presenti. Ti consigliamo di incollare l'SQL generato in BigQuery per identificare e correggere gli errori. La maggior parte degli errori sono correlati a campi selezionati, ma non presenti nell'origine replicata. La UI di BigQuery aiuta a identificarli e commentarli.

Figura 5. Esempio di identificazione dei problemi tramite i log di Cloud Build.

Sposta i file nel bucket DAG di Cloud Composer (Airflow)

Se hai scelto di generare file di integrazione o CDC e disponi di un'istanza di Cloud Composer (Airflow), puoi spostarli nel bucket finale con il seguente comando:

gcloud storage -m cp -r gs://OUTPUT_BUCKET/dags/ gs://COMPOSER_DAG_BUCKET/

gcloud storage -m cp -r gs://OUTPUT_BUCKET/data/ gs://COMPOSER_DAG_BUCKET/

Sostituisci quanto segue:

OUTPUT_BUCKETcon il bucket di output.COMPOSER_DAG_BUCKETcon il bucket DAG di Cloud Composer (Airflow).

Personalizzare e prepararsi per l'upgrade

Molti clienti aziendali hanno personalizzazioni specifiche dei propri sistemi, ad esempio documenti aggiuntivi in un flusso o tipi specifici di un record. Questi sono specifici per ogni cliente e configurati dagli analisti funzionali in base alle esigenze aziendali.

Cortex utilizza i tag ## CORTEX-CUSTOMER nel codice per indicare i punti in cui è probabile che siano necessarie personalizzazioni. Utilizza il comando grep -R CORTEX-CUSTOMER per

controllare tutti i commenti ## CORTEX-CUSTOMER che devi personalizzare.

Oltre ai tag CORTEX-CUSTOMER, potrebbe essere necessario personalizzare ulteriormente

quanto segue eseguendo il commit di tutte queste modifiche con un tag

chiaro nel codice nel tuo repository forked o clonato:

- Aggiunta di regole aziendali.

- Aggiunta di altri set di dati e unione con viste o tabelle esistenti

- Riutilizzare i modelli forniti per chiamare API aggiuntive.

- Modifica degli script di deployment.

- Applicare ulteriori concetti di data mesh.

- Adattamento di alcune tabelle o API di destinazione per includere campi aggiuntivi non inclusi nello standard.

Adotta una pipeline CI/CD adatta alla tua organizzazione per mantenere

questi miglioramenti testati e la tua soluzione complessiva in uno stato affidabile

e solido. Una pipeline può riutilizzare gli script cloudbuild.yaml

per attivare periodicamente il deployment end-to-end o in base

alle operazioni Git, a seconda del repository scelto, mediante

l'automazione delle build.

Utilizza il file config.json per definire diversi insiemi di progetti e

set di dati per gli ambienti di sviluppo, gestione temporanea e produzione. Utilizza

test automatici con i tuoi dati di esempio per assicurarti che i modelli

producano sempre ciò che ti aspetti.

Tagga le tue modifiche in modo visibile nel fork o nella clonazione di un repository insieme ad alcune automazioni di deployment e test per eseguire gli upgrade.

Assistenza

Se riscontri problemi o hai richieste di funzionalità relative a questi modelli o deployer, crea un problema nel repository Cortex Framework Data Foundation. Per facilitare la raccolta delle informazioni

necessarie, esegui support.sh dalla directory clonata. Questo script

ti guida attraverso una serie di passaggi per aiutarti a risolvere i problemi.

Per eventuali richieste o problemi relativi a Cortex Framework, vai alla sezione Assistenza nella pagina Panoramica.

Looker Blocks e dashboard

Sfrutta i blocchi e le dashboard di Looker disponibili. Si tratta essenzialmente di modelli di dati riutilizzabili per pattern di analisi e origini dati comuni per Cortex Framework. Per ulteriori informazioni, consulta la panoramica di Looker Blocks e delle dashboard.