Paso 3: Determina el mecanismo de integración

En esta página se describe el tercer paso para desplegar Data Foundation de Cortex Framework, el componente principal de Cortex Framework. En este paso, configurará la integración con la fuente de datos que haya elegido. Si utilizas datos de ejemplo, puedes saltarte este paso.

Descripción general de la integración

Cortex Framework te ayuda a centralizar datos de varias fuentes, así como de otras plataformas. De esta forma, se crea una única fuente de información veraz para sus datos. Cortex Data Foundation se integra con cada fuente de datos de diferentes formas, pero la mayoría de ellas siguen un procedimiento similar:

- Capa de origen a capa sin procesar: ingiere datos de la fuente de datos al conjunto de datos sin procesar mediante APIs. Para ello, se usan flujos de procesamiento de Dataflow activados mediante DAGs de Cloud Composer.

- Capa sin procesar a capa de CDC: aplica el procesamiento de CDC al conjunto de datos sin procesar y almacena el resultado en el conjunto de datos de CDC. Esto se consigue mediante DAGs de Cloud Composer que ejecutan consultas de SQL de BigQuery.

- Capa de CDC a capa de informes: crea tablas de informes finales a partir de tablas de CDC en el conjunto de datos Reporting. Para ello, se pueden crear vistas de tiempo de ejecución sobre las tablas de CDC o ejecutar DAGs de Cloud Composer para los datos materializados en tablas de BigQuery, en función de cómo se haya configurado. Para obtener más información sobre la configuración, consulta el artículo Personalizar el archivo de configuración de los informes.

El archivo config.json configura los ajustes necesarios para conectarse a fuentes de datos y transferir datos de varias cargas de trabajo. Consulta las opciones de integración de cada fuente de datos en los siguientes recursos.

- Operacional:

- Marketing:

- Sostenibilidad:

Para obtener más información sobre los diagramas de entidad-relación que admite cada fuente de datos, consulta la carpeta docs del repositorio Data Foundation de Cortex Framework.

Despliegue de K9

El implementador de K9 simplifica la integración de diversas fuentes de datos. El implementador de K9 es un conjunto de datos predefinido en el entorno de BigQuery que se encarga de ingerir, procesar y modelar componentes que se pueden reutilizar en diferentes fuentes de datos.

Por ejemplo, la dimensión time se puede reutilizar en todas las fuentes de datos en las que las tablas necesiten obtener resultados analíticos basados en el calendario gregoriano. El K9

deployer combina datos externos, como el tiempo o Google Trends, con otras fuentes de datos

(por ejemplo, SAP, Salesforce o Marketing). Este conjunto de datos enriquecido permite obtener estadísticas más detalladas y hacer análisis más completos.

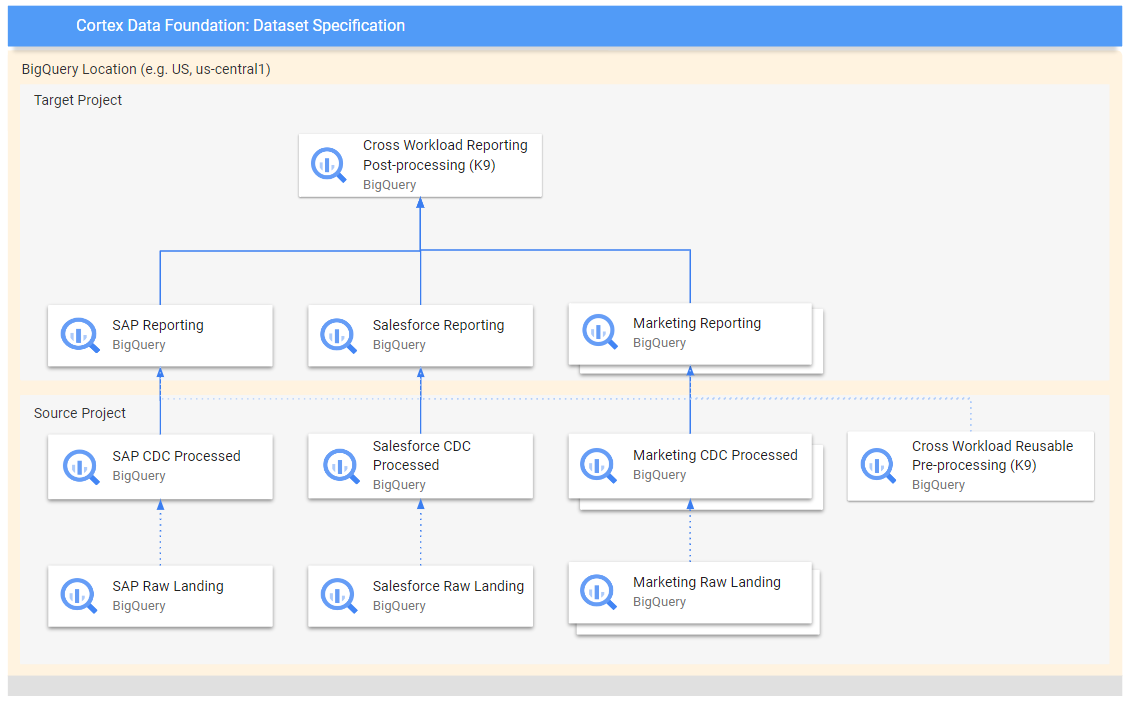

En el siguiente diagrama se muestra el flujo de datos de diferentes fuentes sin procesar a varias capas de informes:

En el diagrama, el proyecto de origen contiene los datos sin procesar de las fuentes de datos elegidas (SAP, Salesforce y Marketing). Mientras que el proyecto de destino contiene datos procesados, derivados del proceso de captura de datos de cambios (CDC).

El paso K9 de preprocesamiento se ejecuta antes de que todas las cargas de trabajo empiecen su implementación, por lo que los modelos reutilizables están disponibles durante la implementación. En este paso se transforman los datos de varias fuentes para crear un conjunto de datos coherente y reutilizable.

Los pasos de K9 posteriores al procesamiento se llevan a cabo después de que todas las cargas de trabajo hayan implementado sus modelos de informes para habilitar los informes entre cargas de trabajo o aumentar los modelos para encontrar las dependencias necesarias en cada conjunto de datos de informes.

Configurar el despliegue de K9

Configura los grafos acíclicos dirigidos (DAGs) y los modelos que se van a generar en el archivo de manifiesto de K9.

El paso de preprocesamiento de K9 es importante porque asegura que todas las cargas de trabajo de la canalización de datos tengan acceso a datos preparados de forma coherente. De esta forma, se reduce la redundancia y se garantiza la coherencia de los datos.

Para obtener más información sobre cómo configurar conjuntos de datos externos para K9, consulta Configurar conjuntos de datos externos para K9.

Pasos siguientes

Cuando haya completado este paso, siga los pasos de implementación que se indican a continuación:

- Establece cargas de trabajo.

- Clonar repositorio.

- Determina el mecanismo de integración (en esta página).

- Configura los componentes.

- Configurar la implementación.

- Ejecuta la implementación.