베어메탈 솔루션 환경 유지보수

베어메탈 솔루션 환경이 준비되고 실행되면 이 가이드에 포함된 정보를 통해 베어메탈 솔루션 서버, 스토리지, 네트워킹을 유지관리합니다.

베어메탈 솔루션 환경에서 SAP HANA를 실행하는 경우 베어메탈 솔루션용 SAP HANA 계획 가이드를 참조하세요.

베어메탈 솔루션 API와 gcloud CLI를 사용하도록 Google Cloud 프로젝트 설정

베어메탈 솔루션 API는 베어메탈 솔루션 환경을 모니터링 및 유지보수할 수 있는 여러 도구를 제공합니다. 일반적으로 이러한 절차는 베어메탈 솔루션 API를 처음 사용할 때만 필요합니다. 하지만 API가 예상한 대로 응답하지 않는 등의 문제 해결 목적에 따라 이 안내를 다시 따를 수 있습니다.

베어메탈 솔루션 관리자 또는 베어메탈 솔루션 편집자 사전 정의된 IAM 역할을 주 구성원에 할당합니다. IAM 역할을 매핑하는 방법을 알아보려면 IAM 역할 부여를 참조하세요.

인터커넥트 연결이 생성된 네트워킹 프로젝트를 비롯해 베어메탈 솔루션 리소스가 구성된 Google Cloud 프로젝트에서 베어메탈 솔루션 API를 사용 설정하고 활성화합니다.

콘솔

- Google Cloud 콘솔 대시보드에서 Bare Metal Solution API로 이동합니다. 또한 API 라이브러리(API 및 서비스 > 라이브러리)에서 베어메탈 솔루션 API를 검색할 수도 있습니다.

- 베어메탈 솔루션 API 페이지에서 사용 설정을 클릭합니다.

- 브라우저에서 뒤로 버튼을 클릭합니다. API 사용 설정됨 단어 옆에 녹색 체크표시가 표시되면 API를 사용할 수 있습니다.

- 베어메탈 솔루션 API를 활성화하려면 다음 중 하나를 수행하세요.

- Google Cloud 프로젝트 내의 베어메탈 솔루션 페이지로 이동합니다.

- Google Cloud 프로젝트 내에서 Google Cloud CLI를 사용하여 베어메탈 솔루션 명령어를 실행합니다.

gcloud

gcloud를 통해 베어메탈 솔루션 API를 사용 설정하려면 다음 명령어에 gcloud CLI 프로젝트 ID를 입력하고, 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고, Enter 또는 Return 키를 누릅니다.gcloud services enable baremetalsolution.googleapis.com --project=PROJECT_ID

베어메탈 솔루션 API를 활성화하려면 다음 중 하나를 수행하세요.

- Google Cloud 프로젝트 내의 베어메탈 솔루션 페이지로 이동합니다.

- Google Cloud 프로젝트 내에서 Google Cloud CLI를 사용하여 베어메탈 솔루션 명령어를 실행합니다.

Google Cloud CLI가 베어메탈 솔루션 API가 사용 설정되고 활성화된 Google Cloud 프로젝트에서 작동하도록 허용합니다.

- Cloud Shell 창에서

gcloud auth login명령어를 입력합니다.gcloud auth login

- 생성된 URL을 복사하여 별도의 브라우저 탭 또는 창에 붙여넣습니다.

- Google Cloud 프로젝트와 연결된 사용자 이름을 사용하여 페이지에 로그인합니다.

- 허용을 클릭하여 gcloud CLI를 사용 설정합니다.

- 승인 코드를 복사합니다.

- 코드를 Cloud Shell 클라이언트 명령줄에 붙여넣습니다.

- Enter 또는 Return 키를 누릅니다.

- Cloud Shell 창에서

Google Cloud에서 API를 설정하는 데 필요한 일반적인 단계에 대한 자세한 내용은 Google Cloud API 시작하기를 참고하세요.

베어메탈 솔루션 서버 운영

베어메탈 솔루션 서버에서 다음 작업을 수행할 수 있습니다.

- 시작: 서버의 전원을 켭니다.

- 중지: 서버의 전원을 끕니다.

재설정: 서버를 다시 시작합니다.

콘솔

서버에서 이 작업을 수행하려면 다음 단계를 따르세요.

Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

시작, 중지, 재설정하려는 서버에서 를 클릭합니다.

다음 단계를 따르세요.

- 서버 전원을 켜려면 전원을 클릭합니다.

- 서버 전원을 끄려면 중지를 클릭합니다.

- 서버를 다시 시작하려면 재설정을 클릭합니다.

gcloud

베어메탈 솔루션 서버의 전원을 끄고 다시 시작하려면 다음 단계를 따르세요.

반드시 API 설정 단계를 따라야 합니다.

서버를 다시 시작하려면 베어메탈 솔루션 API와 gcloud CLI를 사용 설정하고 활성화해야 합니다. 또한 베어메탈 솔루션 관리자 또는 베어메탈 솔루션 편집자 IAM 역할을 주 구성원에 부여해야 합니다.

베어메탈 솔루션 서버를 종료하고 다시 시작하려면

gcloud bms instances reset명령어를 실행합니다.gcloud bms instances reset SERVER_NAME --project=PROJECT_ID --region=REGION

출력에 서버 재시작 요청의 상태가 표시됩니다.

Reset request issued for: [SERVER_NAME]

Waiting for operation [operations/880d346a-4836-4467-acc4-29e6a430bfdd] to complete...done.

이 명령어의 출력은 재시작 상태를 확인하는 데 사용할 수 있는 작업 ID를 제공합니다. 작업 ID를 사용하여 재시작 상태를 확인하려면 장기 실행 작업 상태 보기를 참조하세요.

서버 전원을 켜려면

gcloud bms instances start명령어를 사용합니다.gcloud bms instances start SERVER_NAME --project=PROJECT_ID --region=REGION

출력에 서버 재시작 요청의 상태가 표시됩니다.

Start request issued for: [SERVER_NAME]

Waiting for operation [operations/880d346a-4836-4467-acc4-29e6a430bfdd] to complete...done.

- 서버 운영체제의 종료 명령어를 사용합니다.

- 일부 애플리케이션은 이미지 재처리 후 서버 전원을 자동으로 끕니다.

서버 전원을 끄려면

gcloud bms instances stop명령어를 사용합니다.gcloud bms instances stop --project=PROJECT_ID --region=REGION SERVER_NAME

API

베어메탈 솔루션 서버의 전원을 끄고 다시 시작하려면 다음 단계를 따르세요.

반드시 API 설정 단계를 따라야 합니다.

서버를 다시 시작하려면 베어메탈 솔루션 API와 gcloud CLI를 사용 설정하고 활성화해야 합니다. 또한 베어메탈 솔루션 관리자 또는 베어메탈 솔루션 편집자 IAM 역할을 부여해야 합니다.

베어메탈 솔루션 서버에 로그인하여 서버 재시작을 확인합니다.

- Google Cloud 콘솔 창을 엽니다.

- 점프 호스트 VM 인스턴스로 이동합니다. Compute Engine > VM 인스턴스

- SSH 버튼을 클릭하여 점프 호스트 VM 인스턴스에 연결합니다.

베어메탈 솔루션 서버에 로그인하려면 점프 호스트 명령줄에 SSH 명령어를 입력하세요.

[username@instance-jump-host ~]$ ssh customeradmin@bms-ip-address> customeradmin@bms-ip-address's password: bms-password Last login: Mon Mar 15 22:43:19 2022 from bms-ip-address [customeradmin@BMS_SERVER_NAME ~]$

top명령어를 입력하여 서버가 실행 중인지 확인합니다. 이 창을 사용하여 재부팅 진행 상황을 모니터링할 수 있습니다.

재시작 명령어 실행

- Cloud Shell 창을 엽니다.

다음 명령어에 Google Cloud 프로젝트 ID, 리전, 베어메탈 솔루션 서버 이름을 추가합니다.

curl -X POST \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/BMS_SERVER_NAME:reset"

Cloud Shell 창에 명령어를 복사하여 붙여넣고 Enter 또는 Return 키를 누릅니다.

베어메탈 솔루션 서버가 다시 시작합니다. 서버 구성에 따라 다시 시작하는 데 15~60분 정도 걸립니다.

이 명령어의 출력은 재시작 상태를 확인하는 데 사용할 수 있는 작업 ID를 제공합니다. 작업 ID를 사용하여 상태를 확인하려면 장기 실행 작업 상태 보기를 참조하세요.

{ "name": "operations/5c0c8b3f-5edc-4117-be9f-812af9740aaf" }서버가 재부팅되는 동안 점프 호스트 VM 인스턴스에서 핑 또는 SSH를 사용하여 베어메탈 솔루션 서버에 연결할 수 없습니다. 몇 분 후면 베어메탈 솔루션 서버가 다시 온라인 상태가 됩니다.

서버가 온라인 상태가 되면 호스트 VM 인스턴스에서 핑을 실행하거나 SSH를 사용하여 베어메탈 솔루션 서버에 연결할 수 있습니다.

베어메탈 솔루션 서버 다시 시작에 대한 자세한 내용은 베어메탈 솔루션 API를 참조하세요.

서버의 전원을 켜려면 프로젝트 ID, 리전, 서버 이름을 입력한 후 다음

curl명령어를 실행합니다.curl -X POST \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME:start"

대부분의 경우 서버 전원이 켜진 상태로 유지됩니다. 전원을 끄려면 다음 옵션을 사용합니다.

- 서버 운영체제의 종료 명령어를 사용합니다.

- 일부 애플리케이션은 이미지 재처리 후 서버 전원을 자동으로 끕니다.

서버 전원을 끄려면 프로젝트 ID, 리전, 서버 이름을 입력하고 다음

curl명령어를 실행합니다.curl -X POST \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME:stop"

서버 시작, 중지, 다시 시작을 완료하는 데 시간이 오래 걸리므로 장기 실행 작업 상태 보기의 단계를 수행하여 상태를 확인할 수 있습니다.

서버 상태 확인

서버는 수명 주기의 일부로 여러 상태로 전환합니다. 서버를 시작할 때 베어메탈 솔루션은 서버의 리소스를 프로비저닝합니다. 그런 다음 서버가 부팅 시퀀스를 준비합니다. 서버가 시작되면 서버가 실행 중 상태로 이동합니다. 정상 작동 중에는 실행 중인 서버를 중지했다가 다시 시작할 수 있습니다.

서버는 다음 상태 중 하나일 수 있습니다.

PROVISIONING: 서버에 리소스가 할당됩니다. 서버가 아직 실행 중이 아닙니다.STARTING: 리소스가 확보되었습니다. 서버를 부팅하는 중입니다.부팅 작업은 일반적으로 30분이 소요되며 그 이후에는 서버 상태가

RUNNING로 설정됩니다.RUNNING: 서버가 작동되어 실행 중입니다.서버 상태가

RUNNING이지만 서버를 사용할 수 없는 경우 계속 부팅 중일 수 있습니다. 이는 서버가 크거나 스토리지 볼륨 및 LUN이 많은 경우에 발생할 수 있습니다. 자세한 내용은 서버를 부팅하는 데 시간이 오래 걸림을 참조하세요.STOPPING: 서버를 중지하는 중입니다.SHUTDOWN: 서버가 중지되고 전원이 꺼집니다.DELETED: 서버가 삭제되었습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

상태 열에서 서버의 상태를 볼 수 있습니다.

gcloud

서버 상태를 확인하려면 gcloud bms instances describe 명령어를 실행합니다.

gcloud bms instances describe --project=PROJECT_ID --region=REGION SERVER_NAME

출력의 state 필드에서 서버 상태를 볼 수 있습니다.

예를 들면 다음과 같습니다.

state: RUNNING

API

서버 상태를 확인하려면 프로젝트 ID, 리전, 서버 이름을 다음 curl 명령어에 입력합니다. 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME"

출력의 state 필드에서 서버 상태를 볼 수 있습니다.

예를 들면 다음과 같습니다.

"state" : "RUNNING"

베어메탈 솔루션 환경에서 리소스 관리

베어메탈 솔루션 관리 API, gcloud 명령어, Google Cloud 콘솔을 사용하면 서버, 네트워킹, 스토리지와 같은 베어메탈 솔루션 환경에서 리소스 상태를 볼 수 있습니다.

베어메탈 솔루션 API 설정 확인

리소스 상태를 보려면 베어메탈 솔루션 프로젝트에서 베어메탈 솔루션 API와 gcloud CLI를 사용 설정하고 활성화해야 합니다. 또한 베어메탈 솔루션 관리자 또는 베어메탈 솔루션 편집자와 같은 베어메탈 솔루션 IAM 역할 중 하나를 주 구성원에 부여해야 합니다.

조직 및 폴더의 베어메탈 솔루션 리소스 나열

조직 수준 또는 폴더 수준에서 베어메탈 솔루션 리소스를 확인해야 하는 경우가 있습니다. 조직 또는 폴더 수준에서 리소스를 나열하려면 해당 수준에서 리소스를 나열할 수 있는 IAM 권한이 필요합니다.

사용자에게 IAM 권한을 부여하는 방법은 IAM으로 조직 리소스에 대한 액세스 제어를 참조하세요.

다음은 조직 또는 폴더의 스토리지 볼륨을 나열하는 샘플 Python 스크립트입니다. 요구사항에 따라 이 샘플 스크립트를 수정하여 사용할 수 있습니다. 예를 들어 attached=false와 같은 필터를 사용하여 연결되지 않은 모든 스토리지 볼륨을 나열할 수 있습니다.

이 스크립트를 사용하여 조직 수준에서 스토리지 볼륨을 나열하려면 조직 수준에서 다음 IAM 권한이 필요합니다.

resourcemanager.folders.getresourcemanager.folders.listresourcemanager.organizations.getresourcemanager.projects.getresourcemanager.projects.listbaremetalsolution.volumes.listbaremetalsolution.luns.list

#!/usr/bin/env python

# Copyright 2022 Google LLC

#

# Licensed under the Apache License, Version 2.0 (the "License");

# you may not use this file except in compliance with the License.

# You may obtain a copy of the License at

#

# http://www.apache.org/licenses/LICENSE-2.0

#

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

# This file is automatically generated. Please do not modify it directly.

# Find the relevant recipe file in the samples/recipes or samples/ingredients

# directory and apply your changes there.

from typing import Sequence

from typing import Tuple

from absl import app

from absl import flags

from google.api_core.exceptions import PermissionDenied

from google.cloud import resourcemanager_v3

from google.cloud.bare_metal_solution_v2.services.bare_metal_solution import BareMetalSolutionClient

from google.cloud.bare_metal_solution_v2.types import ListVolumesRequest

_ORGANIZATION_ID = flags.DEFINE_string(

"organization-id",

None,

"Your organization id retrieved from its name:"

" organizations/<organization-id>.",

)

_FOLDER_ID = flags.DEFINE_string(

"folder-id",

None,

"Your folder id retrieved from its name: folders/<folder-id>.",

)

_FILTER = flags.DEFINE_string(

"filter",

"",

"Filter for the resource list request. Syntax should be per"

" https://google.aip.dev/160",

)

def get_projects(

parent: str,

folders_client: resourcemanager_v3.FoldersClient,

projects_client: resourcemanager_v3.ProjectsClient,

) -> str:

"""Retrieves a list of all project IDs available in given organization or folder parent.

Args:

parent: Organization ID or Folder ID of the Cloud org or folder you want

to recursively list project IDs from.

folders_client: Resource manager folder API client.

projects_client: Resource manager project API client.

Yields:

The list of project ids as a string.

"""

projects_request = resourcemanager_v3.ListProjectsRequest(parent=parent)

for project in projects_client.list_projects(request=projects_request):

yield project.project_id

folders_request = resourcemanager_v3.ListFoldersRequest(parent=parent)

for folder in folders_client.list_folders(request=folders_request):

get_projects(folder.name, folders_client, projects_client)

def get_volumes_list(parent: str, filter: str) -> Tuple[str, str]:

"""Retrieves a list of all volume names available in given project.

Args:

parent: Organization ID or Folder ID of the Cloud org or folder you want

to recursively list volumes from.

filter: Filter string for the resource list call. Syntax is per

https://google.aip.dev/160.

Returns:

The list of volumes as a string and the list of PermissionDenied errors in

individual folder or projects, if any.

"""

folders_client = resourcemanager_v3.FoldersClient()

projects_client = resourcemanager_v3.ProjectsClient()

bms_client = BareMetalSolutionClient()

output = []

errors = []

try:

for project in get_projects(parent, folders_client, projects_client):

volumes_list_request = ListVolumesRequest(

parent="projects/" + project + "/locations/global",

filter=filter,

)

try:

for volume in bms_client.list_volumes(request=volumes_list_request):

output.append(f" - {volume.name}")

# This could happen because BMS API is not enabled in a certain project.

except PermissionDenied as e:

errors.append(

f"Unable to list bms resources for project {project}: {e}"

)

except PermissionDenied as e:

errors.append(f"Unable to access folder or project: {e}")

return "\n".join(output), "\n".join(errors)

def main(_: Sequence[str]):

if _ORGANIZATION_ID.value is not None and _FOLDER_ID.value is not None:

raise Exception("Only one of organization ID or folder ID must be provided")

elif _ORGANIZATION_ID.value is None and _FOLDER_ID.value is None:

raise Exception(

"Either one of organization ID or folder ID must be provided"

)

elif _ORGANIZATION_ID.value is not None:

parent = f"organizations/{_ORGANIZATION_ID.value}"

else:

parent = f"folders/{_FOLDER_ID.value}"

volumes, errors = get_volumes_list(parent, filter=_FILTER.value)

print(

"=================== Flat list of volumes in the folder or organization"

" ==================="

)

print(volumes)

print(

"=================== List of folders or projects with errors"

" ==================="

)

print(errors)

if __name__ == "__main__":

app.run(main)

서버 관리

다음 방법으로 베어메탈 솔루션 환경에서 서버를 관리할 수 있습니다.

서버 보기

베어메탈 솔루션 서버의 세부정보를 보려면 다음 단계를 따르세요.

콘솔

서버 페이지로 이동합니다.

서버 페이지에는 다음 세부정보와 함께 모든 서버가 나열됩니다.

필드 설명 예시 상태 서버의 가용성을 나타냅니다. 체크표시가 있는 녹색 원은 서버가 프로비저닝되었고 사용할 수 있음을 나타냅니다. 이름 서버 이름. 서버에 대한 추가 정보를 확인하려면 이름을 클릭합니다.

참고: 서버를 프로비저닝할 때 이름을 입력하지 않으면 이 필드에 ID가 표시됩니다.server-1ID 서버에 할당된 식별자입니다.

- ID를 클릭하여 서버에 대한 기본 정보를 확인합니다.

- 이 리소스의 문제를 해결할 때 Google Cloud 지원팀에 ID를 공유하세요.

at-1234567-svr001위치 베어메탈 솔루션 리전 asia-southeast1포드 서버가 포함된 포드. 포드는 베어메탈 솔루션 리소스가 포함된 격리 단위입니다. 다른 포드의 리소스는 연결할 수 없습니다. 한 리전에 여러 포드가 있을 수 있습니다.

포드 열은 기본적으로 사용 중지되어 있습니다. 이를 사용 설정하려면 다음을 수행하세요.

- 열 표시 옵션을 클릭합니다.

- 포드 체크박스를 선택합니다.

- 확인을 클릭합니다.

포드 열을 사용 설정하지 않으려면 서버 이름을 클릭하여 서버의 포드를 볼 수 있습니다.

asia-southeast1-pod1서버 유형 서버 사양 o2-standard-32-metal클라이언트 IP Google Virtual Private Cloud에 연결되는 서버 IP 주소 10.200.0.5비공개 IP 다른 베어메탈 솔루션 환경 리소스에 연결되는 서버 IP 주소 192.168.2.5라벨 이 서버에 추가한 라벨이 표시됩니다.

라벨의 텍스트를 복사하여 상태 필드 바로 위에 있는 필터 상자에 붙여넣으면 라벨을 사용하여 콘솔 출력을 필터링할 수 있습니다.environment:test서버 활동 워크로드에 영향을 줄 수 있는 베어메탈 솔루션 인프라 문제에 대해 알려줍니다. 서버가 정상적으로 실행되고 문제가 없는 경우 서버 활동 필드는 비어 있습니다. 하지만 서버에 문제가 있으면 이상 감지됨이 표시됩니다. 이 경우 Google에서 조사 후 알려드립니다. 문제가 해결되는 동안 워크로드가 중단되면 고객 지원에 문의하세요.

서버에 대한 추가 세부정보를 보려면 서버의 이름을 클릭합니다.

서버 세부정보 페이지에는 다음과 같은 추가 세부정보가 표시됩니다.

필드 설명 하이퍼스레딩 서버에서 하이퍼스레딩이 사용 설정되었는지 나타냅니다. OS 이미지 서버에서 실행 중인 OS입니다. 펌웨어 버전 서버의 현재 펌웨어 버전입니다. 네트워크 템플릿 서버에서 사용하고 있는 네트워크 템플릿입니다. SSH 키 서버의 SSH 키입니다(구성한 경우). 비밀번호 암호화 키 서버의 암호화 키입니다(구성한 경우). 로그인 정보 로그인 비밀번호를 가져오는 절차입니다. 사용자 계정 사용자 이름과 해당 암호화된 비밀번호입니다. 네트워크 서버에 연결된 네트워크의 세부정보입니다. LUN 서버에 연결된 LUN의 세부정보입니다.

gcloud

베어메탈 솔루션 환경에서 서버를 나열하고 해당 상태를 보려면 프로젝트 ID를 입력하고

gcloud bms instances list명령어를 실행합니다.gcloud bms instances list --project=PROJECT_ID

다음 출력 예시는 서버 이름, 유형, IP 주소, 상태와 같은 서버 관련 정보를 보여줍니다.

NAME PROJECT REGION MACHINE_TYPE IP_ADDRESSES STATE SERVER_NAME PROJECT_ID REGION o2-standard-32-metal 192.168.1.1,192.168.2.1 RUNNING

추가 명령어 옵션은 다음과 같습니다.

--region: 특정 Google Cloud 리전의 기기를 열람합니다.--limit: 특정 기기 수를 표시하도록 출력을 제한합니다.

베어메탈 솔루션 환경에서 특정 서버에 대한 네트워크 및 스토리지 정보를 가져오려면 서버 이름, 프로젝트 ID, 리전을 입력하고

gcloud bms instances describe명령어를 실행합니다.gcloud bms instances describe SERVER_NAME --project=PROJECT_ID --region=REGION

다음 출력 예시는 12개 LUN, 192.168.1.1의 클라이언트 네트워크, 192.168.2.1의 비공개 네트워크로 구성된 운영 서버를 보여줍니다.

luns: - bootLun: true name: SERVER_NAME-lun000-b1 sizeGb: '200' state: READY storageVolume: SERVER_NAME-vol000-b1 - name: STORAGE_DEVICE_NAME-lun001 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun002 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun003 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun004 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun005 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun006 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun007 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun008 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun009 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun010 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun011 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 - name: STORAGE_DEVICE_NAME-lun012 sizeGb: '85' state: READY storageVolume: STORAGE_DEVICE_NAME-vol001 machineType: o2-standard-32-metal name: projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME networks: - ipAddress: 192.168.1.1 macAddress: - 34:80:0D:52:AF:28 - 34:80:0D:15:3E:0D network: STORAGE_DEVICE_NAME-vlan001 - ipAddress: 192.168.2.1 macAddress: - 34:80:0D:52:AF:38 - 34:80:0D:15:3E:1D network: STORAGE_DEVICE_NAME-vlan002 state: RUNNING

API

Google Cloud 콘솔에서 Cloud Shell 터미널 창을 엽니다.

베어메탈 솔루션 환경에 서버를 나열하고 상태를 보려면 다음

curl명령어에 프로젝트 ID와 리전을 입력하고 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣은 후 Enter 또는 Return 키를 누릅니다.curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances"

베어메탈 솔루션 환경에서 서버에 대한 네트워크 및 스토리지 정보를 가져오려면 다음 명령어를 실행합니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME"

라벨을 사용하여 서버 구성

서버 구성을 돕기 위해 라벨을 사용할 수 있습니다. 라벨은 각 서버에 연결할 수 있는 키-값 쌍으로, 라벨에 따라 서버를 필터링할 수 있습니다. 예를 들어 라벨을 사용하여 용도, 환경, 위치, 부서 등을 기준으로 서버를 그룹화할 수 있습니다. 라벨은 선택사항입니다.

서버 라벨 추가 또는 업데이트

기존 서버의 라벨을 추가하거나 업데이트할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

라벨을 지정하려는 서버에서 을 클릭합니다.

라벨 수정을 클릭합니다.

라벨 편집기 페이지에서 다음을 수행합니다.

- 라벨 추가를 클릭하고 키-값 쌍을 추가합니다.

- 라벨을 업데이트하려면 기존 라벨을 선택하고 값을 수정합니다.

- 제출을 클릭합니다.

서버 페이지로 돌아와서 페이지를 새로고침하여 변경사항을 확인합니다.

gcloud

서버의 라벨을 추가하거나 업데이트하려면 --update-labels 옵션과 함께 gcloud bms instances update 명령어를 사용합니다.

다음 샘플 명령어는 environment = dev 및 location = branch 라벨을 추가합니다.

gcloud bms instances update SERVER_NAME --project=PROJECT_ID --region=REGION --update-labels environment=dev,location=branch

이미 존재하는 라벨에 새 값을 제공하면 시스템에서 기존 키를 새 라벨 값으로 업데이트합니다. 새 라벨을 제공하면 시스템에서 라벨 목록에 새 라벨을 추가합니다.

API

서버의 라벨을 추가하거나 업데이트하려면 다음 curl 명령어에 프로젝트 ID, 리전, 서버 이름, 라벨 목록을 입력합니다. 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

다음 샘플 명령어는 environment = test의 라벨을 할당합니다.

curl -X PATCH \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "X-Goog-User-Project: PROJECT_ID" \

-H "Content-Type: application/json" \

"https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME?updateMask=labels"

-d "{

'labels' : {'environment': 'test'}

}"

서버에서 라벨 삭제

서버에서 라벨을 삭제할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

라벨을 삭제할 서버의 경우 을 클릭합니다.

라벨 수정을 클릭합니다.

라벨 편집기 페이지에서 다음을 수행합니다.

- 라벨을 삭제하려면 을 클릭합니다.

- 제출을 클릭합니다.

서버 페이지로 돌아와서 페이지를 새로고침하여 변경사항을 확인합니다.

gcloud

서버에서 라벨을 삭제하려면 다음 옵션과 함께 gcloud bms instances update 명령어를 사용합니다.

--remove-labels: 지정된 라벨을 삭제합니다.--clear-labels: 모든 라벨을 삭제합니다.

다음 샘플 명령어는 서버에서 department 라벨을 삭제합니다.

gcloud bms instances update SERVER_NAME --project=PROJECT_ID --region=REGION --remove-labels=department

다음 샘플 명령어는 서버에서 모든 라벨을 삭제합니다.

gcloud bms instances update SERVER_NAME --project=PROJECT_ID --region=REGION --clear-labels

API

서버에서 라벨을 삭제하려면 다음 curl 명령어에 프로젝트 ID, 리전, 서버 이름을 입력합니다. 비어 있는 라벨 목록을 제공하여 모든 라벨을 삭제하거나 유지하려는 라벨 목록을 제공합니다(삭제하려는 라벨은 생략). 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

다음 샘플 명령어는 environment = test를 제외한 모든 라벨을 삭제합니다.

curl -X PATCH \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "X-Goog-User-Project: PROJECT_ID" \

-H "Content-Type: application/json" \

"https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME?updateMask=labels"

-d "{

'labels' : {'environment': 'test'}

}"

라벨을 사용하여 서버 필터링

라벨을 사용하여 서버를 검색하고 결과를 필터링할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

서버 목록 위에 있는 필터 표시줄을 클릭합니다.

속성 목록에서 라벨을 선택합니다.

라벨의 키, 값 또는 키-값 쌍을 입력합니다.

예를 들어

env:dev라벨이 있는 서버만 보려면 다음 중 하나를 입력하면 됩니다.env키를 입력합니다.dev값을 입력합니다.env:dev키-값 쌍을 입력합니다.

라벨 필터를 적용하려면 필터 표시줄 외부의 아무 곳을 클릭합니다.

gcloud

라벨을 사용하여 서버를 필터링하려면 --filter 옵션과 함께 gcloud bms instances list 명령어를 사용하세요.

--filter 옵션의 값은 labels.KEY=VALUE 형식이어야 합니다. 예를 들어 env 키 및 dev 값으로 라벨을 필터링하려면 다음 명령어를 실행합니다.

gcloud bms instances list --project=PROJECT_ID --region=REGION --filter labels.environment=dev

gcloud CLI의 필터 구문에 대한 상세 설명은 gcloud topic filters 문서를 참조하세요.

API

라벨을 사용하여 서버를 필터링하려면 filter=labels 및 키-값 쌍 라벨과 함께 프로젝트 ID 및 리전을 입력합니다. 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

다음 샘플 명령어는 키-값 쌍 라벨이 environment = test인 서버를 찾도록 출력을 제한합니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances"?filter=labels.environment=test

서버 이름 변경

서버 이름을 바꾸려면 다음 단계를 따르세요.

콘솔

Google Cloud 콘솔에서 Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

서버 이름을 클릭합니다.

서버 세부정보 페이지의 이름 필드에서 이름 수정을 클릭합니다.

이름 수정 페이지에서 새 이름을 입력합니다.

저장을 클릭합니다.

변경사항을 확인하려면 페이지를 새로고침하세요.

gcloud

서버 이름을 바꾸려면 gcloud bms instances rename 명령어를 사용합니다.

gcloud bms instances rename SERVER_NAME --new-name=NEW_NAME --project=PROJECT_ID --region=REGION

다음을 바꿉니다.

- SERVER_NAME: 서버의 현재 이름입니다.

- NEW_NAME: 서버의 새 이름입니다.

- PROJECT_ID: 프로젝트 ID입니다.

- REGION: 서버의 위치입니다.

서버의 초기 비밀번호 검색

베어메탈 솔루션 서버를 처음 받거나 운영체제를 변경하면 서버가 기본 상태로 시작되며 초기 비밀번호가 있습니다. 서버에 처음 액세스할 때 이 비밀번호를 사용해야 합니다. 초기 비밀번호를 입력하면 서버에서 비밀번호를 변경하라는 메시지가 표시됩니다.

초기 비밀번호를 찾으려면 다음 안내를 따르세요.

gcloud

Google Cloud 서비스 계정을 가장할 수 있도록 자신을 승인합니다.

gcloud iam service-accounts add-iam-policy-binding명령어를 실행합니다.gcloud iam service-accounts add-iam-policy-binding \ SERVICE_ACCOUNT_NAME@PROJECT_ID.iam.gserviceaccount.com \ --member=user:USER_EMAIL \ --project=PROJECT_ID \ --role=roles/iam.serviceAccountTokenCreator

이미 승인된 경우 이 단계를 건너뛸 수 있습니다.

베어메탈 솔루션 서버가 포함된 프로젝트에서

gcloud bms instances describe명령어를 실행합니다.gcloud bms instances describe SERVER_NAME --project=PROJECT_ID --region=REGION

출력에서

loginInfo필드를 확인합니다.loginInfo필드에서gcloud beta secrets versions access명령어를 복사하여 명령줄 프롬프트에 붙여넣습니다.다음과 같이

gcloud beta secrets versions access명령어에--impersonate-service-account파라미터를 추가하고 실행합니다.gcloud beta secrets versions access \ --project=PROJECT_ID \ --secret machine-reg-SERVER_NAME-customeradmin latest \ --impersonate-service-account=SERVICE_ACCOUNT_NAME@PROJECT_ID.iam.gserviceaccount.com

이 명령어는 서버의 사용자 인증 정보를 출력합니다.

사용자 이름(일반적으로

customeradmin) 및 비밀번호를 검색합니다.이러한 사용자 인증 정보를 사용하여 서버에 로그인합니다.

비밀번호를 변경합니다.

API

- 비밀번호를 검색하기 전에 Google Cloud에서 제공한 서비스 계정이 활성화되어 있는지 확인합니다.

- 베어메탈 솔루션 리소스가 포함된 프로젝트에서 Cloud Shell에 액세스합니다.

다음

curl명령어에 프로젝트 ID, 리전, 서버 이름을 입력하고, 명령줄 프롬프트에 명령어를 복사하여 붙여넣은 다음 Enter 또는 Return 키를 누릅니다.curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME"

출력에서

loginInfo필드를 찾고 안내를 따릅니다.loginInfo필드에gcloud beta secrets versions access명령어가 포함된 경우 명령어를 복사하여 명령줄 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.사용자 이름(일반적으로

customeradmin) 및 비밀번호를 검색합니다.이러한 사용자 인증 정보를 사용하여 서버에 로그인합니다.

비밀번호를 변경합니다.

OS 세부정보 보기

서버 운영체제(OS)의 세부정보를 보려면 gcloud bms os-images describe 명령어를 실행하여 OS 세부정보를 확인합니다.

gcloud bms os-images describe OS_IMAGE --project=PROJECT_ID

다음을 바꿉니다.

- OS_IMAGE: OS 이미지 코드. OS의 OS 이미지 코드를 확인하려면 운영체제를 참고하세요.

- PROJECT_ID: 프로젝트 ID

예를 들면 다음과 같습니다.

gcloud bms os-images describe OEL8x --project=test-project

다음은 샘플 출력입니다.

applicableInstanceTypes: - o2-highmem-224-metal - o2-standard-112-metal - o2-standard-16-metal - o2-standard-32-metal - o2-standard-48-metal code: OEL8x description: Oracle Linux 8.8 [5.4.17-2136.324.5.3.el8uek.x86_64] name: projects/bmaas-testing/locations/global/osImages/OEL8x supportedNetworkTemplates: - s200-bondaa-bondaa - s400-bondaa-bondaa

서버 OS 변경

베어메탈 솔루션 서버를 다른 OS 이미지로 이미지 재설치할 수 있습니다. OS 이미지를 변경하는 데 오랜 시간이 걸리며 서버의 전원을 껐다 켜야 합니다. 사용 가능한 OS 이미지 중 하나를 선택하려면 운영체제를 방문하세요.

콘솔

Google Cloud 콘솔에서 베어메탈 솔루션 서버의 이미지를 만들 수 있습니다.

- Compute Engine > 베어메탈 솔루션 > 서버로 이동합니다.

- 이미지를 재설치하려는 서버에서 메뉴를 클릭합니다.

- 수정을 클릭합니다.

서버 수정 페이지에서 다음을 수행합니다.

- 서버 재이미지 체크박스를 선택합니다.

- OS 이미지 목록에서 설치하려는 OS 이미지를 선택합니다.

(선택사항) 서버 비밀번호의 암호화 키를 설정합니다.

- 비밀번호 암호화 키 목록에서 키를 선택합니다.

- 버전 목록에서 암호화 키 버전을 선택합니다.

베어메탈 솔루션에서 암호화 키를 사용하는 방법에 대한 자세한 내용은 서버 암호화 키 설정을 참조하세요.

(선택사항) 서버 SSH 키를 설정하거나 변경합니다.

- SSH 키 목록에서 키를 선택합니다. 이 목록에는 서버와 동일한 프로젝트에 있는 SSH 키만 표시됩니다.

서버의 기존 SSH 키를 변경하려면 변경하려는 키를 선택 해제하고 새 키를 선택합니다.

베어메탈 솔루션에서 SSH 키를 사용하는 방법에 대한 자세한 내용은 서버 SSH 키 설정을 참조하세요.

저장을 클릭합니다.

gcloud

gcloud bms instances update 명령어를 실행하여 서버의 OS 이미지를 변경합니다. OS 이미지 코드는 운영체제를 참고하세요.

gcloud bms instances update SERVER_NAME --region REGION --os-image=OS_IMAGE

SSH 키, 암호화 키 또는 둘 다를 설정하려면 gcloud alpha bms instances update 명령어를 사용합니다. 키를 이름이나 전체 리소스로 지정할 수 있습니다.

gcloud alpha bms instances update SERVER_NAME --region REGION --os-image=OS_IMAGE --kms-crypto-key-version=KMS_CRYPTO_KEY_VERSION --ssh-keys=KEY_1,KEY_2

예:

gcloud alpha bms instances update server1 --region europe-west3 --os-image=OS_IMAGE --kms-crypto-key-version=projects/bmaas-testing/locations/global/keyRings/e2e-test/cryptoKeys/e2e-test-key/cryptoKeyVersions/1 --ssh-keys=e2e-test-key-1,e2e-test-key-2

API

베어메탈 솔루션 서버에서 OS 이미지를 업데이트하려면 프로젝트 ID, 리전, 서버 이름 및 OS 이미지를 입력한 후 다음 curl 명령어를 실행하세요. OS 이미지 코드는 운영체제를 참고하세요.

curl -X PATCH \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "X-Goog-User-Project: PROJECT_ID" \

-H "Content-Type: application/json" \

"https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME?updateMask=os_image"

-d "{

'osImage' : 'OS_IMAGE'

}"

이 변경이 완료되는 데 다소 시간이 걸리므로 장기 실행 작업 상태 보기의 단계에 따라 상태를 확인할 수 있습니다.

서버에서 하이퍼스레딩 사용 설정

베어메탈 솔루션 서버에서 하이퍼스레딩을 사용 설정 또는 사용 중지할 수 있습니다. 이 작업은 완료하는 데 시간이 많이 걸리며 서버의 전원을 껐다 켜야 합니다.

콘솔

Google Cloud 콘솔의 베어메탈 솔루션 서버에서 하이퍼 스레딩을 사용 설정하거나 사용 중지할 수 있습니다.

- Compute Engine > 베어메탈 솔루션 > 서버로 이동합니다.

- 하이퍼스레딩을 사용 설정 또는 사용 중지하려는 서버에서 메뉴를 클릭합니다.

- 수정을 클릭합니다.

- 서버 수정 페이지에서 다음을 수행합니다.

- 하이퍼스레딩을 사용 설정하려면 하이퍼스레딩 사용 설정 체크박스를 선택합니다.

- 하이퍼스레딩을 사용 중지하려면 하이퍼스레딩 사용 설정 체크박스를 선택 취소합니다.

- 저장을 클릭합니다.

gcloud

하이퍼스레딩을 사용 설정 또는 중지하려면 gcloud bms instances update 명령어를 실행합니다.

- –enable-hyperthreading 옵션을 포함하여 사용 설정합니다.

- –no-enable-hyperthreading 옵션을 포함하여 사용 중지합니다.

gcloud bms instances update SERVER_NAME --region REGION --enable-hyperthreading

API

서버의 현재 하이퍼스레딩 기능을 변경하려면 다음 curl 명령어에 프로젝트 ID, 리전, 서버 이름을 입력합니다. 하이퍼스레딩 값을 사용하려면 true를 추가하고 이를 중지하려면 false를 추가합니다.

curl -X PATCH \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "X-Goog-User-Project: PROJECT_ID" \

-H "Content-Type: application/json" \

"https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME?updateMask=hyperthreading_enabled"

-d "{

'hyperthreadingEnabled' : 'HYPERTHREADING_VALUE'

}"

이 변경이 완료되는 데 다소 시간이 걸리므로 장기 실행 작업 상태 보기의 단계에 따라 상태를 확인할 수 있습니다.

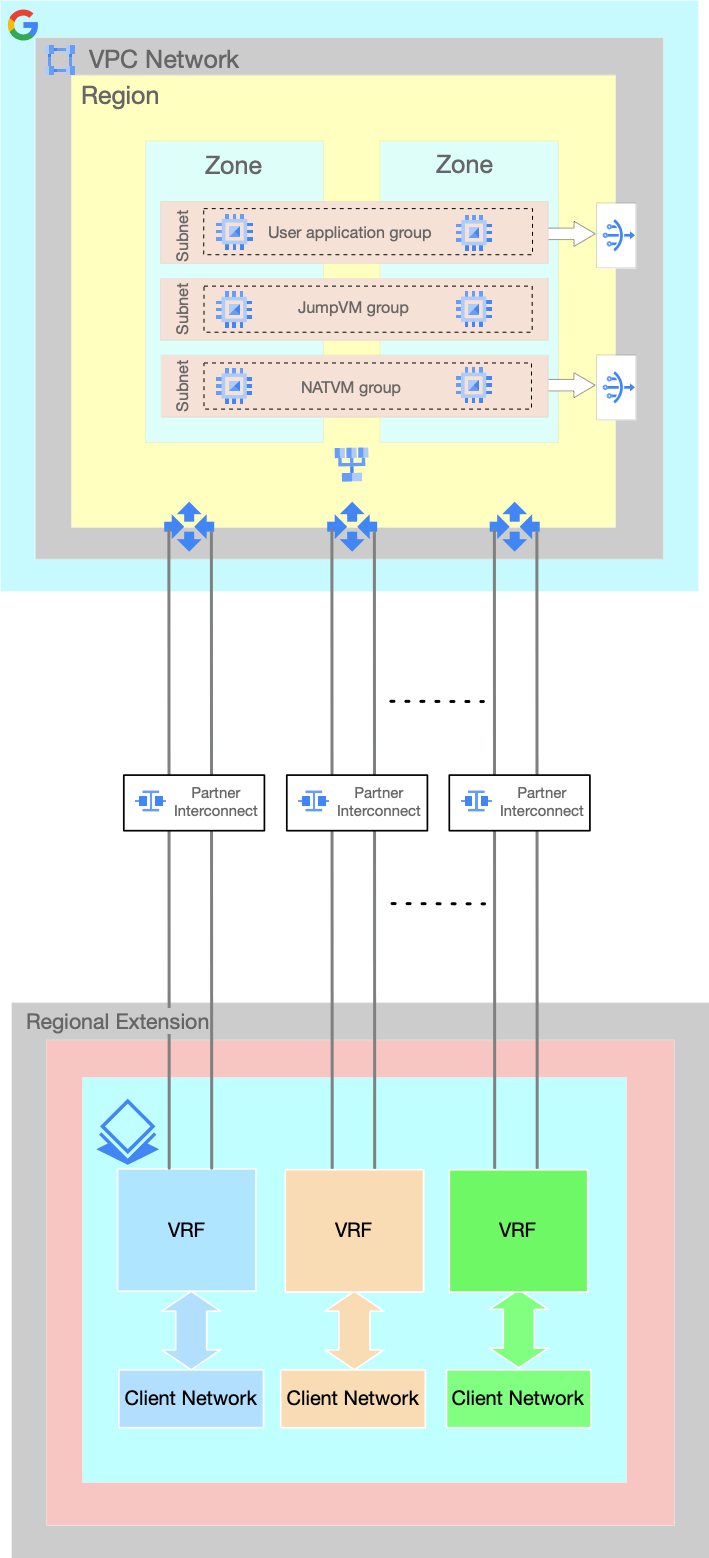

VRF 관리

베어메탈 솔루션 환경에서 VRF(가상 라우팅 및 전달)는 클라이언트 네트워크와 VLAN 연결(interconnectAttachments라고도 함) 간의 연결 인터페이스입니다.

VRF를 사용하면 다음과 같은 방법으로 클라이언트 네트워크를 VLAN 연결에 매핑할 수 있습니다.

단일 VRF를 통해 단일 클라이언트 네트워크를 단일 VLAN 연결 쌍에 매핑합니다. 기본 매핑입니다. Google Cloud 콘솔 접수 양식을 통해 클라이언트 네트워크를 만들면 VRF가 암시적으로 생성됩니다. 이 VRF는 클라이언트 네트워크와 해당 VLAN 연결에서 Google Cloud로 연결을 설정하는 데 사용됩니다.

단일 VRF를 통해 단일 클라이언트 네트워크를 여러 VLAN 연결에 매핑합니다. 이렇게 하면 베어메탈 솔루션 환경과 Google Cloud간의 대역폭을 늘릴 수 있습니다.

단일 VRF를 사용하여 여러 클라이언트 네트워크를 매핑하여 여러 VLAN 연결을 공유합니다. 이렇게 하면 베어메탈 솔루션 환경과 Google Cloud간의 대역폭을 늘릴 수 있습니다.

이 매핑에서는 클라이언트 네트워크가 서로 격리되지 않습니다. 이러한 네트워크는 공통 VRF를 통해 서로 라우팅됩니다. 따라서 이러한 네트워크의 호스트는 트래픽 필터링 없이 서로 통신할 수 있습니다.

전용 VRF를 사용하여 여러 클라이언트 네트워크를 전용 VLAN 연결에 매핑합니다. 이렇게 하면 각 클라이언트 네트워크에 특정 대역폭을 할당할 수 있습니다.

이 매핑에서 클라이언트 네트워크는 서로 격리됩니다. VPC 네트워크 (즉, Google Cloud 네트워크)를 이러한 클라이언트 네트워크 간의 전송으로 사용할 수 없습니다.

다음 방법으로 베어메탈 솔루션 환경에서 VRF 및 VLAN 연결을 관리할 수 있습니다.

VRF 보기

VRF의 세부정보를 보려면 다음 단계를 따르세요.

VRF 페이지로 이동합니다.

VRF 페이지에는 다음 세부정보와 함께 모든 VRF가 표시됩니다.

필드 설명 상태 VRF의 가용성을 나타냅니다. 이름 VRF의 이름입니다. VRF에 대한 추가 정보를 확인하려면 이름을 클릭합니다.

참고: VRF를 프로비저닝할 때 이름을 입력하지 않은 경우 이 필드에 ID가 표시됩니다.ID VRF에 할당된 식별자입니다.

- VRF에 대한 추가 정보를 확인하려면 ID를 클릭합니다.

- 이 리소스의 문제를 해결할 때 Google Cloud 지원팀에 ID를 공유하세요.

리전 VRF가 위치한 리전입니다. 포드 VRF가 포함된 포드입니다. 포드는 베어메탈 솔루션 리소스가 포함된 격리 단위입니다. 다른 포드의 리소스는 연결할 수 없습니다. 한 리전에 여러 포드가 있을 수 있습니다.

포드 열은 기본적으로 사용 중지되어 있습니다. 이를 사용 설정하려면 다음을 수행하세요.

- 열 표시 옵션을 클릭합니다.

- 포드 체크박스를 선택합니다.

- 확인을 클릭합니다.

포드 열을 사용 설정하지 않으려면 VRF 이름 또는 ID를 클릭하여 VRF의 포드를 볼 수 있습니다.

VRF에 대한 추가 세부정보를 보려면 VRF의 이름 또는 ID를 클릭합니다.

VRF 세부정보 페이지에는 다음과 같은 추가 세부정보가 표시됩니다.

필드 설명 VLAN 연결 쌍 피어 IP, 라우터 IP, 대역폭 등의 VRF와 연결된 VLAN 연결 쌍의 세부정보입니다. 구성원 네트워크 VRF와 연결된 네트워크 목록입니다. 네트워크를 클릭하면 네트워크의 세부정보를 볼 수 있습니다.

VRF 만들기

Google Cloud 콘솔 접수 양식을 통해 새 네트워크를 프로비저닝하면 VRF가 암시적으로 생성됩니다. 하지만 나중에 VRF를 더 만들 수도 있습니다.

새 VRF를 만들려면 다음 단계를 따르세요.

VRF 페이지로 이동합니다.

만들기를 클릭합니다.

VRF 이름을 입력합니다.

리전 목록에서 VRF의 리전을 선택합니다.

포드 목록에서 VRF의 포드를 선택합니다.

포드 드롭다운 목록에는 선택한 위치의 각 포드에 있는 기존 베어메탈 솔루션 리소스 수도 표시됩니다.

어떤 포드를 선택해야 할지 잘 모르겠다면 Google Cloud 영업팀에 문의하세요.

-

VRF를 만드는 동안 VLAN 연결 쌍을 하나만 추가할 수 있습니다. VLAN 연결 쌍 추가의 단계에 따라 VRF를 만든 후 VLAN 연결 쌍을 추가할 수 있습니다.

만들기를 클릭합니다.

VRF 삭제

VRF를 삭제하기 전에 모든 VLAN 연결 쌍과 연결된 네트워크를 삭제해야 합니다. VLAN 연결 쌍 삭제 및 네트워크 삭제를 참고하세요.

VRF를 삭제하려면 다음 단계를 따르세요.

VRF 페이지로 이동합니다.

삭제할 VRF를 선택합니다.

삭제를 클릭합니다.

확인을 클릭합니다.

VLAN 연결 관리

다음 방법으로 VLAN 연결 쌍을 관리할 수 있습니다.

VLAN 연결 쌍 추가

VRF에는 여러 VLAN 연결 쌍이 있을 수 있습니다. 하지만 VLAN 연결은 하나의 VRF와만 페어링할 수 있습니다.

베어메탈 솔루션 네트워크의 경우 고가용성을 위해 VLAN 연결을 쌍으로 만드는 것이 좋습니다.

VRF 페이지로 이동합니다.

VRF 이름을 클릭합니다.

VRF 세부정보 페이지의 VLAN 연결 쌍 섹션에서 만들기를 클릭합니다.

새 VLAN 연결 쌍 페이지에서 다음을 수행합니다.

대역폭 목록에서 VLAN 연결에 할당할 대역폭 양을 선택합니다.

현재 프로젝트에서 VLAN 연결 쌍을 추가하려면 다음 안내를 따르세요.

- 현재 프로젝트에서 VLAN 연결 선택 체크박스를 선택합니다.

- 첫 번째 VLAN 연결 ID 필드에 첫 번째 VLAN 연결의 ID를 입력하고 두 번째 VLAN 연결 ID 필드에 두 번째 VLAN 연결의 ID를 입력합니다.

다른 프로젝트의 VLAN 연결 쌍을 추가하려면 다음 안내를 따르세요.

- VLAN 연결이 포함된 네트워킹 프로젝트에서 베어메탈 솔루션 API 및 gcloud CLI를 사용 설정하고 활성화해야 합니다.

- 현재 프로젝트에서 VLAN 연결 선택 체크박스를 선택 해제합니다.

첫 번째 VLAN 연결 ID 필드에 첫 번째 VLAN 연결의 ID를 입력하고 두 번째 VLAN 연결 ID 필드에 두 번째 VLAN 연결의 ID를 입력합니다. VLAN 연결을 다음 형식으로 입력합니다.

projects/PROJECT_ID/regions/INTERCONNECT_REGION/interconnectAttachments/VLAN_ATTACHMENT_NAME

만들기를 클릭합니다.

VLAN 연결 쌍을 만드는 데 다소 시간이 걸리므로 장기 실행 작업 상태 보기의 단계에 따라 상태를 확인할 수 있습니다.

VLAN 연결 쌍 업데이트

VLAN 연결 쌍의 대역폭만 업데이트할 수 있습니다.

VRF 페이지로 이동합니다.

VRF 이름을 클릭합니다.

VRF 세부정보 페이지의 VLAN 연결 쌍 섹션에서 업데이트할 VLAN 연결 쌍을 선택합니다.

수정을 클릭합니다.

VLAN 연결 쌍 수정 페이지에서 다음을 수행합니다.

- 대역폭 목록에서 VLAN 연결에 할당할 대역폭 양을 선택합니다.

- 저장을 클릭합니다.

VLAN 연결 쌍을 업데이트하는 데 다소 시간이 걸리므로 장기 실행 작업 상태 보기의 단계에 따라 상태를 확인할 수 있습니다.

VLAN 연결 쌍 삭제

이 절차의 단계에 따라 VLAN 연결 쌍을 삭제하면 VRF에서 VLAN 연결 쌍이 연결 해제될 뿐 실제로 삭제되지는 않습니다.

VRF 페이지로 이동합니다.

VRF 이름을 클릭합니다.

VRF 세부정보 페이지의 VLAN 연결 쌍 섹션에서 삭제할 VLAN 연결 쌍을 선택합니다.

삭제를 클릭합니다.

VLAN 연결 쌍을 삭제하는 데 다소 시간이 걸리므로 장기 실행 작업 상태 보기의 단계를 수행하여 상태를 확인할 수 있습니다.

네트워크 관리하기

다음 방법으로 베어메탈 솔루션 환경에서 네트워크를 관리할 수 있습니다.

- 네트워크 보기

- 라벨을 사용하여 네트워크 정리

- 네트워크 이름 변경

- 네트워크 만들기

- 서버에 네트워크 연결

- 서버에서 네트워크 분리

- 네트워크 삭제

- 베어메탈 솔루션 환경의 고급 네트워킹 정보 보기

- 베어메탈 솔루션 환경에서 IP 주소 관리 구현

네트워크 보기

베어메탈 솔루션 환경에서 네트워크 리소스를 모니터링하면 서버가 다른 리소스에 연결하는 방법을 알 수 있습니다.

네트워크 세부정보를 보려면 다음 단계를 따르세요.

콘솔

네트워크 페이지로 이동합니다.

네트워크 페이지에는 다음 세부정보와 함께 모든 네트워크가 나열됩니다.

필드 설명 예시 상태 네트워크의 가용성을 나타냅니다. 체크표시가 있는 녹색 원은 네트워크가 프로비저닝되었고 사용할 수 있음을 나타냅니다. ID 네트워크에 할당된 식별자입니다.

- 네트워크에 대한 기본 정보를 보려면 ID를 클릭합니다.

- 이 리소스의 문제를 해결할 때 Google Cloud 지원팀에 ID를 공유하세요.

at-1234567-vlan001이름 네트워크 이름. 네트워크에 대한 추가 정보를 확인하려면 이름을 클릭합니다.

참고: 네트워크를 프로비저닝할 때 이름을 입력하지 않으면 이 필드에 ID가 표시됩니다.network-1위치 네트워크가 위치한 리전 asia-southeast1포드 네트워크가 포함된 포드. 포드는 베어메탈 솔루션 리소스가 포함된 격리 단위입니다. 다른 포드의 리소스는 연결할 수 없습니다. 한 리전에 여러 포드가 있을 수 있습니다.

포드 열은 기본적으로 사용 중지되어 있습니다. 이를 사용 설정하려면 다음을 수행하세요.

- 열 표시 옵션을 클릭합니다.

- 포드 체크박스를 선택합니다.

- 확인을 클릭합니다.

포드 열을 사용 설정하지 않으려면 네트워크 이름을 클릭하여 네트워크의 포드를 볼 수 있습니다.

asia-southeast1-pod1유형 클라이언트 또는 비공개 네트워크 ClientCIDR 네트워크의 IP 주소 범위 192.168.1.0/24VLAN ID Google Cloud에서 할당한 VLAN 식별자 100라벨 이 네트워킹 리소스에 추가한 라벨이 표시됩니다.

라벨의 텍스트를 복사하여 상태 필드 바로 위에 있는 필터 상자에 붙여넣으면 라벨을 사용하여 콘솔 출력을 필터링할 수 있습니다.environment:test네트워크의 추가 세부정보를 보려면 네트워크의 이름 또는 ID를 클릭합니다.

네트워크 세부정보 페이지에는 다음과 같은 추가 세부정보가 표시됩니다.

필드 설명 게이트웨이 IP 네트워크에 있는 게이트웨이의 IP 주소입니다. 서비스 IP 주소 범위 서버에서 실행 중인 OS입니다. MTU 네트워크의 MTU입니다. VRF 네트워크와 연결된 VRF입니다. 사용된 주소 네트워크로 연결된 서버의 IP 주소입니다.

gcloud

베어메탈 솔루션 환경의 모든 네트워크를 보고 해당 상태를 확인하려면 프로젝트 ID를 입력하고

gcloud bms networks list명령어를 실행합니다.gcloud bms networks list --project=PROJECT_ID

NAME REGION RANGE TYPE VLAN_ID at-1111111-vlan001 REGION 192.168.1.0/24 CLIENT 122 at-1111111-vlan002 REGION 192.168.2.0/24 PRIVATE 123

단일 네트워크의 세부정보를 보려면 프로젝트 ID, 리전, 네트워크 이름을 입력하고

gcloud bms networks describe명령어를 실행합니다.gcloud bms networks describe NETWORK_NAME --project=PROJECT_ID --region=REGION

cidr: 192.168.1.0/24 name: projects/PROJECT_ID/locations/REGION/networks/NETWORK_NAME state: PROVISIONED type: CLIENT vlanId: '122' vrf: autonomousSystemNumber: '65500' juniperAlias: g00000-at-1111111-ic001 name: at-1111111-ic001 routeTarget: '282' state: PROVISIONED

API

Google Cloud 콘솔에서 Cloud Shell 터미널 창을 엽니다.

베어메탈 솔루션 환경의 모든 네트워크를 보고 상태를 보려면 다음

curl명령어에 프로젝트 ID와 리전을 입력하고 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣은 후 Enter 또는 Return 키를 누릅니다.curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/networks"

단일 네트워크의 세부정보를 보려면 프로젝트 ID, 리전, 네트워크 이름을 입력하고 다음 명령어를 실행합니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/networks/NETWORK_NAME"

라벨을 사용하여 네트워크 정리

라벨을 사용하여 네트워크를 정리할 수 있습니다. 라벨은 각 네트워크에 연결할 수 있는 키-값 쌍으로, 라벨에 따라 네트워크를 필터링할 수 있습니다. 예를 들어 라벨을 사용하여 용도, 환경, 위치, 부서 등을 기준으로 네트워크를 그룹화할 수 있습니다. 라벨은 선택사항입니다.

네트워크 라벨 추가 또는 업데이트

기존 네트워크의 라벨을 추가하거나 업데이트할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 네트워크 페이지로 이동합니다.

라벨을 지정하려는 네트워크에서 을 클릭합니다.

라벨 수정을 클릭합니다.

라벨 편집기 페이지에서 다음을 수행합니다.

- 라벨 추가를 클릭하고 키-값 쌍을 추가합니다.

- 라벨을 업데이트하려면 기존 라벨을 선택하고 값을 수정합니다.

- 제출을 클릭합니다.

네트워크 페이지로 돌아와서 페이지를 새로고침하여 변경사항을 확인합니다.

gcloud

네트워크의 라벨을 추가하거나 업데이트하려면 --update-labels 옵션과 함께 gcloud bms networks update 명령어를 사용합니다.

다음 샘플 명령어는 environment = dev 및 location = branch 라벨을 추가합니다.

gcloud bms networks update NETWORK_NAME --project=PROJECT_ID --region=REGION --update-labels environment=dev,location=branch

이미 존재하는 라벨에 새 값을 제공하면 시스템에서 기존 라벨을 새 값으로 업데이트합니다. 새 라벨을 제공하면 시스템에서 라벨 목록에 새 라벨을 추가합니다.

API

네트워크의 라벨을 추가하거나 업데이트하려면 다음 curl 명령어에 프로젝트 ID, 리전, 네트워크 이름, 라벨 목록을 입력합니다. 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

다음 샘플 명령어는 environment = test의 라벨을 할당합니다.

curl -X PATCH \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "X-Goog-User-Project: PROJECT_ID" \

-H "Content-Type: application/json" \

"https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/networks/NETWORK_NAME?updateMask=labels"

-d "{

'labels' : {'environment': 'test'}

}"

네트워크에서 라벨 삭제

네트워크에서 라벨을 삭제할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 네트워크 페이지로 이동합니다.

라벨을 삭제할 네트워크의 경우 을 클릭합니다.

라벨 수정을 클릭합니다.

라벨 편집기 페이지에서 다음을 수행합니다.

- 라벨을 삭제하려면 을 클릭합니다.

- 제출을 클릭합니다.

네트워크 페이지로 돌아와서 페이지를 새로고침하여 변경사항을 확인합니다.

gcloud

네트워크에서 라벨을 삭제하려면 다음 옵션과 함께 gcloud bms networks update 명령어를 사용합니다.

--remove-labels: 지정된 라벨을 삭제합니다.--clear-labels: 모든 라벨을 삭제합니다.

다음 샘플 명령어는 네트워크에서 department 라벨을 삭제합니다.

gcloud bms networks update NETWORK_NAME --project=PROJECT_ID --region=REGION --remove-labels=department

다음 샘플 명령어는 네트워크에서 모든 라벨을 삭제합니다.

gcloud bms networks update NETWORK_NAME --project=PROJECT_ID --region=REGION --clear-labels

API

네트워크에서 라벨을 삭제하려면 다음 curl 명령어에 프로젝트 ID, 리전, 네트워크 이름을 입력합니다. 비어 있는 라벨 목록을 제공하여 모든 라벨을 삭제하거나 유지하려는 라벨 목록을 제공합니다(삭제하려는 라벨은 생략). 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

다음 샘플 명령어는 environment = test를 제외한 모든 라벨을 삭제합니다.

curl -X PATCH \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "X-Goog-User-Project: PROJECT_ID" \

-H "Content-Type: application/json" \

"https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/networks/NETWORK_NAME?updateMask=labels"

-d "{

'labels' : {'environment': 'test'}

}"

라벨을 사용하여 네트워크 필터링

라벨을 사용하여 네트워크를 검색하고 결과를 필터링할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 네트워크 페이지로 이동합니다.

네트워크 목록 위에 있는 필터 막대를 클릭합니다.

속성 목록에서 라벨을 선택합니다.

라벨의 키, 값 또는 키-값 쌍을 입력합니다.

예를 들어

env:dev라벨이 있는 네트워크만 보려면 다음 중 하나를 입력하면 됩니다.env키를 입력합니다.dev값을 입력합니다.env:dev키-값 쌍을 입력합니다.

라벨 필터를 적용하려면 필터 표시줄 외부의 아무 곳을 클릭합니다.

gcloud

라벨을 사용하여 네트워크를 필터링하려면 --filter 옵션과 함께 gcloud bms networks list 명령어를 사용합니다.

--filter 옵션의 값은 labels.KEY=VALUE 형식이어야 합니다. 예를 들어 env 키 및 dev 값으로 라벨을 필터링하려면 다음 명령어를 실행합니다.

gcloud bms networks list --project=PROJECT_ID --region=REGION --filter labels.environment=dev

gcloud CLI의 필터 구문에 대한 상세 설명은 gcloud topic filters 문서를 참조하세요.

API

라벨을 사용하여 네트워크를 필터링하려면 filter=labels 및 키-값 쌍 라벨과 함께 프로젝트 ID 및 리전을 입력합니다. 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

다음 샘플 명령어는 키-값 쌍 라벨이 environment = test인 네트워크를 찾도록 출력을 제한합니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/networks"?filter=labels.environment=test

네트워크 이름 변경

네트워크 이름을 바꾸려면 다음 단계를 따르세요.

콘솔

- Google Cloud 콘솔에서 Compute Engine > 베어메탈 솔루션 > 네트워크 페이지로 이동합니다.

- 네트워크 이름을 클릭합니다.

- 네트워크 세부정보 페이지의 이름 필드에서 이름 수정을 클릭합니다.

- 이름 수정 페이지에서 새 이름을 입력합니다.

- 저장을 클릭합니다.

- 변경사항을 확인하려면 페이지를 새로고침하세요.

gcloud

네트워크 이름을 바꾸려면 gcloud bms networks rename 명령어를 사용합니다.

gcloud bms networks rename NETWORK_NAME --new-name=NEW_NAME --project=PROJECT_ID --region=REGION

다음을 바꿉니다.

- NETWORK_NAME: 네트워크의 현재 이름입니다.

- NEW_NAME: 네트워크의 새 이름입니다.

- PROJECT_ID: 프로젝트 ID입니다.

- REGION: 네트워크의 위치입니다.

네트워크 만들기

네트워크를 만들기 전에 VRF를 만들어야 합니다. VRF 만들기를 참고하세요.

네트워크를 만들려면 여기에 다음 단계를 따르세요.

네트워크 페이지로 이동합니다.

만들기를 클릭합니다.

네트워크의 이름을 입력합니다.

위치 목록에서 네트워크의 리전을 선택합니다.

포드 목록에서 네트워크의 포드를 선택합니다.

포드 드롭다운 목록에는 선택한 위치의 각 포드에 있는 기존 베어메탈 솔루션 리소스 수도 표시됩니다.

어떤 포드를 선택해야 할지 잘 모르겠다면 Google Cloud 영업팀에 문의하세요.

네트워크 유형을 선택합니다.

- 클라이언트 네트워크를 만들려면 클라이언트를 선택합니다.

- 비공개 네트워크를 만들려면 비공개를 선택합니다.

(클라이언트 네트워크 유형을 선택한 경우에만 적용 가능) VRF 목록에서 VRF를 선택합니다.

네트워크 IP 주소 범위 필드에 네트워크의 IP 주소 범위를 입력합니다.

(선택사항) 서비스 IP 주소 범위 필드에 네트워크의 서비스 IP 주소 범위를 입력합니다.

네트워크의 MTU를 선택합니다.

- 1500—표준 크기 프레임의 경우

- 9000—점보 프레임의 경우

- 저장을 클릭합니다.

서버에 네트워크 연결

네트워크의 IP 주소 범위가 서버에 연결된 다른 네트워크와 겹치는 경우 서버에 네트워크를 연결할 수 없습니다.

네트워크를 연결하려면 다음 단계를 따르세요.

서버 페이지로 이동합니다.

서버 이름을 클릭합니다.

서버 세부정보 페이지에서 네트워크 연결을 클릭합니다.

네트워크 연결 페이지에서 다음을 수행합니다.

- 조직의 다른 프로젝트에서 네트워크를 선택하려면 다음 안내를 따르세요.

- 조직의 다른 프로젝트에서 네트워크 선택 체크박스를 선택합니다.

- 기존 네트워크 선택 목록에서 네트워크를 선택합니다.

현재 프로젝트에서 네트워크를 선택하려면 다음 안내를 따르세요.

- 조직의 다른 프로젝트에서 네트워크 선택 체크박스를 선택 해제합니다.

- 기존 네트워크 선택 목록에서 네트워크를 선택합니다.

인터페이스 구성을 설정합니다.

인터페이스 목록에서 이 네트워크의 결합 인터페이스를 선택합니다.

대부분의 경우 클라이언트 네트워크에는

bond0을, 비공개 네트워크에는bond1을 선택합니다.IP 주소 필드에 연결하려는 네트워크의 IP 주소를 입력합니다.

- 조직의 다른 프로젝트에서 네트워크를 선택하려면 다음 안내를 따르세요.

(선택사항) 이 네트워크를 기본 게이트웨이로 설정하려면 기본 게이트웨이 체크박스를 선택합니다.

네트워크 연결을 클릭합니다.

서버 상태가 '프로비저닝'으로 변경됩니다. 네트워크 연결은 장기 실행 작업입니다. 상태를 확인하려면 Google Cloud 콘솔에서 알림을 클릭합니다. 장기 실행 작업 상태 보기의 단계를 따를 수도 있습니다. 작업이 완료되면 서버 상태가 '실행 중'으로 변경됩니다.

베어메탈 솔루션 서버의 OS 구성을 업데이트합니다.

Google Cloud 콘솔을 통해 네트워크를 연결하기 위한 이전 단계를 완료하고 서버 상태가 '실행 중'으로 변경되면 베어메탈 솔루션 서버의 OS 구성을 업데이트해야 합니다. OS 구성을 업데이트하지 않으면Google Cloud 콘솔에서 변경한 사항이 완전히 구현되지 않습니다. 이 절차의 다음 단계에서는 OS 구성을 업데이트하는 방법을 보여줍니다.

다음 단계는 예시일 뿐이며 OS에 따라 다를 수 있습니다. 문제가 발생하면 OS 구성 가이드를 참조하세요.

RHEL, Oracle Linux

- 루트 사용자로 로그인합니다.

새 연결을 만듭니다. 다음 명령어를 실행합니다.

nmcli connection add type vlan con-name INTERFACE_NAME.VLAN_ID ifname INTERFACE_NAME.VLAN_ID dev INTERFACE_NAME mtu MTU id VLAN_ID ip4 IP_ADDRESS/NETMASK ipv6.method "ignore"

다음을 바꿉니다.

- INTERFACE_NAME: 네트워크를 연결할 인터페이스의 이름입니다. 이 인터페이스는 이 절차의 6단계(인터페이스 구성 설정)에서 선택한 인터페이스와 동일합니다. 서버 세부정보 페이지의 네트워크 섹션에서 인터페이스 이름을 가져올 수 있습니다. 서버 보기를 참조하세요.

- VLAN_ID: 연결할 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

- IP_ADDRESS: 네트워크에 있는 베어메탈 솔루션 서버의 IP 주소입니다. 이 절차의 6단계(인터페이스 구성 설정)에서 입력한 것과 동일한 IP 주소입니다. 서버 세부정보 페이지의 네트워크 섹션에서 IP 주소를 가져올 수 있습니다. 서버 보기를 참조하세요.

- NETMASK: 연결할 네트워크의 네트워크 마스크입니다. 네트워크 세부정보 페이지의 CIDR 필드에서 네트워크 마스크를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

- MTU: 연결하려는 네트워크의 MTU입니다. 네트워크 세부정보 페이지에서 MTU를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

예를 들면 다음과 같습니다.

nmcli connection add type vlan con-name bond0.114 ifname bond0.114 dev bond0 mtu 1500 id 114 ip4 172.16.80.1/24 ipv6.method "ignore"

(선택사항) 클라이언트 네트워크를 만들었고 이 네트워크를 사용하여 VPC에서 VLAN 연결 또는 다른 환경(예: 온프렘 환경)에 연결하려는 경우 특정 서브넷으로 연결되는 경로를 구성합니다. 루트 사용자로 다음 명령어를 실행합니다.

nmcli connection modify INTERFACE_NAME.VLAN_ID +ipv4.routes "SUBNET GATEWAY_IP"

nmcli connection up INTERFACE_NAME.VLAN_ID

다음을 바꿉니다.

- INTERFACE_NAME: 네트워크를 연결할 인터페이스의 이름입니다. 이 인터페이스는 이 절차의 6단계(인터페이스 구성 설정)에서 선택한 인터페이스와 동일합니다. 서버 세부정보 페이지의 네트워크 섹션에서 인터페이스 이름을 가져올 수 있습니다. 서버 보기를 참조하세요.

- VLAN_ID: 연결할 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

- SUBNET: 클라이언트 네트워크를 통해 베어메탈 솔루션 서버에 연결하는 데 사용되는 네트워크의 IP 주소와 마스크입니다(CIDR 표기법). VPC 네트워크인 경우 VPC 네트워크 페이지의 서브넷 섹션에서 서브넷을 가져올 수 있습니다. 서브넷 나열을 참고하세요. 다른 환경인 경우 네트워크 관리자에게 문의하세요.

- GATEWAY_IP: 연결하려는 네트워크의 게이트웨이 IP 주소입니다. 네트워크 세부정보 페이지에서 게이트웨이 IP를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

예를 들면 다음과 같습니다.

nmcli connection modify bond0.114 +ipv4.routes "192.168.122.0/24 172.16.80.254" nmcli connection up bond0.114

(선택사항) 클라이언트 네트워크를 만들고 이 절차의 7단계(기본 게이트웨이)에서 기본 게이트웨이로 설정한 경우 다음 단계를 수행하여 OS 구성을 업데이트합니다.

- 이전 단계(9.c단계)를 완료합니다.

- 새 클라이언트 네트워크를 통해 베어메탈 솔루션 서버에 연결되어 있는지 확인합니다. 예를 들어 VLAN 연결을 통해 이 네트워크가 연결된 VPC의 VM에서 서버에 연결합니다.

이 네트워크를 기본 게이트웨이로 설정하려면 이전 네트워크에서 기본 게이트웨이 설정을 사용 중지한 다음 이 네트워크에서 기본 게이트웨이 설정을 사용 설정하세요. 루트 사용자로 다음 명령어를 실행합니다.

nmcli connection modify OLD_INTERFACE_NAME.OLD_VLAN_ID ipv4.gateway ""

nmcli connection modify INTERFACE_NAME.VLAN_ID ipv4.gateway GATEWAY_IP

nmcli connection up INTERFACE_NAME.VLAN_ID

nmcli connection up OLD_INTERFACE_NAME.OLD_VLAN_ID

다음을 바꿉니다.

- OLD_INTERFACE_NAME: 이전 기본 게이트웨이 네트워크가 연결된 인터페이스의 이름입니다. 서버 세부정보 페이지의 네트워크 섹션에서 또는 베어메탈 솔루션 서버 OS 구성을 검사하여 인터페이스 이름을 가져올 수 있습니다. 즉,

ip a또는nmcli connection show명령어를 사용하는 것입니다. - OLD_VLAN_ID: 이전 기본 게이트웨이 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기 또는 베어메탈 솔루션 서버 OS 구성을 검사하여, 즉

ip a또는nmcli connection show commands를 사용하여 확인합니다. - INTERFACE_NAME: 새 네트워크가 연결된 인터페이스의 이름입니다. 이 인터페이스는 이 절차의 11단계(인터페이스 구성 설정)에서 선택한 인터페이스와 동일합니다. 서버 세부정보 페이지의 네트워크 섹션에서 인터페이스 이름을 가져올 수 있습니다. 서버 보기를 참조하세요.

- VLAN_ID: 새 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

- GATEWAY_IP: 새 네트워크에 있는 게이트웨이의 IP 주소입니다. 네트워크 세부정보 페이지에서 게이트웨이 IP를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

예를 들면 다음과 같습니다.

nmcli connection modify bond0.143 ipv4.gateway "" nmcli connection modify bond0.114 ipv4.gateway 172.16.80.254 nmcli connection up bond0.114 nmcli connection up bond0.143

- OLD_INTERFACE_NAME: 이전 기본 게이트웨이 네트워크가 연결된 인터페이스의 이름입니다. 서버 세부정보 페이지의 네트워크 섹션에서 또는 베어메탈 솔루션 서버 OS 구성을 검사하여 인터페이스 이름을 가져올 수 있습니다. 즉,

SLES

- 루트 사용자로 로그인합니다.

다음 이름 지정 규칙에 따라

/etc/sysconfig/network위치에 인터페이스 구성(ifcfg) 파일을 만듭니다.ifcfg-INTERFACE_NAME.VLAN_ID

다음을 바꿉니다.

- INTERFACE_NAME: 네트워크를 연결할 인터페이스의 이름입니다. 이 인터페이스는 이 절차의 6단계(인터페이스 구성 설정)에서 선택한 인터페이스와 동일합니다. 서버 세부정보 페이지의 네트워크 섹션에서 인터페이스 이름을 가져올 수 있습니다. 서버 보기를 참조하세요.

- VLAN_ID: 연결할 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

완료되면 파일 경로는 다음과 같이 표시됩니다.

/etc/sysconfig/network/ifcfg-INTERFACE_NAME.VLAN_ID

ifcfg파일의 네트워크 인터페이스에 대한 다음 정보를 추가합니다.NAME='INTERFACE_NAME.VLAN_ID' ETHERDEVICE='INTERFACE_NAME' STARTMODE='auto' USERCONTROL='no' BOOTPROTO='static' IPADDR='IP_ADDRESS/NETMASK' MTU=MTU VLAN='yes'

다음을 바꿉니다.

- INTERFACE_NAME: 네트워크를 연결할 인터페이스의 이름입니다. 이 인터페이스는 이 절차의 6단계(인터페이스 구성 설정)에서 선택한 인터페이스와 동일합니다. 서버 세부정보 페이지의 네트워크 섹션에서 인터페이스 이름을 가져올 수 있습니다. 서버 보기를 참조하세요.

- VLAN_ID: 연결할 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

- IP_ADDRESS: 네트워크에 있는 베어메탈 솔루션 서버의 IP 주소입니다. 이 절차의 6단계(인터페이스 구성 설정)에서 입력한 것과 동일한 IP 주소입니다. 네트워크 섹션의 서버 세부정보 페이지에서 IP 주소를 확인할 수 있습니다.

- NETMASK: 연결할 네트워크의 네트워크 마스크입니다. 네트워크 세부정보 페이지의 CIDR 필드에서 네트워크 마스크를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

- MTU: 연결하려는 네트워크의 MTU입니다. 네트워크 세부정보 페이지에서 MTU를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

예를 들어 샘플 파일

/etc/sysconfig/network/ifcfg-bond1.121은 다음과 같습니다.NAME='bond1.121' ETHERDEVICE='bond1' STARTMODE='auto' USERCONTROL='no' BOOTPROTO='static' IPADDR='192.168.200.10/24' MTU=1500 VLAN='yes'

(선택사항) 클라이언트 네트워크를 만들었고 이 네트워크를 사용하여 VPC에서 VLAN 연결 또는 다른 환경(예: 온프렘 환경)에 연결하려는 경우 특정 서브넷으로 연결되는 경로를 구성합니다.

다음 이름 지정 규칙에 따라

/etc/sysconfig/network위치에 인터페이스 경로 구성(ifroute) 파일을 만듭니다.ifroute-INTERFACE_NAME.VLAN_ID

완료되면 파일 경로는 다음과 같습니다.

/etc/sysconfig/network/ifroute-INTERFACE_NAME.VLAN_ID

ifroute파일의 네트워크 인터페이스에 대한 다음 정보를 추가합니다.SUBNET GATEWAY_IP - -

다음을 바꿉니다.

변경사항을 적용할 인터페이스를 표시합니다.

ifup INTERFACE_NAME.VLAN_ID

다음을 바꿉니다.

(선택사항) 클라이언트 네트워크를 만들고 이 절차의 7단계(기본 게이트웨이)에서 기본 게이트웨이로 설정한 경우 다음 단계를 수행하여 OS 구성을 업데이트합니다.

- 이전 단계(9.c단계)를 완료합니다.

- 이 네트워크를 통해 베어메탈 솔루션 서버에 연결되어 있는지 확인합니다. 예를 들어 이 네트워크가 VLAN 연결을 통해 연결된 VPC의 VM에서 서버에 연결합니다.

이 네트워크를 기본 게이트웨이로 설정하려면 시스템 기본 경로 구성을 변경합니다.

/etc/sysconfig/network/routes파일을 수정하여 현재 기본 게이트웨이의 IP 주소를 새 기본 게이트웨이의 IP 주소로 바꿉니다.다음과 일치하도록 파일 콘텐츠를 업데이트합니다.

default GATEWAY_IP - -

다음을 바꿉니다.

- GATEWAY_IP: 새 네트워크에 있는 게이트웨이의 IP 주소입니다. 네트워크 세부정보 페이지에서 게이트웨이 IP를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

네트워크 구성을 새로고침하여 변경사항을 적용합니다.

systemctl reload network

서버에서 네트워크 분리

한 번에 하나의 네트워크만 서버에서 분리할 수 있으며, 서버는 실행 중이거나 전원이 꺼질 수 있습니다.

네트워크를 분리하려면 다음 단계를 따르세요.

베어메탈 솔루션 서버의 OS 구성을 업데이트합니다.

Google Cloud 콘솔을 통해 네트워크를 분리하기 전에 먼저 베어메탈 솔루션 서버의 OS 구성을 업데이트해야 합니다. OS 구성을 업데이트하지 않으면 Google Cloud 콘솔에서 변경한 사항이 완전히 구현되지 않습니다.

이 단계의 작업은 예시일 뿐이며 OS에 따라 다를 수 있습니다. 문제가 발생하면 OS 구성 가이드를 참조하세요.

RHEL, Oracle Linux

분리할 네트워크의 본드 인터페이스를 삭제합니다. 루트 사용자 권한으로 다음 명령어를 실행합니다.

nmcli connection delete INTERFACE_NAME.VLAN_ID

다음을 바꿉니다.

- INTERFACE_NAME: 분리하려는 네트워크의 인터페이스 이름입니다. 서버 세부정보 페이지의 네트워크 섹션에서 인터페이스 이름을 가져올 수 있습니다. 서버 보기를 참조하세요.

- VLAN_ID: 분리할 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

예를 들면 다음과 같습니다.

nmcli connection delete bond0.148

SLES

인터페이스를 종료합니다. 루트 사용자 권한으로 다음 명령어를 실행합니다.

ifdown INTERFACE_NAME.VLAN_ID

다음을 바꿉니다.

- INTERFACE_NAME: 분리하려는 네트워크의 인터페이스 이름입니다. 서버 세부정보 페이지의 네트워크 섹션에서 인터페이스 이름을 가져올 수 있습니다. 서버 보기를 참조하세요.

- VLAN_ID: 분리할 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

예를 들면 다음과 같습니다.

ifdown bond1.121

다음 부팅 시 처리되지 않도록 인터페이스 구성 파일의 정보를 다른 파일에 백업합니다. 다음 명령어를 실행합니다.

mv /etc/sysconfig/network/ifcfg-INTERFACE_NAME.VLAN_ID /etc/sysconfig/network/ifcfg-INTERFACE_NAME.VLAN_ID.backup

다음을 바꿉니다.

- INTERFACE_NAME: 분리하려는 네트워크의 인터페이스 이름입니다. 서버 세부정보 페이지의 네트워크 섹션에서 인터페이스 이름을 가져올 수 있습니다. 서버 보기를 참조하세요.

- VLAN_ID: 분리할 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

예를 들면 다음과 같습니다.

mv /etc/sysconfig/network/ifcfg-bond1.121 /etc/sysconfig/network/ifcfg-bond1.121.backup

(선택사항) 클라이언트 네트워크를 분리하고 이 네트워크에 맞게 경로를 구성한 경우. 인터페이스 경로 구성 파일의 정보를 다른 파일에 백업하여 다음 부팅 시 처리되지 않도록 합니다. 다음 명령어를 실행합니다.

mv /etc/sysconfig/network/ifroute-INTERFACE_NAME.VLAN_ID /etc/sysconfig/network/ifroute-INTERFACE_NAME.VLAN_ID.backup

다음을 바꿉니다.

- INTERFACE_NAME: 분리하려는 네트워크의 인터페이스 이름입니다. 서버 세부정보 페이지의 네트워크 섹션에서 인터페이스 이름을 가져올 수 있습니다. 서버 보기를 참조하세요.

- VLAN_ID: 분리할 네트워크의 VLAN ID입니다. 네트워크 세부정보 페이지에서 VLAN ID를 가져올 수 있습니다. 네트워크 보기를 참조하세요.

예:

mv /etc/sysconfig/network/ifroute-bond1.121 /etc/sysconfig/network/ifroute-bond1.121.backup

Google Cloud 콘솔을 통해 네트워크를 분리합니다.

- Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

- 서버 이름을 클릭합니다.

- 서버 세부정보 페이지에서 분리할 네트워크를 선택합니다.

- 네트워크 분리를 클릭합니다.

- 메시지가 나타나면 확인을 클릭합니다.

서버 상태가 '프로비저닝'으로 변경됩니다. 네트워크 분리는 장기 실행 작업입니다. 상태를 확인하려면 Google Cloud 콘솔에서 알림을 클릭합니다. 장기 실행 작업 상태 보기의 단계를 따를 수도 있습니다. 작업이 완료되면 서버 상태가 '실행 중'으로 변경됩니다.

네트워크 삭제

동일한 VRF에 연결된 여러 클라이언트 네트워크는 삭제할 수 없습니다. 이러한 경우 고객 지원에 문의하세요.

네트워크를 삭제하려면 다음 단계를 따르세요.

콘솔

- Compute Engine > 베어메탈 솔루션 > 네트워크 페이지로 이동합니다.

- 삭제할 네트워크를 선택합니다.

- 삭제를 클릭합니다.

- 메시지가 나타나면 확인을 클릭합니다.

네트워크 삭제는 장기 실행 작업입니다. 상태를 확인하려면Google Cloud 콘솔에서 알림을 클릭합니다. 장기 실행 작업 상태 보기의 단계를 따를 수도 있습니다.

베어메탈 솔루션 환경의 고급 네트워킹 정보 보기

베어메탈 솔루션 환경에서 복잡한 배포를 위한 고급 네트워킹 옵션을 선택한 경우 다음 서버 명령어를 사용하여 이 정보를 확인할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

서버 이름을 클릭합니다.

서버 세부정보 페이지에서 다음 정보를 볼 수 있습니다.

- 기본 세부정보에서 네트워크 템플릿을 볼 수 있습니다.

- 네트워크 섹션에서 다음 정보를 볼 수 있습니다.

- 네트워크 이름

- 네트워크 유형

- IP 주소

- 기본 게이트웨이

- 인터페이스 이름

gcloud

gcloud bms instances describe 명령어를 실행하여 서버의 고급 네트워킹 설정을 확인합니다.

gcloud bms instances describe SERVER_NAME --project=PROJECT_ID --region=REGION

API

서버의 고급 네트워킹 설정을 보려면 프로젝트 ID, 리전, 서버 이름을 입력한 후 다음 curl 명령어를 실행하세요. 출력의 네트워크 섹션에서 각 인터페이스에 할당된 네트워크 템플릿, 논리 인터페이스, 결합 인터페이스, 네트워크 유형을 볼 수 있습니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/instances/SERVER_NAME"

베어메탈 솔루션 환경에서 IP 주소 관리 구현

베어메탈 솔루션 환경 내에서 네트워크 토폴로지를 관리할 수 있어야 합니다. IP 주소 관리는 리소스의 IP 주소를 생성, 확인 및 삭제하는 데 도움이 됩니다. 이 정보를 사용하여 IP 주소 중복을 방지하고 새 리소스를 요청할 때 충돌을 해결할 수 있습니다.

IP 주소 예약 보기

기존 예약의 IP 주소를 보려면 다음 안내를 따르세요.

gcloud

gcloud bms networks list-ip-reservations 명령어를 실행합니다.

gcloud bms networks list-ip-reservations --project=PROJECT_ID --region REGION

API

기존 리소스의 IP 주소 예약을 보려면 프로젝트 ID, 리전, 네트워크 이름을 입력한 후 다음 curl 명령어를 실행하세요. 출력의 reservations 섹션에는 예약된 IP 주소 범위가 표시됩니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/networks/NETWORK_NAME"

IP 주소 예약 만들기 및 업데이트

새 IP 주소 예약을 만들거나 기존 IP 주소를 업데이트하려면 다음 안내를 따르세요.

gcloud

gcloud bms networks update 명령어를 실행하여 IP 주소 예약을 관리합니다.

gcloud bms networks update NETWORK_NAME --project=PROJECT_ID --region REGION --add-ip-range-reservation=start-address=START_ADDRESS,end-address=END_ADDRESS,note="NOTE"

- 모든 IP 주소 예약을 삭제하려면 --clear-ip-range-reservations 옵션을 추가합니다.

- 예약된 주소 블록 중 하나를 삭제하려면 --remove-ip-range-reservation 옵션을 추가하고 삭제하려는 예약된 IP 주소 블록의 시작 주소와 종료 주소를 지정합니다.

gcloud bms networks update NETWORK_NAME --project=PROJECT_ID --region REGION --remove-ip-range-reservation=start-address=START_ADDRESS,end-address=END_ADDRESS

API

새 IP 주소 예약을 만들거나 기존 IP 주소 예약을 업데이트하려면 다음 명령어에 프로젝트 ID, 리전, 네트워크 이름을 입력합니다. 예약하려는 각 IP 주소 블록에 대해 시작 주소, 종료 주소, 메모를 추가한 후 curl 명령어를 실행합니다.

curl -X PATCH \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "X-Goog-User-Project: PROJECT_ID" \

-H "Content-Type: application/json" \

"https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/networks/NETWORK_NAME?updateMask=reservations"

-d "{

'reservations' : [

{

'startAddress' : 'START_ADDRESS_1',

'endAddress' : 'END_ADDRESS_1',

'note' : 'NOTES_1'

},

{

'startAddress' : 'START_ADDRESS_2',

'endAddress' : 'END_ADDRESS_2',

'note' : 'NOTES_2'

}

]

}"

- IP 주소 예약 블록은 대상 네트워크의 CIDR 범위 내에 있어야 합니다.

- 예약 블록에 .1(게이트웨이 IP 주소)을 사용하지 마세요.

- 이

curl명령어를 실행할 때마다 이전 예약 세트를 덮어씁니다. 업데이트해야 하는 경우 명령어를 실행하기 전에 모든 예약 블록 세트를 포함해야 합니다. 모든 예약을 삭제하려면 명령어의 끝을 다음으로 바꿉니다.

-d "{ 'reservations' : [] }"

저장용량 관리

다음 방법으로 베어메탈 솔루션 환경에서 스토리지를 관리할 수 있습니다.

- 스토리지 볼륨 보기

- 라벨을 사용하여 스토리지 볼륨 정리

- 스토리지 볼륨 이름 변경

- 스토리지 볼륨 리소스 프로비저닝

- 스토리지 볼륨 리소스 삭제

- 부팅 볼륨 스냅샷 및 세부정보 보기

- 부팅 볼륨 스냅샷 만들기

- 부팅 볼륨 스냅샷 삭제

- 부팅 볼륨 스냅샷 복원

스토리지 볼륨 보기

베어메탈 솔루션 환경의 스토리지 리소스에 주의하면 서버에 애플리케이션과 워크로드를 위한 충분한 스토리지 용량이 있는지 확인하는 데 도움이 됩니다.

스토리지 볼륨의 세부정보를 보려면 다음 단계를 따르세요.

콘솔

볼륨 페이지로 이동합니다.

볼륨 페이지에는 다음과 같은 세부정보와 함께 모든 스토리지 볼륨이 나열됩니다.

필드 설명 예시 상태 스토리지 볼륨의 가용성을 나타냅니다. 체크표시가 있는 녹색 원은 스토리지 볼륨이 준비되었음을 나타냅니다. ID 스토리지 볼륨에 할당된 식별자입니다.

- LUN 및 스냅샷을 포함하여 스토리지 볼륨에 대한 기본 정보를 보려면 ID를 클릭하세요.

- 이 리소스의 문제를 해결할 때 Google Cloud 지원팀에 ID를 공유하세요.

- 부팅 볼륨:

at-1234567-svr001-vol000-b1 - Fibre 채널 볼륨:

at-1111111-vol001 - NFS 공유:

at-2222222-nfs001-vol000

이름 스토리지 볼륨 이름입니다. LUN 및 스냅샷을 포함하여 스토리지 볼륨에 대한 추가 정보를 보려면 이름을 클릭합니다.

참고: 스토리지 볼륨을 프로비저닝할 때 이름을 입력하지 않으면 이 필드에 ID가 표시됩니다.- 부팅 볼륨:

boot-volume-1 - Fibre 채널 볼륨:

fibre-channel-volume-5 - NFS 공유:

nfs-share-7

위치 스토리지 볼륨이 위치한 리전 asia-southeast1포드 스토리지 볼륨이 포함된 포드. 포드는 베어메탈 솔루션 리소스가 포함된 격리 단위입니다. 다른 포드의 리소스는 연결할 수 없습니다. 한 리전에 여러 포드가 있을 수 있습니다.

포드 열은 기본적으로 사용 중지되어 있습니다. 이를 사용 설정하려면 다음을 수행하세요.

- 열 표시 옵션을 클릭합니다.

- 포드 체크박스를 선택합니다.

- 확인을 클릭합니다.

포드 열을 사용 설정하지 않으려면 스토리지 볼륨 이름을 클릭하여 스토리지 볼륨의 포드를 볼 수 있습니다.

asia-southeast1-pod1유형 하드 드라이브 또는 솔리드 스테이트 드라이브 HDD - Hard drive라벨 이 스토리지 리소스에 추가한 라벨이 표시됩니다.

라벨의 텍스트를 복사하여 상태 필드 바로 위에 있는 필터 상자에 붙여넣으면 라벨을 사용하여 콘솔 출력을 필터링할 수 있습니다.environment:test

gcloud

베어메탈 솔루션 환경의 모든 스토리지 볼륨을 보고 해당 상태를 확인하려면 프로젝트 ID를 입력하고

gcloud bms volumes list명령어를 실행합니다.gcloud bms volumes list --project=PROJECT_ID

NAME PROJECT REGION REQUESTED_SIZE_GIB STORAGE_TYPE STATE at-1234567-svr001-vol000-b1 PROJECT_ID REGION 200 SSD READY at-1111111-vol001 PROJECT_ID REGION 1024 SSD READY at-2222222-nfs001-vol000 PROJECT_ID REGION 400 HDD READY

단일 스토리지 볼륨을 보려면 스토리지 볼륨 이름, 프로젝트 ID, 리전을 입력하고

gcloud bms volumes describe명령어를 실행합니다.gcloud bms volumes describe VOLUME_NAME --project=PROJECT_ID --region=REGION

currentSizeGib: '250' name: projects/PROJECT_ID/locations/REGION/volumes/VOLUME_NAME requestedSizeGib: '250' snapshotAutoDeleteBehavior: OLDEST_FIRST snapshotReservationDetail: reservedSpaceGib: '50' reservedSpaceRemainingGib: '50' state: READY storageType: SSD

스토리지 볼륨의 모든 LUN을 보려면 프로젝트 ID, 리전, 스토리지 볼륨 이름을 입력하고

gcloud bms volumes luns list명령어를 실행합니다.gcloud bms volumes luns list --project=PROJECT_ID --region=REGION --volume=VOLUME_NAME

NAME REGION VOLUME SIZE_GB STATE at-11111111-vol001-lun000 REGION VOLUME_NAME 200 READY

단일 LUN의 세부정보를 보려면 프로젝트 ID, 리전, LUN 이름을 입력하고

gcloud bms volumes luns describe명령어를 실행합니다.gcloud bms volumes luns describe LUN_NAME --project=PROJECT_ID --region=REGION --volume=VOLUME_NAME

bootLun: true name: projects/PROJECT_ID/locations/REGION/volumes/VOLUME_NAME/luns/LUN_NAME sizeGb: '200' state: READY storageType: SSD storageVolume: VOLUME_NAME wwid: 600a09803831434434244f774d616b94

API

Google Cloud 콘솔에서 Cloud Shell 터미널 창을 엽니다.

베어메탈 솔루션 환경의 모든 스토리지 볼륨과 그 상태를 확인하려면

curlcurl 명령어에 프로젝트 ID와 리전을 입력하고 해당 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣은 후 Enter 또는 Return 키를 누릅니다.curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/volumes"

단일 스토리지 볼륨을 보려면 프로젝트 ID, 리전, 스토리지 볼륨 이름을 입력하고 다음 명령어를 실행합니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/volumes/VOLUME_NAME"

스토리지 볼륨의 모든 논리 단위 번호(LUN)를 보려면 프로젝트 ID, 리전, 스토리지 볼륨 이름을 입력한 후 다음 명령어를 실행합니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/volumes/VOLUME_NAME/luns

단일 LUN의 세부정보를 보려면 프로젝트 ID, 리전, 스토리지 볼륨 이름, LUN 이름을 입력하고 다음 명령어를 실행합니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/volumes/VOLUME_NAME/luns/LUN_NAME"

라벨을 사용하여 스토리지 볼륨 정리

라벨을 사용하여 스토리지 볼륨을 정리할 수 있습니다. 라벨은 각 스토리지 볼륨에 연결할 수 있는 키-값 쌍으로, 해당 라벨을 기준으로 스토리지 볼륨을 필터링할 수 있습니다. 예를 들어 라벨을 사용하여 용도, 환경, 위치, 부서 등을 기준으로 스토리지 볼륨을 그룹화할 수 있습니다. 라벨은 선택사항입니다.

스토리지 볼륨 라벨 추가 또는 업데이트

기존 스토리지 볼륨의 라벨을 추가하거나 업데이트할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 볼륨 페이지로 이동합니다.

라벨을 지정할 스토리지 볼륨에서 을 클릭합니다.

라벨 수정을 클릭합니다.

라벨 편집기 페이지에서 다음을 수행합니다.

- 라벨 추가를 클릭하고 키-값 쌍을 추가합니다.

- 라벨을 업데이트하려면 기존 라벨을 선택하고 값을 수정합니다.

- 제출을 클릭합니다.

볼륨 페이지로 돌아와서 페이지를 새로고침하여 변경사항을 확인합니다.

gcloud

스토리지 볼륨의 라벨을 추가하거나 업데이트하려면 --update-labels 옵션과 함께 gcloud bms volumes update 명령어를 사용합니다.

다음 샘플 명령어는 environment = dev 및 location = branch 라벨을 추가합니다.

gcloud bms volumes update VOLUME_NAME --project=PROJECT_ID --region=REGION --update-labels environment=dev,location=branch

이미 존재하는 라벨에 새 값을 제공하면 시스템에서 기존 라벨을 새 값으로 업데이트합니다. 새 라벨을 제공하면 시스템에서 라벨 목록에 새 라벨을 추가합니다.

API

스토리지 볼륨의 라벨을 추가하거나 업데이트하려면 다음 curl 명령어에 프로젝트 ID, 리전, 볼륨 이름, 라벨 목록을 입력합니다. 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

다음 샘플 명령어는 environment = test의 라벨을 할당합니다.

curl -X PATCH \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "X-Goog-User-Project: PROJECT_ID" \

-H "Content-Type: application/json" \

"https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/volumes/VOLUME_NAME?updateMask=labels"

-d "{

'labels' : {'environment': 'test'}

}"

스토리지 볼륨에서 라벨 삭제

스토리지 볼륨에서 라벨을 삭제할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 볼륨 페이지로 이동합니다.

라벨을 삭제할 스토리지 볼륨의 경우 을 클릭합니다.

라벨 수정을 클릭합니다.

라벨 편집기 페이지에서 다음을 수행합니다.

- 라벨을 삭제하려면 을 클릭합니다.

- 제출을 클릭합니다.

볼륨 페이지로 돌아와서 페이지를 새로고침하여 변경사항을 확인합니다.

gcloud

스토리지 볼륨에서 라벨을 제거하려면 gcloud bms volumes update 옵션과 함께 다음 명령어를 사용합니다.

--remove-labels: 지정된 라벨을 삭제합니다.--clear-labels: 모든 라벨을 삭제합니다.

다음 샘플 명령어는 스토리지 볼륨에서 department 라벨을 삭제합니다.

gcloud bms volumes update VOLUME_NAME --project=PROJECT_ID --region=REGION --remove-labels=department

다음 샘플 명령어는 스토리지 볼륨에서 모든 라벨을 삭제합니다.

gcloud bms volumes update VOLUME_NAME --project=PROJECT_ID --region=REGION --clear-labels

API

스토리지 볼륨에서 라벨을 삭제하려면 다음 curl 명령어에 프로젝트 ID, 리전, 스토리지 볼륨 이름을 입력합니다. 비어 있는 라벨 목록을 제공하여 모든 라벨을 삭제하거나 유지하려는 라벨 목록을 제공합니다(삭제하려는 라벨은 생략). 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

다음 샘플 명령어는 environment = test를 제외한 모든 라벨을 삭제합니다.

curl -X PATCH \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "X-Goog-User-Project: PROJECT_ID" \

-H "Content-Type: application/json" \

"https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/volumes/VOLUME_NAME?updateMask=labels"

-d "{

'labels' : {'environment': 'test'}

}"

라벨을 사용하여 스토리지 볼륨 필터링

라벨을 사용하여 스토리지 볼륨을 검색하고 결과를 필터링할 수 있습니다.

콘솔

Compute Engine > 베어메탈 솔루션 > 볼륨 페이지로 이동합니다.

스토리지 볼륨 목록 위에 있는 필터 표시줄을 클릭합니다.

속성 목록에서 라벨을 선택합니다.

라벨의 키, 값 또는 키-값 쌍을 입력합니다.

예를 들어

env:dev라벨이 있는 스토리지 볼륨만 보려면 다음 중 하나를 입력하면 됩니다.env키를 입력합니다.dev값을 입력합니다.env:dev키-값 쌍을 입력합니다.

라벨 필터를 적용하려면 필터 표시줄 외부의 아무 곳을 클릭합니다.

gcloud

라벨을 사용하여 스토리지 볼륨을 필터링하려면 --filter 옵션과 함께 gcloud bms volumes list 명령어를 사용합니다.

--filter 옵션의 값은 labels.KEY=VALUE 형식이어야 합니다. 예를 들어 env 키 및 dev 값으로 라벨을 필터링하려면 다음 명령어를 실행합니다.

gcloud bms volumes list --project=PROJECT_ID --region=REGION --filter labels.environment=dev

gcloud CLI의 필터 구문에 대한 상세 설명은 gcloud topic filters 문서를 참조하세요.

API

라벨을 사용하여 스토리지 볼륨을 필터링하려면 filter=labels 및 키-값 쌍 라벨과 함께 프로젝트 ID 및 리전을 입력합니다. 명령어를 복사하여 Cloud Shell 프롬프트에 붙여넣고 Enter 또는 Return 키를 누릅니다.

다음 샘플 명령어는 키-값 쌍 라벨이 environment = test인 스토리지 볼륨을 찾도록 출력을 제한합니다.

curl -X GET \ -H "Authorization: Bearer $(gcloud auth print-access-token)" \ -H "X-Goog-User-Project: PROJECT_ID" \ -H "Content-Type: application/json" \ "https://baremetalsolution.googleapis.com/v2/projects/PROJECT_ID/locations/REGION/volumes"?filter=labels.environment=test

스토리지 볼륨 이름 변경

스토리지 볼륨 이름을 바꾸려면 다음 단계를 따르세요.

콘솔

- Google Cloud 콘솔에서 Compute Engine > 베어메탈 솔루션 > 볼륨 페이지로 이동합니다.

- 스토리지 볼륨 이름을 클릭합니다.

- 볼륨 세부정보 페이지의 이름 필드에서 이름 수정을 클릭합니다.

- 이름 수정 페이지에서 새 이름을 입력합니다.

- 저장을 클릭합니다.

- 변경사항을 확인하려면 페이지를 새로고침하세요.

gcloud

스토리지 볼륨의 이름을 바꾸려면 gcloud bms volumes rename 명령어를 사용합니다.

gcloud bms volumes rename VOLUME_NAME --new-name=NEW_NAME --project=PROJECT_ID --region=REGION

다음을 바꿉니다.

- VOLUME_NAME: 스토리지 볼륨의 현재 이름입니다.

- NEW_NAME: 스토리지 볼륨의 새 이름입니다.

- PROJECT_ID: 프로젝트 ID입니다.

- REGION: 스토리지 볼륨의 위치입니다.

베어메탈 솔루션 환경의 스토리지 볼륨 리소스 프로비저닝

베어메탈 솔루션 환경의 스토리지 리소스를 주문한 후 리소스를 사용할 수 있게 되면 리소스를 프로비저닝할 수 있습니다. 다음과 같은 셀프 서비스 옵션을 프로비저닝할 수 있습니다.

- 새로운 Fibre Channel 스토리지 볼륨 만들기

- 볼륨에 LUN 만들기

- 서버에 스토리지 볼륨 연결

새 스토리지 볼륨 만들기

이 기능을 사용하면 이전에 주문한 스토리지를 프로비저닝할 수 있습니다. 스토리지 볼륨을 주문하려면 Google Cloud 영업팀에 문의하세요.

새 스토리지 볼륨을 만들려면 다음 단계를 따르세요.

Google Cloud 콘솔에서 Compute Engine > 베어메탈 솔루션 > 볼륨 메뉴로 이동합니다.

만들기를 클릭합니다.

다음 정보를 입력합니다.

필드 설명 예 리전 Google Cloud 베어메탈 솔루션 환경에 가장 가까운 리전입니다. us-central1이름 스토리지 볼륨의 이름을 만듭니다. volume-1유형 스토리지 유형을 선택합니다. - SSD – 솔리드 스테이트 드라이브

- HDD – 하드 드라이브

SSD성능 등급 SSD 스토리지 유형을 선택한 경우 SSD 드라이브의 성능 등급을 선택합니다. - 표준 – 표준 SSD 드라이브를 만들려면 선택합니다.

- 성능 – 성능 SSD 드라이브를 만들려면 선택합니다.

Performance크기 드라이브 크기(GiB)를 선택합니다. 1024GiB는 1TiB입니다. 크기는 최소 100GiB부터 최대 16TiB까지입니다. 16TiB보다 더 필요하면 그에 맞게 추가 볼륨을 만듭니다.

성능 SSD 드라이브의 경우 최대 크기는 볼륨당 8TiB입니다.16384스냅샷 사용 설정됨 스토리지 볼륨의 백업 복사본을 하루 한 번 저장합니다. 커스텀 스냅샷에 필요하며, 기본적으로 사용 중지됩니다. 스냅샷 사용 설정을 위해 체크박스 선택 구성 필요한 LUN 구성 유형을 선택합니다. - 기본 구성 – 동일한 크기의 LUN을 만듭니다(권장).

- 커스텀 구성 – 크기가 다른 LUN을 만듭니다.

Default configuration대상 서버 서버를 선택하고 스토리지 볼륨을 연결합니다. server-1만들기를 클릭합니다.

콘솔은 요청된 스토리지 볼륨에 사용 가능한 공간이 충분한지 확인합니다. 콘솔은 사용 가능한 공간이 있는 경우 변경사항을 구현하거나 작업을 수행할 수 없는 경우 알림을 제공합니다. 스토리지 볼륨 요청이 성공하면 추가 스토리지 청구가 자동으로 시작됩니다.

스토리지 볼륨을 프로비저닝한 후 추가 서버와 공유할 수 있습니다.

스토리지 볼륨에 LUN 만들기

스토리지 볼륨에 LUN을 만들려면 다음 단계를 따르세요.

Google Cloud 콘솔에서 Compute Engine > 베어메탈 솔루션 > 볼륨 메뉴로 이동합니다.

LUN을 만들 스토리지 볼륨의 이름을 클릭합니다.

LUN 섹션 옆에 있는 만들기를 클릭합니다.

다음 정보를 입력합니다.

필드 설명 예 LUN 수 특정 크기로 만들려는 총 LUN 수입니다. 4크기 LUN 크기(GiB)를 선택합니다. 1024GiB는 1TiB입니다. 1024LUN을 두 세트 이상 만들어야 하는 경우 항목 추가를 클릭합니다.

만들기를 클릭하여 새 LUN을 배포합니다.

서버에 스토리지 볼륨 연결

한 번에 여러 스토리지 볼륨을 서버에 연결할 수 있습니다.

서버에 스토리지 볼륨을 연결하려면 다음 단계를 따르세요.

Google Cloud 콘솔에서 Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

스토리지 볼륨을 연결할 서버의 이름을 클릭합니다.

LUN 섹션에서 볼륨 연결을 클릭합니다.

대상 볼륨 목록에서 연결하려는 스토리지 볼륨을 선택합니다. 또한 여러 스토리지 볼륨을 선택할 수 있습니다.

볼륨 연결을 클릭합니다.

동일한 스토리지 볼륨을 다른 서버에 동시에 연결할 수도 있습니다. 서버 페이지로 이동하여 다른 모든 서버에 대해 이 절차를 반복합니다.

스토리지 볼륨 리소스 삭제

특정 스토리지 볼륨 리소스가 더 이상 필요하지 않으면 삭제할 수 있습니다. 전체 스토리지 볼륨을 삭제할 수도 있고 해당 LUN을 삭제할 수도 있습니다. 하지만 먼저 연결된 서버에서 스토리지 볼륨을 분리해야 합니다.

이 섹션에서는 다음 작업을 설명합니다.

서버에서 스토리지 볼륨 분리

스토리지 볼륨을 서버에서 분리할 수 있습니다. 개별 LUN은 서버에서 분리할 수 없습니다. 한 번에 여러 스토리지 볼륨을 분리할 수 있습니다.

서버에서 스토리지 볼륨을 분리하려면 다음 단계를 따르세요.

베어메탈 솔루션 서버의 OS 구성을 업데이트합니다.

Google Cloud 콘솔을 통해 스토리지 볼륨을 분리하기 전에 베어메탈 솔루션 서버의 OS 구성을 업데이트해야 합니다. OS 구성을 업데이트하지 않으면Google Cloud 콘솔에서 수행된 변경사항이 완전히 구현되지 않고, 데이터가 손상될 수 있으며, 다음 재부팅 시 서버에 문제가 발생할 수 있습니다.

이 단계에서는 OS 구성을 업데이트하는 방법의 예시를 보여줍니다. 안내 내용은 OS에 따라 달라질 수 있습니다. 문제가 발생하면 OS 구성 가이드를 참조하세요.

논리적 볼륨 관리자(LVM)

RHEL7.x, RHEL 8.x, Oracle Linux 7.x, Oracle Linux 8.x, SLES 12 SP4, SLES 12 SP5, SLES 15, SLES 15 SP1에 대해 LVM을 통해 스토리지 볼륨을 분리합니다.

다음 예시 절차에서는 LVM을 통해 파일 시스템(

/testvol02)과 연관된 논리적 볼륨, 기본 LUN을 분리하는 방법을 보여줍니다.다음 단계를 따르세요.

파일 시스템

/testvol02와 연결된 LVM 볼륨 및 기본 LUN을 식별합니다.df -h|grep testvol02

샘플 출력:

/dev/mapper/testvg01-lv02 99G 33M 99G 1% /testvol02

출력에 파일 시스템

/testvol02가/dev/mapper/testvg01-lv02기기와 연결된 것으로 표시됩니다.testvg01-lv02기기의 WWID를 확인합니다.sudo dmsetup ls --tree

샘플 출력:

testvg01-lv02 (253:10) └─3600a0980383146354a2b522d53374236 (253:6) ├─ (8:176) ├─ (8:112) ├─ (8:240) └─ (8:48) testvg01-lv01 (253:9) └─3600a0980383146354a2b522d53374235 (253:5) ├─ (8:160) ├─ (8:96) ├─ (8:224) └─ (8:32)출력에

testvg01-lv02기기의 WWID가3600a0980383146354a2b522d53374236인 것으로 표시됩니다.파일 시스템

/testvol02에 대해 기본 LUN의 논리적 볼륨, 물리적 볼륨, WWID를 확인합니다.sudo vgdisplay -v

샘플 출력:

--- Volume group --- VG Name testvg01 System ID Format lvm2 Metadata Areas 2 Metadata Sequence No 4 VG Access read/write VG Status resizable MAX LV 0 Cur LV 2 Open LV 2 Max PV 0 Cur PV 2 Act PV 2 VG Size 199.99 GiB PE Size 4.00 MiB Total PE 51198 Alloc PE / Size 50688 / 198.00 GiB Free PE / Size 510 / 1.99 GiB VG UUID W42Rle-9sER-jpS1-dwBC-xbtn-1D2b-FNRDMA --- Logical volume --- LV Path /dev/testvg01/lv01 LV Name lv01 VG Name testvg01 LV UUID W8bzQQ-Qtyf-CDJA-AXPt-P1b1-X4xL-2WDq92 LV Write Access read/write LV Creation host, time at-5176205-svr001, 2022-12-06 22:14:56 +0000 LV Status available # open 1 LV Size 99.00 GiB Current LE 25344 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 8192 Block device 253:9 --- Logical volume --- LV Path /dev/testvg01/lv02 LV Name lv02 VG Name testvg01 LV UUID B1vtMm-RAKx-3S92-mHfx-98xc-gKwR-XWOavH LV Write Access read/write LV Creation host, time at-5176205-svr001, 2022-12-07 17:02:53 +0000 LV Status available # open 1 LV Size 99.00 GiB Current LE 25344 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 8192 Block device 253:10 --- Physical volumes --- PV Name /dev/mapper/3600a0980383146354a2b522d53374235 PV UUID ieY2Cr-HNrg-dj2G-wHgP-lsuh-PTAH-hNemRq PV Status allocatable Total PE / Free PE 25599 / 255 PV Name /dev/mapper/3600a0980383146354a2b522d53374236 PV UUID AMrtZa-TZHO-w0h6-Uf1G-NCwa-UtFY-83rZen PV Status allocatable Total PE / Free PE 25599 / 255출력이 보여주는 것은 다음과 같습니다.

- 파일 시스템

/testvol02가 볼륨 그룹testvg01에서 논리적 볼륨(LV)lv02를 사용 중입니다. - 사용 중인 물리적 볼륨(PV)은

/dev/mapper/3600a0980383146354a2b522d53374236입니다. - 기본 LUN의 WWID는

3600a0980383146354a2b522d53374236입니다.

- 파일 시스템

파일 시스템

/testvol02를 마운트 해제합니다.sudo umount /testvol02

필요한 경우 관련 줄을 주석 처리하거나 삭제하여

/etc/fstab파일에서 파일 시스템/testvol02에 대한 해당 항목을 찾아서 삭제합니다.grep testvol02 /etc/fstab

샘플 출력:

/dev/mapper/testvg01-lv02 /testvol02 xfs defaults 0 0

논리적 볼륨

lv02를 비활성화합니다.sudo lvchange -an /dev/testvg01/lv02

볼륨 그룹

testvg01에서 논리적 볼륨lv02를 삭제합니다.sudo lvremove /dev/testvg01/lv02

샘플 출력:

Logical volume "lv02" successfully removed

볼륨 그룹

testvg01에서 물리적 볼륨/dev/mapper/3600a0980383146354a2b522d53374236을 삭제합니다.- 선택사항: 논리적 볼륨과 물리적 볼륨을 삭제한 후

vgdisplay -v및dmsetup ls -tree명령어를 사용해서 기기가 LVM에서 더 이상 사용 중이 아닌지 확인합니다. 기기가 더 이상 사용 중이 아니면vgdisplay명령어 결과의 "물리적 볼륨" 섹션에 표시되지 않으며,dmsetup명령어 결과에서 볼륨과 연결된 것으로 표시되지 않습니다.

sudo vgreduce testvg01 /dev/mapper/3600a0980383146354a2b522d53374236

샘플 출력:

Removed "/dev/mapper/3600a0980383146354a2b522d53374236" from volume group "testvg01"

로컬 파일 시스템

RHEL7.x, RHEL 8.x, Oracle Linux 7.x, Oracle Linux 8.x에 대해 로컬 파일 시스템을 통해 스토리지 볼륨을 분리합니다.

다음 예시 절차에서는 파일 시스템(

/localfs01) 및 기본 LUN을 삭제하는 방법을 보여줍니다.다음 단계를 따르세요.

파일 시스템

/localfs01과 연결된 기본 LUN을 식별합니다.df -h|grep localfs01

샘플 출력:

/dev/mapper/3600a0980383146354a2b522d53374236 100G 33M 100G 1% /localfs01

df명령어 출력에 파일 시스템/localfs01이/dev/mapper/3600a0980383146354a2b522d53374236기기와 연결된 것으로 표시됩니다.파일 시스템

/localfs01을 마운트 해제합니다.sudo umount /localfs01

필요한 경우 관련 줄을 주석 처리하거나 삭제하여

/etc/fstab파일에서 파일 시스템/localfs01에 대한 해당 항목을 찾아서 삭제합니다.grep localfs01 /etc/fstab

샘플 출력:

grep localfs01 /etc/fstab /dev/mapper/3600a0980383146354a2b522d53374236 /localfs01 xfs defaults 0 0

Oracle ASM

RHEL7.x, RHEL 8.x, Oracle Linux 7.x, Oracle Linux 8.x에 대해 Oracle ASM을 통해 스토리지 볼륨을 분리합니다.

다음 예시 절차에서는 Oracle ASM에서 디스크(

DEMO_0001) 및 연결된 LUN을 삭제하는 방법을 보여줍니다.다음 단계를 따르세요.

Oracle ASM에서 삭제하려는 디스크를 식별합니다.

sqlplus / as sysasm set lines 999; col diskgroup for a15 col diskname for a15 col path for a35 select a.name DiskGroup,b.name DiskName, b.total_mb, (b.total_mb-b.free_mb) Used_MB, b.free_mb,b.path,b.header_status from v$asm_disk b, v$asm_diskgroup a where a.group_number (+) =b.group_number order by b.group_number,b.name; DISKGROUP DISKNAME TOTAL_MB USED_MB FREE_MB PATH HEADER_STATU --------------- --------------- ---------- ---------- ---------- ----------------------------------- ------------ DATA DATA_0000 25600 5676 19924 /dev/asmdisks/DATA1 MEMBER DEMO DEMO_0000 25600 16 25584 /dev/asmdisks/DEMO1 MEMBER DEMO DEMO_0001 102400 51 102349 /dev/asmdisks/DEMO2 MEMBER RECO RECO_0000 25600 3896 21704 /dev/asmdisks/RECO1 MEMBER

샘플 출력:

DISKGROUP DISKNAME TOTAL_MB USED_MB FREE_MB PATH HEADER_STATU --------------- --------------- ---------- ---------- ---------- ----------------------------------- ------------ DATA DATA_0000 25600 5676 19924 /dev/asmdisks/DATA1 MEMBER DEMO DEMO_0000 25600 16 25584 /dev/asmdisks/DEMO1 MEMBER DEMO DEMO_0001 102400 51 102349 /dev/asmdisks/DEMO2 MEMBER RECO RECO_0000 25600 3896 21704 /dev/asmdisks/RECO1 MEMBER

쿼리 출력에

DEMO_0001디스크와 연결된 기기가/dev/asmdisks/DEMO2로 표시됩니다.디스크 및 WWID와 연결된 다중 경로 기기를 확인합니다.

ls -l /dev/asmdisks/DEMO2 lrwxrwxrwx 1 root root 8 Dec 29 17:52 /dev/asmdisks/DEMO2 -> ../dm-18

sudo multipath -ll|grep dm-18 3600a0980383146354a2b522d53374247 dm-18 NETAPP ,LUN C-Mode

디스크 그룹에서 디스크를 삭제합니다.

SQL> alter diskgroup DEMO drop disk DEMO_0001 rebalance power 5; Diskgroup altered. col diskgroup for a15 col diskname for a15 col path for a35 select a.name DiskGroup,b.name DiskName, b.total_mb, (b.total_mb-b.free_mb) Used_MB, b.free_mb,b.path,b.header_status from v$asm_disk b, v$asm_diskgroup a where a.group_number (+) =b.group_number order by b.group_number,b.name; DISKGROUP DISKNAME TOTAL_MB USED_MB FREE_MB PATH HEADER_STATU --------------- --------------- ---------- ---------- ---------- ----------------------------------- ------------ 0 0 0 /dev/asmdisks/DEMO2 FORMER DATA DATA_0000 25600 5676 19924 /dev/asmdisks/DATA1 MEMBER DEMO DEMO_0000 25600 64 25536 /dev/asmdisks/DEMO1 MEMBER RECO RECO_0000 25600 3896 21704 /dev/asmdisks/RECO1 MEMBER SQL> exit(클러스터의 모든 노드에서 이 단계를 수행하세요.)

/etc/udev/rules.d/99-oracle-asmdevices.rules파일에서 디스크에 대한 모든 참조를 삭제합니다.이 예시에서는 9번 줄과 10번 줄이 이 절차의 Step 1.b에서 식별된

DEMO_0001디스크 및3600a0980383146354a2b522d53374247의 WWID와 연결되었기 때문에 이를 삭제합니다.cat -n /etc/udev/rules.d/99-oracle-asmdevices.rules 1 # BEGIN ASM disk udev rules for /dev/mapper/3600a0980383146354a2b522d53374244 2 ACTION=="add|change", ENV{DM_UUID}=="mpath-3600a0980383146354a2b522d53374244", SYMLINK+="asmdisks/DATA1", GROUP="asmadmin", OWNER="grid", MODE="0660" 3 # END ASM disk udev rules for /dev/mapper/3600a0980383146354a2b522d53374244 4 # BEGIN ASM disk udev rules for /dev/mapper/3600a0980383146354a2b522d53374243 5 ACTION=="add|change", ENV{DM_UUID}=="mpath-3600a0980383146354a2b522d53374243", SYMLINK+="asmdisks/RECO1", GROUP="asmadmin", OWNER="grid", MODE="0660" 6 # END ASM disk udev rules for /dev/mapper/3600a0980383146354a2b522d53374243 7 # BEGIN ASM disk udev rules for /dev/mapper/3600a0980383146354a2b522d53374242 8 ACTION=="add|change", ENV{DM_UUID}=="mpath-3600a0980383146354a2b522d53374242", SYMLINK+="asmdisks/DEMO1", GROUP="asmadmin", OWNER="grid", MODE="0660" 9 # BEGIN ASM disk udev rules for /dev/mapper/3600a0980383146354a2b522d53374247 10 ACTION=="add|change", ENV{DM_UUID}=="mpath-3600a0980383146354a2b522d53374247", SYMLINK+="asmdisks/DEMO2", GROUP="asmadmin", OWNER="grid", MODE="0660" 11 # END ASM disk udev rules for /dev/mapper/3600a0980383146354a2b522d53374247(클러스터의 모든 노드에서 이 단계를 수행하세요.)

udev규칙 집합 변경사항을 적용합니다.sudo udevadm control -R

Oracle Linux Virtualization Manager

Oracle Linux Virtualization Manager 4.4.10.7을 통해 스토리지 볼륨을 분리합니다.

Oracle Linux Virtualization Manager 스토리지 도메인에서 개별 Fibre 채널 기기 삭제는 지원되지 않습니다. 기본 LUN을 삭제할 수 있으려면 먼저 스토리지 도메인을 삭제해야 합니다.

다음 예시 절차에서는 WWID가

3600a0980383146354a2b522d53374244및3600a0980383146354a2b522d53374245이고 Oracle Linux Virtualization Manager 스토리지 도메인olvm-domain-02의 일부인 LUN을 삭제하는 방법을 보여줍니다.- Oracle Linux Virtualization Manager에서 스토리지 > 도메인으로 이동합니다.

- 스토리지 도메인

olvm-domain-02를 선택합니다. - 도메인 관리를 클릭합니다.

- 삭제하려는 Fibre 채널 LUN의 WWID를 기록해 둡니다.

여기에서 WWID는

3600a0980383146354a2b522d53374244및3600a0980383146354a2b522d53374245입니다. - 도메인 관리 창을 닫습니다.

- 다음과 같이 스토리지 도메인을 유지보수 모드로 설정합니다.

- 스토리지 도메인을 클릭합니다.

- 데이터 센터 탭을 선택합니다.

- 유지보수를 클릭한 후 확인을 클릭합니다.

이 단계에 대한 자세한 내용은 Oracle 문서: 환경에서 스토리지 도메인을 안전하게 삭제하는 방법을 참조하세요.

- 분리를 클릭한 후 확인을 클릭합니다.

- 스토리지 도메인을 삭제합니다.

- 스토리지 > 도메인으로 돌아갑니다.

- 스토리지 도메인을 선택합니다.

- 삭제를 클릭한 후 확인을 클릭합니다.

Oracle VM Server

Oracle VM Server 출시 버전 3.4.6을 통해 스토리지 볼륨을 분리합니다.

다음 예시 절차에서는 WWID가

3600a0980383146354a2b522d53374236인 LUN을 삭제하는 방법을 보여줍니다.다음 단계를 따르세요.

- Oracle VM Manager에서 연결된 물리적 디스크를 삭제합니다. Oracle 문서: 물리적 디스크 삭제를 참조하세요.

이 예시에서 WWID가

3600a0980383146354a2b522d53374236인 물리적 디스크의 OVM 콘솔 이름은NETAPP (10)입니다. - 서버 및 VM에서 물리적 디스크를 선택합니다.

- 물리적 디스크 삭제를 클릭한 후 확인을 클릭합니다.

Google Cloud 콘솔에서 Compute Engine > 베어메탈 솔루션 > 서버 페이지로 이동합니다.

분리할 스토리지 볼륨이 있는 서버의 이름을 클릭합니다.

LUN 섹션에서 볼륨 분리를 클릭합니다.

대상 볼륨 목록에서 분리하려는 스토리지 볼륨을 선택합니다. 또한 여러 스토리지 볼륨을 선택할 수 있습니다.

선택사항: 기본적으로 스토리지 볼륨을 분리하면 서버가 재부팅됩니다. 서버를 재부팅하지 않으려면 서버 재부팅 건너뛰기 체크박스를 선택합니다.

볼륨 분리를 클릭합니다.

6단계에서 서버 재부팅 건너뛰기 옵션을 선택하지 않은 경우 서버가 재부팅되고 스토리지 볼륨과 해당 LUN이 분리됩니다.

(6단계에서 재부팅을 건너뛴 경우 이 단계를 수행합니다.) Google Cloud 콘솔을 통해 스토리지 볼륨을 분리한 후 해당 OS에서 SCSI 재스캔 및 기기 삭제를 수행합니다.

안내 내용은 OS에 따라 달라질 수 있습니다. 문제가 발생하면 OS 구성 가이드를 참조하세요.

논리적 볼륨 관리자(LVM)

이 예시는 RHEL7.x, RHEL 8.x, Oracle Linux 7.x, Oracle Linux 8.x, SLES 12 SP4, SLES 12 SP5, SLES 15, SLES 15 SP1에 적용할 수 있습니다.

LUN과 연결된 경로를 삭제합니다.

다음은 베어메탈 솔루션 환경의 예시입니다.

sudo /bin/rescan-scsi-bus.sh -r Syncing file systems Scanning SCSI subsystem for new devices and remove devices that have disappeared Scanning host 0 for SCSI target IDs 0 1 2 3 4 5 6 7, all LUNs Scanning host 1 for SCSI target IDs 0 1 2 3 4 5 6 7, all LUNs Scanning host 2 for SCSI target IDs 0 1 2 3 4 5 6 7, all LUNs ... Scanning host 17 for all SCSI target IDs, all LUNs 0 new or changed device(s) found. 0 remapped or resized device(s) found. 4 device(s) removed. [14:0:2:1] [14:0:3:1] [16:0:0:1] [16:0:1:1]다중 경로 맵을 새로고침합니다.

sudo /sbin/multipath -r

로컬 파일 시스템

이 예시는 RHEL7.x, RHEL 8.x, Oracle Linux 7.x, Oracle Linux 8.x에 적용할 수 있습니다.

LUN과 연결된 경로를 삭제합니다.

다음은 베어메탈 솔루션 환경의 예시입니다.

sudo /bin/rescan-scsi-bus.sh -r Syncing file systems Scanning SCSI subsystem for new devices and remove devices that have disappeared Scanning host 0 for SCSI target IDs 0 1 2 3 4 5 6 7, all LUNs Scanning host 1 for SCSI target IDs 0 1 2 3 4 5 6 7, all LUNs Scanning host 2 for SCSI target IDs 0 1 2 3 4 5 6 7, all LUNs ... Scanning host 17 for all SCSI target IDs, all LUNs 0 new or changed device(s) found. 0 remapped or resized device(s) found. 4 device(s) removed. [14:0:2:1] [14:0:3:1] [16:0:0:1] [16:0:1:1]다중 경로 맵을 새로고침합니다.

sudo /sbin/multipath -r

Oracle ASM

이 예시는 RHEL7.x, RHEL 8.x, Oracle Linux 7.x, Oracle Linux 8.x에 적용할 수 있습니다.

클러스터의 모든 노드에서 이 단계를 수행하세요.

LUN과 연결된 경로를 삭제합니다.

다음은 베어메탈 솔루션 환경의 예시입니다.