Vertex AI Platform の

Gemini モデルで強化されたエンタープライズ対応 AI でイノベーションを加速

Vertex AI は、生成 AI を構築して使用するためのフルマネージド統合 AI 開発プラットフォームです。Vertex AI Studio、Agent Builder、200 以上の基盤モデルにアクセスして活用できます。

新規のお客様には、Vertex AI やその他の Google Cloud プロダクトをお試しいただける無料クレジット最大 $300 分を差し上げます。

機能

Google の高性能マルチモーダル モデル、Gemini

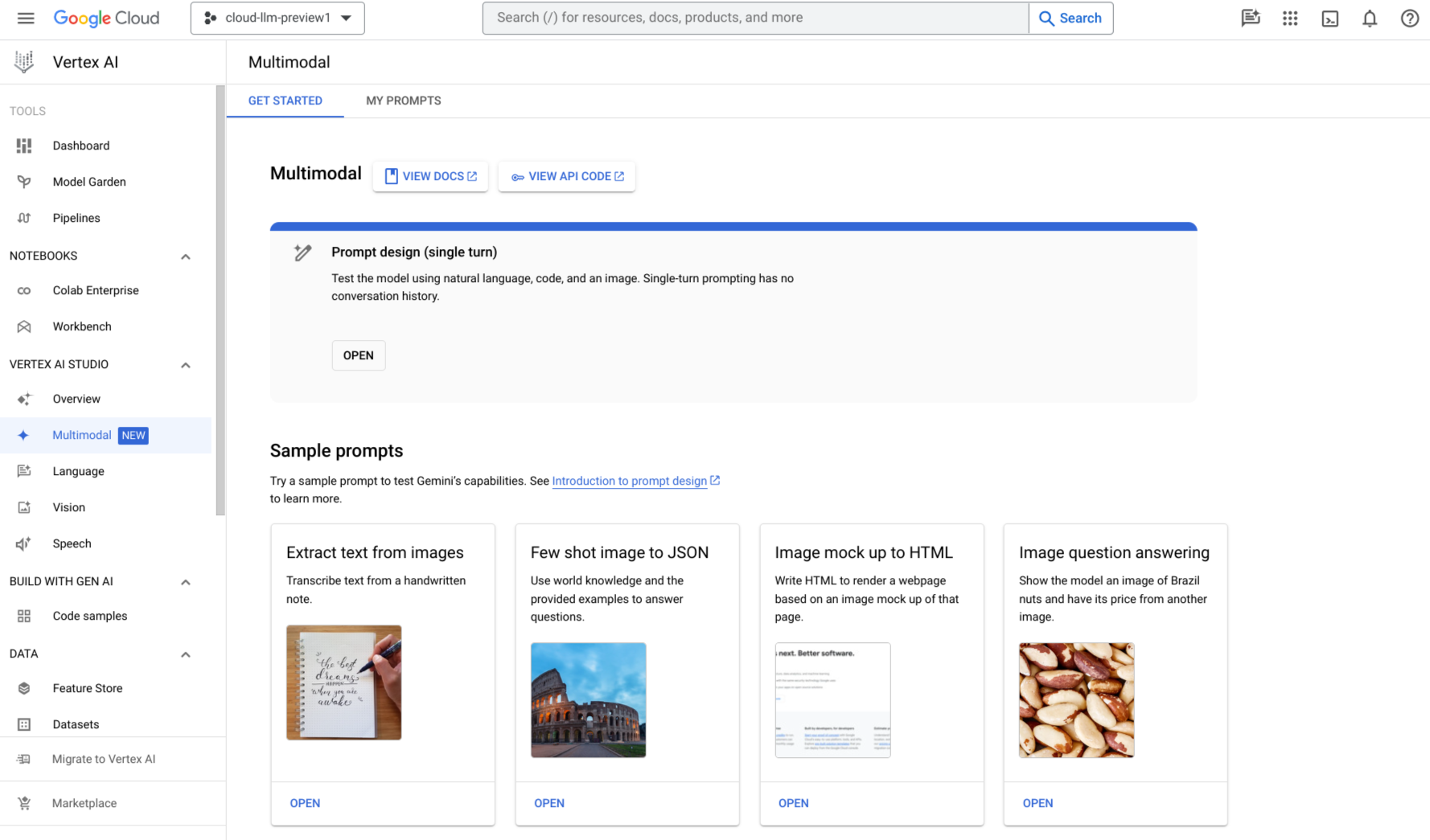

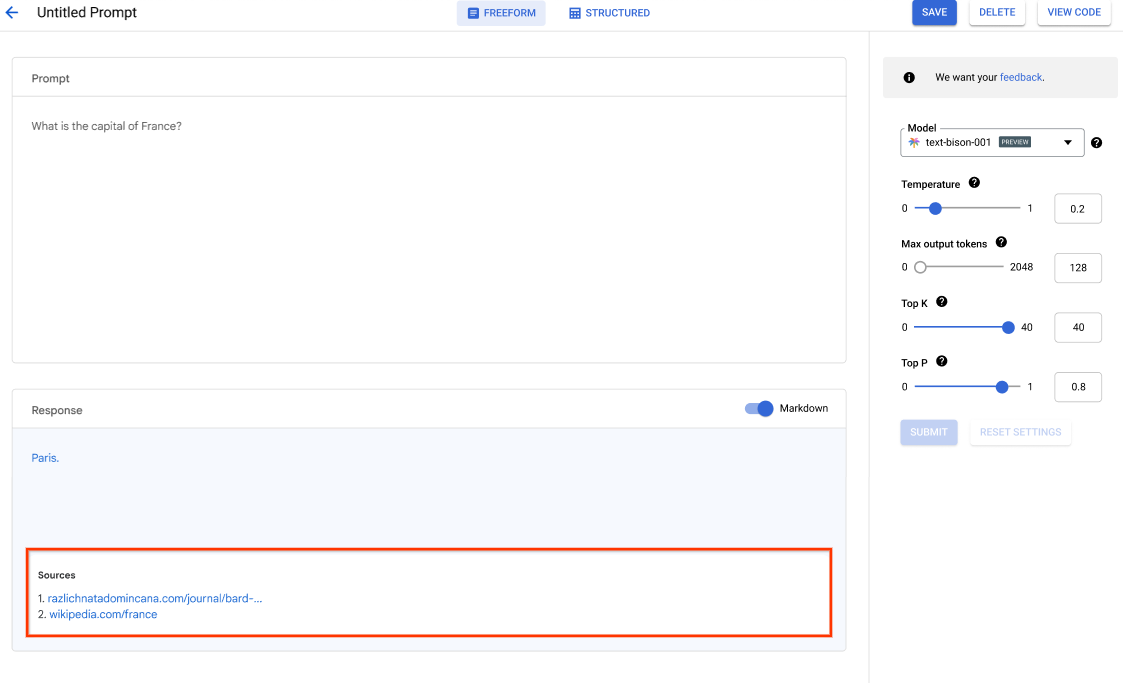

Vertex AI では、Gemini 3 を含む Google の最新の Gemini モデルを利用できます。Gemini は、実質的にあらゆる入力を理解し、さまざまな種類の情報を組み合わせ、ほぼすべての出力を生成できます。Vertex AI Studio では、テキスト、画像、動画、コードを使用したプロンプトを Gemini に入力してテストを行えます。Gemini の高度な推論機能と最先端の生成機能を使用して、画像からのテキスト抽出、画像テキストの JSON への変換、アップロードされた画像に関する回答の生成のためのサンプル プロンプトを試して、次世代の AI アプリケーションを構築できます。

200 以上の生成 AI モデルと各種ツール

Model Garden では、Google 製(Gemini、Imagen、Chirp、Veo)、サードパーティ製(Anthropic の Claude Model Family)、オープンモデル(Gemma、Llama 3.2)と、幅広いモデルからお選びいただけます。拡張機能を使用すると、モデルがリアルタイムの情報を取得してアクションをトリガーできるようになります。また、さまざまなチューニング オプションを使用して、ユースケースに合わせてモデルをカスタマイズすることもできます。

Gen AI Evaluation Service は、生成 AI モデルの客観的でデータドリブンな評価を行うためのエンタープライズ グレードのツールを提供します。

オープンで統合された AI プラットフォーム

Vertex AI Platform のツールを使用して ML モデルをトレーニング、調整、デプロイすることで、データ サイエンティストは迅速に作業できます。

Vertex AI Notebooks(Colab Enterprise または Workbench を選択可能)は、BigQuery とネイティブに統合されており、すべてのデータおよび AI のワークロードに 1 つのサーフェスを提供します。

Vertex AI Training と Vertex AI Prediction では、選択したオープンソース フレームワークと最適化された AI インフラストラクチャを使用して、トレーニング時間を短縮し、モデルを本番環境に簡単にデプロイできます。

予測 AI と生成 AI のための MLOps

Vertex AI Platform には、データ サイエンティストや ML エンジニアが ML プロジェクトを自動化、標準化、管理するための目的に特化した MLOps ツールが用意されています。

モジュール型ツールにより、開発ライフサイクル全体を通じてチーム間の共同作業を行い、モデルを改善できます。具体的には、Vertex AI Evaluation でユースケースに最適なモデルを特定したり、Vertex AI Pipelines でワークフローをオーケストレートしたり、Model Registry であらゆるモデルを管理したり、Feature Store で ML の特徴をサービング、共有、再利用したり、入力のスキューとドリフトをモニタリングしたりできます。

エンタープライズ エージェントの構築、スケーリング、管理

Vertex AI Agent Builder は、企業がエンタープライズ データに基づいてエンタープライズ グレードのエージェントを迅速に構築、スケーリング、管理できる、オープンで包括的なプラットフォームです。アプリケーションとワークフローをグローバル規模で強力かつ信頼性の高いエージェント システムに変換するために必要な、フルスタックの基盤と幅広い開発者の選択肢を提供します。

仕組み

Vertex AI には、モデルのトレーニングとデプロイのオプションが複数用意されています。

- 生成 AI では、Gemini 3 などの大規模生成 AI モデルにアクセスし、モデルを評価、調整、デプロイして、AI を活用したアプリケーションに使用できます。

- Model Garden を使用すると、Vertex AI と厳選されたオープンソース(OSS)モデルとアセットで調査、テスト、カスタマイズ、デプロイできます。

- カスタム トレーニングでは、任意の ML フレームワークの使用、独自のトレーニング コードの記述、ハイパーパラメータ チューニング オプションの選択など、トレーニング プロセスを完全に制御できます。

Vertex AI には、モデルのトレーニングとデプロイのオプションが複数用意されています。

- 生成 AI では、Gemini 3 などの大規模生成 AI モデルにアクセスし、モデルを評価、調整、デプロイして、AI を活用したアプリケーションに使用できます。

- Model Garden を使用すると、Vertex AI と厳選されたオープンソース(OSS)モデルとアセットで調査、テスト、カスタマイズ、デプロイできます。

- カスタム トレーニングでは、任意の ML フレームワークの使用、独自のトレーニング コードの記述、ハイパーパラメータ チューニング オプションの選択など、トレーニング プロセスを完全に制御できます。

一般的な使用例

Gemini モデルで構築

Google のマルチモーダル モデルを使ってみる

Google のマルチモーダル モデルを使ってみる

Vertex AI Studio を使用して、自然言語、コード、画像、動画を使用して Gemini モデルのプロンプトを設計、テスト、管理します。画像からテキストを抽出したり、画像モックアップを HTML にしたり、アップロードされた画像や動画に関する回答を生成したりするサンプル プロンプトをお試しください。

API キーを使用して、Vertex AI 上の Gemini のテストを開始することもできます。

Google Cloud Vertex AI で Gemini API を使用して Gemini モデルにアクセス

- Python

- JavaScript

- Java

- Go

- Curl

チュートリアル、クイックスタート、ラボ

Google のマルチモーダル モデルを使ってみる

Google のマルチモーダル モデルを使ってみる

Vertex AI Studio を使用して、自然言語、コード、画像、動画を使用して Gemini モデルのプロンプトを設計、テスト、管理します。画像からテキストを抽出したり、画像モックアップを HTML にしたり、アップロードされた画像や動画に関する回答を生成したりするサンプル プロンプトをお試しください。

API キーを使用して、Vertex AI 上の Gemini のテストを開始することもできます。

コードサンプル

Google Cloud Vertex AI で Gemini API を使用して Gemini モデルにアクセス

- Python

- JavaScript

- Java

- Go

- Curl

AI Agents とアプリケーション

Vertex AI で高度な AI 機能を活用する

Vertex AI で高度な AI 機能を活用する

お客様の成長に合わせてスケーリングするプラットフォームで、プロダクション レディな生成 AI エージェントとアプリケーションを構築できます。Google の AI 開発プラットフォームである Vertex AI は、AI モデルやアプリケーションを開発、デプロイするための安全な環境を提供します。

デベロッパー向けには、Vertex AI が高度なプラットフォームとして引き続き提供されます。ここでは、Agent Development Kit(ADK)などのフレームワークを使用して、高度なエージェントを構築、カスタマイズ、ファインチューニングできます。

こちらの Codelab を使用して、今すぐ最初の AI アプリケーションを構築しましょう

チュートリアル、クイックスタート、ラボ

Vertex AI で高度な AI 機能を活用する

Vertex AI で高度な AI 機能を活用する

お客様の成長に合わせてスケーリングするプラットフォームで、プロダクション レディな生成 AI エージェントとアプリケーションを構築できます。Google の AI 開発プラットフォームである Vertex AI は、AI モデルやアプリケーションを開発、デプロイするための安全な環境を提供します。

デベロッパー向けには、Vertex AI が高度なプラットフォームとして引き続き提供されます。ここでは、Agent Development Kit(ADK)などのフレームワークを使用して、高度なエージェントを構築、カスタマイズ、ファインチューニングできます。

こちらの Codelab を使用して、今すぐ最初の AI アプリケーションを構築しましょう

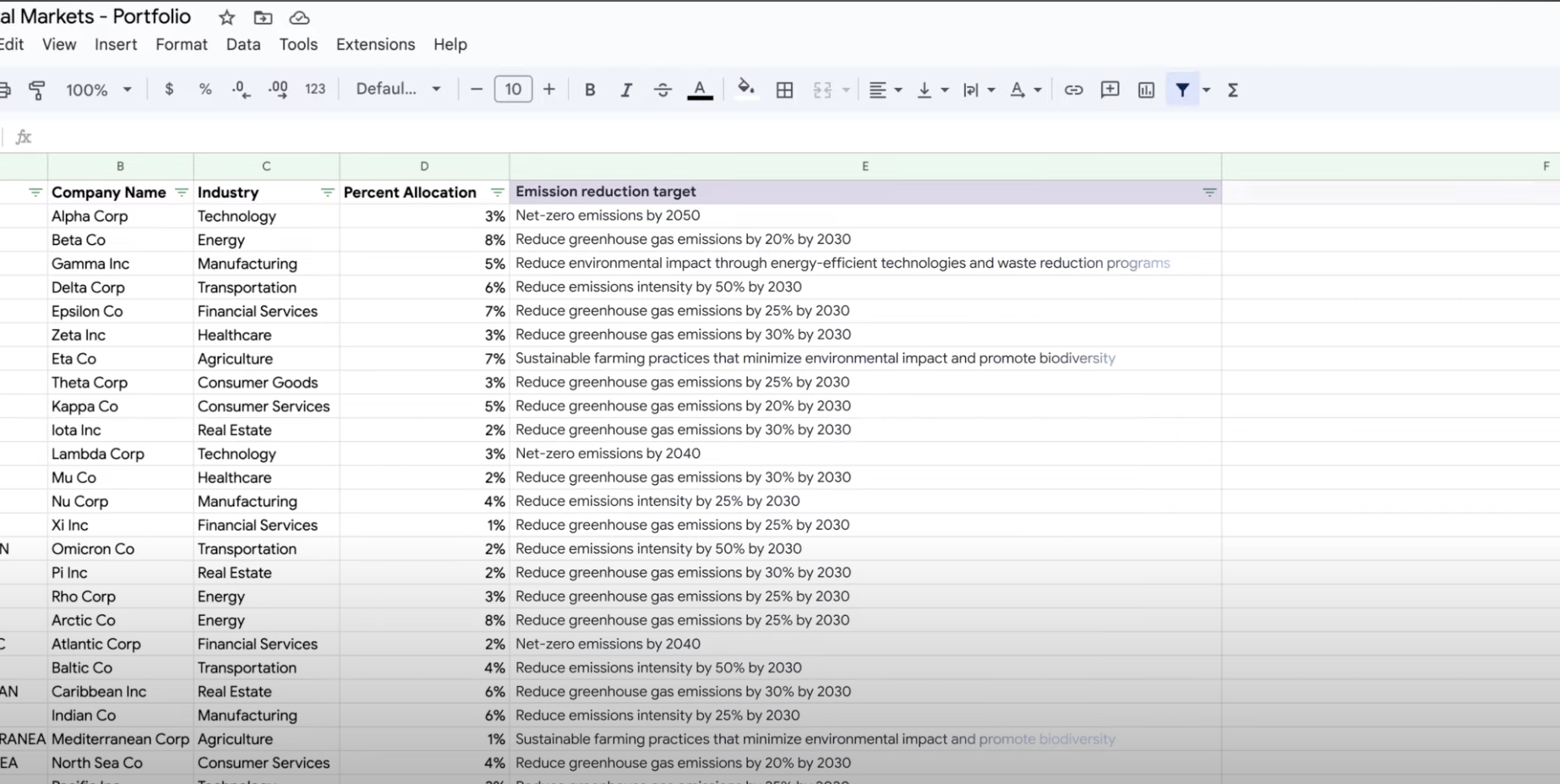

データを抽出、要約、分類する

生成 AI を要約、分類、抽出に使用する

生成 AI を要約、分類、抽出に使用する

Vertex AI の生成 AI のサポートを利用して、任意の数のタスクを処理するためのテキスト プロンプトを作成する方法を学びます。最も一般的なタスクには、分類、要約、抽出があります。 Gemini on Vertex AI を使用すると、プロンプトの構造と形式を柔軟に設計できます。

チュートリアル、クイックスタート、ラボ

生成 AI を要約、分類、抽出に使用する

生成 AI を要約、分類、抽出に使用する

Vertex AI の生成 AI のサポートを利用して、任意の数のタスクを処理するためのテキスト プロンプトを作成する方法を学びます。最も一般的なタスクには、分類、要約、抽出があります。 Gemini on Vertex AI を使用すると、プロンプトの構造と形式を柔軟に設計できます。

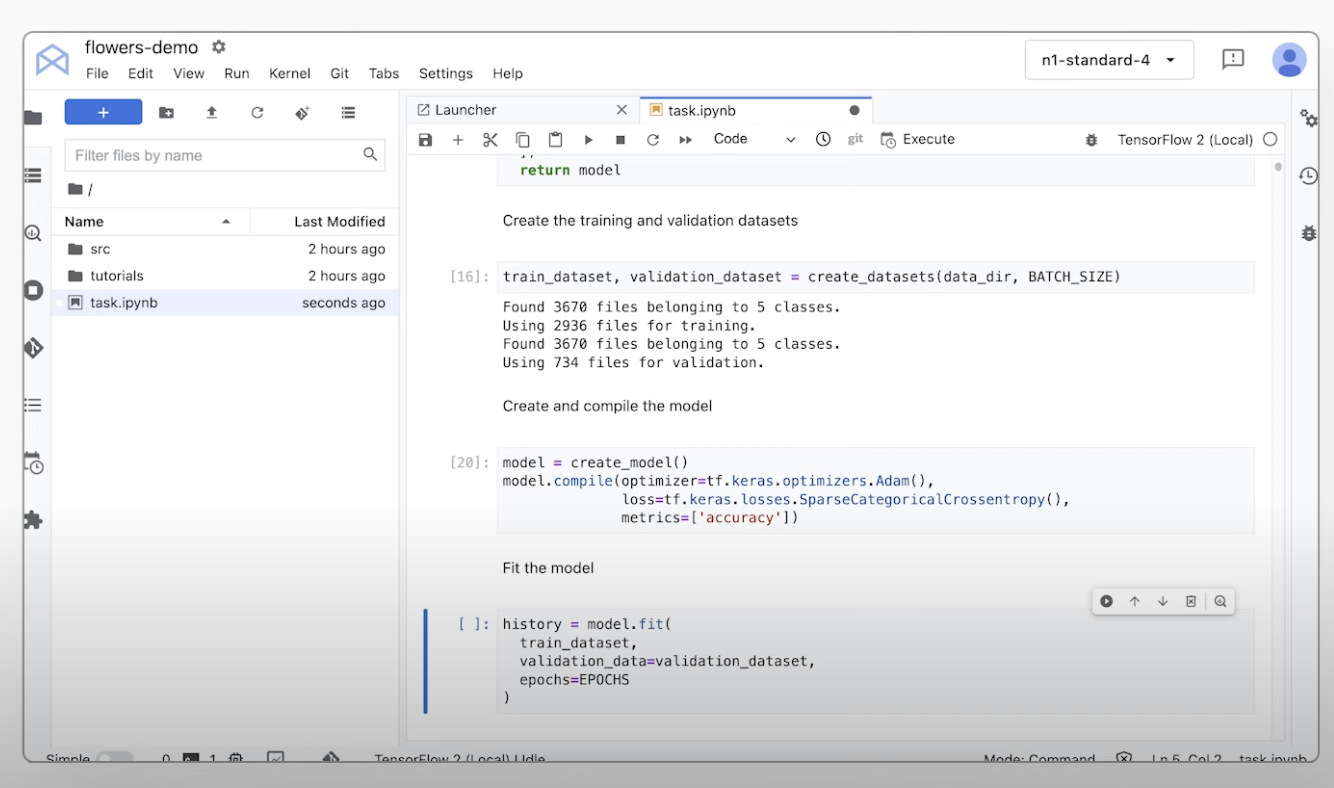

カスタム ML モデルをトレーニングする

カスタム ML のトレーニングの概要とドキュメント

カスタム ML のトレーニングの概要とドキュメント

Vertex AI のカスタム トレーニング ワークフローの概要、カスタム トレーニングのメリット、利用可能なさまざまなトレーニング オプションについて説明します。このページでは、データの準備から予測まで、ML トレーニング ワークフローに関連するすべてのステップについて詳しく説明します。

Vertex AI でカスタムモデルをトレーニングするために必要な手順に関するチュートリアル動画を確認する。

チュートリアル、クイックスタート、ラボ

カスタム ML のトレーニングの概要とドキュメント

カスタム ML のトレーニングの概要とドキュメント

Vertex AI のカスタム トレーニング ワークフローの概要、カスタム トレーニングのメリット、利用可能なさまざまなトレーニング オプションについて説明します。このページでは、データの準備から予測まで、ML トレーニング ワークフローに関連するすべてのステップについて詳しく説明します。

Vertex AI でカスタムモデルをトレーニングするために必要な手順に関するチュートリアル動画を確認する。

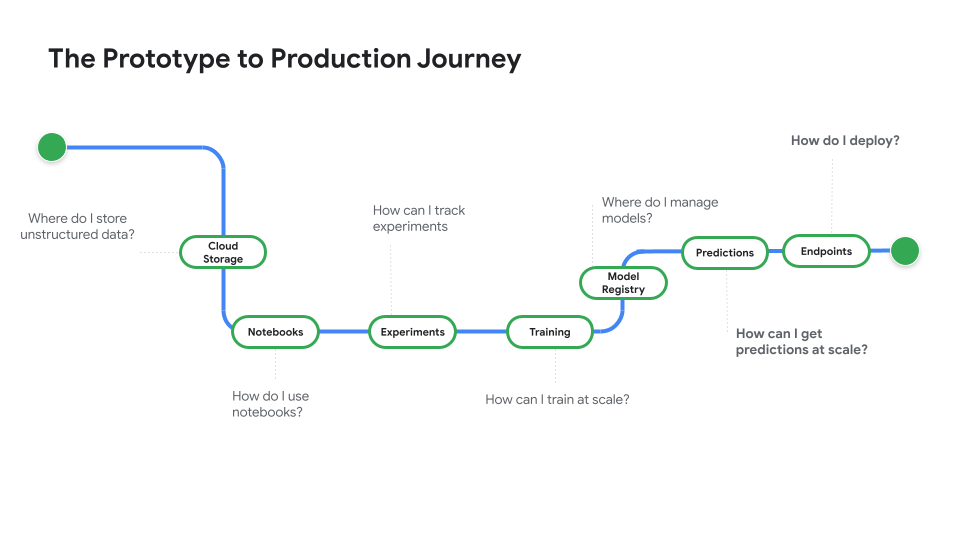

本番環境で使用するモデルをデプロイする

バッチ予測またはオンライン予測のためのデプロイ

バッチ予測またはオンライン予測のためのデプロイ

モデルを使用して現実世界の問題を解決する準備ができたら、モデルを Vertex AI Model Registry に登録し、Vertex AI 予測サービスを使用してバッチ予測とオンライン予測を行います。

プロトタイプから本番環境へをご覧ください。この動画シリーズは、ノートブック コードからデプロイされたモデルへの移行について説明するものです。

チュートリアル、クイックスタート、ラボ

バッチ予測またはオンライン予測のためのデプロイ

バッチ予測またはオンライン予測のためのデプロイ

モデルを使用して現実世界の問題を解決する準備ができたら、モデルを Vertex AI Model Registry に登録し、Vertex AI 予測サービスを使用してバッチ予測とオンライン予測を行います。

プロトタイプから本番環境へをご覧ください。この動画シリーズは、ノートブック コードからデプロイされたモデルへの移行について説明するものです。

料金

| Vertex AI の料金の仕組み | Vertex AI のツール、ストレージ、コンピューティング、使用した Cloud リソースに対して支払いが発生します。新規のお客様には、Vertex AI やその他の Google Cloud プロダクトをお試しいただける無料クレジット $300 分を差し上げます。 | |

|---|---|---|

| ツールと使用状況 | 説明 | 料金 |

生成 AI | 画像生成用の Imagen モデル 画像入力、文字入力、カスタム トレーニングの料金に基づきます。 | 目安 $0.0001 |

テキスト、チャット、コードの生成 1,000 文字単位の入力(プロンプト)と 1,000 文字単位の出力(レスポンス)に基づきます。 | 目安 $0.0001 1,000文字ごと | |

カスタム トレーニング済みモデル | カスタムモデルのトレーニング 1 時間あたりに使用されるマシンタイプ、リージョン、使用されたアクセラレータに基づきます。Google の営業担当者を通じて、または料金計算ツールを使用して見積りを取得できます。 | お問い合わせ |

Vertex AI Notebooks | コンピューティングとストレージのリソース Compute Engine および Cloud Storage と同じレートに基づいています。 | プロダクトを参照する |

管理手数料 上記のリソース使用量に加えて、使用するリージョン、インスタンス、ノートブック、マネージド ノートブックに応じて管理手数料が適用されます。詳細を表示 | 詳細を参照する | |

Vertex AI Pipelines | 実行料金と追加料金 実行料金、使用したリソース、追加のサービス手数料に基づきます。 | 目安 $0.03 パイプラインの実行あたり |

Vertex AI Vector Search | 利用料金と構築料金 データのサイズ、実行する秒間クエリ数(QPS)、使用するノード数に基づきます。サンプルを表示。 | 例を参照する |

Vertex AI のすべての機能とサービスの料金の詳細をご覧ください。

Vertex AI の料金の仕組み

Vertex AI のツール、ストレージ、コンピューティング、使用した Cloud リソースに対して支払いが発生します。新規のお客様には、Vertex AI やその他の Google Cloud プロダクトをお試しいただける無料クレジット $300 分を差し上げます。

テキスト、チャット、コードの生成

1,000 文字単位の入力(プロンプト)と 1,000 文字単位の出力(レスポンス)に基づきます。

Starting at

$0.0001

1,000文字ごと

カスタム トレーニング済みモデル

カスタムモデルのトレーニング

1 時間あたりに使用されるマシンタイプ、リージョン、使用されたアクセラレータに基づきます。Google の営業担当者を通じて、または料金計算ツールを使用して見積りを取得できます。

お問い合わせ

Vertex AI Notebooks

コンピューティングとストレージのリソース

Compute Engine および Cloud Storage と同じレートに基づいています。

プロダクトを参照する

Vertex AI Pipelines

実行料金と追加料金

実行料金、使用したリソース、追加のサービス手数料に基づきます。

Starting at

$0.03

パイプラインの実行あたり

Vertex AI のすべての機能とサービスの料金の詳細をご覧ください。

ビジネスケース

生成 AI の可能性を最大限に引き出す

「Google Cloud の生成 AI ソリューションの精度と Vertex AI Platform の実用性のおかげで、この最先端テクノロジーをビジネスの中核に導入し、応答時間 0 分という長期的な目標を達成するために必要な自信が持てました。」

GA Telesis CEO、Abdol Moabery 氏

アナリスト レポート

Google は IDC の 2025 年版 MarketScape「Worldwide GenAI Life-Cycle Foundation Model Software」でリーダーに選出されました。レポートをダウンロード

Google は、The Forrester Wave™: AI Foundation Models for Language, Q2 2024 のリーダーに選出されました。レポートを読む

Forrester Wave: AI/ML Platforms, Q3 2024 で Google がリーダーに選出されました。レポートを読む