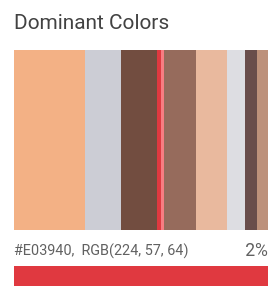

La fonctionnalité Propriétés d'image détecte les caractéristiques générales de l'image, telles que la couleur dominante.

Couleurs dominantes détectées :

Requêtes de détection des propriétés de l'image

Configurer votre projet Google Cloud et votre authentification

Si vous n'avez pas encore créé de projet Google Cloud , faites-le maintenant. Développez cette section pour connaître la marche à suivre.

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vision API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Si vous utilisez un fournisseur d'identité (IdP) externe, vous devez d'abord vous connecter à la gcloud CLI avec votre identité fédérée.

-

Pour initialiser la gcloud CLI, exécutez la commande suivante :

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vision API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Si vous utilisez un fournisseur d'identité (IdP) externe, vous devez d'abord vous connecter à la gcloud CLI avec votre identité fédérée.

-

Pour initialiser la gcloud CLI, exécutez la commande suivante :

gcloud init - BASE64_ENCODED_IMAGE : représentation en base64 (chaîne ASCII) de vos données d'image binaires. Cette chaîne doit ressembler à la chaîne suivante :

/9j/4QAYRXhpZgAA...9tAVx/zDQDlGxn//2Q==

- RESULTS_INT : (facultatif) valeur entière des résultats à renvoyer. Si vous omettez le champ

"maxResults"et sa valeur, l'API renvoie la valeur par défaut de 10 résultats. Ce champ ne s'applique pas aux types de fonctionnalités suivants :TEXT_DETECTION,DOCUMENT_TEXT_DETECTIONniCROP_HINTS. - PROJECT_ID : ID de votre projet Google Cloud .

- CLOUD_STORAGE_IMAGE_URI : chemin d'accès à un fichier image valide dans un bucket Cloud Storage. Il vous faut au minimum disposer de droits de lecture sur le fichier.

Exemple :

gs://cloud-samples-data/vision/image_properties/bali.jpeg

- RESULTS_INT : (facultatif) valeur entière des résultats à renvoyer. Si vous omettez le champ

"maxResults"et sa valeur, l'API renvoie la valeur par défaut de 10 résultats. Ce champ ne s'applique pas aux types de fonctionnalités suivants :TEXT_DETECTION,DOCUMENT_TEXT_DETECTIONniCROP_HINTS. - PROJECT_ID : ID de votre projet Google Cloud .

Détecter les propriétés d'image dans une image locale

L'API Vision permet de détecter des caractéristiques dans un fichier image local.

Pour les requêtes REST, envoyez le contenu du fichier image en tant que chaîne encodée en base64 dans le corps de votre requête.

Pour les requêtes gcloud et les bibliothèques clientes, spécifiez le chemin d'accès à une image locale dans votre requête.

Le champ ColorInfo ne contient pas d'informations sur l'espace colorimétrique absolu à utiliser pour interpréter la valeur RVB, par exemple sRVB, Adobe RVB, DCI-P3, BT.2020, etc. Par défaut, les applications doivent partir du principe qu'il s'agit de l'espace colorimétrique sRVB.

REST

Avant d'utiliser les données de requête ci-dessous, effectuez les remplacements suivants :

Méthode HTTP et URL :

POST https://vision.googleapis.com/v1/images:annotate

Corps JSON de la requête :

{

"requests": [

{

"image": {

"content": "BASE64_ENCODED_IMAGE"

},

"features": [

{

"maxResults": RESULTS_INT,

"type": "IMAGE_PROPERTIES"

},

]

}

]

}

Pour envoyer votre requête, choisissez l'une des options suivantes :

curl

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://vision.googleapis.com/v1/images:annotate"

PowerShell

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://vision.googleapis.com/v1/images:annotate" | Select-Object -Expand Content

Si la requête aboutit, le serveur affiche un code d'état HTTP 200 OK et la réponse au format JSON.

Réponse :

Réponse

{

"responses": [

{

"imagePropertiesAnnotation": {

"dominantColors": {

"colors": [

{

"color": {

"red": 243,

"green": 177,

"blue": 133

},

"score": 0.18074834,

"pixelFraction": 0.013533333

},

{

"color": {

"red": 204,

"green": 205,

"blue": 213

},

"score": 0.092455424,

"pixelFraction": 0.19266666

},

{

"color": {

"red": 114,

"green": 77,

"blue": 64

},

"score": 0.090447456,

"pixelFraction": 0.034133334

},

{

"color": {

"red": 224,

"green": 57,

"blue": 64

},

"score": 0.010952942,

"pixelFraction": 0.014266667

},

{

"color": {

"red": 248,

"green": 125,

"blue": 130

},

"score": 0.006984347,

"pixelFraction": 0.0057333335

},

{

"color": {

"red": 150,

"green": 107,

"blue": 92

},

"score": 0.081589326,

"pixelFraction": 0.019666666

},

{

"color": {

"red": 233,

"green": 185,

"blue": 158

},

"score": 0.08035342,

"pixelFraction": 0.0122

},

{

"color": {

"red": 221,

"green": 221,

"blue": 226

},

"score": 0.045200635,

"pixelFraction": 0.202

},

{

"color": {

"red": 105,

"green": 77,

"blue": 75

},

"score": 0.030223774,

"pixelFraction": 0.013866667

},

{

"color": {

"red": 189,

"green": 145,

"blue": 123

},

"score": 0.028689377,

"pixelFraction": 0.0069333334

}

]

}

},

"cropHintsAnnotation": {

"cropHints": [

{

"boundingPoly": {

"vertices": [

{},

{

"x": 2549

},

{

"x": 2549,

"y": 1699

},

{

"y": 1699

}

]

},

"confidence": 0.79999995,

"importanceFraction": 1

}

]

}

}

]

}

Go

Avant d'essayer cet exemple, suivez les instructions de configuration pour Go décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vision pour Go.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

// detectProperties gets image properties from the Vision API for an image at the given file path.

func detectProperties(w io.Writer, file string) error {

ctx := context.Background()

client, err := vision.NewImageAnnotatorClient(ctx)

if err != nil {

return err

}

f, err := os.Open(file)

if err != nil {

return err

}

defer f.Close()

image, err := vision.NewImageFromReader(f)

if err != nil {

return err

}

props, err := client.DetectImageProperties(ctx, image, nil)

if err != nil {

return err

}

fmt.Fprintln(w, "Dominant colors:")

for _, quantized := range props.DominantColors.Colors {

color := quantized.Color

r := int(color.Red) & 0xff

g := int(color.Green) & 0xff

b := int(color.Blue) & 0xff

fmt.Fprintf(w, "%2.1f%% - #%02x%02x%02x\n", quantized.PixelFraction*100, r, g, b)

}

return nil

}

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vision en langage Java.

import com.google.cloud.vision.v1.AnnotateImageRequest;

import com.google.cloud.vision.v1.AnnotateImageResponse;

import com.google.cloud.vision.v1.BatchAnnotateImagesResponse;

import com.google.cloud.vision.v1.ColorInfo;

import com.google.cloud.vision.v1.DominantColorsAnnotation;

import com.google.cloud.vision.v1.Feature;

import com.google.cloud.vision.v1.Image;

import com.google.cloud.vision.v1.ImageAnnotatorClient;

import com.google.protobuf.ByteString;

import java.io.FileInputStream;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

public class DetectProperties {

public static void detectProperties() throws IOException {

// TODO(developer): Replace these variables before running the sample.

String filePath = "path/to/your/image/file.jpg";

detectProperties(filePath);

}

// Detects image properties such as color frequency from the specified local image.

public static void detectProperties(String filePath) throws IOException {

List<AnnotateImageRequest> requests = new ArrayList<>();

ByteString imgBytes = ByteString.readFrom(new FileInputStream(filePath));

Image img = Image.newBuilder().setContent(imgBytes).build();

Feature feat = Feature.newBuilder().setType(Feature.Type.IMAGE_PROPERTIES).build();

AnnotateImageRequest request =

AnnotateImageRequest.newBuilder().addFeatures(feat).setImage(img).build();

requests.add(request);

// Initialize client that will be used to send requests. This client only needs to be created

// once, and can be reused for multiple requests. After completing all of your requests, call

// the "close" method on the client to safely clean up any remaining background resources.

try (ImageAnnotatorClient client = ImageAnnotatorClient.create()) {

BatchAnnotateImagesResponse response = client.batchAnnotateImages(requests);

List<AnnotateImageResponse> responses = response.getResponsesList();

for (AnnotateImageResponse res : responses) {

if (res.hasError()) {

System.out.format("Error: %s%n", res.getError().getMessage());

return;

}

// For full list of available annotations, see http://g.co/cloud/vision/docs

DominantColorsAnnotation colors = res.getImagePropertiesAnnotation().getDominantColors();

for (ColorInfo color : colors.getColorsList()) {

System.out.format(

"fraction: %f%nr: %f, g: %f, b: %f%n",

color.getPixelFraction(),

color.getColor().getRed(),

color.getColor().getGreen(),

color.getColor().getBlue());

}

}

}

}

}Node.js

Avant d'essayer cet exemple, suivez les instructions de configuration pour Node.js décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vision pour Node.js.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

const vision = require('@google-cloud/vision');

// Creates a client

const client = new vision.ImageAnnotatorClient();

/**

* TODO(developer): Uncomment the following line before running the sample.

*/

// const fileName = 'Local image file, e.g. /path/to/image.png';

// Performs property detection on the local file

const [result] = await client.imageProperties(fileName);

const colors = result.imagePropertiesAnnotation.dominantColors.colors;

colors.forEach(color => console.log(color));Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vision pour Python.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

def detect_properties(path):

"""Detects image properties in the file."""

from google.cloud import vision

client = vision.ImageAnnotatorClient()

with open(path, "rb") as image_file:

content = image_file.read()

image = vision.Image(content=content)

response = client.image_properties(image=image)

props = response.image_properties_annotation

print("Properties:")

for color in props.dominant_colors.colors:

print(f"fraction: {color.pixel_fraction}")

print(f"\tr: {color.color.red}")

print(f"\tg: {color.color.green}")

print(f"\tb: {color.color.blue}")

print(f"\ta: {color.color.alpha}")

if response.error.message:

raise Exception(

"{}\nFor more info on error messages, check: "

"https://cloud.google.com/apis/design/errors".format(response.error.message)

)

Langages supplémentaires

C# : Veuillez suivre les Instructions de configuration pour C# sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour .NET.

PHP : Veuillez suivre les Instructions de configuration pour PHP sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour PHP.

Ruby : Veuillez suivre les Instructions de configuration de Ruby sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour Ruby.

Détecter les propriétés d'image dans une image distante

L'API Vision permet de détecter des caractéristiques dans un fichier image distant situé dans Cloud Storage ou sur le Web. Pour envoyer une requête de fichier distant, spécifiez l'URL Web ou l'URI Cloud Storage du fichier dans le corps de la requête.

Le champ ColorInfo ne contient pas d'informations sur l'espace colorimétrique absolu à utiliser pour interpréter la valeur RVB, par exemple sRVB, Adobe RVB, DCI-P3, BT.2020, etc. Par défaut, les applications doivent partir du principe qu'il s'agit de l'espace colorimétrique sRVB.

REST

Avant d'utiliser les données de requête ci-dessous, effectuez les remplacements suivants :

Méthode HTTP et URL :

POST https://vision.googleapis.com/v1/images:annotate

Corps JSON de la requête :

{

"requests": [

{

"image": {

"source": {

"gcsImageUri": "CLOUD_STORAGE_IMAGE_URI"

}

},

"features": [

{

"maxResults": RESULTS_INT,

"type": "IMAGE_PROPERTIES"

},

]

}

]

}

Pour envoyer votre requête, choisissez l'une des options suivantes :

curl

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://vision.googleapis.com/v1/images:annotate"

PowerShell

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://vision.googleapis.com/v1/images:annotate" | Select-Object -Expand Content

Si la requête aboutit, le serveur affiche un code d'état HTTP 200 OK et la réponse au format JSON.

Réponse :

Réponse

{

"responses": [

{

"imagePropertiesAnnotation": {

"dominantColors": {

"colors": [

{

"color": {

"red": 243,

"green": 177,

"blue": 133

},

"score": 0.18074834,

"pixelFraction": 0.013533333

},

{

"color": {

"red": 204,

"green": 205,

"blue": 213

},

"score": 0.092455424,

"pixelFraction": 0.19266666

},

{

"color": {

"red": 114,

"green": 77,

"blue": 64

},

"score": 0.090447456,

"pixelFraction": 0.034133334

},

{

"color": {

"red": 224,

"green": 57,

"blue": 64

},

"score": 0.010952942,

"pixelFraction": 0.014266667

},

{

"color": {

"red": 248,

"green": 125,

"blue": 130

},

"score": 0.006984347,

"pixelFraction": 0.0057333335

},

{

"color": {

"red": 150,

"green": 107,

"blue": 92

},

"score": 0.081589326,

"pixelFraction": 0.019666666

},

{

"color": {

"red": 233,

"green": 185,

"blue": 158

},

"score": 0.08035342,

"pixelFraction": 0.0122

},

{

"color": {

"red": 221,

"green": 221,

"blue": 226

},

"score": 0.045200635,

"pixelFraction": 0.202

},

{

"color": {

"red": 105,

"green": 77,

"blue": 75

},

"score": 0.030223774,

"pixelFraction": 0.013866667

},

{

"color": {

"red": 189,

"green": 145,

"blue": 123

},

"score": 0.028689377,

"pixelFraction": 0.0069333334

}

]

}

},

"cropHintsAnnotation": {

"cropHints": [

{

"boundingPoly": {

"vertices": [

{},

{

"x": 2549

},

{

"x": 2549,

"y": 1699

},

{

"y": 1699

}

]

},

"confidence": 0.79999995,

"importanceFraction": 1

}

]

}

}

]

}

Go

Avant d'essayer cet exemple, suivez les instructions de configuration pour Go décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vision pour Go.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

// detectProperties gets image properties from the Vision API for an image at the given file path.

func detectPropertiesURI(w io.Writer, file string) error {

ctx := context.Background()

client, err := vision.NewImageAnnotatorClient(ctx)

if err != nil {

return err

}

image := vision.NewImageFromURI(file)

props, err := client.DetectImageProperties(ctx, image, nil)

if err != nil {

return err

}

fmt.Fprintln(w, "Dominant colors:")

for _, quantized := range props.DominantColors.Colors {

color := quantized.Color

r := int(color.Red) & 0xff

g := int(color.Green) & 0xff

b := int(color.Blue) & 0xff

fmt.Fprintf(w, "%2.1f%% - #%02x%02x%02x\n", quantized.PixelFraction*100, r, g, b)

}

return nil

}

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vision pour Java.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

import com.google.cloud.vision.v1.AnnotateImageRequest;

import com.google.cloud.vision.v1.AnnotateImageResponse;

import com.google.cloud.vision.v1.BatchAnnotateImagesResponse;

import com.google.cloud.vision.v1.ColorInfo;

import com.google.cloud.vision.v1.DominantColorsAnnotation;

import com.google.cloud.vision.v1.Feature;

import com.google.cloud.vision.v1.Image;

import com.google.cloud.vision.v1.ImageAnnotatorClient;

import com.google.cloud.vision.v1.ImageSource;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

public class DetectPropertiesGcs {

public static void detectPropertiesGcs() throws IOException {

// TODO(developer): Replace these variables before running the sample.

String filePath = "gs://your-gcs-bucket/path/to/image/file.jpg";

detectPropertiesGcs(filePath);

}

// Detects image properties such as color frequency from the specified remote image on Google

// Cloud Storage.

public static void detectPropertiesGcs(String gcsPath) throws IOException {

List<AnnotateImageRequest> requests = new ArrayList<>();

ImageSource imgSource = ImageSource.newBuilder().setGcsImageUri(gcsPath).build();

Image img = Image.newBuilder().setSource(imgSource).build();

Feature feat = Feature.newBuilder().setType(Feature.Type.IMAGE_PROPERTIES).build();

AnnotateImageRequest request =

AnnotateImageRequest.newBuilder().addFeatures(feat).setImage(img).build();

requests.add(request);

// Initialize client that will be used to send requests. This client only needs to be created

// once, and can be reused for multiple requests. After completing all of your requests, call

// the "close" method on the client to safely clean up any remaining background resources.

try (ImageAnnotatorClient client = ImageAnnotatorClient.create()) {

BatchAnnotateImagesResponse response = client.batchAnnotateImages(requests);

List<AnnotateImageResponse> responses = response.getResponsesList();

for (AnnotateImageResponse res : responses) {

if (res.hasError()) {

System.out.format("Error: %s%n", res.getError().getMessage());

return;

}

// For full list of available annotations, see http://g.co/cloud/vision/docs

DominantColorsAnnotation colors = res.getImagePropertiesAnnotation().getDominantColors();

for (ColorInfo color : colors.getColorsList()) {

System.out.format(

"fraction: %f%nr: %f, g: %f, b: %f%n",

color.getPixelFraction(),

color.getColor().getRed(),

color.getColor().getGreen(),

color.getColor().getBlue());

}

}

}

}

}Node.js

Avant d'essayer cet exemple, suivez les instructions de configuration pour Node.js décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vision pour Node.js.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

// Imports the Google Cloud client libraries

const vision = require('@google-cloud/vision');

// Creates a client

const client = new vision.ImageAnnotatorClient();

/**

* TODO(developer): Uncomment the following lines before running the sample.

*/

// const bucketName = 'Bucket where the file resides, e.g. my-bucket';

// const fileName = 'Path to file within bucket, e.g. path/to/image.png';

// Performs property detection on the gcs file

const [result] = await client.imageProperties(

`gs://${bucketName}/${fileName}`

);

const colors = result.imagePropertiesAnnotation.dominantColors.colors;

colors.forEach(color => console.log(color));Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python décrites dans le guide de démarrage rapide de Vision à l'aide des bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API Vision pour Python.

Pour vous authentifier auprès de Vision, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez Configurer l'authentification pour un environnement de développement local.

def detect_properties_uri(uri):

"""Detects image properties in the file located in Google Cloud Storage or

on the Web."""

from google.cloud import vision

client = vision.ImageAnnotatorClient()

image = vision.Image()

image.source.image_uri = uri

response = client.image_properties(image=image)

props = response.image_properties_annotation

print("Properties:")

for color in props.dominant_colors.colors:

print(f"frac: {color.pixel_fraction}")

print(f"\tr: {color.color.red}")

print(f"\tg: {color.color.green}")

print(f"\tb: {color.color.blue}")

print(f"\ta: {color.color.alpha}")

if response.error.message:

raise Exception(

"{}\nFor more info on error messages, check: "

"https://cloud.google.com/apis/design/errors".format(response.error.message)

)

gcloud

Pour effectuer la détection des propriétés de l'image, utilisez la commande gcloud ml vision detect-image-properties comme indiqué dans l'exemple suivant :

gcloud ml vision detect-image-properties gs://cloud-samples-data/vision/image_properties/bali.jpeg

Langages supplémentaires

C# : Veuillez suivre les Instructions de configuration pour C# sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour .NET.

PHP : Veuillez suivre les Instructions de configuration pour PHP sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur Vision pour PHP.

Ruby : Suivez les instructions de configuration pour Ruby sur la page des bibliothèques clientes, puis consultez la documentation de référence de Vision pour Ruby.

Essayer

Essayez la détection des propriétés de l'image ci-dessous. Vous pouvez utiliser l'image déjà spécifiée gs://cloud-samples-data/vision/image_properties/bali.jpeg ou spécifier votre propre image à la place. Pour envoyer la requête, cliquez sur Exécuter.

Corps de la requête :

{

"requests": [

{

"features": [

{

"maxResults": 10,

"type": "IMAGE_PROPERTIES"

}

],

"image": {

"source": {

"imageUri": "gs://cloud-samples-data/vision/image_properties/bali.jpeg"

}

}

}

]

}