O Vertex AI Vision é uma plataforma com tecnologia de IA que pode usar para carregar, analisar e armazenar dados de vídeo. O Vertex AI Vision permite-lhe criar e implementar aplicações de IA. Pode criar soluções de Vertex AI Vision ponto a ponto tirando partido da integração do Vertex AI Vision com outros componentes do produto.

Para começar a implementar soluções com a plataforma Vertex AI Vision, reveja os seguintes conceitos e componentes do Vertex AI Vision:

Streams: representam uma camada de streaming de vídeo da sua solução. A origem da stream pode ser um vídeo em direto (por exemplo, uma câmara IP) ou um ficheiro de vídeo (por exemplo, um ficheiro MP4).

Aplicações: ative a ligação entre uma stream e um processador de IA para realizar uma operação de aprendizagem automática no vídeo. Por exemplo, pode associar um stream de vídeo a um modelo de IA que conta as pessoas que passam em frente ao mesmo.

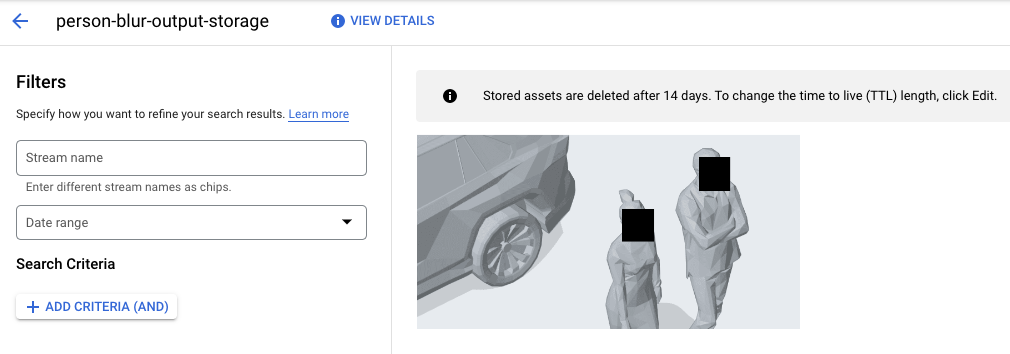

Armazéns de conteúdo multimédia: armazenam o vídeo carregado por streams para o Google Cloud armazenamento. O armazenamento de dados neste destino permite-lhe consultar a saída da análise e os metadados dos processadores de IA usados em dados dos streams carregados.

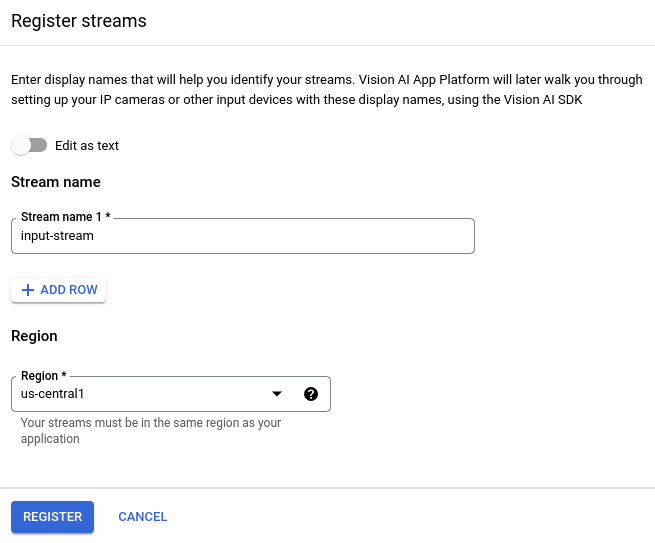

Crie uma stream

Para criar uma app de análise de vídeo em streaming, primeiro tem de criar e registar um recurso de stream. Como o recurso que recebe os dados de vídeo dos utilizadores, a stream é necessária em qualquer cenário que criar com o Vertex AI Vision.Consola

Para criar uma nova stream na Google Cloud consola, siga estes passos.

Abra o separador Streams do painel de controlo do Vertex AI Vision.

Clique em Registar.

Introduza

input-streamcomo o nome da stream e selecione a região onde quer criar a stream.Clique em Registar para criar uma ou mais streams.

Carregue vídeo para a stream

Depois de criar um recurso de stream, pode usar a vaictl ferramenta de linha de comandos

para enviar dados de vídeo para a stream.

Câmara IP

Se estiver a testar com uma câmara IP em direto, tem de obter o endereço IP da câmara. Tem de fornecer estas informações com o pedido, juntamente com outras substituições de variáveis:

- PROJECT_ID: o ID do seu Google Cloud projeto.

- LOCATION_ID: o ID da sua localização. Por exemplo,

us-central1. Para mais informações, consulte o artigo Localizações na nuvem. - RTSP_ADDRESS: o endereço do seu feed do protocolo de streaming em tempo real (RTSP). Por exemplo,

rtsp://192.168.1.180:540.

Este comando envia um feed RTSP para a stream. Tem de executar este comando na rede que tem acesso direto ao feed RTSP.

vaictl -p PROJECT_ID \

-l LOCATION_ID \

-c application-cluster-0 \

--service-endpoint visionai.googleapis.com \

send rtsp to streams input-stream --rtsp-uri RTSP_ADDRESS

Se o comando for executado com êxito, recebe a seguinte saída:

[...] Waiting for long running operation projects/your-project/locations/us-central1/operations/operation-1651364156981-5dde82db7e4a9-dfb17ca5-1051eb20 ⠙ I20220430 21:16:28.024988 211449 gstvaisink.cc:417] cluster-id=application-cluster-0 I20220430 21:16:28.025032 211449 gstvaisink.cc:418] cluster-endpoint=c8khq35ftg78mn61ef50.us-central1.visionai.goog I20220430 21:16:28.025040 211449 gstvaisink.cc:419] event-id=ev-1651364114183255223 I20220430 21:16:28.025048 211449 gstvaisink.cc:420] stream-id=input-stream I20220430 21:16:28.025053 211449 gstvaisink.cc:421] series-id=ev-1651364114183255223--input-stream I20220430 21:16:28.025060 211449 gstvaisink.cc:422] Sending data

Ficheiro de vídeo local

Também pode enviar dados de ficheiros de vídeo para uma stream em vez de um feed de vídeo em direto. Esta opção pode ser útil se não tiver acesso a uma câmara IP.

A única diferença nesta opção são os parâmetros do comando vaictl. Em vez de transmitir as informações da câmara IP, transmita o caminho do ficheiro de vídeo local. Faça as seguintes substituições de variáveis:

- PROJECT_ID: o ID do seu Google Cloud projeto.

- LOCATION_ID: o ID da sua localização. Por exemplo,

us-central1. Mais informações. - LOCAL_FILE.EXT: o nome do ficheiro de um ficheiro de vídeo local.

Por exemplo,

my-video.mp4. - Sinalizador

--loop: opcional. Faz um ciclo dos dados de ficheiros para simular o streaming.

Este comando transmite um ficheiro de vídeo para uma stream. Se usar a flag --loop, o vídeo é repetido no stream até parar o comando:

vaictl -p PROJECT_ID \

-l LOCATION_ID \

-c application-cluster-0 \

--service-endpoint visionai.googleapis.com \

send video-file to streams 'input-stream' --file-path LOCAL_FILE.EXT --loop

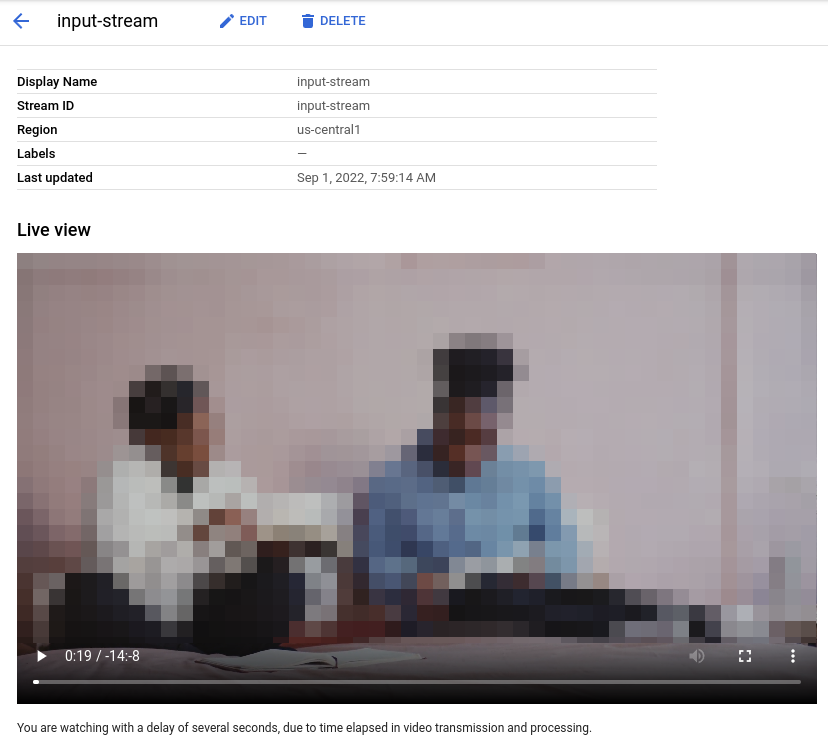

Pode demorar cerca de 100 segundos entre o início da operação de carregamento vaictl e a apresentação do vídeo no painel de controlo.

Depois de a ingestão de streams estar disponível,

pode ver o feed de vídeo no separador Streams do painel de controlo do Vertex AI Vision

selecionando a stream input-stream.

Crie uma aplicação de efeito esbatido a rostos

Depois de criar uma stream e carregar dados para a stream, é altura de criar uma app Vertex AI Vision para processar os dados. Pode considerar uma app como um pipeline automatizado que liga o seguinte:

- Carregamento de dados: um feed de vídeo é carregado numa stream.

- Análise de dados: pode adicionar um modelo de IA após a ingestão. Qualquer operação de visão por computador pode ser realizada nas informações de vídeo carregadas.

- Armazenamento de dados: as duas versões do feed de vídeo (a stream original e a stream processada pelo modelo de IA) podem ser armazenadas num armazém de multimédia.

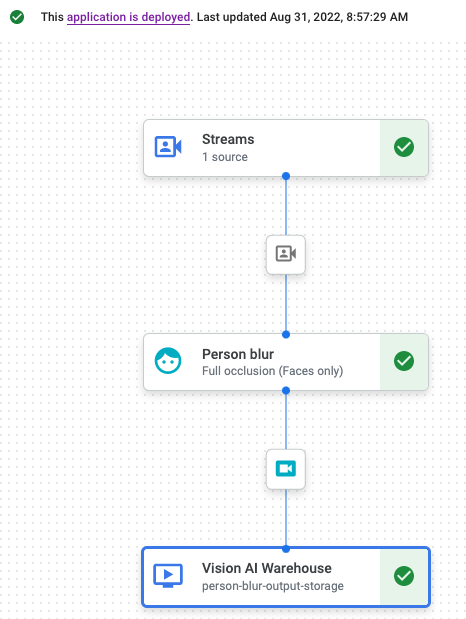

Na Google Cloud consola, uma app é representada como um gráfico. Além disso, no Vertex AI Vision, um gráfico de apps tem de ter, pelo menos, dois nós: um nó de origem de vídeo (stream) e , pelo menos, mais um nó (um modelo de processamento ou um destino de saída).

Crie uma aplicação vazia

Antes de poder preencher o gráfico de apps, tem de criar uma app vazia.Consola

Crie uma app na Google Cloud consola.

Abra o separador Aplicações do painel de controlo do Vertex AI Vision.

Clique no botão Criar.

Introduza

person-blur-appcomo o nome da app e escolha a sua região.Clique em Criar.

Adicione nós de componentes de apps

Depois de criar a aplicação vazia, pode adicionar os três nós ao gráfico da app:

- Nó de carregamento: o recurso de stream que já está a carregar dados.

- Nó de processamento: o modelo de esbatimento de pessoas que atua sobre os dados carregados.

- Nó de armazenamento: o armazém de multimédia que armazena vídeos processados e também funciona como um armazém de metadados. O armazém de dados permite gerar informações de estatísticas sobre os dados de vídeo carregados, bem como armazenar informações inferidas sobre os dados pelos modelos de IA.

Consola

Adicione nós de componentes à sua app na consola.

Abra o separador Aplicações do painel de controlo do Vertex AI Vision.

Na linha

person-blur-app, selecione Ver gráfico. Isto permite aceder à visualização do gráfico do pipeline de processamento.

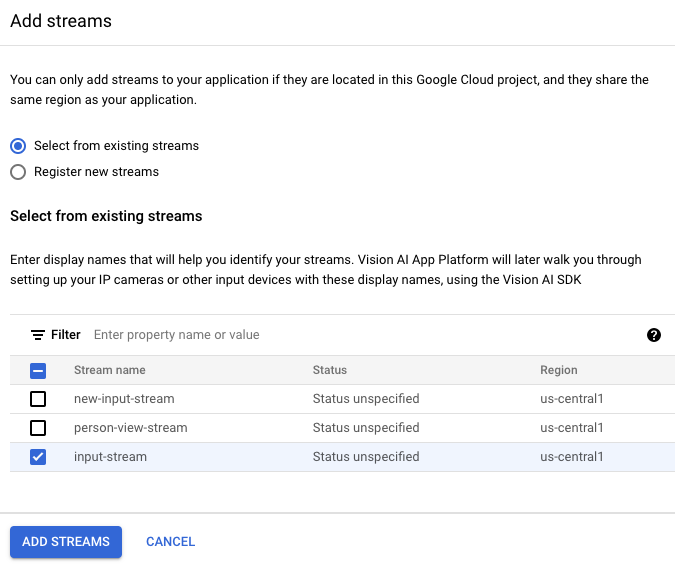

Adicione um nó de carregamento de dados

Para adicionar o nó de fluxo de entrada, selecione a opção Streams na secção Conetores do menu lateral.

Na secção Origem do menu Stream que é aberto, selecione Adicionar streams.

No menu Adicionar streams, escolha Selecionar a partir de streams existentes e selecione

person-blur-appna lista de recursos de streams.

Para adicionar a stream ao gráfico de apps, clique em Adicionar streams.

Adicione um nó de tratamento de dados

Para adicionar o nó do modelo de efeito esbatido de pessoas, selecione a opção Efeito esbatido de pessoas na secção Processadores gerais do menu lateral.

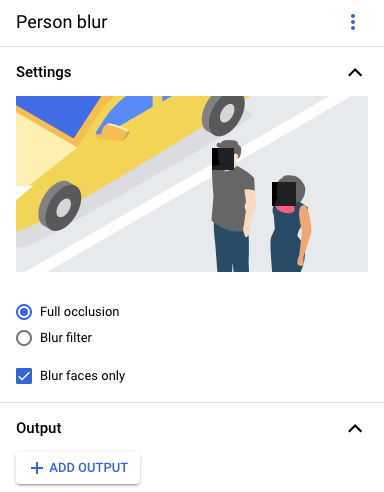

No menu de opções "Desfocar pessoas" apresentado, deixe a opção Oclusão total selecionada e ative a opção Desfocar apenas rostos.

Adicione um nó de armazenamento de dados

Para adicionar o nó de destino de saída (armazenamento), selecione a opção Media Warehouse do Vertex AI Vision na secção Conetores do menu lateral.

No menu Media Warehouse da Vertex AI Vision, clique em Associar armazém.

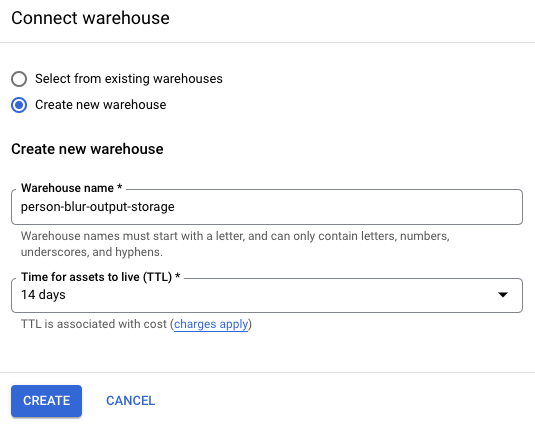

No menu Associar armazém, selecione Criar novo armazém. Dê o nome

person-blur-appao armazém e deixe a duração do TTL em 14 dias.Para adicionar o armazém, clique em Criar.

Implemente a sua aplicação

Depois de criar a sua app de ponta a ponta com todos os componentes necessários, o último passo para usar a app é implementá-la.Consola

Abra o separador Aplicações do painel de controlo do Vertex AI Vision.

Selecione Ver gráfico junto à app

person-blur-appna lista.Na página do criador de gráficos de aplicações, clique no botão Implementar.

Na caixa de diálogo de confirmação seguinte, selecione Implementar.

A operação de implementação pode demorar vários minutos a ser concluída. Após a conclusão da implementação, aparecem marcas de verificação verdes junto aos nós.

Veja os dados de saída processados

Consola

Abra o separador Armazéns do painel de controlo do Vertex AI Vision.

Encontre o armazém

person-blur-output-storagena lista e clique em Ver recursos.