Lo streaming prevede la ricezione delle risposte ai prompt man mano che vengono generati. ovvero, non appena il modello genera token di output, questi vengono inviati.

Puoi inviare richieste in streaming al modello linguistico di grandi dimensioni (LLM) di Vertex AI utilizzando quanto segue:

- L'API REST di Vertex AI con eventi inviati dal server (SSE)

- L'API REST di Vertex AI

- L'SDK Vertex AI per Python

- Una libreria client

Le API in streaming e non in streaming utilizzano gli stessi parametri e non c'è differenza in termini di prezzi e quote.

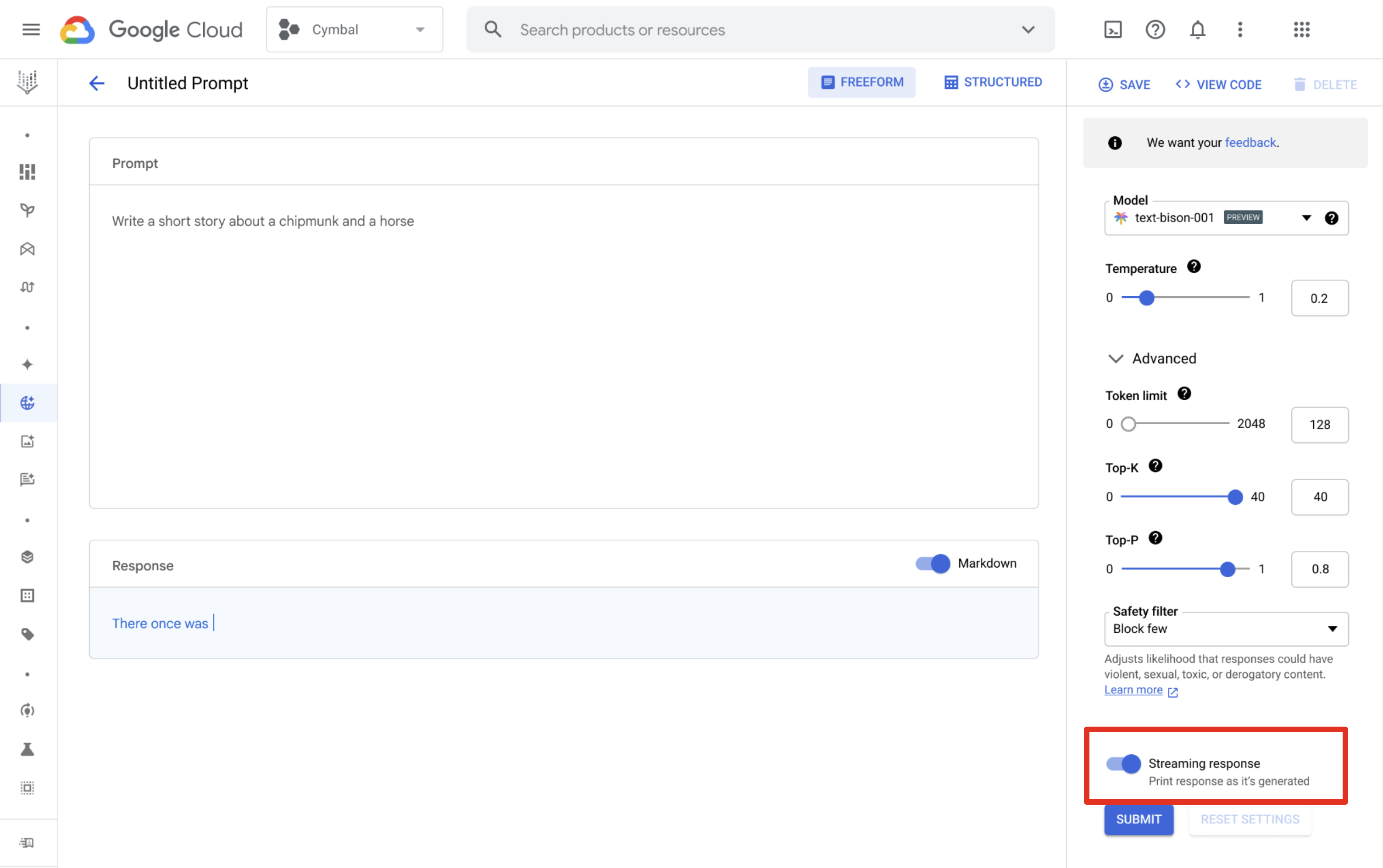

Vertex AI Studio

Puoi utilizzare Vertex AI Studio per progettare ed eseguire prompt e ricevere risposte in streaming. Nella pagina di progettazione del prompt, fai clic sul pulsante Risposta dinamica per attivare lo streaming.

Lingue supportate

| Codice lingua | Lingua |

|---|---|

en |

Inglese |

es |

Spagnolo |

pt |

Portoghese |

fr |

Francese |

it |

Italiano |

de |

Tedesco |

ja |

Giapponese |

ko |

Coreano |

hi |

Hindi |

zh |

Cinese |

id |

Indonesiano |

Esempi

Puoi chiamare l'API Streaming utilizzando uno dei seguenti elementi:

API REST con eventi inviati dal server (SSE)

I parametri sono diversi nei tipi di modelli utilizzati nei seguenti esempi:

Testo

I modelli attualmente supportati sono text-bison e text-unicorn. Consulta le versioni disponibili.

Richiedi

PROJECT_ID=YOUR_PROJECT_ID

PROMPT="PROMPT"

MODEL_ID=text-bison

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://us-central1-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/us-central1/publishers/google/models/${MODEL_ID}:serverStreamingPredict?alt=sse -d \

'{

"inputs": [

{

"struct_val": {

"prompt": {

"string_val": [ "'"${PROMPT}"'" ]

}

}

}

],

"parameters": {

"struct_val": {

"temperature": { "float_val": 0.8 },

"maxOutputTokens": { "int_val": 1024 },

"topK": { "int_val": 40 },

"topP": { "float_val": 0.95 }

}

}

}'

Risposta

Le risposte sono messaggi di evento inviati dal server.

data: {"outputs": [{"structVal": {"content": {"stringVal": [RESPONSE]},"safetyAttributes": {"structVal": {"blocked": {"boolVal": [BOOLEAN]},"categories": {"listVal": [{"stringVal": [Safety category name]}]},"scores": {"listVal": [{"doubleVal": [Safety category score]}]}}},"citationMetadata": {"structVal": {"citations": {}}}}}]}

Chat

Il modello attualmente supportato è chat-bison. Consulta le versioni disponibili.

Richiedi

PROJECT_ID=YOUR_PROJECT_ID

PROMPT="PROMPT"

AUTHOR="USER"

MODEL_ID=chat-bison

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://us-central1-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/us-central1/publishers/google/models/${MODEL_ID}:serverStreamingPredict?alt=sse -d \

$'{

"inputs": [

{

"struct_val": {

"messages": {

"list_val": [

{

"struct_val": {

"content": {

"string_val": [ "'"${PROMPT}"'" ]

},

"author": {

"string_val": [ "'"${AUTHOR}"'"]

}

}

}

]

}

}

}

],

"parameters": {

"struct_val": {

"temperature": { "float_val": 0.5 },

"maxOutputTokens": { "int_val": 1024 },

"topK": { "int_val": 40 },

"topP": { "float_val": 0.95 }

}

}

}'

Risposta

Le risposte sono messaggi di evento inviati dal server.

data: {"outputs": [{"structVal": {"candidates": {"listVal": [{"structVal": {"author": {"stringVal": [AUTHOR]},"content": {"stringVal": [RESPONSE]}}}]},"citationMetadata": {"listVal": [{"structVal": {"citations": {}}}]},"safetyAttributes": {"structVal": {"blocked": {"boolVal": [BOOLEAN]},"categories": {"listVal": [{"stringVal": [Safety category name]}]},"scores": {"listVal": [{"doubleVal": [Safety category score]}]}}}}}]}

Codice

Il modello attualmente supportato è code-bison. Consulta le versioni disponibili.

Richiedi

PROJECT_ID=YOUR_PROJECT_ID

PROMPT="PROMPT"

MODEL_ID=code-bison

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://us-central1-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/us-central1/publishers/google/models/${MODEL_ID}:serverStreamingPredict?alt=sse -d \

$'{

"inputs": [

{

"struct_val": {

"prefix": {

"string_val": [ "'"${PROMPT}"'" ]

}

}

}

],

"parameters": {

"struct_val": {

"temperature": { "float_val": 0.8 },

"maxOutputTokens": { "int_val": 1024 },

"topK": { "int_val": 40 },

"topP": { "float_val": 0.95 }

}

}

}'

Risposta

Le risposte sono messaggi di evento inviati dal server.

data: {"outputs": [{"structVal": {"citationMetadata": {"structVal": {"citations": {}}},"safetyAttributes": {"structVal": {"blocked": {"boolVal": [BOOLEAN]},"categories": {"listVal": [{"stringVal": [Safety category name]}]},"scores": {"listVal": [{"doubleVal": [Safety category score]}]}}},"content": {"stringVal": [RESPONSE]}}}]}

Chat di codice

Il modello attualmente supportato è codechat-bison. Consulta le versioni disponibili.

Richiedi

PROJECT_ID=YOUR_PROJECT_ID

PROMPT="PROMPT"

AUTHOR="USER"

MODEL_ID=codechat-bison

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://us-central1-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/us-central1/publishers/google/models/${MODEL_ID}:serverStreamingPredict?alt=sse -d \

$'{

"inputs": [

{

"struct_val": {

"messages": {

"list_val": [

{

"struct_val": {

"content": {

"string_val": [ "'"${PROMPT}"'" ]

},

"author": {

"string_val": [ "'"${AUTHOR}"'"]

}

}

}

]

}

}

}

],

"parameters": {

"struct_val": {

"temperature": { "float_val": 0.5 },

"maxOutputTokens": { "int_val": 1024 },

"topK": { "int_val": 40 },

"topP": { "float_val": 0.95 }

}

}

}'

Risposta

Le risposte sono messaggi di evento inviati dal server.

data: {"outputs": [{"structVal": {"safetyAttributes": {"structVal": {"blocked": {"boolVal": [BOOLEAN]},"categories": {"listVal": [{"stringVal": [Safety category name]}]},"scores": {"listVal": [{"doubleVal": [Safety category score]}]}}},"citationMetadata": {"listVal": [{"structVal": {"citations": {}}}]},"candidates": {"listVal": [{"structVal": {"content": {"stringVal": [RESPONSE]},"author": {"stringVal": [AUTHOR]}}}]}}}]}

API REST

I parametri sono diversi nei tipi di modelli utilizzati nei seguenti esempi:

Testo

I modelli attualmente supportati sono text-bison e text-unicorn. Consulta le versioni disponibili.

Richiedi

PROJECT_ID=YOUR_PROJECT_ID

PROMPT="PROMPT"

MODEL_ID=text-bison

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://us-central1-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/us-central1/publishers/google/models/${MODEL_ID}:serverStreamingPredict -d \

'{

"inputs": [

{

"struct_val": {

"prompt": {

"string_val": [ "'"${PROMPT}"'" ]

}

}

}

],

"parameters": {

"struct_val": {

"temperature": { "float_val": 0.8 },

"maxOutputTokens": { "int_val": 1024 },

"topK": { "int_val": 40 },

"topP": { "float_val": 0.95 }

}

}

}'

Risposta

{

"outputs": [

{

"structVal": {

"citationMetadata": {

"structVal": {

"citations": {}

}

},

"safetyAttributes": {

"structVal": {

"categories": {},

"scores": {},

"blocked": {

"boolVal": [

false

]

}

}

},

"content": {

"stringVal": [

RESPONSE

]

}

}

}

]

}

Chat

Il modello attualmente supportato è chat-bison. Consulta le versioni disponibili.

Richiedi

PROJECT_ID=YOUR_PROJECT_ID

PROMPT="PROMPT"

AUTHOR="USER"

MODEL_ID=chat-bison

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://us-central1-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/us-central1/publishers/google/models/${MODEL_ID}:serverStreamingPredict -d \

$'{

"inputs": [

{

"struct_val": {

"messages": {

"list_val": [

{

"struct_val": {

"content": {

"string_val": [ "'"${PROMPT}"'" ]

},

"author": {

"string_val": [ "'"${AUTHOR}"'"]

}

}

}

]

}

}

}

],

"parameters": {

"struct_val": {

"temperature": { "float_val": 0.5 },

"maxOutputTokens": { "int_val": 1024 },

"topK": { "int_val": 40 },

"topP": { "float_val": 0.95 }

}

}

}'

Risposta

{

"outputs": [

{

"structVal": {

"candidates": {

"listVal": [

{

"structVal": {

"content": {

"stringVal": [

RESPONSE

]

},

"author": {

"stringVal": [

AUTHOR

]

}

}

}

]

},

"citationMetadata": {

"listVal": [

{

"structVal": {

"citations": {}

}

}

]

},

"safetyAttributes": {

"listVal": [

{

"structVal": {

"categories": {},

"blocked": {

"boolVal": [

false

]

},

"scores": {}

}

}

]

}

}

}

]

}

Codice

Il modello attualmente supportato è code-bison. Consulta le versioni disponibili.

Richiedi

PROJECT_ID=YOUR_PROJECT_ID

PROMPT="PROMPT"

MODEL_ID=code-bison

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://us-central1-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/us-central1/publishers/google/models/${MODEL_ID}:serverStreamingPredict -d \

$'{

"inputs": [

{

"struct_val": {

"prefix": {

"string_val": [ "'"${PROMPT}"'" ]

}

}

}

],

"parameters": {

"struct_val": {

"temperature": { "float_val": 0.8 },

"maxOutputTokens": { "int_val": 1024 },

"topK": { "int_val": 40 },

"topP": { "float_val": 0.95 }

}

}

}'

Risposta

{

"outputs": [

{

"structVal": {

"safetyAttributes": {

"structVal": {

"categories": {},

"scores": {},

"blocked": {

"boolVal": [

false

]

}

}

},

"citationMetadata": {

"structVal": {

"citations": {}

}

},

"content": {

"stringVal": [

RESPONSE

]

}

}

}

]

}

Chat di codice

Il modello attualmente supportato è codechat-bison. Consulta le versioni disponibili.

Richiedi

PROJECT_ID=YOUR_PROJECT_ID

PROMPT="PROMPT"

AUTHOR="USER"

MODEL_ID=codechat-bison

curl \

-X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://us-central1-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/us-central1/publishers/google/models/${MODEL_ID}:serverStreamingPredict -d \

$'{

"inputs": [

{

"struct_val": {

"messages": {

"list_val": [

{

"struct_val": {

"content": {

"string_val": [ "'"${PROMPT}"'" ]

},

"author": {

"string_val": [ "'"${AUTHOR}"'"]

}

}

}

]

}

}

}

],

"parameters": {

"struct_val": {

"temperature": { "float_val": 0.5 },

"maxOutputTokens": { "int_val": 1024 },

"topK": { "int_val": 40 },

"topP": { "float_val": 0.95 }

}

}

}'

Risposta

{

"outputs": [

{

"structVal": {

"candidates": {

"listVal": [

{

"structVal": {

"content": {

"stringVal": [

RESPONSE

]

},

"author": {

"stringVal": [

AUTHOR

]

}

}

}

]

},

"citationMetadata": {

"listVal": [

{

"structVal": {

"citations": {}

}

}

]

},

"safetyAttributes": {

"listVal": [

{

"structVal": {

"categories": {},

"blocked": {

"boolVal": [

false

]

},

"scores": {}

}

}

]

}

}

}

]

}

SDK Vertex AI per Python

Per informazioni sull'installazione dell'SDK Vertex AI per Python, consulta Installare l'SDK Vertex AI per Python.

Testo

import vertexai

from vertexai.language_models import TextGenerationModel

def streaming_prediction(

project_id: str,

location: str,

) -> str:

"""Streaming Text Example with a Large Language Model"""

vertexai.init(project=project_id, location=location)

text_generation_model = TextGenerationModel.from_pretrained("text-bison")

parameters = {

"temperature": temperature, # Temperature controls the degree of randomness in token selection.

"max_output_tokens": 256, # Token limit determines the maximum amount of text output.

"top_p": 0.8, # Tokens are selected from most probable to least until the sum of their probabilities equals the top_p value.

"top_k": 40, # A top_k of 1 means the selected token is the most probable among all tokens.

}

responses = text_generation_model.predict_streaming(prompt="Give me ten interview questions for the role of program manager.", **parameters)

for response in responses:

`print(response)`

Chat

import vertexai

from vertexai.language_models import ChatModel, InputOutputTextPair

def streaming_prediction(

project_id: str,

location: str,

) -> str:

"""Streaming Chat Example with a Large Language Model"""

vertexai.init(project=project_id, location=location)

chat_model = ChatModel.from_pretrained("chat-bison")

parameters = {

"temperature": 0.8, # Temperature controls the degree of randomness in token selection.

"max_output_tokens": 256, # Token limit determines the maximum amount of text output.

"top_p": 0.95, # Tokens are selected from most probable to least until the sum of their probabilities equals the top_p value.

"top_k": 40, # A top_k of 1 means the selected token is the most probable among all tokens.

}

chat = chat_model.start_chat(

context="My name is Miles. You are an astronomer, knowledgeable about the solar system.",

examples=[

InputOutputTextPair(

input_text="How many moons does Mars have?",

output_text="The planet Mars has two moons, Phobos and Deimos.",

),

],

)

responses = chat.send_message_streaming(

message="How many planets are there in the solar system?", **parameters)

for response in responses:

`print(response)`

Codice

import vertexai

from vertexai.language_models import CodeGenerationModel

def streaming_prediction(

project_id: str,

location: str,

) -> str:

"""Streaming Chat Example with a Large Language Model"""

vertexai.init(project=project_id, location=location)

code_model = CodeGenerationModel.from_pretrained("code-bison")

parameters = {

"temperature": 0.8, # Temperature controls the degree of randomness in token selection.

"max_output_tokens": 256, # Token limit determines the maximum amount of text output.

}

responses = code_model.predict_streaming(

prefix="Write a function that checks if a year is a leap year.", **parameters)

for response in responses:

`print(response)`

Chat di codice

import vertexai

from vertexai.language_models import CodeChatModel

def streaming_prediction(

project_id: str,

location: str,

) -> str:

"""Streaming Chat Example with a Large Language Model"""

vertexai.init(project=project_id, location=location)

codechat_model = CodeChatModel.from_pretrained("codechat-bison")

parameters = {

"temperature": 0.8, # Temperature controls the degree of randomness in token selection.

"max_output_tokens": 1024, # Token limit determines the maximum amount of text output.

}

codechat = codechat_model.start_chat()

responses = codechat.send_message_streaming(

message="Please help write a function to calculate the min of two numbers", **parameters)

for response in responses:

`print(response)`

Librerie client disponibili

Per trasmettere le risposte in streaming, puoi utilizzare una delle seguenti librerie client:

- Python

- Node.js

- Java

- Go

- C#

Per visualizzare richieste e risposte di codice di esempio che utilizzano l'API REST, consulta Esempi di utilizzo dell'API REST.

Per visualizzare richieste e risposte di codice di esempio che utilizzano l'SDK Vertex AI per Python, consulta Esempi di utilizzo dell'SDK Vertex AI per Python.

AI responsabile

I filtri di intelligenza artificiale responsabile (RAI) esaminano l'output in streaming man mano che viene generato dal modello. Se viene rilevata una violazione,

i filtri bloccano i token di output in violazione e restituiscono un output con un

indicatore di blocco in safetyAttributes, che termina lo stream.

Passaggi successivi

- Scopri di più sulla progettazione di prompt di testo e di prompt di chat di testo.

- Scopri come testare i prompt in Vertex AI Studio.

- Scopri di più sugli embedding di testo.

- Prova a ottimizzare un modello linguistico di base.

- Scopri le best practice per l'AI responsabile e i filtri di sicurezza di Vertex AI.