En Cloud Service Mesh 1.5 y versiones posteriores, la autenticación TLS mutua automática (mTLS automática) está habilitada de forma predeterminada. Con mTLS automático, un proxy sidecar del cliente detecta automáticamente si el servidor tiene un sidecar. El sidecar del cliente envía mTLS a las cargas de trabajo con sidecars y texto sin formato a las cargas de trabajo sin sidecars. Sin embargo, los servicios aceptan tráfico tanto de texto sin formato como de mTLS. A medida que insertes proxies sidecar en tus pods, te recomendamos que también configures tus servicios para que solo acepten tráfico mTLS.

Con Cloud Service Mesh, puedes aplicar mTLS fuera del código de tu aplicación aplicando un solo archivo YAML. Cloud Service Mesh te ofrece la flexibilidad necesaria para aplicar una política de autenticación a toda la malla de servicios, a un espacio de nombres o a una carga de trabajo concreta.

Acceder a Online Boutique

Define el contexto actual de

kubectlen el clúster en el que has desplegado Online Boutique:gcloud container clusters get-credentials CLUSTER_NAME \ --project=PROJECT_ID \ --zone=CLUSTER_LOCATIONMuestra los servicios del espacio de nombres

frontend:kubectl get services -n frontendObserva que

frontend-externales unLoadBalancery tiene una dirección IP externa. La aplicación de ejemplo incluye un servicio que es un balanceador de carga para que se pueda implementar en GKE sin Cloud Service Mesh.Visita la aplicación en tu navegador con la dirección IP externa del servicio

frontend-external:http://FRONTEND_EXTERNAL_IP/Cloud Service Mesh te permite desplegar una pasarela de entrada. También puedes acceder a Online Boutique mediante la dirección IP externa de la pasarela de entrada. Obtén la IP externa de la pasarela. Sustituye los marcadores de posición por la siguiente información:

- GATEWAY_SERVICE_NAME : nombre del servicio de pasarela de entrada. Si has implementado la pasarela de ejemplo sin modificarla o si has implementado la pasarela de entrada predeterminada, el nombre es

istio-ingressgateway. - GATEWAY_NAMESPACE: el espacio de nombres en el que has implementado la pasarela de entrada. Si has implementado la pasarela de entrada predeterminada, el espacio de nombres es

istio-system.

kubectl get service GATEWAY_NAME -n GATEWAY_NAMESPACE- GATEWAY_SERVICE_NAME : nombre del servicio de pasarela de entrada. Si has implementado la pasarela de ejemplo sin modificarla o si has implementado la pasarela de entrada predeterminada, el nombre es

Abre otra pestaña en el navegador y visita la aplicación con la dirección IP externa de la pasarela de entrada:

http://INGRESS_GATEWAY_EXTERNAL_IP/Ejecuta el siguiente comando para

curlel serviciofrontendcon HTTP sin cifrar desde otro pod. Como los servicios están en espacios de nombres diferentes, debes usar curl en el nombre DNS del serviciofrontend.kubectl debug --image istio/base --target istio-proxy -it \ $(kubectl get pod -l app=productcatalogservice -n product-catalog -o jsonpath={.items..metadata.name}) \ -n product-catalog -- \ curl http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Tu solicitud se ha completado correctamente con el estado

200porque, de forma predeterminada, se acepta tanto el tráfico TLS como el de texto sin cifrar.

Habilitar TLS mutuo por espacio de nombres

Para aplicar mTLS, debes aplicar una política PeerAuthentication con kubectl.

Guarda la siguiente política de autenticación como

mtls-namespace.yaml.cat <<EOF > mtls-namespace.yaml apiVersion: "security.istio.io/v1beta1" kind: "PeerAuthentication" metadata: name: "namespace-policy" spec: mtls: mode: STRICT EOFLa línea

mode: STRICTdel archivo YAML configura los servicios para que solo acepten mTLS. De forma predeterminada,modeesPERMISSIVE, lo que configura los servicios para que acepten tanto texto sin cifrar como mTLS.Aplica la política de autenticación para configurar todos los servicios de Online Boutique de forma que solo acepten mTLS:

for ns in ad cart checkout currency email frontend loadgenerator \ payment product-catalog recommendation shipping; do kubectl apply -n $ns -f mtls-namespace.yaml doneResultado esperado:

peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created peerauthentication.security.istio.io/namespace-policy created

Ve a la pestaña de tu navegador que accede a Online Boutique mediante la dirección IP externa del servicio

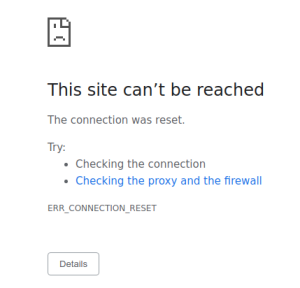

frontend-external:http://FRONTEND_EXTERNAL_IP/Actualiza la página. El navegador muestra el siguiente error:

Al actualizar la página, se envía texto sin formato al servicio

frontend. Debido a laSTRICTpolítica de autenticación, el proxy sidecar bloquea la solicitud al servicio.Ve a la pestaña del navegador que accede a Online Boutique mediante la dirección IP externa de

istio-ingressgatewayy actualiza la página, que se mostrará correctamente. Cuando accedes a Online Boutique mediante la puerta de enlace de entrada, la solicitud sigue esta ruta:Flujo de autenticación mTLS:

- El navegador envía una solicitud HTTP en texto sin cifrar al servidor.

- El contenedor proxy de la puerta de enlace de entrada intercepta la solicitud.

- El proxy de la pasarela de entrada realiza un handshake TLS con el proxy del lado del servidor (el servicio frontend en este ejemplo). Este handshake incluye un intercambio de certificados. Cloud Service Mesh precarga estos certificados en los contenedores proxy.

- El proxy de la pasarela de entrada realiza una comprobación de nombres segura en el certificado del servidor para verificar que una identidad autorizada esté ejecutando el servidor.

- La pasarela de entrada y los proxies del servidor establecen una conexión TLS mutua, y el proxy del servidor reenvía la solicitud al contenedor de la aplicación del servidor (el servicio frontend).

Ejecuta el siguiente comando para

curlel serviciofrontendcon HTTP sin cifrar desde otro pod.kubectl exec testcurl -n default -- curl \ http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Tu solicitud falla porque estamos enviando tráfico de texto sin formato desde una carga de trabajo sin sidecar en la que se aplica la política STRICT

peerAuthentication.

Buscar y eliminar políticas de autenticación

Para ver una lista de todas las políticas de

PeerAuthenticationen la malla de servicios, haz lo siguiente:kubectl get peerauthentication --all-namespacesEl resultado debería ser similar al siguiente:

NAMESPACE NAME MODE AGE ad namespace-policy STRICT 17m cart namespace-policy STRICT 17m checkout namespace-policy STRICT 17m currency namespace-policy STRICT 17m email namespace-policy STRICT 17m frontend namespace-policy STRICT 17m loadgenerator namespace-policy STRICT 17m payment namespace-policy STRICT 17m product-catalog namespace-policy STRICT 17m recommendation namespace-policy STRICT 17m shipping namespace-policy STRICT 17mElimina la política de autenticación de todos los espacios de nombres de Online Boutique:

for ns in ad cart checkout currency email frontend loadgenerator payment \ product-catalog recommendation shipping; do kubectl delete peerauthentication -n $ns namespace-policy done;Resultado esperado:

peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deleted peerauthentication.security.istio.io "namespace-policy" deletedAccede a Online Boutique con la dirección IP externa del servicio

frontend-externaly actualiza la página. La página se muestra como se espera.Ejecuta el siguiente comando para

curlel serviciofrontendcon HTTP sin cifrar desde otro pod.kubectl debug --image istio/base --target istio-proxy -it \ $(kubectl get pod -l app=productcatalogservice -n product-catalog -o jsonpath={.items..metadata.name}) \ -n product-catalog -- \ curl http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Tu solicitud se ha completado correctamente con el estado

200porque, de forma predeterminada, se acepta tanto el tráfico TLS como el de texto sin cifrar.

Si actualizas la página de la consola Google Cloud que muestra la lista Cargas de trabajo, ahora verás que el estado de mTLS es Permissive.

Habilitar TLS mutuo por carga de trabajo

Para definir una política de PeerAuthentication en una carga de trabajo específica, debe configurar la sección selector y especificar las etiquetas que coincidan con la carga de trabajo deseada.

Sin embargo, Cloud Service Mesh no puede agregar políticas a nivel de carga de trabajo para el tráfico mTLS saliente a un servicio. Para gestionar este comportamiento, debe configurar una regla de destino.

Aplica una política de autenticación a una carga de trabajo específica. Fíjate en cómo la siguiente política usa etiquetas y selectores para segmentar una

frontendimplementación específica.cat <<EOF | kubectl apply -n frontend -f - apiVersion: "security.istio.io/v1beta1" kind: "PeerAuthentication" metadata: name: "frontend" namespace: "frontend" spec: selector: matchLabels: app: frontend mtls: mode: STRICT EOFResultado esperado:

peerauthentication.security.istio.io/frontend created

Configura una regla de destino de coincidencia.

cat <<EOF | kubectl apply -n frontend -f - apiVersion: "networking.istio.io/v1alpha3" kind: "DestinationRule" metadata: name: "frontend" spec: host: "frontend.demo.svc.cluster.local" trafficPolicy: tls: mode: ISTIO_MUTUAL EOFResultado esperado:

destinationrule.networking.istio.io/frontend created

Accede a Online Boutique con la dirección IP externa del servicio

frontend-externaly actualiza la página. La página no se muestra porquefrontend serviceestá configurado comoSTRICTmTLS y el proxy sidecar bloquea la solicitud.Ejecuta el siguiente comando para

curlel serviciofrontendcon HTTP sin cifrar desde otro pod.kubectl exec testcurl -n default -- curl \ http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Tu solicitud falla porque estamos enviando tráfico de texto sin formato desde una carga de trabajo sin sidecar en la que se aplica la política STRICT

peerAuthentication.Elimina la política de autenticación:

kubectl delete peerauthentication -n frontend frontendResultado esperado:

peerauthentication.security.istio.io "frontend" deletedElimina la regla de destino:

kubectl delete destinationrule -n frontend frontendResultado esperado:

destinationrule.networking.istio.io "frontend" deleted

Implementar mTLS en toda la malla

Para evitar que todos los servicios de la malla acepten tráfico sin cifrar, define una PeerAuthentication política en toda la malla con el modo mTLS definido como STRICT.

La política PeerAuthentication de toda la malla no debe tener un selector y debe aplicarse en el espacio de nombres raíz, istio-system. Cuando implementas la política, el plano de control aprovisiona automáticamente certificados TLS para que las cargas de trabajo puedan autenticarse entre sí.

Implementa mTLS en toda la malla:

kubectl apply -f - <<EOF apiVersion: "security.istio.io/v1beta1" kind: "PeerAuthentication" metadata: name: "mesh-wide" namespace: "istio-system" spec: mtls: mode: STRICT EOFResultado esperado:

peerauthentication.security.istio.io/mesh-wide created

Accede a Online Boutique con la dirección IP externa del servicio

frontend-externaly actualiza la página. La página no se muestra.Ejecuta el siguiente comando para

curlel serviciofrontendcon HTTP sin cifrar desde otro pod.kubectl exec testcurl -n default -- curl \ http://frontend.frontend.svc.cluster.local:80/ -o /dev/null -s -w '%{http_code}\n'Tu solicitud falla porque estamos enviando tráfico de texto sin formato desde una carga de trabajo sin sidecar en la que se aplica la política STRICT

peerAuthentication.Elimina la política

mesh-wide:kubectl delete peerauthentication -n istio-system mesh-wideResultado esperado:

peerauthentication.security.istio.io "mesh-wide" deleted