Ce document explique comment créer et gérer des buckets Cloud Logging à l'aide de la console Google Cloud , de la CLI Google Cloud et de l'API Logging.

Il fournit également des instructions pour créer et gérer des buckets de journaux au niveau du projetGoogle Cloud . Vous ne pouvez pas créer de buckets de journaux au niveau du dossier ni de l'organisation. Toutefois, Cloud Logging crée automatiquement les buckets de journaux _Default et _Required au niveau du dossier et de l'organisation pour vous.

Vous pouvez mettre à niveau les buckets de journaux pour utiliser l'analyse de journaux. L'Analyse de journaux vous permet d'exécuter des requêtes SQL sur vos données de journaux, ce qui vous aide à résoudre les problèmes liés aux applications, à la sécurité et au réseau.

Pour utiliser BigQuery afin d'analyser vos données de journaux, vous avez deux possibilités :

Mettez à niveau un bucket de journaux pour utiliser l'Analyse de journaux, puis créez un ensemble de données BigQuery associé. Dans ce scénario, Logging stocke vos données de journaux, mais BigQuery peut les lire.

Exporter vos entrées de journaux vers BigQuery Dans ce scénario, vous devez créer un récepteur. BigQuery stocke et gère les données, et vous avez la possibilité d'utiliser des tables partitionnées.

Lorsque vos données de journaux sont disponibles dans BigQuery, vous pouvez les associer à d'autres données stockées dans BigQuery. Vous pouvez également accéder à ces données depuis d'autres outils tels que Looker Studio et Looker.

Pour obtenir une présentation des concepts liés aux buckets, consultez la page Présentation du routage et du stockage : buckets de journaux.

Ce document ne décrit pas comment créer un bucket de journaux qui utilise une clé de chiffrement gérée par le client (CMEK). Si ce sujet vous intéresse, consultez Configurer des clés CMEK pour le stockage des journaux.

Avant de commencer

Pour faire vos premiers pas avec les buckets, procédez comme suit :

- Configurez votre projet Google Cloud :

-

Verify that billing is enabled for your Google Cloud project.

-

Pour obtenir les autorisations nécessaires pour créer, mettre à niveau et associer un bucket de journaux, demandez à votre administrateur de vous accorder le rôle IAM Rédacteur de configuration des journaux (

roles/logging.configWriter) sur votre projet. Pour en savoir plus sur l'attribution de rôles, consultez la page Gérer l'accès aux projets, aux dossiers et aux organisations.Vous pouvez également obtenir les autorisations requises avec des rôles personnalisés ou d'autres rôles prédéfinis.

Pour obtenir la liste complète des autorisations et des rôles, consultez Contrôle des accès avec IAM.

- Facultatif : Pour utiliser BigQuery afin d'afficher les données stockées dans un bucket de journaux, procédez comme suit :

- Assurez-vous que l'API BigQuery est activée. Vous pouvez vérifier que l'API est activée en listant les services disponibles.

- Votre rôle Identity and Access Management inclut les autorisations qui vous permettent de créer un ensemble de données associé. Pour en savoir plus, consultez Autorisations pour les ensembles de données BigQuery associés.

-

- Familiarisez-vous avec les régions disponibles dans lesquelles vous pouvez stocker vos journaux.

-

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

REST

Pour utiliser les exemples API REST de cette page dans un environnement de développement local, vous devez utiliser les identifiants que vous fournissez à la gcloud CLI.

Installez la Google Cloud CLI. Une fois que la Google Cloud CLI est installée, initialisez-la en exécutant la commande suivante :

gcloud initSi vous utilisez un fournisseur d'identité (IdP) externe, vous devez d'abord vous connecter à la gcloud CLI avec votre identité fédérée.

Pour en savoir plus, consultez la section S'authentifier pour utiliser REST dans la documentation sur l'authentification Google Cloud .

- Si vous prévoyez d'utiliser la Google Cloud CLI ou l'API Cloud Logging pour créer ou gérer vos buckets de journaux, vous devez comprendre les exigences de formatage

LogBucket.Créer un bucket

Vous pouvez créer au maximum 100 buckets par projetGoogle Cloud .

Pour créer un bucket de journaux défini par l'utilisateur pour votre projet Google Cloud , procédez comme suit :

Console Google Cloud

Pour créer un bucket de journaux dans votre projet Google Cloud , procédez comme suit :

-

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Cliquez sur Créer un bucket de journaux.

Saisissez un Nom et une Description pour votre bucket.

Facultatif : Mettez à niveau votre bucket pour utiliser l'Analyse de journaux.

Sélectionnez Effectuez la mise à niveau pour utiliser l'Analyse de journaux.

Lorsque vous mettez à niveau un bucket pour utiliser l'analyse de journaux, vous pouvez interroger vos journaux sur la page Analyse de journaux à l'aide de requêtes SQL. Vous pouvez également continuer à afficher vos journaux à l'aide de l'explorateur de journaux.

Facultatif : Pour afficher vos journaux dans BigQuery, sélectionnez Créer un ensemble de données BigQuery lié à ce bucket et saisissez un nom d'ensemble de données unique.

Lorsque vous sélectionnez cette option, BigQuery peut lire les données stockées dans votre bucket de journaux. Vous pouvez désormais effectuer des requêtes dans l'interface BigQuery, où vous pouvez joindre vos données de journaux et accéder aux données d'autres outils tels que Looker Studio et Looker.

Facultatif : Pour sélectionner la région de stockage de vos journaux, cliquez sur le menu Sélectionner la région du bucket de journaux et sélectionnez une région. Si vous ne sélectionnez pas de région, la région

globalest utilisée, ce qui signifie que les journaux peuvent se trouver physiquement dans n'importe quelle région compatible.Facultatif : Pour définir une durée de conservation personnalisée pour les journaux du bucket, cliquez sur Suivant.

Dans le champ Durée de conservation, saisissez le nombre de jours (compris entre 1 et 3 650 jours) pendant lesquels vous souhaitez que Cloud Logging conserve vos journaux. Si vous ne personnalisez pas la durée de conservation, la valeur par défaut est

30 days.Vous pouvez également mettre à jour votre bucket pour appliquer une conservation personnalisée après sa création.

Cliquez sur Créer un bucket.

Une fois le bucket de journaux créé, la journalisation met à niveau le bucket et crée le lien vers l'ensemble de données, si ces options ont été sélectionnées.

L'exécution de ces étapes peut prendre un moment.

gcloud

Pour créer un bucket de journaux uniquement, exécutez la commande

gcloud logging buckets create. Si vous souhaitez mettre à niveau le bucket de journaux pour utiliser l'Analyse de journaux, incluez les indicateurs--enable-analyticset--async, et assurez-vous de définir la variable LOCATION sur une région acceptée :gcloud logging buckets create BUCKET_ID --location=LOCATION --enable-analytics --async OPTIONAL_FLAGS

L'option

--asyncforce la commande à être asynchrone. Le retour d'une méthode asynchrone est un objetOperation. Il contient des informations sur la progression de la méthode. Une fois la méthode terminée, l'objetOperationcontient l'état. Pour en savoir plus, consultez Méthodes d'API asynchrones.Si vous ne souhaitez pas mettre à niveau le bucket de journaux pour utiliser l'Analyse de journaux, omettez les indicateurs

--enable-analyticset--async.Par exemple, si vous souhaitez créer un bucket avec l'élément BUCKET_ID

my-bucketdans la régionglobal, votre commande se présente comme suit :gcloud logging buckets create my-bucket --location global --description "My first bucket"

Par exemple, pour créer un bucket avec l'élément BUCKET_ID

my-upgraded-bucketdans l'emplacementglobal, puis mettre à niveau le bucket de journaux pour utiliser l'analyse de journaux, votre commande se présente comme suit :gcloud logging buckets create my-upgraded-bucket --location global \ --description "My first upgraded bucket" \ --enable-analytics --retention-days=45REST

Pour créer un bucket, utilisez la méthode

projects.locations.buckets.createouprojects.locations.buckets.createAsync. Préparez les arguments de la méthode comme suit :Définissez le paramètre

parentsur la ressource dans laquelle créer le bucket :projects/PROJECT_ID/locations/LOCATIONLa variable LOCATION fait référence à la région dans laquelle vous souhaitez stocker vos journaux.

Par exemple, si vous souhaitez créer un bucket pour le projet

my-projectdans la régionglobal, votre paramètreparentse présentera comme suit :projects/my-project/locations/global.Définissez le paramètre

bucketId(par exemple,my-bucket).Effectuez l'une des opérations suivantes :

Pour créer un bucket de journaux, puis le mettre à niveau pour utiliser l'Analyse de journaux :

Définissez le booléen

LogBucket.analyticsEnabledsurtrue.Appelez la méthode asynchrone

projects.locations.buckets.createAsyncpour créer le bucket.La réponse aux méthodes asynchrones est un objet

Operation. Cet objet contient des informations sur la progression de la méthode. Une fois la méthode terminée, l'objetOperationcontient l'état. Pour en savoir plus, consultez Méthodes d'API asynchrones.L'exécution de la méthode

createAsyncprend plusieurs minutes. Cette méthode ne génère pas de message d'erreur ni n'échoue lorsque le booléenanalyticsEnabledest défini surtrue.

Sinon, appelez la méthode synchrone

projects.locations.buckets.createpour créer le bucket.

Après avoir créé un bucket, créez un récepteur pour y acheminer les entrées de journal et configurez les vues des journaux pour contrôler les utilisateurs autorisés à accéder aux journaux de votre nouveau bucket et les journaux qu'ils peuvent consulter. Vous pouvez également mettre à jour le bucket pour configurer la conservation personnalisée et les champs restreints.

Suivre le volume de journaux stockés dans les buckets de journaux

La page Stockage des journaux de la console Google Cloud permet de suivre le volume des données de journaux stockées dans les buckets de journaux :

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

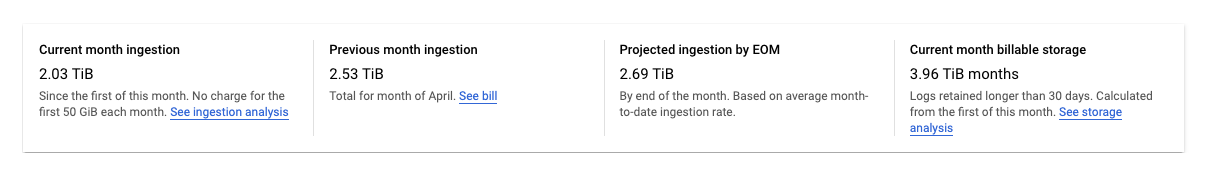

La page Stockage des journaux affiche un récapitulatif des statistiques de votre projetGoogle Cloud :

Les statistiques suivantes sont consignées :

Ingestion du mois en cours : quantité de données de journaux stockées par votre projetGoogle Cloud dans des buckets de journaux depuis le premier jour du mois civil en cours.

Ingestion du mois précédent : quantité de données de journaux stockées par votre projetGoogle Cloud dans des buckets de journaux au cours du dernier mois civil.

Ingestion prévue à la fin du mois : quantité estimée de données de journaux que votre projetGoogle Cloud stockera dans des buckets de journaux à la fin du mois calendaire en cours, en fonction de l'utilisation actuelle.

Stockage facturable du mois en cours : quantité de données de journaux conservées pendant plus de 30 jours et facturées.

Les statistiques précédentes n'incluent pas les journaux du bucket

_Required. Les journaux de ce bucket ne peuvent pas être exclus ni désactivés.La page Routeur de journaux de la console Google Cloud vous fournit des outils permettant de réduire les frais de stockage de journaux dans des buckets de journaux ou de stockage dépassant votre attribution mensuelle. Vous pouvez procéder comme suit :

- Désactivez le stockage des journaux au niveau du bucket.

- Excluez certaines entrées de journal du stockage dans les buckets de journaux.

Pour en savoir plus, consultez la page Gérer les récepteurs.

Gérer les buckets

Cette section explique comment gérer vos buckets de journaux à l'aide de la Google Cloud CLI ou de la console Google Cloud .

Mettre à jour un bucket

Pour mettre à jour les propriétés de votre bucket, telles que la description ou la durée de conservation, procédez comme suit :Console Google Cloud

Pour mettre à jour les propriétés de votre bucket, procédez comme suit :

-

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Cliquez sur l'élément more_vert Plus correspondant au bucket que vous souhaitez mettre à jour.

Cliquez sur Modifier le bucket.

Modifiez votre bucket comme désiré.

Cliquez sur Mettre à jour le bucket.

gcloud

Pour mettre à jour les propriétés de votre bucket, exécutez la commande

gcloud logging buckets update:gcloud logging buckets update BUCKET_ID --location=LOCATION UPDATED_ATTRIBUTES

Exemple :

gcloud logging buckets update my-bucket --location=global --description "Updated description"

REST

Pour mettre à jour les propriétés de votre bucket, utilisez

projects.locations.buckets.patchdans l'API Logging.Mettre à niveau un bucket pour utiliser l'Analyse de journaux

Une fois que vous avez mis à niveau un bucket pour utiliser l'Analyse de journaux, toutes les nouvelles entrées de journal qui arrivent peuvent être analysées dans l'interface de l'Analyse de journaux. Cloud Logging lance également une opération de remplissage, qui vous permet d'analyser les anciennes entrées de journal écrites avant la mise à niveau. Le processus de remplissage peut prendre plusieurs heures. Vous ne pouvez pas annuler une opération de mise à niveau d'un bucket.

Pour mettre à niveau un bucket existant afin qu'il utilise l'Analyse de journaux, les restrictions suivantes s'appliquent :

- Le bucket de journaux a été créé au niveau du projet Google Cloud .

- Le bucket de journaux est déverrouillé, sauf s'il s'agit du bucket

_Required. Aucune mise à jour n'est en attente pour le bucket.

Console Google Cloud

Pour mettre à niveau un bucket existant afin qu'il utilise l'Analyse de journaux :

-

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Localisez le bucket que vous souhaitez mettre à niveau.

Lorsque la colonne Analyse de journaux disponible affiche Mettre à niveau, vous pouvez mettre à niveau le bucket de journaux pour utiliser l'Analyse de journaux. Cliquez sur S'abonner.

Une boîte de dialogue s'ouvre. Cliquez sur Confirmer.

gcloud

Pour mettre à niveau votre bucket de journaux afin d'utiliser l'Analyse de journaux, exécutez la commande

gcloud logging buckets update. Vous devez définir l'option--enable-analytics. Nous vous recommandons également d'inclure l'option--async:gcloud logging buckets update BUCKET_ID --location=LOCATION --enable-analytics --async

L'option

--asyncforce la commande à être asynchrone. Le retour d'une méthode asynchrone est un objetOperation, qui contient des informations sur la progression de la méthode. Une fois la méthode terminée, l'objetOperationcontient l'état. Pour en savoir plus, consultez Méthodes d'API asynchrones.REST

Pour mettre à niveau un bucket de journaux afin qu'il utilise l'analyse de journaux, utilisez la méthode

projects.locations.buckets.updateAsyncde l'API Cloud Logging.Préparez les arguments de la méthode comme suit :

- Définissez le booléen

LogBucket.analyticsEnabledsurtrue. - Pour le paramètre de requête de la commande, utilisez

updateMask=analyticsEnabled.

La réponse aux méthodes asynchrones est un objet

Operation. Cet objet contient des informations sur la progression de la méthode. Une fois la méthode terminée, l'objetOperationcontient l'état. Pour en savoir plus, consultez Méthodes d'API asynchrones.L'

updateAsyncpeut prendre plusieurs minutes.Créer un ensemble de données BigQuery associé

Si vous souhaitez utiliser les fonctionnalités de BigQuery pour analyser vos données de journaux, mettez à niveau un bucket de journaux pour utiliser l'Analyse de journaux, puis créez un ensemble de données associé. Avec cette configuration, Logging stocke vos données de journaux, mais BigQuery peut les lire.

Console Google Cloud

Pour créer un lien vers un ensemble de données BigQuery pour un bucket de journaux existant, procédez comme suit :

-

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Localisez le bucket de journaux et vérifiez que la colonne Analyse de journaux disponible affiche Ouvrir.

Si la colonne affiche Mettre à niveau, cela signifie que le bucket de journaux n'a pas été mis à niveau pour utiliser l'Analyse de journaux. Configurer l'analyse de journaux :

- Cliquez sur Mettre à niveau.

- Cliquez sur Confirmer dans la boîte de dialogue.

Une fois la mise à niveau terminée, passez à l'étape suivante.

Sur le bucket de journaux, cliquez sur Plusmore_vert, puis sur Modifier le bucket.

La boîte de dialogue Modifier le bucket de journaux s'ouvre.

Sélectionnez Créer un ensemble de données BigQuery associé à ce bucket, puis saisissez le nom du nouvel ensemble de données.

Le nom de l'ensemble de données doit être unique pour chaque Google Cloud projet. Si vous saisissez le nom d'un ensemble de données existant, l'erreur suivante s'affiche :

Dataset name must be unique in the selected region.Cliquez sur OK, puis sur Mettre à jour le bucket.

Une fois que Logging affiche le nom de l'ensemble de données associé sur la page Stockage des journaux, BigQuery peut mettre plusieurs minutes à reconnaître l'ensemble de données.

gcloud

Pour créer un ensemble de données associé pour un bucket de journaux mis à niveau afin d'utiliser l'analyse de journaux, exécutez la commande

gcloud logging links create:gcloud logging links create LINK_ID --bucket=BUCKET_ID --location=LOCATION

Le LINK_ID que vous fournissez est utilisé comme nom de l'ensemble de données BigQuery. La valeur de ce champ doit être unique pour votre projet Google Cloud .

La commande

links createest asynchrone. Le retour d'une méthode asynchrone est un objetOperation, qui contient des informations sur la progression de la méthode. Une fois la méthode terminée, l'objetOperationcontient l'état. Pour en savoir plus, consultez Méthodes d'API asynchrones.L'exécution de la commande

links createprend plusieurs minutes.Par exemple, la commande suivante crée un ensemble de données associé nommé

mylinkpour le bucket de journaux nommémy-bucket:gcloud logging links create mylink --bucket=my-bucket --location=global

Le nom de l'ensemble de données doit être unique pour chaque Google Cloud projet. Si vous essayez de créer un ensemble de données portant le même nom qu'un ensemble de données existant, l'erreur suivante s'affiche :

BigQuery dataset with name "LINK_ID" already exists.Si vous tentez de créer un ensemble de données associé pour un bucket de journaux qui n'a pas été mis à niveau pour utiliser l'Analyse de journaux, l'erreur suivante s'affiche :

A link can only be created for an analytics-enabled bucket.REST

Pour créer un ensemble de données BigQuery associé pour un bucket de journaux existant qui a été mis à niveau pour utiliser l'analyse de journaux, appelez la méthode asynchrone

projects.locations.buckets.links.createde l'API Cloud Logging.Préparez les arguments de la méthode comme suit :

- Créez le corps de la requête pour la commande

create. Le corps de la requête est mis en forme en tant qu'objetLink. - Pour le paramètre de requête de la commande, utilisez

linkId=LINK_ID. Le LINK_ID que vous fournissez est utilisé comme nom de l'ensemble de données BigQuery. La valeur de ce champ doit être unique pour votre projet Google Cloud .

La réponse aux méthodes asynchrones est un objet

Operation. Cet objet contient des informations sur la progression de la méthode. Une fois la méthode terminée, l'objetOperationcontient l'état. Pour en savoir plus, consultez Méthodes d'API asynchrones.L'exécution de la méthode

links.createprend plusieurs minutes.Le nom de l'ensemble de données doit être unique pour chaque Google Cloud projet. Si vous essayez de créer un ensemble de données portant le même nom qu'un ensemble de données existant, l'erreur suivante s'affiche :

BigQuery dataset with name "LINK_ID" already exists.Si vous tentez de créer un ensemble de données associé pour un bucket de journaux qui n'a pas été mis à niveau pour utiliser l'Analyse de journaux, l'erreur suivante s'affiche :

A link can only be created for an analytics-enabled bucket.Verrouiller un bucket

Lorsque vous verrouillez les mises à jour pour un bucket, vous verrouillez également la règle de conservation du bucket. Une fois qu'une règle de conservation est verrouillée, vous ne pouvez pas supprimer le bucket tant que la durée de conservation de ce dernier n'a pas été atteinte pour toutes les entrée de journal qu'il contient. Si vous souhaitez éviter la suppression accidentelle d'un projet contenant un bucket de journaux verrouillé, ajoutez un privilège au projet. Pour en savoir plus, consultez Protéger les projets à l'aide de privilèges.

Pour empêcher toute personne de mettre à jour ou de supprimer un bucket de journaux, verrouillez-le. Pour verrouiller le bucket, procédez comme suit :

Console Google Cloud

La console Google Cloud ne permet pas de verrouiller un bucket de journaux.

gcloud

Pour verrouiller votre bucket, exécutez la commande

gcloud logging buckets updateavec l'indicateur--locked:gcloud logging buckets update BUCKET_ID --location=LOCATION --locked

Exemple :

gcloud logging buckets update my-bucket --location=global --locked

REST

Pour verrouiller les attributs de votre bucket, utilisez

projects.locations.buckets.patchdans l'API Logging. Définissez le paramètrelockedsurtrue.Répertorier les buckets

Pour répertorier les buckets de journaux associés à un projet Google Cloud et afficher des détails tels que les paramètres de conservation, procédez comme suit :

Console Google Cloud

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Un tableau intitulé Buckets de journaux liste les buckets associés au projetGoogle Cloud actuel.

La table répertorie les attributs suivants pour chaque bucket de journaux :

- Nom : nom du bucket de journaux.

- Description : description du bucket.

- Durée de conservation : nombre de jours pendant lesquels les données du bucket seront stockées par Cloud Logging.

- Région : emplacement géographique où les données du bucket sont stockées.

- État : indique si le bucket est verrouillé ou non.

Si un bucket est en attente de suppression par Cloud Logging, son entrée de table est annotée avec un symbole d'warning avertissement.

gcloud

Exécutez la commande

gcloud logging buckets list:gcloud logging buckets list

Les attributs suivants s'affichent pour les buckets de journaux :

LOCATION: région dans laquelle les données du bucket sont stockées.BUCKET_ID: nom du bucket de journaux.RETENTION_DAYS: nombre de jours pendant lesquels les données du bucket seront stockées par Cloud Logging.LIFECYCLE_STATE: indique si le bucket est en attente de suppression par Cloud Logging.LOCKED: indique si le bucket est verrouillé ou non.CREATE_TIME: horodatage indiquant la date de création du bucket.UPDATE_TIME: horodatage indiquant la date de la dernière modification du bucket.

Vous pouvez également afficher les attributs d'un seul bucket. Par exemple, pour afficher les détails du bucket de journaux

_Defaultdans la régionglobal, exécutez la commandegcloud logging buckets describe:gcloud logging buckets describe _Default --location=global

REST

Pour répertorier les buckets de journaux associés à un projet Google Cloud , utilisez

projects.locations.buckets.listdans l'API Logging.Afficher les détails d'un bucket

Pour afficher les détails d'un seul bucket de journaux, procédez comme suit :

Console Google Cloud

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Dans le bucket de journaux, cliquez sur more_vert Plus, puis sélectionnez Afficher les détails du bucket.

La boîte de dialogue répertorie les attributs suivants pour le bucket de journaux :

- Nom : nom du bucket de journaux.

- Description : description du bucket de journaux.

- Durée de conservation : nombre de jours pendant lesquels les données du bucket seront stockées par Cloud Logging.

- Région : emplacement géographique où les données du bucket sont stockées.

- Analyse de journaux : indique si votre bucket a été mis à niveau pour utiliser l'Analyse de journaux.

- Analyse BigQuery : indique si un ensemble de données BigQuery est associé à votre bucket.

- Ensemble de données BigQuery : fournit un lien vers votre ensemble de données BigQuery, qui s'ouvre sur la page BigQuery Studio. La date à laquelle l'association à BigQuery a été activée est également indiquée.

gcloud

Exécutez la commande

gcloud logging buckets describe.Par exemple, la commande suivante affiche les détails du bucket

_Default:gcloud logging buckets describe _Default --location=global

Les attributs suivants s'affichent pour le bucket de journaux :

createTime: horodatage indiquant la date de création du bucket.description: description du bucket de journaux.lifecycleState: indique si le bucket est en attente de suppression par Cloud Logging.name: nom du bucket de journaux.retentionDays: nombre de jours pendant lesquels les données du bucket seront stockées par Cloud Logging.updateTime: horodatage indiquant la date de la dernière modification du bucket.

REST

Pour afficher les détails d'un seul bucket de journaux, utilisez

projects.locations.buckets.getdans l'API Logging.Supprimer un bucket

Vous pouvez supprimer les buckets de journaux qui répondent à l'un des critères suivants :

- Le bucket de journaux est déverrouillé.

- Le bucket de journaux est verrouillé et toutes les entrées de journal qu'il contient ont atteint la durée de conservation du bucket.

Vous ne pouvez pas supprimer un bucket de journaux verrouillé contre les mises à jour lorsqu'il stocke des entrées de journaux qui n'ont pas atteint la date limite de conservation du bucket.

Une fois la commande de suppression émise, le bucket de journaux passe à l'état

DELETE_REQUESTED, dans lequel il reste pendant sept jours. Pendant cette période, Logging continue d'acheminer les journaux vers le bucket de journaux. Pour arrêter l'acheminement des journaux vers le bucket de journaux, supprimez ou modifiez les récepteurs de journaux qui acheminent les entrées de journaux vers le bucket.Vous ne pouvez pas créer de bucket de journaux portant le même nom qu'un bucket de journaux à l'état

DELETE_REQUESTED.Pour supprimer un bucket de journaux, procédez comme suit :

Console Google Cloud

Pour supprimer un bucket de journaux, procédez comme suit :

-

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Recherchez le bucket que vous souhaitez supprimer, puis cliquez sur more_vertPlus.

Si la colonne Ensemble de données associé dans BigQuery affiche un lien, supprimez l'ensemble de données BigQuery associé :

Cliquez sur Modifier le bucket.

Décochez Créer un ensemble de données BigQuery associé à ce bucket, cliquez sur OK, puis sur Mettre à jour le bucket.

Une fois de retour sur la page Stockage des journaux, cliquez sur more_vertPlus pour le bucket que vous souhaitez supprimer, puis passez aux étapes suivantes.

Cliquez sur Supprimer le bucket.

Dans le panneau de confirmation, cliquez sur Supprimer.

Sur la page Stockage des journaux, un indicateur spécifie que votre bucket est en attente de suppression. Le bucket, y compris tous les journaux qu'il contient, est supprimé au bout de sept jours.

gcloud

Pour supprimer un bucket de journaux, exécutez la commande

gcloud logging buckets delete:gcloud logging buckets delete BUCKET_ID --location=LOCATION

Vous ne pouvez pas supprimer un bucket de journaux lorsqu'il est associé à un ensemble de données BigQuery :

- Pour lister les liens associés à un bucket de journaux, exécutez la commande

gcloud logging links list. - Pour supprimer un ensemble de données associé, exécutez la commande

gcloud logging links delete.

REST

Pour supprimer un bucket, utilisez

projects.locations.buckets.deletedans l'API Logging.La suppression d'un bucket de journaux est une erreur si ce bucket est associé à un ensemble de données BigQuery. Vous devez supprimer l'ensemble de données associé avant de supprimer le bucket de journaux :

- Pour lister les liens associés à un bucket de journaux, exécutez la méthode

projects.locations.buckets.links.list. - Pour supprimer un ensemble de données associé, exécutez la méthode

projects.locations.buckets.links.delete.

Restaurer un bucket supprimé

Vous pouvez restaurer, c'est-à-dire annuler la suppression d'un bucket de journaux dont l'état est "en attente de suppression". Pour restaurer un bucket de journaux, procédez comme suit :

Console Google Cloud

Pour restaurer un bucket de journaux en attente de suppression, procédez comme suit :

-

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Pour le bucket que vous souhaitez restaurer, cliquez sur more_vert Plus, puis sélectionnez Restaurer un bucket supprimé.

Dans le panneau de confirmation, cliquez sur Restaurer.

Sur la page Stockage des journaux, l'indicateur de suppression en attente est retiré de votre bucket de journaux.

gcloud

Pour restaurer un bucket de journaux en attente de suppression, exécutez la commande

gcloud logging buckets undelete:gcloud logging buckets undelete BUCKET_ID --location=LOCATION

REST

Pour restaurer un bucket en attente de suppression, utilisez

projects.locations.buckets.undeletedans l'API Logging.Alerte sur les octets de journaux mensuels stockés dans les buckets de journaux

Pour créer une règle d'alerte, sur la page Stockage des journaux de la consoleGoogle Cloud , cliquez sur add_alert Créer une alerte d'utilisation. Ce bouton ouvre la page Créer une règle d'alerte dans Monitoring et remplit le champ du type de métrique avec

logging.googleapis.com/billing/bytes_ingested.Pour créer une règle d'alerte qui se déclenche lorsque le nombre d'octets de journaux écrits dans vos buckets de journaux dépasse la limite définie par l'utilisateur pour Cloud Logging, utilisez les paramètres suivants.

ChampNouvelle condition

ValeurRessource et métrique Dans le menu Ressources, sélectionnez Global.

Dans le menu Catégories de métriques, sélectionnez Métrique basée sur les journaux.

Dans le menu Métriques, sélectionnez Octets de journaux ingérés par mois.Filter Aucun Dans toutes les séries temporelles

Agrégation de séries temporellessum

Fenêtre glissante 60 m

Fenêtrage glissant maxChamp Configurer le déclencheur d'alerte

ValeurType de condition ThresholdDéclencheur d'alerte Any time series violatesPosition du seuil Above thresholdValeur du seuil Vous définissez la valeur acceptable. Fenêtre du nouveau test La valeur minimale acceptable est de 30 minutes. Pour en savoir plus sur les règles d'alerte, consultez la page Présentation des alertes.

Écrire dans un bucket

Vous n'écrivez pas directement de journaux dans un bucket de journaux. Vous écrivez plutôt des journaux sur une ressourceGoogle Cloud : un projet, un dossier ou une organisation Google Cloud . Les récepteurs de la ressource parente acheminent ensuite les journaux vers les destinations, dont les buckets de journaux. Un récepteur achemine les journaux vers une destination de bucket de journaux lorsque les journaux correspondent au filtre du récepteur et que celui-ci est autorisé à acheminer les journaux vers le bucket de journaux.

Lire des données à partir d'un bucket

Chaque bucket de journaux possède un ensemble de vues de journaux. Pour lire les journaux d'un bucket de journaux, vous devez avoir accès à une vue de journaux sur le bucket. Les vues de journaux vous permettent d'accorder à un utilisateur l'accès à un sous-ensemble seulement des journaux stockés dans un bucket de journaux. Pour savoir comment configurer des vues de journaux et accorder l'accès à des vues de journaux spécifiques, consultez Configurer des vues de journaux dans un bucket de journaux.

Pour lire les journaux d'un bucket de journaux, procédez comme suit :

Console Google Cloud

-

Dans la console Google Cloud , accédez à la page Explorateur de journaux.

Accéder à l'explorateur de journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Pour personnaliser les journaux affichés dans l'explorateur de journaux, cliquez sur Affiner le champ d'application, puis sélectionnez une option. Par exemple, vous pouvez afficher les journaux stockés dans un projet ou par vue de journal.

Cliquez sur Appliquer. Le volet Résultats de la requête est actualisé avec les journaux correspondant à l'option que vous avez sélectionnée.

Pour en savoir plus, consultez Présentation de l'explorateur de journaux : affiner le champ d'application.

gcloud

Pour lire les journaux d'un bucket de journaux, utilisez la commande

gcloud logging readet ajoutez unLOG_FILTERpour sélectionner les données :gcloud logging read LOG_FILTER --bucket=BUCKET_ID --location=LOCATION --view=LOG_VIEW_ID

REST

Pour lire les journaux d'un bucket de journaux, utilisez la méthode entries.list. Définissez

resourceNamespour spécifier le bucket et la vue de journaux appropriés, et définissezfilterpour sélectionner les données.Pour en savoir plus sur la syntaxe de filtrage, consultez la page Langage de requête Logging.

Configurer la conservation personnalisée

Lorsque vous créez un bucket de journaux, vous avez la possibilité de personnaliser la période pendant laquelle Cloud Logging stocke les journaux du bucket. Vous pouvez configurer la durée de conservation de n'importe quel bucket de journaux défini par l'utilisateur, ainsi que celle du bucket de journaux

_Default. Vous ne pouvez pas modifier la durée de conservation du bucket de journaux_Required.Si vous raccourcissez la durée de conservation d'un bucket, un délai de grâce de sept jours est accordé pendant lequel les journaux expirés ne sont pas supprimés. Vous ne pouvez pas interroger ni afficher ces journaux expirés, mais vous pouvez restaurer l'accès complet dans les sept jours en prolongeant la période de conservation du bucket. Les journaux stockés pendant le délai de grâce sont comptabilisés dans vos frais de conservation.

L'application de la conservation est un processus cohérent à terme. Si vous écrivez des entrées de journal dans un bucket de journaux alors qu'elles sont antérieures à la période de conservation du bucket, vous pourrez peut-être les voir brièvement. Par exemple, si vous envoyez des entrées de journal datant de 10 jours dans un bucket de journaux avec une période de conservation de 7 jours, ces entrées de journal sont stockées, puis supprimées définitivement. Ces entrées de journal ne contribuent pas à vos coûts de conservation. Ils contribuent à vos coûts de stockage. Pour réduire vos coûts de stockage, n'écrivez pas d'entrées de journal antérieures à la durée de conservation de votre bucket.

Pour mettre à jour la durée de conservation d'un bucket de journaux personnalisé ou du bucket de journaux

_Default, procédez comme suit :Console Google Cloud

Pour mettre à jour la durée de conservation d'un bucket de journaux, procédez comme suit :

-

Dans la console Google Cloud , accédez à la page Stockage des journaux :

Accéder à la page Stockage des journaux

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Logging.

Pour le bucket que vous souhaitez mettre à jour, cliquez sur more_vert Plus, puis sélectionnez Modifier le bucket.

Dans le champ Conservation, saisissez le nombre de jours (compris entre 1 et 3 650 jours) pendant lesquels vous souhaitez que Cloud Logging conserve vos journaux.

Cliquez sur Mettre à jour le bucket. Votre nouvelle durée de conservation apparaît dans la liste Bucket de journaux.

gcloud

Pour mettre à jour la durée de conservation d'un bucket de journaux, exécutez la commande

gcloud logging buckets update, après avoir défini une valeur pour RETENTION_DAYS :gcloud logging buckets update BUCKET_ID --location=LOCATION --retention-days=RETENTION_DAYS

Par exemple, pour conserver les journaux dans le bucket

_Defaultdans l'emplacementglobalpendant un an, votre commande se présentera comme suit :gcloud logging buckets update _Default --location=global --retention-days=365

Si vous prolongez la durée de conservation d'un bucket, les règles de conservation ne s'appliquent pas de façon rétroactive. Les journaux ne peuvent pas être récupérés après la fin de leur période de conservation spécifique.

Méthodes d'API asynchrones

La réponse d'une méthode asynchrone telle que

projects.locations.buckets.createAsyncest un objetOperation.Les applications qui appellent une méthode API asynchrone doivent interroger le point de terminaison

operation.getjusqu'à ce que la valeur du champOperation.donesoittrue:Lorsque l'état

doneest défini surfalse, l'opération est en cours.Pour actualiser les informations d'état, envoyez une requête

GETau point de terminaisonoperation.get.Lorsque

doneest défini surtrue, l'opération est terminée et le champerrorouresponseest défini:error: si défini, l'opération asynchrone a échoué. La valeur de ce champ est un objetStatusqui contient un code d'erreur gRPC et un message d'erreur.response: si défini, l'opération asynchrone est terminée et la valeur reflète le résultat.

Pour interroger une commande asynchrone à l'aide de Google Cloud CLI, exécutez la commande suivante :

gcloud logging operations describe OPERATION_ID --location=LOCATION --project=PROJECT_ID

Pour en savoir plus, consultez la page

gcloud logging operations describe.Résoudre les problèmes courants

Si vous rencontrez des problèmes lors de l'utilisation des buckets de journaux, reportez-vous aux étapes de dépannage suivantes et aux réponses aux questions courantes.

Pourquoi ne puis-je pas supprimer ce bucket ?

Si vous essayez de supprimer un bucket, procédez comme suit :

Vérifiez que vous disposez des autorisations appropriées pour supprimer le bucket. Pour obtenir la liste des autorisations dont vous avez besoin, consultez Contrôle des accès avec IAM.

Déterminez si le bucket est verrouillé en répertoriant les attributs du bucket. Si le bucket est verrouillé, vérifiez sa durée de conservation. Vous ne pouvez pas supprimer un bucket verrouillé tant que tous les journaux qu'il contient n'ont pas atteint la date limite de conservation du bucket.

Vérifiez que le bucket de journaux n'est pas associé à un ensemble de données BigQuery. Vous ne pouvez pas supprimer un bucket de journaux associé à un ensemble de données.

L'erreur suivante s'affiche en réponse à une commande

deletesur un bucket de journaux associé à un ensemble de données :FAILED_PRECONDITION: This bucket is used for advanced analytics and has an active link. The link must be deleted first before deleting the bucket

Pour lister les liens associés à un bucket de journaux, exécutez la commande

gcloud logging links listou la méthode d'APIprojects.locations.buckets.links.list.

Quels comptes de service acheminent les journaux vers mon bucket ?

Pour déterminer si des comptes de service disposent d'autorisations IAM pour acheminer les journaux vers votre bucket, procédez comme suit :

-

Dans la console Google Cloud , accédez à la page IAM :

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est IAM et administration.

À partir de l'onglet Autorisations, affichez la liste par Rôles. Une table contenant tous les rôles et comptes principaux IAM associés à votre projetGoogle Cloud s'affiche.

Dans la tableFiltre zone de texte filter_list, saisissez Rédacteur de bucket de journaux.

Tous les comptes principaux dotés du rôle Rédacteur de bucket de journaux s'affichent. Si un compte principal est un compte de service, son ID contient la chaîne

gserviceaccount.com.Facultatif : Si vous souhaitez empêcher un compte de service d'acheminer les journaux vers votre projet Google Cloud , cochez la case check_box_outline_blank correspondant au compte de service, puis cliquez sur Supprimer.

Pourquoi les journaux d'un projet Google Cloud apparaissent-ils alors que je les ai exclus de mon récepteur

_Default?Vous pouvez consulter les journaux d'un bucket de journaux dans un projet Google Cloud centralisé qui regroupe les journaux de votre organisation.

Si vous utilisez l'explorateur de journaux pour accéder à ces journaux et que vous voyez les journaux que vous avez exclus du récepteur

_Default, il est possible que votre vue soit définie au niveau du projetGoogle Cloud .Pour résoudre ce problème, sélectionnez Vue des journaux dans le menu Affiner le champ d'application, puis sélectionnez la vue des journaux associée au bucket

_Defaultdans votre projetGoogle Cloud . Vous ne devriez plus voir les journaux exclus.Étapes suivantes

Pour en savoir plus sur les méthodes de l'API Logs Bucket, consultez la documentation de référence sur

LogBucket.Si vous gérez une organisation ou un dossier, vous pouvez spécifier l'emplacement des buckets de journaux

_Defaultet_Requireddes ressources enfants. Vous pouvez également configurer l'utilisation de CMEK par les buckets de journaux et le comportement du récepteur de journaux_Default. Pour en savoir plus, consultez Configurer les paramètres par défaut pour les organisations et les dossiers.Pour en savoir plus sur la gestion des cas d'utilisation courants des buckets de journaux, consultez les articles suivants :

Sauf indication contraire, le contenu de cette page est régi par une licence Creative Commons Attribution 4.0, et les échantillons de code sont régis par une licence Apache 2.0. Pour en savoir plus, consultez les Règles du site Google Developers. Java est une marque déposée d'Oracle et/ou de ses sociétés affiliées.

Dernière mise à jour le 2025/10/22 (UTC).

- Si vous prévoyez d'utiliser la Google Cloud CLI ou l'API Cloud Logging pour créer ou gérer vos buckets de journaux, vous devez comprendre les exigences de formatage