Dokumen ini menjelaskan cara membuat dan mengelola bucket Cloud Logging menggunakan

konsol Google Cloud , Google Cloud CLI, dan

Logging API.

Bagian ini juga memberikan petunjuk untuk membuat dan mengelola bucket log di

Google Cloud level project. Anda tidak dapat membuat bucket log di level folder atau organisasi; namun, Cloud Logging secara otomatis membuat bucket log _Default dan _Required di level folder dan organisasi untuk Anda.

Anda dapat mengupgrade bucket log untuk menggunakan Log Analytics. Log Analytics memungkinkan Anda menjalankan kueri SQL pada data log, sehingga membantu Anda memecahkan masalah aplikasi, keamanan, dan jaringan.

Untuk menggunakan BigQuery dalam menganalisis data log, Anda memiliki dua pilihan:

Upgrade bucket log untuk menggunakan Log Analytics, lalu buat set data BigQuery tertaut. Dalam skenario ini, Logging menyimpan data log Anda, tetapi BigQuery dapat membaca data log tersebut.

Ekspor entri log Anda ke BigQuery. Dalam skenario ini, Anda harus membuat sink, BigQuery menyimpan dan mengelola data, dan Anda memiliki opsi untuk menggunakan tabel berpartisi.

Setelah data log tersedia di BigQuery, Anda dapat menggabungkan data log dengan data lain yang disimpan di BigQuery, dan Anda dapat mengakses data ini dari alat lain seperti Looker Studio dan Looker.

Untuk mengetahui ringkasan konseptual tentang bucket, lihat Ringkasan perutean dan penyimpanan: Bucket log.

Dokumen ini tidak menjelaskan cara membuat bucket log yang menggunakan kunci enkripsi yang dikelola pelanggan (CMEK). Jika Anda tertarik dengan topik tersebut, lihat Mengonfigurasi CMEK untuk penyimpanan log.

Sebelum memulai

Untuk mulai menggunakan bucket, lakukan hal berikut:

- Konfigurasi project Google Cloud Anda:

-

Verify that billing is enabled for your Google Cloud project.

-

Untuk mendapatkan izin yang diperlukan untuk membuat, mengupgrade, dan menautkan bucket log, minta administrator untuk memberi Anda peran IAM Logs Configuration Writer (

roles/logging.configWriter) di project Anda. Untuk mengetahui informasi selengkapnya tentang cara memberikan peran, lihat Mengelola akses ke project, folder, dan organisasi.Anda mungkin juga bisa mendapatkan izin yang diperlukan melalui peran khusus atau peran bawaan lainnya.

Untuk mengetahui daftar lengkap izin dan peran, lihat Kontrol akses dengan IAM.

- Opsional: Untuk menggunakan BigQuery guna melihat data yang disimpan di bucket log, lakukan hal berikut:

- Pastikan BigQuery API diaktifkan. Anda dapat memverifikasi bahwa API diaktifkan dengan mencantumkan layanan yang tersedia.

- Peran Identity and Access Management Anda mencakup izin yang memungkinkan Anda membuat set data tertaut. Untuk mengetahui informasi selengkapnya, lihat Izin untuk set data BigQuery yang ditautkan.

-

- Pahami region yang didukung tempat Anda dapat menyimpan log.

-

Select the tab for how you plan to use the samples on this page:

Console

When you use the Google Cloud console to access Google Cloud services and APIs, you don't need to set up authentication.

gcloud

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

REST

Untuk memakai contoh REST API di halaman ini dalam lingkungan pengembangan lokal, gunakan kredensial yang Anda berikan ke gcloud CLI.

Instal Google Cloud CLI. Setelah penginstalan, lakukan inisialisasi Google Cloud CLI dengan menjalankan perintah berikut:

gcloud initJika Anda menggunakan penyedia identitas (IdP) eksternal, Anda harus login ke gcloud CLI dengan identitas gabungan Anda terlebih dahulu.

Untuk mengetahui informasi selengkapnya, lihat Melakukan autentikasi untuk menggunakan REST dalam dokumentasi autentikasi Google Cloud .

- Jika Anda berencana menggunakan Google Cloud CLI atau Cloud Logging API untuk membuat atau mengelola bucket log, pahami persyaratan pemformatan

LogBucket.Membuat bucket

Anda dapat membuat maksimum 100 bucket per Google Cloud project.

Untuk membuat bucket log yang ditentukan pengguna untuk project Google Cloud Anda, lakukan langkah-langkah berikut:

Google Cloud console

Untuk membuat bucket log di Google Cloud project Anda, lakukan hal berikut:

-

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Klik Buat bucket log.

Masukkan Nama dan Deskripsi untuk bucket Anda.

Opsional: Upgrade bucket Anda untuk menggunakan Log Analytics.

Pilih Upgrade untuk menggunakan Log Analytics.

Saat mengupgrade bucket agar dapat menggunakan Log Analytics, Anda dapat membuat kueri log di halaman Log Analytics menggunakan kueri SQL. Anda juga dapat terus melihat log menggunakan Logs Explorer.

Opsional: Untuk melihat log di BigQuery, pilih Buat set data BigQuery baru yang ditautkan ke bucket ini dan masukkan nama set data yang unik.

Jika Anda memilih opsi ini, BigQuery dapat membaca data yang disimpan di bucket log Anda. Sekarang Anda dapat membuat kueri di antarmuka BigQuery tempat Anda dapat menggabungkan data log, dan juga mengakses data dari alat lain seperti Looker Studio dan Looker.

Opsional: Untuk memilih region penyimpanan untuk log Anda, klik menu Pilih region bucket log, lalu pilih region. Jika Anda tidak memilih region, maka region

globalakan digunakan, yang berarti log dapat secara fisik berlokasi di region yang didukung.Opsional: Untuk menetapkan periode retensi kustom bagi log di bucket, klik Berikutnya.

Di kolom Periode retensi data, masukkan jumlah hari, antara 1 hari dan 3.650 hari, yang Anda inginkan agar Cloud Logging mempertahankan log Anda. Jika Anda tidak menyesuaikan periode retensi, defaultnya adalah

30 days.Anda juga dapat memperbarui bucket untuk menerapkan retensi kustom setelah Anda membuatnya.

Klik Create bucket.

Setelah bucket log dibuat, Logging akan mengupgrade bucket dan membuat link set data, jika opsi ini dipilih.

Mungkin perlu beberapa saat untuk menyelesaikan langkah-langkah ini.

gcloud

Untuk membuat bucket log saja, jalankan perintah

gcloud logging buckets create. Jika Anda ingin mengupgrade bucket log untuk menggunakan Log Analytics, sertakan flag--enable-analyticsdan--async, dan pastikan Anda menyetel variabel LOCATION ke wilayah yang didukung:gcloud logging buckets create BUCKET_ID --location=LOCATION --enable-analytics --async OPTIONAL_FLAGS

Flag

--asyncmemaksa perintah menjadi asinkron. Hasil yang ditampilkan dari metode asinkron adalah objekOperation, yang berisi informasi tentang progres metode. Setelah metode selesai, objekOperationakan berisi status. Untuk mengetahui informasi selengkapnya, lihat Metode API asinkron.Jika Anda tidak ingin mengupgrade bucket log untuk menggunakan Log Analytics, hapus flag

--enable-analyticsdan--async.Misalnya, jika Anda ingin membuat bucket dengan BUCKET_ID

my-bucketdi regionglobal, perintah Anda akan terlihat seperti berikut:gcloud logging buckets create my-bucket --location global --description "My first bucket"

Misalnya, untuk membuat bucket dengan BUCKET_ID

my-upgraded-bucketdi lokasiglobal, lalu mengupgrade bucket log untuk menggunakan Log Analytics, perintah Anda akan terlihat seperti berikut:gcloud logging buckets create my-upgraded-bucket --location global \ --description "My first upgraded bucket" \ --enable-analytics --retention-days=45REST

Untuk membuat bucket, gunakan metode

projects.locations.buckets.createatauprojects.locations.buckets.createAsync. Siapkan argumen ke metode sebagai berikut:Tetapkan parameter

parentmenjadi resource tempat bucket akan dibuat:projects/PROJECT_ID/locations/LOCATIONVariabel LOCATION merujuk ke region tempat Anda ingin menyimpan log.

Misalnya, jika Anda ingin membuat bucket untuk project

my-projectdi regionglobal, parameterparentAnda akan terlihat seperti ini:projects/my-project/locations/globalTetapkan parameter

bucketId; misalnya,my-bucket.Lakukan salah satu tindakan berikut:

Untuk membuat bucket log, lalu mengupgrade bucket log agar dapat menggunakan Log Analytics:

Tetapkan boolean

LogBucket.analyticsEnabledketrue.Panggil metode asinkron

projects.locations.buckets.createAsyncuntuk membuat bucket.Respons terhadap metode asinkron adalah objek

Operation. Objek ini berisi informasi tentang progres metode. Setelah metode selesai, objekOperationakan berisi status. Untuk mengetahui informasi selengkapnya, lihat Metode API asinkron.Metode

createAsyncmemerlukan waktu beberapa menit hingga selesai. Metode ini tidak menghasilkan pesan error atau gagal saat booleananalyticsEnableddisetel ketrue.

Jika tidak, panggil metode sinkron

projects.locations.buckets.createuntuk membuat bucket.

Setelah membuat bucket, buat sink untuk merutekan entri log ke bucket Anda dan konfigurasi tampilan log untuk mengontrol siapa yang dapat mengakses log di bucket baru Anda dan log mana yang dapat diakses oleh mereka. Anda juga dapat memperbarui bucket untuk mengonfigurasi retensi kustom dan kolom terbatas.

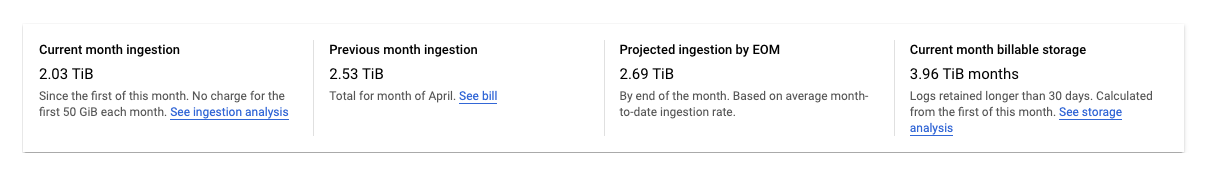

Melacak volume log yang disimpan dalam bucket log

Halaman Logs Storage di konsol Google Cloud melacak volume data log yang disimpan dalam bucket log:

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Halaman Logs Storage menampilkan ringkasan statistik untuk Google Cloud project Anda:

Statistik berikut dilaporkan:

Penyerapan bulan ini: Jumlah data log yang telah disimpan project Google Cloud Anda dalam bucket log sejak hari pertama bulan kalender saat ini.

Penyerapan bulan sebelumnya: Jumlah data log yang disimpan project Google Cloud Anda dalam bucket log pada bulan kalender terakhir.

Proyeksi penyerapan data pada akhir bulan: Perkiraan jumlah data log yang akan disimpan projectGoogle Cloud Anda dalam bucket log pada akhir bulan kalender saat ini, berdasarkan penggunaan saat ini.

Penyimpanan yang dapat ditagih untuk bulan ini: Jumlah data log yang telah disimpan selama lebih dari 30 hari yang ditagih.

Statistik sebelumnya tidak menyertakan log di bucket

_Required. Log di bucket tersebut tidak dapat dikecualikan atau dinonaktifkan.Halaman Log Router di konsol Google Cloud memberi Anda alat yang dapat digunakan untuk meminimalkan biaya penyimpanan log di bucket log atau untuk penyimpanan yang melebihi alokasi bulanan Anda. Anda dapat melakukan hal berikut:

- Menonaktifkan penyimpanan log di tingkat bucket.

- Mengecualikan entri log tertentu agar tidak disimpan di bucket log.

Untuk mengetahui informasi selengkapnya, lihat Mengelola sink.

Mengelola bucket

Bagian ini menjelaskan cara mengelola bucket log menggunakan Google Cloud CLI atau Google Cloud konsol.

Memperbarui bucket

Untuk memperbarui properti bucket, seperti deskripsi atau periode retensi, lakukan hal berikut:Google Cloud console

Untuk memperbarui properti bucket, lakukan hal berikut:

-

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Untuk bucket yang ingin Anda perbarui, klik more_vert Lainnya.

Pilih Edit bucket.

Edit bucket sesuai kebutuhan.

Klik Perbarui bucket.

gcloud

Untuk memperbarui properti bucket, jalankan perintah

gcloud logging buckets update:gcloud logging buckets update BUCKET_ID --location=LOCATION UPDATED_ATTRIBUTES

Contoh:

gcloud logging buckets update my-bucket --location=global --description "Updated description"

REST

Untuk memperbarui properti bucket, gunakan

projects.locations.buckets.patchdi Logging API.Mengupgrade bucket untuk menggunakan Log Analytics

Setelah Anda mengupgrade bucket untuk menggunakan Log Analytics, semua entri log baru yang masuk dapat dianalisis di antarmuka Log Analytics. Cloud Logging juga memulai operasi pengisian ulang, yang memungkinkan Anda menganalisis entri log lama yang ditulis sebelum upgrade. Proses pengisian ulang mungkin memerlukan waktu beberapa jam. Anda tidak dapat mengurungkan operasi upgrade pada bucket.

Untuk mengupgrade bucket yang ada agar dapat menggunakan Log Analytics, batasan berikut berlaku:

- Bucket log dibuat di tingkat project Google Cloud .

- Bucket log tidak terkunci kecuali jika bucket tersebut adalah bucket

_Required. Tidak ada update tertunda ke bucket.

Google Cloud console

Untuk mengupgrade bucket yang ada agar dapat menggunakan Log Analytics, lakukan hal berikut:

-

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Cari bucket yang ingin Anda upgrade.

Jika kolom Log Analytics available menampilkan Upgrade, Anda dapat mengupgrade bucket log untuk menggunakan Log Analytics. Klik Upgrade.

Dialog akan terbuka. Klik Konfirmasi.

gcloud

Untuk mengupgrade bucket log agar dapat menggunakan Log Analytics, jalankan perintah

gcloud logging buckets update. Anda harus menetapkan flag--enable-analyticsdan sebaiknya sertakan juga flag--async:gcloud logging buckets update BUCKET_ID --location=LOCATION --enable-analytics --async

Flag

--asyncmemaksa perintah menjadi asinkron. Hasil dari metode asinkron adalah objekOperation, dan objek tersebut berisi informasi tentang progres metode. Setelah metode selesai, objekOperationakan berisi status. Untuk mengetahui informasi selengkapnya, lihat Metode API asinkron.REST

Untuk mengupgrade bucket log agar dapat menggunakan Log Analytics, gunakan metode

projects.locations.buckets.updateAsyncCloud Logging API.Siapkan argumen ke metode sebagai berikut:

- Tetapkan boolean

LogBucket.analyticsEnabledketrue. - Untuk parameter kueri perintah, gunakan

updateMask=analyticsEnabled.

Respons terhadap metode asinkron adalah objek

Operation. Objek ini berisi informasi tentang progres metode. Setelah metode selesai, objekOperationakan berisi status. Untuk mengetahui informasi selengkapnya, lihat Metode API asinkron.updateAsyncmungkin memerlukan waktu beberapa menit untuk diselesaikan.Membuat set data BigQuery tertaut

Jika Anda ingin menggunakan kemampuan BigQuery untuk menganalisis data log, upgrade bucket log untuk menggunakan Log Analytics, lalu buat set data tertaut. Dengan konfigurasi ini, Logging menyimpan data log Anda, tetapi BigQuery dapat membaca data log tersebut.

Google Cloud console

Untuk membuat link ke set data BigQuery untuk bucket log yang ada, lakukan hal berikut:

-

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Cari bucket log dan pastikan kolom Log Analytics available menampilkan Open.

Jika kolom ini menampilkan Upgrade, berarti bucket log belum diupgrade untuk menggunakan Log Analytics. Konfigurasi Log Analytics:

- Klik Upgrade.

- Klik Konfirmasi di dialog.

Setelah upgrade selesai, lanjutkan ke langkah berikutnya.

Di bucket log, klik Lainnyamore_vert, lalu klik Edit bucket.

Dialog Edit log bucket akan terbuka.

Pilih Buat set data BigQuery baru yang ditautkan ke bucket ini, lalu masukkan nama untuk set data baru.

Nama set data harus unik untuk setiap Google Cloud project. Jika Anda memasukkan nama set data yang ada, Anda akan menerima error berikut:

Dataset name must be unique in the selected region.Klik Selesai, lalu klik Perbarui bucket.

Setelah Logging menampilkan nama set data tertaut di halaman Penyimpanan Log, mungkin perlu waktu beberapa menit sebelum BigQuery mengenali set data tersebut.

gcloud

Untuk membuat set data tertaut untuk bucket log yang diupgrade agar dapat menggunakan Log Analytics, jalankan perintah

gcloud logging links create:gcloud logging links create LINK_ID --bucket=BUCKET_ID --location=LOCATION

LINK_ID yang Anda berikan digunakan sebagai nama set data BigQuery, dan nilai kolom ini harus unik untuk project Google Cloud Anda.

Perintah

links createbersifat asinkron. Hasil dari metode asinkron adalah objekOperation, dan objek tersebut berisi informasi tentang progres metode. Setelah metode selesai, objekOperationakan berisi status. Untuk mengetahui informasi selengkapnya, lihat Metode API asinkron.Perintah

links creatememerlukan waktu beberapa menit untuk diselesaikan.Misalnya, perintah berikut akan membuat set data tertaut bernama

mylinkuntuk bucket log bernamamy-bucket:gcloud logging links create mylink --bucket=my-bucket --location=global

Nama set data harus unik untuk setiap Google Cloud project. Jika Anda mencoba membuat set data dengan nama yang sama seperti set data yang ada, Anda akan menerima error berikut:

BigQuery dataset with name "LINK_ID" already exists.Jika Anda mencoba membuat set data tertaut untuk bucket log yang belum diupgrade untuk menggunakan Log Analytics, error berikut akan dilaporkan:

A link can only be created for an analytics-enabled bucket.REST

Untuk membuat set data BigQuery tertaut untuk bucket log yang ada yang diupgrade menggunakan Log Analytics, panggil metode

projects.locations.buckets.links.createasinkron dari Cloud Logging API.Siapkan argumen ke metode sebagai berikut:

- Buat isi permintaan untuk perintah

create. Isi permintaan diformat sebagai objekLink. - Untuk parameter kueri perintah, gunakan

linkId=LINK_ID. LINK_ID yang Anda berikan digunakan sebagai nama set data BigQuery, dan nilai kolom ini harus unik untuk project Google Cloud Anda.

Respons terhadap metode asinkron adalah objek

Operation. Objek ini berisi informasi tentang progres metode. Setelah metode selesai, objekOperationakan berisi status. Untuk mengetahui informasi selengkapnya, lihat Metode API asinkron.Metode

links.creatememerlukan waktu beberapa menit hingga selesai.Nama set data harus unik untuk setiap Google Cloud project. Jika Anda mencoba membuat set data dengan nama yang sama seperti set data yang ada, Anda akan menerima error berikut:

BigQuery dataset with name "LINK_ID" already exists.Jika Anda mencoba membuat set data tertaut untuk bucket log yang belum diupgrade untuk menggunakan Log Analytics, error berikut akan dilaporkan:

A link can only be created for an analytics-enabled bucket.Mengunci bucket

Saat Anda mengunci bucket agar tidak diupdate, Anda juga mengunci kebijakan retensi bucket. Setelah kebijakan retensi dikunci, Anda tidak dapat menghapus bucket hingga setiap entri log dalam bucket memenuhi periode retensi bucket. Jika Anda ingin mencegah penghapusan project secara tidak sengaja yang berisi bucket log terkunci, tambahkan lien ke project. Untuk mempelajari lebih lanjut, lihat Melindungi project dengan lien.

Untuk mencegah siapa pun memperbarui atau menghapus bucket log, kunci bucket. Untuk mengunci bucket, lakukan langkah berikut:

Google Cloud console

Konsol Google Cloud tidak mendukung penguncian bucket log.

gcloud

Untuk mengunci bucket, jalankan perintah

gcloud logging buckets updatedengan flag--locked:gcloud logging buckets update BUCKET_ID --location=LOCATION --locked

Contoh:

gcloud logging buckets update my-bucket --location=global --locked

REST

Untuk mengunci atribut bucket, gunakan

projects.locations.buckets.patchdi Logging API. Tetapkan parameterlockedketrue.Membuat daftar bucket

Untuk mencantumkan bucket log yang terkait dengan project, dan untuk melihat detail seperti setelan retensi, lakukan langkah-langkah berikut: Google Cloud

Google Cloud console

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Tabel bernama Bucket log mencantumkan bucket yang terkait dengan Google Cloud project saat ini.

Tabel mencantumkan atribut berikut untuk setiap bucket log:

- Nama: Nama bucket log.

- Deskripsi: Deskripsi bucket.

- Periode retensi: Jumlah hari data bucket akan disimpan oleh Cloud Logging.

- Region: Lokasi geografis tempat data bucket disimpan.

- Status: Apakah bucket dikunci atau tidak dikunci.

Jika bucket menunggu penghapusan oleh Cloud Logging, maka entri tabelnya akan diberi anotasi dengan simbol peringatan warning.

gcloud

Jalankan perintah

gcloud logging buckets list:gcloud logging buckets list

Anda akan melihat atribut berikut untuk bucket log:

LOCATION: Region tempat data bucket disimpan.BUCKET_ID: Nama bucket log.RETENTION_DAYS: Jumlah hari data bucket akan disimpan oleh Cloud Logging.LIFECYCLE_STATE: Menunjukkan apakah bucket menunggu penghapusan oleh Cloud Logging.LOCKED: Apakah bucket dikunci atau tidak dikunci.CREATE_TIME: Stempel waktu yang menunjukkan kapan bucket dibuat.UPDATE_TIME: Stempel waktu yang menunjukkan kapan bucket terakhir diubah.

Anda juga dapat melihat atribut hanya untuk satu bucket. Misalnya, untuk melihat detail bucket log

_Defaultdi regionglobal, jalankan perintahgcloud logging buckets describe:gcloud logging buckets describe _Default --location=global

REST

Untuk mencantumkan bucket log yang terkait dengan project Google Cloud , gunakan

projects.locations.buckets.listdi Logging API.Melihat detail bucket

Untuk melihat detail satu bucket log, lakukan langkah berikut:

Google Cloud console

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Di bucket log, klik more_vert Lainnya, lalu pilih Lihat detail bucket.

Dialog mencantumkan atribut berikut untuk bucket log:

- Nama: Nama bucket log.

- Deskripsi: Deskripsi bucket log.

- Periode retensi: Jumlah hari data bucket akan disimpan oleh Cloud Logging.

- Region: Lokasi geografis tempat data bucket disimpan.

- Log Analytics: Menunjukkan apakah bucket Anda diupgrade untuk menggunakan Log Analytics.

- Analisis BigQuery: Menunjukkan apakah set data BigQuery ditautkan ke bucket Anda.

- Set data BigQuery: Menyediakan link ke set data BigQuery Anda, yang terbuka di halaman BigQuery Studio. Tanggal saat penautan BigQuery diaktifkan juga ditampilkan.

gcloud

Jalankan perintah

gcloud logging buckets describe.Misalnya, perintah berikut melaporkan detail bucket

_Default:gcloud logging buckets describe _Default --location=global

Anda akan melihat atribut berikut untuk bucket log:

createTime: Stempel waktu yang menunjukkan kapan bucket dibuat.description: Deskripsi bucket log.lifecycleState: Menunjukkan apakah bucket menunggu penghapusan oleh Cloud Logging.name: Nama bucket log.retentionDays: Jumlah hari data bucket akan disimpan oleh Cloud Logging.updateTime: Stempel waktu yang menunjukkan kapan bucket terakhir diubah.

REST

Untuk melihat detail satu bucket log, gunakan

projects.locations.buckets.getdi Logging API.Menghapus bucket

Anda dapat menghapus bucket log yang memenuhi salah satu kondisi berikut:

- Bucket log tidak terkunci.

- Bucket log dikunci dan semua entri log di bucket log telah memenuhi periode retensi bucket.

Anda tidak dapat menghapus bucket log yang dikunci agar tidak diupdate jika bucket log tersebut menyimpan entri log yang belum memenuhi periode retensi bucket.

Setelah Anda mengeluarkan perintah hapus, bucket log akan bertransisi ke status

DELETE_REQUESTED, dan tetap dalam status tersebut selama 7 hari. Selama jangka waktu ini, Logging akan terus merutekan log ke bucket log. Anda dapat menghentikan perutean log ke bucket log dengan menghapus atau mengubah sink log yang merutekan entri log ke bucket.Anda tidak dapat membuat bucket log baru yang menggunakan nama yang sama dengan bucket log yang berada dalam status

DELETE_REQUESTED.Untuk menghapus bucket log, lakukan langkah-langkah berikut:

Google Cloud console

Untuk menghapus bucket log, lakukan langkah-langkah berikut:

-

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Cari bucket yang ingin Anda hapus, lalu klik more_vertLainnya.

Jika kolom Set data tertaut di BigQuery menampilkan link, hapus set data BigQuery tertaut:

Klik Edit bucket.

Hapus centang pada Buat set data BigQuery baru yang ditautkan ke bucket ini, klik Selesai, lalu klik Perbarui bucket.

Setelah Anda kembali ke halaman Penyimpanan Log, klik more_vertLainnya untuk bucket yang ingin Anda hapus, lalu lanjutkan ke langkah berikutnya.

Pilih Hapus bucket.

Di panel konfirmasi, klik Hapus.

Di halaman Penyimpanan Log, bucket Anda memiliki indikator bahwa bucket tersebut menunggu penghapusan. Bucket, termasuk semua log di dalamnya, akan dihapus setelah 7 hari.

gcloud

Untuk menghapus bucket log, jalankan perintah

gcloud logging buckets delete:gcloud logging buckets delete BUCKET_ID --location=LOCATION

Anda tidak dapat menghapus bucket log jika bucket tersebut memiliki set data BigQuery yang tertaut:

- Untuk mencantumkan link yang terkait dengan bucket log, jalankan perintah

gcloud logging links list. - Untuk menghapus set data tertaut, jalankan perintah

gcloud logging links delete.

REST

Untuk menghapus bucket, gunakan

projects.locations.buckets.deletedi Logging API.Error akan terjadi jika Anda menghapus bucket log yang memiliki set data BigQuery tertaut. Anda harus menghapus set data tertaut sebelum menghapus bucket log:

- Untuk mencantumkan link yang terkait dengan bucket log, jalankan metode

projects.locations.buckets.links.list. - Untuk menghapus set data tertaut, jalankan metode

projects.locations.buckets.links.delete.

Memulihkan bucket yang dihapus

Anda dapat memulihkan, atau membatalkan penghapusan, bucket log yang berada dalam status menunggu penghapusan. Untuk memulihkan bucket log, lakukan langkah berikut:

Google Cloud console

Untuk memulihkan bucket log yang menunggu penghapusan, lakukan hal berikut:

-

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Untuk bucket yang ingin Anda pulihkan, klik more_vert Lainnya, lalu pilih Pulihkan bucket yang dihapus.

Di panel konfirmasi, klik Pulihkan.

Di halaman Logs Storage, indikator menunggu penghapusan dihapus dari bucket log Anda.

gcloud

Untuk memulihkan bucket log yang menunggu penghapusan, jalankan perintah

gcloud logging buckets undelete:gcloud logging buckets undelete BUCKET_ID --location=LOCATION

REST

Untuk memulihkan bucket yang menunggu penghapusan, gunakan

projects.locations.buckets.undeletedi Logging API.Pemberitahuan tentang byte log bulanan yang disimpan di bucket log

Untuk membuat kebijakan pemberitahuan, di halaman Penyimpanan Log di konsolGoogle Cloud , klik add_alert Buat pemberitahuan penggunaan. Tombol ini akan membuka halaman Buat kebijakan pemberitahuan di Monitoring, dan mengisi kolom jenis metrik dengan

logging.googleapis.com/billing/bytes_ingested.Untuk membuat kebijakan pemberitahuan yang akan dipicu saat jumlah byte log yang ditulis ke bucket log melampaui batas yang ditentukan pengguna untuk Cloud Logging, gunakan setelan berikut.

Kolom New condition

NilaiResource and Metric Di menu Resources, pilih Global.

Di menu Metric categories, pilih Logs-based metric.

Di menu Metrics, pilih Monthly log bytes ingested.Filter Tidak ada. Across time series

Time series aggregationsum

Rolling window 60 m

Rolling window function maxKolom Configure alert trigger

NilaiCondition type ThresholdAlert trigger Any time series violatesThreshold position Above thresholdThreshold value Anda menentukan nilai yang dapat diterima. Retest window Nilai minimum yang dapat diterima adalah 30 menit. Untuk mengetahui informasi selengkapnya tentang kebijakan pemberitahuan, lihat Ringkasan pemberitahuan.

Menulis ke bucket

Anda tidak menulis log secara langsung ke bucket log. Sebaliknya, Anda menulis log ke Google Cloud resource: a Google Cloud project, folder, atau organisasi. Sink di resource induk kemudian merutekan log ke tujuan, termasuk bucket log. Sink merutekan log ke tujuan bucket log jika log cocok dengan filter sink dan sink memiliki izin untuk merutekan log ke bucket log.

Membaca dari bucket

Setiap bucket log memiliki serangkaian tampilan log. Untuk membaca log dari bucket log, Anda memerlukan akses ke tampilan log di bucket log. Dengan tampilan log, Anda dapat memberikan akses pengguna hanya ke sebagian log yang disimpan dalam bucket log. Untuk mengetahui informasi tentang cara mengonfigurasi tampilan log, dan cara memberikan akses ke tampilan log tertentu, lihat Mengonfigurasi tampilan log di bucket log.

Untuk membaca log dari bucket log, lakukan hal berikut:

Google Cloud console

-

Di konsol Google Cloud , buka halaman Logs Explorer:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Untuk menyesuaikan log yang ditampilkan di Logs Explorer, klik Persempit cakupan, lalu pilih opsi. Misalnya, Anda dapat melihat log yang disimpan dalam project atau menurut tampilan log.

Klik Terapkan. Panel Query results dimuat ulang dengan log yang cocok dengan opsi yang Anda pilih.

Untuk mengetahui informasi selengkapnya, lihat Ringkasan Logs Explorer: Mempersempit cakupan.

gcloud

Untuk membaca log dari bucket log, gunakan perintah

gcloud logging readdan tambahkanLOG_FILTERuntuk memilih data:gcloud logging read LOG_FILTER --bucket=BUCKET_ID --location=LOCATION --view=LOG_VIEW_ID

REST

Untuk membaca log dari bucket log, gunakan metode entries.list. Tetapkan

resourceNamesuntuk menentukan bucket dan tampilan log yang sesuai, lalu tetapkanfilteruntuk memilih data.Untuk mengetahui informasi mendetail tentang sintaksis pemfilteran, lihat Bahasa kueri logging.

Mengonfigurasi retensi kustom

Saat membuat bucket log, Anda memiliki opsi untuk menyesuaikan jangka waktu penyimpanan log bucket oleh Cloud Logging. Anda dapat mengonfigurasi periode retensi data untuk bucket log yang ditentukan pengguna dan juga untuk bucket log

_Default. Anda tidak dapat mengubah periode retensi bucket log_Required.Jika Anda mempersingkat retensi bucket, akan ada masa tenggang 7 hari untuk mengamankan log yang telah habis masa berlakunya agar tidak dihapus. Anda tidak dapat membuat kueri atau melihat log yang telah habis masa berlakunya tersebut, tetapi dalam waktu 7 hari tersebut, Anda dapat memulihkan akses penuh dengan memperpanjang retensi bucket. Log yang disimpan selama masa tenggang ini mengurangi biaya retensi Anda.

Penerapan retensi adalah proses yang konsisten pada akhirnya. Jika Anda menulis entri log ke bucket log saat entri log lebih lama dari periode retensi bucket, Anda mungkin dapat melihat entri log ini secara singkat. Misalnya, jika Anda mengirim entri log yang berusia 10 hari ke bucket log dengan periode retensi 7 hari, entri log tersebut akan disimpan, lalu dihapus pada akhirnya. Entri log ini tidak berkontribusi pada biaya retensi Anda. Data tersebut memengaruhi biaya penyimpanan Anda. Untuk meminimalkan biaya penyimpanan, jangan tulis entri log yang lebih lama dari periode retensi bucket Anda.

Untuk memperbarui periode retensi bucket log kustom atau bucket log

_Default, lakukan hal berikut:Google Cloud console

Untuk memperbarui periode retensi bucket log, lakukan hal berikut:

-

Di konsol Google Cloud , buka halaman Logs Storage:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah Logging.

Untuk bucket yang ingin Anda perbarui, klik more_vert Lainnya, lalu pilih Edit bucket.

Di kolom Retensi, masukkan jumlah hari, antara 1 hari dan 3.650 hari, yang Anda inginkan agar Cloud Logging mempertahankan log Anda.

Klik Perbarui bucket. Durasi retensi baru Anda akan muncul di daftar Bucket log.

gcloud

Untuk memperbarui periode retensi bucket log, jalankan perintah

gcloud logging buckets update, setelah menetapkan nilai untuk RETENTION_DAYS:gcloud logging buckets update BUCKET_ID --location=LOCATION --retention-days=RETENTION_DAYS

Misalnya, untuk menyimpan log di bucket

_Defaultdi lokasiglobalselama setahun, perintah Anda akan terlihat seperti berikut:gcloud logging buckets update _Default --location=global --retention-days=365

Jika Anda memperpanjang periode retensi bucket, aturan retensi akan berlaku ke depan dan tidak berlaku surut. Log tidak dapat dipulihkan setelah periode retensi yang berlaku berakhir.

Metode API asinkron

Respons metode asinkron seperti

projects.locations.buckets.createAsyncadalah objekOperation.Aplikasi yang memanggil metode API asinkron harus melakukan polling endpoint

operation.gethingga nilai kolomOperation.doneadalahtrue:Jika

doneadalahfalse, operasi sedang berlangsung.Untuk memperbarui informasi status, kirim permintaan

GETke endpointoperation.get.Jika

doneadalahtrue, operasi selesai dan kolomerroratauresponseditetapkan:error: Jika disetel, operasi asinkron gagal. Nilai kolom ini adalah objekStatusyang berisi kode error gRPC dan pesan error.response: Jika disetel, operasi asinkron berhasil diselesaikan, dan nilai mencerminkan hasilnya.

Untuk melakukan polling perintah asinkron menggunakan Google Cloud CLI, jalankan perintah berikut:

gcloud logging operations describe OPERATION_ID --location=LOCATION --project=PROJECT_ID

Untuk informasi selengkapnya, lihat

gcloud logging operations describe.Memecahkan masalah umum

Jika Anda mengalami masalah saat menggunakan bucket log, lihat langkah-langkah pemecahan masalah dan jawaban untuk pertanyaan umum berikut.

Mengapa saya tidak dapat menghapus bucket ini?

Jika Anda mencoba menghapus bucket, lakukan langkah-langkah berikut:

Verifikasi bahwa Anda memiliki izin yang benar untuk menghapus bucket. Untuk mengetahui daftar izin yang Anda perlukan, lihat Kontrol akses dengan IAM.

Tentukan apakah bucket dikunci dengan mencantumkan atribut bucket. Jika bucket dikunci, periksa periode retensi bucket. Anda tidak dapat menghapus bucket yang terkunci hingga semua log dalam bucket tersebut memenuhi periode retensi data bucket.

Pastikan bucket log tidak memiliki set data BigQuery yang ditautkan. Anda tidak dapat menghapus bucket log dengan set data tertaut.

Error berikut ditampilkan sebagai respons terhadap perintah

deletepada bucket log yang memiliki set data tertaut:FAILED_PRECONDITION: This bucket is used for advanced analytics and has an active link. The link must be deleted first before deleting the bucket

Untuk mencantumkan link yang terkait dengan bucket log, jalankan perintah

gcloud logging links listatau jalankan metode APIprojects.locations.buckets.links.list.

Akun layanan mana yang merutekan log ke bucket saya?

Untuk menentukan apakah ada akun layanan yang memiliki izin IAM untuk merutekan log ke bucket Anda, lakukan hal berikut:

-

Di konsol Google Cloud , buka halaman IAM:

Jika Anda menggunakan kotak penelusuran untuk menemukan halaman ini, pilih hasil yang subjudulnya adalah IAM & Admin.

Dari tab Permissions, lihat menurut Roles. Anda akan melihat tabel yang berisi semua peran dan akun utama IAM yang terkait dengan projectGoogle Cloud .

Di kotak teks Filter tabel filter_list, masukkan Logs Bucket Writer.

Anda akan melihat akun utama apa pun dengan peran Penulis Bucket Log. Jika akun utama adalah akun layanan, ID-nya berisi string

gserviceaccount.com.Opsional: Jika Anda ingin menghapus kemampuan akun layanan untuk merutekan log ke project Google Cloud Anda, pilih kotak centang check_box_outline_blank untuk akun layanan tersebut, lalu klik Hapus.

Mengapa saya melihat log untuk project Google Cloud , meskipun saya mengecualikannya dari sink

_Default?Anda mungkin melihat log di bucket log dalam project Google Cloud terpusat, yang menggabungkan log dari seluruh organisasi Anda.

Jika Anda menggunakan Logs Explorer untuk mengakses log ini dan melihat log yang Anda kecualikan dari sink

_Default, tampilan Anda mungkin disetel ke tingkat projectGoogle Cloud .Untuk memperbaiki masalah ini, pilih Tampilan log di menu Persempit cakupan lalu pilih tampilan log yang terkait dengan bucket

_Defaultdi Google Cloud project Anda. Anda tidak akan melihat log yang dikecualikan lagi.Langkah berikutnya

Untuk mengetahui informasi tentang metode API bucket log, lihat dokumentasi referensi

LogBucket.Jika Anda mengelola organisasi atau folder, Anda dapat menentukan lokasi bucket log

_Defaultdan_Requireddari resource turunan. Anda juga dapat mengonfigurasi apakah bucket log menggunakan CMEK dan perilaku sink log_Default. Untuk mengetahui informasi selengkapnya, lihat Mengonfigurasi setelan default untuk organisasi dan folder.Untuk mengetahui informasi tentang cara menangani kasus penggunaan umum dengan bucket log, lihat topik berikut:

Kecuali dinyatakan lain, konten di halaman ini dilisensikan berdasarkan Lisensi Creative Commons Attribution 4.0, sedangkan contoh kode dilisensikan berdasarkan Lisensi Apache 2.0. Untuk mengetahui informasi selengkapnya, lihat Kebijakan Situs Google Developers. Java adalah merek dagang terdaftar dari Oracle dan/atau afiliasinya.

Terakhir diperbarui pada 2025-10-22 UTC.

- Jika Anda berencana menggunakan Google Cloud CLI atau Cloud Logging API untuk membuat atau mengelola bucket log, pahami persyaratan pemformatan