Cloud Monitoring vous offre une réelle visibilité sur les performances, le temps d'activité et l'état général de vos applications cloud. Google Cloud Observability collecte et ingère des métriques, des événements et des métadonnées à partir de clusters Dataproc, y compris les métriques HDFS, YARN et de tâche par cluster, afin de générer des insights via des tableaux de bord et des graphiques (voir Métriques Dataproc Cloud Monitoring).

Consultez la page Tarifs Cloud Monitoring pour comprendre vos coûts.

Consultez la section Quotas et limites de Monitoring pour obtenir plus d'informations sur la conservation des données métriques.

Collecte des métriques de ressources Dataproc

Cloud Monitoring collecte des métriques liées aux ressources Dataproc suivantes :

- Cloud Dataproc Cluster

- Cloud Dataproc Job

- Lot Cloud Dataproc

- Session Cloud Dataproc

Les métriques de ressources Dataproc sont collectées au format suivant : dataproc.googleapis.com/RESOURCE/METRIC. Elles incluent la collecte de plusieurs métriques OSS.

Afficher les métriques des ressources Dataproc

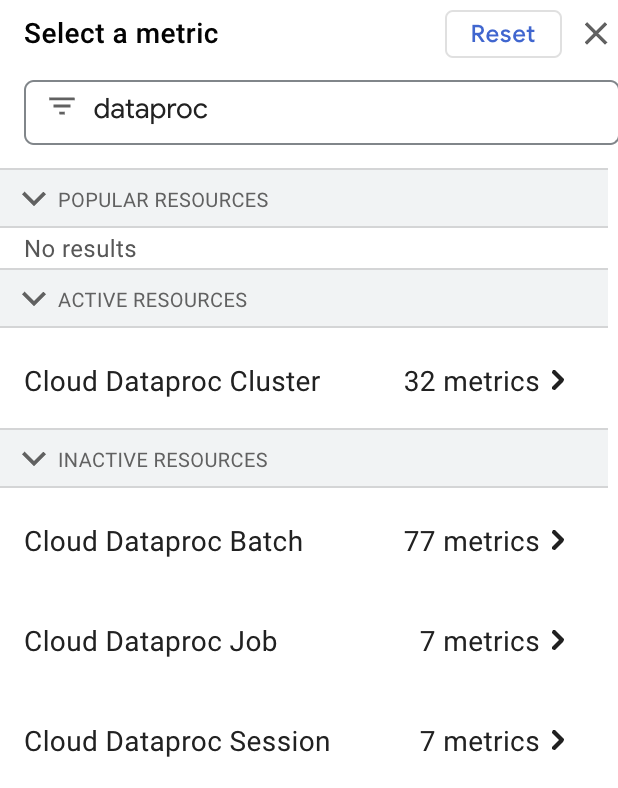

Vous pouvez sélectionner et afficher les métriques de ressources Dataproc dans l'explorateur de métriques en saisissant "dataproc" dans la zone Filter by resource or metric name, puis en sélectionnant une ressource "Cloud Dataproc".

Collecte de métriques personnalisées

Lorsque vous créez un cluster Dataproc, vous pouvez activer la collecte de métriques à partir d'une ou de plusieurs sources de métriques personnalisées. Un ensemble standard de métriques est collecté à partir de chaque source de métriques activée, sauf si vous spécifiez les métriques à collecter à partir d'une source de métriques (les métriques spécifiées par l'utilisateur sont appelées "remplacements" de métriques).

Les métriques OSS personnalisées sont collectées au format suivant :

custom.googleapis.com/OSS_COMPONENT/METRIC

Exemples de métriques OSS personnalisées :

custom.googleapis.com/spark/driver/DAGScheduler/job/allJobs custom.googleapis.com/hiveserver2/memory/MaxNonHeapMemory

Activer la collecte de métriques personnalisées

Vous pouvez utiliser la gcloud CLI ou l'API Dataproc pour activer la collecte de métriques personnalisées à partir d'une ou de plusieurs sources de métriques.

gcloud CLI

Collecte de métriques personnalisées

Utilisez l'indicateur

gcloud dataproc clusters create --metric-sources pour activer la collecte de métriques personnalisées à partir d'une ou de plusieurs sources de métriques.

gcloud dataproc clusters create cluster-name \ --metric-sources=METRIC_SOURCE(s) \ ... other flags

Remarques :

--metric-sources: obligatoire pour activer la collecte de métriques personnalisées. Spécifiez une ou plusieurs des sources de métriques suivantes :spark,flink,hdfs,yarn,spark-history-server,hiveserver2,hivemetastoreetmonitoring-agent-defaults. Le nom de la source de métrique n'est pas sensible à la casse. Par exemple, "yarn" ou "YARN" sont acceptables.- Les valeurs par défaut de l'agent Monitoring ne sont pas disponibles dans les clusters utilisant la version 2.2 de l'image. Vous pouvez installer l'agent Ops, qui collecte les journaux syslog et les métriques d'hôte .

Remplacer la collecte de métriques

Vous pouvez éventuellement ajouter l'indicateur --metric-overrides ou --metric-overrides-file pour activer la collecte d'une ou plusieurs métriques personnalisées à partir d'une ou plusieurs sources de métriques.

-

Toutes les métriques personnalisées et toutes les métriques Spark peuvent être listées pour la collecte en tant que métriques de remplacement. Les valeurs de remplacement des métriques sont sensibles à la casse et doivent être fournies, le cas échéant, au format CamelCase.

Exemples :

sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.committedhiveserver2:JVM:Memory:NonHeapMemoryUsage.usedyarn:ResourceManager:JvmMetrics:MemHeapMaxM

-

Seules les métriques remplacées spécifiées seront collectées à partir d'une source de métrique donnée. Par exemple, si une ou plusieurs métriques

spark:executivesont listées comme métriques de remplacement, les autres métriquesSPARKne seront pas collectées. La collecte de métriques personnalisées à partir d'autres sources de métriques n'est pas affectée. Par exemple, si les sources de métriquesSPARKetYARNsont activées et que des remplacements sont fournis uniquement pour les métriques Spark, l'ensemble standard de métriques YARN activées sera collecté. -

La source du remplacement de métrique spécifié doit être activée. Par exemple, si une ou plusieurs métriques

spark:driversont fournies en tant que métriques de remplacement, la source de métriquesparkdoit être activée (--metric-sources=spark).

Liste des métriques de remplacement

gcloud dataproc clusters create cluster-name \ --metric-sources=METRIC_SOURCE(s) \ --metric-overrides=LIST_OF_METRIC_OVERRIDES \ ... other flags

Remarques :

--metric-sources: obligatoire pour activer la collecte de métriques personnalisées. Spécifiez une ou plusieurs des sources de métriques suivantes :spark,flink,hdfs,yarn,spark-history-server,hiveserver2,hivemetastoreetmonitoring-agent-defaults. Le nom de la source de métrique n'est pas sensible à la casse. Par exemple, "yarn" ou "YARN" sont acceptables.--metric-overrides: fournissez une liste de métriques au format suivant :METRIC_SOURCE:INSTANCE:GROUP:METRIC

Exemple :

--metric-overrides=sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.committedCette option est une alternative à l'option

--metric-overrides-fileet ne peut pas être utilisée avec celle-ci.

Fichier de métriques de remplacement

gcloud dataproc clusters create cluster-name \ --metric-sources=METRIC-SOURCE(s) \ --metric-overrides-file=METRIC_OVERRIDES_FILENAME \ ... other flags

Remarques :

-

--metric-sources: obligatoire pour activer la collecte de métriques personnalisées. Spécifiez une ou plusieurs des sources de métriques suivantes :spark,flink,hdfs,yarn,spark-history-server,hiveserver2,hivemetastoreetmonitoring-agent-defaults. Le nom de la source de métrique n'est pas sensible à la casse. Par exemple, "yarn" ou "YARN" sont acceptables. -

--metric-overrides-file: spécifiez un fichier local ou Cloud Storage (gs://bucket/filename) contenant une ou plusieurs métriques au format suivant :METRIC_SOURCE:INSTANCE:GROUP:METRIC

Utilisez le format camelcase si nécessaire.Exemples :

--metric-overrides-file=gs://my-bucket/my-filename.txt--metric-overrides-file=./local-directory/local-filename.txtCette option est une alternative à l'option

--metric-overrideset ne peut pas être utilisée avec celle-ci.

API REST

Utilisez DataprocMetricConfig dans le cadre d'une requête clusters.create pour activer la collecte de métriques personnalisées. Remarque : monitoring-agent-defaults n'est pas disponible dans les clusters de version d'image 2.2, sauf si l'agent Ops est installé.

Afficher les métriques personnalisées

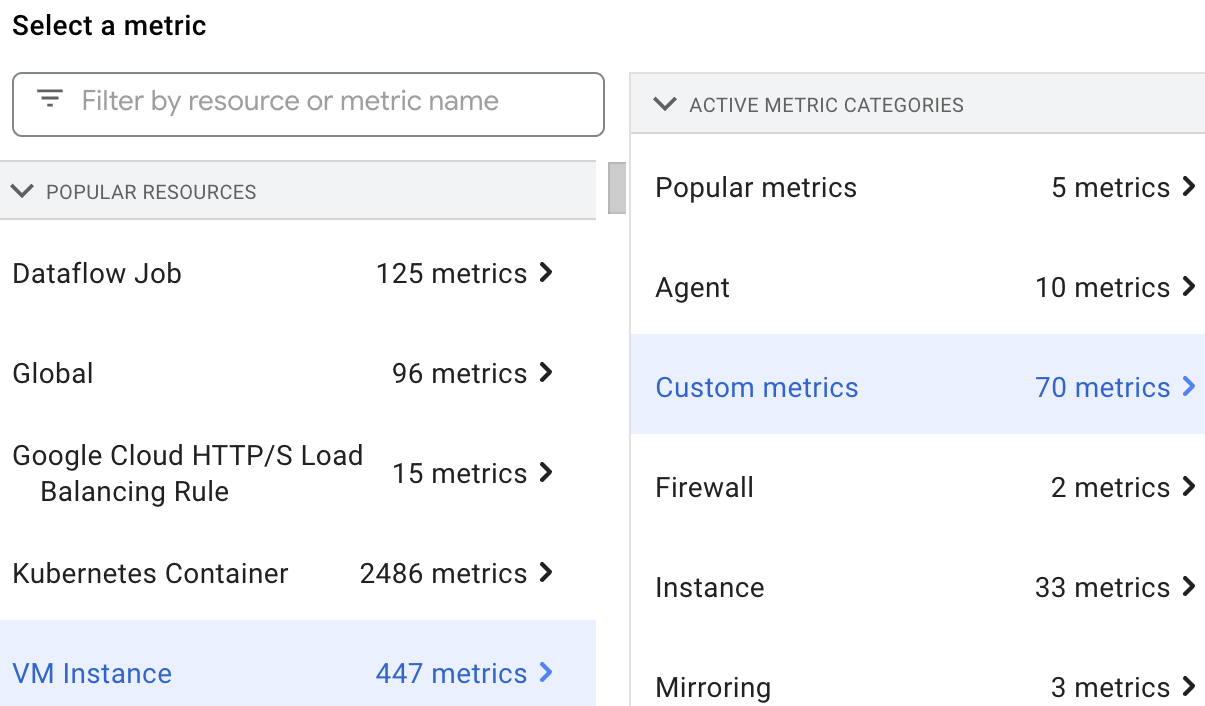

Vous pouvez sélectionner et afficher les métriques de ressources Dataproc dans l'explorateur de métriques en sélectionnant la ressource VM Instance, puis Custom metrics.

Métriques personnalisées

Vous pouvez activer Dataproc pour collecter les métriques personnalisées listées dans les tableaux suivants.

La colonne Métriques activées est marquée d'un "y" si Dataproc collecte la métrique lorsque vous activez la source de métrique associée.

Vous pouvez activer la collecte de n'importe quelle métrique listée pour une source de métrique, ainsi que de toutes les métriques Spark, si vous remplacez la collecte de l'ensemble standard de métriques activées pour la source de métrique (voir Activer la collecte de métriques personnalisées).

Dataproc utilise l'agent de surveillance pour collecter des métriques. L'activation d'une source de métriques permet de collecter les métriques de l'agent. Ces métriques ne sont pas facturées aux utilisateurs. Dataproc les utilise pour diagnostiquer les problèmes de collecte de métriques.

Métriques Hadoop

Métriques HDFS

| Métrique | Nom de l'explorateur de métriques | Métriques activées |

|---|---|---|

| hdfs:NameNode:FSNamesystem:CapacityTotalGB | dfs/FSNamesystem/CapacityTotalGB | y |

| hdfs:NameNode:FSNamesystem:CapacityUsedGB | dfs/FSNamesystem/CapacityUsedGB | y |

| hdfs:NameNode:FSNamesystem:CapacityRemainingGB | dfs/FSNamesystem/CapacityRemainingGB | y |

| hdfs:NameNode:FSNamesystem:FilesTotal | dfs/FSNamesystem/FilesTotal | y |

| hdfs:NameNode:FSNamesystem:MissingBlocks | dfs/FSNamesystem/MissingBlocks | n |

| hdfs:NameNode:FSNamesystem:ExpiredHeartbeats | dfs/FSNamesystem/ExpiredHeartbeats | n |

| hdfs:NameNode:FSNamesystem:TransactionsSinceLastCheckpoint | dfs/FSNamesystem/TransactionsSinceLastCheckpoint | n |

| hdfs:NameNode:FSNamesystem:TransactionsSinceLastLogRoll | dfs/FSNamesystem/TransactionsSinceLastLogRoll | n |

| hdfs:NameNode:FSNamesystem:LastWrittenTransactionId | dfs/FSNamesystem/LastWrittenTransactionId | n |

| hdfs:NameNode:FSNamesystem:CapacityTotal | dfs/FSNamesystem/CapacityTotal | n |

| hdfs:NameNode:FSNamesystem:CapacityUsed | dfs/FSNamesystem/CapacityUsed | n |

| hdfs:NameNode:FSNamesystem:CapacityRemaining | dfs/FSNamesystem/CapacityRemaining | n |

| hdfs:NameNode:FSNamesystem:CapacityUsedNonDFS | dfs/FSNamesystem/CapacityUsedNonDFS | n |

| hdfs:NameNode:FSNamesystem:TotalLoad | dfs/FSNamesystem/TotalLoad | n |

| hdfs:NameNode:FSNamesystem:SnapshottableDirectories | dfs/FSNamesystem/SnapshottableDirectories | n |

| hdfs:NameNode:FSNamesystem:Snapshots | dfs/FSNamesystem/Snapshots | n |

| hdfs:NameNode:FSNamesystem:BlocksTotal | dfs/FSNamesystem/BlocksTotal | n |

| hdfs:NameNode:FSNamesystem:PendingReplicationBlocks | dfs/FSNamesystem/PendingReplicationBlocks | n |

| hdfs:NameNode:FSNamesystem:UnderReplicatedBlocks | dfs/FSNamesystem/UnderReplicatedBlocks | n |

| hdfs:NameNode:FSNamesystem:CorruptBlocks | dfs/FSNamesystem/CorruptBlocks | n |

| hdfs:NameNode:FSNamesystem:ScheduledReplicationBlocks | dfs/FSNamesystem/ScheduledReplicationBlocks | n |

| hdfs:NameNode:FSNamesystem:PendingDeletionBlocks | dfs/FSNamesystem/PendingDeletionBlocks | n |

| hdfs:NameNode:FSNamesystem:ExcessBlocks | dfs/FSNamesystem/ExcessBlocks | n |

| hdfs:NameNode:FSNamesystem:PostponedMisreplicatedBlocks | dfs/FSNamesystem/PostponedMisreplicatedBlocks | n |

| hdfs:NameNode:FSNamesystem:PendingDataNodeMessageCourt | dfs/FSNamesystem/PendingDataNodeMessageCourt | n |

| hdfs:NameNode:FSNamesystem:MillisSinceLastLoadedEdits | dfs/FSNamesystem/MillisSinceLastLoadedEdits | n |

| hdfs:NameNode:FSNamesystem:BlockCapacity | dfs/FSNamesystem/BlockCapacity | n |

| hdfs:NameNode:FSNamesystem:StaleDataNodes | dfs/FSNamesystem/StaleDataNodes | n |

| hdfs:NameNode:FSNamesystem:TotalFiles | dfs/FSNamesystem/TotalFiles | n |

| hdfs:NameNode:JvmMetrics:MemHeapUsedM | dfs/jvm/MemHeapUsedM | n |

| hdfs:NameNode:JvmMetrics:MemHeapCommittedM | dfs/jvm/MemHeapCommittedM | n |

| hdfs:NameNode:JvmMetrics:MemHeapMaxM | dfs/jvm/MemHeapMaxM | n |

| hdfs:NameNode:JvmMetrics:MemMaxM | dfs/jvm/MemMaxM | n |

Métriques YARN

| Métrique | Nom de l'explorateur de métriques | Métriques activées |

|---|---|---|

| yarn:ResourceManager:ClusterMetrics:NumActiveNMs | yarn/ClusterMetrics/NumActiveNMs | y |

| yarn:ResourceManager:ClusterMetrics:NumDecommissionedNMs | yarn/ClusterMetrics/NumDecommissionedNMs | n |

| yarn:ResourceManager:ClusterMetrics:NumLostNMs | yarn/ClusterMetrics/NumLostNMs | n |

| yarn:ResourceManager:ClusterMetrics:NumUnhealthyNMs | yarn/ClusterMetrics/NumUnhealthyNMs | n |

| yarn:ResourceManager:ClusterMetrics:NumRebootedNMs | yarn/ClusterMetrics/NumRebootedNMs | n |

| yarn:ResourceManager:QueueMetrics:running_0 | yarn/QueueMetrics/running_0 | y |

| yarn:ResourceManager:QueueMetrics:running_60 | yarn/QueueMetrics/running_60 | y |

| yarn:ResourceManager:QueueMetrics:running_300 | yarn/QueueMetrics/running_300 | y |

| yarn:ResourceManager:QueueMetrics:running_1440 | yarn/QueueMetrics/running_1440 | y |

| yarn:ResourceManager:QueueMetrics:AppsSubmitted | yarn/QueueMetrics/AppsSubmitted | y |

| yarn:ResourceManager:QueueMetrics:AvailableMB | yarn/QueueMetrics/AvailableMB | y |

| yarn:ResourceManager:QueueMetrics:PendingContainers | yarn/QueueMetrics/PendingContainers | y |

| yarn:ResourceManager:QueueMetrics:AppsRunning | yarn/QueueMetrics/AppsRunning | n |

| yarn:ResourceManager:QueueMetrics:AppsPending | yarn/QueueMetrics/AppsPending | n |

| yarn:ResourceManager:QueueMetrics:AppsCompleted | yarn/QueueMetrics/AppsCompleted | n |

| yarn:ResourceManager:QueueMetrics:AppsKilled | yarn/QueueMetrics/AppsKilled | n |

| yarn:ResourceManager:QueueMetrics:AppsFailed | yarn/QueueMetrics/AppsFailed | n |

| yarn:ResourceManager:QueueMetrics:AllocatedMB | yarn/QueueMetrics/AllocatedMB | n |

| yarn:ResourceManager:QueueMetrics:AllocatedVCores | yarn/QueueMetrics/AllocatedVCores | n |

| yarn:ResourceManager:QueueMetrics:AllocatedContainers | yarn/QueueMetrics/AllocatedContainers | n |

| yarn:ResourceManager:QueueMetrics:AggregateContainersAllocated | yarn/QueueMetrics/AggregateContainersAllocated | n |

| yarn:ResourceManager:QueueMetrics:AggregateContainersReleased | yarn/QueueMetrics/AggregateContainersReleased | n |

| yarn:ResourceManager:QueueMetrics:AvailableVCores | yarn/QueueMetrics/AvailableVCores | n |

| yarn:ResourceManager:QueueMetrics:PendingMB | yarn/QueueMetrics/PendingMB | n |

| yarn:ResourceManager:QueueMetrics:PendingVCores | yarn/QueueMetrics/PendingVCores | n |

| yarn:ResourceManager:QueueMetrics:ReservedMB | yarn/QueueMetrics/ReservedMB | n |

| yarn:ResourceManager:QueueMetrics:ReservedVCores | yarn/QueueMetrics/ReservedVCores | n |

| yarn:ResourceManager:QueueMetrics:ReservedContainers | yarn/QueueMetrics/ReservedContainers | n |

| yarn:ResourceManager:QueueMetrics:ActiveUsers | yarn/QueueMetrics/ActiveUsers | n |

| yarn:ResourceManager:QueueMetrics:ActiveApplications | yarn/QueueMetrics/ActiveApplications | n |

| yarn:ResourceManager:QueueMetrics:FairShareMB | yarn/QueueMetrics/FairShareMB | n |

| yarn:ResourceManager:QueueMetrics:FairShareVCores | yarn/QueueMetrics/FairShareVCores | n |

| yarn:ResourceManager:QueueMetrics:MinShareMB | yarn/QueueMetrics/MinShareMB | n |

| yarn:ResourceManager:QueueMetrics:MinShareVCores | yarn/QueueMetrics/MinShareVCores | n |

| yarn:ResourceManager:QueueMetrics:MaxShareMB | yarn/QueueMetrics/MaxShareMB | n |

| yarn:ResourceManager:QueueMetrics:MaxShareVCores | yarn/QueueMetrics/MaxShareVCores | n |

| yarn:ResourceManager:JvmMetrics:MemHeapUsedM | yarn/jvm/MemHeapUsedM | n |

| yarn:ResourceManager:JvmMetrics:MemHeapCommittedM | yarn/jvm/MemHeapCommittedM | n |

| yarn:ResourceManager:JvmMetrics:MemHeapMaxM | yarn/jvm/MemHeapMaxM | n |

| yarn:ResourceManager:JvmMetrics:MemMaxM | yarn/jvm/MemMaxM | n |

Métriques Spark

Métriques du pilote Spark

| Métrique | Nom de l'explorateur de métriques | Métriques activées |

|---|---|---|

| spark:driver:BlockManager:disk.diskSpaceUsed_MB | spark/driver/BlockManager/disk/diskSpaceUsed_MB | y |

| spark:driver:BlockManager:memory.maxMem_MB | spark/driver/BlockManager/memory/maxMem_MB | y |

| spark:driver:BlockManager:memory.memUsed_MB | spark/driver/BlockManager/memory/memUsed_MB | y |

| spark:driver:DAGScheduler:job.allJobs | spark/driver/DAGScheduler/job/allJobs | y |

| spark:driver:DAGScheduler:stage.failedStages | spark/driver/DAGScheduler/stage/failedStages | y |

| spark:driver:DAGScheduler:stage.waitingStages | spark/driver/DAGScheduler/stage/waitingStages | y |

Métriques de l'exécuteur Spark

| Métrique | Nom de l'explorateur de métriques | Métriques activées |

|---|---|---|

| spark:executor:executor:bytesRead | spark/executor/bytesRead | y |

| spark:executor:executor:bytesWritten | spark/executor/bytesWritten | y |

| spark:executor:executor:cpuTime | spark/executor/cpuTime | y |

| spark:executor:executor:diskBytesSpilled | spark/executor/diskBytesSpilled | y |

| spark:executor:executor:recordsRead | spark/executor/recordsRead | y |

| spark:executor:executor:recordsWritten | spark/executor/recordsWritten | y |

| spark:executor:executor:runTime | spark/executor/runTime | y |

| spark:executor:executor:shuffleRecordsRead | spark/executor/shuffleRecordsRead | y |

| spark:executor:executor:shuffleRecordsWritten | spark/executor/shuffleRecordsWritten | y |

Métriques Flink

| Métrique | Nom de l'explorateur de métriques | Métriques activées |

|---|---|---|

| flink:jobmanager:numRegisteredTaskManagers | flink/jobmanager/numRegisteredTaskManagers | n |

| flink:jobmanager:numRunningJobs | flink/jobmanager/numRunningJobs | n |

| flink:jobmanager:Status.JVM.ClassLoader.ClassesLoaded | flink/jobmanager/Status.JVM.ClassLoader.ClassesLoaded | n |

| flink:jobmanager:Status.JVM.ClassLoader.ClassesUnloaded | flink/jobmanager/Status.JVM.ClassLoader.ClassesUnloaded | n |

| flink:jobmanager:Status.JVM.CPU.Load | flink/jobmanager/Status.JVM.CPU.Load | n |

| flink:jobmanager:Status.JVM.CPU.Time | flink/jobmanager/Status.JVM.CPU.Time | y |

| flink:jobmanager:Status.JVM.GarbageCollector.PSMarkSweep.Count | flink/jobmanager/Status.JVM.GarbageCollector.PSMarkSweep.Count | n |

| flink:jobmanager:Status.JVM.GarbageCollector.PSMarkSweep.Time | flink/jobmanager/Status.JVM.GarbageCollector.PSMarkSweep.Time | n |

| flink:jobmanager:Status.JVM.GarbageCollector.PSScavenge.Count | flink/jobmanager/Status.JVM.GarbageCollector.PSScavenge.Count | n |

| flink:jobmanager:Status.JVM.GarbageCollector.PSScavenge.Time | flink/jobmanager/Status.JVM.GarbageCollector.PSScavenge.Time | n |

| flink:jobmanager:Status.JVM.Memory.Direct.Count | flink/jobmanager/Status.JVM.Memory.Direct.Count | y |

| flink:jobmanager:Status.JVM.Memory.Direct.MemoryUsed | flink/jobmanager/Status.JVM.Memory.Direct.MemoryUsed | y |

| flink:jobmanager:Status.JVM.Memory.Direct.TotalCapacity | flink/jobmanager/Status.JVM.Memory.Direct.TotalCapacity | y |

| flink:jobmanager:Status.JVM.Memory.Heap.Committed | flink/jobmanager/Status.JVM.Memory.Heap.Committed | y |

| flink:jobmanager:Status.JVM.Memory.Heap.Max | flink/jobmanager/Status.JVM.Memory.Heap.Max | y |

| flink:jobmanager:Status.JVM.Memory.Heap.Used | flink/jobmanager/Status.JVM.Memory.Heap.Used | y |

| flink:jobmanager:Status.JVM.Memory.Mapped.Count | flink/jobmanager/Status.JVM.Memory.Mapped.Count | y |

| flink:jobmanager:Status.JVM.Memory.Mapped.MemoryUsed | flink/jobmanager/Status.JVM.Memory.Mapped.MemoryUsed | y |

| flink:jobmanager:Status.JVM.Memory.Mapped.TotalCapacity | flink/jobmanager/Status.JVM.Memory.Mapped.TotalCapacity | y |

| flink:jobmanager:Status.JVM.Memory.Metaspace.Committed | flink/jobmanager/Status.JVM.Memory.Metaspace.Committed | n |

| flink:jobmanager:Status.JVM.Memory.Metaspace.Max | flink/jobmanager/Status.JVM.Memory.Metaspace.Max | n |

| flink:jobmanager:Status.JVM.Memory.Metaspace.Used | flink/jobmanager/Status.JVM.Memory.Metaspace.Used | n |

| flink:jobmanager:Status.JVM.Memory.NonHeap.Committed | flink/jobmanager/Status.JVM.Memory.NonHeap.Committed | n |

| flink:jobmanager:Status.JVM.Memory.NonHeap.Max | flink/jobmanager/Status.JVM.Memory.NonHeap.Max | n |

| flink:jobmanager:Status.JVM.Memory.NonHeap.Used | flink/jobmanager/Status.JVM.Memory.NonHeap.Used | n |

| flink:jobmanager:Status.JVM.Threads.Count | flink/jobmanager/Status.JVM.Threads.Count | n |

| flink:jobmanager:taskSlotsAvailable | flink/jobmanager/taskSlotsAvailable | y |

| flink:jobmanager:taskSlotsTotal | flink/jobmanager/taskSlotsTotal | y |

| flink:operator:numRecordsIn | flink/operator/numRecordsIn | n |

| flink:operator:numRecordsInPerSecond.count | flink/operator/numRecordsInPerSecond.count | n |

| flink:operator:numRecordsInPerSecond.rate | flink/operator/numRecordsInPerSecond.rate | n |

| flink:operator:numRecordsOut | flink/operator/numRecordsOut | n |

| flink:operator:numRecordsOutPerSecond.count | flink/operator/numRecordsOutPerSecond.count | n |

| flink:operator:numRecordsOutPerSecond.rate | flink/operator/numRecordsOutPerSecond.rate | n |

| flink:operator:numSplitsProcessed | flink/operator/numSplitsProcessed | n |

| flink:task:buffers.inPoolUsage | flink/task/buffers.inPoolUsage | n |

| flink:task:buffers.inputExclusiveBuffersUsage | flink/task/buffers.inputExclusiveBuffersUsage | n |

| flink:task:buffers.inputFloatingBuffersUsage | flink/task/buffers.inputFloatingBuffersUsage | n |

| flink:task:buffers.inputQueueLength | flink/task/buffers.inputQueueLength | n |

| flink:task:buffers.outPoolUsage | flink/task/buffers.outPoolUsage | n |

| flink:task:buffers.outputQueueLength | flink/task/buffers.outputQueueLength | n |

| flink:task:idleTimeMsPerSecond.count | flink/task/idleTimeMsPerSecond.count | n |

| flink:task:idleTimeMsPerSecond.rate | flink/task/idleTimeMsPerSecond.rate | n |

| flink:task:numBuffersInLocal | flink/task/numBuffersInLocal | n |

| flink:task:numBuffersInLocalPerSecond.count | flink/task/numBuffersInLocalPerSecond.count | n |

| flink:task:numBuffersInLocalPerSecond.rate | flink/task/numBuffersInLocalPerSecond.rate | n |

| flink:task:numBuffersInRemote | flink/task/numBuffersInRemote | n |

| flink:task:numBuffersInRemotePerSecond.count | flink/task/numBuffersInRemotePerSecond.count | n |

| flink:task:numBuffersInRemotePerSecond.rate | flink/task/numBuffersInRemotePerSecond.rate | n |

| flink:task:numBuffersOut | flink/task/numBuffersOut | n |

| flink:task:numBuffersOutPerSecond.count | flink/task/numBuffersOutPerSecond.count | n |

| flink:task:numBuffersOutPerSecond.rate | flink/task/numBuffersOutPerSecond.rate | n |

| flink:task:numBytesIn | flink/task/numBytesIn | n |

| flink:task:numBytesInLocal | flink/task/numBytesInLocal | n |

| flink:task:numBytesInLocalPerSecond.count | flink/task/numBytesInLocalPerSecond.count | n |

| flink:task:numBytesInLocalPerSecond.rate | flink/task/numBytesInLocalPerSecond.rate | n |

| flink:task:numBytesInPerSecond.count | flink/task/numBytesInPerSecond.count | n |

| flink:task:numBytesInPerSecond.rate | flink/task/numBytesInPerSecond.rate | n |

| flink:task:numBytesInRemote | flink/task/numBytesInRemote | n |

| flink:task:numBytesInRemotePerSecond.count | flink/task/numBytesInRemotePerSecond.count | n |

| flink:task:numBytesInRemotePerSecond.rate | flink/task/numBytesInRemotePerSecond.rate | n |

| flink:task:numBytesOut | flink/task/numBytesOut | n |

| flink:task:numBytesOutPerSecond.count | flink/task/numBytesOutPerSecond.count | n |

| flink:task:numBytesOutPerSecond.rate | flink/task/numBytesOutPerSecond.rate | n |

| flink:task:numRecordsIn | flink/task/numRecordsIn | n |

| flink:task:numRecordsInPerSecond.count | flink/task/numRecordsInPerSecond.count | n |

| flink:task:numRecordsInPerSecond.rate | flink/task/numRecordsInPerSecond.rate | n |

| flink:task:numRecordsOut | flink/task/numRecordsOut | n |

| flink:task:numRecordsOutPerSecond.count | flink/task/numRecordsOutPerSecond.count | n |

| flink:task:numRecordsOutPerSecond.rate | flink/task/numRecordsOutPerSecond.rate | n |

| flink:task:Shuffle.Netty.Input.Buffers.inPoolUsage | flink/task/Shuffle.Netty.Input.Buffers.inPoolUsage | n |

| flink:task:Shuffle.Netty.Input.Buffers.inputExclusiveBuffersUsage | flink/task/Shuffle.Netty.Input.Buffers.inputExclusiveBuffersUsage | n |

| flink:task:Shuffle.Netty.Input.Buffers.inputFloatingBuffersUsage | flink/task/Shuffle.Netty.Input.Buffers.inputFloatingBuffersUsage | n |

| flink:task:Shuffle.Netty.Input.Buffers.inputQueueLength | flink/task/Shuffle.Netty.Input.Buffers.inputQueueLength | n |

| flink:task:Shuffle.Netty.Input.numBuffersInLocal | flink/task/Shuffle.Netty.Input.numBuffersInLocal | n |

| flink:task:Shuffle.Netty.Input.numBuffersInLocalPerSecond.count | flink/task/Shuffle.Netty.Input.numBuffersInLocalPerSecond.count | n |

| flink:task:Shuffle.Netty.Input.numBuffersInLocalPerSecond.rate | flink/task/Shuffle.Netty.Input.numBuffersInLocalPerSecond.rate | n |

| flink:task:Shuffle.Netty.Input.numBuffersInRemote | flink/task/Shuffle.Netty.Input.numBuffersInRemote | n |

| flink:task:Shuffle.Netty.Input.numBuffersInRemotePerSecond.count | flink/task/Shuffle.Netty.Input.numBuffersInRemotePerSecond.count | n |

| flink:task:Shuffle.Netty.Input.numBuffersInRemotePerSecond.rate | flink/task/Shuffle.Netty.Input.numBuffersInRemotePerSecond.rate | n |

| flink:task:Shuffle.Netty.Input.numBytesInLocal | flink/task/Shuffle.Netty.Input.numBytesInLocal | n |

| flink:task:Shuffle.Netty.Input.numBytesInLocalPerSecond.count | flink/task/Shuffle.Netty.Input.numBytesInLocalPerSecond.count | n |

| flink:task:Shuffle.Netty.Input.numBytesInLocalPerSecond.rate | flink/task/Shuffle.Netty.Input.numBytesInLocalPerSecond.rate | n |

| flink:task:Shuffle.Netty.Input.numBytesInRemote | flink/task/Shuffle.Netty.Input.numBytesInRemote | n |

| flink:task:Shuffle.Netty.Input.numBytesInRemotePerSecond.count | flink/task/Shuffle.Netty.Input.numBytesInRemotePerSecond.count | n |

| flink:task:Shuffle.Netty.Input.numBytesInRemotePerSecond.rate | flink/task/Shuffle.Netty.Input.numBytesInRemotePerSecond.rate | n |

| flink:task:Shuffle.Netty.Output.Buffers.outPoolUsage | flink/task/Shuffle.Netty.Output.Buffers.outPoolUsage | n |

| flink:task:Shuffle.Netty.Output.Buffers.outputQueueLength | flink/task/Shuffle.Netty.Output.Buffers.outputQueueLength | n |

| flink:taskmanager:Status.flink.Memory.Managed.Total | flink/taskmanager/Status.flink.Memory.Managed.Total | n |

| flink:taskmanager:Status.flink.Memory.Managed.Used | flink/taskmanager/Status.flink.Memory.Managed.Used | n |

| flink:taskmanager:Status.JVM.ClassLoader.ClassesLoaded | flink/taskmanager/Status.JVM.ClassLoader.ClassesLoaded | n |

| flink:taskmanager:Status.JVM.ClassLoader.ClassesUnloaded | flink/taskmanager/Status.JVM.ClassLoader.ClassesUnloaded | n |

| flink:taskmanager:Status.JVM.CPU.Load | flink/taskmanager/Status.JVM.CPU.Load | n |

| flink:taskmanager:Status.JVM.CPU.Time | flink/taskmanager/Status.JVM.CPU.Time | y |

| flink:taskmanager:Status.JVM.GarbageCollector.PSMarkSweep.Count | flink/taskmanager/Status.JVM.GarbageCollector.PSMarkSweep.Count | n |

| flink:taskmanager:Status.JVM.GarbageCollector.PSMarkSweep.Time | flink/taskmanager/Status.JVM.GarbageCollector.PSMarkSweep.Time | n |

| flink:taskmanager:Status.JVM.GarbageCollector.PSScavenge.Count | flink/taskmanager/Status.JVM.GarbageCollector.PSScavenge.Count | n |

| flink:taskmanager:Status.JVM.GarbageCollector.PSScavenge.Time | flink/taskmanager/Status.JVM.GarbageCollector.PSScavenge.Time | n |

| flink:taskmanager:Status.JVM.Memory.Direct.Count | flink/taskmanager/Status.JVM.Memory.Direct.Count | y |

| flink:taskmanager:Status.JVM.Memory.Direct.MemoryUsed | flink/taskmanager/Status.JVM.Memory.Direct.MemoryUsed | y |

| flink:taskmanager:Status.JVM.Memory.Direct.TotalCapacity | flink/taskmanager/Status.JVM.Memory.Direct.TotalCapacity | y |

| flink:taskmanager:Status.JVM.Memory.Heap.Committed | flink/taskmanager/Status.JVM.Memory.Heap.Committed | y |

| flink:taskmanager:Status.JVM.Memory.Heap.Max | flink/taskmanager/Status.JVM.Memory.Heap.Max | y |

| flink:taskmanager:Status.JVM.Memory.Heap.Used | flink/taskmanager/Status.JVM.Memory.Heap.Used | y |

| flink:taskmanager:Status.JVM.Memory.Mapped.Count | flink/taskmanager/Status.JVM.Memory.Mapped.Count | y |

| flink:taskmanager:Status.JVM.Memory.Mapped.MemoryUsed | flink/taskmanager/Status.JVM.Memory.Mapped.MemoryUsed | y |

| flink:taskmanager:Status.JVM.Memory.Mapped.TotalCapacity | flink/taskmanager/Status.JVM.Memory.Mapped.TotalCapacity | y |

| flink:taskmanager:Status.JVM.Memory.Metaspace.Committed | flink/taskmanager/Status.JVM.Memory.Metaspace.Committed | n |

| flink:taskmanager:Status.JVM.Memory.Metaspace.Max | flink/taskmanager/Status.JVM.Memory.Metaspace.Max | n |

| flink:taskmanager:Status.JVM.Memory.Metaspace.Used | flink/taskmanager/Status.JVM.Memory.Metaspace.Used | n |

| flink:taskmanager:Status.JVM.Memory.NonHeap.Committed | flink/taskmanager/Status.JVM.Memory.NonHeap.Committed | n |

| flink:taskmanager:Status.JVM.Memory.NonHeap.Max | flink/taskmanager/Status.JVM.Memory.NonHeap.Max | n |

| flink:taskmanager:Status.JVM.Memory.NonHeap.Used | flink/taskmanager/Status.JVM.Memory.NonHeap.Used | n |

| flink:taskmanager:Status.JVM.Threads.Count | flink/taskmanager/Status.JVM.Threads.Count | n |

| flink:taskmanager:Status.Network.AvailableMemorySegments | flink/taskmanager/Status.Network.AvailableMemorySegments | n |

| flink:taskmanager:Status.Network.TotalMemorySegments | flink/taskmanager/Status.Network.TotalMemorySegments | n |

| flink:taskmanager:Status.Shuffle.Netty.AvailableMemory | flink/taskmanager/Status.Shuffle.Netty.AvailableMemory | n |

| flink:taskmanager:Status.Shuffle.Netty.AvailableMemorySegments | flink/taskmanager/Status.Shuffle.Netty.AvailableMemorySegments | n |

| flink:taskmanager:Status.Shuffle.Netty.TotalMemory | flink/taskmanager/Status.Shuffle.Netty.TotalMemory | n |

| flink:taskmanager:Status.Shuffle.Netty.TotalMemorySegments | flink/taskmanager/Status.Shuffle.Netty.TotalMemorySegments | n |

| flink:taskmanager:Status.Shuffle.Netty.UsedMemory | flink/taskmanager/Status.Shuffle.Netty.UsedMemory | n |

| flink:taskmanager:Status.Shuffle.Netty.UsedMemorySegments | flink/taskmanager/Status.Shuffle.Netty.UsedMemorySegments | n |

Métriques du serveur d'historique Spark

Dataproc collecte les métriques de mémoire JVM du service d'historique Spark suivantes :

| Métrique | Nom de l'explorateur de métriques | Métriques activées |

|---|---|---|

| sparkHistoryServer:JVM:Memory:HeapMemoryUsage.committed | sparkHistoryServer/memory/CommittedHeapMemory | y |

| sparkHistoryServer:JVM:Memory:HeapMemoryUsage.used | sparkHistoryServer/memory/UsedHeapMemory | y |

| sparkHistoryServer:JVM:Memory:HeapMemoryUsage.max | sparkHistoryServer/memory/MaxHeapMemory | y |

| sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.committed | sparkHistoryServer/memory/CommittedNonHeapMemory | y |

| sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.used | sparkHistoryServer/memory/UsedNonHeapMemory | y |

| sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.max | sparkHistoryServer/memory/MaxNonHeapMemory | y |

Métriques HiveServer2

| Métrique | Nom de l'explorateur de métriques | Métriques activées |

|---|---|---|

| hiveserver2:JVM:Memory:HeapMemoryUsage.committed | hiveserver2/memory/CommittedHeapMemory | y |

| hiveserver2:JVM:Memory:HeapMemoryUsage.used | hiveserver2/memory/UsedHeapMemory | y |

| hiveserver2:JVM:Memory:HeapMemoryUsage.max | hiveserver2/memory/MaxHeapMemory | y |

| hiveserver2:JVM:Memory:NonHeapMemoryUsage.committed | hiveserver2/memory/CommittedNonHeapMemory | y |

| hiveserver2:JVM:Memory:NonHeapMemoryUsage.used | hiveserver2/memory/UsedNonHeapMemory | y |

| hiveserver2:JVM:Memory:NonHeapMemoryUsage.max | hiveserver2/memory/MaxNonHeapMemory | y |

Métriques du métastore Hive

| Métrique | Nom de l'explorateur de métriques | Métriques activées |

|---|---|---|

| hivemetastore:API:GetDatabase:Mean | hivemetastore/get_database/mean | y |

| hivemetastore:API:CreateDatabase:Mean | hivemetastore/create_database/mean | y |

| hivemetastore:API:DropDatabase:Mean | hivemetastore/drop_database/mean | y |

| hivemetastore:API:AlterDatabase:Mean | hivemetastore/alter_database/mean | y |

| hivemetastore:API:GetAllDatabases:Mean | hivemetastore/get_all_databases/mean | y |

| hivemetastore:API:CreateTable:Mean | hivemetastore/create_table/mean | y |

| hivemetastore:API:DropTable:Mean | hivemetastore/drop_table/mean | y |

| hivemetastore:API:AlterTable:Mean | hivemetastore/alter_table/mean | y |

| hivemetastore:API:GetTable:Mean | hivemetastore/get_table/mean | y |

| hivemetastore:API:GetAllTables:Mean | hivemetastore/get_all_tables/mean | y |

| hivemetastore:API:AddPartitionsReq:Mean | hivemetastore/add_partitions_req/mean | y |

| hivemetastore:API:DropPartition:Mean | hivemetastore/drop_partition/mean | y |

| hivemetastore:API:AlterPartition:Mean | hivemetastore/alter_partition/mean | y |

| hivemetastore:API:GetPartition:Mean | hivemetastore/get_partition/mean | y |

| hivemetastore:API:GetPartitionNames:Mean | hivemetastore/get_partition_names/mean | y |

| hivemetastore:API:GetPartitionsPs:Mean | hivemetastore/get_partitions_ps/mean | y |

| hivemetastore:API:GetPartitionsPsWithAuth:Mean | hivemetastore/get_partitions_ps_with_auth/mean | y |

Mesures des métriques du métastore Hive

| Mesure statistique | Exemple de métrique | Exemple de nom de métrique |

|---|---|---|

| Max | hivemetastore:API:GetDatabase:Max | hivemetastore/get_database/max |

| Min | hivemetastore:API:GetDatabase:Min | hivemetastore/get_database/min |

| Moyenne | hivemetastore:API:GetDatabase:Mean | hivemetastore/get_database/mean |

| Nombre | hivemetastore:API:GetDatabase:Count | hivemetastore/get_database/count |

| 50e centile | hivemetastore:API:GetDatabase:50thPercentile | hivemetastore/get_database/median |

| 75e centile | hivemetastore:API:GetDatabase:75thPercentile | hivemetastore/get_database/75th_percentile |

| 95e centile | hivemetastore:API:GetDatabase:95thPercentile | hivemetastore/get_database/95th_percentile |

| 98e centile | hivemetastore:API:GetDatabase:98thPercentile | hivemetastore/get_database/98th_percentile |

| 99e centile | hivemetastore:API:GetDatabase:99thPercentile | hivemetastore/get_database/99th_percentile |

| 999e centile | hivemetastore:API:GetDatabase:999thPercentile | hivemetastore/get_database/999th_percentile |

| StdDev | hivemetastore:API:GetDatabase:StdDev | hivemetastore/get_database/stddev |

| FifteenMinuteRate | hivemetastore:API:GetDatabase:FifteenMinuteRate | hivemetastore/get_database/15min_rate |

| FiveMinuteRate | hivemetastore:API:GetDatabase:FiveMinuteRate | hivemetastore/get_database/5min_rate |

| OneMinuteRate | hivemetastore:API:GetDatabase:OneMinuteRate | hivemetastore/get_database/1min_rate |

| MeanRate | hivemetastore:API:GetDatabase:MeanRate | hivemetastore/get_database/mean_rate |

Métriques de l'agent de surveillance Dataproc

Dataproc collecte les métriques de l'agent de surveillance Dataproc suivantes lorsque vous définissez --metric-sources=monitoring-agent-defaults.

Ces métriques sont publiées avec le préfixe agent.googleapis.com.

CPU

agent.googleapis.com/cpu/load_15m

agent.googleapis.com/cpu/load_1m

agent.googleapis.com/cpu/load_5m

agent.googleapis.com/cpu/usage_time*

agent.googleapis.com/cpu/utilization*

Disque

agent.googleapis.com/disk/bytes_used

agent.googleapis.com/disk/io_time

agent.googleapis.com/disk/merged_operations

agent.googleapis.com/disk/operation_count

agent.googleapis.com/disk/operation_time

agent.googleapis.com/disk/pending_operations

agent.googleapis.com/disk/percent_used

agent.googleapis.com/disk/read_bytes_count

Swap

agent.googleapis.com/swap/bytes_used

agent.googleapis.com/swap/io

agent.googleapis.com/swap/percent_used

Mémoire

agent.googleapis.com/memory/bytes_used

agent.googleapis.com/memory/percent_used

Processus : certains attributs sont soumis à des quotas spécifiques.

agent.googleapis.com/processes/count_by_state

agent.googleapis.com/processes/cpu_time

agent.googleapis.com/processes/disk/read_bytes_count

agent.googleapis.com/processes/disk/write_bytes_count

agent.googleapis.com/processes/fork_count

agent.googleapis.com/processes/rss_usage

agent.googleapis.com/processes/vm_usage

Interface

agent.googleapis.com/interface/errors

agent.googleapis.com/interface/packets

agent.googleapis.com/interface/traffic

Réseau

agent.googleapis.com/network/tcp_connections

Créer un tableau de bord Monitoring

Vous pouvez créer un tableau de bord Monitoring pour afficher les graphiques des métriques Dataproc sélectionnées.

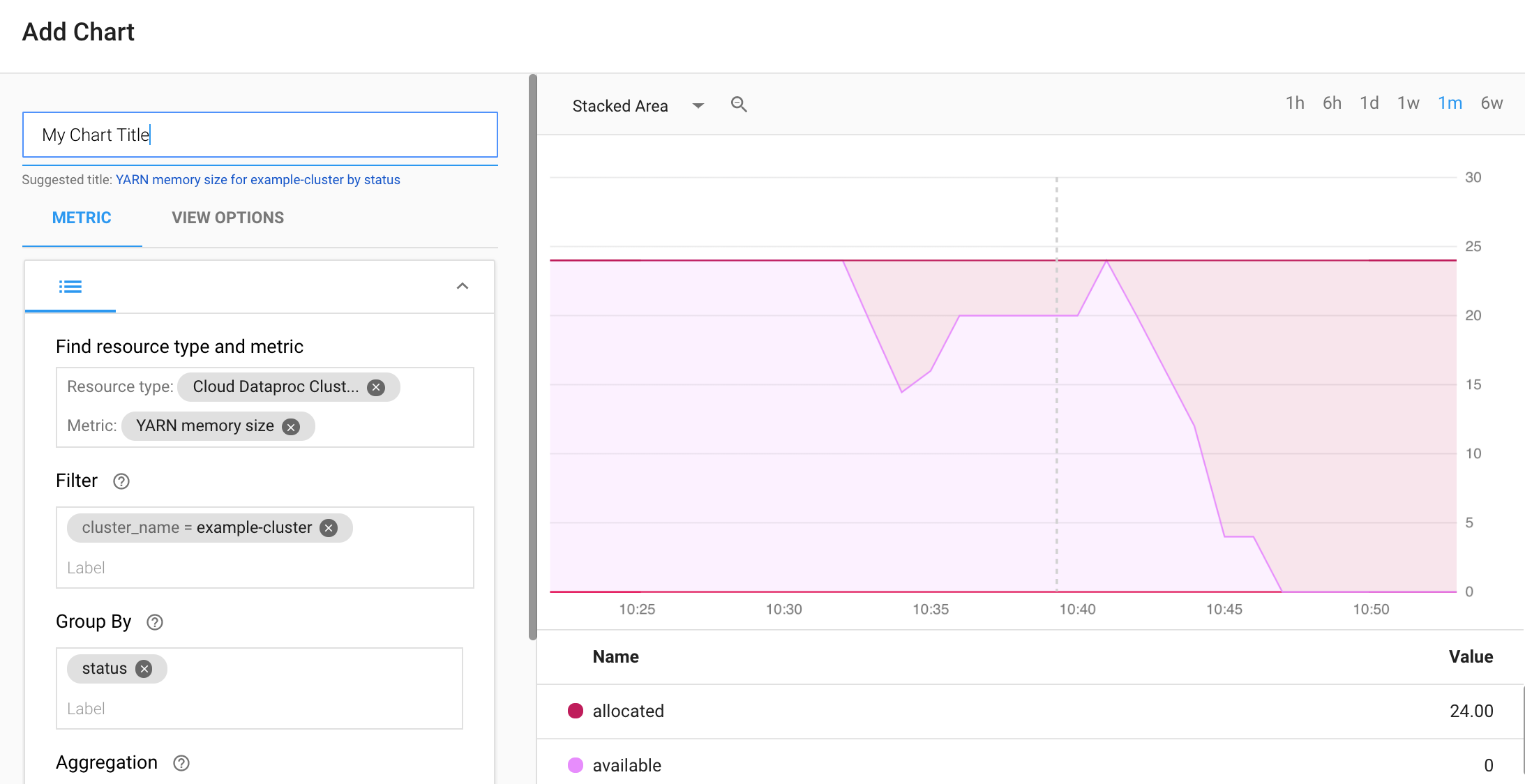

Sélectionnez + CRÉER UN TABLEAU DE BORD sur la page Aperçu des tableaux de bord de Monitoring. Attribuez un nom au tableau de bord, puis cliquez sur Add Chart (Ajouter un graphique) dans le menu situé dans l'angle supérieur droit pour ouvrir la fenêtre correspondante. Sélectionnez le type de ressource "Cloud Dataproc Cluster" (Cluster Cloud Dataproc). Sélectionnez une ou plusieurs métriques, ainsi que des propriétés de métrique et de graphique. Ensuite, enregistrez le graphique.

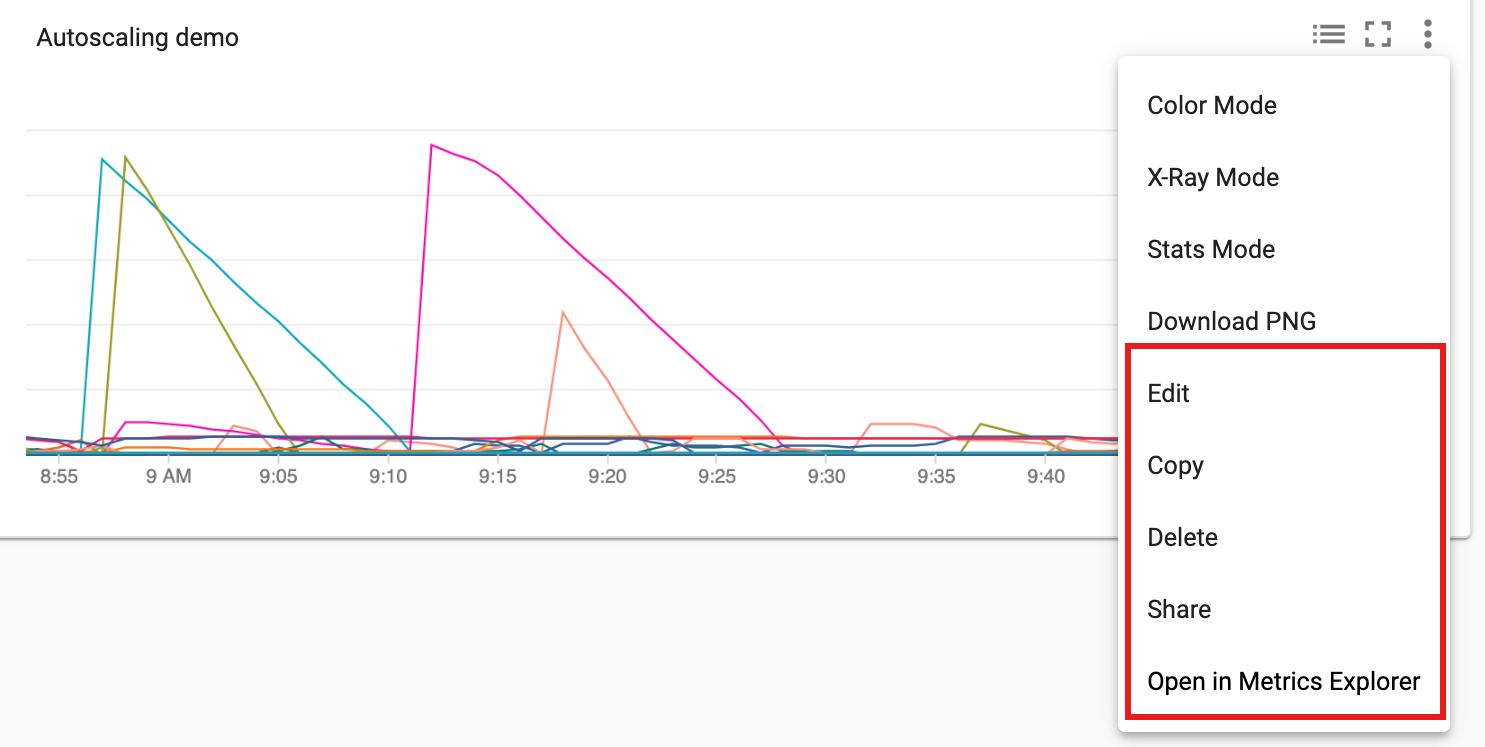

Vous pouvez ajouter des graphiques supplémentaires à votre tableau de bord. Une fois que vous avez enregistré le tableau de bord, son nom apparaît sur la page Aperçu des tableaux de bord de Monitoring. Les graphiques de tableau de bord peuvent être consultés, mis à jour et supprimés depuis la page d'affichage du tableau de bord.

Étape suivante

- Consultez la documentation Cloud Monitoring.

- Découvrez comment créer des alertes de métriques Dataproc.