Dieses Dokument enthält Informationen zu Spark-Messwerten. Standardmäßig werden mit Serverless for Apache Spark verfügbare Spark-Messwerte erfasst, sofern Sie nicht Eigenschaften für die Erfassung von Spark-Messwerten verwenden, um die Erfassung eines oder mehrerer Spark-Messwerte zu deaktivieren oder zu überschreiben.

Weitere Attribute, die Sie beim Senden einer Serverless for Apache Spark-Spark-Batcharbeitslast festlegen können, finden Sie unter Spark-Attribute.

Attribute für die Erfassung von Spark-Messwerten

Mit den in diesem Abschnitt aufgeführten Attributen können Sie die Erfassung eines oder mehrerer verfügbarer Spark-Messwerte deaktivieren oder überschreiben.

| Attribut | Beschreibung |

|---|---|

spark.dataproc.driver.metrics |

Hiermit können Sie Spark-Treibermesswerte deaktivieren oder überschreiben. |

spark.dataproc.executor.metrics |

Hiermit können Sie Spark-Executor-Messwerte deaktivieren oder überschreiben. |

spark.dataproc.system.metrics |

Damit können Sie Spark-Systemmesswerte deaktivieren. |

Beispiele für die gcloud CLI:

Erfassung von Spark-Treibermesswerten deaktivieren:

gcloud dataproc batches submit spark \ --properties spark.dataproc.driver.metrics="" \ --region=region \ other args ...

Überschreiben Sie die standardmäßige Erfassung von Treibermesswerten in Spark, um nur

BlockManager:disk.diskSpaceUsed_MB- undDAGScheduler:stage.failedStages-Messwerte zu erfassen:gcloud dataproc batches submit spark \ --properties=^~^spark.dataproc.driver.metrics="BlockManager:disk.diskSpaceUsed_MB,DAGScheduler:stage.failedStages" \ --region=region \ other args ...

Verfügbare Spark-Messwerte

Bei Serverless for Apache Spark werden die in diesem Abschnitt aufgeführten Spark-Messwerte erfasst, sofern Sie die Erfassung nicht mit Spark-Attributen für die Messwerterfassung deaktivieren oder überschreiben.

custom.googleapis.com/METRIC_EXPLORER_NAME.

Spark-Treibermesswerte

| Messwert | Name des Metrics Explorer |

|---|---|

| BlockManager:disk.diskSpaceUsed_MB | spark/driver/BlockManager/disk/diskSpaceUsed_MB |

| BlockManager:memory.maxMem_MB | spark/driver/BlockManager/memory/maxMem_MB |

| BlockManager:memory.memUsed_MB | spark/driver/BlockManager/memory/memUsed_MB |

| DAGScheduler:job.activeJobs | spark/driver/DAGScheduler/job/activeJobs |

| DAGScheduler:job.allJobs | spark/driver/DAGScheduler/job/allJobs |

| DAGScheduler:messageProcessingTime | spark/driver/DAGScheduler/messageProcessingTime |

| DAGScheduler:stage.failedStages | spark/driver/DAGScheduler/stage/failedStages |

| DAGScheduler:stage.runningStages | spark/driver/DAGScheduler/stage/runningStages |

| DAGScheduler:stage.waitingStages | spark/driver/DAGScheduler/stage/waitingStages |

Messwerte für Spark-Ausführer

| Messwert | Name des Metrics Explorer |

|---|---|

| ExecutorAllocationManager:executors.numberExecutorsDecommissionUnfinished | spark/driver/ExecutorAllocationManager/executors/numberExecutorsDecommissionUnfinished |

| ExecutorAllocationManager:executors.numberExecutorsExitedUnexpectedly | spark/driver/ExecutorAllocationManager/executors/numberExecutorsExitedUnexpectedly |

| ExecutorAllocationManager:executors.numberExecutorsGracefullyDecommissioned | spark/driver/ExecutorAllocationManager/executors/numberExecutorsGracefullyDecommissioned |

| ExecutorAllocationManager:executors.numberExecutorsKilledByDriver | spark/driver/ExecutorAllocationManager/executors/numberExecutorsKilledByDriver |

| LiveListenerBus:queue.executorManagement.listenerProcessingTime | spark/driver/LiveListenerBus/queue/executorManagement/listenerProcessingTime |

| executor:bytesRead | spark/executor/bytesRead |

| executor:bytesWritten | spark/executor/bytesWritten |

| executor:cpuTime | spark/executor/cpuTime |

| executor:diskBytesSpilled | spark/executor/diskBytesSpilled |

| executor:jvmGCTime | spark/executor/jvmGCTime |

| executor:memoryBytesSpilled | spark/executor/memoryBytesSpilled |

| executor:recordsRead | spark/executor/recordsRead |

| executor:recordsWritten | spark/executor/recordsWritten |

| executor:runTime | spark/executor/runTime |

| executor:shuffleFetchWaitTime | spark/executor/shuffleFetchWaitTime |

| executor:shuffleRecordsRead | spark/executor/shuffleRecordsRead |

| executor:shuffleRecordsWritten | spark/executor/shuffleRecordsWritten |

| executor:shuffleRemoteBytesReadToDisk | spark/executor/shuffleRemoteBytesReadToDisk |

| executor:shuffleWriteTime | spark/executor/shuffleWriteTime |

| executor:succeededTasks | spark/executor/succeededTasks |

| ExecutorMetrics:MajorGCTime | spark/executor/ExecutorMetrics/MajorGCTime |

| ExecutorMetrics:MinorGCTime | spark/executor/ExecutorMetrics/MinorGCTime |

Systemmesswerte

| Messwert | Name des Metrics Explorer |

|---|---|

| agent:uptime | agent/uptime |

| cpu:utilization | cpu/utilization |

| disk:bytes_used | disk/bytes_used |

| disk:percent_used | disk/percent_used |

| memory:bytes_used | memory/bytes_used |

| memory:percent_used | memory/percent_used |

| network:tcp_connections | network/tcp_connections |

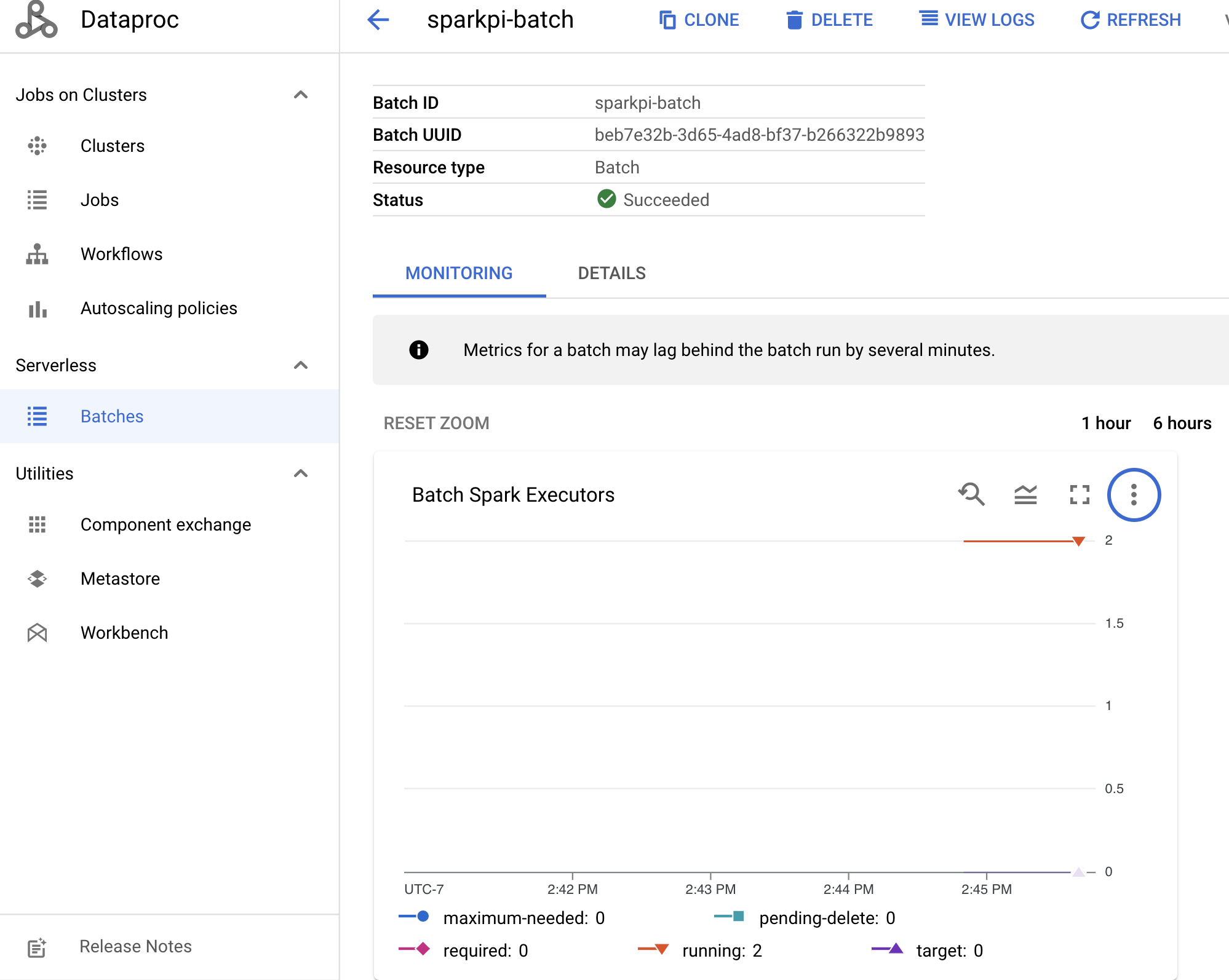

Spark-Messwerte ansehen

Wenn Sie Batchmesswerte aufrufen möchten, klicken Sie in derGoogle Cloud -Konsole auf der Dataproc-Seite Batches auf eine Batch-ID, um die Seite Details für den Batch zu öffnen. Auf dem Tab „Monitoring“ wird ein Messwertdiagramm für die Batcharbeitslast angezeigt.

Weitere Informationen zum Ansehen der erfassten Messwerte finden Sie unter Cloud Monitoring für Dataproc.