Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

Halaman ini menjelaskan cara menyesuaikan parameter skala dan performa lingkungan sesuai kebutuhan project Anda, sehingga Anda mendapatkan performa yang lebih baik dan mengurangi biaya untuk resource yang tidak digunakan oleh lingkungan Anda.

Halaman lain tentang penskalaan dan pengoptimalan:

- Untuk mengetahui informasi tentang penskalaan lingkungan, lihat Menskalakan lingkungan.

- Untuk mengetahui informasi tentang cara kerja penskalaan lingkungan, lihat Penskalaan lingkungan.

- Untuk tutorial tentang cara memantau metrik lingkungan utama, lihat Memantau kondisi dan performa lingkungan dengan metrik utama.

Ringkasan proses pengoptimalan

Membuat perubahan pada parameter lingkungan dapat memengaruhi banyak aspek performa lingkungan Anda. Sebaiknya optimalkan lingkungan Anda dalam iterasi:

- Mulai dengan preset lingkungan.

- Jalankan DAG Anda.

- Amati performa lingkungan Anda.

- Sesuaikan parameter performa dan skala lingkungan, lalu ulangi dari langkah sebelumnya.

Mulai dengan preset lingkungan

Saat membuat lingkungan di Google Cloud konsol, Anda dapat memilih salah satu dari tiga preset lingkungan. Preset ini menetapkan konfigurasi skala dan performa awal lingkungan Anda; setelah membuat lingkungan, Anda dapat mengubah semua parameter skala dan performa yang disediakan oleh preset.

Sebaiknya mulai dengan salah satu preset, berdasarkan estimasi berikut:

- Jumlah total DAG yang Anda rencanakan untuk di-deploy di lingkungan

- Jumlah maksimum operasi DAG serentak

- Jumlah maksimum tugas serentak

Performa lingkungan Anda bergantung pada penerapan DAG tertentu yang Anda jalankan di lingkungan Anda. Tabel berikut mencantumkan estimasi yang didasarkan pada konsumsi resource rata-rata. Jika Anda memperkirakan DAG akan menggunakan lebih banyak resource, sesuaikan estimasinya.

| Preset yang direkomendasikan | Total DAG | Operasi DAG serentak maks. | Tugas serentak maksimum |

|---|---|---|---|

| Kecil | 50 | 15 | 18 |

| Sedang | 250 | 60 | 100 |

| Besar | 1000 | 250 | 400 |

Misalnya, lingkungan harus menjalankan 40 DAG. Semua DAG harus berjalan secara bersamaan dengan satu tugas aktif. Lingkungan ini kemudian akan menggunakan preset Sedang, karena jumlah maksimum tugas dan DAG yang berjalan serentak melebihi estimasi yang direkomendasikan untuk preset Kecil.

Menjalankan DAG

Setelah lingkungan dibuat, upload DAG Anda ke lingkungan tersebut. Jalankan DAG dan amati performa lingkungan.

Sebaiknya jalankan DAG Anda sesuai jadwal yang mencerminkan penerapan DAG Anda di dunia nyata. Misalnya, jika Anda ingin menjalankan beberapa DAG secara bersamaan, pastikan untuk memeriksa performa lingkungan saat semua DAG ini berjalan secara bersamaan.

Mengamati performa lingkungan

Bagian ini berfokus pada aspek penyesuaian kapasitas dan performa Cloud Composer 2 yang paling umum. Sebaiknya ikuti panduan ini langkah demi langkah karena pertimbangan performa yang paling umum dibahas terlebih dahulu.

Buka dasbor Monitoring

Anda dapat memantau metrik performa lingkungan di Dasbor pemantauan lingkungan Anda.

Untuk membuka dasbor Monitoring untuk lingkungan Anda:

Di Google Cloud console, buka halaman Environments.

Klik nama lingkungan Anda.

Buka tab Monitoring.

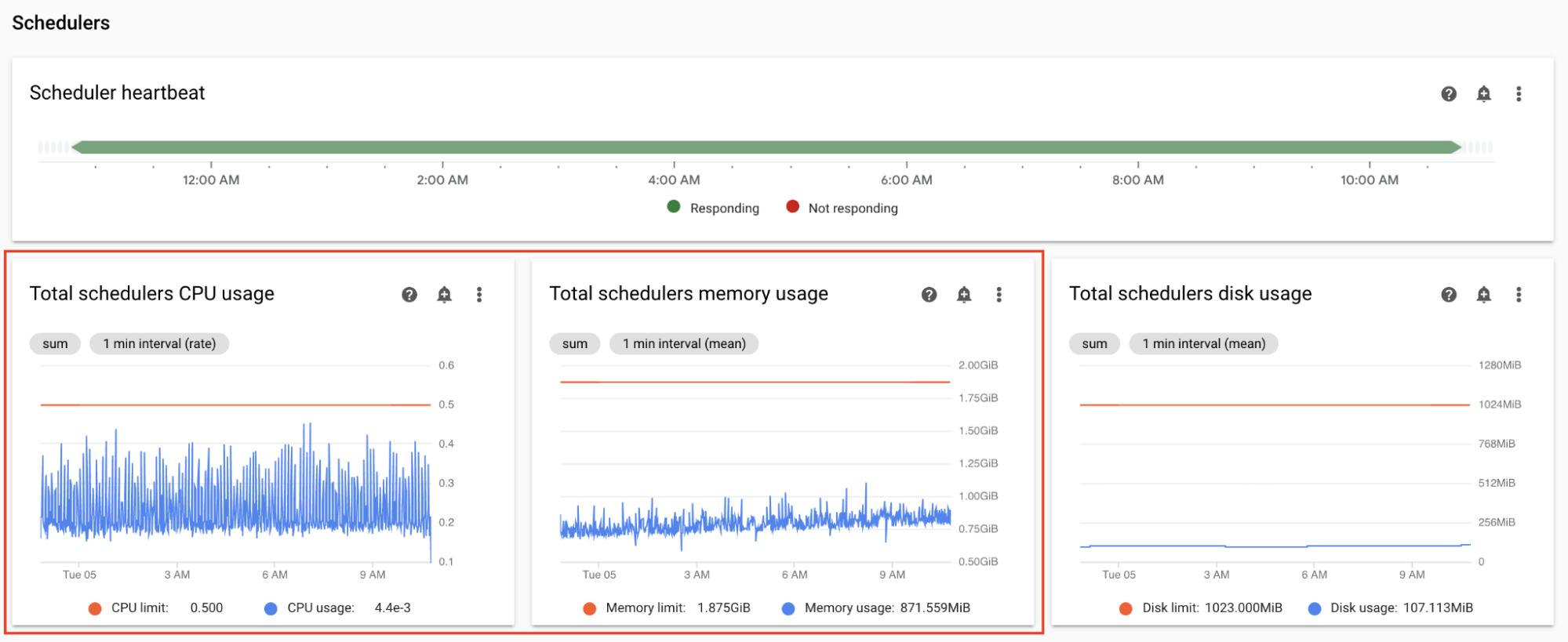

Memantau metrik CPU dan memori penjadwal

Metrik CPU dan memori penjadwal Airflow membantu Anda memeriksa apakah performa penjadwal adalah bottleneck dalam keseluruhan performa Airflow.

Di dasbor Monitoring, di bagian Penjadwal, amati grafik untuk penjadwal Airflow di lingkungan Anda:

- Total penggunaan CPU penjadwal

- Total penggunaan memori penjadwal

Sesuaikan sesuai dengan pengamatan Anda:

Jika penggunaan CPU Penjadwal secara konsisten di bawah 30%-35%, sebaiknya:

Jika penggunaan CPU Penjadwal melebihi 80% selama lebih dari beberapa persen dari total waktu, sebaiknya:

Memantau total waktu penguraian untuk semua file DAG

Penjadwal mengurai DAG sebelum menjadwalkan operasi DAG. Jika DAG memerlukan waktu lama untuk diuraikan, hal ini akan menghabiskan kapasitas penjadwal dan dapat mengurangi performa eksekusi DAG.

Di dasbor Monitoring, di bagian DAG Statistics, amati grafik untuk total waktu penguraian DAG.

Jika jumlahnya melebihi sekitar 10 detik, penjadwal Anda mungkin kelebihan beban dengan penguraian DAG dan tidak dapat menjalankan DAG secara efektif. Frekuensi penguraian DAG default di Airflow adalah 30 detik; jika waktu penguraian DAG melebihi nilai minimum ini, siklus penguraian akan mulai tumpang-tindih, yang kemudian menghabiskan kapasitas penjadwal.

Berdasarkan pengamatan Anda, sebaiknya:

- Sederhanakan DAG Anda, termasuk dependensi Python-nya.

- Tingkatkan interval penguraian file DAG dan tingkatkan interval listingan direktori DAG.

- Meningkatkan jumlah penjadwal.

- Meningkatkan CPU penjadwal.

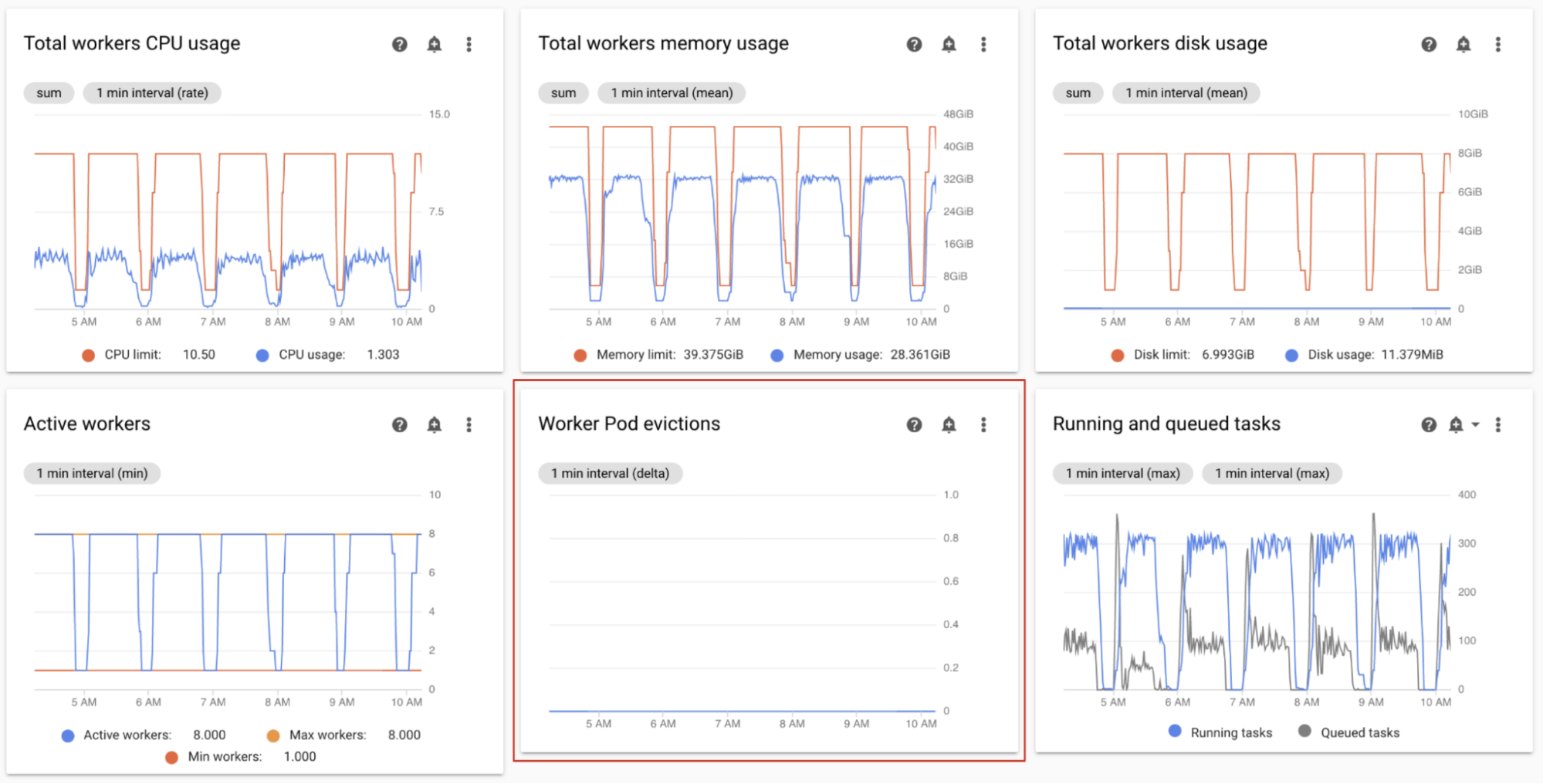

Memantau penghapusan pod pekerja

Penghapusan pod dapat terjadi saat pod tertentu di cluster lingkungan Anda mencapai batas resource-nya.

Jika pod pekerja Airflow dihapus, semua instance tugas yang berjalan di pod tersebut akan terganggu, dan kemudian ditandai sebagai gagal oleh Airflow.

Sebagian besar masalah terkait penghapusan pod pekerja terjadi karena situasi kehabisan memori di pekerja.

Di dasbor Monitoring, di bagian Workers, amati grafik Pengusiran Pod Pekerja untuk lingkungan Anda.

Grafik Total workers memory usage menampilkan perspektif total lingkungan. Satu pekerja masih dapat melebihi batas memori, meskipun penggunaan memori sudah baik di tingkat lingkungan.

Berdasarkan pengamatan Anda, sebaiknya:

- Meningkatkan memori yang tersedia untuk pekerja.

- Mengurangi konkurensi pekerja. Dengan cara ini, pekerja tunggal menangani lebih sedikit tugas sekaligus. Hal ini memberikan lebih banyak memori atau penyimpanan untuk setiap tugas. Jika mengubah konkurensi pekerja, Anda mungkin juga ingin meningkatkan jumlah maksimum pekerja. Dengan cara ini, jumlah tugas yang dapat ditangani lingkungan Anda sekaligus tetap sama. Misalnya, jika Anda mengurangi Konkurensi pekerja dari 12 menjadi 6, Anda dapat menggandakan jumlah maksimum pekerja.

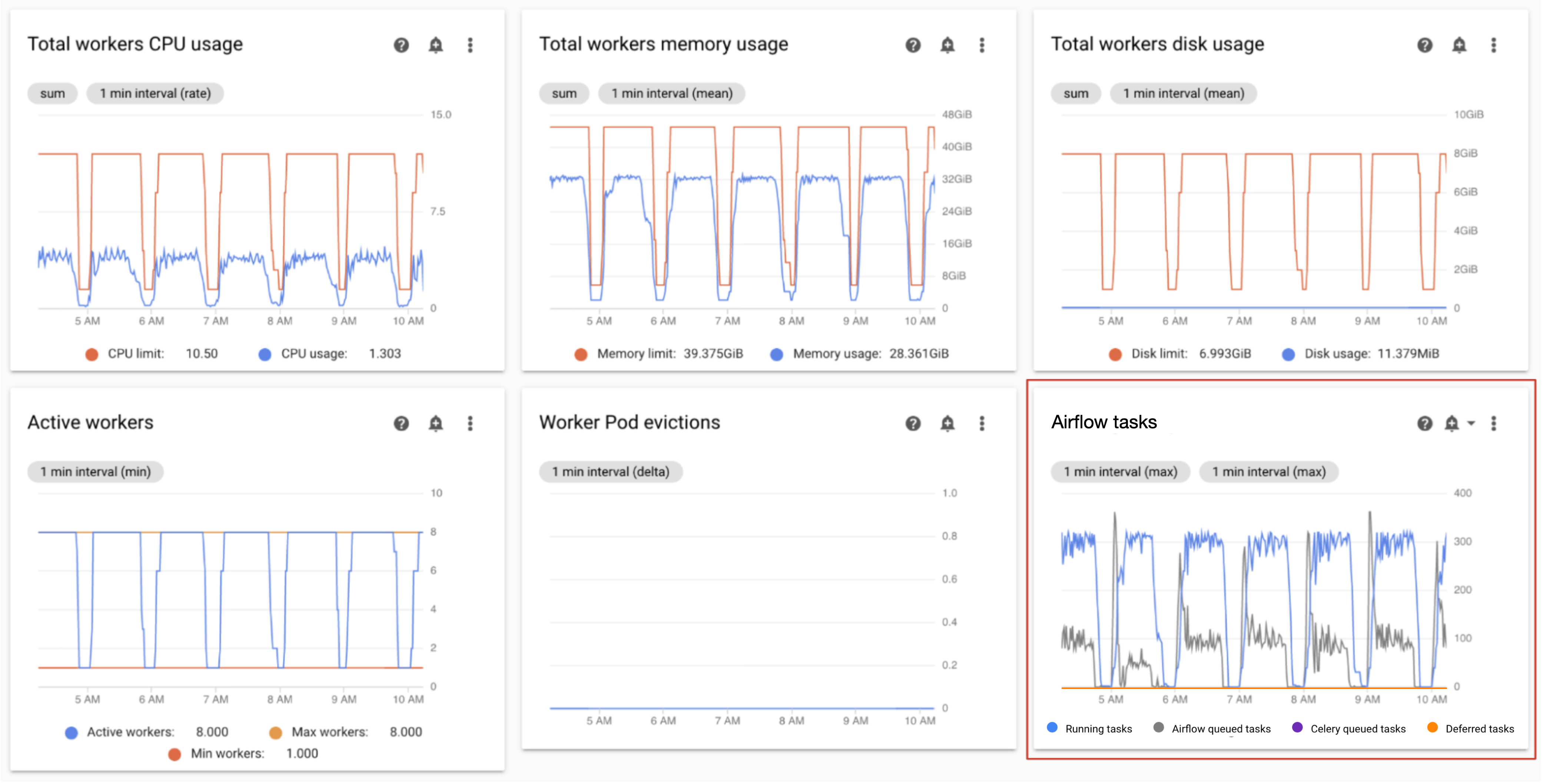

Memantau pekerja aktif

Jumlah pekerja di lingkungan Anda akan diskalakan secara otomatis sebagai respons terhadap tugas yang diantrekan.

Di dasbor Monitoring, di bagian Pekerja, amati grafik untuk jumlah pekerja aktif dan jumlah tugas dalam antrean:

- Pekerja yang aktif

- Tugas Airflow

Sesuaikan sesuai dengan pengamatan Anda:

- Jika lingkungan sering kali mencapai batas maksimum pekerja, dan pada saat yang sama jumlah tugas di antrean Celery terus tinggi, Anda mungkin ingin meningkatkan jumlah maksimum pekerja.

Jika ada penundaan penjadwalan antartugas yang lama, tetapi pada saat yang sama lingkungan tidak diskalakan hingga jumlah pekerja maksimumnya, kemungkinan ada setelan Airflow yang membatasi eksekusi dan mencegah mekanisme Cloud Composer menskalakan lingkungan. Karena lingkungan Cloud Composer 2 diskalakan berdasarkan jumlah tugas dalam antrean Celery, konfigurasikan Airflow agar tidak membatasi tugas saat masuk ke antrean:

- Meningkatkan konkurensi pekerja. Serentak pekerja harus ditetapkan ke nilai yang lebih tinggi dari jumlah maksimum tugas serentak yang diharapkan, dibagi dengan jumlah maksimum pekerja di lingkungan.

- Meningkatkan konkurensi DAG, jika satu DAG menjalankan sejumlah besar tugas secara paralel, yang dapat menyebabkan mencapai jumlah maksimum instance tugas yang berjalan per DAG.

- Meningkatkan jumlah maksimum operasi aktif per DAG, jika Anda menjalankan DAG yang sama beberapa kali secara paralel, yang dapat menyebabkan Airflow melakukan throttling pada eksekusi karena batas jumlah maksimum operasi aktif per DAG tercapai.

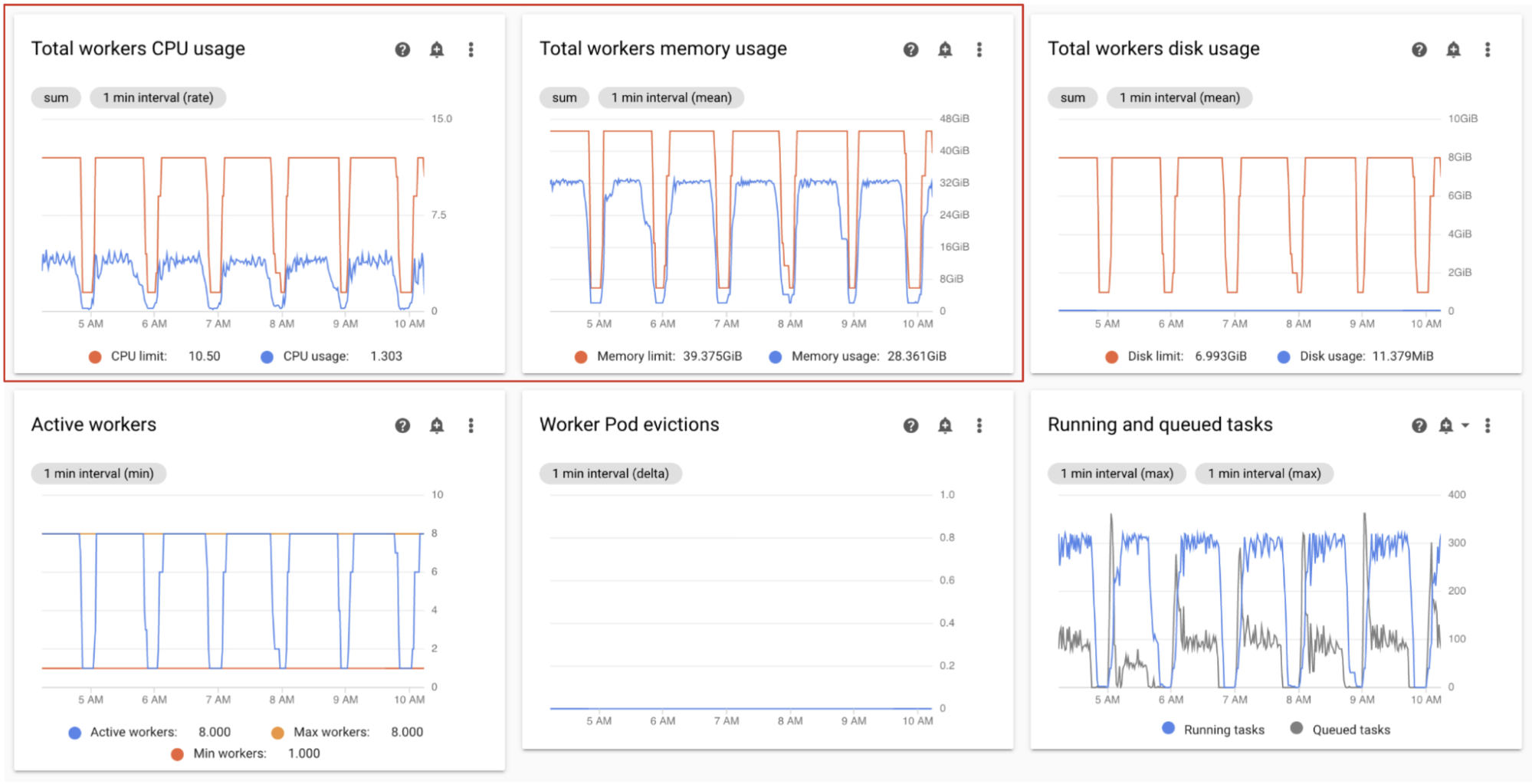

Memantau penggunaan CPU dan memori pekerja

Pantau total penggunaan CPU dan memori yang digabungkan di semua pekerja di lingkungan Anda untuk menentukan apakah pekerja Airflow menggunakan resource lingkungan Anda dengan benar.

Di dasbor Monitoring, di bagian Workers, amati grafik untuk penggunaan CPU dan memori oleh pekerja Airflow:

- Total penggunaan CPU pekerja

- Total penggunaan memori pekerja

Grafik ini mewakili penggunaan resource gabungan; setiap pekerja mungkin masih mencapai batas kapasitasnya, meskipun tampilan gabungan menunjukkan kapasitas cadangan.

Sesuaikan sesuai dengan pengamatan Anda:

- Jika penggunaan memori pekerja mendekati batas, hal ini dapat menyebabkan pengusiran pod pekerja. Untuk mengatasi masalah ini, tingkatkan memori pekerja.

- Jika penggunaan memori minimal dibandingkan dengan batas, dan tidak ada penghapusan pod pekerja, sebaiknya Anda mengurangi memori pekerja.

Jika penggunaan CPU pekerja mendekati batas (melebihi 80% selama lebih dari beberapa persen dari total waktu), sebaiknya:

- Meningkatkan jumlah pekerja. Hal ini memberi lingkungan Anda kontrol yang lebih besar atas kapasitas yang disediakan untuk beban kerja tertentu.

- Tingkatkan CPU Pekerja atau kurangi konkurensi pekerja, jika setiap tugas memerlukan alokasi CPU yang lebih tinggi. Jika tidak, sebaiknya tingkatkan jumlah pekerja.

Memantau tugas yang berjalan dan dalam antrean

Anda dapat memantau jumlah tugas yang diantrekan dan berjalan untuk memeriksa efisiensi proses penjadwalan.

Di dasbor Monitoring, di bagian Workers, amati grafik Airflow tasks untuk lingkungan Anda.

Tugas dalam antrean menunggu untuk dieksekusi oleh pekerja. Jika lingkungan Anda memiliki tugas dalam antrean, hal ini mungkin berarti bahwa pekerja di lingkungan Anda sedang sibuk menjalankan tugas lain.

Beberapa antrean selalu ada di lingkungan, terutama selama puncak pemrosesan. Namun, jika Anda mengamati jumlah tugas yang diantrekan yang tinggi, atau tren yang meningkat dalam grafik, hal ini mungkin menunjukkan bahwa pekerja tidak memiliki kapasitas yang cukup untuk memproses tugas, atau bahwa Airflow membatasi eksekusi tugas.

Jumlah tugas dalam antrean yang tinggi biasanya diamati saat jumlah tugas yang berjalan juga mencapai tingkat maksimum.

Untuk mengatasi kedua masalah tersebut:

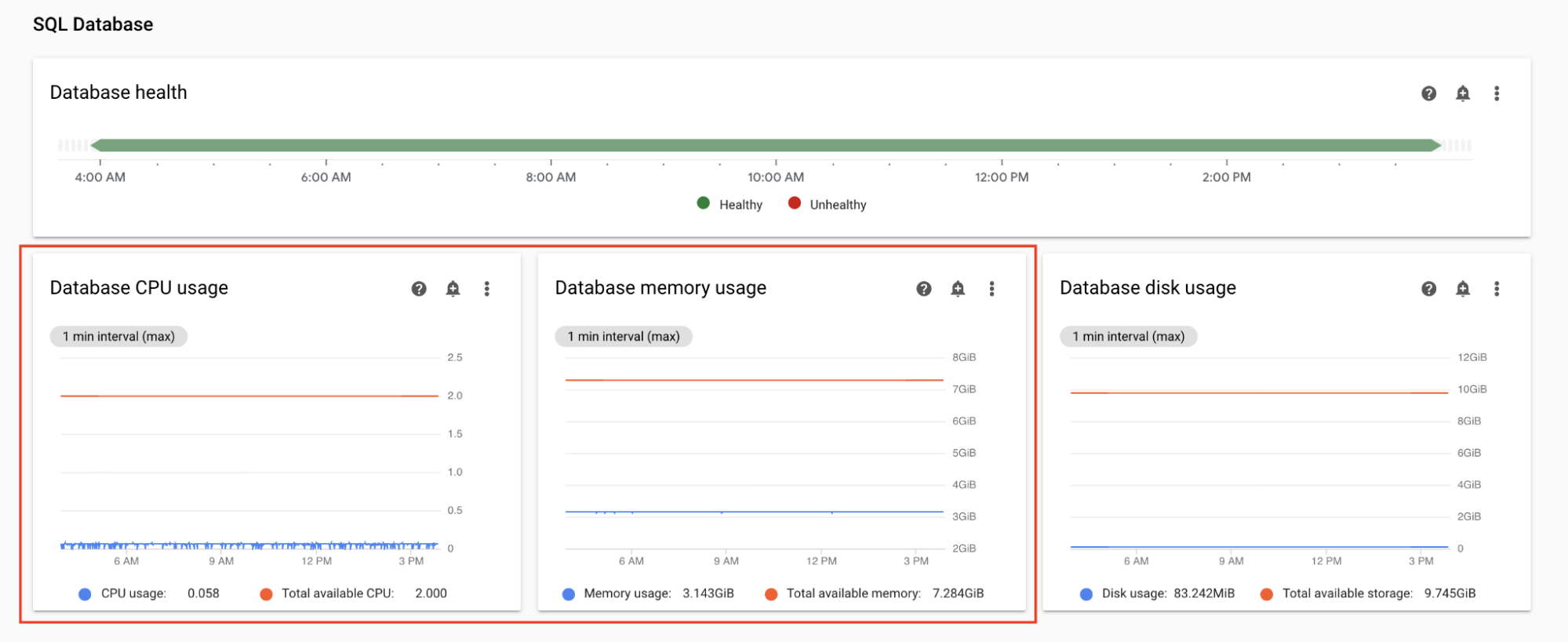

Memantau penggunaan CPU dan memori database

Masalah performa database Airflow dapat menyebabkan masalah eksekusi DAG secara keseluruhan. Penggunaan disk database biasanya tidak perlu dikhawatirkan karena penyimpanan diperluas secara otomatis sesuai kebutuhan.

Di dasbor Monitoring, di bagian Database SQL, amati grafik untuk penggunaan CPU dan memori oleh database Airflow:

- Penggunaan CPU database

- Penggunaan memori database

Jika penggunaan CPU database melebihi 80% selama lebih dari beberapa persen dari total waktu, database kelebihan beban dan memerlukan penskalaan.

Setelan ukuran database dikontrol oleh properti ukuran lingkungan dari lingkungan Anda. Untuk menskalakan database ke atas atau ke bawah, ubah ukuran lingkungan ke tingkat yang berbeda (Kecil, Sedang, atau Besar). Meningkatkan ukuran lingkungan akan meningkatkan biaya lingkungan Anda.

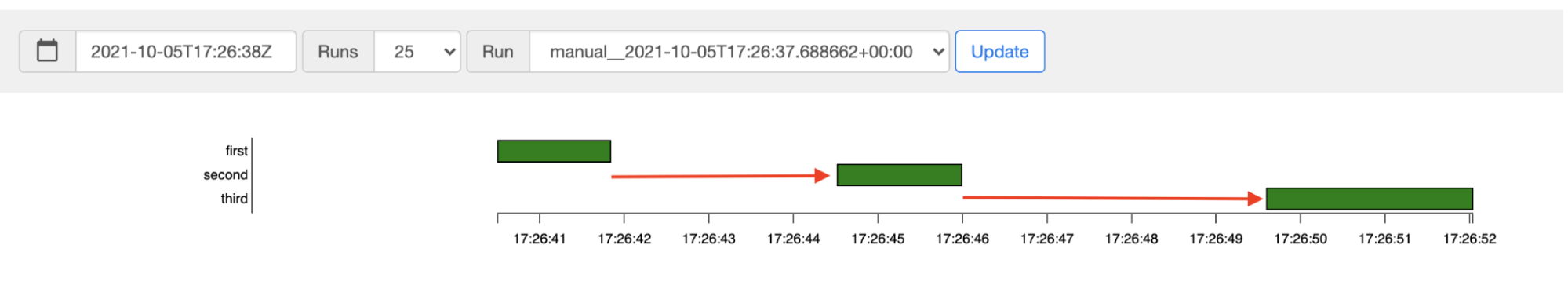

Memantau latensi penjadwalan tugas

Jika latensi antartugas melebihi tingkat yang diharapkan (misalnya, 20 detik atau lebih), hal ini mungkin menunjukkan bahwa lingkungan tidak dapat menangani beban tugas yang dihasilkan oleh DAG yang berjalan.

Anda dapat melihat grafik latensi penjadwalan tugas, di UI Airflow di lingkungan Anda.

Dalam contoh ini, penundaan (2,5 dan 3,5 detik) berada dalam batas yang dapat diterima, tetapi latensi yang jauh lebih tinggi mungkin menunjukkan bahwa:

- Penjadwal kelebihan beban. Pantau CPU dan memori penjadwal untuk menemukan tanda-tanda potensi masalah.

- Opsi konfigurasi Airflow membatasi eksekusi. Coba tingkatkan konkurensi pekerja, tingkatkan konkurensi DAG, atau tingkatkan operasi aktif maksimum per DAG.

- Tidak ada cukup pekerja untuk menjalankan tugas, coba tingkatkan jumlah maksimum pekerja.

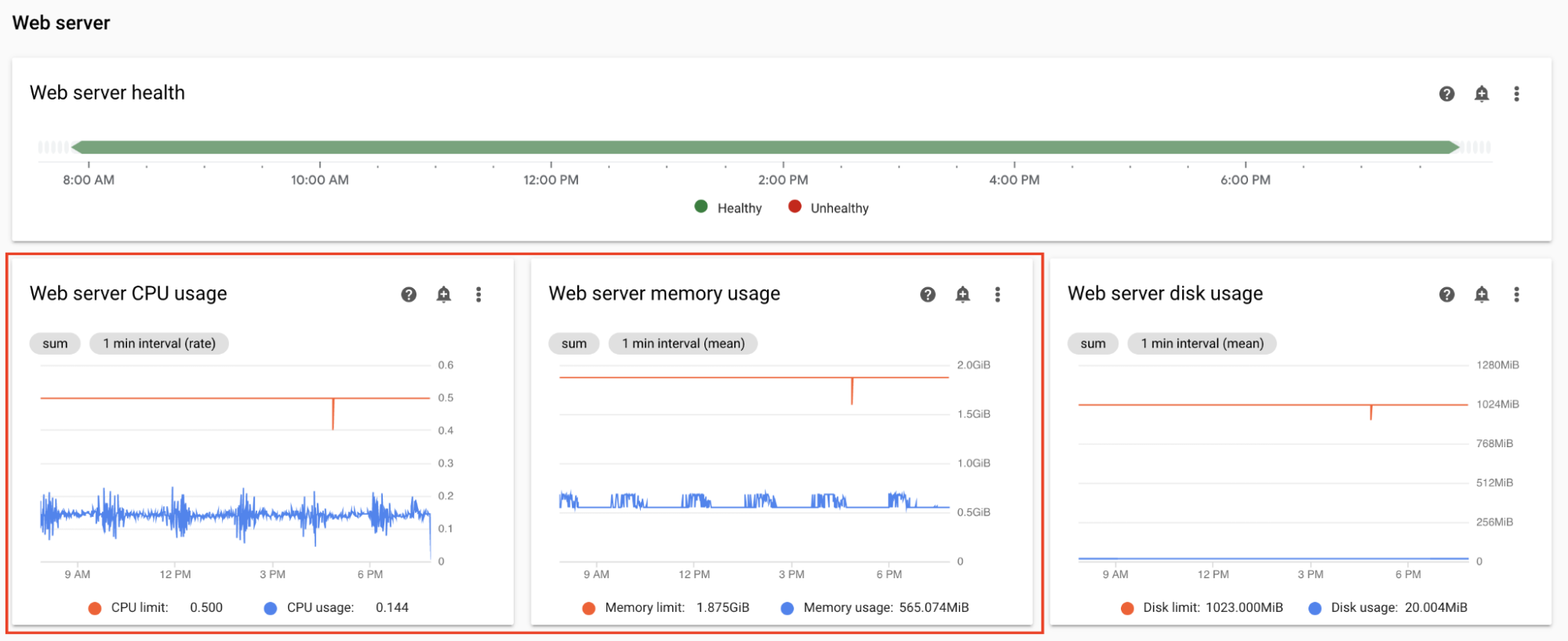

Memantau CPU dan memori server web

Performa server web Airflow memengaruhi UI Airflow. Server web kelebihan beban adalah hal yang tidak biasa. Jika hal ini terjadi, performa UI Airflow mungkin menurun, tetapi hal ini tidak memengaruhi performa DAG yang berjalan.

Di dasbor Monitoring, di bagian Web server, amati grafik untuk server web Airflow:

- Penggunaan CPU server web

- Penggunaan memori server web

Berdasarkan pengamatan Anda:

- Jika penggunaan CPU server web di atas 80% selama lebih dari beberapa persen waktu, pertimbangkan untuk meningkatkan CPU Server Web.

- Jika Anda mengamati penggunaan memori server web yang tinggi, pertimbangkan untuk menambahkan lebih banyak memori ke server web.

Menyesuaikan parameter skala dan performa lingkungan

Mengubah jumlah penjadwal

Menyesuaikan jumlah penjadwal akan meningkatkan kapasitas penjadwal dan ketahanan penjadwalan Airflow.

Jika Anda meningkatkan jumlah penjadwal, hal ini akan meningkatkan traffic ke dan dari database Airflow. Sebaiknya gunakan dua penjadwal Airflow dalam sebagian besar skenario. Penggunaan tiga penjadwal hanya diperlukan dalam kasus yang jarang terjadi yang memerlukan pertimbangan khusus. Mengonfigurasi lebih dari tiga penjadwal sering kali menyebabkan performa lingkungan yang lebih rendah.

Jika Anda memerlukan penjadwalan yang lebih cepat:

- Konfigurasikan dua penjadwal Airflow.

- Tetapkan lebih banyak resource CPU dan memori ke penjadwal Airflow.

- Meningkatkan dag-dir-list-interval

- Meningkatkan min-file-process-interval

- Meningkatkan job-heartbeat-sec

Contoh:

Konsol

Ikuti langkah-langkah di artikel Menyesuaikan jumlah penjadwal untuk menetapkan jumlah penjadwal yang diperlukan untuk lingkungan Anda.

gcloud

Ikuti langkah-langkah di artikel Menyesuaikan jumlah penjadwal untuk menetapkan jumlah penjadwal yang diperlukan untuk lingkungan Anda.

Contoh berikut menetapkan jumlah penjadwal menjadi dua:

gcloud composer environments update example-environment \

--scheduler-count=2

Terraform

Ikuti langkah-langkah di artikel Menyesuaikan jumlah penjadwal untuk menetapkan jumlah penjadwal yang diperlukan untuk lingkungan Anda.

Contoh berikut menetapkan jumlah penjadwal menjadi dua:

resource "google_composer_environment" "example-environment" {

# Other environment parameters

config {

workloads_config {

scheduler {

count = 2

}

}

}

}

Mengubah CPU dan memori untuk penjadwal

Parameter CPU dan memori ditujukan untuk setiap penjadwal di lingkungan Anda. Misalnya, jika lingkungan Anda memiliki dua penjadwal, kapasitas totalnya adalah dua kali jumlah CPU dan memori yang ditentukan.

Konsol

Ikuti langkah-langkah di Menyesuaikan parameter performa dan skala pekerja, penjadwal, dan server web untuk menetapkan CPU dan memori bagi penjadwal.

gcloud

Ikuti langkah-langkah di Menyesuaikan parameter performa dan skala pekerja, penjadwal, dan server web untuk menetapkan CPU dan Memori untuk penjadwal.

Contoh berikut mengubah CPU dan memori untuk penjadwal. Anda hanya dapat menentukan atribut CPU atau Memori, bergantung pada kebutuhan.

gcloud composer environments update example-environment \

--scheduler-cpu=0.5 \

--scheduler-memory=3.75

Terraform

Ikuti langkah-langkah di Menyesuaikan parameter performa dan skala pekerja, penjadwal, dan server web untuk menetapkan CPU dan memori bagi penjadwal.

Contoh berikut mengubah CPU dan memori untuk penjadwal. Anda dapat menghilangkan atribut CPU atau Memori, bergantung pada kebutuhan.

resource "google_composer_environment" "example-environment" {

# Other environment parameters

config {

workloads_config {

scheduler {

cpu = "0.5"

memory_gb = "3.75"

}

}

}

}

Mengubah jumlah maksimum pekerja

Dengan meningkatkan jumlah pekerja maksimum, lingkungan Anda dapat diskalakan secara otomatis ke jumlah pekerja yang lebih tinggi, jika diperlukan.

Mengurangi jumlah maksimum pekerja akan mengurangi kapasitas maksimum lingkungan, tetapi juga dapat membantu mengurangi biaya lingkungan.

Contoh:

Konsol

Ikuti langkah-langkah di Menyesuaikan jumlah pekerja minimum dan maksimum untuk menetapkan jumlah maksimum pekerja yang diperlukan untuk lingkungan Anda.

gcloud

Ikuti langkah-langkah di Menyesuaikan jumlah pekerja minimum dan maksimum untuk menetapkan jumlah maksimum pekerja yang diperlukan untuk lingkungan Anda.

Contoh berikut menetapkan jumlah maksimum pekerja menjadi enam:

gcloud composer environments update example-environment \

--max-workers=6

Terraform

Ikuti langkah-langkah di Menyesuaikan jumlah pekerja minimum dan maksimum untuk menetapkan jumlah maksimum pekerja yang diperlukan untuk lingkungan Anda.

Contoh berikut menetapkan jumlah maksimum penjadwal menjadi enam:

resource "google_composer_environment" "example-environment" {

# Other environment parameters

config {

workloads_config {

worker {

max_count = "6"

}

}

}

}

Mengubah CPU dan memori pekerja

Mengurangi memori pekerja dapat membantu saat grafik penggunaan pekerja menunjukkan penggunaan memori yang sangat rendah.

Meningkatkan memori pekerja memungkinkan pekerja menangani lebih banyak tugas secara bersamaan atau menangani tugas yang membutuhkan banyak memori. Hal ini dapat mengatasi masalah pengusiran pod pekerja.

Mengurangi CPU pekerja dapat membantu jika grafik penggunaan CPU pekerja menunjukkan bahwa resource CPU dialokasikan secara berlebihan.

Meningkatkan CPU pekerja memungkinkan pekerja menangani lebih banyak tugas secara bersamaan dan dalam beberapa kasus mengurangi waktu yang diperlukan untuk memproses tugas ini.

Mengubah CPU atau memori pekerja akan memulai ulang pekerja, yang dapat memengaruhi tugas yang sedang berjalan. Sebaiknya lakukan saat tidak ada DAG yang berjalan.

Parameter CPU dan memori ditujukan untuk setiap pekerja di lingkungan Anda. Misalnya, jika lingkungan Anda memiliki empat pekerja, kapasitas totalnya adalah empat kali jumlah CPU dan memori yang ditentukan.

Konsol

Ikuti langkah-langkah di Menyesuaikan parameter performa dan skala pekerja, penjadwal, dan server web untuk menetapkan CPU dan memori bagi pekerja.

gcloud

Ikuti langkah-langkah di Menyesuaikan parameter performa dan skala pekerja, penjadwal, dan server web untuk menetapkan CPU dan memori untuk pekerja.

Contoh berikut mengubah CPU dan memori untuk pekerja. Anda dapat menghilangkan atribut CPU atau memori, jika diperlukan.

gcloud composer environments update example-environment \

--worker-memory=3.75 \

--worker-cpu=2

Terraform

Ikuti langkah-langkah di Menyesuaikan parameter performa dan skala pekerja, penjadwal, dan server web untuk menetapkan CPU dan memori bagi pekerja.

Contoh berikut mengubah CPU dan memori untuk pekerja. Anda dapat menghilangkan parameter CPU atau memori, jika diperlukan.

resource "google_composer_environment" "example-environment" {

# Other environment parameters

config {

workloads_config {

worker {

cpu = "2"

memory_gb = "3.75"

}

}

}

}

Mengubah CPU dan memori server web

Mengurangi CPU atau memori server web dapat membantu jika grafik penggunaan server web menunjukkan bahwa server web tersebut terus-menerus kurang digunakan.

Mengubah parameter server web akan memulai ulang server web, yang menyebabkan periode nonaktif server web sementara. Sebaiknya buat perubahan di luar jam penggunaan reguler.

Konsol

Ikuti langkah-langkah di artikel Menyesuaikan parameter performa dan skala pekerja, penjadwal, dan server web untuk menetapkan CPU dan memori untuk server web.

gcloud

Ikuti langkah-langkah di bagian Menyesuaikan parameter performa dan skala pekerja, penjadwal, dan server web untuk menetapkan CPU dan Memori untuk server web.

Contoh berikut mengubah CPU dan memori untuk server web. Anda dapat menghilangkan atribut CPU atau memori, bergantung pada kebutuhan.

gcloud composer environments update example-environment \

--web-server-cpu=2 \

--web-server-memory=3.75

Terraform

Ikuti langkah-langkah di artikel Menyesuaikan parameter performa dan skala pekerja, penjadwal, dan server web untuk menetapkan CPU dan memori untuk server web.

Contoh berikut mengubah CPU dan memori untuk server web. Anda dapat menghilangkan atribut CPU atau memori, bergantung pada kebutuhan.

resource "google_composer_environment" "example-environment" {

# Other environment parameters

config {

workloads_config {

web_server {

cpu = "2"

memory_gb = "3.75"

}

}

}

}

Mengubah ukuran lingkungan

Mengubah ukuran lingkungan akan mengubah kapasitas komponen backend Cloud Composer, seperti database Airflow dan antrean Airflow.

- Pertimbangkan untuk mengubah ukuran lingkungan menjadi lebih kecil (misalnya, Besar ke Sedang, atau Sedang ke Kecil) saat metrik Penggunaan database menunjukkan pemanfaatan yang kurang substansial.

Pertimbangkan untuk meningkatkan ukuran lingkungan jika Anda mengamati penggunaan database Airflow yang tinggi.

Konsol

Ikuti langkah-langkah di Menyesuaikan ukuran lingkungan untuk menetapkan ukuran lingkungan.

gcloud

Ikuti langkah-langkah di Menyesuaikan ukuran lingkungan untuk menetapkan ukuran lingkungan.

Contoh berikut mengubah ukuran lingkungan menjadi Sedang.

gcloud composer environments update example-environment \

--environment-size=medium

Terraform

Ikuti langkah-langkah di Menyesuaikan ukuran lingkungan untuk menetapkan ukuran lingkungan.

Contoh berikut mengubah ukuran lingkungan menjadi Sedang.

resource "google_composer_environment" "example-environment" {

# Other environment parameters

config {

environment_size = "medium"

}

}

Mengubah interval listingan direktori DAG

Meningkatkan interval listingan direktori DAG akan mengurangi beban penjadwal yang terkait dengan penemuan DAG baru di bucket lingkungan.

- Pertimbangkan untuk meningkatkan interval ini jika Anda jarang men-deploy DAG baru.

- Pertimbangkan untuk mengurangi interval ini jika Anda ingin Airflow bereaksi lebih cepat terhadap file DAG yang baru di-deploy.

Untuk mengubah parameter ini, ganti opsi konfigurasi Airflow berikut:

| Bagian | Kunci | Nilai | Catatan |

|---|---|---|---|

scheduler |

dag_dir_list_interval |

Nilai baru untuk interval listingan | Nilai defaultnya, dalam detik, adalah 120. |

Mengubah interval penguraian file DAG

Meningkatkan interval penguraian file DAG akan mengurangi beban penjadwal yang terkait dengan penguraian DAG yang berkelanjutan di bag DAG.

Pertimbangkan untuk meningkatkan interval ini jika Anda memiliki DAG dalam jumlah besar yang tidak terlalu sering berubah, atau mengamati beban penjadwal yang tinggi secara umum.

Untuk mengubah parameter ini, ganti opsi konfigurasi Airflow berikut:

| Bagian | Kunci | Nilai | Catatan |

|---|---|---|---|

scheduler |

min_file_process_interval |

Nilai baru untuk interval penguraian DAG | Nilai defaultnya, dalam detik, adalah 30. |

Konkurensi pekerja

Performa konkurensi dan kemampuan lingkungan Anda untuk melakukan penskalaan otomatis terhubung ke dua setelan:

- jumlah minimum pekerja Airflow

- parameter

[celery]worker_concurrency

Nilai default yang disediakan oleh Cloud Composer optimal untuk sebagian besar kasus penggunaan, tetapi lingkungan Anda mungkin akan mendapatkan manfaat dari penyesuaian kustom.

Pertimbangan performa konkurensi pekerja

Parameter [celery]worker_concurrency menentukan jumlah tugas

yang dapat diambil oleh satu pekerja dari antrean tugas.

Kecepatan eksekusi tugas bergantung pada beberapa faktor, seperti CPU pekerja, memori,

dan jenis pekerjaan itu sendiri.

Penskalaan otomatis pekerja

Cloud Composer memantau antrean tugas dan membuat pekerja tambahan untuk

mengambil tugas yang menunggu. Menetapkan [celery]worker_concurrency ke nilai tinggi

berarti setiap pekerja dapat mengambil banyak tugas, sehingga dalam keadaan tertentu,

antrean mungkin tidak pernah terisi penuh, sehingga penskalaan otomatis tidak pernah terpicu.

Misalnya, di lingkungan Cloud Composer dengan dua pekerja Airflow,

[celery]worker_concurrency ditetapkan ke 100, dan tugas 200 dalam antrean,

setiap pekerja akan mengambil 100 tugas. Tindakan ini akan membuat antrean kosong dan tidak memicu penskalaan otomatis. Jika tugas ini memerlukan waktu lama untuk diselesaikan, hal ini dapat menyebabkan masalah performa.

Namun, jika tugasnya kecil dan cepat dieksekusi, nilai tinggi dalam

setelan [celery]worker_concurrency dapat menyebabkan penskalaan yang terlalu cepat.

Misalnya, jika lingkungan tersebut memiliki 300 tugas dalam antrean,

Cloud Composer akan mulai membuat pekerja baru. Namun, jika 200 tugas pertama selesai dieksekusi pada saat pekerja baru siap, pekerja yang ada dapat mengambilnya. Hasil akhirnya adalah penskalaan otomatis membuat pekerja baru, tetapi

tidak ada tugas untuk mereka.

Penyesuaian [celery]worker_concurrency untuk kasus khusus harus didasarkan

pada waktu eksekusi tugas puncak dan nomor antrean:

- Untuk tugas yang memerlukan waktu lebih lama untuk diselesaikan, pekerja tidak boleh dapat mengosongkan antrean sepenuhnya.

- Untuk tugas yang lebih cepat dan lebih kecil, tingkatkan jumlah minimum pekerja Airflow untuk menghindari penskalaan yang berlebihan.

Sinkronisasi log tugas

Pekerja Airflow memiliki komponen yang menyinkronkan log eksekusi tugas ke bucket Cloud Storage. Jumlah tugas serentak yang tinggi yang dilakukan oleh satu pekerja akan menghasilkan banyak permintaan sinkronisasi. Hal ini dapat membebani pekerja Anda dan menyebabkan masalah performa.

Jika Anda mengamati masalah performa karena jumlah traffic sinkronisasi log yang tinggi, turunkan nilai [celery]worker_concurrency dan sesuaikan jumlah minimum pekerja Airflow.

Mengubah serentak pekerja

Mengubah parameter ini akan menyesuaikan jumlah tugas yang dapat dijalankan oleh satu pekerja secara bersamaan.

Misalnya, Pekerja dengan 0,5 CPU biasanya dapat menangani 6 tugas serentak; lingkungan dengan tiga pekerja tersebut dapat menangani hingga 18 tugas serentak.

Tingkatkan parameter ini jika ada tugas yang menunggu dalam antrean, dan pekerja Anda menggunakan persentase CPU dan memori yang rendah secara bersamaan.

Kurangi parameter ini saat Anda mendapatkan pengusiran pod; tindakan ini akan mengurangi jumlah tugas yang dicoba diproses oleh satu pekerja. Sebagai alternatif, Anda dapat meningkatkan memori pekerja.

Secara default, konkurensi pekerja ditetapkan berdasarkan jumlah instance tugas serentak ringan yang dapat ditampung pekerja. Artinya, nilainya bergantung pada batas resource pekerja. Nilai konkurensi pekerja tidak bergantung pada jumlah pekerja di lingkungan Anda.

Untuk mengubah parameter ini, ganti opsi konfigurasi Airflow berikut:

| Bagian | Kunci | Nilai |

|---|---|---|

celery |

worker_concurrency |

Nilai baru untuk konkurensi pekerja |

Mengubah serentak DAG

Serentak DAG menentukan jumlah maksimum instance tugas yang diizinkan untuk dijalankan secara serentak di setiap DAG. Tingkatkan jika DAG Anda menjalankan tugas serentak dalam jumlah besar. Jika setelan ini rendah, penjadwal akan menunda penempatan lebih banyak tugas ke dalam antrean, yang juga mengurangi efisiensi penskalaan otomatis lingkungan.

Untuk mengubah parameter ini, ganti opsi konfigurasi Airflow berikut:

| Bagian | Kunci | Nilai | Catatan |

|---|---|---|---|

core |

max_active_tasks_per_dag |

Nilai baru untuk konkurensi DAG | Nilai defaultnya adalah 16 |

Meningkatkan operasi aktif maksimum per DAG

Atribut ini menentukan jumlah maksimum DAG aktif yang berjalan per DAG. Jika DAG yang sama harus dijalankan beberapa kali secara serentak, misalnya, dengan argumen input yang berbeda, atribut ini memungkinkan penjadwal memulai operasi tersebut secara paralel.

Untuk mengubah parameter ini, ganti opsi konfigurasi Airflow berikut:

| Bagian | Kunci | Nilai | Catatan |

|---|---|---|---|

core |

max_active_runs_per_dag |

Nilai baru untuk operasi aktif maksimum per DAG | Nilai defaultnya adalah 25 |

Langkah berikutnya

- Menskalakan lingkungan

- Tentang penskalaan lingkungan

- Mengganti konfigurasi Airflow

- Memantau kesehatan dan performa lingkungan dengan metrik utama