Compute Engine の説明: マシン ファミリーとマシンタイプの選択基準

Google Cloud Japan Team

※この投稿は米国時間 2020 年 7 月 10 日に、Google Cloud blog に投稿されたものの抄訳です。

編集者注: この記事は、Compute Engine の VM を効果的に活用するヒントを紹介するシリーズの第 1 弾です。

現在使用しているクラウド コンピューティングのリソースが、自社のワークロードに最適なものであるかどうか疑問を抱いたことはありませんか?この記事では、Compute Engine の数種類のマシン ファミリーについて詳しく解説するとともに、これらの選択基準の目安を示します。Compute Engine の使用を最適化するためのヒントを中心に、クラウド コンピューティングの初心者や Google Cloud のビギナーにも役立つ内容を紹介します。

Compute Engine では、数種類のマシン ファミリーが提供されています。Google Cloud で仮想マシン(VM)を実行する際は、自社のワークロードやアプリケーションに適したものをお選びください。また、それぞれのマシン ファミリーに、特定のプロセッサとメモリで構成されたマシンタイプが揃っています。

- 汎用 - 価格とパフォーマンスのバランスが良く、データベースから、開発環境、テスト環境、ウェブ アプリケーション、モバイルゲームまで、幅広いワークロードに適しています。

- コンピューティング最適化 - Compute Engine 上で 1 コアあたりのパフォーマンスが最も高く、コンピューティング負荷の高いワークロードに最適です。たとえば、ハイ パフォーマンス コンピューティング(HPC)や、ゲームサーバー、レイテンシの影響を受けやすい API での使用に適しています。

- メモリ最適化 - VM ファミリーの中でメモリ構成が最大で、単一インスタンスで最高 12 TB まで使用可能です。この VM は、SAP HANA などの大規模なインメモリ データベースや、インメモリ データ分析など、メモリ使用量の多いワークロードに適しています。

- アクセラレータ最適化 - NVIDIA Ampere A100 Tensor Core GPU を基盤としていて、VM あたり最大 16 個の GPU を使用可能です。この VM は、CUDA による機械学習(ML)トレーニングおよび推論や、HPC など、非常に厳しい要件が求められるワークロードに適しています。

汎用ファミリー

このマシン ファミリーは、価格とパフォーマンスのバランスが良く、一般的なワークロードに幅広く適しています。以下の 4 つの汎用マシンタイプから選択できます。

- E2 は Google Cloud における総所有コスト(TCO)が最小で、第 1 世代の N1 と比べると最大 31% 節約できます。E2 VM は各種 CPU プラットフォーム(Intel と AMD)で動作し、ノードあたり最大 32 個の vCPU、128 GB のメモリを使用可能です。また、E2 マシンタイプは動的リソース管理を採用していて、さまざまな経済的メリットがあるため、コスト重視のワークロードに向いています。

- N2 は、Compute Engine の汎用マシン ファミリーに第 2 世代の Intel Xeon スケーラブル プロセッサ(Cascade Lake)を搭載したタイプです。第 1 世代の N1 マシンに比べ、多くのワークロードでコスト パフォーマンスが 20% 以上改善するほか、vCPU あたりのメモリも最大 25% 増加しています。

- N2D VM は、最新の第 2 世代 AMD EPYC(Rome)CPU を搭載していて、汎用 Compute Engine VM の中で最大のコア数、メモリをサポートしています。N2D VM は、N2 VM と同じ機能(ローカル SSD、カスタム マシンタイプ、ライブ マイグレーションによる透過的メンテナンスなど)を提供します。

- N1 は汎用 VM の第 1 世代であり、最大 96 個の vCPU と 624 GB のメモリを提供します。一般的な用途には、上記の第 2 世代の汎用マシンタイプのいずれかを選ぶことをおすすめします。N1 は NVIDIA の各種 GPU をサポートしていて、GPU のワークロードに対応します(各ゾーンでサポートされている GPU の種類について詳しくは、こちらの表をご覧ください)。

汎用マシンには、一定数の vCPU とメモリがあらかじめ搭載されているタイプのほか、構成を自由に決められるカスタム マシンタイプもあります。カスタム マシンタイプの場合、アプリケーションに合わせて CPU とメモリの構成を自由に決められるので、必要な分だけ支払うことができます。

では、汎用マシン ファミリーについて詳しく見ていきましょう。

E2 マシンタイプ

E2 VM は、Google が自社サービスにおいてハードウェア リソースを効率良く利用するために開発した動的リソース管理テクノロジーを使用していて、コスト削減に効果的です。N1 で問題なく動作しているワークロード(ウェブサービス、中小規模のデータベース、アプリケーション開発、テスト環境など)で、大きなインスタンス サイズや、GPU、ローカル SSD が不要な場合は、E2 への移行をご検討ください。

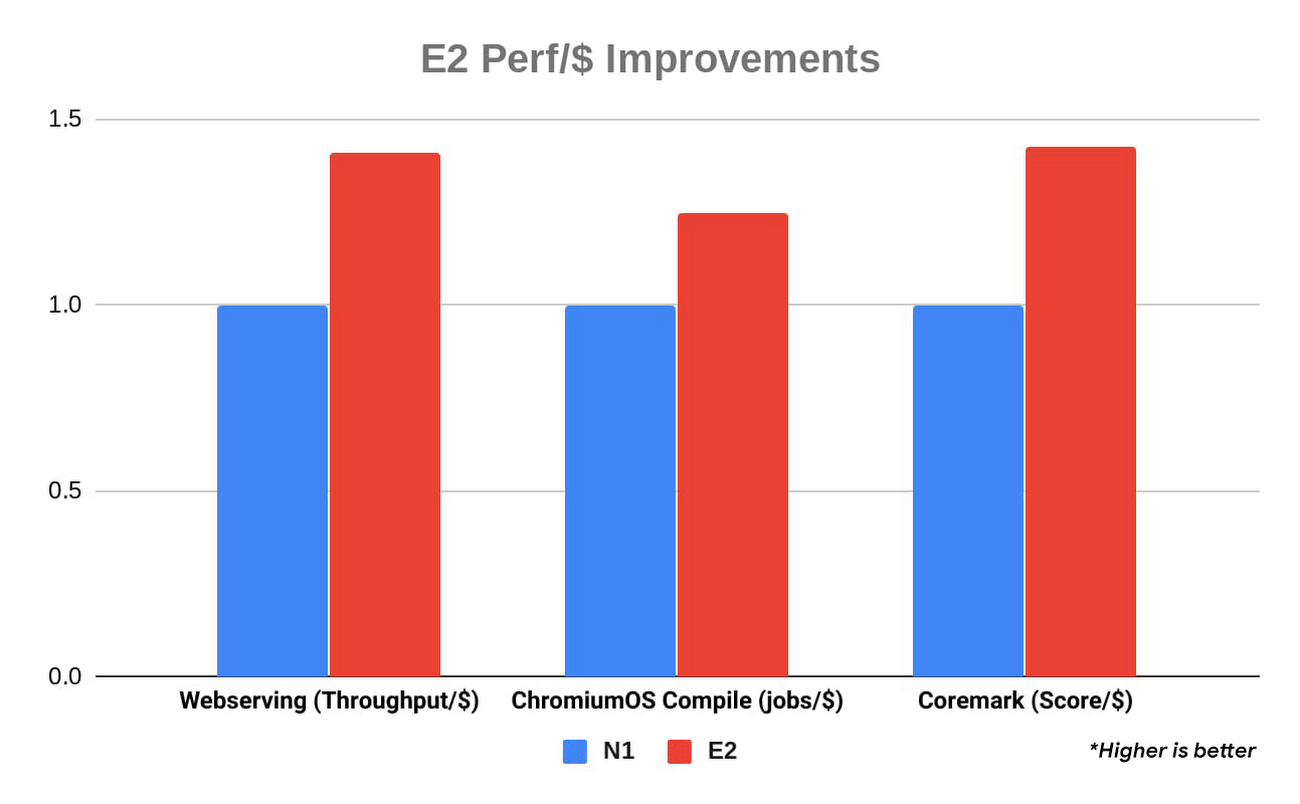

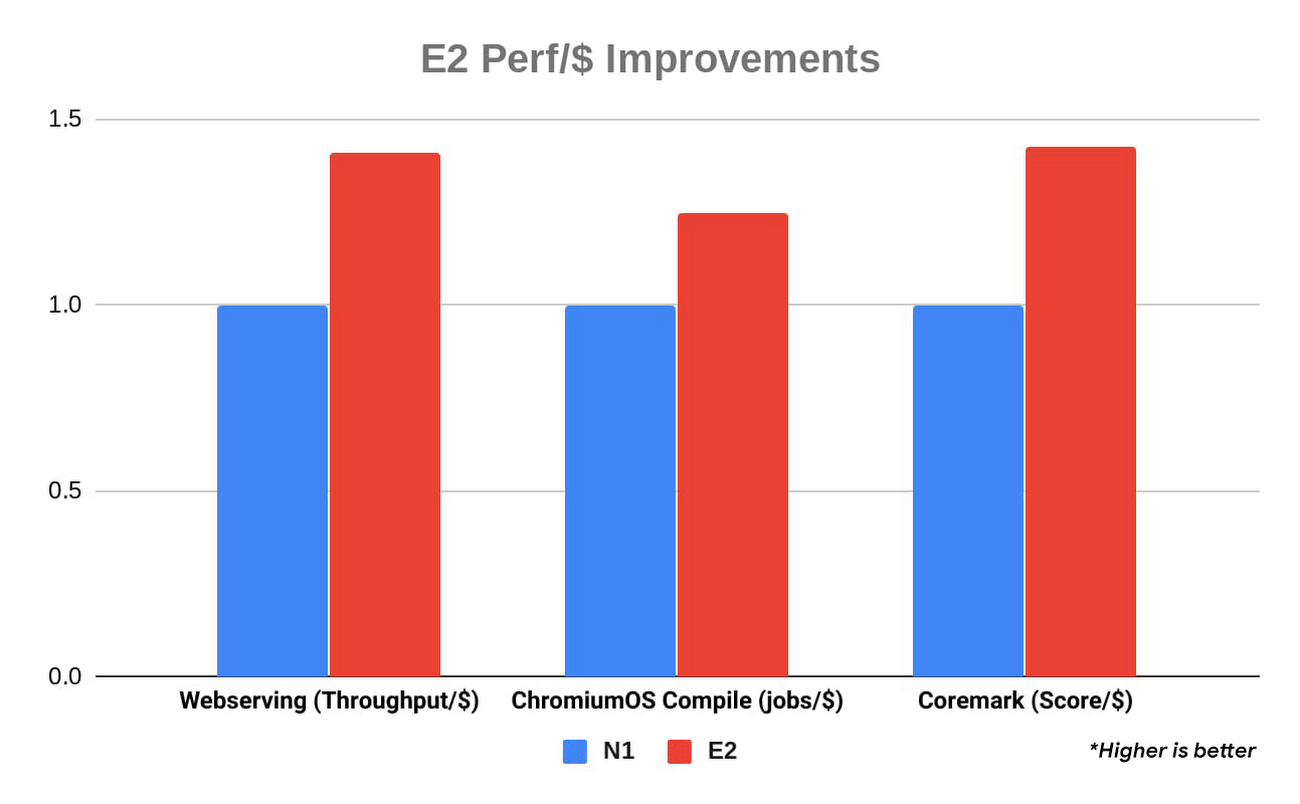

オンデマンド利用の TCO と確約利用割引のどちらにおいても、E2 はコスト パフォーマンスに優れていて、以下に示すように、各種ベンチマークで最大 31% の改善を記録しています。E2 の料金にはあらかじめ継続利用割引が適用されているほか、確約利用割引も利用すれば 3 年間の契約でさらに最大 55% 節約できます。

この結果は、すべてのインスタンス タイプに同等サイズの VM(16 個の vCPU)を使用した Google Cloud の内部ベンチマークに基づいています。(*数値が高いほど優れている)

N2 マシンタイプ

N2 マシンの基本周波数は 2.8 GHz で、全コアターボでは 3.4 GHz の周波数を維持します。また、最大で 80 個の vCPU と 640 GB のメモリを提供します。コアあたりのパフォーマンスが高く、ウェブサーバーやアプリケーション サーバーはもちろん、エンタープライズ アプリケーション、ゲームサーバー、コンテンツ システム、コラボレーション システム、さらに主なデータベースまで、幅広いワークロードに適しています。

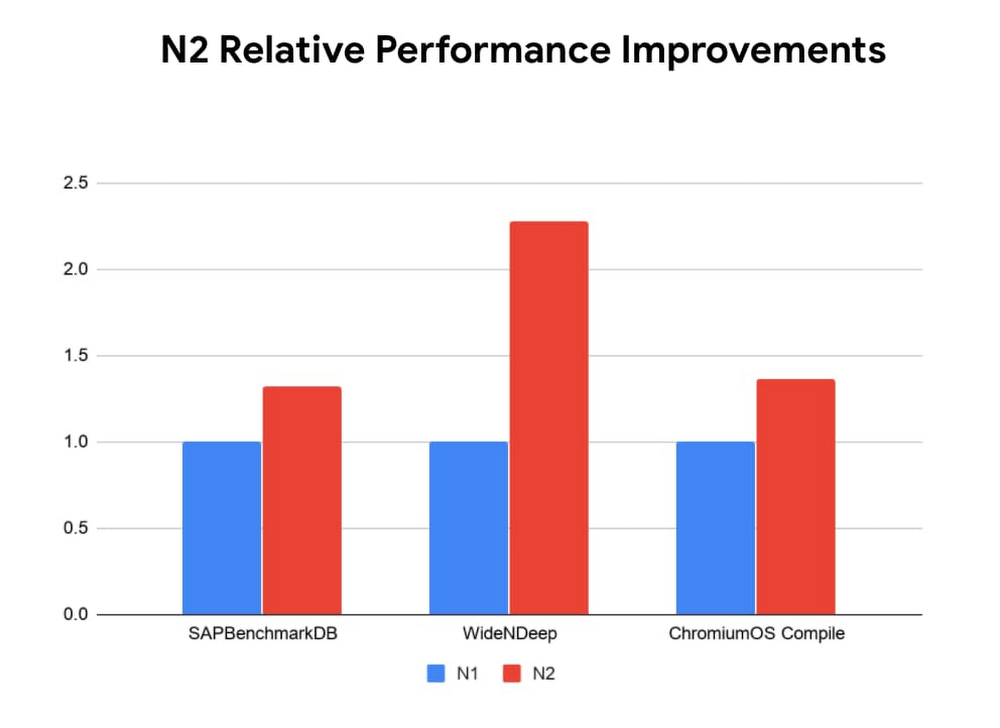

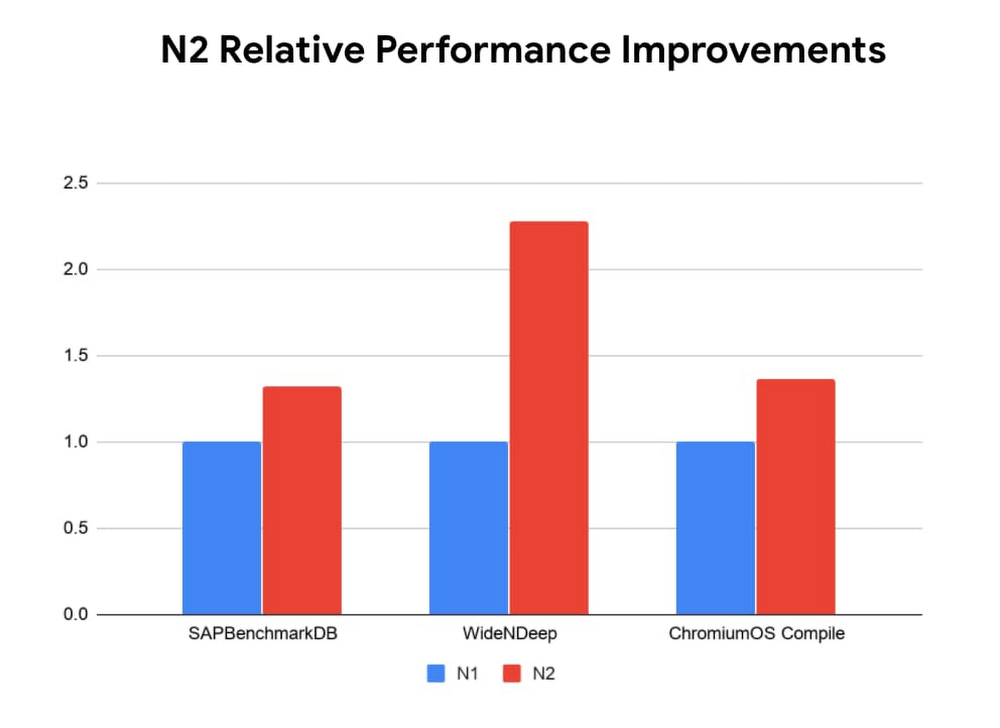

ビジネス クリティカルなデータベースでもインタラクティブなウェブ アプリケーションでも、以下に示すように各種ベンチマークでパフォーマンスが最大 30% 向上しているほか、コンピューティング プロセスの大部分が短縮されています。さらに、この VM に搭載されている Intel AVX-512 は、前世代の Intel Advanced Vector Extensions 2(Intel AVX2)と比べてクロック サイクルあたりの FLOPS が 2 倍となっていて、非常に厳しい要件の計算タスクでも高いパフォーマンスとスループットを発揮します。

N2 インスタンスでは、ワイド&ディープモデルの AI 推論に、Intel 向けに最適化した TensorFlow を使用し、第 2 世代の Xeon スケーラブル プロセッサに搭載された新しい Deep Learning(DL)Boost 命令も活用しています。これにより、N1 インスタンスに比べ 2.82 倍の処理速度を実現しています。この新しい DL Boost 命令で Intel AVX-512 の命令セットを拡張することで、前世代のプロセッサでは 3 つの命令によって実行していたような処理を 1 つの命令で実行しています。

N2D マシンタイプ

N2D VM は最大 224 個の vCPU によって、AMD の大きいメモリ帯域幅とシステムごとのスループット(大規模な VM で利用可能)を利用するデータ管理ワークロードのパフォーマンスを改善します。これは、Google Compute Engine で最大の汎用 VM です。N2D VM には、互換性のある N シリーズのインスタンスと比べて最大 13% のコスト削減効果があります。

N2D マシンタイプは、ウェブ アプリケーション、データベース、ワークロード、動画ストリーミングに適しています。また N2D VM は、大きいメモリ帯域幅を活用する多くのハイ パフォーマンス コンピューティング ワークロードのパフォーマンスも改善します。

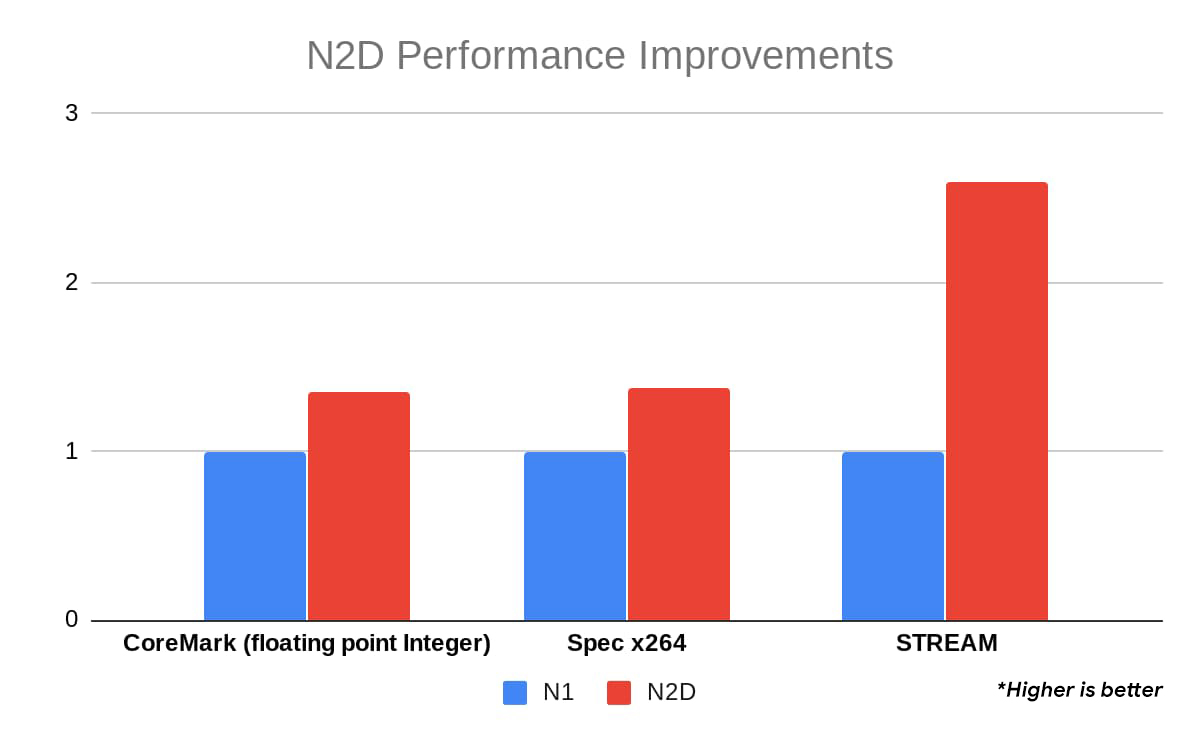

以下のベンチマークでは、多数のワークロード タイプで 20~30% のパフォーマンス向上が見られました。STREAM など、N2D の改善されたメモリ帯域幅を活用したベンチマークで最大 2.5 倍の改善を記録したことから、メモリ帯域幅を多く必要とするアプリケーションに最適であることがわかります。

この結果は、すべてのインスタンス タイプに同等サイズの VM(16 個の vCPU)を使用した Google Cloud の内部ベンチマークに基づいています。(*数値が高いほど優れている)

N2 VM と N2D VM には最大 20% の継続利用割引があり、確約利用割引の対象でもあるため、3 年契約でさらに最大 55% のコスト削減が可能です。

コンピューティング最適化(C2)ファミリー

コンピューティング最適化マシンはコアごとの最高パフォーマンスと一貫したパフォーマンスの達成に特化し、リアルタイムのアプリケーション パフォーマンスに関するニーズに対応します。第 2 世代 Intel Xeon スケーラブル プロセッサ(Cascade Lake)と最大 3.8 GHz の持続型オールコア ターボをベースとするこれらの VM は、HPC、ゲーム(AAA ゲームサーバー)、ハイ パフォーマンス ウェブサービスなどのコンピューティング負荷の高いワークロード向けに最適化されています。

コンピューティング最適化マシンは、前世代の N1 と比べてパフォーマンスを 40% 以上も改善します。また、スレッドあたりのパフォーマンスが向上し、レイテンシの影響を受けやすいワークロードは分離されます。コンピューティング最適化 VM の vCPU 数は 4~60 個で、メモリは最大 240 GB です。高いストレージ パフォーマンスを必要とするアプリケーションの場合は、最大 3 TB のローカル ストレージをこれらの VM にアタッチできます。

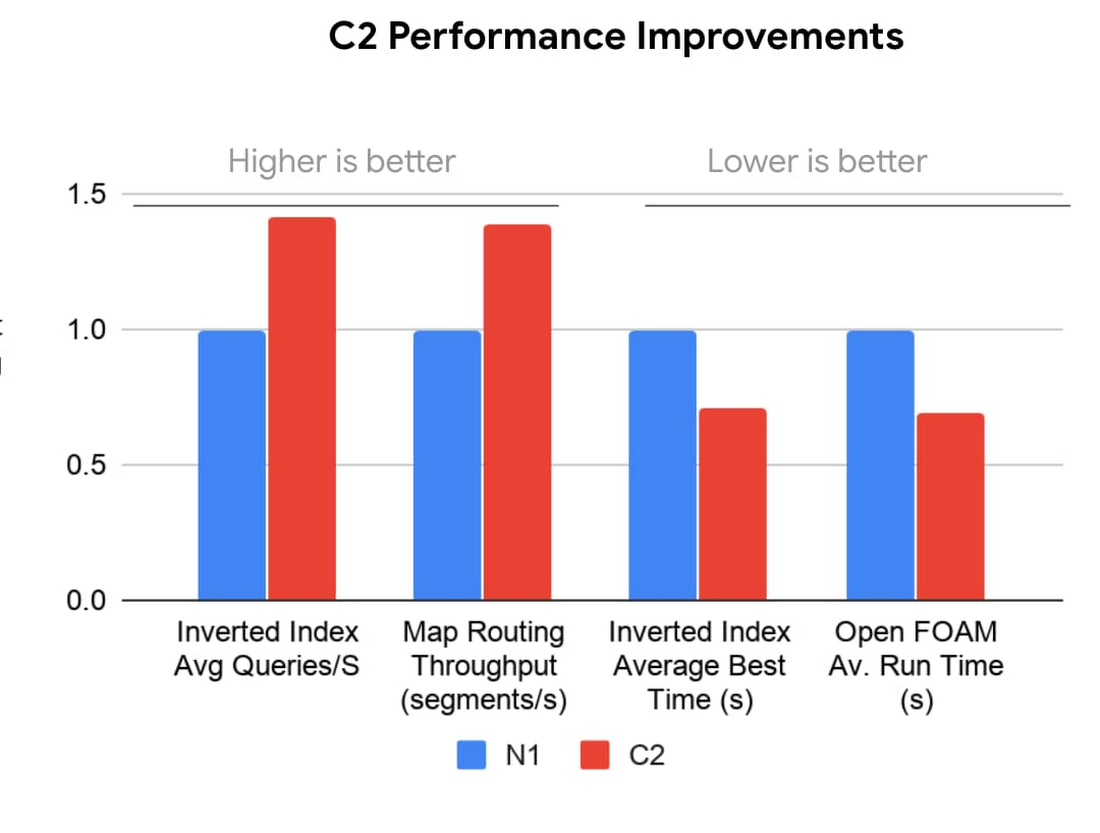

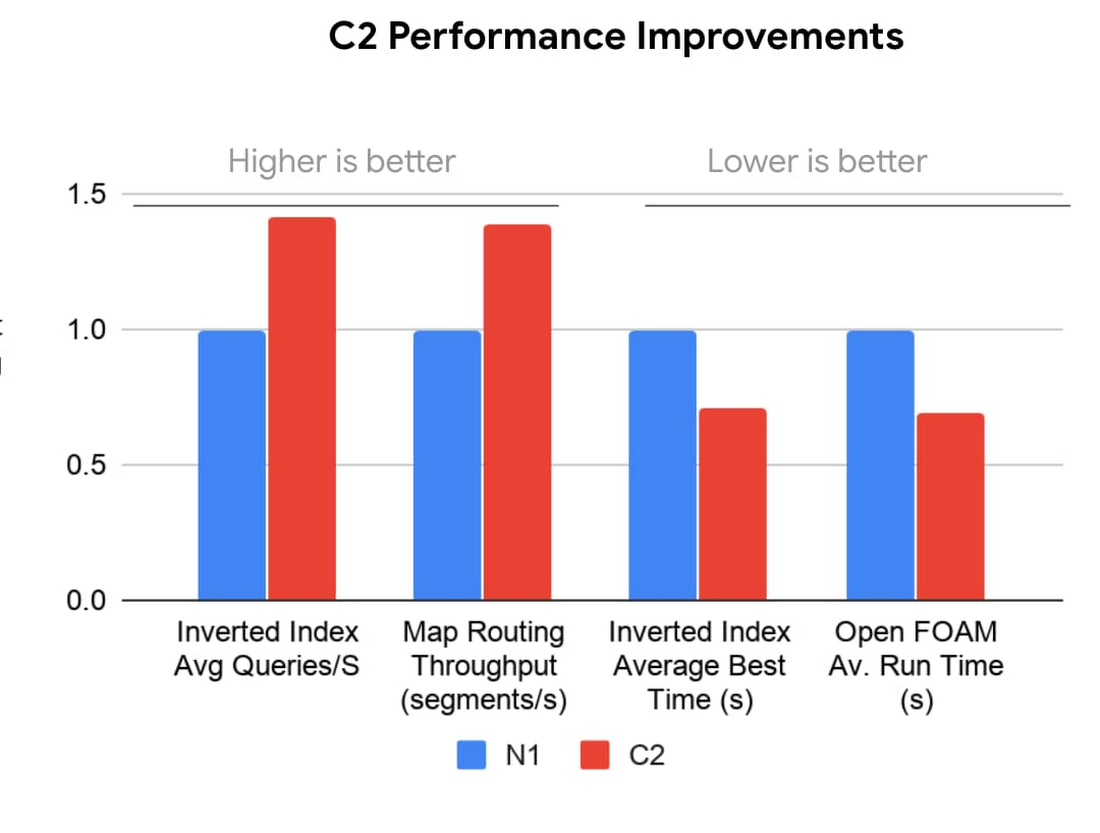

以下に示すように、コンピューティング最適化 VM はほとんどの対話型アプリケーションで最大 40% のパフォーマンス改善を達成しています。最適化の対象が 1 秒あたりのクエリ数でも、マップ ルーティング アルゴリズムのスループットでも同様です。多くの HPC アプリケーションの場合、OpenFOAM などのベンチマークでは、平均ランタイムの短縮率が最大で 4 倍になっていることがわかります。

C2 VM には最大 20% の継続利用割引があり、確約利用割引の対象でもあるため、3 年契約でさらに最大 60% のコスト削減が可能です。

メモリ最適化(M1、M2)ファミリー

メモリ最適化マシンタイプは、Google の VM ファミリーで最大のメモリを提供します。メモリサイズが 1 TB~12 TB で、最大 416 個の vCPU を備えるこれらの VM は、全 Compute Engine VM ソリューションの中で最大のコンピューティングとメモリリソースを提供します。SAP HANA などの大型インメモリ データベースや、インメモリ データ分析ワークロードに最適です。M1 VM は最大 4 TB のメモリ、M2 VM は最大 12 TB のメモリに対応しています。

M1 VM タイプと M2 VM タイプはメモリ 1 GB あたりのコストも Compute Engine の中で最低であるため、大きなメモリ構成を利用し、コンピューティング リソースの要件が低いワークロードに適しています。Microsoft SQL Server などのデータベースのワークロードにこれらの VM を使用すると、大きなメモリ構成を利用しながら、必要なコンピューティング リソースだけをプロビジョニングできます。

Compute Engine のメモリ最適化マシンタイプ(M2)に 6 TB と 12 TB の VM が追加されたことにより、SAP のお客様は大規模な SAP HANA データベースを Google Cloud で実行できるようになりました。これらの VM は、パブリック クラウド プロバイダから入手できる最大の SAP 認定 VM です。

M2 マシンタイプは、要求の厳しいビジネス クリティカルなデータベース アプリケーションに対応するだけでなく、Google Cloud の機能もサポートしています。こうしたビジネス クリティカルなデータベースの場合、ビジネスの継続性を維持するうえで稼働時間が重要になります。ライブ マイグレーションにより、インフラストラクチャのメンテナンス、アップグレード、セキュリティ パッチに対処する場合も、システムを稼働させ続けることができます。また、Google Cloud の柔軟な確約利用割引により、増大するデータベースを 1 TB~4 TB のインスタンスから新しい 6 TB の VM に移行する一方で、最新のメモリ最適化コミットメントを利用できます。

M1 VM と M2 VM には最大 30% の継続利用割引があり、確約利用割引の対象でもあるため、3 年契約でさらに最大 60% 以上のコスト削減が可能です。

アクセラレータ最適化(A2)ファミリー

アクセラレータ最適化ファミリーは、Compute Engine ポートフォリオの最新ソリューションです。A2 は現在、アルファ プログラムでご利用いただけます。一般提供は今年後半を予定しています。A2 は最新の NVIDIA Ampere A100 GPU を搭載していて、機械学習や HPC といった現代の要求の厳しいアプリケーションに対応できるように設計されました。A2 VM は、パブリック クラウド初の NVIDIA Ampere A100 Tensor Core GPU 搭載ソリューションでした。

40 GB の高性能 HBM2 GPU メモリを搭載した A100 GPU は、前世代の GPU と比較して、GPU 1 個あたり最大 20 倍の処理パフォーマンスを誇ります。A2 は NVIDIA の HGX システムを使用して、高速 NVLink による最大 600 GB/秒の GPU 間の帯域幅を実現しています。A2 マシンでは、最大 96 個の Intel Cascade Lake vCPU、GPU への高速なデータフィードを必要とするワークロード向けのローカル SSD(オプション)、最大 100 Gbps のネットワーキングをご利用いただけます。また、A2 VM では、基盤となる GPU サーバー プラットフォームのアーキテクチャが vNUMA により完全に透明化され、高度なパフォーマンス チューニングが実現します。

要求の厳しいコンピューティング ワークロード向けに、A2 には a2-megagpu-16g マシンタイプがあります。このマシンタイプは 16 個の A100 GPU を備え、合計 640 GB の GPU メモリが利用可能です。また、新しいスパース機能を使用した単一の VM の場合、FP16 では最大 10 PFLOPS、INT8 では最大 20 PetaOPS の CUDA のコンピューティング能力を実現できます。

コンピューティングを最大限に活用する

適切な VM ファミリーの選択は、ワークロードの効率を向上させるための第一歩です。今後数週間にわたって、Google のインテリジェント コンピューティング ソリューションの概要、OS のトラブルシューティングと最適化、ライセンス、データ保護など、その他の役立つ情報をお届けします。お使いの Compute Engine リソースの最適化にお役立てください。また、Compute Engine でのコスト削減に関する最近の投稿もぜひご覧ください。Compute Engine の詳細については、こちらのドキュメントのページをご覧ください。

- By Compute Engine プロダクト マネージャー Hanan Youssef