Ce document explique comment rendre Google Distributed Cloud disponible pour une gestion dans la console Google Cloud. Cela inclut la gestion de base, telle que la possibilité de se connecter aux clusters et d'afficher leurs charges de travail, ainsi que la manière d'activer la gestion du cycle de vie des clusters afin que vous puissiez mettre à niveau, mettre à jour et supprimer des clusters.

Membres du parc et console

Tous les services Google Distributed Cloud doivent être membres d'un parc, un moyen unifié d'afficher et de gérer plusieurs clusters et leurs charges de travail. Chaque parc de clusters est associé à un projet hôte de parc.

Dans Google Distributed Cloud, un cluster d'administrateur est enregistré dans un parc au moment de sa création en spécifiant le projet hôte de votre parc dans la section gkeConnect du fichier de configuration du cluster. Google Distributed Cloud utilise ces informations pour enregistrer votre cluster dans le projet de parc spécifié. Si l'enregistrement échoue, vous pouvez le relancer en exécutant gkectl update credentials register.

Notez que lorsque vous tentez à nouveau de vous inscrire, vous n'avez pas besoin de mettre à jour la clé de compte de service connect-register. En d'autres termes, vous pouvez continuer à utiliser votre compte de service connect-register d'origine. Pour en savoir plus sur la commande, consultez Effectuer une rotation des clés de compte de service.

Dans Google Distributed Cloud, un cluster d'utilisateur est enregistré dans un parc au moment de sa création:

Lorsque vous créez un cluster d'utilisateur à l'aide de

gkectl, vous spécifiez le projet hôte de votre parc dans la sectiongkeConnectdu fichier de configuration du cluster. Google Distributed Cloud utilise ces informations pour enregistrer votre cluster dans le projet de parc spécifié.Lorsque vous créez un cluster d'utilisateur à l'aide d'un outil standard (la console, Google Cloud CLI ou Terraform), le cluster devient automatiquement membre du parc du projet que vous spécifiez.

Les membres du parc en dehors de Google Cloud, tels que Google Distributed Cloud, sont affichés dans la console du projet hôte de votre parc, ainsi que d'autres clusters de parc tels que GKE sur Google Cloud. La mesure dans laquelle vous pouvez gérer Google Distributed Cloud depuis la console dépend des éléments suivants:

Si vous avez configuré l'authentification, vous pouvez vous connecter à vos clusters et afficher leurs charges de travail et d'autres détails.

Si vous avez activé la gestion du cycle de vie des clusters, vous pouvez également mettre à niveau, mettre à jour ou supprimer des clusters d'utilisateur à l'aide de la console. Si cette fonctionnalité n'est pas activée, vous ne pouvez gérer le cycle de vie du cluster qu'en utilisant

gkectlsur votre poste de travail administrateur.

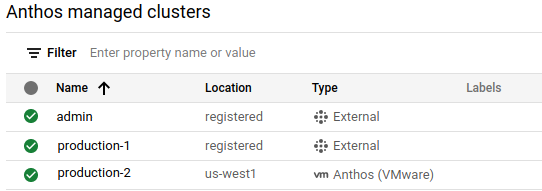

Afficher les clusters enregistrés

Tous les clusters de votre parc sont affichés sur la page Présentation des clusters Google Kubernetes Engine de la console. Cela vous donne à la fois un aperçu de l'ensemble de votre parc et, pour Google Distributed Cloud, vous permet de voir quels clusters sont gérés par l'API GKE On-Prem.

Pour afficher les clusters de votre parc:

Dans la console, accédez à la page de présentation des clusters Google Kubernetes Engine.

Sélectionnez le projet Google Cloud.

Si vm GKE sur VMware est affiché dans la colonne Type, le cluster est géré par l'API GKE On-Prem.

Si Externe est affiché dans la colonne Type, le cluster n'est pas géré par l'API GKE On-Prem.

Pour afficher plus de détails sur un cluster, les utilisateurs doivent se connecter et s'authentifier auprès du cluster. Pour ce faire, vous devez :

- Configurer une méthode d'authentification

- Accorder aux utilisateurs des rôles Identity and Access Management spécifiques

Configurer l'authentification

Comme décrit précédemment, tous les clusters de parc apparaissent dans les listes de clusters GKE et GKE Enterprise de la console. Toutefois, pour afficher plus de détails, tels que les nœuds et les charges de travail (et pour effectuer des tâches de gestion du cycle de vie du cluster si la fonctionnalité est activée), les utilisateurs doivent se connecter au cluster et s'authentifier. Pour ce faire, vos clusters enregistrés doivent être configurés avec l'une des méthodes d'authentification suivantes:

Identité Google: cette option permet aux utilisateurs de se connecter à l'aide de leur identité Google Cloud, qui correspond à l'adresse e-mail associée à votre compte Google Cloud. Utilisez cette option si les utilisateurs ont déjà accès à Google Cloud avec leur identité Google. Si vous avez créé le cluster dans la console, vous pouvez vous y connecter à l'aide de votre identité Google, mais vous devrez configurer l'authentification pour les autres utilisateurs.

La connexion avec l'identité Google est l'approche la plus simple pour l'authentification dans la console, en particulier si vous essayez Google Distributed Cloud avec une installation minimale. Nous avons donc expliqué comment configurer cette fonctionnalité plus en détail ci-dessous dans la section Configurer l'authentification de l'identité Google.

OpenID Connect (OIDC): cette option permet aux utilisateurs de se connecter à des clusters depuis la console à l'aide de leur identité provenant d'un fournisseur d'identité OIDC tiers, tel qu'Okta ou Microsoft AD FS. Vous pouvez utiliser cette option si vos utilisateurs disposent de noms d'utilisateur, de mots de passe et d'appartenances à des groupes de sécurité de votre fournisseur. Pour savoir comment configurer l'authentification OIDC tierce pour vos clusters, consultez les guides suivants:

Configurer des clusters pour GKE Identity Service avec OIDC : ce guide explique comment configurer l'authentification OIDC cluster par cluster.

Configurer GKE Identity Service pour un parc : cette option vous permet de configurer OIDC au niveau du parc.

Jeton de support: si les solutions fournies précédemment par Google ne conviennent pas à votre organisation, vous pouvez configurer l'authentification à l'aide d'un compte de service Kubernetes et utiliser son jeton de support pour vous connecter. Pour en savoir plus, consultez Configurer à l'aide d'un jeton de support.

Attribuer les rôles requis

L'accès à la console est contrôlé par Identity and Access Management (IAM). Ces rôles IAM sont requis quelle que soit la méthode d'authentification choisie. Pour gérer le cycle de vie du cluster dans la console, vous devez attribuer des rôles IAM.

Pour permettre aux utilisateurs d'accéder à la console, vous devez au minimum leur attribuer les rôles suivants:

roles/container.viewer. Ce rôle permet aux utilisateurs d'afficher la page "Clusters GKE" et les autres ressources de conteneur dans la console. Pour plus d'informations sur les autorisations incluses dans ce rôle ou pour accorder des autorisations de lecture/écriture à un rôle, consultez la section Rôles Kubernetes Engine dans la documentation IAM.roles/gkehub.viewer. Ce rôle permet aux utilisateurs d'afficher les clusters en dehors de Google Cloud dans la console. Pour en savoir plus sur les autorisations incluses dans ce rôle ou pour accorder un rôle avec des autorisations de lecture/écriture, consultez la section Rôles GKE Hub dans la documentation IAM.

Pour permettre aux utilisateurs de gérer le cycle de vie du cluster dans la console, accordez le rôle IAM

roles/gkeonprem.admin. Le rôleroles/gkeonprem.adminaccorde aux utilisateurs un accès administrateur à l'API GKE On-Prem, que la console utilise pour gérer le cycle de vie du cluster. Pour en savoir plus sur les autorisations incluses dans ce rôle, consultez la section Rôles GKE On-Prem dans la documentation IAM.

Les commandes suivantes montrent comment attribuer les rôles minimaux nécessaires pour gérer le cycle de vie du cluster dans la console:

gcloud projects add-iam-policy-binding FLEET_HOST_PROJECT_ID \

--member=MEMBER \

--role=roles/container.viewer

gcloud projects add-iam-policy-binding FLEET_HOST_PROJECT_ID \

--member=MEMBER \

--role=roles/gkehub.viewer

gcloud projects add-iam-policy-binding FLEET_HOST_PROJECT_ID \

--member=MEMBER \

--role=roles/gkeonprem.admin

où :

FLEET_HOST_PROJECT_IDest le projet hôte du parc. Pour les clusters créés à l'aide degkectl, il s'agit du projet que vous avez configuré dans la sectiongkeConnectdu fichier de configuration du cluster d'utilisateur. Pour les clusters créés dans la console, il s'agit du projet que vous avez choisi lors de la création du cluster.MEMBERcorrespond à l'adresse e-mail de l'utilisateur au formatuser:emailID, par exemple:user:alice@example.com.

Activer la gestion du cycle de vie des clusters dans la console

Les clusters d'utilisateur créés à l'aide d'outils standards (la console, gcloud CLI ou Terraform) sont automatiquement enregistrés dans l'API GKE On-Prem et vous permettent d'effectuer les tâches de gestion du cycle de vie des clusters dans la console. Si vous souhaitez activer cette fonctionnalité pour les clusters d'utilisateur créés à l'aide de gkectl, suivez la procédure décrite dans la section Configurer un cluster d'utilisateur à gérer par l'API GKE On-Prem.

Lorsque la gestion du cycle de vie des clusters est activée, vous pouvez effectuer les tâches suivantes depuis la console:

- Mettre à niveau les clusters d'utilisateur

- Redimensionner des clusters d'utilisateur

- Créer et gérer des pools de nœuds

- Supprimer des clusters d'utilisateur

Configurer l'authentification de l'identité Google

Pour permettre aux utilisateurs de se connecter au cluster à l'aide de leur identité Google, vous devez configurer les éléments suivants:

Les utilisateurs ont besoin de rôles Identity and Access Management (IAM) spécifiques pour pouvoir voir les clusters de la console et interagir avec ceux-ci sur les pages Clusters GKE et Clusters GKE Enterprise.

Les utilisateurs doivent être ajoutés aux stratégies de contrôle des accès basé sur les rôles (RBAC) Kubernetes dont la passerelle Connect a besoin pour accéder au serveur d'API Kubernetes du cluster via l'agent Connect.

Configurer l'autorisation RBAC

Le serveur d'API Kubernetes de chaque cluster doit pouvoir autoriser les requêtes provenant de la console. Pour configurer l'autorisation, vous devez configurer des stratégies de contrôle des accès basé sur les rôles (RBAC) Kubernetes sur chaque cluster.

Si vous avez utilisé un outil standard pour créer le cluster d'utilisateur, vous disposez peut-être déjà des stratégies RBAC appropriées qui vous octroient un accès administrateur complet au cluster. L'API GKE On-Prem ajoute automatiquement votre compte Google en tant qu'administrateur dans les cas suivants:

Vous avez créé le cluster d'utilisateur dans la console.

Vous avez créé le cluster d'utilisateur à l'aide de la gcloud CLI et votre compte Google a été spécifié dans l'option

--admin-usersde la commande de création de cluster.Vous avez créé le cluster d'utilisateur à l'aide de Terraform et votre compte Google a été spécifié dans le champ

authorization.admin_users.username.

Les clusters d'utilisateur créés à l'aide de gkectl ne vous accordent pas les stratégies RBAC permettant d'administrer le cluster à l'aide de la console. Vous devez vous ajouter vous-même après la création du cluster. Quel que soit l'outil que vous avez utilisé pour créer le cluster, vous pouvez ajouter d'autres personnes en tant qu'administrateurs une fois le cluster créé.

Vous pouvez utiliser l'une des méthodes suivantes pour accorder un accès administrateur au cluster. Deux commandes gcloud différentes sont fournies.

La commande

gcloud ... generate-gateway-rbacdoit être exécutée sur votre poste de travail administrateur, car elle nécessite un accès au fichier kubeconfig et au contexte du cluster (qui ne se trouvent généralement que sur votre poste de travail administrateur). La commandegenerate-gateway-rbacvous permet de personnaliser les stratégies RBAC, mais les adresses e-mail des utilisateurs ne seront pas affichées en tant qu'administrateurs dans la section Détails du cluster de la console.La commande

gcloud ... updatepeut être exécutée sur votre poste de travail administrateur ou sur n'importe quel ordinateur ayant accès à l'API GKE On-Prem.

generate-gateway-rbac

Se connecter au poste de travail administrateur

Exécutez la commande suivante pour mettre à jour les composants:

gcloud components updateGénérez et appliquez les stratégies RBAC pour les utilisateurs et les comptes de service à votre cluster:

gcloud container fleet memberships generate-gateway-rbac \ --membership=MEMBERSHIP_NAME \ --role=ROLE \ --users=USERS \ --project=FLEET_HOST_PROJECT_ID \ --kubeconfig=KUBECONFIG_PATH \ --context=KUBECONFIG_CONTEXT \ --applyRemplacez les éléments suivants :

- MEMBERSHIP_NAME: nom utilisé pour représenter de manière unique le cluster dans son parc. Dans Google Distributed Cloud, le nom de l'appartenance et le nom du cluster sont identiques.

- ROLE: rôle Kubernetes que vous souhaitez attribuer aux utilisateurs du cluster. Pour accorder aux utilisateurs un accès complet à toutes les ressources du cluster dans tous les espaces de noms, spécifiez

clusterrole/cluster-admin. Pour fournir un accès en lecture seule, spécifiezclusterrole/view. Vous pouvez également créer un rôle personnalisé, par exemple:role/mynamespace/namespace-reader. Le rôle personnalisé doit déjà exister pour que vous puissiez exécuter la commande. - USERS : adresses e-mail des utilisateurs (comptes utilisateur ou comptes de service) auxquels vous souhaitez accorder les autorisations, sous la forme d'une liste d'éléments séparés par une virgule. Exemple :

--users=foo@example.com,test-acct@test-project.iam.gserviceaccount.com. - FLEET_HOST_PROJECT_ID: ID du projet hôte du parc.

- KUBECONFIG_PATH: chemin d'accès local où est stocké votre fichier kubeconfig contenant une entrée pour le cluster.

KUBECONFIG_CONTEXT : contexte du cluster tel qu'il apparaît dans le fichier kubeconfig. Vous pouvez obtenir le contexte actuel à partir de la ligne de commande en exécutant la commande

kubectl config current-context. Que vous utilisiez le contexte actuel ou non, assurez-vous qu'il fonctionne pour l'accès au cluster en exécutant une commande simple telle que la suivante :kubectl get namespaces \ --kubeconfig=KUBECONFIG_PATH \ --context=KUBECONFIG_CONTEXT

Après avoir exécuté

gcloud container fleet memberships generate-gateway-rbac, un message semblable au suivant s'affiche à la fin du résultat, qui est tronqué pour des raisons de lisibilité:Validating input arguments. Specified Cluster Role is: clusterrole/cluster-admin Generated RBAC policy is: -------------------------------------------- ... Applying the generate RBAC policy to cluster with kubeconfig: /usr/local/google/home/foo/.kube/config, context: kind-kind Writing RBAC policy for user: foo@example.com to cluster. Successfully applied the RBAC policy to cluster.Il s'agit du contexte d'accès au cluster via la passerelle Connect.

Pour en savoir plus sur la commande

generate-gateway-rbac, consultez le guide de référence de gcloud CLI.

update

Exécutez la commande suivante pour mettre à jour les composants:

gcloud components updatePour chaque utilisateur auquel le rôle

clusterrole/cluster-admindoit être accordé, incluez l'option--admin-userset exécutez la commande suivante. Vous ne pouvez pas spécifier plusieurs utilisateurs avec une seule option. Veillez à inclure votre compte Google dans la commande, car celle-ci remplace la liste d'autorisation par les utilisateurs que vous spécifiez dans la commande.gcloud container vmware clusters update USER_CLUSTER_NAME \ --admin-users YOUR_GOOGLE_ACCOUNT \ --admin-users ADMIN_GOOGLE_ACCOUNT_1 \

En plus d'accorder le rôle Kubernetes clusterrole/cluster-admin, la commande accorde les stratégies RBAC nécessaires aux utilisateurs pour accéder au cluster via la passerelle Connect.

Console

Pour appliquer les stratégies RBAC aux utilisateurs, procédez comme suit dans la console:

Dans la console, accédez à la page de présentation des clusters Google Kubernetes Engine.

Sélectionnez le projet Google Cloud dans lequel se trouve le cluster d'utilisateur.

Dans la liste des clusters, cliquez sur le nom du cluster puis sur Afficher les détails dans le panneau Détails.

Dans la section Autorisation, cliquez sur le champ Utilisateurs administrateurs de cluster et saisissez l'adresse e-mail de chaque utilisateur.

Une fois les utilisateurs ajoutés, cliquez sur OK.

En savoir plus

- Présentation de la gestion du parc

- Utiliser des clusters depuis Google Cloud Console

- Présentation de Connect

- Présentation de l'agent Connect