Riconoscimento ottico dei caratteri (OCR)

L'API Vision può rilevare ed estrarre il testo dalle immagini. Esistono due funzionalità di annotazione che supportano il riconoscimento ottico dei caratteri (OCR):

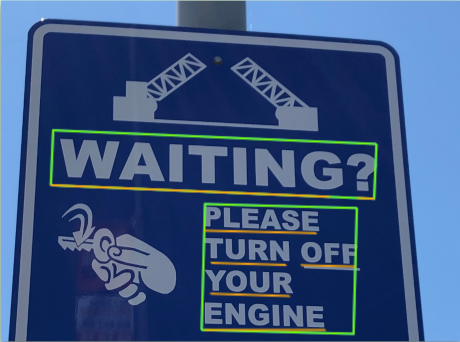

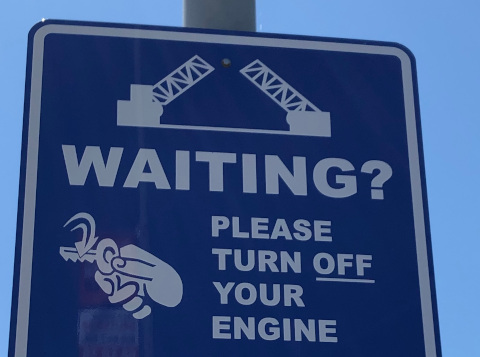

TEXT_DETECTIONrileva ed estrae il testo da qualsiasi immagine. Ad esempio, una fotografia potrebbe contenere un cartello stradale o un segnale stradale. Il file JSON include l'intera stringa estratta, nonché le singole parole e i relativi rettangoli di selezione.

DOCUMENT_TEXT_DETECTIONestrae anche il testo da un'immagine, ma la risposta è ottimizzata per testo e documenti densi. Il JSON include informazioni su pagina, blocco, paragrafo, parola e interruzione.

Scopri di più su

DOCUMENT_TEXT_DETECTIONper l'estrazione della scrittura a mano e l'estrazione del testo dai file (PDF/TIFF).

Provalo

Se non conosci Google Cloud, crea un account per valutare le prestazioni di Cloud Vision in scenari reali. I nuovi clienti ricevono anche 300 $ di crediti per l'esecuzione, il test e il deployment di workload senza costi aggiuntivi.

Prova Cloud Vision gratuitamenteRichieste di rilevamento testo

Configura il progetto Google Cloud e l'autenticazione

Se non hai creato un Google Cloud progetto, fallo ora. Espandi questa sezione per le istruzioni.

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vision API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Vision API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Install the Google Cloud CLI.

-

Se utilizzi un provider di identità (IdP) esterno, devi prima accedere a gcloud CLI con la tua identità federata.

-

Per inizializzare gcloud CLI, esegui questo comando:

gcloud init - BASE64_ENCODED_IMAGE: la rappresentazione

in Base64 (stringa ASCII) dei dati dell'immagine binaria. Questa stringa dovrebbe essere simile alla

seguente:

/9j/4QAYRXhpZgAA...9tAVx/zDQDlGxn//2Q==

- PROJECT_ID: il tuo ID progetto Google Cloud .

- CLOUD_STORAGE_IMAGE_URI: il percorso di un file immagine valido in un bucket Cloud Storage. Devi disporre almeno dei privilegi di lettura per il file.

Esempio:

gs://cloud-samples-data/vision/ocr/sign.jpg

- PROJECT_ID: il tuo ID progetto Google Cloud .

us: solo Stati Unitieu: L'Unione Europea- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/images:annotate

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/images:asyncBatchAnnotate

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/files:annotate

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/files:asyncBatchAnnotate

- REGION_ID: uno degli identificatori di località regionali validi:

us: solo Stati Unitieu: L'Unione Europea

- CLOUD_STORAGE_IMAGE_URI: il percorso di un file immagine valido in un bucket Cloud Storage. Devi disporre almeno dei privilegi di lettura per il file.

Esempio:

gs://cloud-samples-data/vision/ocr/sign.jpg

- PROJECT_ID: il tuo ID progetto Google Cloud .

Rilevamento del testo in un'immagine locale

Puoi utilizzare l'API Vision per eseguire il rilevamento delle funzionalità su un file immagine locale.

Per le richieste REST, invia i contenuti del file immagine come stringa codificata in base64 nel corpo della richiesta.

Per le richieste gcloud e delle librerie client, specifica il percorso di un'immagine locale nella tua richiesta.

gcloud

Per eseguire il rilevamento del testo, utilizza il comando

gcloud ml vision detect-text

come mostrato nell'esempio seguente:

gcloud ml vision detect-text ./path/to/local/file.jpg

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

Metodo HTTP e URL:

POST https://vision.googleapis.com/v1/images:annotate

Corpo JSON della richiesta:

{

"requests": [

{

"image": {

"content": "BASE64_ENCODED_IMAGE"

},

"features": [

{

"type": "TEXT_DETECTION"

}

]

}

]

}

Per inviare la richiesta, scegli una di queste opzioni:

curl

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://vision.googleapis.com/v1/images:annotate"

PowerShell

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://vision.googleapis.com/v1/images:annotate" | Select-Object -Expand Content

Se la richiesta riesce, il server restituisce un codice di stato HTTP 200 OK e la risposta in formato JSON.

Una risposta TEXT_DETECTION include la frase rilevata, il riquadro di delimitazione di selezione e le singole parole con i relativi riquadri di selezione.

Risposta

{

"responses": [

{

"textAnnotations": [

{

"locale": "en",

"description": "WAITING?\nPLEASE\nTURN OFF\nYOUR\nENGINE\n",

"boundingPoly": {

"vertices": [

{

"x": 341,

"y": 828

},

{

"x": 2249,

"y": 828

},

{

"x": 2249,

"y": 1993

},

{

"x": 341,

"y": 1993

}

]

}

},

{

"description": "WAITING?",

"boundingPoly": {

"vertices": [

{

"x": 352,

"y": 828

},

{

"x": 2248,

"y": 911

},

{

"x": 2238,

"y": 1148

},

{

"x": 342,

"y": 1065

}

]

}

},

{

"description": "PLEASE",

"boundingPoly": {

"vertices": [

{

"x": 1210,

"y": 1233

},

{

"x": 1907,

"y": 1263

},

{

"x": 1902,

"y": 1383

},

{

"x": 1205,

"y": 1353

}

]

}

},

{

"description": "TURN",

"boundingPoly": {

"vertices": [

{

"x": 1210,

"y": 1418

},

{

"x": 1730,

"y": 1441

},

{

"x": 1724,

"y": 1564

},

{

"x": 1205,

"y": 1541

}

]

}

},

{

"description": "OFF",

"boundingPoly": {

"vertices": [

{

"x": 1792,

"y": 1443

},

{

"x": 2128,

"y": 1458

},

{

"x": 2122,

"y": 1581

},

{

"x": 1787,

"y": 1566

}

]

}

},

{

"description": "YOUR",

"boundingPoly": {

"vertices": [

{

"x": 1219,

"y": 1603

},

{

"x": 1746,

"y": 1629

},

{

"x": 1740,

"y": 1759

},

{

"x": 1213,

"y": 1733

}

]

}

},

{

"description": "ENGINE",

"boundingPoly": {

"vertices": [

{

"x": 1222,

"y": 1771

},

{

"x": 1944,

"y": 1834

},

{

"x": 1930,

"y": 1992

},

{

"x": 1208,

"y": 1928

}

]

}

}

],

"fullTextAnnotation": {

"pages": [

...

]

},

"paragraphs": [

...

]

},

"words": [

...

},

"symbols": [

...

}

]

}

],

"blockType": "TEXT"

},

...

]

}

],

"text": "WAITING?\nPLEASE\nTURN OFF\nYOUR\nENGINE\n"

}

}

]

}

Go

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Go.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

// detectText gets text from the Vision API for an image at the given file path.

func detectText(w io.Writer, file string) error {

ctx := context.Background()

client, err := vision.NewImageAnnotatorClient(ctx)

if err != nil {

return err

}

f, err := os.Open(file)

if err != nil {

return err

}

defer f.Close()

image, err := vision.NewImageFromReader(f)

if err != nil {

return err

}

annotations, err := client.DetectTexts(ctx, image, nil, 10)

if err != nil {

return err

}

if len(annotations) == 0 {

fmt.Fprintln(w, "No text found.")

} else {

fmt.Fprintln(w, "Text:")

for _, annotation := range annotations {

fmt.Fprintf(w, "%q\n", annotation.Description)

}

}

return nil

}

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida dell'API Vision che utilizza le librerie client. Per saperne di più, consulta la documentazione di riferimento di Vision API Java.

import com.google.cloud.vision.v1.AnnotateImageRequest;

import com.google.cloud.vision.v1.AnnotateImageResponse;

import com.google.cloud.vision.v1.BatchAnnotateImagesResponse;

import com.google.cloud.vision.v1.EntityAnnotation;

import com.google.cloud.vision.v1.Feature;

import com.google.cloud.vision.v1.Image;

import com.google.cloud.vision.v1.ImageAnnotatorClient;

import com.google.protobuf.ByteString;

import java.io.FileInputStream;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

public class DetectText {

public static void detectText() throws IOException {

// TODO(developer): Replace these variables before running the sample.

String filePath = "path/to/your/image/file.jpg";

detectText(filePath);

}

// Detects text in the specified image.

public static void detectText(String filePath) throws IOException {

List<AnnotateImageRequest> requests = new ArrayList<>();

ByteString imgBytes = ByteString.readFrom(new FileInputStream(filePath));

Image img = Image.newBuilder().setContent(imgBytes).build();

Feature feat = Feature.newBuilder().setType(Feature.Type.TEXT_DETECTION).build();

AnnotateImageRequest request =

AnnotateImageRequest.newBuilder().addFeatures(feat).setImage(img).build();

requests.add(request);

// Initialize client that will be used to send requests. This client only needs to be created

// once, and can be reused for multiple requests. After completing all of your requests, call

// the "close" method on the client to safely clean up any remaining background resources.

try (ImageAnnotatorClient client = ImageAnnotatorClient.create()) {

BatchAnnotateImagesResponse response = client.batchAnnotateImages(requests);

List<AnnotateImageResponse> responses = response.getResponsesList();

for (AnnotateImageResponse res : responses) {

if (res.hasError()) {

System.out.format("Error: %s%n", res.getError().getMessage());

return;

}

// For full list of available annotations, see http://g.co/cloud/vision/docs

for (EntityAnnotation annotation : res.getTextAnnotationsList()) {

System.out.format("Text: %s%n", annotation.getDescription());

System.out.format("Position : %s%n", annotation.getBoundingPoly());

}

}

}

}

}Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Node.js.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

const vision = require('@google-cloud/vision');

// Creates a client

const client = new vision.ImageAnnotatorClient();

/**

* TODO(developer): Uncomment the following line before running the sample.

*/

// const fileName = 'Local image file, e.g. /path/to/image.png';

// Performs text detection on the local file

const [result] = await client.textDetection(fileName);

const detections = result.textAnnotations;

console.log('Text:');

detections.forEach(text => console.log(text));Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Python.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

def detect_text(path):

"""Detects text in the file."""

from google.cloud import vision

client = vision.ImageAnnotatorClient()

with open(path, "rb") as image_file:

content = image_file.read()

image = vision.Image(content=content)

response = client.text_detection(image=image)

texts = response.text_annotations

print("Texts:")

for text in texts:

print(f'\n"{text.description}"')

vertices = [

f"({vertex.x},{vertex.y})" for vertex in text.bounding_poly.vertices

]

print("bounds: {}".format(",".join(vertices)))

if response.error.message:

raise Exception(

"{}\nFor more info on error messages, check: "

"https://cloud.google.com/apis/design/errors".format(response.error.message)

)

Linguaggi aggiuntivi

C#: Segui le istruzioni di configurazione di C# nella pagina delle librerie client e poi visita la documentazione di riferimento di Vision per .NET.

PHP: Segui le istruzioni di configurazione di PHP nella pagina delle librerie client e poi consulta la documentazione di riferimento di Vision per PHP.

Ruby: Segui le istruzioni di configurazione di Ruby nella pagina delle librerie client e poi visita la documentazione di riferimento di Vision per Ruby.

Rilevare il testo in un'immagine remota

Puoi utilizzare l'API Vision per eseguire il rilevamento delle funzionalità su un file immagine remoto che si trova in Cloud Storage o sul web. Per inviare una richiesta di file remoto, specifica l'URL web del file o l'URI Cloud Storage nel corpo della richiesta.

gcloud

Per eseguire il rilevamento del testo, utilizza il comando

gcloud ml vision detect-text

come mostrato nell'esempio seguente:

gcloud ml vision detect-text gs://cloud-samples-data/vision/ocr/sign.jpg

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

Metodo HTTP e URL:

POST https://vision.googleapis.com/v1/images:annotate

Corpo JSON della richiesta:

{

"requests": [

{

"image": {

"source": {

"imageUri": "CLOUD_STORAGE_IMAGE_URI"

}

},

"features": [

{

"type": "TEXT_DETECTION"

}

]

}

]

}

Per inviare la richiesta, scegli una di queste opzioni:

curl

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://vision.googleapis.com/v1/images:annotate"

PowerShell

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://vision.googleapis.com/v1/images:annotate" | Select-Object -Expand Content

Se la richiesta riesce, il server restituisce un codice di stato HTTP 200 OK e la risposta in formato JSON.

Una risposta TEXT_DETECTION include la frase rilevata, il riquadro di delimitazione di selezione e le singole parole con i relativi riquadri di selezione.

Risposta

{

"responses": [

{

"textAnnotations": [

{

"locale": "en",

"description": "WAITING?\nPLEASE\nTURN OFF\nYOUR\nENGINE\n",

"boundingPoly": {

"vertices": [

{

"x": 341,

"y": 828

},

{

"x": 2249,

"y": 828

},

{

"x": 2249,

"y": 1993

},

{

"x": 341,

"y": 1993

}

]

}

},

{

"description": "WAITING?",

"boundingPoly": {

"vertices": [

{

"x": 352,

"y": 828

},

{

"x": 2248,

"y": 911

},

{

"x": 2238,

"y": 1148

},

{

"x": 342,

"y": 1065

}

]

}

},

{

"description": "PLEASE",

"boundingPoly": {

"vertices": [

{

"x": 1210,

"y": 1233

},

{

"x": 1907,

"y": 1263

},

{

"x": 1902,

"y": 1383

},

{

"x": 1205,

"y": 1353

}

]

}

},

{

"description": "TURN",

"boundingPoly": {

"vertices": [

{

"x": 1210,

"y": 1418

},

{

"x": 1730,

"y": 1441

},

{

"x": 1724,

"y": 1564

},

{

"x": 1205,

"y": 1541

}

]

}

},

{

"description": "OFF",

"boundingPoly": {

"vertices": [

{

"x": 1792,

"y": 1443

},

{

"x": 2128,

"y": 1458

},

{

"x": 2122,

"y": 1581

},

{

"x": 1787,

"y": 1566

}

]

}

},

{

"description": "YOUR",

"boundingPoly": {

"vertices": [

{

"x": 1219,

"y": 1603

},

{

"x": 1746,

"y": 1629

},

{

"x": 1740,

"y": 1759

},

{

"x": 1213,

"y": 1733

}

]

}

},

{

"description": "ENGINE",

"boundingPoly": {

"vertices": [

{

"x": 1222,

"y": 1771

},

{

"x": 1944,

"y": 1834

},

{

"x": 1930,

"y": 1992

},

{

"x": 1208,

"y": 1928

}

]

}

}

],

"fullTextAnnotation": {

"pages": [

...

]

},

"paragraphs": [

...

]

},

"words": [

...

},

"symbols": [

...

}

]

}

],

"blockType": "TEXT"

},

...

]

}

],

"text": "WAITING?\nPLEASE\nTURN OFF\nYOUR\nENGINE\n"

}

}

]

}

Go

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Go.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

// detectText gets text from the Vision API for an image at the given file path.

func detectTextURI(w io.Writer, file string) error {

ctx := context.Background()

client, err := vision.NewImageAnnotatorClient(ctx)

if err != nil {

return err

}

image := vision.NewImageFromURI(file)

annotations, err := client.DetectTexts(ctx, image, nil, 10)

if err != nil {

return err

}

if len(annotations) == 0 {

fmt.Fprintln(w, "No text found.")

} else {

fmt.Fprintln(w, "Text:")

for _, annotation := range annotations {

fmt.Fprintf(w, "%q\n", annotation.Description)

}

}

return nil

}

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida dell'API Vision che utilizza le librerie client. Per saperne di più, consulta la documentazione di riferimento di Vision API Java.

import com.google.cloud.vision.v1.AnnotateImageRequest;

import com.google.cloud.vision.v1.AnnotateImageResponse;

import com.google.cloud.vision.v1.BatchAnnotateImagesResponse;

import com.google.cloud.vision.v1.EntityAnnotation;

import com.google.cloud.vision.v1.Feature;

import com.google.cloud.vision.v1.Image;

import com.google.cloud.vision.v1.ImageAnnotatorClient;

import com.google.cloud.vision.v1.ImageSource;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

public class DetectTextGcs {

public static void detectTextGcs() throws IOException {

// TODO(developer): Replace these variables before running the sample.

String filePath = "gs://your-gcs-bucket/path/to/image/file.jpg";

detectTextGcs(filePath);

}

// Detects text in the specified remote image on Google Cloud Storage.

public static void detectTextGcs(String gcsPath) throws IOException {

List<AnnotateImageRequest> requests = new ArrayList<>();

ImageSource imgSource = ImageSource.newBuilder().setGcsImageUri(gcsPath).build();

Image img = Image.newBuilder().setSource(imgSource).build();

Feature feat = Feature.newBuilder().setType(Feature.Type.TEXT_DETECTION).build();

AnnotateImageRequest request =

AnnotateImageRequest.newBuilder().addFeatures(feat).setImage(img).build();

requests.add(request);

// Initialize client that will be used to send requests. This client only needs to be created

// once, and can be reused for multiple requests. After completing all of your requests, call

// the "close" method on the client to safely clean up any remaining background resources.

try (ImageAnnotatorClient client = ImageAnnotatorClient.create()) {

BatchAnnotateImagesResponse response = client.batchAnnotateImages(requests);

List<AnnotateImageResponse> responses = response.getResponsesList();

for (AnnotateImageResponse res : responses) {

if (res.hasError()) {

System.out.format("Error: %s%n", res.getError().getMessage());

return;

}

// For full list of available annotations, see http://g.co/cloud/vision/docs

for (EntityAnnotation annotation : res.getTextAnnotationsList()) {

System.out.format("Text: %s%n", annotation.getDescription());

System.out.format("Position : %s%n", annotation.getBoundingPoly());

}

}

}

}

}Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Node.js.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

// Imports the Google Cloud client libraries

const vision = require('@google-cloud/vision');

// Creates a client

const client = new vision.ImageAnnotatorClient();

/**

* TODO(developer): Uncomment the following lines before running the sample.

*/

// const bucketName = 'Bucket where the file resides, e.g. my-bucket';

// const fileName = 'Path to file within bucket, e.g. path/to/image.png';

// Performs text detection on the gcs file

const [result] = await client.textDetection(`gs://${bucketName}/${fileName}`);

const detections = result.textAnnotations;

console.log('Text:');

detections.forEach(text => console.log(text));Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Python.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

def detect_text_uri(uri):

"""Detects text in the file located in Google Cloud Storage or on the Web."""

from google.cloud import vision

client = vision.ImageAnnotatorClient()

image = vision.Image()

image.source.image_uri = uri

response = client.text_detection(image=image)

texts = response.text_annotations

print("Texts:")

for text in texts:

print(f'\n"{text.description}"')

vertices = [

f"({vertex.x},{vertex.y})" for vertex in text.bounding_poly.vertices

]

print("bounds: {}".format(",".join(vertices)))

if response.error.message:

raise Exception(

"{}\nFor more info on error messages, check: "

"https://cloud.google.com/apis/design/errors".format(response.error.message)

)

Linguaggi aggiuntivi

C#: Segui le istruzioni di configurazione di C# nella pagina delle librerie client e poi visita la documentazione di riferimento di Vision per .NET.

PHP: Segui le istruzioni di configurazione di PHP nella pagina delle librerie client e poi consulta la documentazione di riferimento di Vision per PHP.

Ruby: Segui le istruzioni di configurazione di Ruby nella pagina delle librerie client e poi visita la documentazione di riferimento di Vision per Ruby.

(Facoltativo) Specifica la lingua

Entrambi i tipi di richieste OCR supportano uno o più languageHints che specificano la

lingua di qualsiasi testo nell'immagine. Tuttavia, un valore vuoto in genere produce i risultati migliori,

perché l'omissione di un valore consente il rilevamento automatico della lingua. Per le lingue basate sull'alfabeto latino, non è necessario impostare languageHints. In rari casi, quando la lingua del testo nell'immagine è nota, l'impostazione di un suggerimento aiuta a ottenere risultati migliori (anche se può essere un ostacolo significativo se il suggerimento è errato). Il rilevamento del testo restituisce un errore se una o più delle lingue specificate non sono tra le lingue supportate.

Se scegli di fornire un suggerimento sulla lingua, modifica il corpo della richiesta

(file request.json) per fornire la stringa di una delle lingue supportate

nel campo imageContext.languageHints, come mostrato nel seguente esempio:

{ "requests": [ { "image": { "source": { "imageUri": "IMAGE_URL" } }, "features": [ { "type": "DOCUMENT_TEXT_DETECTION" } ], "imageContext": { "languageHints": ["en-t-i0-handwrit"] } } ] }

Supporto di più aree geografiche

Ora puoi specificare l'archiviazione dei dati a livello di continente e l'elaborazione OCR. Al momento sono supportate le seguenti regioni:

Località

Cloud Vision ti offre un certo controllo su dove vengono archiviate ed elaborate le risorse del tuo progetto. In particolare, puoi configurare Cloud Vision per archiviare ed elaborare i tuoi dati solo nell'Unione Europea.

Per impostazione predefinita, Cloud Vision archivia ed elabora le risorse in una località globale, il che significa che Cloud Vision non garantisce che le risorse rimarranno all'interno di una determinata località o regione. Se scegli la località Unione Europea, Google archivierà i tuoi dati e li elaborerà solo nell'Unione Europea. Tu e i tuoi utenti potete accedere ai dati da qualsiasi posizione.

Impostazione della posizione utilizzando l'API

L'API Vision supporta un endpoint API globale (vision.googleapis.com) e anche

due endpoint basati sulla regione: un endpoint dell'Unione Europea

(eu-vision.googleapis.com) e un endpoint degli Stati Uniti (us-vision.googleapis.com). Utilizza questi endpoint per l'elaborazione specifica per regione. Ad esempio, per archiviare ed elaborare i tuoi dati solo nell'Unione Europea, utilizza l'URI eu-vision.googleapis.com al posto di vision.googleapis.com per le chiamate API REST:

Per archiviare ed elaborare i dati solo negli Stati Uniti, utilizza l'endpoint statunitense

(us-vision.googleapis.com) con i metodi precedenti.

Impostare la posizione utilizzando le librerie client

Per impostazione predefinita, le librerie client dell'API Vision accedono all'endpoint API globale

(vision.googleapis.com). Per archiviare ed elaborare i dati solo nell'Unione Europea, devi impostare esplicitamente l'endpoint (eu-vision.googleapis.com). I seguenti esempi di codice mostrano come configurare questa impostazione.

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

Metodo HTTP e URL:

POST https://REGION_ID-vision.googleapis.com/v1/projects/PROJECT_ID/locations/REGION_ID/images:annotate

Corpo JSON della richiesta:

{

"requests": [

{

"image": {

"source": {

"imageUri": "CLOUD_STORAGE_IMAGE_URI"

}

},

"features": [

{

"type": "TEXT_DETECTION"

}

]

}

]

}

Per inviare la richiesta, scegli una di queste opzioni:

curl

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://REGION_ID-vision.googleapis.com/v1/projects/PROJECT_ID/locations/REGION_ID/images:annotate"

PowerShell

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://REGION_ID-vision.googleapis.com/v1/projects/PROJECT_ID/locations/REGION_ID/images:annotate" | Select-Object -Expand Content

Se la richiesta riesce, il server restituisce un codice di stato HTTP 200 OK e la risposta in formato JSON.

Una risposta TEXT_DETECTION include la frase rilevata, il riquadro di delimitazione di selezione e le singole parole con i relativi riquadri di selezione.

Risposta

{

"responses": [

{

"textAnnotations": [

{

"locale": "en",

"description": "WAITING?\nPLEASE\nTURN OFF\nYOUR\nENGINE\n",

"boundingPoly": {

"vertices": [

{

"x": 341,

"y": 828

},

{

"x": 2249,

"y": 828

},

{

"x": 2249,

"y": 1993

},

{

"x": 341,

"y": 1993

}

]

}

},

{

"description": "WAITING?",

"boundingPoly": {

"vertices": [

{

"x": 352,

"y": 828

},

{

"x": 2248,

"y": 911

},

{

"x": 2238,

"y": 1148

},

{

"x": 342,

"y": 1065

}

]

}

},

{

"description": "PLEASE",

"boundingPoly": {

"vertices": [

{

"x": 1210,

"y": 1233

},

{

"x": 1907,

"y": 1263

},

{

"x": 1902,

"y": 1383

},

{

"x": 1205,

"y": 1353

}

]

}

},

{

"description": "TURN",

"boundingPoly": {

"vertices": [

{

"x": 1210,

"y": 1418

},

{

"x": 1730,

"y": 1441

},

{

"x": 1724,

"y": 1564

},

{

"x": 1205,

"y": 1541

}

]

}

},

{

"description": "OFF",

"boundingPoly": {

"vertices": [

{

"x": 1792,

"y": 1443

},

{

"x": 2128,

"y": 1458

},

{

"x": 2122,

"y": 1581

},

{

"x": 1787,

"y": 1566

}

]

}

},

{

"description": "YOUR",

"boundingPoly": {

"vertices": [

{

"x": 1219,

"y": 1603

},

{

"x": 1746,

"y": 1629

},

{

"x": 1740,

"y": 1759

},

{

"x": 1213,

"y": 1733

}

]

}

},

{

"description": "ENGINE",

"boundingPoly": {

"vertices": [

{

"x": 1222,

"y": 1771

},

{

"x": 1944,

"y": 1834

},

{

"x": 1930,

"y": 1992

},

{

"x": 1208,

"y": 1928

}

]

}

}

],

"fullTextAnnotation": {

"pages": [

...

]

},

"paragraphs": [

...

]

},

"words": [

...

},

"symbols": [

...

}

]

}

],

"blockType": "TEXT"

},

...

]

}

],

"text": "WAITING?\nPLEASE\nTURN OFF\nYOUR\nENGINE\n"

}

}

]

}

Go

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Go.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

import (

"context"

"fmt"

vision "cloud.google.com/go/vision/apiv1"

"google.golang.org/api/option"

)

// setEndpoint changes your endpoint.

func setEndpoint(endpoint string) error {

// endpoint := "eu-vision.googleapis.com:443"

ctx := context.Background()

client, err := vision.NewImageAnnotatorClient(ctx, option.WithEndpoint(endpoint))

if err != nil {

return fmt.Errorf("NewImageAnnotatorClient: %w", err)

}

defer client.Close()

return nil

}

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida dell'API Vision che utilizza le librerie client. Per saperne di più, consulta la documentazione di riferimento di Vision API Java.

ImageAnnotatorSettings settings =

ImageAnnotatorSettings.newBuilder().setEndpoint("eu-vision.googleapis.com:443").build();

// Initialize client that will be used to send requests. This client only needs to be created

// once, and can be reused for multiple requests. After completing all of your requests, call

// the "close" method on the client to safely clean up any remaining background resources.

ImageAnnotatorClient client = ImageAnnotatorClient.create(settings);Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Node.js.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

// Imports the Google Cloud client library

const vision = require('@google-cloud/vision');

async function setEndpoint() {

// Specifies the location of the api endpoint

const clientOptions = {apiEndpoint: 'eu-vision.googleapis.com'};

// Creates a client

const client = new vision.ImageAnnotatorClient(clientOptions);

// Performs text detection on the image file

const [result] = await client.textDetection('./resources/wakeupcat.jpg');

const labels = result.textAnnotations;

console.log('Text:');

labels.forEach(label => console.log(label.description));

}

setEndpoint();Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Python.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

from google.cloud import vision

client_options = {"api_endpoint": "eu-vision.googleapis.com"}

client = vision.ImageAnnotatorClient(client_options=client_options)Prova

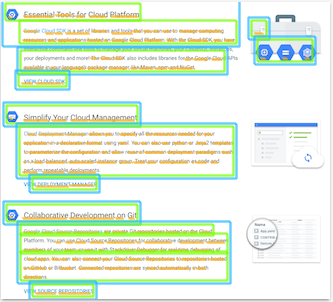

Prova il rilevamento del testo e il rilevamento del testo nei documenti di seguito. Puoi utilizzare l'immagine

già specificata (gs://cloud-samples-data/vision/ocr/sign.jpg) facendo clic su

Esegui oppure puoi specificare un'immagine personalizzata.

Per provare il rilevamento del testo del documento, aggiorna il valore di type a

DOCUMENT_TEXT_DETECTION.

Corpo della richiesta:

{

"requests": [

{

"features": [

{

"type": "TEXT_DETECTION"

}

],

"image": {

"source": {

"imageUri": "gs://cloud-samples-data/vision/ocr/sign.jpg"

}

}

}

]

}