Vision Warehouse는 개발자가 비정형 미디어 콘텐츠 (스트리밍 동영상, 이미지, 일괄 동영상)의 저장소 및 AI 기반 검색을 기존 도구 및 애플리케이션에 통합할 수 있는 API입니다.

Vision Warehouse는 Vertex AI Vision의 주요 구성요소입니다. 스토리지 저장소 역할을 하며 여러 데이터 유형과 사용 사례에 고급 검색 기능을 제공합니다. 구체적으로는 다음과 같습니다.

- 동영상 스트리밍: Vertex AI Vision 플랫폼 애플리케이션 또는 Vision Warehouse API를 사용하여 라이브 동영상 스트림 및 라이브 동영상 분석 데이터를 가져오고 Vision Warehouse API 또는 Google Cloud 콘솔을 사용하여 이미지를 검색할 수 있습니다.

- 이미지: Vision Warehouse API를 사용하여 이미지와 메타데이터를 가져오고, Vision Warehouse API를 사용하여 이미지를 분석하고, Vision Warehouse API 또는 Google Cloud 콘솔을 사용하여 이미지를 검색할 수 있습니다.

- 일괄 동영상: Vision Warehouse API를 사용하여 일괄 동영상 및 메타데이터를 가져오고, Vision Warehouse API를 사용하여 일괄 동영상을 분석하고, Vision Warehouse API 또는 Google Cloud 콘솔을 사용하여 일괄 동영상을 검색할 수 있습니다.

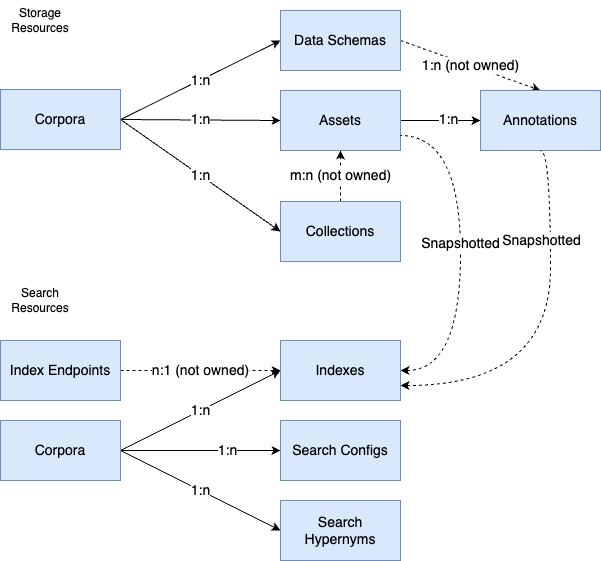

API 리소스 개요

Storage API 리소스

Corpus: 특정 유형의 미디어 애셋을 보유하는 컨테이너입니다. 여러 개의 자료 모음을 만들어 다양한 유형의 미디어 애셋을 구성할 수 있습니다.

애셋: 코퍼스 내에 저장된 미디어 객체입니다. 저작물은 이미지, 일괄 동영상 또는 동영상 스트림일 수 있습니다. 자료에는 일반적으로 동일한 유형의 저작물이 많이 포함되어 있습니다. 저작물과 연결된 주석을 지정할 수 있습니다. 저작물은 관리를 위해 컬렉션으로 그룹화할 수도 있습니다.

컬렉션: 저작물 참조의 컨테이너 역할을 하는 자료 내 리소스입니다.

주석: 저작물과 연결된 Vertex AI Vision에서 파생된 사용자 제공 메타데이터 또는 데이터입니다. 저작물에는 주석이 여러 개 있을 수 있습니다.

- 예 1: 일괄 동영상 저작물에 'video-title'이라는 텍스트 주석을 지정합니다.

- 예 2: Vertex AI Vision 모델에서 분석된 데이터를 주석으로 저장합니다. 예를 들어 여러 동영상 타임프레임의 객체 인식 라벨을 주석으로 저장할 수 있습니다.

데이터 스키마: 주석이 자료 내에서 해석되는 방식을 정의합니다. 데이터 스키마는 하나의 주석 유형과 검색 전략을 정의합니다. 각 주석은 데이터 스키마와 연결되어야 합니다.

Search API 리소스

색인 (이미지 및 일괄 동영상 카테고리에서 사용 가능): 분석된 확장 소재 및 주석의 관리형 표현인 자료 수준 리소스입니다. 색인은 미디어 콘텐츠의 의미를 나타내는 임베딩 벡터 및 시맨틱 제한의 데이터 세트로 볼 수 있습니다. 색인은 검색을 위해 색인 엔드포인트에 배포할 수 있습니다.

색인 엔드포인트 (이미지 및 일괄 동영상 카테고리에서 사용 가능): Vision 웨어하우스 색인을 제공하는 관리형 환경입니다. 색인 엔드포인트는 검색 요청을 전송하기 위한 단일 액세스 포인트를 제공합니다.

검색 구성: 검색 동작 및 검색 결과에 영향을 미치는 다양한 속성을 저장합니다.

- Facet 속성 (스트리밍 동영상 카테고리에 사용 가능): 측정기준 기반 히스토그램 검색 결과를 사용 설정하는 구성을 만듭니다.

- 검색 기준 속성 (스트리밍 동영상 및 일괄 동영상 카테고리에 사용 가능): 맞춤 검색 기준과 하나 이상의 데이터 스키마 키 간에 매핑을 만듭니다.

검색 상위어: 단어의 상위어를 인식하는 검색 서비스의 기능을 맞춤설정할 수 있는 특정 유형의 검색 구성입니다. 예를 들어 사용자는 '고양이'와 '강아지'의 상위 용어로 '동물'을 지정할 수 있습니다. 'animal'을 검색하면 색인 데이터에 'cat' 및 'dog'가 포함된 결과도 반환됩니다.

지원 언어

Batch 동영상 창고 및 이미지 창고는 시맨틱 검색을 위해 다음 언어를 지원합니다.

- 영어

- 스페인어

- 포르투갈어

- 프랑스어

- 일본어

- 중국어

Streaming Warehouse에는 언어 제한이 없습니다.

다음 단계

- 각 미디어 카테고리(스트리밍 동영상, 이미지, 일괄 동영상)의 주요 API 사용자 흐름을 이해합니다.

- Vision Warehouse 할당량 및 한도를 살펴보세요.

- 가격 책정을 숙지하세요.

- 지원을 받는 방법을 알아보세요.