El servicio de evaluación de IA generativa proporciona herramientas de nivel empresarial para realizar evaluaciones objetivas y basadas en datos de modelos de IA generativa. Admite e informa sobre varias tareas de desarrollo, como migraciones de modelos, edición de peticiones y ajuste.

Funciones del servicio de evaluación de la IA generativa

La característica definitoria del servicio de evaluación de IA generativa es la capacidad de usar rúbricas adaptativas, un conjunto de pruebas personalizadas para determinar si se supera o no cada petición. Las rúbricas de evaluación son similares a las pruebas unitarias en el desarrollo de software y tienen como objetivo mejorar el rendimiento de los modelos en diversas tareas.

El servicio de evaluación de IA generativa admite los siguientes métodos de evaluación habituales:

Rúbricas adaptativas (recomendado): genera un conjunto único de rúbricas de aprobado o suspenso para cada petición individual de tu conjunto de datos.

Rúbricas estáticas: aplica un conjunto fijo de criterios de puntuación a todas las peticiones.

Métricas basadas en cálculos: usa algoritmos deterministas como

ROUGEoBLEUcuando haya una verdad fundamental disponible.Funciones personalizadas: define tu propia lógica de evaluación en Python para requisitos especializados.

Generación de conjuntos de datos de evaluación

Puede crear un conjunto de datos de evaluación de las siguientes formas:

Sube un archivo que contenga instancias de peticiones completas o proporciona una plantilla de petición junto con un archivo de valores de variables correspondiente para rellenar las peticiones completas.

Toma muestras directamente de los registros de producción para evaluar el uso real de tu modelo.

Usa la generación de datos sintéticos para generar un gran número de ejemplos coherentes para cualquier plantilla de petición.

Interfaces admitidas

Puedes definir y ejecutar tus evaluaciones con las siguientes interfaces:

Google Cloud Consola: una interfaz de usuario web que proporciona un flujo de trabajo guiado de principio a fin. Gestiona tus conjuntos de datos, realiza evaluaciones y profundiza en informes y visualizaciones interactivos. Consulta Realizar una evaluación con la consola.

SDK de Python: ejecuta evaluaciones de forma programática y muestra comparaciones de modelos en paralelo directamente en tu entorno de Colab o Jupyter. Consulta Realizar evaluaciones con el cliente de IA generativa en el SDK de Vertex AI.

Casos prácticos

El servicio de evaluación de IA generativa te permite ver cómo se comporta un modelo en tus tareas específicas y en función de tus criterios únicos, lo que te proporciona información valiosa que no se puede obtener de las tablas de clasificación públicas ni de las comparativas generales. Esto permite llevar a cabo tareas de desarrollo críticas, como las siguientes:

Migraciones de modelos: compara versiones de modelos para identificar diferencias de comportamiento y ajustar tus peticiones y ajustes en consecuencia.

Encontrar el mejor modelo: compara directamente los modelos de Google y de terceros con tus datos para establecer una base de rendimiento e identificar el que mejor se adapte a tu caso práctico.

Mejora de las peticiones: usa los resultados de la evaluación para orientar tus esfuerzos de personalización. Volver a ejecutar una evaluación crea un bucle de retroalimentación ajustado que proporciona comentarios inmediatos y cuantificables sobre los cambios.

Ajuste de modelos: evalúa la calidad de un modelo ajustado aplicando criterios de evaluación coherentes a cada ejecución.

Evaluaciones con rúbricas adaptativas

Las rúbricas adaptativas son el método recomendado para la mayoría de los casos prácticos de evaluación y suelen ser la forma más rápida de empezar a usar las evaluaciones.

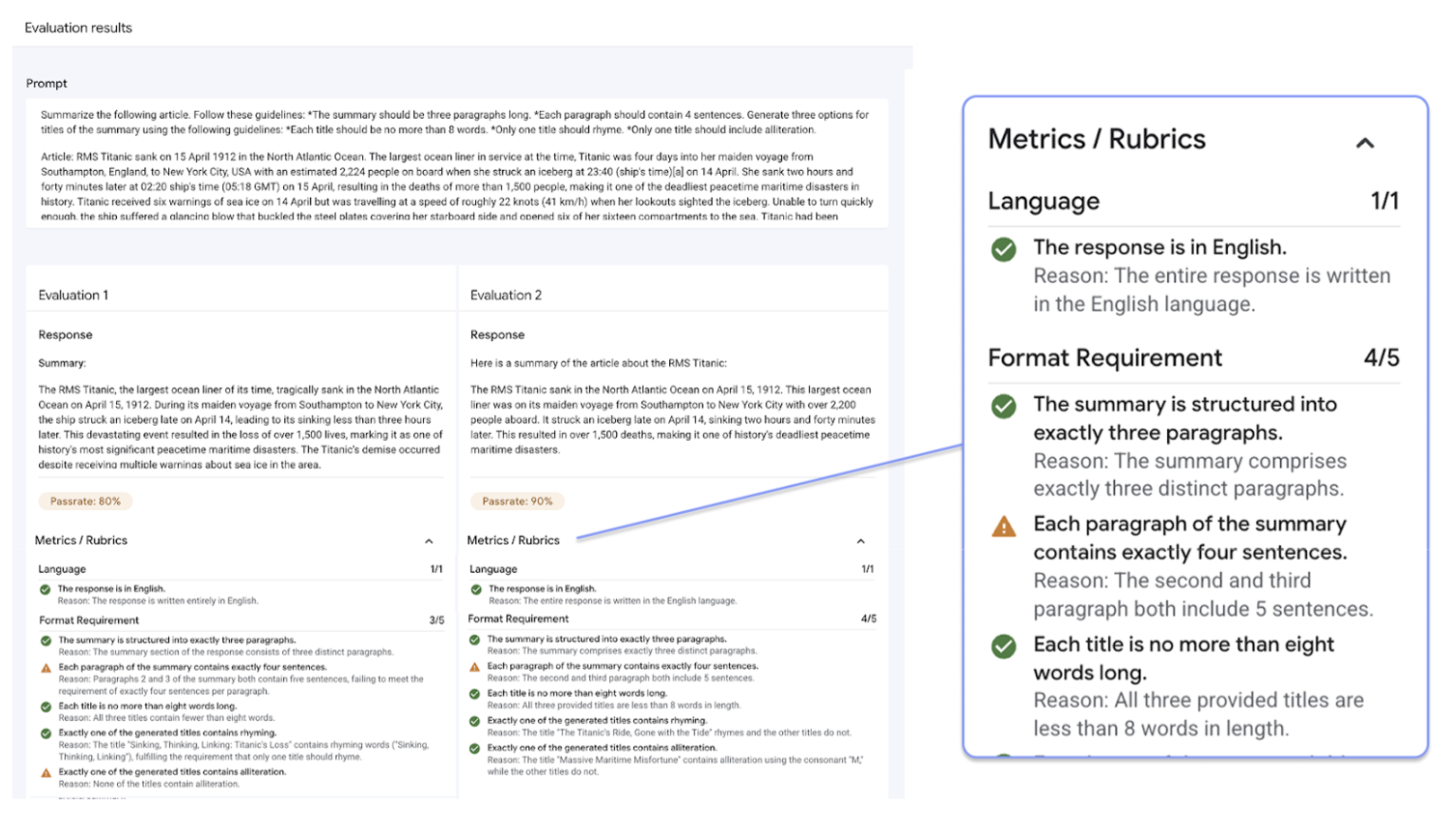

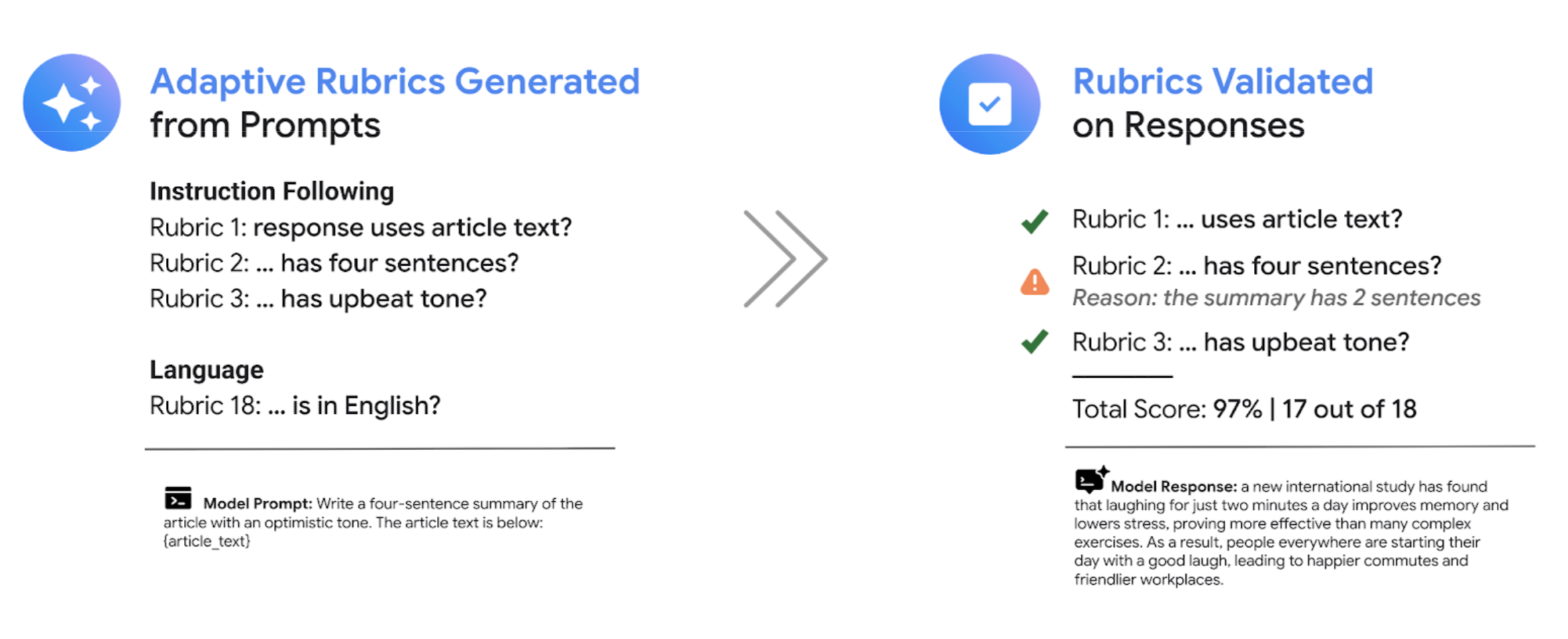

En lugar de usar un conjunto general de rúbricas de calificación, como la mayoría de los sistemas de LLMs como juez, el marco de evaluación basado en pruebas genera de forma adaptativa un conjunto único de rúbricas de aprobado o suspenso para cada petición individual de tu conjunto de datos. De esta forma, cada evaluación se adapta a la tarea específica que se está evaluando.

El proceso de evaluación de cada petición utiliza un sistema de dos pasos:

Generación de rúbricas: el servicio analiza primero tu petición y genera una lista de pruebas específicas y verificables (las rúbricas) que debe cumplir una buena respuesta.

Validación de la rúbrica: después de que el modelo genere una respuesta, el servicio la evalúa en función de cada rúbrica y ofrece un veredicto claro (

PassoFail) y una justificación.

El resultado final es una tasa de aprobaciones agregada y un desglose detallado de las rúbricas que ha aprobado el modelo, lo que le proporciona estadísticas útiles para diagnosticar problemas y medir mejoras.

Al pasar de puntuaciones subjetivas de alto nivel a resultados de pruebas objetivos y detallados, puedes adoptar un ciclo de desarrollo basado en la evaluación e incorporar las prácticas recomendadas de ingeniería de software al proceso de creación de aplicaciones de IA generativa.

Ejemplo de evaluación con rúbricas

Para entender cómo genera y usa rúbricas el servicio de evaluación de IA generativa, consulta este ejemplo:

Petición del usuario: Write a four-sentence summary of the provided article about renewable energy, maintaining an optimistic tone.

En esta petición, el paso de generación de rúbrica podría producir las siguientes rúbricas:

Rúbrica 1: la respuesta es un resumen del artículo proporcionado.

Rúbrica 2: la respuesta contiene exactamente cuatro frases.

Rúbrica 3: La respuesta mantiene un tono optimista.

Tu modelo puede generar la siguiente respuesta: The article highlights significant growth in solar and wind power. These advancements are making clean energy more affordable. The future looks bright for renewables. However, the report also notes challenges with grid infrastructure.

Durante la validación de la rúbrica, el servicio de evaluación de IA generativa evalúa la respuesta en función de cada rúbrica:

Rúbrica 1: la respuesta es un resumen del artículo proporcionado.

Resultado:

PassMotivo: la respuesta resume con precisión los puntos principales.

Rúbrica 2: la respuesta contiene exactamente cuatro frases.

Resultado:

PassMotivo: La respuesta se compone de cuatro frases distintas.

Rúbrica 3: La respuesta mantiene un tono optimista.

Resultado:

FailMotivo: la última frase introduce un punto negativo, lo que resta valor al tono optimista.

La tasa de aprobaciones final de esta respuesta es del 66,7%. Para comparar dos modelos, puedes evaluar sus respuestas con este mismo conjunto de pruebas generadas y comparar sus tasas de aprobaciones generales.

Flujo de trabajo de evaluación

Para completar una evaluación, normalmente hay que seguir estos pasos:

Crea un conjunto de datos de evaluación: reúne un conjunto de datos de instancias de peticiones que reflejen tu caso práctico específico. Puedes incluir respuestas de referencia (validadas en el terreno) si tienes previsto usar métricas basadas en cálculos.

Definir métricas de evaluación: elija las métricas que quiera usar para medir el rendimiento del modelo. El SDK admite todos los tipos de métricas, mientras que la consola admite rúbricas adaptativas.

Generar respuestas del modelo: selecciona uno o varios modelos para generar respuestas para tu conjunto de datos. El SDK admite cualquier modelo al que se pueda llamar mediante

LiteLLM, mientras que la consola admite los modelos de Google Gemini.Ejecutar la evaluación: ejecuta la tarea de evaluación, que compara las respuestas de cada modelo con las métricas que has seleccionado.

Interpretar los resultados: consulta las puntuaciones agregadas y las respuestas individuales para analizar el rendimiento del modelo.

Empezar a usar las evaluaciones

Puedes empezar a hacer evaluaciones con la consola.

También puedes usar el siguiente código para completar una evaluación con el cliente de IA generativa en el SDK de Vertex AI:

from vertexai import client

from vertexai import types

import pandas as pd

# Create an evaluation dataset

prompts_df = pd.DataFrame({

"prompt": [

"Write a simple story about a dinosaur",

"Generate a poem about Vertex AI",

],

})

# Get responses from one or multiple models

eval_dataset = client.evals.run_inference(model="gemini-2.5-flash", src=prompts_df)

# Define the evaluation metrics and run the evaluation job

eval_result = client.evals.evaluate(

dataset=eval_dataset,

metrics=[types.RubricMetric.GENERAL_QUALITY]

)

# View the evaluation results

eval_result.show()

El servicio de evaluación de IA generativa ofrece dos interfaces de SDK:

Cliente de IA generativa en el SDK de Vertex AI (recomendado) (vista previa)

from vertexai import clientEl cliente de IA generativa es la interfaz más reciente y recomendada para la evaluación, a la que se accede a través de la clase Client unificada. Admite todos los métodos de evaluación y está diseñado para flujos de trabajo que incluyen la comparación de modelos, la visualización en el cuaderno y las estadísticas para la personalización de modelos.

Módulo de evaluación del SDK de Vertex AI (disponibilidad general)

from vertexai.evaluation import EvalTaskEl módulo de evaluación es la interfaz antigua, que se mantiene para que sea retrocompatible con los flujos de trabajo actuales, pero ya no está en fase de desarrollo. Se accede a él a través de la clase

EvalTask. Este método admite métricas estándar basadas en LLMs y en cálculos, pero no admite métodos de evaluación más recientes, como las rúbricas adaptativas.