Valuta i modelli

Dopo l'addestramento di un modello, AutoML Translation utilizza il set TEST per

valutare la qualità e l'accuratezza del nuovo modello. AutoML Translation

esprime la qualità del modello utilizzando il punteggio BLEU (Bilingual Evaluation Understudy), che indica il grado di somiglianza tra il testo candidato e il testo di riferimento. Un valore del punteggio BLEU più vicino a 1 indica che una

traduzione è più vicina al testo di riferimento.

Usa questi dati per valutare l'idoneità del modello. Per migliorare la qualità del modello, valuta la possibilità di aggiungere altre coppie di segmenti di addestramento (più diverse). Dopo aver modificato il set di dati, addestra un nuovo modello utilizzando il set di dati migliorato.

Tieni presente che i punteggi BLEU non sono consigliati per il confronto tra corpus e lingue diversi. Ad esempio, un punteggio BLEU di 50 dall'inglese al tedesco non è paragonabile a un punteggio BLEU di 50 dal giapponese all'inglese. Molti esperti di traduzione sono passati ad approcci basati su metriche basate su modelli, che hanno una correlazione più elevata con le valutazioni umane e sono più granulari nell'identificazione degli scenari di errore.

AutoML Translation supporta solo i punteggi BLEU. Per valutare il modello di traduzione utilizzando metriche basate sul modello, consulta Gen AI evaluation service in Vertex AI.

Recupero della valutazione del modello

Vai alla console AutoML Translation.

Nel menu di navigazione, fai clic su Modelli per visualizzare un elenco dei tuoi modelli.

Fai clic sul modello da valutare.

Fai clic sulla scheda Addestra per visualizzare le metriche di valutazione del modello, ad esempio il punteggio BLEU.

Testare le previsioni del modello

Utilizzando la Google Cloud console, puoi confrontare i risultati di traduzione del tuo modello personalizzato con quelli del modello NMT predefinito.

Vai alla console AutoML Translation.

Nel menu di navigazione, fai clic su Modelli per visualizzare un elenco dei tuoi modelli.

Fai clic sul modello da testare.

Fai clic sulla scheda Prevedi.

Aggiungi il testo di input nella casella di testo della lingua di origine.

Fai clic su Traduci.

AutoML Translation mostra i risultati della traduzione per il modello personalizzato e per il modello NMT.

Valutare e confrontare i modelli utilizzando un nuovo set di test

Dalla console Google Cloud , puoi rivalutare i modelli esistenti utilizzando un nuovo set di dati di test. In una singola valutazione, puoi includere fino a 5 modelli diversi e confrontarne i risultati.

Carica i dati di test in Cloud Storage come valori separati da tabulazione (TSV) o come file Translation Memory eXchange (TMX).

AutoML Translation valuta i modelli in base al set di test e poi produce i punteggi di valutazione. Se vuoi, puoi salvare i risultati per ogni modello come file TSV in un bucket Cloud Storage, dove ogni riga ha il seguente formato:

Source segment tab Model candidate translation tab Reference translation

Vai alla console AutoML Translation.

Nel menu di navigazione, fai clic su Modelli per visualizzare un elenco dei tuoi modelli.

Fai clic sul modello da valutare.

Fai clic sulla scheda Valuta.

Nella scheda Valuta, fai clic su Nuova valutazione.

Seleziona i modelli che vuoi valutare e confrontare, poi fai clic su Avanti.

Il modello attuale deve essere selezionato e Google NMT è selezionato per impostazione predefinita, che puoi deselezionare.

Specifica un nome per il Set di test per distinguerlo da altre valutazioni, quindi seleziona il nuovo set di test da Cloud Storage.

Fai clic su Avanti.

Per esportare le previsioni, specifica una cartella di destinazione Cloud Storage.

Fai clic su Inizia valutazione.

Al termine della valutazione, AutoML Translation presenta i punteggi di valutazione in formato tabellare nella console. Puoi eseguire una sola valutazione alla volta. Se hai specificato una cartella in cui archiviare i risultati della previsione, AutoML Translation scrive in questa posizione file TSV denominati con l'ID modello associato, a cui viene aggiunto il nome del set di test.

Informazioni sul punteggio BLEU

BLEU (BiLingual Evaluation Understudy) è una metrica per la valutazione automatica del testo tradotto automaticamente. Il punteggio BLEU è un numero compreso tra zero e uno che misura la somiglianza del testo tradotto automaticamente con un insieme di traduzioni di riferimento di alta qualità. Un valore pari a 0 indica che l'output della traduzione automatica non presenta sovrapposizioni con la traduzione di riferimento (il che indica una qualità inferiore), mentre un valore pari a 1 indica una sovrapposizione perfetta con le traduzioni di riferimento (il che indica una qualità superiore).

AutoML Translation esprime i punteggi BLEU come percentuale anziché come numero decimale compreso tra 0 e 1.

Interpretazione

Come linea guida approssimativa, la seguente interpretazione dei punteggi BLEU (espressi in percentuali anziché in numeri decimali) potrebbe essere utile.

| Punteggio BLEU | Interpretazione |

|---|---|

| < 10 | Quasi inutile |

| 10-19 | Difficile capire il succo del discorso |

| 20 - 29 | Il succo del discorso è chiaro, ma contiene errori grammaticali significativi |

| 30 - 40 | Traduzioni comprensibili e di buona qualità |

| 40 - 50 | Traduzioni di alta qualità |

| 50 - 60 | Traduzioni di altissima qualità, adeguate e fluenti |

| > 60 | Qualità spesso migliore di quella umana |

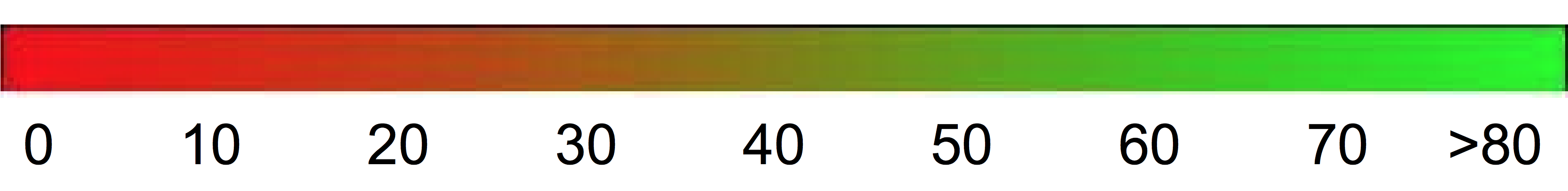

Il seguente gradiente di colore può essere utilizzato come scala generale di interpretazione del punteggio BLEU:

Dettagli matematici

Da punto di vista matematico, il punteggio BLEU è definito come segue:

grazie a

\[ precision_i = \dfrac{\sum_{\text{snt}\in\text{Cand-Corpus}}\sum_{i\in\text{snt}}\min(m^i_{cand}, m^i_{ref})} {w_t^i = \sum_{\text{snt'}\in\text{Cand-Corpus}}\sum_{i'\in\text{snt'}} m^{i'}_{cand}} \]

dove

- \(m_{cand}^i\hphantom{xi}\) è il conteggio dell'i-gram nella corrispondenza del candidato con la traduzione di riferimento

- \(m_{ref}^i\hphantom{xxx}\) è il conteggio di i-gram nella traduzione di riferimento

- \(w_t^i\hphantom{m_{max}}\) è il numero totale di i-grammi nella traduzione candidata

La formula è composta da due parti: la penalità per brevità e la sovrapposizione di n-grammi.

Penalità per brevità

La penalità per brevità penalizza le traduzioni generate troppo brevi rispetto alla lunghezza di riferimento più vicina con un decadimento esponenziale. La penalità per brevità compensa il fatto che il punteggio BLEU non ha un termine di richiamo.Sovrapposizione di n-grammi

La sovrapposizione di n-grammi conta quanti unigrammi, bigrammi, trigrammi e quadrigrammi (i=1,...,4) corrispondono al loro n-gramma omologo nelle traduzioni di riferimento. Questo termine funge da metrica di precisione. Gli unigrammi tengono conto dell'adeguatezza, mentre gli n-grammi più lunghi tengono conto della fluidità della traduzione. Per evitare conteggi eccessivi, i conteggi degli n-grammi vengono troncati al conteggio massimo degli n-grammi che si verifica nel riferimento (\(m_{ref}^n\)).

Esempi

Calcolo in corso \(precision_1\)

Considera questa frase di riferimento e la traduzione candidata:

Riferimento: the cat is on the mat

Candidato: the the the cat mat

Il primo passaggio consiste nel conteggio delle occorrenze di ogni unigramma nel riferimento e nel candidato. Tieni presente che la metrica BLEU è sensibile alle maiuscole.

| Unigram | \(m_{cand}^i\hphantom{xi}\) | \(m_{ref}^i\hphantom{xxx}\) | \(\min(m^i_{cand}, m^i_{ref})\) |

|---|---|---|---|

the |

3 | 2 | 2 |

cat |

1 | 1 | 1 |

is |

0 | 1 | 0 |

on |

0 | 1 | 0 |

mat |

1 | 1 | 1 |

Il numero totale di unigrammi nel candidato (\(w_t^1\)) è 5, quindi \(precision_1\) = (2 + 1 + 1)/5 = 0,8.

Calcolo del punteggio BLEU

Reference:

The NASA Opportunity rover is battling a massive dust storm on Mars .

Candidate 1:

The Opportunity rover is combating a big sandstorm on Mars .

Candidate 2:

A NASA rover is fighting a massive storm on Mars .

L'esempio precedente è costituito da un unico riferimento e due traduzioni candidate. Le frasi vengono suddivise in token prima del calcolo del punteggio BLEU, come illustrato sopra; ad esempio, il punto finale viene conteggiato come token separato.

Per calcolare il punteggio BLEU per ogni traduzione, calcoliamo le seguenti statistiche.

- Precisioni n-grammi

La tabella seguente contiene le precisioni n-grammi per entrambi i candidati. - Brevity-Penalty

La brevità-penalty è la stessa per il candidato 1 e il candidato 2, poiché entrambe le frasi sono composte da 11 token. - Punteggio BLEU

Tieni presente che è necessario almeno un 4-gramma corrispondente per ottenere un punteggio BLEU > 0. Poiché la traduzione candidata 1 non ha 4-grammi corrispondenti, il suo punteggio BLEU è 0.

| Metrica | Candidato 1 | Candidato 2 |

|---|---|---|

| \(precision_1\) (1 grammo) | 8/11 | 11/9 |

| \(precision_2\) (2 grammi) | 4/10 | 5/10 |

| \(precision_3\) (3 grammi) | 2/9 | 2/9 |

| \(precision_4\) (4 grammi) | 0/8 | 1/8 |

| Brevity-Penalty | 0,83 | 0,83 |

| Punteggio BLEU | 0,0 | 0,27 |

Proprietà

BLEU è una metrica basata sul corpus

La metrica BLEU ha un rendimento scarso se utilizzata per valutare singole frasi. Ad esempio, entrambe le frasi di esempio ottengono punteggi BLEU molto bassi anche se trasmettono la maggior parte del significato. Poiché le statistiche n-grammi per le singole frasi sono meno significative, BLEU è per progettazione una metrica basata sul corpus, ovvero le statistiche vengono accumulate su un intero corpus durante il calcolo del punteggio. Tieni presente che la metrica BLEU definita sopra non può essere fattorizzata per le singole frasi.Nessuna distinzione tra parole di contenuto e funzionali

La metrica BLEU non distingue tra parole di contenuto e funzionali, ovvero una parola funzionale omessa come "un" riceve la stessa penalità di se il nome "NASA" fosse erroneamente sostituito con "ESA".Non è in grado di cogliere il significato e la correttezza grammaticale di una frase

L'omissione di una sola parola, come "non", può cambiare la polarità di una frase. Inoltre, se si prendono in considerazione solo gli n-grammi con n≤4, le dipendenze a lungo raggio vengono ignorate e quindi BLEU spesso impone solo una piccola penalità per le frasi non grammaticali.Normalizzazione e tokenizzazione

Prima di calcolare il punteggio BLEU, le traduzioni di riferimento e candidate vengono normalizzate e tokenizzate. La scelta dei passaggi di normalizzazione e tokenizzazione influisce in modo significativo sul punteggio BLEU finale.