TPU v3

Este documento descreve a arquitetura e as configurações compatíveis do Cloud TPU v3.

arquitetura do sistema.

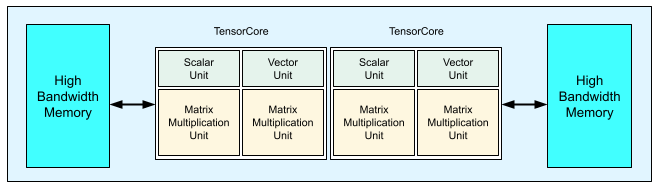

Cada chip de TPU v3 contém dois TensorCores. Cada TensorCore tem duas unidades de multiplicação de matriz (MXUs), uma unidade vetorial e uma escalar. A tabela a seguir mostra as principais especificações e os valores de um pod da TPU v3.

| Principais especificações | Valores do pod v3 |

|---|---|

| Pico de computação por chip | 123 teraflops (bf16) |

| Capacidade e largura de banda da HBM2 | 32 GiB, 900 GBps |

| Potência mínima/média/máxima medida | 123/220/262 W |

| Tamanho do pod da TPU | 1.024 chips |

| Topologia de interconexão | Toroide 2D |

| Tempo de computação máximo por pod | 126 petaflops (bf16) |

| Largura de banda de redução total por pod | 340 TB/s |

| Largura de banda de bisection por pod | 6,4 TB/s |

O diagrama a seguir ilustra um chip TPU v3.

Os detalhes de arquitetura e as características de desempenho da TPU v3 estão disponíveis em Um supercomputador específico para domínios para treinamento de redes neurais profundas.

Benefícios de desempenho da TPU v3 em relação à v2

O aumento de FLOPS por TensorCore e capacidade de memória nas configurações da TPU v3 pode melhorar o desempenho dos seus modelos das seguintes maneiras:

As configurações da TPU v3 oferecem benefícios de desempenho significativos por TensorCore para modelos vinculados à computação. Os modelos limitados à memória nas configurações da TPU v2 podem não alcançar essa mesma melhoria de desempenho se eles também estiverem limitados à memória nas configurações da TPU v3.

Nos casos em que os dados não cabem na memória nas configurações da TPU v2, a TPU v3 pode melhorar o desempenho e reduzir a necessidade de recalcular valores intermediários (rematerialização).

As configurações da TPU v3 executam novos modelos com tamanhos de lotes que não cabem nas configurações da TPU v2. Por exemplo, a TPU v3 pode permitir modelos ResNet mais profundos e imagens maiores com o RetinaNet.

Os modelos que são quase limitados à entrada ("alimentação") na TPU v2, porque as etapas de treinamento estão aguardando pela entrada, também podem ficar limitados à entrada no Cloud TPU v3. O guia de desempenho do pipeline pode ajudar você a resolver problemas de alimentação.

Configurações

Um pod de TPU v3 é composto por 1.024 chips interconectados por links de alta velocidade. Para

criar um dispositivo ou uma fração de TPU v3, use a flag --accelerator-type

no comando de criação de TPU (gcloud compute tpus tpu-vm). Especifique o tipo de acelerador especificando a

versão e o número de núcleos de TPU. Por exemplo, para uma única TPU v3, use

--accelerator-type=v3-8. Para uma fatia v3 com 128 TensorCores, use

--accelerator-type=v3-128.

A tabela a seguir lista os tipos de TPU v3 compatíveis:

| Versão da TPU | Fim da compatibilidade |

|---|---|

| v3-8 | (data final ainda não definida) |

| v3-32 | (data final ainda não definida) |

| v3-128 | (data final ainda não definida) |

| v3-256 | (data final ainda não definida) |

| v3-512 | (data final ainda não definida) |

| v3-1024 | (data final ainda não definida) |

| v3-2048 | (data final ainda não definida) |

O comando a seguir mostra como criar uma fatia de TPU v3 com 128 TensorCores:

$ gcloud compute tpus tpu-vm create tpu-name \ --zone=europe-west4-a \ --accelerator-type=v3-128 \ --version=tpu-ubuntu2204-base

Para mais informações sobre como gerenciar TPUs, consulte Gerenciar TPUs. Para mais informações sobre a arquitetura do sistema do Cloud TPU, consulte Arquitetura do sistema.