TPU v3

Dokumen ini menjelaskan arsitektur dan konfigurasi yang didukung dari Cloud TPU v3.

Arsitektur sistem

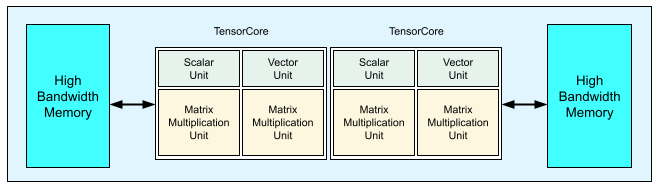

Setiap chip TPU v3 berisi dua TensorCore. Setiap TensorCore memiliki dua unit perkalian matriks (MXU), unit vektor, dan unit skalar. Tabel berikut menampilkan spesifikasi utama dan nilainya untuk Pod TPU v3.

| Spesifikasi utama | Nilai Pod v3 |

|---|---|

| Komputasi puncak per chip | 123 teraflop (bf16) |

| Kapasitas dan bandwidth HBM2 | 32 GiB, 900 GBps |

| Daya min/rata-rata/maks yang diukur | 123/220/262 W |

| Ukuran Pod TPU | 1.024 chip |

| Topologi interkoneksi | Torus 2D |

| Komputasi puncak per Pod | 126 petaflop (bf16) |

| Bandwidth all-reduce per Pod | 340 TB/dtk |

| Bandwidth bisection per Pod | 6,4 TB/dtk |

Diagram berikut mengilustrasikan chip TPU v3.

Detail arsitektur dan karakteristik performa TPU v3 tersedia di Superkomputer Khusus Domain untuk Melatih Jaringan Saraf Dalam.

Manfaat performa TPU v3 dibandingkan v2

Peningkatan FLOPS per TensorCore dan kapasitas memori dalam konfigurasi TPU v3 dapat meningkatkan performa model Anda dengan cara berikut:

Konfigurasi TPU v3 memberikan manfaat performa yang signifikan per TensorCore untuk model yang terikat komputasi. Model yang terikat memori pada konfigurasi TPU v2 mungkin tidak mencapai peningkatan performa yang sama jika juga terikat memori pada konfigurasi TPU v3.

Jika data tidak sesuai dengan memori pada konfigurasi TPU v2, TPU v3 dapat memberikan performa yang lebih baik dan mengurangi komputasi ulang nilai perantara (rematerialisasi).

Konfigurasi TPU v3 dapat menjalankan model baru dengan ukuran batch yang tidak sesuai dengan konfigurasi TPU v2. Misalnya, TPU v3 mungkin mengizinkan model ResNet yang lebih dalam dan gambar yang lebih besar dengan RetinaNet.

Model yang hampir terikat input ("infeed") di TPU v2 karena langkah pelatihan menunggu input mungkin juga terikat input dengan Cloud TPU v3. Panduan performa pipeline dapat membantu Anda menyelesaikan masalah infeed.

Konfigurasi

Pod TPU v3 terdiri dari 1.024 chip yang saling terhubung dengan link berkecepatan tinggi. Untuk membuat perangkat atau slice TPU v3, gunakan flag --accelerator-type dalam perintah pembuatan TPU (gcloud compute tpus tpu-vm). Anda menentukan jenis akselerator dengan menentukan versi TPU dan jumlah core TPU. Misalnya, untuk satu TPU v3, gunakan

--accelerator-type=v3-8. Untuk slice v3 dengan 128 TensorCore, gunakan

--accelerator-type=v3-128.

Tabel berikut mencantumkan jenis TPU v3 yang didukung:

| Versi TPU | Dukungan berakhir |

|---|---|

| v3-8 | (Tanggal akhir belum ditetapkan) |

| v3-32 | (Tanggal akhir belum ditetapkan) |

| v3-128 | (Tanggal akhir belum ditetapkan) |

| v3-256 | (Tanggal akhir belum ditetapkan) |

| v3-512 | (Tanggal akhir belum ditetapkan) |

| v3-1024 | (Tanggal akhir belum ditetapkan) |

| v3-2048 | (Tanggal akhir belum ditetapkan) |

Perintah berikut menunjukkan cara membuat slice TPU v3 dengan 128 TensorCore:

$ gcloud compute tpus tpu-vm create tpu-name \ --zone=europe-west4-a \ --accelerator-type=v3-128 \ --version=tpu-ubuntu2204-base

Untuk informasi selengkapnya tentang cara mengelola TPU, lihat Mengelola TPU. Untuk mengetahui informasi selengkapnya tentang arsitektur sistem Cloud TPU, lihat Arsitektur sistem.