Document AI는 프로세서의 예측 성능을 결정하는 데 도움이 되도록 평가 측정항목(예: 정밀도, 재현율)을 생성합니다.

이러한 평가 측정항목은 프로세서에서 반환된 항목 (예측)을 테스트 문서의 주석과 비교하여 생성됩니다. 프로세서에 테스트 세트가 없는 경우 먼저 데이터 세트를 만들고 테스트 문서에 라벨을 지정해야 합니다.

평가 실행

프로세서 버전을 학습시키거나 업데이트할 때마다 평가가 자동으로 실행됩니다.

평가를 수동으로 실행할 수도 있습니다. 테스트 세트를 수정한 후 또는 사전 학습된 프로세서 버전을 평가하는 경우 업데이트된 측정항목을 생성해야 합니다.

웹 UI

Google Cloud 콘솔에서 프로세서 페이지로 이동하여 프로세서를 선택합니다.

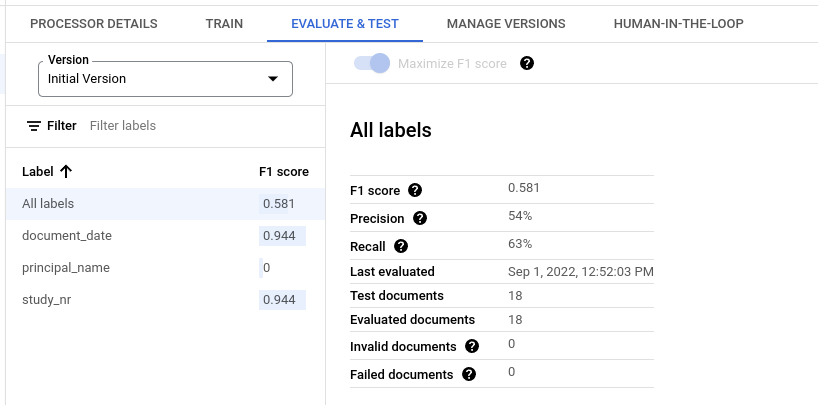

평가 및 테스트 탭에서 평가할 프로세서의 버전을 선택한 다음 새 평가 실행을 클릭합니다.

완료되면 페이지에 모든 라벨과 각 개별 라벨의 평가 측정항목이 표시됩니다.

Python

자세한 내용은 Document AI Python API 참고 문서를 참고하세요.

Document AI에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 로컬 개발 환경의 인증 설정을 참조하세요.

평가 결과 가져오기

웹 UI

Google Cloud 콘솔에서 프로세서 페이지로 이동하여 프로세서를 선택합니다.

평가 및 테스트 탭에서 평가를 확인할 프로세서의 버전을 선택합니다.

완료되면 페이지에 모든 라벨과 각 개별 라벨의 평가 측정항목이 표시됩니다.

Python

자세한 내용은 Document AI Python API 참고 문서를 참고하세요.

Document AI에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 로컬 개발 환경의 인증 설정을 참조하세요.

프로세서 버전의 모든 평가 나열

Python

자세한 내용은 Document AI Python API 참고 문서를 참고하세요.

Document AI에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 로컬 개발 환경의 인증 설정을 참조하세요.

모든 라벨의 평가 측정항목

모든 라벨의 측정항목은 모든 라벨에 걸쳐 데이터 세트의 참양성, 거짓양성, 거짓음성 수를 기반으로 계산되므로 데이터 세트에 각 라벨이 표시되는 횟수에 따라 가중치가 부여됩니다. 이러한 용어의 정의는 개별 라벨의 평가 측정항목을 참고하세요.

정밀도: 테스트 세트의 주석과 일치하는 예측의 비율입니다.

True Positives / (True Positives + False Positives)로 정의됩니다.재현율: 테스트 세트에서 올바르게 예측된 주석의 비율입니다.

True Positives / (True Positives + False Negatives)로 정의됩니다.F1 점수: 정밀도와 재현율의 조화 평균으로, 정밀도와 재현율을 단일 측정항목으로 결합하여 두 항목에 동일한 가중치를 부여합니다.

2 * (Precision * Recall) / (Precision + Recall)로 정의됩니다.

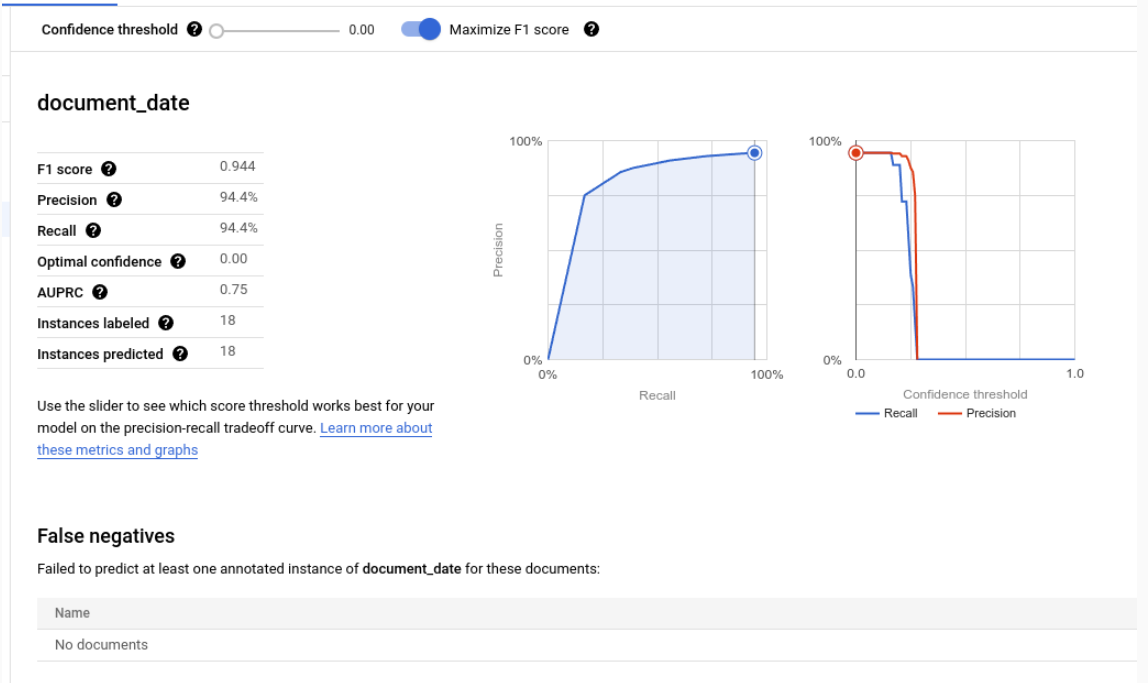

개별 라벨의 평가 측정항목

참양성: 테스트 문서의 주석과 일치하는 예측된 항목입니다. 자세한 내용은 일치 동작을 참고하세요.

거짓양성: 테스트 문서의 주석과 일치하지 않는 예측된 항목입니다.

거짓 음성: 예측된 항목과 일치하지 않는 테스트 문서의 주석입니다.

- 거짓 음성 (임계값 미만): 예측된 항목과 일치했을 수 있지만 예측된 항목의 신뢰도 값이 지정된 신뢰도 임계값 미만인 테스트 문서의 주석입니다.

신뢰도 기준

평가 로직은 예측이 올바르더라도 지정된 신뢰도 임계값 미만의 신뢰도를 갖는 예측을 무시합니다. Document AI는 신뢰도 임곗값이 더 낮게 설정된 경우 일치하는 주석인 거짓음성 (임곗값 미만) 목록을 제공합니다.

Document AI는 F1 점수를 극대화하는 최적의 임곗값을 자동으로 계산하고 기본적으로 신뢰도 임곗값을 이 최적의 값으로 설정합니다.

슬라이더 막대를 이동하여 원하는 신뢰도 임곗값을 선택할 수 있습니다. 일반적으로 신뢰도 기준점이 높을수록 다음과 같은 결과가 나타납니다.

- 예측이 올바를 가능성이 높기 때문에 정밀도가 높아집니다.

- 예측이 적기 때문에 재현율이 낮습니다.

표 형식 항목

상위 라벨의 측정항목은 하위 측정항목을 직접 평균하여 계산하는 것이 아니라 상위 라벨의 신뢰도 기준을 모든 하위 라벨에 적용하고 결과를 집계하여 계산합니다.

상위 항목의 최적 임곗값은 모든 하위 항목에 적용했을 때 상위 항목의 F1 점수가 최대가 되는 신뢰도 임곗값입니다.

일치 동작

예측된 항목은 다음과 같은 경우 주석과 일치합니다.

- 예측된 항목의 유형(

entity.type)이 주석의 라벨 이름과 일치합니다. - 예측된 항목의 값(

entity.mention_text또는entity.normalized_value.text)이 주석의 텍스트 값과 일치합니다(퍼지 일치가 사용 설정된 경우).

유형과 텍스트 값만 일치에 사용됩니다. 텍스트 앵커, 경계 상자 (아래에 설명된 표 형식 항목 제외)와 같은 기타 정보는 사용되지 않습니다.

단일 발생 라벨과 다중 발생 라벨

단일 발생 라벨은 값이 동일한 문서에 여러 번 주석 처리되더라도 (예: 인보이스 ID가 동일한 문서의 모든 페이지에 표시됨) 문서당 하나의 값을 갖습니다 (예: 인보이스 ID). 여러 주석의 텍스트가 다르더라도 동일한 것으로 간주됩니다. 즉, 예측된 항목이 주석 중 하나와 일치하면 일치로 간주됩니다. 추가 주석은 중복 멘션으로 간주되며 참양성, 거짓양성 또는 거짓음성 수에 반영되지 않습니다.

다중 발생 라벨은 서로 다른 값을 여러 개 가질 수 있습니다. 따라서 예측된 각 항목과 주석은 별도로 고려되고 일치됩니다. 문서에 다중 발생 라벨에 대한 주석이 N개 포함된 경우 예측된 항목과 일치하는 항목이 N개 있을 수 있습니다. 각 예측된 항목과 주석은 참양성, 거짓양성 또는 거짓음성으로 독립적으로 계산됩니다.

퍼지 일치

유사 검색 전환 버튼을 사용하면 일치하는 항목 수를 줄이거나 늘리도록 일부 일치 규칙을 강화하거나 완화할 수 있습니다.

예를 들어 퍼지 일치 없이는 대소문자로 인해 문자열 ABC이 abc과 일치하지 않습니다. 하지만 퍼지 일치를 사용하면 일치합니다.

퍼지 일치를 사용 설정하면 다음과 같이 규칙이 변경됩니다.

공백 정규화: 선행-후행 공백을 삭제하고 연속된 중간 공백 (줄바꿈 포함)을 단일 공백으로 압축합니다.

선행/후행 구두점 삭제: 다음 선행-후행 구두점 문자

!,.:;-"?|를 삭제합니다.대소문자 구분 없는 일치: 모든 문자를 소문자로 변환합니다.

금액 정규화: 데이터 유형이

money인 라벨의 경우 선행 및 후행 통화 기호를 삭제합니다.

표 형식 항목

상위 항목과 주석에는 텍스트 값이 없으며 하위 항목의 결합된 경계 상자를 기반으로 일치됩니다. 예측된 상위 요소가 하나이고 주석이 지정된 상위 요소가 하나인 경우 경계 상자에 관계없이 자동으로 일치됩니다.

부모가 일치되면 자녀는 표 형식 외 항목인 것처럼 일치됩니다. 부모가 일치하지 않으면 Document AI는 자녀를 일치시키려고 시도하지 않습니다. 즉, 상위 항목이 일치하지 않으면 텍스트 콘텐츠가 동일하더라도 하위 항목이 잘못된 것으로 간주될 수 있습니다.

상위 / 하위 항목은 미리보기 기능이며 중첩이 한 레이어인 표에만 지원됩니다.

평가 측정항목 내보내기

Google Cloud 콘솔에서 프로세서 페이지로 이동하여 프로세서를 선택합니다.

평가 및 테스트 탭에서 측정항목 다운로드를 클릭하여 평가 측정항목을 JSON 파일로 다운로드합니다.