En esta guía, se muestra cómo usar la protección de datos sensibles para inspeccionar una tabla de BigQuery y enviar los resultados de la inspección a Data Catalog.

Además, puedes realizar la creación de perfiles de datos, que es diferente de una operación de inspección. También puedes enviar perfiles de datos a Dataplex. Para obtener más información, consulta Etiqueta tablas en Dataplex basadas en estadísticas de los perfiles de datos.

Data Catalog es un servicio escalable de administración de metadatos que te permite descubrir, administrar y comprender con rapidez todos tus datos en Google Cloud.

La protección de datos sensibles tiene integración integrada en Data Catalog. Cuando usas una acción de protección de datos sensibles para inspeccionar tus tablas de BigQuery en busca de datos sensibles, esta puede enviar los resultados de forma directa a Data Catalog en forma de plantilla de etiqueta.

Si completas los pasos de esta guía, realizarás las siguientes acciones:

- Habilita Data Catalog y la protección de datos sensibles.

- Configurar la protección de datos sensibles para inspeccionar una tabla de BigQuery

- Configurar una inspección de protección de datos sensibles para enviar resultados de inspección a Data Catalog

Para obtener más información sobre Data Catalog, consulta la documentación de Data Catalog.

Si quieres enviar los resultados de las operaciones de creación de perfiles de datos (no de trabajos de inspección) a Dataplex, consulta la documentación para generar perfiles de una organización, una carpeta o un proyecto.

Costos

En este documento, usarás los siguientes componentes facturables de Google Cloud:

- Sensitive Data Protection

- BigQuery

Para generar una estimación de costos en función del uso previsto, usa la calculadora de precios.

Antes de comenzar

Antes de enviar los resultados de la inspección de la protección de datos sensibles a Data Catalog, haz lo siguiente:

- Paso 1: Configura la facturación

- Paso 2: Crea un proyecto nuevo y propaga una tabla de BigQuery nueva (Opcional)

- Paso 3: Habilita Data Catalog

- Paso 4: Habilita la protección de datos sensibles.

Las siguientes subsecciones abarcan cada paso en detalle.

Paso 1: Configura la facturación

Si aún no tienes una, primero debes configurar una cuenta de facturación.

Aprende a habilitar la facturación

Paso 2: Crea un proyecto nuevo y propaga una tabla de BigQuery nueva (opcional)

Si configuras esta función para el trabajo de producción o ya tienes una tabla de BigQuery que deseas inspeccionar, abre el proyecto de Google Cloud que contiene la tabla y continúa con el paso 3.

Si pruebas esta función y quieres inspeccionar los datos de prueba, crea un proyecto nuevo. Para completar este paso, debes tener la función de Creador de proyectos de IAM. Obtén más información sobre las funciones de IAM.

- Ve a la página Proyecto nuevo en la consola de Google Cloud.

- En la lista desplegable Cuenta de facturación, selecciona la cuenta de facturación en la que se debe facturar el proyecto.

- En la lista desplegable Organización, selecciona la organización en la que deseas crear el proyecto.

- En la lista desplegable Ubicación, selecciona la organización o la carpeta en la que deseas crear el proyecto.

- Haz clic en Crear para crear el proyecto.

A continuación, descarga y almacena los datos de muestra:

- Ve al repositorio de instructivos de Cloud Functions en GitHub.

- Selecciona uno de los archivos CSV que contenga datos de ejemplo y, luego, descarga el archivo.

- A continuación, ve a BigQuery en la consola de Google Cloud.

- Elige tu proyecto.

- Haz clic en Crear conjunto de datos.

- Haz clic en Crear tabla.

- Haz clic en Subir y, luego, selecciona el archivo que deseas subir.

- Asígnale un nombre a la tabla y, luego, haz clic en Crear tabla.

Paso 3: Habilita Data Catalog

A continuación, habilita Data Catalog para el proyecto que contiene la tabla de BigQuery que deseas inspeccionar mediante la protección de datos sensibles.

Para habilitar Data Catalog con la consola de Google Cloud, sigue estos pasos:

- Registra tu aplicación en Data Catalog.

- En la página de registro, en la lista desplegable Crear un proyecto, selecciona el proyecto que deseas usar con Data Catalog.

- Después de seleccionar el proyecto, haz clic en Continuar.

Data Catalog ya se encuentra habilitado para tu proyecto.

Paso 4: Habilita la protección de datos sensibles

Habilita la protección de datos sensibles en el mismo proyecto para el que habilitaste Data Catalog.

Para habilitar la protección de datos sensibles con la consola de Google Cloud, sigue estos pasos:

- Registra tu solicitud para la Protección de datos sensibles.

- En la página de registro, en la lista desplegable Crear un proyecto, selecciona el mismo proyecto que elegiste en el paso anterior.

- Después de seleccionar el proyecto, haz clic en Continuar.

Se habilitó la protección de datos sensibles en tu proyecto.

Configura y ejecuta un trabajo de inspección de protección de datos sensibles

Puedes configurar y ejecutar un trabajo de inspección de protección de datos sensibles mediante la consola de Google Cloud o la API de DLP.

Las plantillas de etiquetas de Data Catalog se almacenan en el mismo proyecto y la misma región que la tabla de BigQuery. Si inspeccionas una tabla de otro proyecto, debes otorgar la función de propietario de TagTemplate de Data Catalog (roles/datacatalog.tagTemplateOwner) al agente de servicio de protección de datos sensibles en el proyecto en el que existe la tabla de BigQuery.

Consola de Google Cloud

Para configurar un trabajo de inspección de una tabla de BigQuery con la protección de datos sensibles, haz lo siguiente:

En la sección Protección de datos sensibles de la consola de Google Cloud, ve a la página Crear trabajo o activador de trabajo.

Ingresa la información del trabajo de protección de datos sensibles y haz clic en Continuar para completar cada paso:

En el Paso 1: Elige los datos de entrada, asígnale un nombre al trabajo mediante el ingreso de un valor en el campo Nombre. En Ubicación, elige BigQuery en el menú Tipo de almacenamiento y, luego, ingresa la información de la tabla que se inspeccionará. La sección Muestreo está preconfigurada para ejecutar una inspección de muestra con tus datos. Puedes ajustar los campos Limitar filas por y Cantidad máxima de filas para ahorrar recursos si tienes una gran cantidad de datos. Para obtener más detalles, consulta Elige los datos de entrada.

(Opcional) En el Paso 2: Configura la detección, puedes configurar qué tipos de datos buscar, llamados “infoTypes”. Para los fines de esta explicación, mantén seleccionados los Infotipos predeterminados. Para obtener más detalles, consulta Configura la detección.

En Paso 3: Agrega acciones, habilita Guardar en Data Catalog.

En el Paso 4: Programa, para los fines de esta explicación, deja el menú establecido en Ninguno a fin de que la inspección se ejecute solo una vez (opcional). Para obtener más información sobre cómo programar trabajos de inspección recurrentes, consulta Programa.

Haz clic en Crear. El trabajo se ejecuta de inmediato.

API de DLP

En esta sección, configurarás y ejecutarás un trabajo de inspección de protección de datos sensibles.

El trabajo de inspección que configures aquí le indicará a la protección de datos sensibles que inspeccione los datos de muestra de BigQuery descritos en el Paso 2 o tus propios datos de BigQuery. En la configuración del trabajo que especificas, también le indicas a la protección de datos sensibles que guarde los resultados de la inspección en Data Catalog.

Paso 1: Anota tu identificador de proyecto

Ve a la consola de Google Cloud.

Ve a la consola de Google Cloud.

Haz clic en Seleccionar.

En la lista desplegable Seleccionar de, selecciona la organización para la que habilitaste Data Catalog.

En ID, copia el ID del proyecto que contiene los datos que deseas inspeccionar. Este es el proyecto que se describe en el paso previo de esta página, Configura repositorios de almacenamiento.

En Nombre, haz clic en el proyecto para seleccionarlo.

Paso 2: Abre el Explorador de API y configura el trabajo

Ve al Explorador de API en la página de referencia del método

dlpJobs.create. Para mantener estas instrucciones disponibles, haz clic con el botón derecho en el siguiente vínculo y ábrelo en una pestaña o una ventana nueva:En el cuadro parent, ingresa lo siguiente, en el que project-id es el ID del proyecto que anotaste en el paso anterior:

projects/project-id

A continuación, copia el siguiente JSON. Selecciona el contenido del campo Cuerpo de la solicitud en el Explorador de API y, luego, pega el JSON para reemplazar el contenido. Asegúrate de reemplazar los marcadores de posición

project-id,bigquery-dataset-nameybigquery-table-namepor el ID del proyecto y los nombres del conjunto de datos y la tabla de BigQuery reales, respectivamente.{ "inspectJob": { "storageConfig": { "bigQueryOptions": { "tableReference": { "projectId": "project-id", "datasetId": "bigquery-dataset-name", "tableId": "bigquery-table-name" } } }, "inspectConfig": { "infoTypes": [ { "name": "EMAIL_ADDRESS" }, { "name": "PERSON_NAME" }, { "name": "US_SOCIAL_SECURITY_NUMBER" }, { "name": "PHONE_NUMBER" } ], "includeQuote": true, "minLikelihood": "UNLIKELY", "limits": { "maxFindingsPerRequest": 100 } }, "actions": [ { "publishFindingsToCloudDataCatalog": {} } ] } }

Para obtener más información sobre las opciones de inspección disponibles, consulta Inspecciona el almacenamiento y las bases de datos en busca de datos sensibles. Para obtener una lista completa de los tipos de información que la protección de datos sensibles puede inspeccionar, consulta la referencia de Infotipos.

Paso 3: Ejecuta la solicitud para iniciar el trabajo de inspección

Después de haber seguido los pasos anteriores para configurar el trabajo, haz clic en Ejecutar a fin de enviar la solicitud. Si la solicitud es exitosa, aparecerá una respuesta con un código de éxito y un objeto JSON que indica el estado del trabajo de protección de datos sensibles que acabas de crear.

La respuesta a tu solicitud de inspección incluye el ID del trabajo de inspección como la clave "name" y el estado actual del trabajo de inspección como la clave "state". Debido a que acabas de enviar la solicitud, el estado del trabajo en ese momento es "PENDING".

Verifica el estado del trabajo de inspección de la protección de datos sensibles

Después de enviar la solicitud de inspección, el trabajo de inspección comienza de inmediato.

Consola de Google Cloud

Para verificar el estado del trabajo de inspección, haz lo siguiente:

En la consola de Google Cloud, abre la protección de datos sensibles.

Haz clic en la pestaña Trabajos y activadores de trabajos y, luego, en Todos los trabajos.

Es probable que el trabajo que acabas de ejecutar se encuentre en la parte superior de la lista. Verifica que el estado de la columna Estado sea Listo.

Puedes hacer clic en el ID del trabajo para ver sus resultados. Cada detector de Infotipos que se enumera en la página de detalles del trabajo va seguido de la cantidad de coincidencias que se encontraron en el contenido.

API de DLP

Para verificar el estado del trabajo de inspección, haz lo siguiente:

Para ir al Explorador de API en la página de referencia del método

dlpJobs.get, haz clic en el siguiente botón:En el cuadro name, escribe el nombre del trabajo de la respuesta JSON a la solicitud de inspección con el siguiente formato:

projects/project-id/dlpJobs/job-id

i-1234567890123456789.Para enviar la solicitud, haz clic en Ejecutar.

Si la clave "state" del objeto JSON de respuesta indica que el trabajo es "DONE", significa que finalizó el trabajo de inspección.

Para ver el resto de la respuesta JSON, desplázate hacia abajo en la página. En "result" > "infoTypeStats", cada tipo de información enumerado debe tener un valor "count" correspondiente. De lo contrario, asegúrate de haber ingresado el JSON de forma adecuada y de que la ruta de acceso o la ubicación de tus datos sea correcta.

Una vez que se haya completado el trabajo de inspección, puedes continuar con la siguiente sección de esta guía para ver los resultados de inspección en Security Command Center.

Consulta los resultados de la inspección de la protección de datos sensibles en Data Catalog

Debido a que le indicaste a Protección de datos sensibles que envíe sus resultados de trabajo de inspección a Data Catalog, ahora puedes ver las etiquetas creadas automáticamente y la plantilla de etiquetas en la IU de Data Catalog:

- Ve a la página de Data Catalog en la consola de Google Cloud.

- Busca la tabla que inspeccionaste.

- Haz clic en los resultados que coincidan con tu tabla para ver los metadatos de la tabla.

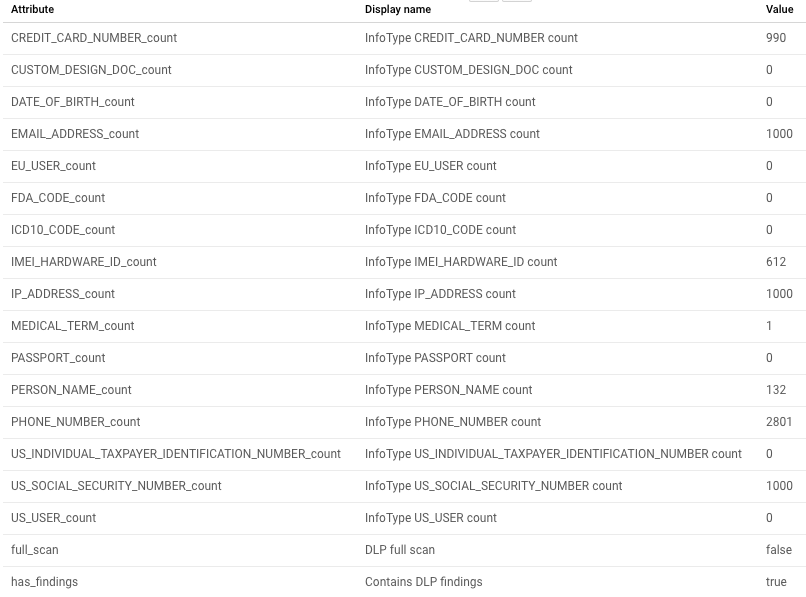

En la siguiente captura de pantalla, se muestra la vista de metadatos de Data Catalog de una tabla de ejemplo:

Resumen de la inspección

Los resultados de la protección de datos sensibles se incluyen en forma de resumen de la tabla que inspeccionaste. En este resumen, se incluyen los recuentos totales de Infotipos, así como los datos de resumen sobre el trabajo de inspección, en los que se incluye el ID del recurso del trabajo y las fechas.

Se enumeran todos los infoTypes que se inspeccionaron. Los que tienen resultados muestran un recuento superior a cero.

Realice una limpieza

Para evitar que se apliquen cargos a tu cuenta de Google Cloud por los recursos que se usaron en este tema, realiza una de las siguientes acciones en función de si usaste datos de muestra o tus propios datos:

- Datos de muestra: borra el proyecto que creaste.

- Tus propios datos: Borra el trabajo de protección de datos sensibles que creaste.

Borra el proyecto

La manera más fácil de eliminar la facturación es borrar el proyecto que creaste con las instrucciones que se proporcionan en este tema.

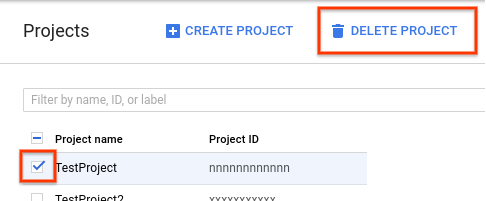

Para borrar el proyecto, haz lo siguiente:

- En la consola de Google Cloud, ve a la página Proyectos.

-

En la lista de proyectos, selecciona el que quieres borrar y haz clic en Delete project (Borrar proyecto).

- En el cuadro de diálogo, escribe el ID del proyecto y haz clic en Cerrar para borrar el proyecto.

Cuando borres tu proyecto con este método, también se borrarán el trabajo de protección de datos sensibles y el bucket de Cloud Storage que creaste. Ya finalizas. No es necesario seguir las instrucciones en las siguientes secciones.

Borra el trabajo o el activador de trabajos de la protección de datos sensibles

Si inspeccionaste tus propios datos, borra el trabajo de inspección o el activador de trabajo que acabas de crear.

Consola de Google Cloud

En la consola de Google Cloud, abre la protección de datos sensibles.

Haz clic en la pestaña Trabajos y activadores de trabajos y, luego, en la pestaña Activadores de trabajos.

En la columna Acciones del activador de trabajos que deseas borrar, haz clic en el menú Más acciones (se muestra como tres puntos verticales) y, luego, haz clic en Borrar.

De manera opcional, también puedes borrar los detalles del trabajo que ejecutaste. Haz clic en la pestaña Todos los trabajos y, luego, en la columna Acciones del trabajo que deseas borrar. A continuación, haz clic en el menú Más acciones (se muestra como tres puntos verticales) y, luego, en Borrar.

API de DLP

Para ir al Explorador de API en la página de referencia del método

dlpJobs.delete, haz clic en el siguiente botón:En el cuadro name, escribe el nombre del trabajo de la respuesta JSON a la solicitud de inspección, el cual tiene la siguiente forma:

projects/project-id/dlpJobs/job-id

i-1234567890123456789.

Si creaste trabajos de inspección adicionales o si deseas asegurarte de haber borrado el trabajo con éxito, puedes enumerar todos los trabajos existentes:

Para ir al Explorador de API en la página de referencia del método

dlpJobs.list, haz clic en el siguiente botón:En el cuadro parent, escribe el identificador del proyecto en el siguiente formato, en el que project-id es el identificador del proyecto:

projects/project-id

Haz clic en Ejecutar.

Si no se enumeran trabajos en la respuesta, significa que borraste todos los trabajos. Si se enumeran trabajos en la respuesta, repite el procedimiento de eliminación anterior para esos trabajos.

¿Qué sigue?

- Obtén más información sobre la acción

publishFindingsToCloudDataCatalogen la Protección de datos sensibles. - Obtén más información para crear etiquetas personalizadas o a nivel de columna en Data Catalog basadas en los resultados de la protección de datos sensibles.

- Obtén más información sobre cómo inspeccionar repositorios de almacenamiento en busca de datos sensibles con la protección de datos sensibles.

- Obtén más información sobre cómo usar Data Catalog.