Este documento fornece informações sobre as métricas do Spark. Por padrão, o Serverless para Apache Spark ativa a coleta de métricas do Spark disponíveis, a menos que você use propriedades de coleta de métricas do Spark para desativar ou substituir a coleta de uma ou mais métricas do Spark.

Para outras propriedades que podem ser definidas ao enviar uma carga de trabalho em lote do Spark sem servidor para Apache Spark, consulte Propriedades do Spark.

Propriedades de coleta de métricas do Spark

É possível usar as propriedades listadas nesta seção para desativar ou substituir a coleta de uma ou mais métricas do Spark disponíveis.

| Propriedade | Descrição |

|---|---|

spark.dataproc.driver.metrics |

Usado para desativar ou substituir as métricas do driver do Spark. |

spark.dataproc.executor.metrics |

Usado para desativar ou substituir métricas do executor do Spark. |

spark.dataproc.system.metrics |

Usado para desativar as métricas do sistema do Spark. |

Exemplos da CLI gcloud:

Desative a coleta de métricas do driver do Spark:

gcloud dataproc batches submit spark \ --properties spark.dataproc.driver.metrics="" \ --region=region \ other args ...

Substitua a coleta de métricas do driver padrão do Spark para coletar apenas métricas de

BlockManager:disk.diskSpaceUsed_MBeDAGScheduler:stage.failedStages:gcloud dataproc batches submit spark \ --properties=^~^spark.dataproc.driver.metrics="BlockManager:disk.diskSpaceUsed_MB,DAGScheduler:stage.failedStages" \ --region=region \ other args ...

Métricas do Spark disponíveis

O Serverless para Apache Spark coleta as métricas do Spark listadas nesta seção, a menos que você use as propriedades de coleta de métricas do Spark para desativar ou substituir a coleta.

custom.googleapis.com/METRIC_EXPLORER_NAME.

Métricas do driver do Spark

| Métrica | Nome do Metrics Explorer |

|---|---|

| BlockManager:disk.diskSpaceUsed_MB | spark/driver/BlockManager/disk/diskSpaceUsed_MB |

| BlockManager:memory.maxMem_MB | spark/driver/BlockManager/memory/maxMem_MB |

| BlockManager:memory.memUsed_MB | spark/driver/BlockManager/memory/memUsed_MB |

| DAGScheduler:job.activeJobs | spark/driver/DAGScheduler/job/activeJobs |

| DAGScheduler:job.allJobs | spark/driver/DAGScheduler/job/allJobs |

| DAGScheduler:messageProcessingTime | spark/driver/DAGScheduler/messageProcessingTime |

| DAGScheduler:stage.failedStages | spark/driver/DAGScheduler/stage/failedStages |

| DAGScheduler:stage.runningStages | spark/driver/DAGScheduler/stage/runningStages |

| DAGScheduler:stage.waitingStages | spark/driver/DAGScheduler/stage/waitingStages |

Métricas do executor do Spark

| Métrica | Nome do Metrics Explorer |

|---|---|

| ExecutorAllocationManager:executors.numberExecutorsDecommissionUnfinished | spark/driver/ExecutorAllocationManager/executors/numberExecutorsDecommissionUnfinished |

| ExecutorAllocationManager:executors.numberExecutorsExitedUnexpectedly | spark/driver/ExecutorAllocationManager/executors/numberExecutorsExitedUnexpectedly |

| ExecutorAllocationManager:executors.numberExecutorsGracefullyDecommissioned | spark/driver/ExecutorAllocationManager/executors/numberExecutorsGracefullyDecommissioned |

| ExecutorAllocationManager:executors.numberExecutorsKilledByDriver | spark/driver/ExecutorAllocationManager/executors/numberExecutorsKilledByDriver |

| LiveListenerBus:queue.executorManagement.listenerProcessingTime | spark/driver/LiveListenerBus/queue/executorManagement/listenerProcessingTime |

| executor:bytesRead | spark/executor/bytesRead |

| executor:bytesWritten | spark/executor/bytesWritten |

| executor:cpuTime | spark/executor/cpuTime |

| executor:diskBytesSpilled | spark/executor/diskBytesSpilled |

| executor:jvmGCTime | spark/executor/jvmGCTime |

| executor:memoryBytesSpilled | spark/executor/memoryBytesSpilled |

| executor:recordsRead | spark/executor/recordsRead |

| executor:recordsWritten | spark/executor/recordsWritten |

| executor:runTime | spark/executor/runTime |

| executor:shuffleFetchWaitTime | spark/executor/shuffleFetchWaitTime |

| executor:shuffleRecordsRead | spark/executor/shuffleRecordsRead |

| executor:shuffleRecordsWritten | spark/executor/shuffleRecordsWritten |

| executor:shuffleRemoteBytesReadToDisk | spark/executor/shuffleRemoteBytesReadToDisk |

| executor:shuffleWriteTime | spark/executor/shuffleWriteTime |

| executor:succeededTasks | spark/executor/succeededTasks |

| ExecutorMetrics:MajorGCTime | spark/executor/ExecutorMetrics/MajorGCTime |

| ExecutorMetrics:MinorGCTime | spark/executor/ExecutorMetrics/MinorGCTime |

Métricas do sistema

| Métrica | Nome do Metrics Explorer |

|---|---|

| agent:uptime | agent/uptime |

| cpu:utilization | CPU/uso |

| disk:bytes_used | disk/bytes_used |

| disk:percent_used | disk/percent_used |

| memory:bytes_used | memory/bytes_used |

| memory:percent_used | memory/percent_used |

| network:tcp_connections | network/tcp_connections |

Conferir métricas do Spark

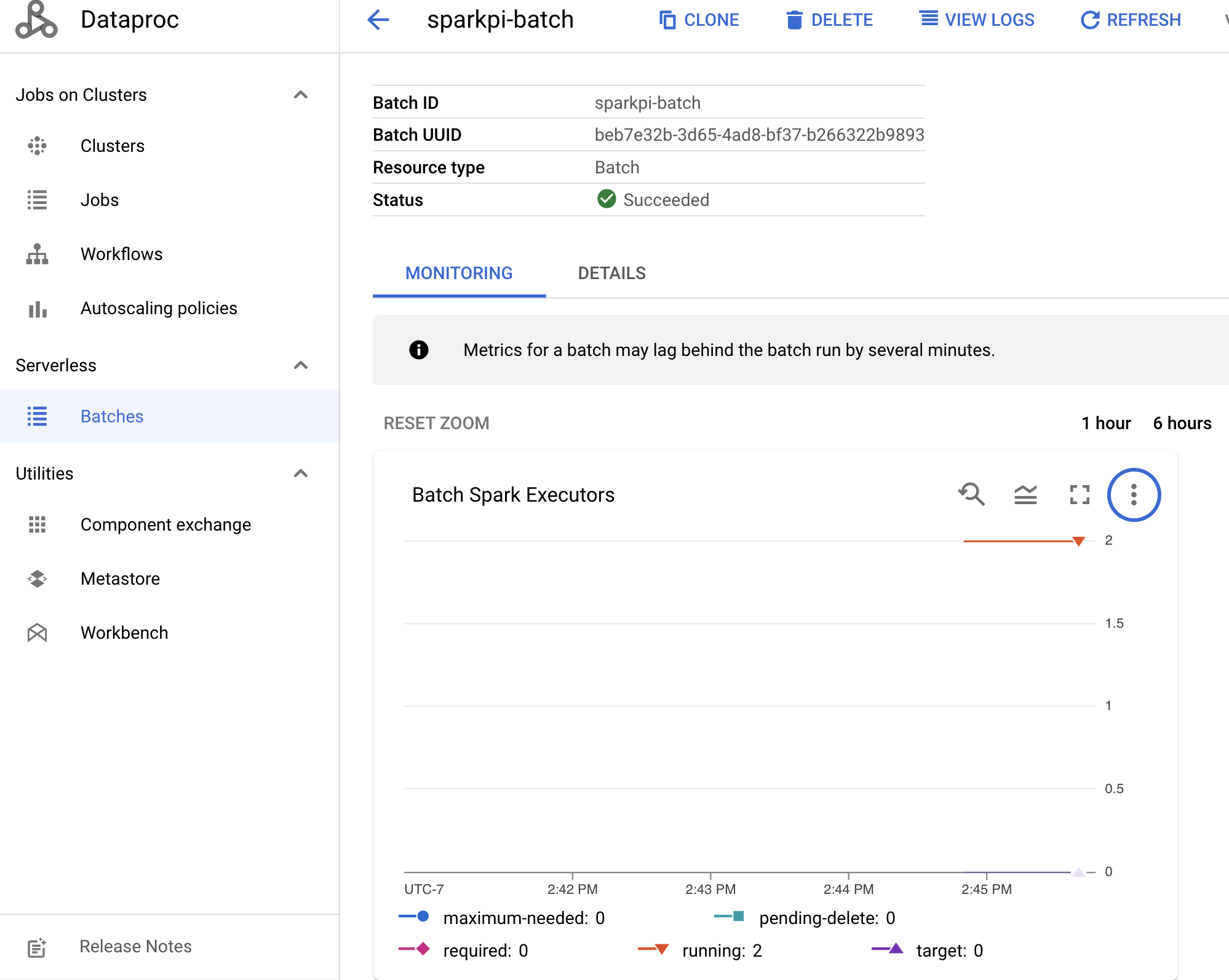

Para conferir as métricas do lote, clique em um ID na página Lotes do Dataproc no console doGoogle Cloud para abrir a página Detalhes do lote, que mostra um gráfico de métricas para a carga de trabalho em lote na guia Monitoramento.

Consulte o Cloud Monitoring do Dataproc para mais informações sobre como visualizar as métricas coletadas.