Spark 구성 옵션의 수와 이러한 옵션이 워크로드에 미치는 영향을 평가하기가 어렵기 때문에 성능과 복원력을 위해 Spark 워크로드를 최적화하기 어려울 수 있습니다. Dataproc Serverless 자동 조정은 Spark 최적화 권장사항 및 워크로드 실행 분석을 기반으로 반복되는 Spark 워크로드에 Spark 구성 설정을 자동으로 적용하여 수동 워크로드 구성의 대안을 제공합니다.

Dataproc Serverless 자동 조정 신청

이 페이지에 설명된 Dataproc Serverless 자동 조정 미리보기 출시 액세스 권한을 신청하려면 BigQuery의 Gemini 미리보기가입 양식을 작성하고 제출합니다. 양식이 승인되면 양식에 나열된 프로젝트에서 미리보기 기능에 액세스할 수 있습니다.

이점

Dataproc Serverless 자동 조정의 이점은 다음과 같습니다.

- 성능 향상: 성능 향상을 위한 최적화 조정

- 더 빠른 최적화: 시간이 많이 소요되는 수동 구성 테스트를 방지하는 자동 구성

- 복원력 향상: 메모리 관련 장애를 방지하는 자동 메모리 할당

제한사항

Dataproc Serverless 자동 조정에는 다음과 같은 제한사항이 있습니다.

- 자동 조정은 계산되어 워크로드의 두 번째 및 이후 실행에 적용됩니다. Dataproc Serverless 자동 조정은 최적화를 위해 워크로드 기록을 사용하므로 반복 워크로드의 첫 번째 실행은 자동 조정되지 않습니다.

- 메모리 축소는 지원되지 않습니다.

- 자동 조정은 실행 중인 워크로드에 소급해서 적용되지 않고 새로 제출된 워크로드 동질 집단에만 소급 적용됩니다.

자동 조정 동질 집단

자동 조정은 동질 집단이라고 하는 일괄 워크로드의 반복 실행에 적용됩니다.

워크로드를 제출할 때 지정한 동질 집단 이름은 이를 반복 워크로드의 연속 실행 중 하나로 식별합니다.

워크로드 유형을 설명하거나 반복 워크로드 안에서 워크로드 실행을 식별하는 데 도움이 되는 동질 집단 이름을 사용하는 것이 좋습니다. 예를 들어 일일 판매 집계 태스크를 실행하는 예약된 워크로드의 동질 집단 이름으로 daily_sales_aggregation을 지정합니다.

자동 조정 시나리오

다음 자동 조정 시나리오 중 하나 이상을 선택하여 워크로드에 Dataproc Serverless 자동 조정을 적용합니다.

MEMORY: Spark 메모리 할당을 자동 조정하여 잠재적인 워크로드 메모리 부족 오류를 예측하고 방지합니다. 메모리 부족(OOM) 오류로 인해 이전에 실패한 워크로드를 수정합니다.SCALING: Spark 자동 확장 구성 설정을 자동 조정합니다.BROADCAST_HASH_JOIN: Spark 구성 설정을 자동 조정하여 SQL 브로드캐스트 조인 성능을 최적화합니다.

가격 책정

Dataproc Serverless 자동 조정은 미리보기 중에 추가 비용 없이 제공됩니다. 표준 Dataproc Serverless 가격 책정이 적용됩니다.

사용 가능한 리전

사용 가능한 Compute Engine 리전에 제출된 배치에서 Dataproc Serverless 자동 조정을 사용할 수 있습니다.

Dataproc Serverless 자동 조정 사용

Google Cloud 콘솔, Google Cloud CLI 또는 Dataproc API를 사용하여 워크로드에서 Dataproc Serverless 자동 조정을 사용 설정할 수 있습니다.

콘솔

반복 일괄 워크로드를 제출할 때마다 Dataproc Serverless 자동 조정을 사용 설정하려면 다음 단계를 수행합니다.

Google Cloud 콘솔에서 Dataproc Batches 페이지로 이동합니다.

일괄 워크로드를 만들려면 만들기를 클릭합니다.

컨테이너 섹션에서 Spark 워크로드에 대해 다음 필드를 작성합니다.

동질 집단: 배치를 일련의 반복되는 워크로드 중 하나로 식별하는 동질 집단 이름. 이 동질 집단 이름으로 제출된 두 번째 및 후속 워크로드에 자동 조정이 적용됩니다. 예를 들어 일일 판매 집계 태스크를 실행하는 예약된 워크로드의 동질 집단 이름으로

daily_sales_aggregation을 지정합니다.자동 조정 시나리오: 워크로드 최적화에 사용하는 하나 이상의 자동 조정 시나리오(예:

BROADCAST_HASH_JOIN,MEMORY,SCALING). 배치 동질 집단을 제출할 때마다 시나리오 선택을 변경할 수 있습니다.

필요에 따라 배치 만들기 페이지의 다른 섹션을 작성한 후 제출을 클릭합니다. 이러한 필드에 대한 자세한 내용은 일괄 워크로드 제출을 참조하세요.

gcloud

반복 일괄 워크로드를 제출할 때마다 Dataproc Serverless 자동 조정을 사용 설정하려면 다음 gcloud CLI

gcloud dataproc batches submit

명령어를 터미널 창에서 로컬로 실행하거나 Cloud Shell에서 실행합니다.

gcloud dataproc batches submit COMMAND \ --region=REGION \ --cohort=COHORT \ --autotuning-scenarios=SCENARIOS \ other arguments ...

다음을 바꿉니다.

- COMMAND: Spark 워크로드 유형(예:

Spark,PySpark,Spark-Sql또는Spark-R). - REGION: 워크로드가 실행되는 리전.

COHORT: 배치를 일련의 반복되는 워크로드 중 하나로 식별하는 동질 집단 이름. 이 동질 집단 이름으로 제출된 두 번째 및 후속 워크로드에 자동 조정이 적용됩니다. 예를 들어 일일 판매 집계 태스크를 실행하는 예약된 워크로드의 동질 집단 이름으로

daily_sales_aggregation을 지정합니다.SCENARIOS: 워크로드를 최적화하는 데 사용할 쉼표로 구분된 하나 이상의 자동 조정 시나리오(예:

--autotuning-scenarios=MEMORY,SCALING). 배치 동질 집단을 제출할 때마다 시나리오 목록을 변경할 수 있습니다.

API

반복 일괄 워크로드를 제출할 때마다 Dataproc Serverless 자동 조정을 사용 설정하려면 다음 필드가 포함된 batches.create 요청을 제출합니다.

RuntimeConfig.cohort: 배치를 일련의 반복되는 워크로드 중 하나로 식별하는 동질 집단 이름. 이 동질 집단 이름으로 제출된 두 번째 및 후속 워크로드에 자동 조정이 적용됩니다. 예를 들어 일일 판매 집계 태스크를 실행하는 예약된 워크로드의 동질 집단 이름으로daily_sales_aggregation을 지정합니다.AutotuningConfig.scenarios: 워크로드 최적화에 사용하는 하나 이상의 자동 조정 시나리오(예:BROADCAST_HASH_JOIN,MEMORY,SCALING). 배치 동질 집단을 제출할 때마다 시나리오 목록을 변경할 수 있습니다.

예:

...

runtimeConfig:

cohort: daily_sales_aggregation

autotuningConfig:

scenarios:

- BROADCAST_HASH_JOIN

- MEMORY

- SCALING

...

Java

이 샘플을 사용해 보기 전에 클라이언트 라이브러리를 사용한 Dataproc Serverless 빠른 시작의 Java 설정 안내를 따르세요. 자세한 내용은 Dataproc Serverless Java API 참고 문서를 참조하세요.

Dataproc Serverless에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 로컬 개발 환경의 인증 설정을 참조하세요.

반복 일괄 워크로드를 제출할 때마다 Dataproc Serverless 자동 조정을 사용 설정하려면 CreateBatchRequest에 다음 필드를 포함하여 BatchControllerClient.createBatch를 호출합니다.

Batch.RuntimeConfig.cohort: 배치를 일련의 반복되는 워크로드 중 하나로 식별하는 동질 집단 이름. 이 동질 집단 이름으로 제출된 두 번째 및 후속 워크로드에 자동 조정이 적용됩니다. 예를 들어 일일 판매 집계 태스크를 실행하는 예약된 워크로드의 동질 집단 이름으로daily_sales_aggregation을 지정합니다.Batch.RuntimeConfig.AutotuningConfig.scenarios: 워크로드 최적화에 사용하는 하나 이상의 자동 조정 시나리오(예:BROADCAST_HASH_JOIN,MEMORY,SCALING). 배치 동질 집단을 제출할 때마다 시나리오 목록을 변경할 수 있습니다. 전체 시나리오 목록은 AutotuningConfig.Scenario Javadoc을 참조하세요.

예:

...

Batch batch =

Batch.newBuilder()

.setRuntimeConfig(

RuntimeConfig.newBuilder()

.setCohort("daily_sales_aggregation")

.setAutotuningConfig(

AutotuningConfig.newBuilder()

.addScenarios(Scenario.SCALING))

...

.build();

batchControllerClient.createBatch(

CreateBatchRequest.newBuilder()

.setParent(parent)

.setBatchId(batchId)

.setBatch(batch)

.build());

...

API를 사용하려면 google-cloud-dataproc 클라이언트 라이브러리 버전 4.43.0 이상을 사용해야 합니다. 다음 구성 중 하나를 사용하여 프로젝트에 라이브러리를 추가할 수 있습니다.

Maven

<dependencies>

<dependency>

<groupId>com.google.cloud</groupId>

<artifactId>google-cloud-dataproc</artifactId>

<version>4.43.0</version>

</dependency>

</dependencies>

Gradle

implementation 'com.google.cloud:google-cloud-dataproc:4.43.0'

SBT

libraryDependencies += "com.google.cloud" % "google-cloud-dataproc" % "4.43.0"

Python

이 샘플을 사용해 보기 전에 클라이언트 라이브러리를 사용한 Dataproc Serverless 빠른 시작의 Python 설정 안내를 따르세요. 자세한 내용은 Dataproc Serverless Python API 참고 문서를 참조하세요.

Dataproc Serverless에 인증하려면 애플리케이션 기본 사용자 인증 정보를 설정합니다. 자세한 내용은 로컬 개발 환경의 인증 설정을 참조하세요.

반복 일괄 워크로드를 제출할 때마다 Dataproc Serverless 자동 조정을 사용 설정하려면 Batch에 다음 필드를 포함하여 BatchControllerClient.create_batch를 호출합니다.

batch.runtime_config.cohort: 배치를 일련의 반복되는 워크로드 중 하나로 식별하는 동질 집단 이름. 이 동질 집단 이름으로 제출된 두 번째 및 후속 워크로드에 자동 조정이 적용됩니다. 예를 들어 일일 판매 집계 태스크를 실행하는 예약된 워크로드의 동질 집단 이름으로daily_sales_aggregation을 지정합니다.batch.runtime_config.autotuning_config.scenarios: 워크로드 최적화에 사용하는 하나 이상의 자동 조정 시나리오(예:BROADCAST_HASH_JOIN,MEMORY,SCALING). 배치 동질 집단을 제출할 때마다 시나리오 목록을 변경할 수 있습니다. 전체 시나리오 목록은 시나리오 참조를 확인하세요.

예:

# Create a client

client = dataproc_v1.BatchControllerClient()

# Initialize request argument(s)

batch = dataproc_v1.Batch()

batch.pyspark_batch.main_python_file_uri = "gs://bucket/run_tpcds.py"

batch.runtime_config.cohort = "daily_sales_aggregation"

batch.runtime_config.autotuning_config.scenarios = [

Scenario.SCALING

]

request = dataproc_v1.CreateBatchRequest(

parent="parent_value",

batch=batch,

)

# Make the request

operation = client.create_batch(request=request)

API를 사용하려면 google-cloud-dataproc 클라이언트 라이브러리 버전 5.10.1 이상을 사용해야 합니다. 프로젝트에 추가하려면 다음 요구사항을 사용하면 됩니다.

google-cloud-dataproc>=5.10.1

Airflow

반복 일괄 워크로드를 제출할 때마다 Dataproc Serverless 자동 조정을 사용 설정하려면 Batch에 다음 필드를 포함하여 BatchControllerClient.create_batch를 호출합니다.

batch.runtime_config.cohort: 배치를 일련의 반복되는 워크로드 중 하나로 식별하는 동질 집단 이름. 이 동질 집단 이름으로 제출된 두 번째 및 후속 워크로드에 자동 조정이 적용됩니다. 예를 들어 일일 판매 집계 태스크를 실행하는 예약된 워크로드의 동질 집단 이름으로daily_sales_aggregation을 지정합니다.batch.runtime_config.autotuning_config.scenarios: 워크로드 최적화에 사용하는 하나 이상의 자동 조정 시나리오(예:BROADCAST_HASH_JOIN,MEMORY,SCALING). 배치 동질 집단을 제출할 때마다 시나리오 목록을 변경할 수 있습니다. 전체 시나리오 목록은 시나리오 참조를 확인하세요.

예:

create_batch = DataprocCreateBatchOperator(

task_id="batch_create",

batch={

"pyspark_batch": {

"main_python_file_uri": PYTHON_FILE_LOCATION,

},

"environment_config": {

"peripherals_config": {

"spark_history_server_config": {

"dataproc_cluster": PHS_CLUSTER_PATH,

},

},

},

"runtime_config": {

"cohort": "daily_sales_aggregation",

"autotuning_config": {

"scenarios": [

Scenario.SCALING,

]

}

},

},

batch_id="BATCH_ID",

)

API를 사용하려면 google-cloud-dataproc 클라이언트 라이브러리 버전 5.10.1 이상을 사용해야 합니다. 다음 Airflow 환경 요구사항을 사용할 수 있습니다.

google-cloud-dataproc>=5.10.1

Cloud Composer에서 패키지를 업데이트하려면 Cloud Composer용 Python 종속 항목 설치를 참조하세요.

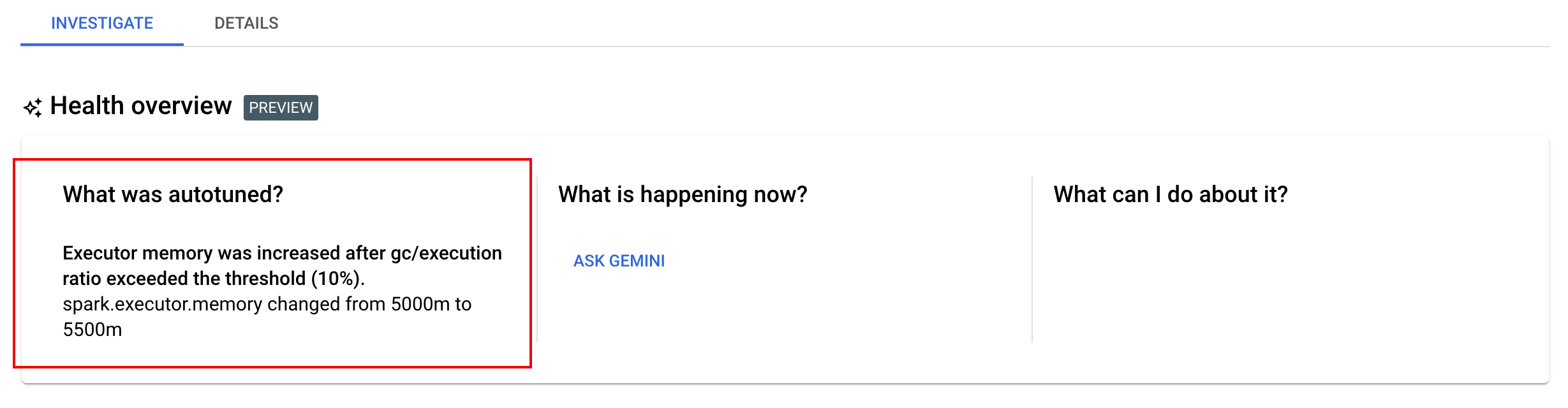

자동 조정 변경사항 보기

일괄 워크로드에 대한 Dataproc Serverless 자동 조정 변경사항을 보려면 gcloud dataproc batches describe 명령어를 실행합니다.

예시: gcloud dataproc batches describe 출력은 다음과 비슷합니다.

...

runtimeInfo:

propertiesInfo:

# Properties set by autotuning.

autotuningProperties

spark.driver.memory:

annotation: Driver OOM was detected

value: 11520m

spark.driver.memoryOverhead:

annotation: Driver OOM was detected

value: 4608m

# Old overwritten properties.

userProperties

...

Google Cloud 콘솔의 일괄 세부정보 페이지의 조사 탭에서 실행, 완료 또는 실패한 워크로드에 적용된 최근 자동 조정 변경사항을 확인할 수 있습니다.