L'API Vision può rilevare e trascrivere il testo dai file PDF e TIFF archiviati in Cloud Storage.

Il rilevamento del testo del documento da PDF e TIFF deve essere richiesto utilizzando la funzione files:asyncBatchAnnotate, che esegue una richiesta offline (asincrona) e fornisce il relativo stato utilizzando le risorse operations.

L'output di una richiesta PDF/TIFF viene scritto in un file JSON creato nel bucket Cloud Storage specificato.

Limitazioni

L'API Vision accetta file PDF/TIFF fino a 2000 pagine. I file più grandi restituiranno un errore.

Autenticazione

Le chiavi API non sono supportate per le richieste files:asyncBatchAnnotate. Consulta Utilizzare un service account per istruzioni sull'autenticazione con un account di servizio.

L'account utilizzato per l'autenticazione deve avere accesso al bucket Cloud Storage

specificato per l'output (roles/editor o

roles/storage.objectCreator o versioni successive).

Puoi utilizzare una chiave API per eseguire query sullo stato dell'operazione. Per istruzioni, consulta la sezione Utilizzo di una chiave API.

Richieste di rilevamento del testo di documenti

Al momento, il rilevamento dei documenti PDF/TIFF è disponibile solo per i file archiviati nei bucket Cloud Storage. I file JSON di risposta vengono salvati in modo simile in un bucket Cloud Storage.

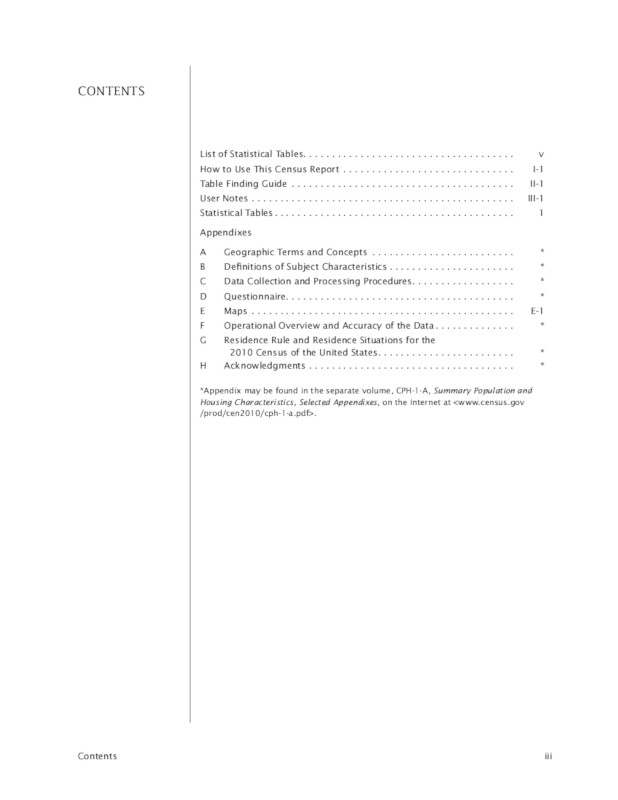

gs://cloud-samples-data/vision/pdf_tiff/census2010.pdf,

Fonte:

United States

Census Bureau.

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- CLOUD_STORAGE_BUCKET: un bucket/una directory Cloud Storage in cui salvare i file di output, espresso nel seguente formato:

gs://bucket/directory/

- CLOUD_STORAGE_FILE_URI: il percorso di un file valido (PDF/TIFF) in un bucket Cloud Storage. Devi disporre almeno dei privilegi di lettura per

il file.

Esempio:

gs://cloud-samples-data/vision/pdf_tiff/census2010.pdf

- FEATURE_TYPE: Un tipo di funzionalità valido.

Per le richieste

files:asyncBatchAnnotatepuoi utilizzare i seguenti tipi di funzionalità:DOCUMENT_TEXT_DETECTIONTEXT_DETECTION

- PROJECT_ID: il tuo ID progetto Google Cloud .

Considerazioni specifiche per i campi:

inputConfig: sostituisce il campoimageutilizzato in altre richieste API Vision. Contiene due campi secondari:gcsSource.uri: l'URI Google Cloud Storage del file PDF o TIFF (accessibile all'utente o al account di servizio che effettua la richiesta).mimeType, uno dei tipi di file accettati:application/pdfoimage/tiff.

outputConfig: specifica i dettagli dell'output. Contiene due campi secondari:gcsDestination.uri: un URI Google Cloud Storage valido. Il bucket deve essere scrivibile dall'utente o dal account di servizio che effettua la richiesta. Il nome file saràoutput-x-to-y, dovexeyrappresentano i numeri di pagina PDF/TIFF inclusi nel file di output. Se il file esiste, i relativi contenuti verranno sovrascritti.batchSize: specifica il numero di pagine di output da includere in ogni file JSON di output.

Metodo HTTP e URL:

POST https://vision.googleapis.com/v1/files:asyncBatchAnnotate

Corpo JSON della richiesta:

{

"requests":[

{

"inputConfig": {

"gcsSource": {

"uri": "CLOUD_STORAGE_FILE_URI"

},

"mimeType": "application/pdf"

},

"features": [

{

"type": "FEATURE_TYPE"

}

],

"outputConfig": {

"gcsDestination": {

"uri": "CLOUD_STORAGE_BUCKET"

},

"batchSize": 1

}

}

]

}

Per inviare la richiesta, scegli una di queste opzioni:

curl

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://vision.googleapis.com/v1/files:asyncBatchAnnotate"

PowerShell

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://vision.googleapis.com/v1/files:asyncBatchAnnotate" | Select-Object -Expand Content

Una richiesta asyncBatchAnnotate riuscita restituisce una risposta con un singolo campo

nome:

{ "name": "projects/usable-auth-library/operations/1efec2285bd442df" }

Questo nome rappresenta un'operazione a lunga esecuzione con un ID associato

(ad esempio, 1efec2285bd442df), che può essere interrogata utilizzando l'API

v1.operations.

Per recuperare la risposta dell'annotazione Vision, invia una richiesta GET all'endpoint v1.operations, passando l'ID operazione nell'URL:

GET https://vision.googleapis.com/v1/operations/operation-idAd esempio:

curl -X GET -H "Authorization: Bearer $(gcloud auth application-default print-access-token)" \ -H "Content-Type: application/json" \ https://vision.googleapis.com/v1/projects/project-id/locations/location-id/operations/1efec2285bd442df

Se l'operazione è in corso:

{ "name": "operations/1efec2285bd442df", "metadata": { "@type": "type.googleapis.com/google.cloud.vision.v1.OperationMetadata", "state": "RUNNING", "createTime": "2019-05-15T21:10:08.401917049Z", "updateTime": "2019-05-15T21:10:33.700763554Z" } }

Una volta completata l'operazione, state viene visualizzato come DONE e i risultati vengono scritti nel file Google Cloud Storage specificato:

{ "name": "operations/1efec2285bd442df", "metadata": { "@type": "type.googleapis.com/google.cloud.vision.v1.OperationMetadata", "state": "DONE", "createTime": "2019-05-15T20:56:30.622473785Z", "updateTime": "2019-05-15T20:56:41.666379749Z" }, "done": true, "response": { "@type": "type.googleapis.com/google.cloud.vision.v1.AsyncBatchAnnotateFilesResponse", "responses": [ { "outputConfig": { "gcsDestination": { "uri": "gs://your-bucket-name/folder/" }, "batchSize": 1 } } ] } }

Il JSON nel file di output è simile a quello di una [richiesta di rilevamento del testo del documento](/vision/docs/ocr) di un'immagine, con l'aggiunta di un campo context che mostra la posizione del PDF o del TIFF specificato e il numero di pagine del file:

output-1-to-1.json

Go

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Go.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida dell'API Vision che utilizza le librerie client. Per saperne di più, consulta la documentazione di riferimento di Vision API Java.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Node.js.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Python.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

gcloud

Il comando gcloud che utilizzi dipende dal tipo di file.

Per eseguire il rilevamento del testo PDF, utilizza il comando

gcloud ml vision detect-text-pdfcome mostrato nell'esempio seguente:gcloud ml vision detect-text-pdf gs://my_bucket/input_file gs://my_bucket/out_put_prefix

Per eseguire il rilevamento del testo TIFF, utilizza il comando

gcloud ml vision detect-text-tiffcome mostrato nell'esempio seguente:gcloud ml vision detect-text-tiff gs://my_bucket/input_file gs://my_bucket/out_put_prefix

Linguaggi aggiuntivi

C#: Segui le istruzioni di configurazione di C# nella pagina delle librerie client e poi visita la documentazione di riferimento di Vision per .NET.

PHP: Segui le istruzioni di configurazione di PHP nella pagina delle librerie client e poi consulta la documentazione di riferimento di Vision per PHP.

Ruby: Segui le istruzioni di configurazione di Ruby nella pagina delle librerie client e poi visita la documentazione di riferimento di Vision per Ruby.

Supporto di più aree geografiche

Ora puoi specificare l'archiviazione dei dati a livello di continente e l'elaborazione OCR. Al momento sono supportate le seguenti regioni:

us: solo Stati Unitieu: L'Unione Europea

Località

Cloud Vision ti offre un certo controllo su dove vengono archiviate ed elaborate le risorse del tuo progetto. In particolare, puoi configurare Cloud Vision per archiviare ed elaborare i tuoi dati solo nell'Unione Europea.

Per impostazione predefinita, Cloud Vision archivia ed elabora le risorse in una località globale, il che significa che Cloud Vision non garantisce che le risorse rimarranno all'interno di una località o regione specifica. Se scegli la località Unione Europea, Google archivierà i tuoi dati e li elaborerà solo nell'Unione Europea. Tu e i tuoi utenti potete accedere ai dati da qualsiasi posizione.

Impostazione della posizione utilizzando l'API

L'API Vision supporta un endpoint API globale (vision.googleapis.com) e anche

due endpoint basati sulla regione: un endpoint dell'Unione Europea

(eu-vision.googleapis.com) e un endpoint degli Stati Uniti (us-vision.googleapis.com). Utilizza questi endpoint per l'elaborazione specifica per regione. Ad esempio, per archiviare ed elaborare i tuoi dati solo nell'Unione Europea, utilizza l'URI eu-vision.googleapis.com al posto di vision.googleapis.com per le chiamate API REST:

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/images:annotate

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/images:asyncBatchAnnotate

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/files:annotate

- https://eu-vision.googleapis.com/v1/projects/PROJECT_ID/locations/eu/files:asyncBatchAnnotate

Per archiviare ed elaborare i dati solo negli Stati Uniti, utilizza l'endpoint statunitense

(us-vision.googleapis.com) con i metodi precedenti.

Impostare la posizione utilizzando le librerie client

Per impostazione predefinita, le librerie client dell'API Vision accedono all'endpoint API globale

(vision.googleapis.com). Per archiviare ed elaborare i dati solo nell'Unione Europea, devi impostare esplicitamente l'endpoint (eu-vision.googleapis.com). I seguenti esempi di codice mostrano come configurare questa impostazione.

REST

Prima di utilizzare i dati della richiesta, apporta le seguenti sostituzioni:

- REGION_ID: uno degli identificatori di località regionali validi:

us: solo Stati Unitieu: L'Unione Europea

- CLOUD_STORAGE_IMAGE_URI: il percorso di un file immagine valido in un bucket Cloud Storage. Devi disporre almeno dei privilegi di lettura per il file.

Esempio:

gs://cloud-samples-data/vision/pdf_tiff/census2010.pdf

- CLOUD_STORAGE_BUCKET: un bucket/una directory Cloud Storage in cui salvare i file di output, espresso nel seguente formato:

gs://bucket/directory/

- FEATURE_TYPE: Un tipo di funzionalità valido.

Per le richieste

files:asyncBatchAnnotatepuoi utilizzare i seguenti tipi di funzionalità:DOCUMENT_TEXT_DETECTIONTEXT_DETECTION

- PROJECT_ID: il tuo ID progetto Google Cloud .

Considerazioni specifiche per i campi:

inputConfig: sostituisce il campoimageutilizzato in altre richieste API Vision. Contiene due campi secondari:gcsSource.uri: l'URI Google Cloud Storage del file PDF o TIFF (accessibile all'utente o al account di servizio che effettua la richiesta).mimeType, uno dei tipi di file accettati:application/pdfoimage/tiff.

outputConfig: specifica i dettagli dell'output. Contiene due campi secondari:gcsDestination.uri: un URI Google Cloud Storage valido. Il bucket deve essere scrivibile dall'utente o dal account di servizio che effettua la richiesta. Il nome file saràoutput-x-to-y, dovexeyrappresentano i numeri di pagina PDF/TIFF inclusi nel file di output. Se il file esiste, i relativi contenuti verranno sovrascritti.batchSize: specifica il numero di pagine di output da includere in ogni file JSON di output.

Metodo HTTP e URL:

POST https://REGION_ID-vision.googleapis.com/v1/projects/PROJECT_ID/locations/REGION_ID/files:asyncBatchAnnotate

Corpo JSON della richiesta:

{

"requests":[

{

"inputConfig": {

"gcsSource": {

"uri": "CLOUD_STORAGE_IMAGE_URI"

},

"mimeType": "application/pdf"

},

"features": [

{

"type": "FEATURE_TYPE"

}

],

"outputConfig": {

"gcsDestination": {

"uri": "CLOUD_STORAGE_BUCKET"

},

"batchSize": 1

}

}

]

}

Per inviare la richiesta, scegli una di queste opzioni:

curl

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: PROJECT_ID" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://REGION_ID-vision.googleapis.com/v1/projects/PROJECT_ID/locations/REGION_ID/files:asyncBatchAnnotate"

PowerShell

Salva il corpo della richiesta in un file denominato request.json,

ed esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "PROJECT_ID" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://REGION_ID-vision.googleapis.com/v1/projects/PROJECT_ID/locations/REGION_ID/files:asyncBatchAnnotate" | Select-Object -Expand Content

Una richiesta asyncBatchAnnotate riuscita restituisce una risposta con un singolo campo

nome:

{ "name": "projects/usable-auth-library/operations/1efec2285bd442df" }

Questo nome rappresenta un'operazione a lunga esecuzione con un ID associato

(ad esempio, 1efec2285bd442df), che può essere interrogata utilizzando l'API

v1.operations.

Per recuperare la risposta dell'annotazione Vision, invia una richiesta GET all'endpoint v1.operations, passando l'ID operazione nell'URL:

GET https://vision.googleapis.com/v1/operations/operation-idAd esempio:

curl -X GET -H "Authorization: Bearer $(gcloud auth application-default print-access-token)" \ -H "Content-Type: application/json" \ https://vision.googleapis.com/v1/projects/project-id/locations/location-id/operations/1efec2285bd442df

Se l'operazione è in corso:

{ "name": "operations/1efec2285bd442df", "metadata": { "@type": "type.googleapis.com/google.cloud.vision.v1.OperationMetadata", "state": "RUNNING", "createTime": "2019-05-15T21:10:08.401917049Z", "updateTime": "2019-05-15T21:10:33.700763554Z" } }

Una volta completata l'operazione, state viene visualizzato come DONE e i risultati vengono scritti nel file Google Cloud Storage specificato:

{ "name": "operations/1efec2285bd442df", "metadata": { "@type": "type.googleapis.com/google.cloud.vision.v1.OperationMetadata", "state": "DONE", "createTime": "2019-05-15T20:56:30.622473785Z", "updateTime": "2019-05-15T20:56:41.666379749Z" }, "done": true, "response": { "@type": "type.googleapis.com/google.cloud.vision.v1.AsyncBatchAnnotateFilesResponse", "responses": [ { "outputConfig": { "gcsDestination": { "uri": "gs://your-bucket-name/folder/" }, "batchSize": 1 } } ] } }

Il JSON nel file di output è simile a quello di una risposta di rilevamento del testo del documento di un'immagine se hai utilizzato la funzionalità DOCUMENT_TEXT_DETECTION o a una risposta di rilevamento del testo se hai utilizzato la funzionalità TEXT_DETECTION. L'output avrà un campo

context aggiuntivo che mostra la posizione del PDF o del TIFF specificato e

il numero di pagine del file:

output-1-to-1.json

Go

Prima di provare questo esempio, segui le istruzioni di configurazione di Go nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Go.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione di Java nella guida rapida dell'API Vision che utilizza le librerie client. Per saperne di più, consulta la documentazione di riferimento di Vision API Java.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione di Node.js nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Node.js.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione di Python nella guida rapida di Vision per l'utilizzo delle librerie client. Per saperne di più, consulta la documentazione di riferimento dell'API Vision Python.

Per eseguire l'autenticazione in Vision, configura le Credenziali predefinite dell'applicazione. Per ulteriori informazioni, consulta Configura l'autenticazione per un ambiente di sviluppo locale.

Provalo

Se non conosci Google Cloud, crea un account per valutare le prestazioni dell'API Cloud Vision in scenari reali. I nuovi clienti ricevono anche 300 $ di crediti per l'esecuzione, il test e il deployment di workload senza costi aggiuntivi.

Prova l'API Cloud Vision gratuitamente