Dopo aver addestrato un modello, AutoML Vision utilizza gli elementi del set di TEST per valutare la qualità e l'accuratezza del nuovo modello.

Panoramica della valutazione

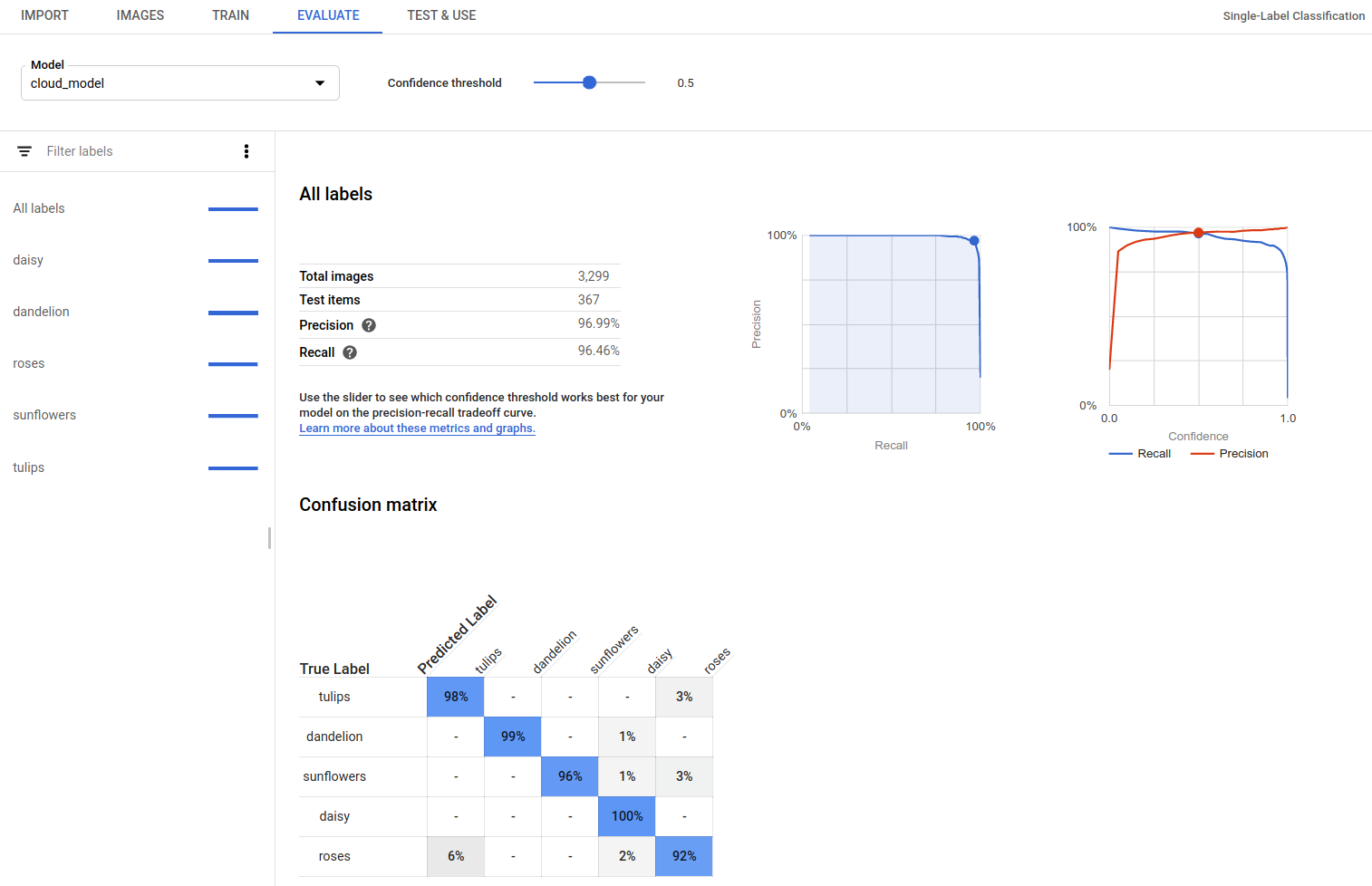

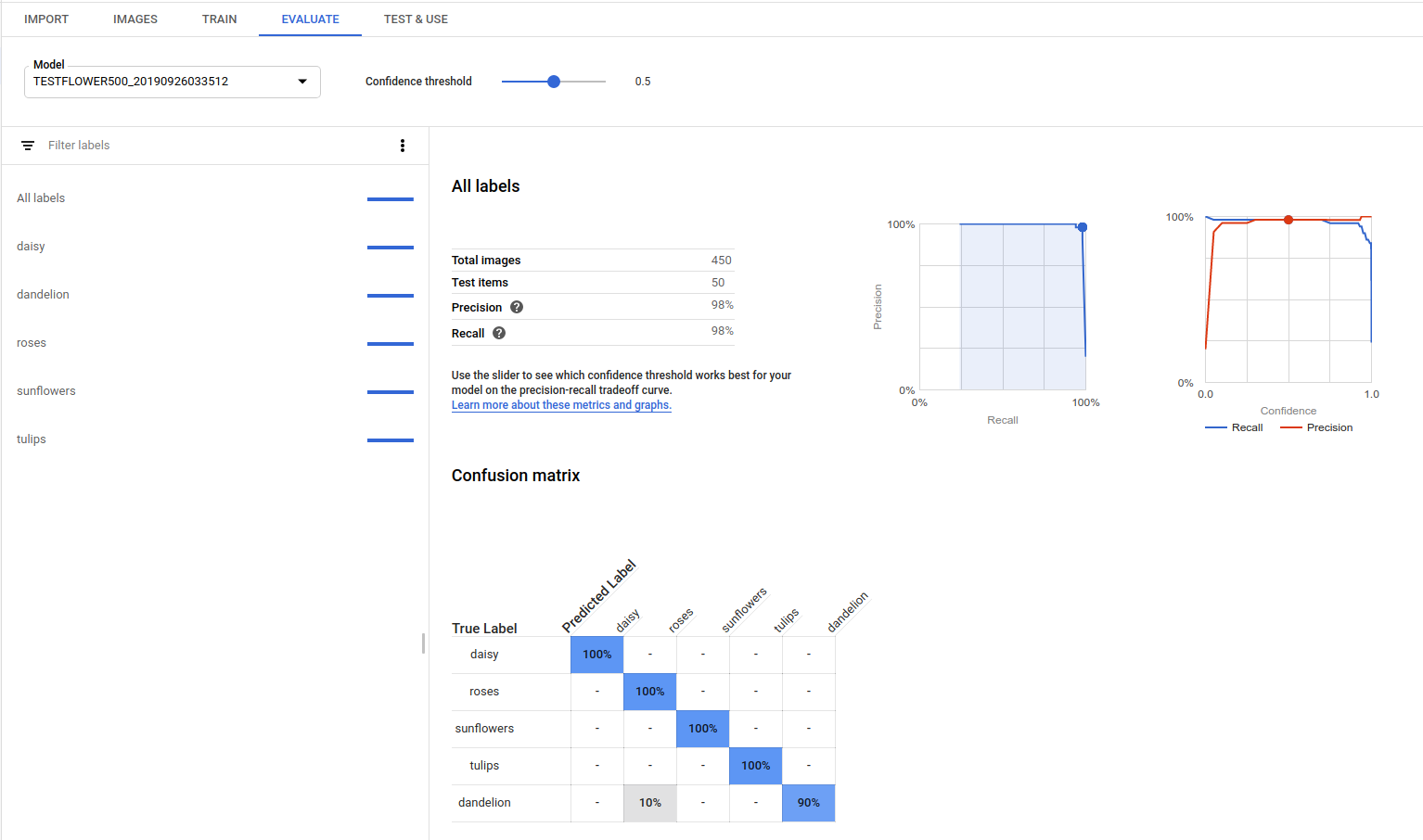

AutoML Vision fornisce un set aggregato di metriche di valutazione che indicano il rendimento complessivo del modello, nonché metriche di valutazione per ogni etichetta di categoria, che indicano le prestazioni del modello per quell'etichetta.

AuPRC : area sotto la curva di precisione/richiamo, detta anche "precisione media". Di solito tra 0,5 e 1,0. Valori più alti indicano modelli più accurati.

Le curve della soglia di affidabilità mostrano in che modo le diverse soglie di confidenza influirebbero sulla precisione, sul richiamo e sui tassi di veri e falsi positivi. Scopri il rapporto tra precisione e richiamo.

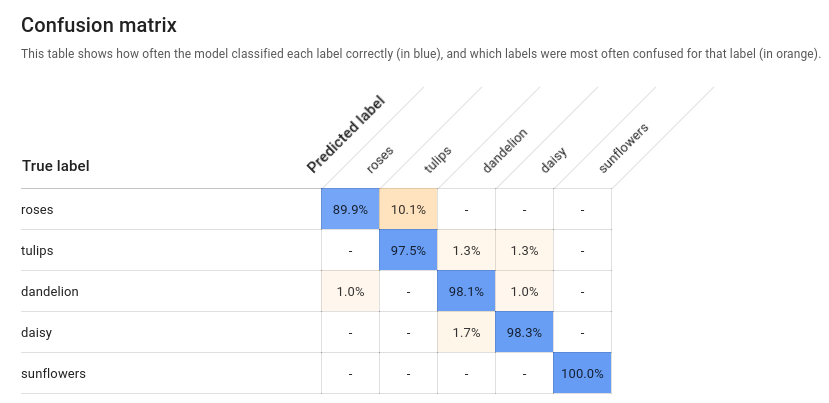

Matrice di confusione: presente solo per i modelli con una sola etichetta per immagine. Rappresenta la percentuale di volte in cui ogni etichetta è stata prevista per ogni etichetta nel set di addestramento durante la valutazione.

Idealmente, l'etichetta

oneverrebbe assegnata solo alle immagini classificate come etichettaonee così via, perciò una matrice perfetta sarebbe:100 0 0 0 0 100 0 0 0 0 100 0 0 0 0 100Nell'esempio precedente, se un'immagine è stata classificata come

one, ma il modello ha previstotwo, la prima riga sarà invece:99 1 0 0Per ulteriori informazioni, cerca "machine learning matrix di confusione".

AutoML Vision crea la matrice di confusione per un massimo di 10 etichette. Se hai più di 10 etichette, la matrice include le 10 con la maggiore confusione (previsioni errate).

Utilizza questi dati per valutare l'idoneità del modello. Una confusione elevata, punteggi AUC bassi o punteggi di precisione e richiamo bassi possono indicare che il modello ha bisogno di ulteriori dati di addestramento o ha etichette incoerenti. Un punteggio AUC molto alto e una precisione e un richiamo perfetti possono indicare che i dati sono troppo semplici e potrebbero non essere generalizzati.

Elenco valutazioni modello

Dopo aver addestrato un modello, puoi elencare le relative metriche di valutazione.

UI web

Apri l'interfaccia utente di AutoML Vision e fai clic sulla scheda Modelli (con l'icona a forma di lampadina) nella barra di navigazione a sinistra per visualizzare i modelli disponibili.

Per visualizzare i modelli di un altro progetto, seleziona il progetto dall'elenco a discesa in alto a destra nella barra del titolo.

Fai clic sulla riga del modello da valutare.

Se necessario, fai clic sulla scheda Valuta appena sotto la barra del titolo.

Se l'addestramento del modello è stato completato, AutoML Vision mostra le sue metriche di valutazione.

REST

Prima di utilizzare i dati della richiesta, effettua le seguenti sostituzioni:

- project-id: l'ID del tuo progetto Google Cloud.

- model-id: l'ID del modello, dalla

risposta al momento della creazione del modello. L'ID è l'ultimo elemento del nome del modello.

Ad esempio:

- nome del modello:

projects/project-id/locations/location-id/models/IOD4412217016962778756 - ID modello:

IOD4412217016962778756

- nome del modello:

- model-evaluation-id: il valore ID della valutazione del modello. Puoi ottenere gli ID di valutazione del modello dall'operazione di valutazione del modello

list.

Metodo HTTP e URL:

GET https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID

Per inviare la richiesta, scegli una delle seguenti opzioni:

arricciatura

Esegui questo comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID"

PowerShell

Esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID" | Select-Object -Expand Content

Dovresti ricevere una risposta JSON simile all'esempio seguente. I campi specifici per il rilevamento degli oggetti chiave sono in grassetto e viene mostrata una versione abbreviata delle voci classificationEvaluationMetrics per maggiore chiarezza:

Go

Prima di provare questo esempio, segui le istruzioni di configurazione per questa lingua nella pagina Librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione per questa lingua nella pagina Librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione per questa lingua nella pagina Librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione per questa lingua nella pagina Librerie client.

Linguaggi aggiuntivi

C#: segui le istruzioni di configurazione di C# nella pagina delle librerie client e poi consulta la documentazione di riferimento di AutoML Vision per .NET.

PHP: segui le istruzioni per la configurazione dei file PHP nella pagina delle librerie client e consulta la documentazione di riferimento di AutoML Vision per PHP.

Ruby: segui le istruzioni di configurazione di Ruby nella pagina delle librerie client e poi visita la documentazione di riferimento di AutoML Vision per Ruby.

Ottieni valori di valutazione del modello

Puoi anche ottenere una valutazione specifica di un modello per un'etichetta (displayName) utilizzando

un ID valutazione. Per ottenere l'ID valutazione del modello, esegui la funzione di elenco delle valutazioni dei modelli

mostrata in Elenca valutazioni dei modelli.

UI web

Apri l'Vision Dashboard e fai clic sull'icona a forma di lampadina nella barra di navigazione a sinistra per visualizzare i modelli disponibili.

Per visualizzare i modelli di un altro progetto, seleziona il progetto dall'elenco a discesa in alto a destra nella barra del titolo.

Fai clic sulla riga del modello da valutare.

Se necessario, fai clic sulla scheda Valuta appena sotto la barra del titolo.

Se l'addestramento del modello è stato completato, AutoML Vision mostra le sue metriche di valutazione.

Per visualizzare le metriche relative a un'etichetta specifica, seleziona il nome dell'etichetta dall'elenco di etichette nella parte inferiore della pagina.

REST

Per ottenere solo le metriche di valutazione per un'etichetta specifica, aggiungi /{MODEL_EVALUATION_ID} alla richiesta precedente dalla risposta.

Ad esempio, puoi trovare l'ID di valutazione del modello per l'etichetta rose (displayName) nel nome di valutazione restituito dall'operazione list:

"name": "projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/858136867710915695"

Prima di utilizzare i dati della richiesta, effettua le seguenti sostituzioni:

- project-id: l'ID del tuo progetto Google Cloud.

- model-id: l'ID del modello, dalla

risposta al momento della creazione del modello. L'ID è l'ultimo elemento del nome del modello.

Ad esempio:

- nome del modello:

projects/project-id/locations/location-id/models/IOD4412217016962778756 - ID modello:

IOD4412217016962778756

- nome del modello:

- model-evaluation-id: il valore ID della valutazione del modello. Puoi ottenere gli ID di valutazione del modello dall'operazione di valutazione del modello

list.

Metodo HTTP e URL:

GET https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID

Per inviare la richiesta, scegli una delle seguenti opzioni:

arricciatura

Esegui questo comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID"

PowerShell

Esegui questo comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/models/MODEL_ID/modelEvaluations/MODEL_EVALUATION_ID" | Select-Object -Expand Content

Dovresti ricevere una risposta JSON simile alla seguente:

Go

Prima di provare questo esempio, segui le istruzioni di configurazione per questa lingua nella pagina Librerie client.

Java

Prima di provare questo esempio, segui le istruzioni di configurazione per questa lingua nella pagina Librerie client.

Node.js

Prima di provare questo esempio, segui le istruzioni di configurazione per questa lingua nella pagina Librerie client.

Python

Prima di provare questo esempio, segui le istruzioni di configurazione per questa lingua nella pagina Librerie client.

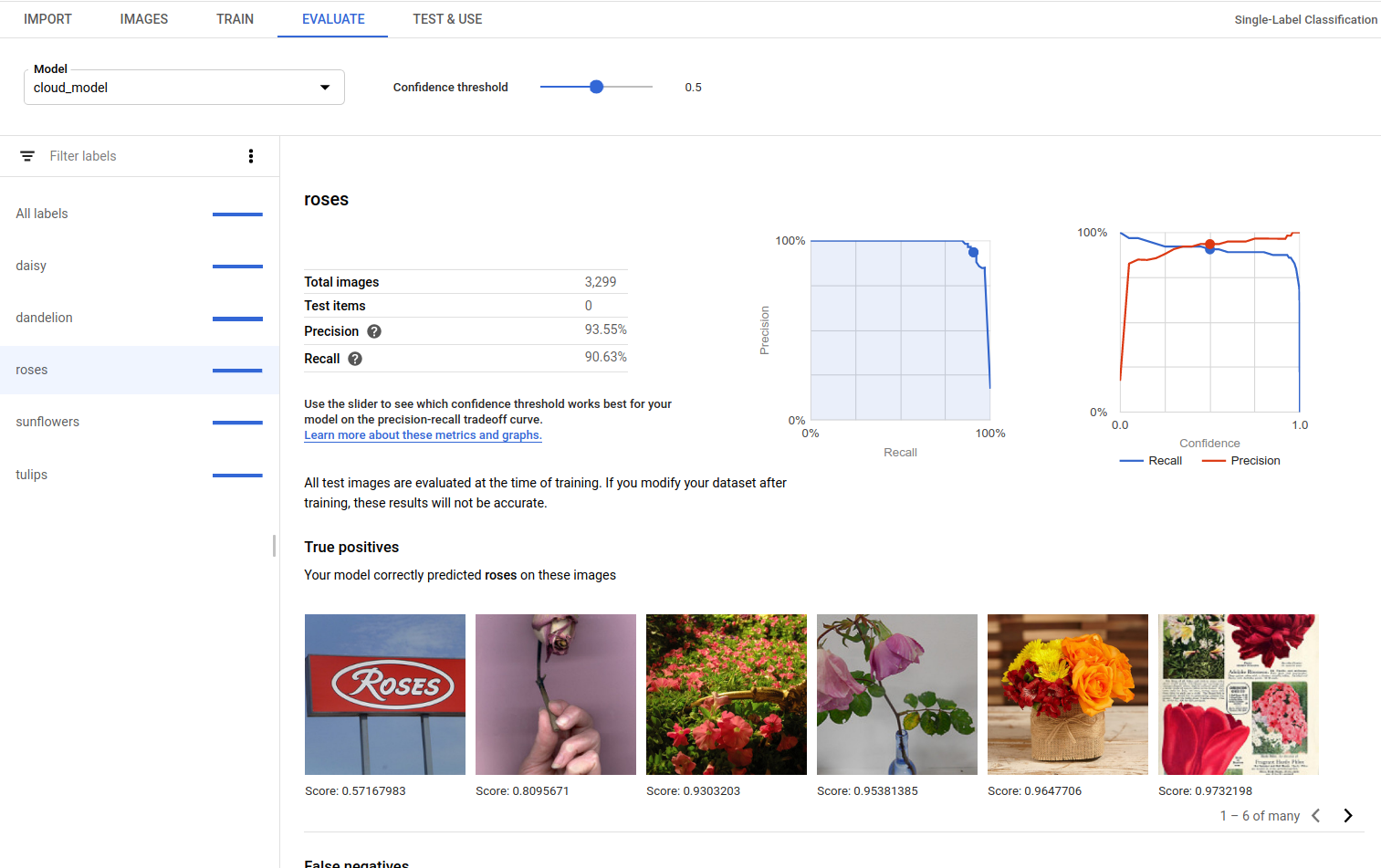

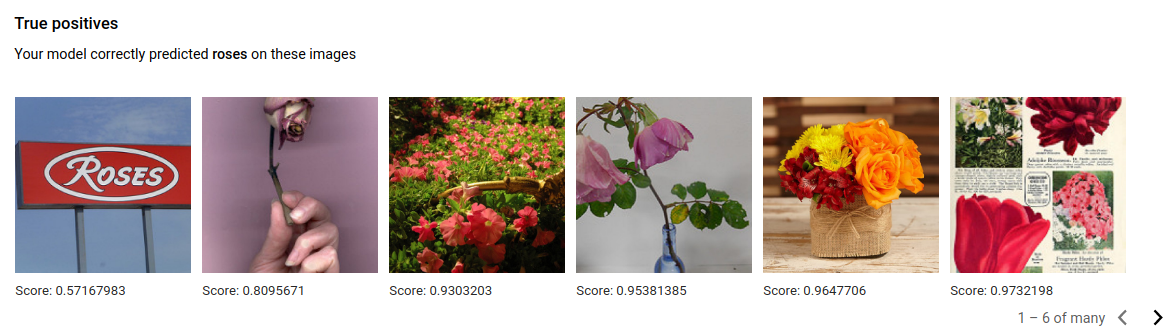

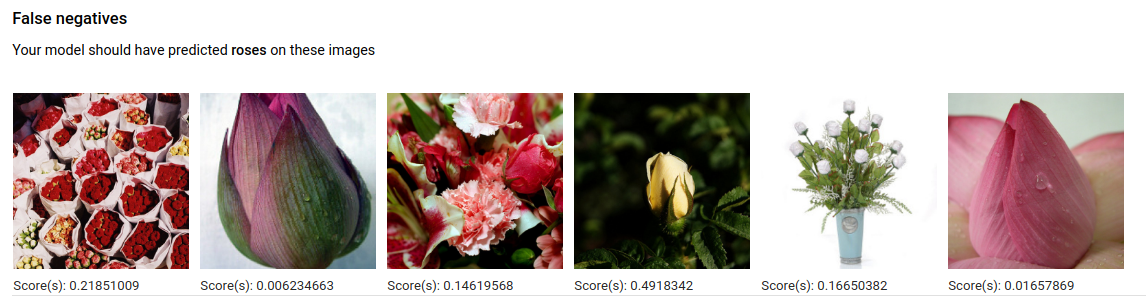

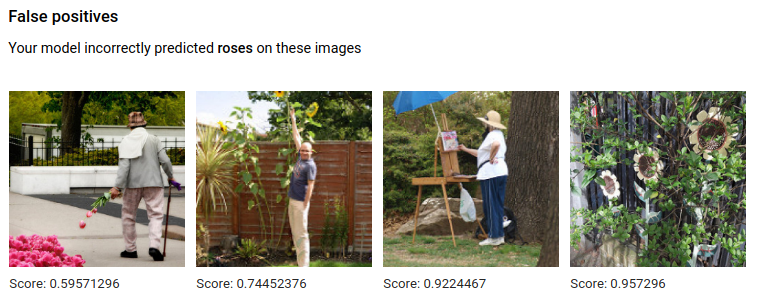

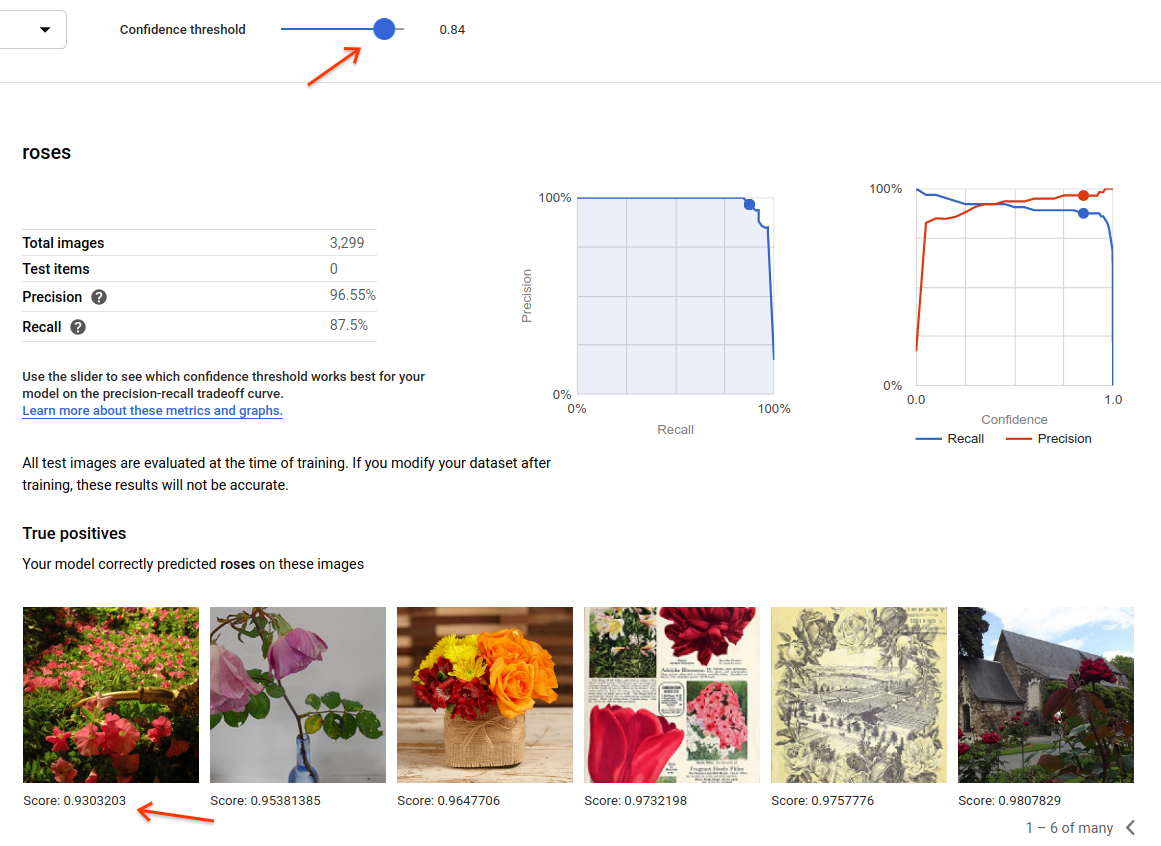

Veri positivi, falsi negativi e falsi positivi (solo UI)

Nell'interfaccia utente puoi osservare esempi specifici di prestazioni dei modelli, ovvero istanze di veri positivi (TP), falsi negativi (FN) e falsi positivi (FP) dei tuoi set FORMAZIONE e VALIDAZIONE.

UI web

Prima di provare questo esempio, segui le istruzioni di configurazione per questa lingua nella pagina Librerie client.

Puoi accedere alle visualizzazioni VP, FN e FP nell'interfaccia utente selezionando la scheda Valuta e quindi un'etichetta specifica.

Visualizzando le tendenze in queste previsioni, puoi modificare il set di addestramento per migliorare le prestazioni del modello.

Le immagini true positive sono immagini di esempio fornite al modello addestrato e annotate correttamente dal modello:

Le immagini di falsi negativi sono fornite in modo simile al modello addestrato, ma il modello non è riuscito a annotare correttamente l'immagine per l'etichetta specificata:

Infine, le immagini di falsi positivi sono quelle fornite al modello addestrato che sono state annotate con l'etichetta specificata, ma che non dovevano essere state annotate:

Il modello seleziona casi interessanti, il che offre l'opportunità di perfezionare le definizioni e le etichette per aiutarlo a comprendere le interpretazioni delle etichette. Ad esempio, una definizione più restrittiva aiuterebbe il modello a capire se consideriamo o meno una "rosa" un dipinto astratto di una rosa.

Con loop ripetuti di etichette, addestramento e valutazione, il modello mostrerà altre ambiguità nei dati.

Puoi anche regolare la soglia di punteggio in questa visualizzazione nell'interfaccia utente e le immagini TP, FN e FP visualizzate rispecchieranno la variazione della soglia:

Esegui l'iterazione sul modello

Se i livelli qualitativi non ti soddisfano, puoi tornare ai passaggi precedenti per migliorare la qualità:

- AutoML Vision ti consente di ordinare le immagini in base a quanto è "confuso" il modello, in base all'etichetta vera e all'etichetta prevista. Esamina queste immagini e assicurati che siano etichettate correttamente.

- Valuta la possibilità di aggiungere altre immagini a tutte le etichette di bassa qualità.

- Potresti dover aggiungere diversi tipi di immagini (ad es. un'angolazione più ampia, una risoluzione superiore o inferiore, punti di vista diversi).

- Valuta la possibilità di rimuovere del tutto le etichette se non disponi di immagini di addestramento sufficienti.

- Ricorda che le macchine non possono leggere il nome dell'etichetta; è solo una stringa casuale di lettere. Se hai un'etichetta con la scritta "porta" e un'altra con la dicitura "porta_con_manopola", la macchina non ha modo di cogliere le sfumature al di fuori delle immagini fornite da te.

- Arricchisci i tuoi dati con più esempi di veri positivi e negativi. Gli esempi particolarmente importanti sono quelli vicini ai confini decisionali (che potrebbero generare confusione, ma che comunque sono etichettati correttamente).

- Specifica la tua suddivisione per addestramento, test e convalida. Lo strumento assegna le immagini in modo casuale, ma i quasi duplicati potrebbero finire in TRAIN e VALIDATION, il che potrebbe portare a un overfitting e quindi a prestazioni scadenti nel set di TEST.

Dopo aver apportato le modifiche, addestra e valuta un nuovo modello fino a raggiungere un livello qualitativo sufficientemente elevato.