モデルの評価

モデルをトレーニングした後、AutoML Video Intelligence オブジェクト トラッキングはテストセットの項目を使用して、新しいモデルの品質と精度を評価します。

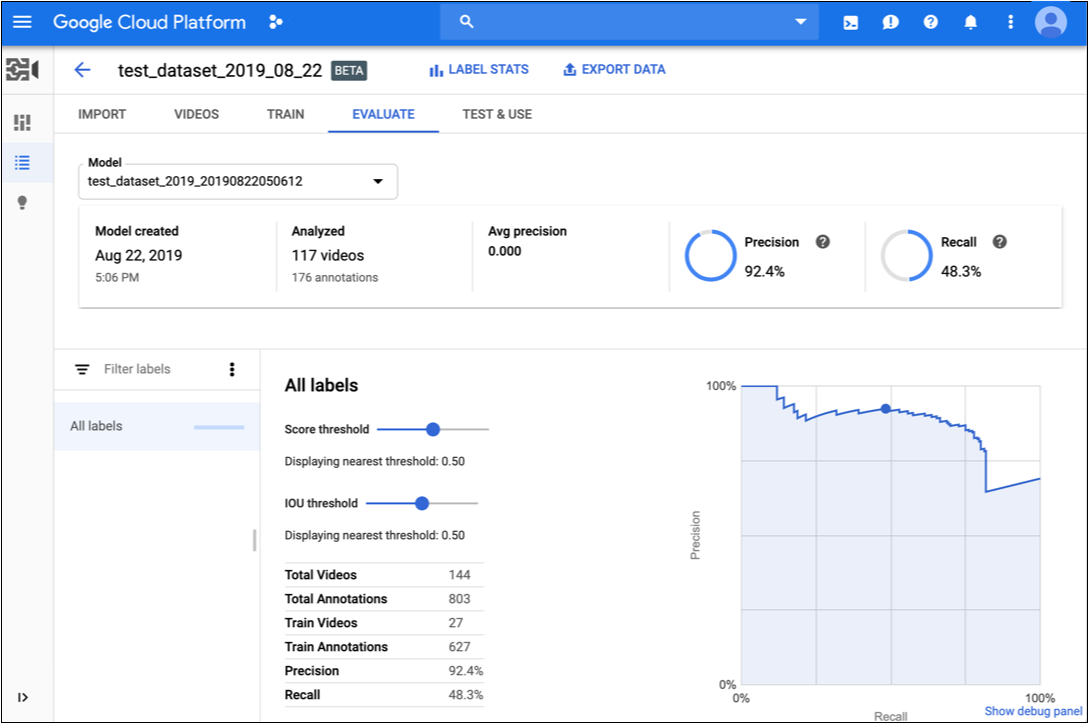

AutoML Video Intelligence オブジェクト トラッキングには、モデルが全体的にどの程度適切に機能するかを示す評価指標のセットと、モデルが特定のラベルに対してどの程度適切に機能するかを示す各カテゴリラベルの評価指標が用意されています。

IoU: Intersection over Union。オブジェクト トラッキングで使用される指標の 1 つで、動画フレームのオブジェクト インスタンスについて予測された境界ボックスが実際の境界ボックスとどの程度オーバーラップしているかを測定します。予測された境界ボックスの値が実際の境界ボックスの値に近いほど、交差部分と IoU 値が大きいことになります。

AuPRC: 適合率 / 再現率曲線の下の部分の面積で、「平均適合率」とも呼ばれます。通常は、0.5 から 1.0 の間です。値が高いほど、モデルの精度が高いことを示します。

信頼しきい値曲線は、さまざまな信頼しきい値が適合率、再現率、真陽性率、および偽陽性率にどのように影響するかを示します。適合率と再現率の関係をご覧ください。

このデータを使用して、モデルの準備状況を評価します。AUC スコアが低い、つまり適合率スコアと再現率スコアが低い場合は、モデルに追加のトレーニング データが必要であるか、ラベルに一貫性がないことを示している可能性があります。AUC スコアが非常に高く、適合率と再現率が完璧な場合は、データが単純すぎて適切に一般化できないことを示している可能性があります。

モデル評価値の取得

ウェブ UI

-

AutoML Video Object Tracking UI で [モデル] ページを開きます。

-

評価するモデルの行をクリックします。

-

[評価] タブをクリックします。

モデルのトレーニングが完了している場合、AutoML Video Object Tracking はその評価指標を表示します。

- 特定のラベルの指標を表示するには、ページの下部にあるラベルのリストからラベル名を選択します。

REST

リクエストのデータを使用する前に、次のように置き換えます。

- model-id: モデルの識別子に置き換えます。

- project-number: プロジェクトの数

- location-id: アノテーションを実行する Cloud リージョン。サポート対象のクラウド リージョンは

us-east1、us-west1、europe-west1、asia-east1です。リージョンを指定しないと、動画ファイルの場所に基づいてリージョンが決まります。

HTTP メソッドと URL:

GET https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/models/model-id:modelEvaluations

リクエストを送信するには、次のいずれかのオプションを選択します。

curl

次のコマンドを実行します。

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-number" \

"https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/models/model-id:modelEvaluations"

PowerShell

次のコマンドを実行します。

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-number" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/models/model-id:modelEvaluations" | Select-Object -Expand Content

8703337066443674578 です。

Java

AutoML Video Object Tracking への認証を行うには、アプリケーションのデフォルト認証情報を設定します。 詳細については、ローカル開発環境の認証の設定をご覧ください。

Node.js

AutoML Video Object Tracking への認証を行うには、アプリケーションのデフォルト認証情報を設定します。 詳細については、ローカル開発環境の認証の設定をご覧ください。

Python

AutoML Video Object Tracking への認証を行うには、アプリケーションのデフォルト認証情報を設定します。 詳細については、ローカル開発環境の認証の設定をご覧ください。

モデルの反復処理

品質水準に不満がある場合は、前のステップに戻って品質を向上させることができます。

- さまざまなタイプの動画を追加しなければならない場合があります(たとえば、構図の拡大、解像度の増減、異なる視点など)。

- 十分なトレーニング動画がない場合は、ラベルを完全に削除することを検討してください。

- マシンにはラベル名の意味は理解できません。つまり、ラベル名はマシンにとって単なるランダムな文字列にすぎません。「door」というラベルと「door_with_knob」という別のラベルがある場合、マシンにはそのラベルが付いた動画以外にニュアンスを把握する方法はありません。

- 真陽性と真陰性のサンプルを追加してデータを強化してください。 特に重要なのは、決定境界に近いサンプルです。

変更が完了したら、十分に高い品質水準に達するまで、モデルをトレーニングして評価します。