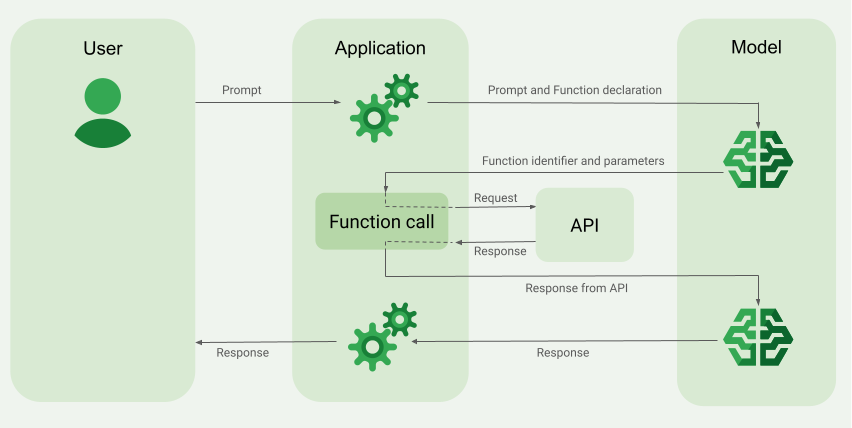

A chamada de função, também conhecida como uso de ferramentas, fornece ao LLM definições de ferramentas externas (por exemplo, uma função get_current_weather). Ao processar um comando, o modelo determina de forma inteligente se uma ferramenta é necessária e, em caso afirmativo, gera dados estruturados especificando a ferramenta a ser chamada e os parâmetros dela (por exemplo, get_current_weather(location='Boston')). Em seguida, seu aplicativo executa essa ferramenta e envia o resultado de volta ao modelo, permitindo que ele conclua a resposta com informações dinâmicas e do mundo real ou o resultado de uma ação. Isso conecta o LLM aos seus sistemas e amplia os recursos dele.

As chamadas de função permitem dois casos de uso principais:

Busca de dados: recupere informações atualizadas para respostas do modelo, como clima atual, conversão de moeda ou dados específicos de bases de conhecimento e APIs (RAG).

Realizar ações: execute operações externas, como enviar formulários, atualizar o estado do aplicativo ou orquestrar fluxos de trabalho de agentes (por exemplo, transferências de conversa).

Para mais casos de uso e exemplos com tecnologia de chamada de função, consulte Casos de uso.

Recursos e limitações

Os modelos a seguir oferecem suporte à chamada de função:

Modelos do Gemini:

- Gemini 2.5 Flash-Lite

- Gemini 2.5 Flash com áudio nativo da API Live (pré-lançamento)

- Gemini 2.0 Flash com API Live (pré-lançamento)

- Otimizador de modelos da Vertex AI (experimental)

- Gemini 2.5 Pro

- Gemini 2.5 Flash

- Gemini 2.0 Flash

- Gemini 2.0 Flash-Lite

Modelos abertos:

É possível especificar até 512

FunctionDeclarationsDefina suas funções no formato de esquema da OpenAPI.

Para conferir as práticas recomendadas relacionadas às declarações de função, incluindo dicas para nomes e descrições, consulte Práticas recomendadas.

Para modelos abertos, siga este guia do usuário.

Como criar um aplicativo de chamada de função

Para usar a chamada de função, faça o seguinte:

Etapa 1: enviar o comando e as declarações de função para o modelo

Declare um Tool em um formato de esquema compatível com o esquema da OpenAPI. Para mais informações, consulte Exemplos de esquemas.

Os exemplos a seguir enviam um comando e uma declaração de função aos modelos do Gemini.

REST

PROJECT_ID=myproject

LOCATION=us-central1

MODEL_ID=gemini-2.0-flash-001

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://${LOCATION}-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/${LOCATION}/publishers/google/models/${MODEL_ID}:generateContent \

-d '{

"contents": [{

"role": "user",

"parts": [{

"text": "What is the weather in Boston?"

}]

}],

"tools": [{

"functionDeclarations": [

{

"name": "get_current_weather",

"description": "Get the current weather in a given location",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "The city name of the location for which to get the weather.",

"default": {

"string_value": "Boston, MA"

}

}

},

"required": [

"location"

]

}

}

]

}]

}'

Python

É possível especificar o esquema manualmente usando um dicionário Python ou automaticamente com a função auxiliar from_func. O exemplo a seguir demonstra como declarar uma função manualmente.

import vertexai

from vertexai.generative_models import (

Content,

FunctionDeclaration,

GenerationConfig,

GenerativeModel,

Part,

Tool,

ToolConfig

)

# Initialize Vertex AI

# TODO(developer): Update the project

vertexai.init(project="PROJECT_ID", location="us-central1")

# Initialize Gemini model

model = GenerativeModel(model_name="gemini-2.0-flash")

# Manual function declaration

get_current_weather_func = FunctionDeclaration(

name="get_current_weather",

description="Get the current weather in a given location",

# Function parameters are specified in JSON schema format

parameters={

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "The city name of the location for which to get the weather.",

"default": {

"string_value": "Boston, MA"

}

}

},

},

)

response = model.generate_content(

contents = [

Content(

role="user",

parts=[

Part.from_text("What is the weather like in Boston?"),

],

)

],

generation_config = GenerationConfig(temperature=0),

tools = [

Tool(

function_declarations=[get_current_weather_func],

)

]

)

Como alternativa, você pode declarar a função automaticamente com a função auxiliar from_func, conforme mostrado no exemplo a seguir:

def get_current_weather(location: str = "Boston, MA"):

"""

Get the current weather in a given location

Args:

location: The city name of the location for which to get the weather.

"""

# This example uses a mock implementation.

# You can define a local function or import the requests library to call an API

return {

"location": "Boston, MA",

"temperature": 38,

"description": "Partly Cloudy",

"icon": "partly-cloudy",

"humidity": 65,

"wind": {

"speed": 10,

"direction": "NW"

}

}

get_current_weather_func = FunctionDeclaration.from_func(get_current_weather)

Node.js

Este exemplo demonstra um cenário de texto com uma só função e um só comando.

Node.js

Antes de testar essa amostra, siga as instruções de configuração para Node.js Guia de início rápido da Vertex AI: como usar bibliotecas de cliente. Para mais informações, consulte a documentação de referência da API Vertex AI para Node.js.

Para autenticar na Vertex AI, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Go

Este exemplo demonstra um cenário de texto com uma só função e um só comando.

Saiba como instalar ou atualizar o Go.

Para saber mais, consulte a documentação de referência do SDK.

Defina variáveis de ambiente para usar o SDK de IA generativa com a Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

C#

Este exemplo demonstra um cenário de texto com uma só função e um só comando.

C#

Antes de testar esse exemplo, siga as instruções de configuração para C# no Guia de início rápido da Vertex AI sobre como usar bibliotecas de cliente. Para mais informações, consulte a documentação de referência da API Vertex AI para C#.

Para autenticar na Vertex AI, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Java

Java

Antes de testar esse exemplo, siga as instruções de configuração para Java no Guia de início rápido da Vertex AI sobre como usar bibliotecas de cliente. Para mais informações, consulte a documentação de referência da API Vertex AI para Java.

Para autenticar na Vertex AI, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Se o modelo determinar que precisa da saída de uma função específica, a resposta que o aplicativo recebe do modelo conterá o nome da função e os valores de parâmetro com os quais a função precisa ser chamada.

Veja a seguir um exemplo de resposta de modelo para o comando do usuário "Como está o clima em Boston?". O modelo propõe chamar a função get_current_weather com o parâmetro Boston, MA.

candidates {

content {

role: "model"

parts {

function_call {

name: "get_current_weather"

args {

fields {

key: "location"

value {

string_value: "Boston, MA"

}

}

}

}

}

}

...

}

Etapa 2: fornecer a saída da API ao modelo

Invoque a API externa e transmita a saída dela de volta ao modelo.

O exemplo a seguir usa dados sintéticos para simular um payload de resposta de uma API externa e envia a saída de volta ao modelo.

REST

PROJECT_ID=myproject

MODEL_ID=gemini-2.0-flash

LOCATION="us-central1"

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://${LOCATION}-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/${LOCATION}/publishers/google/models/${MODEL_ID}:generateContent \

-d '{

"contents": [

{

"role": "user",

"parts": {

"text": "What is the weather in Boston?"

}

},

{

"role": "model",

"parts": [

{

"functionCall": {

"name": "get_current_weather",

"args": {

"location": "Boston, MA"

}

}

}

]

},

{

"role": "user",

"parts": [

{

"functionResponse": {

"name": "get_current_weather",

"response": {

"temperature": 20,

"unit": "C"

}

}

}

]

}

],

"tools": [

{

"function_declarations": [

{

"name": "get_current_weather",

"description": "Get the current weather in a specific location",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "The city name of the location for which to get the weather."

}

},

"required": [

"location"

]

}

}

]

}

]

}'

Python

function_response_contents = []

function_response_parts = []

# Iterates through the function calls in the response in case there are parallel function call requests

for function_call in response.candidates[0].function_calls:

print(f"Function call: {function_call.name}")

# In this example, we'll use synthetic data to simulate a response payload from an external API

if (function_call.args['location'] == "Boston, MA"):

api_response = { "location": "Boston, MA", "temperature": 38, "description": "Partly Cloudy" }

if (function_call.args['location'] == "San Francisco, CA"):

api_response = { "location": "San Francisco, CA", "temperature": 58, "description": "Sunny" }

function_response_parts.append(

Part.from_function_response(

name=function_call.name,

response={"contents": api_response}

)

)

# Add the function call response to the contents

function_response_contents = Content(role="user", parts=function_response_parts)

# Submit the User's prompt, model's response, and API output back to the model

response = model.generate_content(

[

Content( # User prompt

role="user",

parts=[

Part.from_text("What is the weather like in Boston?"),

],

),

response.candidates[0].content, # Function call response

function_response_contents # API output

],

tools=[

Tool(

function_declarations=[get_current_weather_func],

)

],

)

# Get the model summary response

print(response.text)

Para conferir as práticas recomendadas relacionadas à invocação de API, consulte Práticas recomendadas: invocação de API.

Se o modelo propôs várias chamadas de função paralelas, o aplicativo precisa fornecer todas as respostas de volta ao modelo. Para saber mais, consulte o Exemplo de chamada de função paralela.

O modelo pode determinar que a saída de outra função é necessária para responder ao comando. Nesse caso, a resposta que o aplicativo recebe do modelo contém outro nome de função e outro conjunto de valores de parâmetro.

Se o modelo determinar que a resposta da API é suficiente para responder ao comando do usuário, ele criará uma resposta com linguagem natural e a retornará para o aplicativo. Nesse caso, o aplicativo precisa transmitir a resposta de volta ao usuário. Confira a seguir um exemplo de resposta de linguagem natural:

It is currently 38 degrees Fahrenheit in Boston, MA with partly cloudy skies.

Chamada de função com reflexões

Ao chamar funções com a reflexão ativada, você

precisa extrair o thought_signature do

objeto de resposta do modelo e retorná-lo ao enviar o resultado da execução da função

de volta ao modelo. Exemplo:

Python

# Call the model with function declarations

# ...Generation config, Configure the client, and Define user prompt (No changes)

# Send request with declarations (using a thinking model)

response = client.models.generate_content(

model="gemini-2.5-flash", config=config, contents=contents)

# See thought signatures

for part in response.candidates[0].content.parts:

if not part.text:

continue

if part.thought and part.thought_signature:

print("Thought signature:")

print(part.thought_signature)

Não é necessário ver as assinaturas de pensamento, mas você precisa ajustar a Etapa 2 para retorná-las com o resultado da execução da função. Assim, ela pode incorporar os pensamentos à resposta final:

Python

# Create user friendly response with function result and call the model again

# ...Create a function response part (No change)

# Append thought signatures, function call and result of the function execution to contents

function_call_content = response.candidates[0].content

# Append the model's function call message, which includes thought signatures

contents.append(function_call_content)

contents.append(types.Content(role="user", parts=[function_response_part])) # Append the function response

final_response = client.models.generate_content(

model="gemini-2.5-flash",

config=config,

contents=contents,

)

print(final_response.text)

Ao retornar assinaturas de pensamento, siga estas diretrizes:

- O modelo retorna assinaturas em outras partes da resposta, por exemplo, chamadas de função ou texto, texto ou partes de resumo de pensamento. Retorne a resposta inteira com todas as partes ao modelo em rodadas subsequentes.

- Não mescle uma parte com uma assinatura com outra parte que também contenha uma assinatura. Não é possível concatenar assinaturas.

- Não mescle uma parte com uma assinatura com outra sem assinatura. Isso prejudica o posicionamento correto do pensamento representado pela assinatura.

Saiba mais sobre as limitações e o uso de assinaturas de pensamento e sobre modelos de pensamento em geral na página Pensamento.

Chamada de função paralela

Para comandos como "Receber detalhes do clima em Boston e São Francisco?", o modelo pode propor várias chamadas de função paralelas. Para conferir uma lista de modelos que oferecem suporte à chamada de função paralela, consulte Modelos compatíveis.

REST

Este exemplo demonstra um cenário com uma função get_current_weather.

O comando do usuário é "Receber detalhes do clima em Boston e São Francisco?". O

modelo propõe duas chamadas de função get_current_weather paralelas: uma com o

parâmetro Boston e outra com o parâmetro San Francisco.

Para saber mais sobre os parâmetros de solicitação, consulte a API Gemini.

{

"candidates": [

{

"content": {

"role": "model",

"parts": [

{

"functionCall": {

"name": "get_current_weather",

"args": {

"location": "Boston"

}

}

},

{

"functionCall": {

"name": "get_current_weather",

"args": {

"location": "San Francisco"

}

}

}

]

},

...

}

],

...

}

O comando a seguir demonstra como fornecer a saída da função para o modelo. Substitua my-project pelo nome do seu projeto Google Cloud .

Solicitação de modelo

PROJECT_ID=my-project

MODEL_ID=gemini-2.0-flash

LOCATION="us-central1"

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://${LOCATION}-aiplatform.googleapis.com/v1/projects/${PROJECT_ID}/locations/${LOCATION}/publishers/google/models/${MODEL_ID}:generateContent \

-d '{

"contents": [

{

"role": "user",

"parts": {

"text": "What is difference in temperature in Boston and San Francisco?"

}

},

{

"role": "model",

"parts": [

{

"functionCall": {

"name": "get_current_weather",

"args": {

"location": "Boston"

}

}

},

{

"functionCall": {

"name": "get_current_weather",

"args": {

"location": "San Francisco"

}

}

}

]

},

{

"role": "user",

"parts": [

{

"functionResponse": {

"name": "get_current_weather",

"response": {

"temperature": 30.5,

"unit": "C"

}

}

},

{

"functionResponse": {

"name": "get_current_weather",

"response": {

"temperature": 20,

"unit": "C"

}

}

}

]

}

],

"tools": [

{

"function_declarations": [

{

"name": "get_current_weather",

"description": "Get the current weather in a specific location",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "The city name of the location for which to get the weather."

}

},

"required": [

"location"

]

}

}

]

}

]

}'

A resposta de linguagem natural criada pelo modelo é semelhante a esta:

Resposta do modelo

[

{

"candidates": [

{

"content": {

"parts": [

{

"text": "The temperature in Boston is 30.5C and the temperature in San Francisco is 20C. The difference is 10.5C. \n"

}

]

},

"finishReason": "STOP",

...

}

]

...

}

]

Python

Este exemplo demonstra um cenário com uma função get_current_weather.

O comando do usuário é "Como está o clima em Boston e São Francisco?".

Substitua my-project pelo nome do seu projeto Google Cloud .

import vertexai

from vertexai.generative_models import (

Content,

FunctionDeclaration,

GenerationConfig,

GenerativeModel,

Part,

Tool,

ToolConfig

)

# Initialize Vertex AI

# TODO(developer): Update the project

vertexai.init(project="my-project", location="us-central1")

# Initialize Gemini model

model = GenerativeModel(model_name="gemini-2.0-flash")

# Manual function declaration

get_current_weather_func = FunctionDeclaration(

name="get_current_weather",

description="Get the current weather in a given location",

# Function parameters are specified in JSON schema format

parameters={

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "The city name of the location for which to get the weather.",

"default": {

"string_value": "Boston, MA"

}

}

},

},

)

response = model.generate_content(

contents = [

Content(

role="user",

parts=[

Part.from_text("What is the weather like in Boston and San Francisco?"),

],

)

],

generation_config = GenerationConfig(temperature=0),

tools = [

Tool(

function_declarations=[get_current_weather_func],

)

]

)

O comando a seguir demonstra como fornecer a saída da função para o modelo.

function_response_contents = []

function_response_parts = []

# You can have parallel function call requests for the same function type.

# For example, 'location_to_lat_long("London")' and 'location_to_lat_long("Paris")'

# In that case, collect API responses in parts and send them back to the model

for function_call in response.candidates[0].function_calls:

print(f"Function call: {function_call.name}")

# In this example, we'll use synthetic data to simulate a response payload from an external API

if (function_call.args['location'] == "Boston, MA"):

api_response = { "location": "Boston, MA", "temperature": 38, "description": "Partly Cloudy" }

if (function_call.args['location'] == "San Francisco, CA"):

api_response = { "location": "San Francisco, CA", "temperature": 58, "description": "Sunny" }

function_response_parts.append(

Part.from_function_response(

name=function_call.name,

response={"contents": api_response}

)

)

# Add the function call response to the contents

function_response_contents = Content(role="user", parts=function_response_parts)

function_response_contents

response = model.generate_content(

contents = [

Content(

role="user",

parts=[

Part.from_text("What is the weather like in Boston and San Francisco?"),

],

), # User prompt

response.candidates[0].content, # Function call response

function_response_contents, # Function response

],

tools = [

Tool(

function_declarations=[get_current_weather_func],

)

]

)

# Get the model summary response

print(response.text)

Go

Modos de chamada de função

É possível controlar como o modelo usa as ferramentas fornecidas (declarações de função) definindo o modo no function_calling_config.

| Modo | Descrição |

|---|---|

AUTO |

O comportamento padrão do modelo. O modelo decide se quer prever chamadas de função ou responder com linguagem natural com base no contexto. Esse é o modo mais flexível e recomendado para a maioria dos cenários. |

VALIDATED (Visualização prévia) |

O modelo é restrito a prever chamadas de função ou linguagem natural e garante a adesão ao esquema de função. Se allowed_function_names não for fornecido, o modelo vai escolher entre todas as declarações de função disponíveis. Se allowed_function_names for fornecido, o modelo vai escolher entre o conjunto de funções permitidas. |

ANY |

O modelo é restrito a sempre prever uma ou mais chamadas de função e garante a adesão ao esquema de função. Se allowed_function_names não for fornecido, o modelo vai escolher entre todas as declarações de função disponíveis. Se allowed_function_names for fornecido, o modelo vai escolher entre o conjunto de funções permitidas. Use esse modo quando precisar de uma resposta de chamada de função para cada comando (se aplicável). |

NONE |

O modelo é proibido de fazer chamadas de função. Isso é equivalente a enviar uma solicitação sem declarações de função. Use esse modo para desativar temporariamente a chamada de função sem remover as definições de ferramentas. |

Chamada de função forçada

Em vez de permitir que o modelo escolha entre uma resposta de linguagem natural e uma chamada de função, é possível forçá-lo a prever apenas chamadas de função. Isso é conhecido como chamada de função forçada. Também é possível fornecer ao modelo um conjunto completo de declarações de função, mas restringir as respostas a um subconjunto dessas funções.

O exemplo a seguir é forçado a prever apenas chamadas de função get_weather.

Python

response = model.generate_content(

contents = [

Content(

role="user",

parts=[

Part.from_text("What is the weather like in Boston?"),

],

)

],

generation_config = GenerationConfig(temperature=0),

tools = [

Tool(

function_declarations=[get_weather_func, some_other_function],

)

],

tool_config=ToolConfig(

function_calling_config=ToolConfig.FunctionCallingConfig(

# ANY mode forces the model to predict only function calls

mode=ToolConfig.FunctionCallingConfig.Mode.ANY,

# Allowed function calls to predict when the mode is ANY. If empty, any of

# the provided function calls will be predicted.

allowed_function_names=["get_weather"],

)

)

)

Exemplos de esquema de função

As declarações de função são compatíveis com o esquema da OpenAPI. Aceitamos os seguintes atributos: type, nullable, required, format, description, properties, items, enum, anyOf, $ref e $defs. Os atributos restantes não são compatíveis.

Função com parâmetros de objeto e matriz

O exemplo a seguir usa um dicionário Python para declarar uma função que usa parâmetros de objeto e matriz:

extract_sale_records_func = FunctionDeclaration( name="extract_sale_records", description="Extract sale records from a document.", parameters={ "type": "object", "properties": { "records": { "type": "array", "description": "A list of sale records", "items": { "description": "Data for a sale record", "type": "object", "properties": { "id": {"type": "integer", "description": "The unique id of the sale."}, "date": {"type": "string", "description": "Date of the sale, in the format of MMDDYY, e.g., 031023"}, "total_amount": {"type": "number", "description": "The total amount of the sale."}, "customer_name": {"type": "string", "description": "The name of the customer, including first name and last name."}, "customer_contact": {"type": "string", "description": "The phone number of the customer, e.g., 650-123-4567."}, }, "required": ["id", "date", "total_amount"], }, }, }, "required": ["records"], }, )

Função com parâmetro de enumeração

O exemplo a seguir usa um dicionário Python para declarar uma função que usa um parâmetro inteiro enum:

set_status_func = FunctionDeclaration( name="set_status", description="set a ticket's status field", # Function parameters are specified in JSON schema format parameters={ "type": "object", "properties": { "status": { "type": "integer", "enum": [ "10", "20", "30" ], # Provide integer (or any other type) values as strings. } }, }, )

Função com ref e def

A declaração de função JSON a seguir usa os atributos ref e defs:

{ "contents": ..., "tools": [ { "function_declarations": [ { "name": "get_customer", "description": "Search for a customer by name", "parameters": { "type": "object", "properties": { "first_name": { "ref": "#/defs/name" }, "last_name": { "ref": "#/defs/name" } }, "defs": { "name": { "type": "string" } } } } ] } ] }

Observações sobre o uso:

- Ao contrário do esquema OpenAPI, especifique

refedefssem o símbolo$. refprecisa se referir ao filho direto dedefs. Não são permitidas referências externas.- A profundidade máxima do esquema aninhado é 32.

- A profundidade de recursão em

defs(autorreferência) é limitada a dois.

from_func com parâmetro de matriz

O exemplo de código abaixo declara uma função que multiplica uma matriz de números e usa from_func para gerar o esquema FunctionDeclaration.

from typing import List # Define a function. Could be a local function or you can import the requests library to call an API def multiply_numbers(numbers: List[int] = [1, 1]) -> int: """ Calculates the product of all numbers in an array. Args: numbers: An array of numbers to be multiplied. Returns: The product of all the numbers. If the array is empty, returns 1. """ if not numbers: # Handle empty array return 1 product = 1 for num in numbers: product *= num return product multiply_number_func = FunctionDeclaration.from_func(multiply_numbers) """ multiply_number_func contains the following schema: {'name': 'multiply_numbers', 'description': 'Calculates the product of all numbers in an array.', 'parameters': {'properties': {'numbers': {'items': {'type': 'INTEGER'}, 'description': 'list of numbers', 'default': [1.0, 1.0], 'title': 'Numbers', 'type': 'ARRAY'}}, 'description': 'Calculates the product of all numbers in an array.', 'title': 'multiply_numbers', 'property_ordering': ['numbers'], 'type': 'OBJECT'}} """

Práticas recomendadas para chamadas de função

Escreva nomes de funções, descrições de parâmetros e instruções claras e detalhadas.

Os nomes de funções precisam começar com uma letra ou um sublinhado e conter apenas caracteres a-z, A-Z, 0-9, sublinhados, pontos ou traços com um tamanho máximo de 64.

Seja extremamente claro e específico nas descrições de funções e parâmetros. O modelo depende deles para escolher a função correta e fornecer argumentos adequados. Por exemplo, uma função

book_flight_ticketpode ter a descriçãobook flight tickets after confirming users' specific requirements, such as time, departure, destination, party size and preferred airline

Usar parâmetros fortemente tipados

Se os valores de parâmetro forem de um conjunto finito, adicione um campo enum em vez de colocar o conjunto de valores na descrição. Se o valor do parâmetro for sempre um número inteiro, defina o tipo como integer em vez de number.

Seleção de ferramentas

Embora o modelo possa usar um número arbitrário de ferramentas, fornecer muitas pode aumentar o risco de selecionar uma ferramenta incorreta ou inadequada. Para ter os melhores resultados, forneça apenas as ferramentas relevantes para o contexto ou a tarefa, mantendo o conjunto ativo em um máximo de 10 a 20. Se você tiver um grande número total de ferramentas, considere a seleção dinâmica com base no contexto da conversa.

Se você fornecer ferramentas genéricas de baixo nível (como bash), o modelo poderá usar a ferramenta com mais frequência, mas com menos precisão. Se você fornecer uma ferramenta específica de alto nível (como get_weather), o modelo poderá usá-la com mais precisão, mas ela não será usada com tanta frequência.

Usar as instruções de sistema

Ao usar funções com parâmetros de data, hora ou local, inclua a data, a hora ou as informações de local relevantes (por exemplo, cidade e país) na instrução do sistema. Isso fornece ao modelo o contexto necessário para processar a solicitação com precisão, mesmo que o comando do usuário não tenha detalhes.

Engenharia de comando

Para melhores resultados, adicione ao início os seguintes detalhes antes do comando do usuário:

- Contexto adicional para o modelo, por exemplo,

You are a flight API assistant to help with searching flights based on user preferences.. - Detalhes ou instruções sobre como e quando usar as funções, por exemplo,

Don't make assumptions on the departure or destination airports. Always use a future date for the departure or destination time. - Instruções para fazer perguntas esclarecedoras se as consultas do usuário forem ambíguas, por exemplo,

Ask clarifying questions if not enough information is available.

Usar a configuração de geração

Para o parâmetro de temperatura, use 0 ou outro valor baixo. Isso instrui o modelo a gerar resultados mais confiáveis e reduz alucinações.

Validar a chamada de API

Se o modelo propor a invocação de uma função que envia uma ordem, atualiza um banco de dados ou tem consequências significativas, valide a chamada de função com o usuário antes de executá-la.

Usar assinaturas de pensamento

As assinaturas de pensamento devem sempre ser usadas com a chamada de função para ter os melhores resultados.

Preços

Os preços da chamada de funções são baseados no número de caracteres nas entradas e saídas de texto. Para saber mais, consulte os preços da Vertex AI.

Aqui, a entrada de texto (comando) se refere ao comando do usuário sobre o turno da conversa atual, as declarações de função para o turno da conversa atual e o histórico da conversa. O histórico da conversa inclui as consultas, as chamadas de função e as respostas de função das interações anteriores. A Vertex AI trunca o histórico da conversa em 32.000 caracteres.

Saída de texto (resposta) refere-se às chamadas de função e às respostas de texto da rodada de conversa atual.

Casos de uso de chamada de funções

É possível usar a chamada de função para as seguintes tarefas:

| Caso de uso | Exemplo de descrição | Link de exemplo |

|---|---|---|

| Integrar com APIs externas | Receber informações sobre o clima usando uma API meteorológica | Tutorial do notebook |

| Converter endereços em coordenadas de latitude/longitude | Tutorial do notebook | |

| Converter moedas usando uma API de câmbio | Codelab | |

| Criar chatbots avançados | Responder às perguntas dos clientes sobre produtos e serviços | Tutorial do notebook |

| Criar um assistente para responder a perguntas financeiras e de notícias sobre empresas | Tutorial do notebook | |

| Estruturar e controlar chamadas de função | Extrair entidades estruturadas de dados de registro brutos | Tutorial do notebook |

| Extrair um ou vários parâmetros da entrada do usuário | Tutorial do notebook | |

| Processar listas e estruturas de dados aninhadas em chamadas de função | Tutorial do notebook | |

| Lidar com o comportamento da chamada de função | Processar chamadas e respostas de função paralelas | Tutorial do notebook |

| Gerenciar quando e quais funções o modelo pode chamar | Tutorial do notebook | |

| Consultar bancos de dados com linguagem natural | Converter perguntas em linguagem natural em consultas SQL para o BigQuery | App de exemplo |

| Chamada de função multimodal | Usar imagens, vídeos, áudio e PDFs como entrada para acionar chamadas de função | Tutorial do notebook |

Confira outros casos de uso:

Interpretar comandos de voz: crie funções que correspondam a tarefas no veículo. Por exemplo, crie funções que liguem o rádio ou ativem o ar-condicionado. Envie arquivos de áudio com os comandos de voz do usuário ao modelo e peça que ele converta o áudio em texto e identifique a função que o usuário quer chamar.

Automatizar fluxos de trabalho com base em gatilhos ambientais: crie funções para representar processos que podem ser automatizados. Forneça dados de sensores ambientais ao modelo e peça que ele analise e processe os dados para determinar se um ou mais fluxos de trabalho precisam ser ativados. Por exemplo, um modelo pode processar dados de temperatura em um armazém e ativar uma função de sprinkler.

Automatizar a atribuição de tíquetes de suporte: forneça ao modelo tíquetes de suporte, registros e regras baseadas no contexto. Peça ao modelo para processar todas essas informações e determinar a quem o tíquete será atribuído. Chame uma função para atribuir o tíquete à pessoa sugerida pelo modelo.

Recuperar informações de uma base de conhecimento: crie funções que recuperem e resumam artigos acadêmicos sobre um determinado assunto. Permita que o modelo responda perguntas sobre matérias acadêmicas e forneça citações das respectivas respostas.

A seguir

Consulte a referência da API para chamada de função.

Saiba mais sobre o Vertex AI Agent Engine.