La función de ejecución de código de la API de Gemini permite que el modelo genere y ejecute código de Python, y aprenda de forma iterativa a partir de los resultados hasta llegar a un resultado final. Puedes usar esta función de ejecución de código para crear aplicaciones que se beneficien del razonamiento basado en código y que produzcan resultados de texto. Por ejemplo, puedes usar la ejecución de código en una aplicación que resuelve ecuaciones o procesa texto.

La API de Gemini proporciona la ejecución de código como una herramienta, de forma similar a las llamadas a funciones. Después de que agregas la ejecución de código como herramienta, el modelo decide cuándo usarla.

El entorno de ejecución de código incluye las siguientes bibliotecas. No puedes instalar tus propias bibliotecas.

- Altair

- Chess

- Cv2

- Matplotlib

- Mpmath

- NumPy

- Pandas

- Pdfminer

- Reportlab

- Seaborn

- Sklearn

- Statsmodels

- Striprtf

- SymPy

- Tabulate

Modelos compatibles

Los siguientes modelos proporcionan compatibilidad para la ejecución de código:

- Gemini 2.5 Flash (versión preliminar)

- Gemini 2.5 Flash-Lite (versión preliminar)

- Gemini 2.5 Flash-Lite

- Gemini 2.0 Flash con la API en vivo (versión preliminar)

- Gemini 2.5 Pro

- Gemini 2.5 Flash

- Gemini 2.0 Flash

Comienza a ejecutar código

En esta sección, se supone que completaste los pasos de configuración que se muestran en la guía de inicio rápido de la API de Gemini.

Habilita la ejecución de código en el modelo

Puedes habilitar la ejecución de código básica como se muestra aquí:

Python

Instalar

pip install --upgrade google-genai

Para obtener más información, consulta la documentación de referencia del SDK.

Establece variables de entorno para usar el SDK de IA generativa con Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

Go

Obtén más información para instalar o actualizar Go.

Para obtener más información, consulta la documentación de referencia del SDK.

Establece variables de entorno para usar el SDK de IA generativa con Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

Node.js

Instalar

npm install @google/genai

Para obtener más información, consulta la documentación de referencia del SDK.

Establece variables de entorno para usar el SDK de IA generativa con Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

Java

Obtén más información para instalar o actualizar Java.

Para obtener más información, consulta la documentación de referencia del SDK.

Establece variables de entorno para usar el SDK de IA generativa con Vertex AI:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=global export GOOGLE_GENAI_USE_VERTEXAI=True

REST

Antes de usar cualquiera de los datos de solicitud a continuación, realiza los siguientes reemplazos:

GENERATE_RESPONSE_METHOD: El tipo de respuesta que quieres que genere el modelo. Elige un método que genere cómo quieres que se muestre la respuesta del modelo:streamGenerateContent: La respuesta se transmite a medida que se genera para reducir la percepción de latencia para un público humano.generateContent: La respuesta se muestra después de que se genera por completo.

LOCATION: La región para procesar la solicitud. Las opciones disponibles incluyen las siguientes:Haz clic para expandir una lista parcial de regiones disponibles

us-central1us-west4northamerica-northeast1us-east4us-west1asia-northeast3asia-southeast1asia-northeast1

PROJECT_ID: El ID del proyecto.MODEL_ID: Es el ID del modelo que deseas usar.ROLE: El rol en una conversación asociada con el contenido. Especificar un rol es obligatorio incluso en casos de uso de un solo turno. Los valores aceptables son los siguientes:USER: especifica el contenido que envías.MODEL: especifica la respuesta del modelo.

TEXT

Para enviar tu solicitud, elige una de estas opciones:

curl

Guarda el cuerpo de la solicitud en un archivo llamado request.json.

Ejecuta el comando siguiente en la terminal para crear o reemplazar este archivo en el directorio actual:

cat > request.json << 'EOF'

{

"tools": [{'codeExecution': {}}],

"contents": {

"role": "ROLE",

"parts": { "text": "TEXT" }

},

}

EOFLuego, ejecuta el siguiente comando para enviar tu solicitud de REST:

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID:GENERATE_RESPONSE_METHOD"

PowerShell

Guarda el cuerpo de la solicitud en un archivo llamado request.json.

Ejecuta el comando siguiente en la terminal para crear o reemplazar este archivo en el directorio actual:

@'

{

"tools": [{'codeExecution': {}}],

"contents": {

"role": "ROLE",

"parts": { "text": "TEXT" }

},

}

'@ | Out-File -FilePath request.json -Encoding utf8Luego, ejecuta el siguiente comando para enviar tu solicitud de REST:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://LOCATION-aiplatform.googleapis.com/v1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID:GENERATE_RESPONSE_METHOD" | Select-Object -Expand Content

Deberías recibir una respuesta JSON similar a la que se muestra a continuación:

Cómo usar la ejecución de código en el chat

También puedes usar la ejecución de código como parte de un chat.

REST

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "Content-Type: application/json" \

https://aiplatform.googleapis.com/v1/projects/test-project/locations/global/publishers/google/models/gemini-2.0-flash-001:generateContent -d \

$'{

"tools": [{'code_execution': {}}],

"contents": [

{

"role": "user",

"parts": {

"text": "Can you print \"Hello world!\"?"

}

},

{

"role": "model",

"parts": [

{

"text": ""

},

{

"executable_code": {

"language": "PYTHON",

"code": "\nprint(\"hello world!\")\n"

}

},

{

"code_execution_result": {

"outcome": "OUTCOME_OK",

"output": "hello world!\n"

}

},

{

"text": "I have printed \"hello world!\" using the provided python code block. \n"

}

],

},

{

"role": "user",

"parts": {

"text": "What is the sum of the first 50 prime numbers? Generate and run code for the calculation, and make sure you get all 50."

}

}

]

}'

Comparación entre la ejecución de código y la llamada a funciones

La ejecución de código y la llamada a funciones son funciones similares:

- La ejecución de código permite que el modelo ejecute código en el backend de la API en un entorno fijo y aislado.

- La llamada a funciones te permite ejecutar las funciones que solicita el modelo en el entorno que desees.

En general, deberías preferir usar la ejecución de código si puede controlar tu caso de uso. La ejecución de código es más fácil de usar (solo debes habilitarla) y se resuelve en una sola solicitud de GenerateContent. La llamada a función requiere una solicitud GenerateContent adicional para devolver el resultado de cada llamada a función.

En la mayoría de los casos, debes usar la llamada a funciones si tienes tus propias funciones que deseas ejecutar de forma local, y debes usar la ejecución de código si deseas que la API escriba y ejecute código Python por ti y devuelva el resultado.

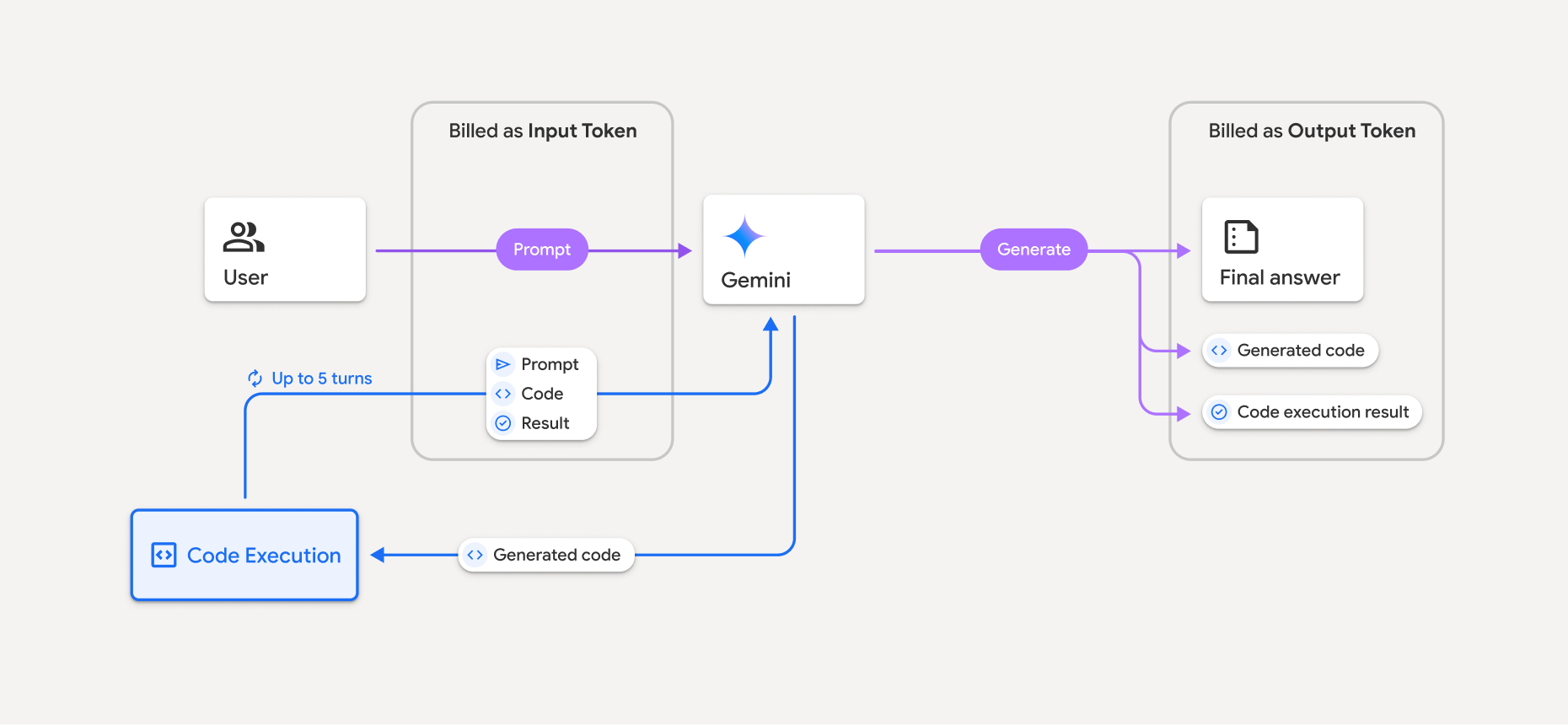

Facturación

No se aplican cargos adicionales por habilitar la ejecución de código desde la API de Gemini. Se te facturará a la tarifa actual de los tokens de entrada y salida según el modelo de Gemini que uses.

A continuación, se incluyen otros aspectos que debes tener en cuenta sobre la facturación de la ejecución de código:

- Solo se te facturará una vez por los tokens de entrada que pases al modelo y los tokens de entrada intermedios que genere la herramienta de ejecución de código.

- Se te facturan los tokens de salida finales que se te devuelven en la respuesta de la API.

- Se te facturará según la tarifa actual de los tokens de entrada y salida en función del modelo de Gemini que uses.

- Si Gemini usa la ejecución de código cuando genera tu respuesta, la instrucción original, el código generado y el resultado del código ejecutado se etiquetan como tokens intermedios y se facturan como tokens de entrada.

- Luego, Gemini genera un resumen y devuelve el código generado, el resultado del código ejecutado y el resumen final. Estos se facturan como tokens de salida.

- La API de Gemini incluye un recuento de tokens intermedio en la respuesta de la API, por lo que puedes hacer un seguimiento de los tokens de entrada adicionales más allá de los que se pasaron en tu instrucción inicial.

El código generado puede incluir texto y resultados multimodales, como imágenes.

Limitaciones

- El modelo solo puede generar y ejecutar código. No puede devolver otros artefactos, como archivos multimedia.

- La herramienta de ejecución de código no admite URIs de archivos como entrada o salida. Sin embargo, la herramienta de ejecución de código admite la entrada de archivos y la salida de gráficos como bytes intercalados. Con estas funciones de entrada y salida, puedes subir archivos CSV y de texto, hacer preguntas sobre los archivos y generar gráficos de Matplotlib como parte del resultado de la ejecución del código.

Los tipos de MIME admitidos para los bytes intercalados son

.cpp,.csv,.java,.jpeg,.js,.png,.py,.tsy.xml. - La ejecución de código puede durar un máximo de 30 segundos antes de que se agote el tiempo de espera.

- En algunos casos, habilitar la ejecución de código puede generar regresiones en otras áreas del resultado del modelo (por ejemplo, escribir un cuento).