En este instructivo, verás un caso de uso común del lanzamiento de una implementación de versiones canary con Cloud Service Mesh.

¿Qué es una implementación de versiones canary?

Una implementación de versiones canary enruta un pequeño porcentaje del tráfico a una nueva versión de un microservicio. Luego, te permite lanzar de forma gradual a toda la base de usuarios, a la vez que elimina y retira la versión anterior. Si algo sale mal durante este proceso, se puede volver a cambiar el tráfico a la versión anterior. Con Cloud Service Mesh, puedes enrutar el tráfico para asegurarte de que se ingresen los servicios nuevos de forma segura.

Costos

En este documento, usarás los siguientes componentes facturables de Google Cloud:

Para generar una estimación de costos en función del uso previsto, usa la calculadora de precios.

Cuando completes el instructivo puedes borrar los recursos que hayas creado para evitar que se te sigan cobrando. Para obtener más información, consulta Cómo realizar una limpieza.

Antes de comenzar

Asegúrate de que la facturación esté habilitada para tu proyecto de Cloud. Descubre cómo confirmar que tienes habilitada la facturación en un proyecto.

Instala Cloud Service Mesh administrado* en un clúster de GKE.

Clone el repositorio:

git clone https://github.com/GoogleCloudPlatform/anthos-service-mesh-samples cd anthos-service-mesh-samples/docs/canary-service

Implementa Online Boutique

Configura el contexto actual de

kubectlen el clúster en el que implementaste Online Boutique:gcloud container clusters get-credentials CLUSTER_NAME \ --project=PROJECT_ID \ --zone=CLUSTER_LOCATIONCrea el espacio de nombres para la aplicación de muestra y la puerta de enlace de entrada:

kubectl create namespace onlineboutiqueEtiqueta el espacio de nombres

onlineboutiquepara insertar de forma automática los proxies de Envoy. Sigue los pasos sobre cómo habilitar la inserción automática de sidecar.Implementa la app de muestra. En este instructivo, implementarás Online Boutique, una app de demostración de microservicios.

kubectl apply \ -n onlineboutique \ -f https://raw.githubusercontent.com/GoogleCloudPlatform/anthos-service-mesh-samples/main/docs/shared/online-boutique/kubernetes-manifests.yamlPara agregar una etiqueta

version=v1a la implementaciónproductcatalog, ejecuta el siguiente comando:kubectl patch deployments/productcatalogservice -p '{"spec":{"template":{"metadata":{"labels":{"version":"v1"}}}}}' \ -n onlineboutiqueVisualiza los servicios que implementaste:

kubectl get pods -n onlineboutiqueResultado esperado:

NAME READY STATUS RESTARTS AGE adservice-85598d856b-m84m6 2/2 Running 0 2m7s cartservice-c77f6b866-m67vd 2/2 Running 0 2m8s checkoutservice-654c47f4b6-hqtqr 2/2 Running 0 2m10s currencyservice-59bc889674-jhk8z 2/2 Running 0 2m8s emailservice-5b9fff7cb8-8nqwz 2/2 Running 0 2m10s frontend-77b88cc7cb-mr4rp 2/2 Running 0 2m9s loadgenerator-6958f5bc8b-55q7w 2/2 Running 0 2m8s paymentservice-68dd9755bb-2jmb7 2/2 Running 0 2m9s productcatalogservice-84f95c95ff-c5kl6 2/2 Running 0 114s recommendationservice-64dc9dfbc8-xfs2t 2/2 Running 0 2m9s redis-cart-5b569cd47-cc2qd 2/2 Running 0 2m7s shippingservice-5488d5b6cb-lfhtt 2/2 Running 0 2m7sTodos los Pods de tu aplicación deben estar en funcionamiento, con un

2/2en la columnaREADY. Esto indica que los Pods tienen un proxy de sidecar de Envoy insertado de forma correcta.Implementa tu

VirtualServiceyDestinationRulepara la v1 deproductcatalog:kubectl apply -f destination-vs-v1.yaml -n onlineboutiqueTen en cuenta que solo

v1está presente en los recursos.Visita la aplicación en tu navegador con la dirección IP externa de tu Ingress:

kubectl get services -n GATEWAY_NAMESPACE

En la siguiente sección, se explorará la IU de Cloud Service Mesh y se mostrará cómo puedes ver tus métricas.

Implementa y ve tus servicios en la consola de Google Cloud

En la consola de Google Cloud, ve a la página Servicios de GKE Enterprise.

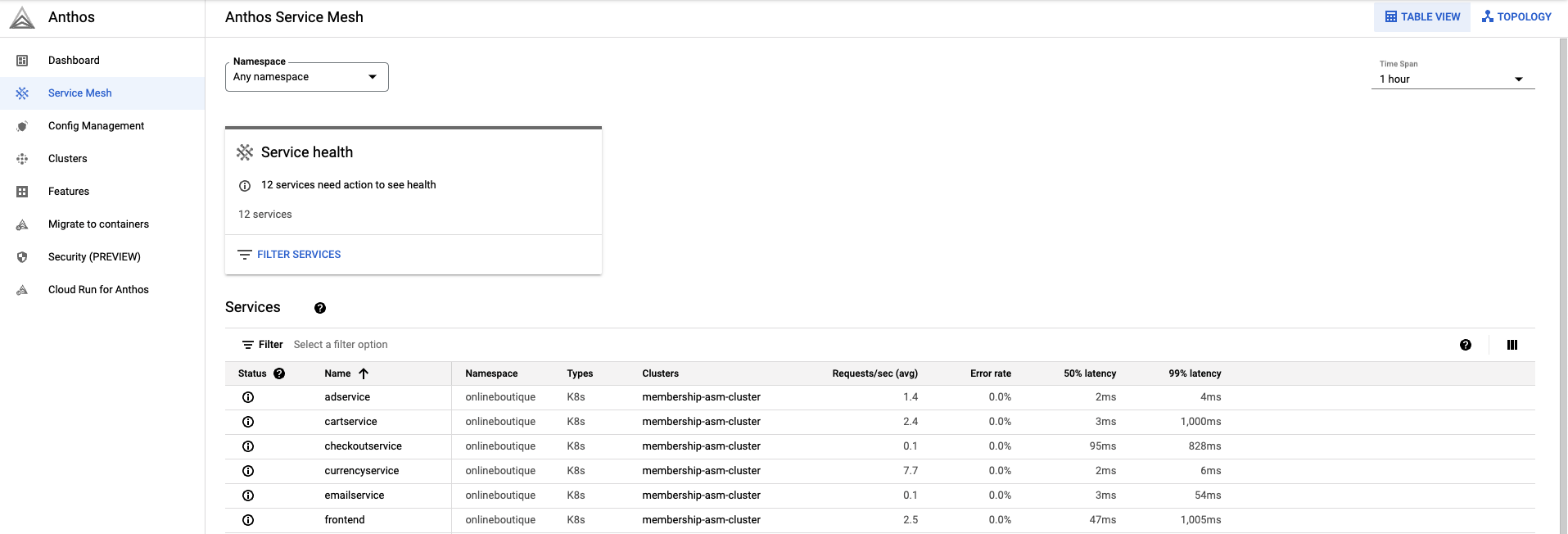

De forma predeterminada, los servicios se ven en la vista Tabla.

La descripción general de la tabla te permite observar todos tus servicios y las métricas importantes con facilidad.

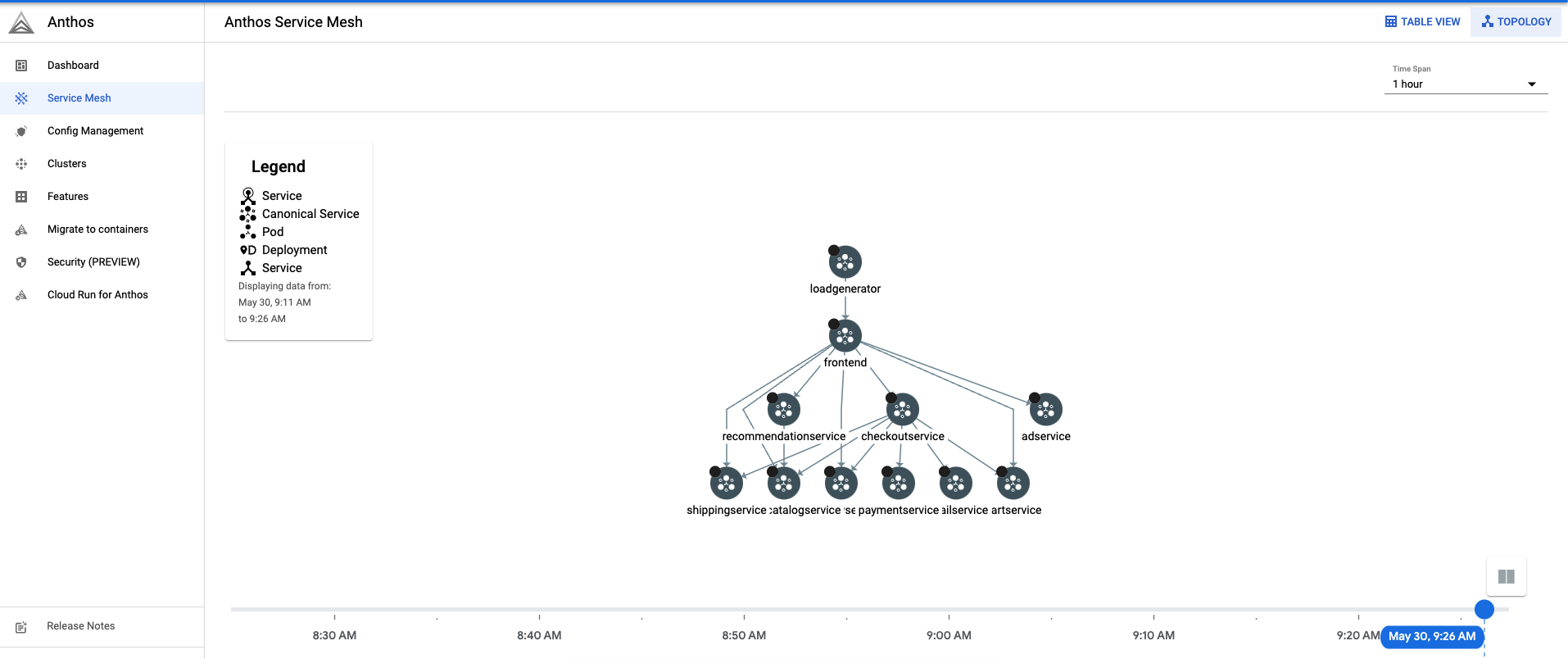

En la esquina superior derecha, haz clic en Topología. Aquí puedes ver tus servicios y su interacción entre sí.

Puedes expandir los servicios y ver las solicitudes por segundo para cada uno de tus servicios si colocas el cursor sobre ellos con el cursor.

Regresa a la Vista de tabla.

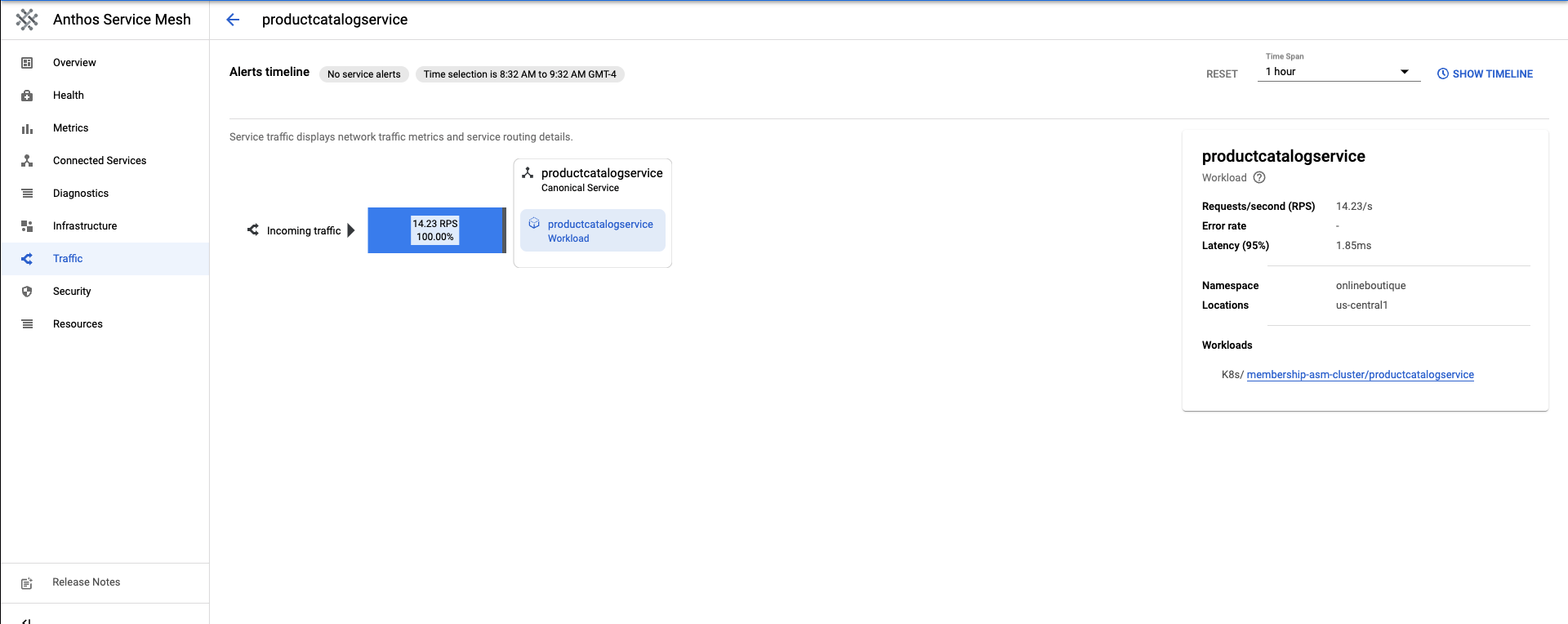

En la Tabla de servicios, selecciona

productcatalogservice. Esto te llevará a una descripción general de tu servicio.En el lado izquierdo de la pantalla, haz clic en Tráfico.

Asegúrate de que el 100% del tráfico entrante a

productcatalogservicevaya al servicio de la carga de trabajo.

En la siguiente sección, se creará una v2 del servicio productcatalog.

Implementa la v2 de un servicio

En este instructivo,

productcatalogservice-v2agregará una latencia de 3 segundos a las solicitudes con el campoEXTRA_LATENCY.Aplica este recurso al espacio de nombres

onlineboutique.kubectl apply -f productcatalog-v2.yaml -n onlineboutiqueVerifica los Pods de tu aplicación.

kubectl get pods -n onlineboutiqueResultado esperado:

NAME READY STATUS RESTARTS AGE adservice-85598d856b-8wqfd 2/2 Running 0 25h cartservice-c77f6b866-7jwcr 2/2 Running 0 25h checkoutservice-654c47f4b6-n8c6x 2/2 Running 0 25h currencyservice-59bc889674-l5xw2 2/2 Running 0 25h emailservice-5b9fff7cb8-jjr89 2/2 Running 0 25h frontend-77b88cc7cb-bwtk4 2/2 Running 0 25h loadgenerator-6958f5bc8b-lqmnw 2/2 Running 0 25h paymentservice-68dd9755bb-dckrj 2/2 Running 0 25h productcatalogservice-84f95c95ff-ddhjv 2/2 Running 0 25h productcatalogservice-v2-6df4cf5475-9lwjb 2/2 Running 0 8s recommendationservice-64dc9dfbc8-7s7cx 2/2 Running 0 25h redis-cart-5b569cd47-vw7lw 2/2 Running 0 25h shippingservice-5488d5b6cb-dj5gd 2/2 Running 0 25hTen en cuenta que ahora hay dos

productcatalogservicesenumerados.DestinationRulees la forma de especificar los subconjuntos de un servicio. En este caso, hay un subconjunto para la v1 y la v2 deproductcatalogservice.Observa el campo

labels. Las versiones deproductcatalogservicese distinguen después de queVirtualServiceenruta el tráfico.Aplica

DestinationRule:kubectl apply -f destination-v1-v2.yaml -n onlineboutique

Divide el tráfico entre v1 y v2

Un

VirtualServicees la manera de ingresar un pequeño porcentaje del tráfico para dirigirlo a la v2 deproductcatalogservice.El campo del subconjunto indica la versión, y el campo de peso indica la división porcentual del tráfico. El 75% del tráfico se dirigirá a v1 de productcatalog y el 25% a v2.

Aplica

VirtualService:kubectl apply -f vs-split-traffic.yaml -n onlineboutique

Si visitas la EXTERNAL_IP de la entrada del clúster, deberías notar que, periódicamente, el frontend es más lento para cargar.

En la siguiente sección, explorarás la división del tráfico en la consola de Google Cloud de GKE Enterprise.

Observa la división del tráfico en la consola de Google Cloud

Regresa a la consola de Google Cloud y ve a la página Servicios de GKE Enterprise Ir a Servicios de GKE Enterprise

En la esquina superior derecha, haz clic en Topología.

Expande la carga de trabajo

productcatalogservice. Verás las implementacionesproductcatalogserviceyproductcatalogservice-v2.

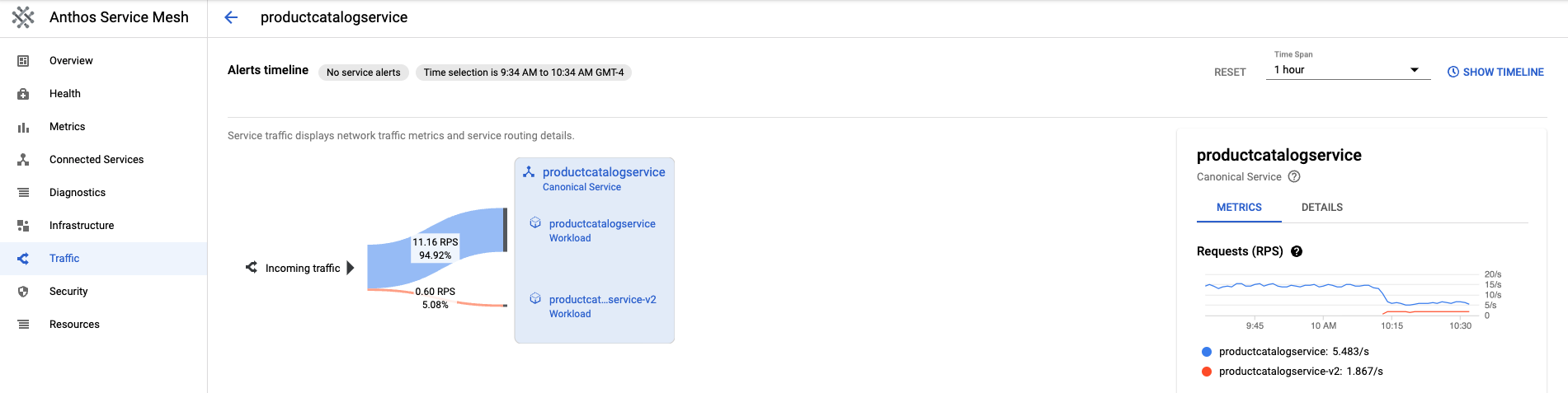

Regresa a la Vista de tabla. Haz clic en

productcatalogserviceen la tabla de servicios. Regrese a Tráfico en la barra de navegación izquierda.Ten en cuenta que el tráfico entrante se divide entre v1 y v2 según el porcentaje especificado en el archivo

VirtualServicey que hay 2 cargas de trabajo del servicio productcatalog.En el lado derecho de la pantalla, verás Solicitudes, Tasa de error y Métricas de latencia. Con Cloud Service Mesh, cada servicio tendrá estas métricas descritas para proporcionarte la observabilidad.

Lanza o revierte a una versión

Después de observar las métricas durante una implementación de versiones canary, puedes lanzar al nuevo servicio o revertir al servicio anterior aprovechando el recurso VirtualService.

Lanzamiento

Una vez que estés satisfecho con el comportamiento de un servicio v2, aumenta de forma gradual el comportamiento del tráfico al servicio v2. Finalmente, el 100% del tráfico se puede dirigir al servicio nuevo.

Para dirigir todo el tráfico a la v2 de productcatalogservice, haz lo siguiente:

kubectl apply -f vs-v2.yaml -n onlineboutique

Revertir

Si necesitas revertir al servicio v1, solo aplica el destination-vs-v1.yaml anterior. Esto dirigirá el tráfico solo a la v1 de productcatalogservice.

Para dirigir todo el tráfico a la v1 de productcatalogservice, haz lo siguiente:

kubectl apply -f vs-v1.yaml -n onlineboutique

Limpia

Para evitar que se apliquen cargos a tu cuenta de Google Cloud por los recursos usados en este instructivo, borra el proyecto que contiene los recursos o conserva el proyecto y borra los recursos individuales.

Para evitar que se apliquen cargos continuos a tu cuenta de Google Cloud por los recursos que se usaron en este instructivo, puedes borrar el proyecto o borrar los recursos individuales.

Borra el proyecto

En Cloud Shell, borra el proyecto:

gcloud projects delete PROJECT_ID

Borra recursos

Si deseas evitar cargos adicionales, borra el clúster:

gcloud container clusters delete CLUSTER_NAME \ --project=PROJECT_ID \ --zone=CLUSTER_LOCATIONSi deseas conservar el clúster y quitar la muestra de Online Retail, realiza la siguiente acción:

Borra los espacios de nombres de la aplicación:

kubectl delete -f namespace onlineboutiqueResultado esperado:

namespace "onlineboutique" deletedBorra las entradas de servicio:

kubectl delete -f https://raw.githubusercontent.com/GoogleCloudPlatform/microservices-demo/main/istio-manifests/frontend.yaml -n onlineboutique kubectl delete -f https://raw.githubusercontent.com/GoogleCloudPlatform/microservices-demo/main/istio-manifests/frontend-gateway.yaml -n onlineboutiqueResultado esperado:

serviceentry.networking.istio.io "allow-egress-googleapis" deleted serviceentry.networking.istio.io "allow-egress-google-metadata" deleted

¿Qué sigue?

- Para obtener una guía general sobre cómo configurar las políticas de

PeerAuthentication, consulta Configura la seguridad de transporte.