Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

Auf dieser Seite wird beschrieben, wie Sie auf das Monitoring-Dashboard für eine Cloud Composer-Umgebung zugreifen und es verwenden.

Eine Anleitung zum Überwachen wichtiger Umgebungsmesswerte finden Sie unter Zustand und Leistung einer Umgebung anhand wichtiger Messwerte überwachen.

Weitere Informationen zu bestimmten Messwerten finden Sie unter Umgebungen mit Cloud Monitoring überwachen.

Auf das Monitoring-Dashboard zugreifen

Das Monitoring-Dashboard enthält Messwerte und Diagramme zur Überwachung von Trends in den DAG-Ausführungen in Ihrer Umgebung sowie zur Identifizierung von Problemen mit Airflow-Komponenten und Cloud Composer-Ressourcen.

So greifen Sie auf das Monitoring-Dashboard für Ihre Umgebung zu:

Rufen Sie in der Google Cloud -Console die Seite Umgebungen auf.

Klicken Sie in der Liste der Umgebungen auf den Namen Ihrer Umgebung. Die Seite Umgebungsdetails wird geöffnet.

Rufen Sie den Tab Monitoring auf.

Benachrichtigungen für Messwerte einrichten

Sie können Benachrichtigungen für einen Messwert einrichten, indem Sie auf das Glockensymbol in der Ecke der Monitoring-Karte klicken.

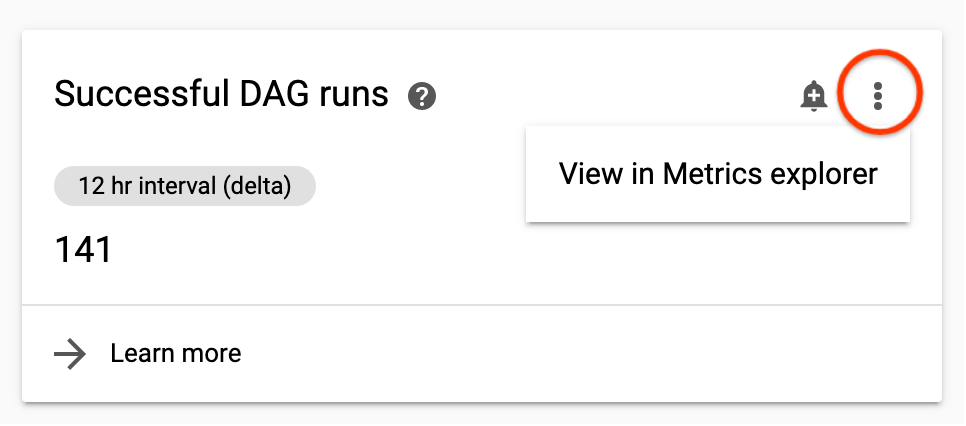

Messwert in Monitoring ansehen

Sie können einen Messwert genauer untersuchen, indem Sie ihn in Monitoring anzeigen.

Klicken Sie auf das Dreipunkt-Menü rechts oben in einer Messwertkarte und wählen Sie Im Metrics Explorer ansehen aus, um das Cloud Composer-Monitoring-Dashboard aufzurufen.

Messwertbeschreibungen

Jede Cloud Composer-Umgebung hat ein eigenes Monitoring-Dashboard. Die Messwerte, die in einem Monitoring-Dashboard für eine bestimmte Umgebung angezeigt werden, erfassen nur die DAG-Ausführungen, Airflow-Komponenten und Umgebungsdetails für diese Umgebung. Wenn Sie beispielsweise zwei Umgebungen haben, werden im Dashboard keine Messwerte aus beiden Umgebungen zusammengefasst.

Umgebungsübersicht

| Umgebungsmesswert | Beschreibung |

|---|---|

| Umgebungsstatus (Airflow-Monitoring-DAG) | Eine Zeitachse, die den Zustand der Composer-Bereitstellung zeigt. Der grüne Status spiegelt nur den Status der Composer-Bereitstellung wider. Er bedeutet nicht, dass alle Airflow-Komponenten betriebsbereit sind und DAGs ausgeführt werden können. |

| Planer-Heartbeat | Eine Zeitachse mit dem Heartbeat des Airflow-Planers. Suchen Sie nach roten Bereichen, um Probleme mit Airflow-Planern zu identifizieren. Wenn Ihre Umgebung mehr als einen Scheduler hat, ist der Herzschlagstatus in Ordnung, solange mindestens einer der Scheduler antwortet. |

| Webserverstatus | Eine Zeitachse mit dem Status des Airflow-Webservers. Dieser Status wird anhand der vom Airflow-Webserver zurückgegebenen HTTP-Statuscodes generiert. |

| Datenbankstatus | Zeitachse, die den Status der Verbindung zur Cloud SQL-Instanz anzeigt, auf der die Airflow-Datenbank gehostet wird. |

| Umgebungsvorgänge | Eine Zeitachse mit Vorgängen, die die Umgebung ändern, z. B. Konfigurationsaktualisierungen oder das Laden von Umgebungs-Snapshots. |

| Wartungsvorgänge | Eine Zeitachse mit Zeiträumen, in denen Wartungsvorgänge auf dem Cluster der Umgebung ausgeführt werden. |

| Umgebungsabhängigkeiten | Eine Zeitachse mit dem Status der Erreichbarkeits- und Berechtigungsprüfungen für die Umgebung. |

DAG-Statistiken

| Umgebungsmesswert | Beschreibung |

|---|---|

| Erfolgreiche DAG-Ausführungen | Die Gesamtzahl der erfolgreichen Ausführungen für alle DAGs in der Umgebung während des ausgewählten Zeitraums. Wenn die Anzahl der erfolgreichen DAG-Ausführungen unter den erwarteten Niveau fällt, kann das auf Fehler (Fehlgeschlagene DAG-Ausführungen) oder auf ein Problem hinweisen. |

| Fehlgeschlagene DAG-Ausführungen Fehlgeschlagene Aufgaben | Gesamtzahl der nicht erfolgreiche Ausführungen für alle DAGs in der Umgebung im ausgewählten Zeitraum. Die Gesamtzahl der Aufgaben, die im ausgewählten Zeitraum in der Umgebung fehlgeschlagen sind. Fehlgeschlagene Aufgaben führen nicht immer zu einem Fehler bei der Ausführung eines DAG. Sie können jedoch ein nützliches Signal für die Fehlerbehebung von DAG-Fehlern sein. |

| Abgeschlossene DAG-Ausführungen | Die Anzahl der erfolgreichen und fehlgeschlagenen DAG-Fehler im ausgewählten Zeitraum. Dies ist nützlich, um vorübergehende Probleme mit DAG-Ausführungen zu identifizieren und sie mit anderen Ereignissen zu korrelieren, z. B. Worker-Pod-Entfernungen. |

| Erledigte Aufgaben | Die Anzahl der in der Umgebung ausgeführten Aufgaben mit einer Aufschlüsselung in erfolgreiche und fehlgeschlagene Aufgaben. |

| Ausführungsdauer Median-DAG | Der Medianwert für die Dauer von DAG-Ausführungen. Mithilfe dieses Diagramms lassen sich Leistungsprobleme erkennen und Trends in der DAG-Dauer erkennen. |

| Airflow-Tasks | Die Anzahl der Task im Status „Wird ausgeführt“, „In der Warteschlange“ oder „Ausgesetzt“ zu einem bestimmten Zeitpunkt. Airflow-Aufgaben sind Aufgaben, die sich in Airflow in einem Warteschlangenstatus befinden. Sie können entweder an die Celery- oder die Kubernetes Executor-Broker-Warteschlange gesendet werden. Tasks in der Celery-Warteschlange sind Taskinstanzen, die in die Celery-Broker-Warteschlange gestellt wurden. |

| Zombie-Aufgaben gelöscht | Die Anzahl der Zombie-Aufgaben, die in einem kleinen Zeitfenster beendet wurden. Zombie-Aufgaben werden häufig durch die externe Beendigung von Airflow-Prozessen verursacht. Der Airflow-Planer beendet Zombieaufgaben regelmäßig, was in diesem Diagramm angezeigt wird. |

| Größe der DAG-Bags | Die Anzahl der DAGs, die in den Bucket Ihrer Umgebung bereitgestellt und von Airflow zu einem bestimmten Zeitpunkt verarbeitet werden. Dies kann bei der Analyse von Leistungsengpässen hilfreich sein. Beispielsweise kann eine erhöhte Anzahl von DAG-Bereitstellungen die Leistung aufgrund einer übermäßigen Last beeinträchtigen. |

| DAG-Prozessorfehler | Die Anzahl der Fehler und Zeitüberschreitungen pro Sekunde, die beim Verarbeiten von DAG-Dateien aufgetreten sind. Der Wert gibt die Häufigkeit der vom DAG-Prozessor gemeldeten Fehler an. Dies ist ein anderer Wert als die Anzahl der fehlgeschlagenen DAGs. |

| Gesamtzeit zur Analyse aller DAGs | Ein Diagramm mit der Gesamtzeit, die Airflow benötigt, um alle DAGs in der Umgebung zu verarbeiten. Eine längere Parsing-Zeit kann sich auf die Effizienz auswirken. Weitere Informationen finden Sie unter Unterschied zwischen der DAG-Parsing-Zeit und der DAG-Ausführungszeit. |

Planerstatistiken

| Umgebungsmesswert | Beschreibung |

|---|---|

| Planer-Heartbeat | Weitere Informationen finden Sie unter Umgebungsübersicht. |

| Gesamte CPU-Nutzung des Planers | Die Gesamtnutzung von vCPU-Kernen durch Container, die in allen Airflow-Planer-Pods ausgeführt werden, und das kombinierte vCPU-Limit für alle Planer. |

| Gesamte Arbeitsspeichernutzung des Planers | Die Gesamtnutzung des Arbeitsspeichers durch Container, die in allen Airflow-Planer-Pods ausgeführt werden, und das kombinierte vCPU-Limit für alle Planer. |

| Gesamte Laufwerksnutzung des Planers | Die Gesamtnutzung des Speicherplatzes durch Container, die in allen Airflow-Planer-Pods ausgeführt werden, und das kombinierte Speicherplatzlimit für alle Planer. |

| Neustarts von Planercontainern | Die Gesamtzahl der Neustarts für einzelne Planercontainer. |

| Bereinigungen von Planer-Pods | Anzahl der Bereinigungen von Airflow-Planer-Pods. Die Pod-Bereinigung kann auftreten, wenn ein bestimmter Pod im Cluster Ihrer Umgebung die Ressourcenlimits erreicht. |

Statistiken zu Mitarbeitern

| Umgebungsmesswert | Beschreibung |

|---|---|

| Gesamte CPU-Nutzung der Worker | Die Gesamtnutzung von vCPU-Kernen durch Container, die in allen Airflow-Worker-Pods ausgeführt werden, und das kombinierte vCPU-Limit für alle Worker. |

| Gesamte Arbeitsspeichernutzung der Worker | Die Gesamtnutzung des Arbeitsspeichers durch Container, die in allen Airflow-Worker-Pods ausgeführt werden, und das kombinierte vCPU-Limit für alle Worker. |

| Gesamte Laufwerknutzung der Worker | Die Gesamtnutzung des Speicherplatzes durch Container, die in allen Airflow-Worker-Pods ausgeführt werden, und das kombinierte Speicherplatzlimit für alle Worker. |

| Aktive Worker | Die aktuelle Anzahl der Worker in Ihrer Umgebung. In Cloud Composer 2 wird die Anzahl der aktiven Worker in Ihrer Umgebung automatisch skaliert. |

| Neustarts von Worker-Containern | Die Gesamtzahl der Neustarts für einzelne Worker-Container. |

| Bereinigte Worker-Pods | Anzahl der Bereinigungen von Airflow-Worker-Pods. Die Pod-Bereinigung kann auftreten, wenn ein bestimmter Pod im Cluster Ihrer Umgebung die Ressourcenlimits erreicht. Wenn ein Airflow-Worker-Pod entfernt wird, werden alle auf diesem Pod ausgeführten Aufgabeninstanzen unterbrochen und später von Airflow als fehlgeschlagen markiert. |

| Airflow-Tasks | Weitere Informationen finden Sie unter Umgebungsübersicht. |

| Unbestätigte Celery-Aufgaben |

Die Anzahl der unbestätigten Aufgaben in der Celery-Broker-Warteschlange. Zu den unbestätigten Aufgaben gehören Airflow-Aufgabeninstanzen in den Aufgabenstatus queued und running. Beide Status sind bei der Ausführung von Airflow-Aufgaben normal. In der Grafik „Unacknowledged Celery tasks“ (Unbestätigte Celery-Aufgaben) werden Aufgaben in diesen Status als unbestätigt angezeigt, während sie von Airflow verarbeitet werden. Wenn eine Airflow-Aufgabeninstanz auf ungewöhnliche Weise unterbrochen wird (z. B. als Zombie erkannt), bleibt sie auch unbestätigt, bis der visibility_timeout erreicht ist. In diesem Fall wird im Diagramm eine Aufgabe angezeigt, die über einen längeren Zeitraum hinweg nicht bestätigt wird. In Cloud Composer ist der Zeitüberschreitungswert für die Sichtbarkeit auf 7 Tage festgelegt. Nach Ablauf dieser Zeit wird die Aufgabe noch einmal gesendet und kann dann bestätigt werden. Wenn der Fehler erneut auftritt, wird er möglicherweise weitere sieben Tage lang nicht bestätigt. |

| Zeitüberschreitungen beim Veröffentlichen in Celery Broker |

Die Gesamtzahl der AirflowTaskTimeout-Fehler, die beim Veröffentlichen von Aufgaben in Celery-Brokern aufgetreten sind. Dieser Messwert entspricht dem Airflow-Messwert celery.task_timeout_error. |

| Fehler von Celery-Ausführungsbefehlen |

Die Gesamtzahl der Exit-Codes ungleich null aus Celery-Tasks. Dieser Messwert entspricht dem Airflow-Messwert celery.execute_command.failure. |

| Vom System beendete Tasks | Die Anzahl der Workflowtasks, bei denen der Task-Runner mit SIGKILL beendet wurde, beispielsweise aufgrund von Worker-Arbeitsspeicher- oder Heartbeat-Problemen. |

Triggerstatistiken

| Umgebungsmesswert | Beschreibung |

|---|---|

| Zurückgestellte Aufgaben | Die Anzahl der Tasks im Status „Ausgesetzt“ zu einer bestimmten Zeit. Weitere Informationen zu verzögerten Aufgaben finden Sie unter Zurückstellbare Operatoren verwenden. |

| Abgeschlossene Trigger | Die Anzahl der in allen Trigger-Pods abgeschlossenen Trigger. |

| Laufende Trigger | Die Anzahl der laufenden Trigger pro Triggerinstanz. Dieses Diagramm enthält separate Linien für jeden Trigger. |

| Blockierende Trigger | Anzahl der Trigger, die den Hauptthread blockiert haben (wahrscheinlich, weil sie nicht vollständig asynchron sind). |

| Gesamte Triggerer-CPU-Nutzung | Die Gesamtnutzung von vCPU-Kernen durch Container, die in allen Airflow-Trigger-Pods ausgeführt werden, und das kombinierte vCPU-Limit für alle Trigger. |

| Gesamte Triggerer-Arbeitsspeichernutzung | Die Gesamtnutzung des Arbeitsspeichers durch Container, die in allen Airflow-Trigger-Pods ausgeführt werden, und das kombinierte vCPU-Limit für alle Trigger. |

| Gesamte Laufwerksnutzung durch Triggerer | Die Gesamtnutzung des Speicherplatzes durch Container, die in allen Airflow-Trigger-Pods ausgeführt werden, und das kombinierte Speicherplatzlimit für alle Trigger. |

| Aktive Trigger | Die Anzahl der aktiven Triggerinstanzen. |

| Neustarts des Trigger-Containers | Die Anzahl der Neustarts des Trigger-Containers. |

Webserverstatistiken

| Umgebungsmesswert | Beschreibung |

|---|---|

| Webserverstatus | Weitere Informationen finden Sie unter Umgebungsübersicht. |

| Webserver-CPU-Nutzung | Die Gesamtnutzung von vCPU-Kernen durch Container, die in allen Airflow-Webserver-Pods ausgeführt werden, und das kombinierte vCPU-Limit für alle Webserver. |

| Webserver-Arbeitsspeichernutzung | Die Gesamtnutzung des Arbeitsspeichers durch Container, die in allen Airflow-Webserver-Pods ausgeführt werden, und das kombinierte vCPU-Limit für alle Webserver. |

| Gesamte Laufwerksnutzung des Webservers | Die Gesamtnutzung des Speicherplatzes durch Container, die in allen Airflow-Webserver-Pods ausgeführt werden, und das kombinierte Speicherplatzlimit für alle Webserver. |

SQL-Datenbankstatistiken

| Umgebungsmesswert | Beschreibung |

|---|---|

| Datenbankstatus | Weitere Informationen finden Sie unter Umgebungsübersicht. |

| CPU-Nutzung der Datenbank | Die Nutzung von CPU-Kernen durch die Cloud SQL-Datenbankinstanzen Ihrer Umgebung. |

| Arbeitsspeichernutzung der Datenbank | Die Gesamtnutzung des Arbeitsspeichers durch die Cloud SQL-Datenbankinstanzen Ihrer Umgebung. |

| Datenträgerbelegung der Datenbank | Die Gesamtnutzung des Speicherplatzes durch die Cloud SQL-Datenbankinstanzen Ihrer Umgebung. Dieser Messwert bezieht sich auf die Cloud SQL-Datenbankinstanz selbst. Er sinkt also nicht, wenn die Größe der Airflow-Datenbank reduziert wird. Einen Messwert für die Größe des Inhalts der Airflow-Datenbank finden Sie unter „Größe der Airflow-Metadaten-Datenbank“. |

| Größe der Airflow-Metadaten-Datenbank | Größe der Airflow-Metadaten-Datenbank. Dieser Messwert gilt für die Airflow-Komponente Ihrer Umgebung und gibt den Speicherplatz an, den die Airflow-Metadatendatenbank auf der Cloud SQL-Datenbankinstanz belegt. Dieser Messwert sinkt, wenn die Größe der Airflow-Metadaten-Datenbank reduziert wird (z. B. nach der Wartung der Airflow-Datenbank). Er gibt an, ob Snapshots erstellt und Umgebungen aktualisiert werden können. Dieser Messwert unterscheidet sich vom Messwert „Datenplattennutzung der Datenbank“, der den von den Cloud SQL-Datenbankinstanzen genutzten Speicherplatz angibt. |

| Datenbankverbindungen | Die Gesamtzahl der aktiven Verbindungen zur Datenbank und das Limit für die Gesamtzahl der Verbindungen. |

Unterschied zwischen der DAG-Parsing-Zeit und der DAG-Ausführungszeit

Im Monitoring-Dashboard einer Umgebung wird die Gesamtzeit angezeigt, die zum Parsen aller DAGs in Ihrer Cloud Composer-Umgebung erforderlich ist, sowie die durchschnittliche Zeit, die zum Ausführen eines DAG benötigt wird.

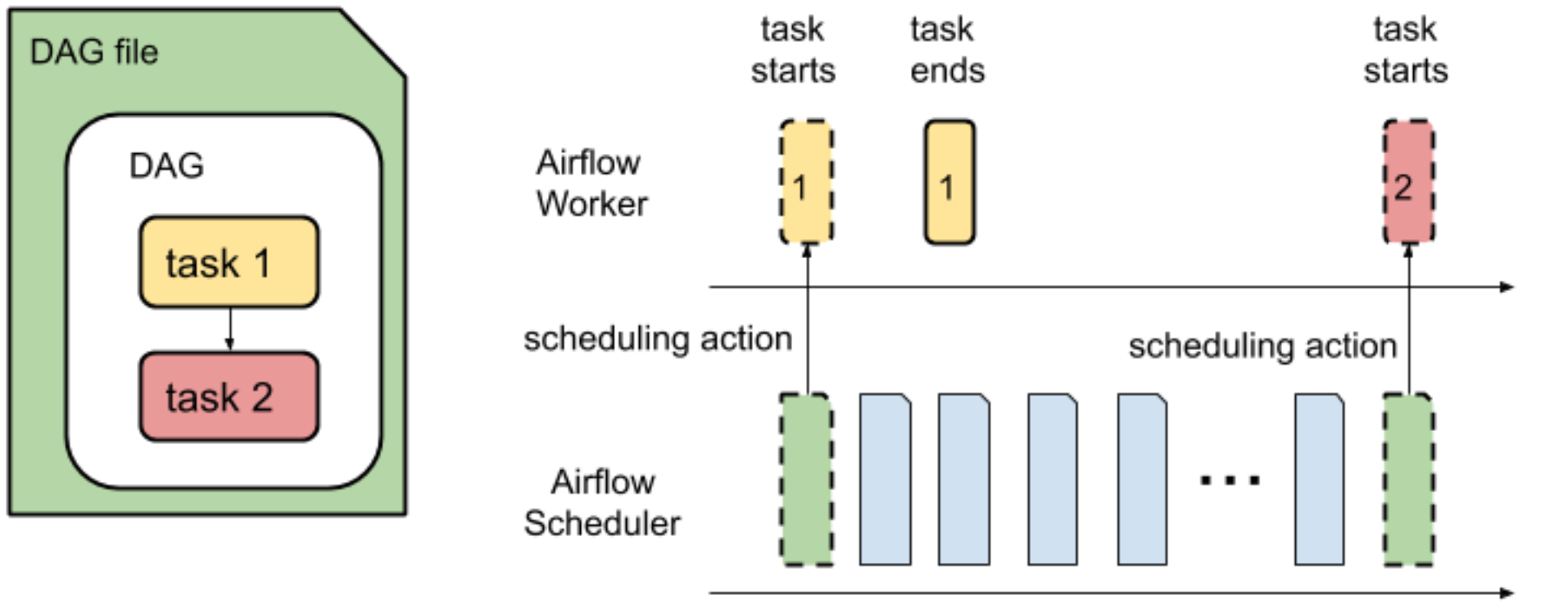

Das Parsen eines DAG und das Planen von Aufgaben aus einem DAG zur Ausführung sind zwei separate Vorgänge, die vom Airflow-Planer ausgeführt werden.

Die DAG-Parsing-Zeit ist die Zeit, die der Airflow-Planer benötigt, um eine DAG-Datei zu lesen und zu parsen.

Bevor der Airflow-Planer Aufgaben aus einem DAG planen kann, muss er die DAG-Datei parsen, um die Struktur des DAG und die definierten Aufgaben zu ermitteln. Nachdem die DAG-Datei geparst wurde, kann der Planer Aufgaben aus dem DAG planen.

Die DAG-Ausführungszeit ist die Summe aller Aufgabenausführungszeiten für einen DAG.

Um Informationen zur Dauer der Ausführung einer bestimmten Airflow-Aufgabe aus einem DAG zu erhalten, wählen Sie in der Airflow-Weboberfläche einen DAG aus und öffnen Sie den Tab Aufgabendauer. Dieser Tab zeigt die Ausführungszeiten der Aufgaben für die angegebene Anzahl der letzten DAG-Ausführungen an.