Execute um DAG do Apache Airflow no Cloud Composer 2

Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

Este guia de início rápido mostra como criar um ambiente do Cloud Composer e executar um DAG do Apache Airflow no Cloud Composer 2.

Se não conhece o Airflow, consulte o tutorial de conceitos do Airflow na documentação do Apache Airflow para obter mais informações sobre os conceitos, os objetos e a respetiva utilização do Airflow.

Se quiser usar a CLI do Google Cloud, consulte o artigo Execute um DAG do Apache Airflow no Cloud Composer (CLI do Google Cloud).

Se quiser criar um ambiente com o Terraform, consulte o artigo Criar ambientes (Terraform).

Antes de começar

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Composer API.

Roles required to enable APIs

To enable APIs, you need the Service Usage Admin IAM role (

roles/serviceusage.serviceUsageAdmin), which contains theserviceusage.services.enablepermission. Learn how to grant roles. -

Para receber as autorizações de que precisa para concluir este início rápido, peça ao seu administrador que lhe conceda as seguintes funções da IAM no seu projeto:

-

Para ver, criar e gerir o ambiente do Cloud Composer:

-

Administrador de objetos de ambiente e armazenamento (

roles/composer.environmentAndStorageObjectAdmin) -

Utilizador da conta de serviço (

roles/iam.serviceAccountUser)

-

Administrador de objetos de ambiente e armazenamento (

-

Para ver registos:

Visualizador de registos (

roles/logging.viewer)

Para mais informações sobre a atribuição de funções, consulte o artigo Faça a gestão do acesso a projetos, pastas e organizações.

Também pode conseguir as autorizações necessárias através de funções personalizadas ou outras funções predefinidas.

-

Para ver, criar e gerir o ambiente do Cloud Composer:

Crie uma nova conta de serviço, conforme descrito na documentação de gestão de identidade e de acesso.

Atribuir-lhe uma função, conforme descrito na documentação da gestão de identidade e de acesso. A função necessária é Composer Worker (

composer.worker).Na Google Cloud consola, aceda à página Criar ambiente.

Se este for o primeiro ambiente no seu projeto, é apresentada a secção Conceda as autorizações necessárias à conta de serviço do Cloud Composer.

Adiciona a conta do agente de serviço do Cloud Composer como um novo principal na conta de serviço do seu ambiente e concede-lhe a função Extensão do agente de serviço da API Cloud Composer v2.

Confirme que usa a conta de serviço pretendida para o seu ambiente e clique em Conceder.

No campo Nome, introduza

example-environment.Na lista pendente Localização, selecione uma região para o ambiente do Cloud Composer. Este guia usa a região

us-central1.Para outras opções de configuração do ambiente, use as predefinições fornecidas.

Clique em Criar e aguarde até que o ambiente seja criado.

Quando terminar, é apresentada uma marca de verificação verde junto ao nome do ambiente.

- Cria um DAG,

composer_sample_dag. Este DAG é executado todos os dias. - Executa uma tarefa,

print_dag_run_conf. A tarefa imprime a configuração da execução do DAG usando o operador bash. Na Google Cloud consola, aceda à página Ambientes.

Na lista de ambientes, clique no nome do seu ambiente,

example-environment. É apresentada a página Detalhes do ambiente.Clique em Abrir pasta de DAGs. É apresentada a página Detalhes do contentor.

Clique em Carregar ficheiros e, de seguida, selecione a sua cópia do ficheiro

quickstart.py.Para carregar o ficheiro, clique em Abrir.

- Analisa o ficheiro DAG que carregou. Pode demorar alguns minutos até que o DAG fique disponível para o Airflow.

- Adiciona o DAG à lista de DAGs disponíveis.

- Executa o DAG de acordo com a agenda que forneceu no ficheiro DAG.

Aguarde cerca de cinco minutos para dar tempo ao Airflow de processar o ficheiro DAG que carregou anteriormente e concluir a primeira execução do DAG (explicada mais tarde).

Na Google Cloud consola, aceda à página Ambientes.

Na lista de ambientes, clique no nome do seu ambiente,

example-environment. É apresentada a página Detalhes do ambiente.Aceda ao separador DAGs.

Verifique se o

composer_quickstartDAG está presente na lista de DAGs.

Figura 1. A lista de DAGs apresenta o DAG composer_quickstart (clique para aumentar) No separador DAGs, clique em

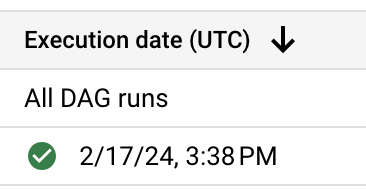

composer_quickstart. O separador Execuções do DAG é aberto.Na lista de execuções de DAG, clique na primeira entrada.

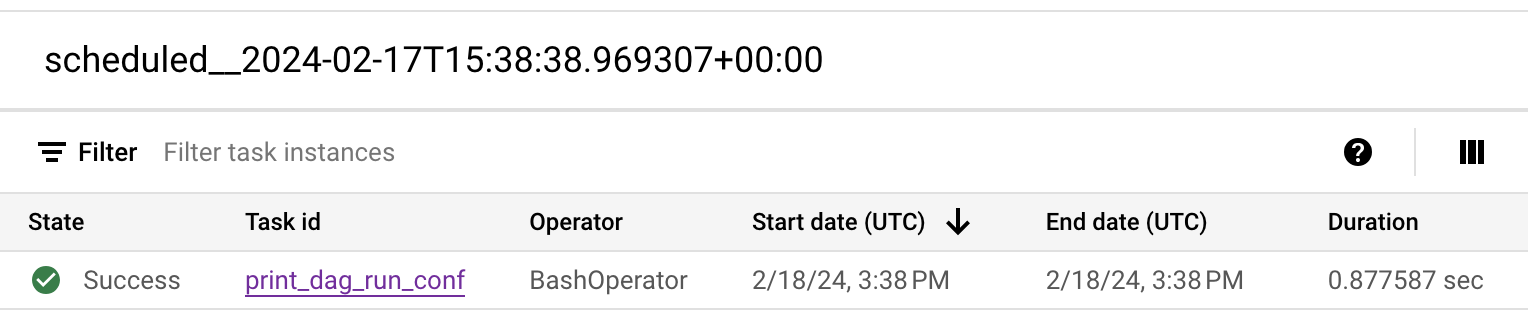

Figura 2. A lista de execuções de DAG para o DAG composer_quickstart (clique para aumentar) São apresentados os detalhes da execução do DAG, que detalham as informações sobre as tarefas individuais do DAG de exemplo.

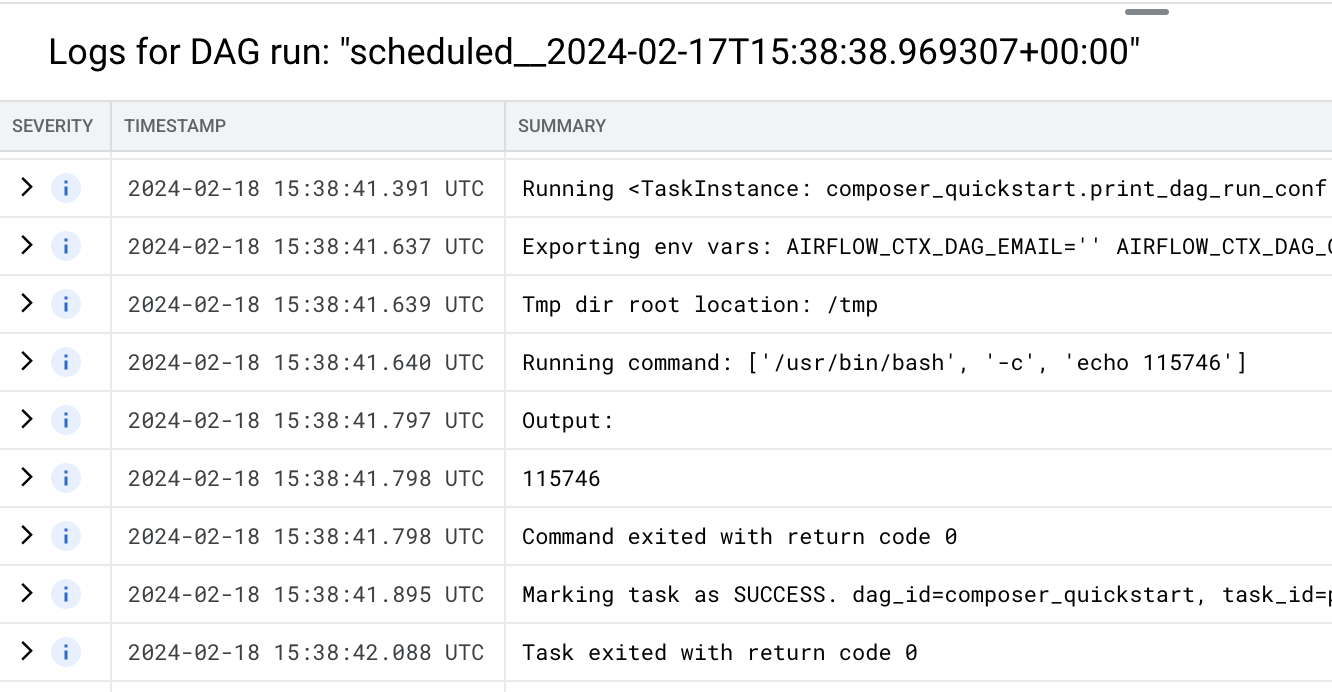

Figura 3. A lista de tarefas que foram executadas na execução do DAG (clique para aumentar) A secção Registos da execução do DAG apresenta os registos de todas as tarefas na execução do DAG. Pode ver o resultado do comando

echonos registos.

Figura 4. Registos da tarefa print_dag_run_conf (clique para aumentar) Elimine o ambiente do Cloud Composer:

Na Google Cloud consola, aceda à página Ambientes.

Selecione

example-environmente clique em Eliminar.Aguarde até que o ambiente seja eliminado.

Elimine o contentor do seu ambiente. A eliminação do ambiente do Cloud Composer não elimina o respetivo contentor.

Na Google Cloud consola, aceda à página Armazenamento > Navegador.

Selecione o contentor do ambiente e clique em Eliminar. Por exemplo, este contentor pode ter o nome

us-central1-example-environ-c1616fe8-bucket.

Crie uma conta de serviço do ambiente

Quando cria um ambiente, especifica uma conta de serviço. Esta conta de serviço chama-se conta de serviço do ambiente. O seu ambiente usa esta conta de serviço para realizar a maioria das operações.

A conta de serviço do seu ambiente não é uma conta de utilizador. Uma conta de serviço é um tipo especial de conta usada por uma aplicação ou uma instância de máquina virtual (MV), e não por uma pessoa.

Para criar uma conta de serviço para o seu ambiente:

Crie um ambiente

Crie um ficheiro DAG

Um DAG do Airflow é uma coleção de tarefas organizadas que quer agendar e executar. Os DAGs são definidos em ficheiros Python padrão.

Este guia usa um exemplo de DAG do Airflow definido no ficheiro quickstart.py.

O código Python neste ficheiro faz o seguinte:

Guarde uma cópia do ficheiro quickstart.py no seu computador local:

Carregue o ficheiro DAG para o contentor do seu ambiente

Todos os ambientes do Cloud Composer têm um contentor do Cloud Storage associado. O Airflow no Cloud Composer agenda apenas DAGs localizados na pasta /dags neste contentor.

Para agendar o seu DAG, carregue o ficheiro quickstart.py a partir da sua máquina local para a pasta /dags do ambiente:

Veja o DAG

Depois de carregar o ficheiro DAG, o Airflow faz o seguinte:

Verifique se o DAG é processado sem erros e está disponível no Airflow através da visualização na IU do DAG. A IU do DAG é a interface do Cloud Composer para ver informações do DAG na Google Cloud consola. O Cloud Composer também oferece acesso à IU do Airflow, que é uma interface Web do Airflow nativa.

Veja os detalhes da execução do DAG

Uma única execução de um DAG é denominada execução de DAG. O Airflow executa imediatamente uma execução de DAG para o DAG de exemplo porque a data de início no ficheiro DAG está definida para ontem. Desta forma, o Airflow atualiza-se de acordo com a programação do DAG especificado.

O DAG de exemplo contém uma tarefa, print_dag_run_conf, que executa o comando echo

na consola. Este comando produz metainformações sobre o DAG (identificador numérico da execução do DAG).

Limpar

Para evitar incorrer em cobranças na sua Google Cloud conta pelos recursos usados nesta página, siga estes passos.

Elimine os recursos usados neste tutorial:

O que se segue?