Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

Questo tutorial ti guida nella diagnosi e nella risoluzione dei problemi di pianificazione e analisi delle attività che causano malfunzionamento dello scheduler, errori di analisi, latenza ed errori delle attività.

Introduzione

Lo scheduler Airflow è principalmente influenzato da due fattori: la pianificazione delle attività e l'analisi dei DAG. I problemi in uno di questi fattori possono avere un impatto negativo sulla salute e sulle prestazioni dell'ambiente.

A volte vengono pianificate troppe attività contemporaneamente. In questa situazione, la coda è piena e le attività rimangono nello stato "pianificato" o vengono ripianificate dopo essere state messe in coda, il che potrebbe causare errori e latenza delle prestazioni.

Un altro problema comune è la latenza e gli errori di analisi causati dalla complessità di un codice DAG. Ad esempio, un codice DAG che contiene variabili Airflow nel livello superiore del codice può causare ritardi nell'analisi, sovraccarico del database, errori di pianificazione e timeout DAG.

In questo tutorial, diagnosticherai i DAG di esempio e imparerai a risolvere i problemi di pianificazione e analisi, a migliorare la pianificazione dei DAG e a ottimizzare il codice DAG e le configurazioni dell'ambiente per migliorare il rendimento.

Obiettivi

Questa sezione elenca gli obiettivi per gli esempi in questo tutorial.

Esempio: malfunzionamento dello scheduler e latenza causata da un'elevata concorrenza delle attività

Carica il DAG di esempio che viene eseguito più volte contemporaneamente e diagnostica il malfunzionamento dello scheduler e i problemi di latenza con Cloud Monitoring.

Ottimizza il codice DAG consolidando le attività e valuta l'impatto sulle prestazioni.

Distribuisci le attività in modo più uniforme nel tempo e valuta l'impatto sul rendimento.

Ottimizza le configurazioni di Airflow e dell'ambiente e valuta l'impatto.

Esempio: errori di analisi DAG e latenza causati da codice complesso

Carica il DAG di esempio con le variabili Airflow e diagnostica i problemi di analisi con Cloud Monitoring.

Ottimizza il codice DAG evitando le variabili Airflow al livello superiore del codice e valuta l'impatto sul tempo di analisi.

Ottimizza le configurazioni di Airflow e dell'ambiente e valuta l'impatto sul tempo di analisi.

Costi

Questo tutorial utilizza i seguenti componenti fatturabili di Google Cloud:

Al termine di questo tutorial, puoi evitare l'addebito di ulteriori costi eliminando le risorse create. Per maggiori dettagli, vedi Pulizia.

Prima di iniziare

Questa sezione descrive le azioni necessarie prima di iniziare il tutorial.

Creare e configurare un progetto

Per questo tutorial, è necessario un Google Cloud progetto. Configura il progetto nel seguente modo:

Nella console Google Cloud , seleziona o crea un progetto:

Verifica che la fatturazione sia attivata per il tuo progetto. Scopri come verificare se la fatturazione è abilitata per un progetto.

Assicurati che l'utente del progetto Google Cloud disponga dei seguenti ruoli per creare le risorse necessarie:

- Amministratore ambienti e oggetti Storage

(

roles/composer.environmentAndStorageObjectAdmin) - Compute Admin (

roles/compute.admin)

- Amministratore ambienti e oggetti Storage

(

Abilitare le API per il progetto

Enable the Cloud Composer API.

Crea l'ambiente Cloud Composer

Crea un ambiente Cloud Composer 2.

Durante la creazione dell'ambiente,

concedi il ruolo Estensione agente di servizio API Cloud Composer v2

(roles/composer.ServiceAgentV2Ext) all'account

agente di servizio Composer. Cloud Composer utilizza questo account per eseguire operazioni

nel tuo progetto Google Cloud .

Esempio: malfunzionamento dello scheduler e errore dell'attività a causa di problemi di pianificazione

Questo esempio mostra il debug del malfunzionamento dello scheduler e della latenza causata dall'elevata concorrenza delle attività.

Carica il DAG di esempio nel tuo ambiente

Carica il seguente DAG di esempio nell'ambiente

che hai creato nei passaggi precedenti. In questo tutorial, questo DAG si chiama

dag_10_tasks_200_seconds_1.

Questo DAG ha 200 attività. Ogni attività attende 1 secondo e stampa "Completato". Il DAG viene attivato automaticamente una volta caricato. Cloud Composer esegue questo DAG 10 volte e tutte le esecuzioni del DAG avvengono in parallelo.

import time

from datetime import datetime, timedelta

from airflow import DAG

from airflow.decorators import task

tasks_amount = 200

seconds = 1

minutes = 5

with DAG(

dag_id=f"dag_10_tasks_{tasks_amount}_sec_{seconds}",

start_date=datetime(2023, 11, 22, 20, 0),

end_date=datetime(2023, 11, 22, 20, 49),

schedule_interval=timedelta(minutes=minutes),

catchup=True,

) as dag:

@task

def create_subtasks(seconds: int) -> None:

time.sleep(seconds)

for i in range(tasks_amount):

create_subtasks(seconds)

Diagnostica i problemi di malfunzionamento dello scheduler e di errore delle attività

Al termine dell'esecuzione del DAG, apri l'interfaccia utente di Airflow e fai clic sul DAG

dag_10_tasks_200_seconds_1. Vedrai che sono state eseguite correttamente 10 esecuzioni di DAG e che ognuna ha 200 attività completate.

Esamina i log delle attività Airflow:

Nella console Google Cloud , vai alla pagina Ambienti.

Nell'elenco degli ambienti, fai clic sul nome del tuo ambiente. Viene visualizzata la pagina Dettagli ambiente.

Vai alla scheda Log, poi vai a Tutti i log > Log di Airflow > Worker > Visualizza in Esplora log.

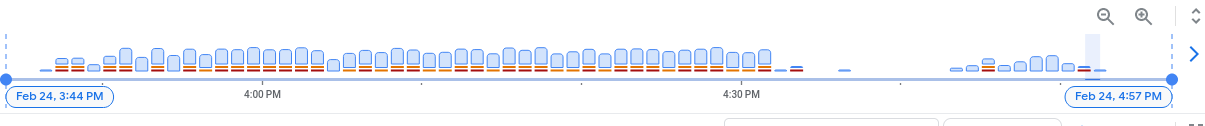

Nell'istogramma dei log, puoi vedere gli errori e gli avvisi indicati con i colori rosso e arancione:

Il DAG di esempio ha generato circa 130 avvisi e 60 errori. Fai clic su una colonna che contiene barre gialle e rosse. Nei log verranno visualizzati alcuni dei seguenti avvisi ed errori:

State of this instance has been externally set to success. Terminating

instance.

Received SIGTERM. Terminating subprocesses.

worker: Warm shutdown (MainProcess).

Questi log potrebbero indicare che l'utilizzo delle risorse ha superato i limiti e che il worker è stato riavviato.

Se un'attività Airflow viene mantenuta in coda troppo a lungo, lo scheduler la contrassegna come non riuscita e up_for_retry e la riprogramma per l'esecuzione. Un modo per osservare i sintomi di questa situazione è esaminare il grafico con il numero di attività in coda e se i picchi in questo grafico non diminuiscono in circa 10 minuti, è probabile che si verifichino errori delle attività (senza log).

Esamina le informazioni di monitoraggio:

Vai alla scheda Monitoraggio e seleziona Panoramica.

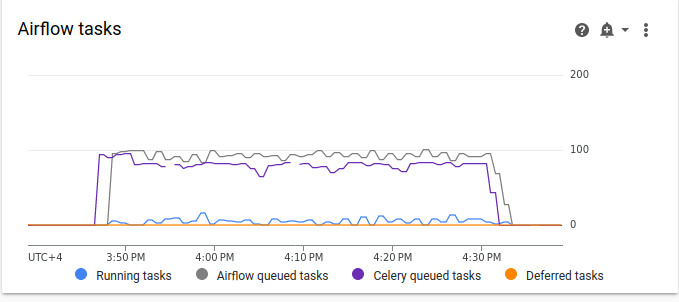

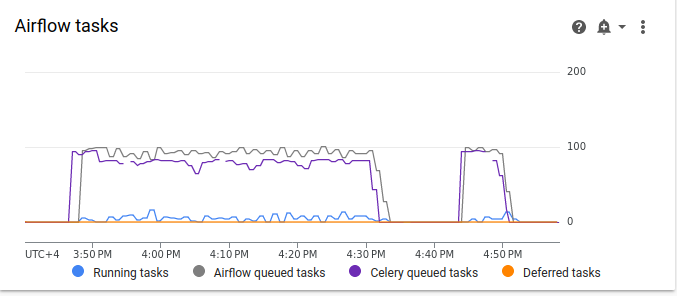

Esamina il grafico Attività Airflow.

Figura 2. Grafico delle attività Airflow (fai clic per ingrandire) Nel grafico delle attività di Airflow, si verifica un picco di attività in coda che dura per più di 10 minuti, il che potrebbe significare che non ci sono risorse sufficienti nel tuo ambiente per elaborare tutte le attività pianificate.

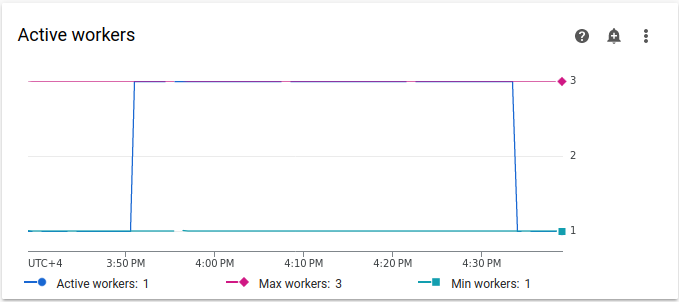

Esamina il grafico Worker attivi:

Figura 3. Grafico dei worker attivi (fai clic per ingrandire) Il grafico Worker attivi indica che il DAG ha attivato la scalabilità automatica fino al limite massimo consentito di tre worker durante l'esecuzione del DAG.

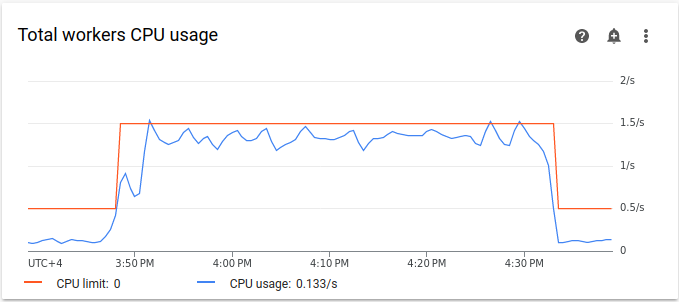

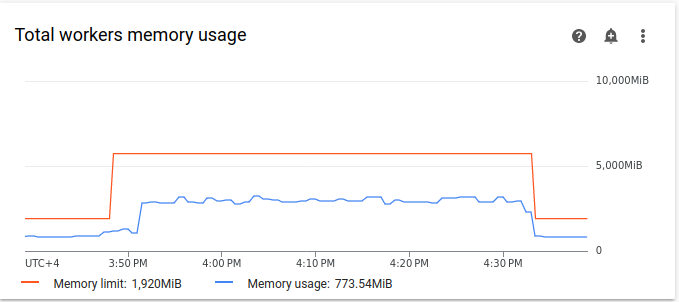

I grafici sull'utilizzo delle risorse possono indicare la mancanza di capacità nei worker Airflow per eseguire le attività in coda. Nella scheda Monitoraggio, seleziona Worker e controlla i grafici Utilizzo totale CPU worker e Utilizzo totale memoria worker.

Figura 4. Grafico dell'utilizzo totale della CPU dei worker (fai clic per ingrandire)

Figura 5. Grafico dell'utilizzo totale della memoria dei worker (fai clic per ingrandire) I grafici indicano che l'esecuzione di troppe attività contemporaneamente ha comportato il raggiungimento del limite di CPU. Le risorse sono state utilizzate per oltre 30 minuti, un periodo di tempo ancora più lungo della durata totale di 200 attività in 10 esecuzioni DAG eseguite una alla volta.

Questi sono gli indicatori del riempimento della coda e della mancanza di risorse per elaborare tutte le attività pianificate.

Consolidare le attività

Il codice attuale crea molti DAG e attività senza risorse sufficienti per elaborare tutte le attività in parallelo, il che comporta il riempimento della coda. Se le attività rimangono in coda troppo a lungo, potrebbero essere riprogrammate o non essere completate. In questi casi, è consigliabile optare per un numero inferiore di attività più consolidate.

Il seguente DAG di esempio modifica il numero di attività nell'esempio iniziale da 200 a 20 e aumenta il tempo di attesa da 1 a 10 secondi per imitare attività più consolidate che svolgono la stessa quantità di lavoro.

Carica il seguente DAG di esempio nell'ambiente

che hai creato. In questo tutorial, questo DAG si chiama

dag_10_tasks_20_seconds_10.

import time

from datetime import datetime, timedelta

from airflow import DAG

from airflow.decorators import task

tasks_amount = 20

seconds = 10

minutes = 5

with DAG(

dag_id=f"dag_10_tasks_{tasks_amount}_sec_{seconds}",

start_date=datetime(2021, 12, 22, 20, 0),

end_date=datetime(2021, 12, 22, 20, 49),

schedule_interval=timedelta(minutes=minutes),

catchup=True,

) as dag:

@task

def create_subtasks(seconds: int) -> None:

time.sleep(seconds)

for i in range(tasks_amount):

create_subtasks(seconds)

Valuta l'impatto delle attività più consolidate sui processi di pianificazione:

Attendi il completamento delle esecuzioni del DAG.

Nell'interfaccia utente di Airflow, nella pagina DAG, fai clic sul DAG

dag_10_tasks_20_seconds_10. Vedrai 10 esecuzioni di DAG, ognuna con 20 attività completate.Nella console Google Cloud , vai alla pagina Ambienti.

Nell'elenco degli ambienti, fai clic sul nome del tuo ambiente. Viene visualizzata la pagina Dettagli ambiente.

Vai alla scheda Log, poi vai a Tutti i log > Log di Airflow > Worker > Visualizza in Esplora log.

Il secondo esempio con attività più consolidate ha generato circa 10 avvisi e 7 errori. Nell'istogramma puoi confrontare il numero di errori e avvisi nel primo esempio (valori precedenti) e nel secondo esempio (valori successivi).

Figura 6. Istogramma dei log dei worker di Airflow dopo il consolidamento delle attività (fai clic per ingrandire) Se confronti il primo esempio con quello più consolidato, puoi notare che nel secondo esempio ci sono molti meno errori e avvisi. Tuttavia, gli stessi errori relativi all'arresto controllato vengono visualizzati ancora nei log a causa del sovraccarico delle risorse.

Nella scheda Monitoraggio, seleziona Worker ed esamina i grafici.

Se confronti il grafico delle attività Airflow del primo esempio (valori precedenti) con il grafico del secondo esempio con attività più consolidate, puoi notare che il picco di attività in coda è durato per un periodo di tempo più breve quando le attività erano più consolidate. Tuttavia, è durato quasi 10 minuti, il che non è comunque ottimale.

Figura 7. Grafico delle attività Airflow dopo il consolidamento delle attività (fai clic per ingrandire) Nel grafico Lavoratori attivi, puoi vedere che il primo esempio (sul lato sinistro del grafico) ha utilizzato le risorse per un periodo di tempo molto più lungo rispetto al secondo, anche se entrambi gli esempi imitano la stessa quantità di lavoro.

Figura 8. Grafico dei lavoratori attivi dopo il consolidamento delle attività (fai clic per ingrandire) Esamina i grafici sul consumo delle risorse dei worker. Anche se la differenza tra le risorse utilizzate nell'esempio con attività più consolidate e l'esempio iniziale è piuttosto significativa, l'utilizzo della CPU raggiunge comunque il 70% del limite.

Figura 9. Grafico dell'utilizzo totale della CPU dei worker dopo il consolidamento delle attività (fai clic per ingrandire)

Figura 10. Grafico dell'utilizzo totale della memoria dei worker dopo il consolidamento delle attività (fai clic per ingrandire)

Distribuire le attività in modo più uniforme nel tempo

Un numero eccessivo di attività simultanee comporta il riempimento della coda, il che porta le attività a rimanere bloccate nella coda o a essere riprogrammate. Nei passaggi precedenti, hai ridotto il numero di attività consolidandole, ma i log di output e il monitoraggio hanno indicato che il numero di attività simultanee è ancora subottimale.

Puoi controllare il numero di esecuzioni simultanee delle attività implementando una pianificazione o impostando limiti per il numero di attività che possono essere eseguite contemporaneamente.

In questo tutorial, distribuisci le attività in modo più uniforme nel tempo aggiungendo

i parametri a livello di DAG nel DAG dag_10_tasks_20_seconds_10:

Aggiungi l'argomento

max_active_runs=1al gestore di contesto DAG. Questo argomento imposta un limite di una sola istanza di un'esecuzione DAG in un determinato momento.Aggiungi l'argomento

max_active_tasks=5al gestore di contesto DAG. Questo argomento controlla il numero massimo di istanze di attività che possono essere eseguite contemporaneamente in ogni DAG.

Carica il seguente DAG di esempio nell'ambiente

che hai creato. In questo tutorial, questo DAG si chiama

dag_10_tasks_20_seconds_10_scheduled.py.

import time

from datetime import datetime, timedelta

from airflow import DAG

from airflow.decorators import task

tasks_amount = 20

seconds = 10

minutes = 5

active_runs = 1

active_tasks = 5

with DAG(

dag_id=f"dag_10_tasks_{tasks_amount}_sec_{seconds}_runs_{active_runs}_tasks_{active_tasks}",

start_date=datetime(2021, 12, 22, 20, 0),

end_date=datetime(2021, 12, 22, 20, 49),

schedule_interval=timedelta(minutes=minutes),

max_active_runs=active_runs,

max_active_tasks=active_tasks,

catchup=True,

) as dag:

@task

def create_subtasks(seconds: int) -> None:

time.sleep(seconds)

for i in range(tasks_amount):

create_subtasks(seconds)

Valuta l'impatto della distribuzione delle attività nel tempo sui processi di pianificazione:

Attendi il completamento delle esecuzioni del DAG.

Nella console Google Cloud , vai alla pagina Ambienti.

Nell'elenco degli ambienti, fai clic sul nome del tuo ambiente. Viene visualizzata la pagina Dettagli ambiente.

Vai alla scheda Log, poi vai a Tutti i log > Log di Airflow > Worker > Visualizza in Esplora log.

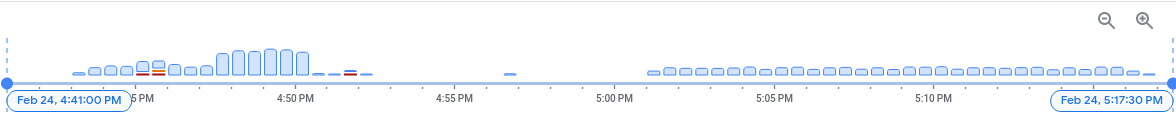

Nell'istogramma puoi notare che il terzo DAG con un numero limitato di attività e esecuzioni attive non ha generato avvisi o errori e la distribuzione dei log appare più uniforme rispetto ai valori precedenti.

Figura 11. Istogramma dei log dei worker di Airflow dopo che le attività sono state consolidate e distribuite nel tempo (fai clic per ingrandire)

Le attività nell'esempio dag_10_tasks_20_seconds_10_scheduled con un numero limitato di attività e esecuzioni attive non hanno causato pressione sulle risorse perché le attività sono state accodate in modo uniforme.

Dopo aver eseguito i passaggi descritti, hai ottimizzato l'utilizzo delle risorse consolidando le piccole attività e distribuendole in modo più uniforme nel tempo.

Ottimizzare le configurazioni dell'ambiente

Puoi modificare le configurazioni dell'ambiente per assicurarti che i worker Airflow abbiano sempre capacità per eseguire le attività in coda.

Numero di worker e concorrenza dei worker

Puoi regolare il numero massimo di worker per fare in modo che Cloud Composer esegua automaticamente lo scale del tuo ambiente entro i limiti impostati.

Il parametro [celery]worker_concurrency definisce il numero massimo di attività

che un singolo worker può prelevare dalla coda di attività. La modifica di questo parametro

modifica il numero di attività che un singolo worker può eseguire contemporaneamente.

Puoi modificare questa opzione di configurazione di Airflow

eseguendo l'override. Per impostazione predefinita, la concorrenza dei worker viene impostata in base al numero di istanze di attività simultanee leggere che un worker può

gestire. Ciò significa che il suo valore dipende dai limiti delle risorse worker.

Il valore di concorrenza dei worker non dipende dal numero di worker nel tuo ambiente.

Il numero di worker e la concorrenza dei worker funzionano in combinazione tra loro e le prestazioni dell'ambiente dipendono in larga misura da entrambi i parametri. Puoi utilizzare le seguenti considerazioni per scegliere la combinazione corretta:

Più attività rapide eseguite in parallelo. Puoi aumentare la concorrenza dei worker quando ci sono attività in attesa nella coda e i worker utilizzano una percentuale ridotta di CPU e memoria contemporaneamente. Tuttavia, in determinate circostanze la coda potrebbe non riempirsi mai, causando la mancata attivazione della scalabilità automatica. Se le attività di piccole dimensioni terminano l'esecuzione prima che i nuovi worker siano pronti, un worker esistente può riprendere le attività rimanenti e non ci saranno attività per i worker appena creati.

In queste situazioni, è consigliabile aumentare il numero minimo di worker e la concorrenza dei worker per evitare uno scaling eccessivo.

Più attività lunghe in esecuzione in parallelo. L'elevata concorrenza dei worker impedisce al sistema di scalare il numero di worker. Se più attività richiedono molte risorse e richiedono molto tempo per essere completate, una concorrenza elevata dei worker può comportare il mancato riempimento della coda e l'acquisizione di tutte le attività da parte di un solo worker, il che comporta problemi di prestazioni. In queste situazioni, è consigliabile aumentare il numero massimo di worker e diminuire la concorrenza dei worker.

L'importanza del parallelismo

Gli scheduler di Airflow controllano la pianificazione delle esecuzioni dei DAG e delle singole attività dei DAG. L'opzione di configurazione di Airflow [core]parallelism controlla il numero di attività che lo scheduler di Airflow può mettere in coda nella coda dell'executor dopo che tutte le dipendenze di queste attività sono soddisfatte.

Il parallelismo è un meccanismo di protezione di Airflow che determina il numero di attività che possono essere eseguite contemporaneamente per ogni scheduler, indipendentemente dal numero di worker. Il valore di parallelismo, moltiplicato per il numero di scheduler nel cluster, è il numero massimo di istanze di attività che il tuo ambiente può mettere in coda.

In genere, [core]parallelism viene impostato come prodotto di un numero massimo di worker

e [celery]worker_concurrency. Inoltre, è influenzato dal

pool.

Puoi modificare questa opzione di configurazione di Airflow

eseguendo l'override. Per ulteriori informazioni sulla modifica delle configurazioni di Airflow relative allo scaling, consulta Configurazione dello scaling di Airflow.

Trovare le configurazioni dell'ambiente ottimali

Il modo consigliato per risolvere i problemi di pianificazione è consolidare le attività piccole in attività più grandi e distribuire le attività in modo più uniforme nel tempo. Oltre a ottimizzare il codice DAG, puoi anche ottimizzare le configurazioni dell'ambiente per avere una capacità sufficiente per eseguire più attività contemporaneamente.

Ad esempio, supponiamo che tu consolidi le attività nel tuo DAG il più possibile, ma limitare le attività attive per distribuirle in modo più uniforme nel tempo non è una soluzione preferita per il tuo caso d'uso specifico.

Puoi modificare i parametri di parallelismo, numero di worker e concorrenza dei worker

per eseguire il DAG dag_10_tasks_20_seconds_10 senza limitare le attività

attive. In questo esempio, il DAG viene eseguito 10 volte e ogni esecuzione contiene 20 piccole attività.

Se vuoi eseguirli tutti contemporaneamente:

Avrai bisogno di un ambiente più grande, perché controlla i parametri di prestazioni dell'infrastruttura Cloud Composer gestita del tuo ambiente.

I worker di Airflow devono essere in grado di eseguire 20 attività contemporaneamente, il che significa che devi impostare la concorrenza dei worker su 20.

I worker hanno bisogno di CPU e memoria sufficienti per gestire tutte le attività. La concorrenza dei worker è influenzata dalla CPU e dalla memoria dei worker, pertanto avrai bisogno di almeno

worker_concurrency / 12di CPU eleast worker_concurrency / 8di memoria.Dovrai aumentare il parallelismo per corrispondere alla maggiore concorrenza dei worker. Affinché i worker possano prelevare 20 attività dalla coda, lo scheduler deve prima pianificare queste 20 attività.

Modifica le configurazioni dell'ambiente nel seguente modo:

Nella console Google Cloud , vai alla pagina Ambienti.

Nell'elenco degli ambienti, fai clic sul nome del tuo ambiente. Viene visualizzata la pagina Dettagli ambiente.

Vai alla scheda Configurazione ambiente.

Trova la configurazione Risorse > Workload e fai clic su Modifica.

Nella sezione Worker, nel campo Memoria, specifica il nuovo limite di memoria per i worker Airflow. In questo tutorial, utilizza 4 GB.

Nel campo CPU, specifica il nuovo limite di CPU per i worker Airflow. In questo tutorial, utilizza 2 vCPU.

Salva le modifiche e attendi alcuni minuti per il riavvio dei worker Airflow.

A questo punto, esegui l'override delle opzioni di configurazione di Airflow per parallelismo e concorrenza dei worker:

Vai alla scheda Override della configurazione Airflow.

Fai clic su Modifica, poi su Aggiungi override della configurazione di Airflow.

Esegui l'override della configurazione del parallelismo:

Sezione Chiave Valore coreparallelism20Fai clic su Aggiungi override della configurazione Airflow ed esegui l'override della configurazione della concorrenza dei worker:

Sezione Chiave Valore celeryworker_concurrency20Fai clic su Salva e attendi l'aggiornamento della configurazione dell'ambiente.

Attiva di nuovo lo stesso DAG di esempio con le configurazioni modificate:

Nell'interfaccia utente di Airflow, vai alla pagina DAG.

Trova il

dag_10_tasks_20_seconds_10DAG ed eliminalo.Dopo l'eliminazione del DAG, Airflow controlla la cartella DAG nel bucket dell'ambiente ed esegue di nuovo il DAG automaticamente.

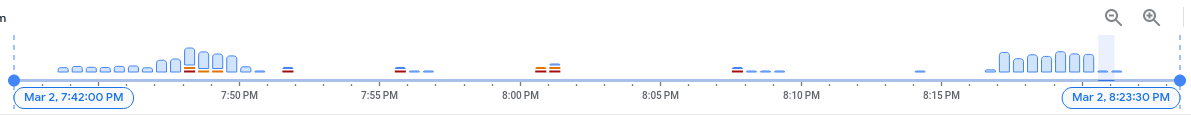

Al termine delle esecuzioni del DAG, esamina di nuovo l'istogramma dei log. Nel diagramma,

puoi notare che l'esempio dag_10_tasks_20_seconds_10 con più

attività consolidate non ha generato errori e avvisi durante l'esecuzione con

la configurazione dell'ambiente modificata. Confronta i risultati con i dati precedenti

nel diagramma, in cui lo stesso esempio ha generato errori e avvisi durante

l'esecuzione con la configurazione dell'ambiente predefinita.

Le configurazioni dell'ambiente e di Airflow svolgono un ruolo fondamentale nella pianificazione delle attività, ma non è possibile aumentare le configurazioni oltre determinati limiti.

Ti consigliamo di ottimizzare il codice DAG, consolidare le attività e utilizzare la pianificazione per prestazioni ed efficienza ottimali.

Esempio: errori di analisi DAG e latenza a causa del codice DAG complesso

In questo esempio, esamini la latenza di analisi di un DAG di esempio che imita un eccesso di variabili Airflow.

Crea una nuova variabile Airflow

Prima di caricare il codice campione, crea una nuova variabile Airflow.

Nella console Google Cloud , vai alla pagina Ambienti.

Nella colonna Server web Airflow, segui il link Airflow per il tuo ambiente.

Vai ad Amministrazione > Variabili > Aggiungi un nuovo record.

Imposta i seguenti valori:

- chiave:

example_var - val:

test_airflow_variable

- chiave:

Carica il DAG di esempio nel tuo ambiente

Carica il seguente DAG di esempio nell'ambiente

che hai creato nei passaggi precedenti. In questo tutorial, questo DAG si chiama

dag_for_loop_airflow_variable.

Questo DAG contiene un ciclo for che viene eseguito 1000 volte e imita un eccesso di

variabili Airflow. Ogni iterazione legge la variabile example_var e

genera un'attività. Ogni attività contiene un comando che stampa il valore della variabile.

from datetime import datetime

from airflow import DAG

from airflow.operators.bash_operator import BashOperator

from airflow.models import Variable

default_args = {

'owner': 'airflow',

'depends_on_past': False,

'start_date': datetime(2023, 2, 17),

'retries': 0

}

dag = DAG(

'dag_for_loop_airflow_variable',

default_args=default_args,

catchup=False,

schedule_interval="@daily"

)

for i in range(1000):

a = Variable.get('example_var', 'N/A')

task = BashOperator(

task_id=f'task_{i}',

bash_command='echo variable foo=${foo_env}',

dag=dag,

env={'foo_env': a}

)

Diagnosticare i problemi di analisi

Il tempo di analisi del DAG è il tempo necessario allo scheduler Airflow per leggere un file DAG e analizzarlo. Prima che lo scheduler Airflow possa pianificare qualsiasi attività da un DAG, deve analizzare il file DAG per scoprire la struttura del DAG e le attività definite.

Se l'analisi di un DAG richiede molto tempo, la capacità dello scheduler viene consumata e le prestazioni delle esecuzioni del DAG potrebbero ridursi.

Per monitorare il tempo di analisi del DAG:

Esegui il

dags reportcomando dell'interfaccia a riga di comando di Airflow in gcloud CLI per visualizzare il tempo di analisi di tutti i tuoi DAG:gcloud composer environments run ENVIRONMENT_NAME \ --location LOCATION \ dags reportSostituisci quanto segue:

ENVIRONMENT_NAME: il nome del tuo ambiente.LOCATION: la regione in cui si trova l'ambiente.

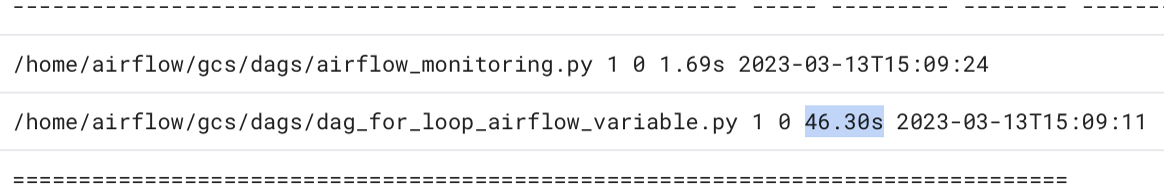

Nell'output del comando, cerca il valore della durata del DAG

dag_for_loop_airflow_variables. Un valore elevato potrebbe indicare che questo DAG non è implementato in modo ottimale. Se hai più DAG, dalla tabella di output puoi identificare i DAG con un lungo tempo di analisi.Esempio:

file | duration | dag_num | task_num | dags ====================+================+=========+==========+===================== /dag_for_loop_airfl | 0:00:14.773594 | 1 | 1000 | dag_for_loop_airflow ow_variable.py | | | | _variable /airflow_monitoring | 0:00:00.003035 | 1 | 1 | airflow_monitoring .pyEsamina i tempi di analisi dei DAG nella console Google Cloud :

- Nella console Google Cloud , vai alla pagina Ambienti.

Nell'elenco degli ambienti, fai clic sul nome del tuo ambiente. Viene visualizzata la pagina Dettagli ambiente.

Vai alla scheda Log, poi a Tutti i log > Gestore processore DAG.

Esamina i log

dag-processor-managere identifica i possibili problemi.

Figura 13. I log del gestore processore DAG mostrano i tempi di analisi DAG (fai clic per ingrandire)

Se il tempo totale di analisi del DAG supera i 10 secondi circa, gli scheduler potrebbero essere sovraccarichi di analisi del DAG e non possono eseguire i DAG in modo efficace.

Ottimizza il codice DAG

È consigliabile evitare codice Python "di primo livello" non necessario nei DAG. I DAG con molti import, variabili e funzioni al di fuori del DAG introducono tempi di analisi maggiori per lo scheduler Airflow. Ciò riduce le prestazioni e la scalabilità di Cloud Composer e Airflow. L'eccesso di lettura delle variabili Airflow comporta tempi di analisi lunghi e un carico elevato del database. Se questo codice si trova in un file DAG, queste funzioni vengono eseguite a ogni heartbeat dello scheduler, il che potrebbe essere lento.

I campi modello di Airflow ti consentono di incorporare valori dalle variabili di Airflow e dai modelli Jinja nei tuoi DAG. In questo modo si evita l'esecuzione inutile di funzioni durante i battiti del cuore dello scheduler.

Per implementare l'esempio di DAG in modo migliore, evita di utilizzare le variabili Airflow nel codice Python di primo livello dei DAG. Trasferisci invece le variabili Airflow agli operatori esistenti tramite un modello Jinja, che ritarderà la lettura del valore fino all'esecuzione dell'attività.

Carica la nuova versione del DAG di esempio nel tuo

ambiente. In questo tutorial, questo DAG si chiama

dag_for_loop_airflow_variable_optimized.

from datetime import datetime

from airflow import DAG

from airflow.operators.bash_operator import BashOperator

default_args = {

'owner': 'airflow',

'depends_on_past': False,

'start_date': datetime(2023, 2, 17),

'retries': 0

}

dag = DAG(

'dag_for_loop_airflow_variable_optimized',

default_args=default_args,

catchup=False,

schedule_interval='@daily'

)

for i in range(1000):

task = BashOperator(

task_id=f'bash_use_variable_good_{i}',

bash_command='echo variable foo=${foo_env}',

dag=dag,

env={'foo_env': '{{ var.value.get("example_var") }}'},

)

Esamina il nuovo tempo di analisi del DAG:

Attendi il completamento dell'esecuzione del DAG.

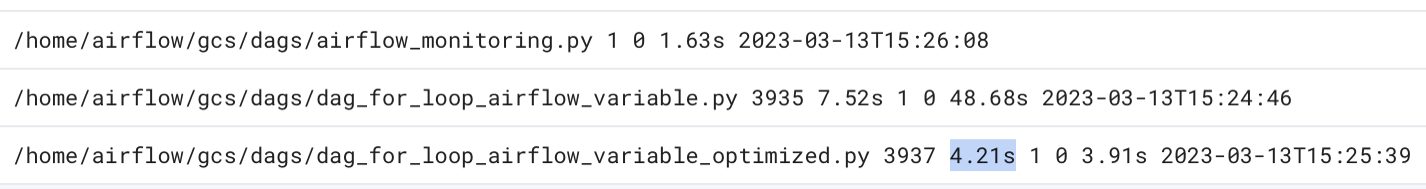

Esegui di nuovo il comando

dags reportper visualizzare il tempo di analisi di tutti i tuoi DAG:file | duration | dag_num | task_num | dags ====================+================+=========+==========+===================== /dag_for_loop_airfl | 0:00:37.000369 | 1 | 1000 | dag_for_loop_airflow ow_variable.py | | | | _variable /dag_for_loop_airfl | 0:00:01.109457 | 1 | 1000 | dag_for_loop_airflow ow_variable_optimiz | | | | _variable_optimized ed.py | | | | /airflow_monitoring | 0:00:00.040510 | 1 | 1 | airflow_monitoring .py | | | |Rivedi i log

dag-processor-managere analizza la durata dell'analisi.

Figura 14. I log del gestore processore DAG mostrano i tempi di analisi DAG dopo l'ottimizzazione del codice DAG (fai clic per ingrandire)

Sostituendo le variabili di ambiente con i modelli Airflow, hai semplificato il codice DAG e ridotto la latenza di analisi di circa dieci volte.

Ottimizza le configurazioni dell'ambiente Airflow

Lo scheduler di Airflow tenta costantemente di attivare nuove attività e analizza tutti i DAG nel bucket dell'ambiente. Se i tuoi DAG hanno un lungo tempo di analisi e lo scheduler consuma molte risorse, puoi ottimizzare le configurazioni dello scheduler di Airflow in modo che lo scheduler utilizzi le risorse in modo più efficiente.

In questo tutorial, l'analisi dei file DAG richiede molto tempo e i cicli di analisi

iniziano a sovrapporsi, il che esaurisce la capacità dello scheduler. Nel nostro esempio,

l'analisi del primo DAG richiede più di 5 secondi, quindi configurerai

lo scheduler in modo che venga eseguito meno frequentemente per utilizzare le risorse in modo più efficiente. Eseguirai l'override dell'opzione di configurazione di Airflow scheduler_heartbeat_sec. Questa configurazione definisce la frequenza di esecuzione dello

scheduler (in secondi). Per impostazione predefinita, il valore è impostato su 5 secondi.

Puoi modificare questa opzione di configurazione di Airflow

eseguendo l'override.

Esegui l'override dell'opzione di configurazione di Airflow scheduler_heartbeat_sec:

Nella console Google Cloud , vai alla pagina Ambienti.

Nell'elenco degli ambienti, fai clic sul nome del tuo ambiente. Viene visualizzata la pagina Dettagli ambiente.

Vai alla scheda Override della configurazione Airflow.

Fai clic su Modifica, poi su Aggiungi override della configurazione di Airflow.

Esegui l'override dell'opzione di configurazione di Airflow:

Sezione Chiave Valore schedulerscheduler_heartbeat_sec10Fai clic su Salva e attendi l'aggiornamento della configurazione dell'ambiente.

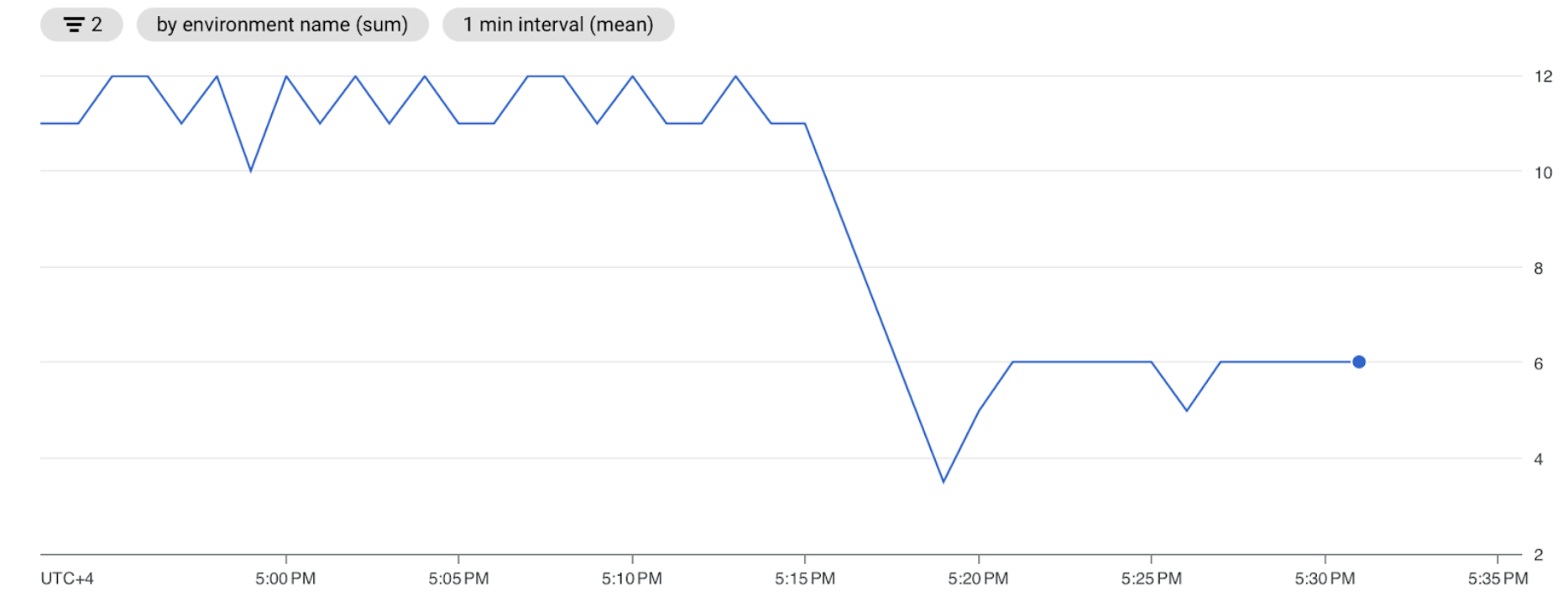

Controlla le metriche dello strumento di pianificazione:

Vai alla scheda Monitoraggio e seleziona Pianificatori.

Nel grafico Battito cardiaco dello scheduler, fai clic sul pulsante Altre opzioni (tre puntini) e poi su Visualizza in Esplora metriche.

Nel grafico, vedrai che lo scheduler viene eseguito due volte meno frequentemente dopo aver modificato la configurazione predefinita da 5 secondi a 10 secondi. Riducendo la frequenza dei battiti, ti assicuri che lo scheduler non inizi a essere eseguito mentre è in corso il ciclo di analisi precedente e che la capacità delle risorse dello scheduler non sia esaurita.

Assegnare più risorse allo strumento di pianificazione

In Cloud Composer 2, puoi allocare più risorse di CPU e memoria allo scheduler. In questo modo, puoi aumentare le prestazioni dello scheduler e accelerare il tempo di analisi del DAG.

Assegna CPU e memoria aggiuntive allo scheduler:

Nella console Google Cloud , vai alla pagina Ambienti.

Nell'elenco degli ambienti, fai clic sul nome del tuo ambiente. Viene visualizzata la pagina Dettagli ambiente.

Vai alla scheda Configurazione ambiente.

Trova la configurazione Risorse > Workload e fai clic su Modifica.

Nella sezione Pianificatore, nel campo Memoria, specifica il nuovo limite di memoria. In questo tutorial, utilizza 4 GB.

Nel campo CPU, specifica il nuovo limite della CPU. In questo tutorial, utilizza 2 vCPU.

Salva le modifiche e attendi diversi minuti per il riavvio degli scheduler Airflow.

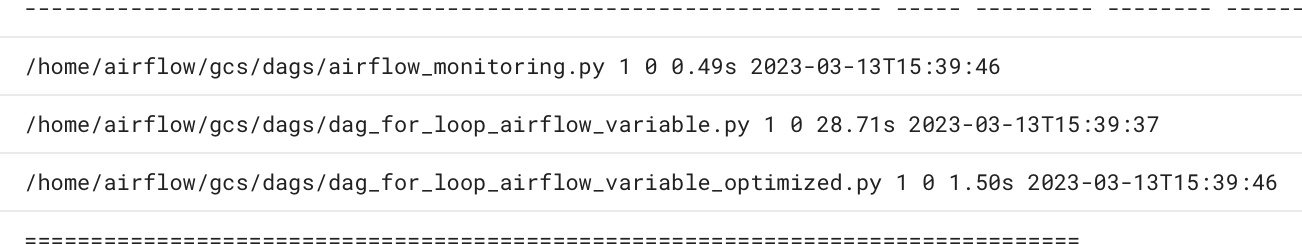

Vai alla scheda Log, poi a Tutti i log > Gestore processore DAG.

Esamina i log di

dag-processor-managere confronta la durata dell'analisi per gli esempi di DAG:

Figura 16. I log del gestore processore DAG mostrano i tempi di analisi DAG dopo l'assegnazione di altre risorse allo scheduler (fai clic per ingrandire)

Assegnando più risorse allo scheduler, hai aumentato la capacità dello scheduler e ridotto significativamente la latenza di analisi rispetto alle configurazioni dell'ambiente predefinite. Con più risorse, lo scheduler può analizzare i DAG più velocemente, tuttavia aumenteranno anche i costi associati alle risorse di Cloud Composer. Inoltre, non è possibile aumentare le risorse oltre un determinato limite.

Ti consigliamo di allocare le risorse solo dopo aver implementato le possibili ottimizzazioni del codice DAG e della configurazione di Airflow.

Esegui la pulizia

Per evitare che al tuo account Google Cloud vengano addebitati costi relativi alle risorse utilizzate in questo tutorial, elimina il progetto che contiene le risorse oppure mantieni il progetto ed elimina le singole risorse.

Elimina il progetto

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.

Elimina singole risorse

Se intendi esplorare più tutorial e guide rapide, il riuso dei progetti ti aiuta a non superare i limiti di quota.

Elimina l'ambiente Cloud Composer. Durante questa procedura, elimini anche il bucket dell'ambiente.

Passaggi successivi

- Ottimizzare le prestazioni e i costi dell'ambiente

- Scala gli ambienti

- Risoluzione dei problemi dei DAG