Cloud Composer 1 | Cloud Composer 2 | Cloud Composer 3

Ce guide explique comment créer un pipeline CI/CD pour tester, synchroniser et déployer des DAG dans votre environnement Cloud Composer à partir de votre dépôt GitHub.

Si vous souhaitez synchroniser uniquement les données d'autres services, consultez Transférer des données provenant d'autres services

Présentation du pipeline CI/CD

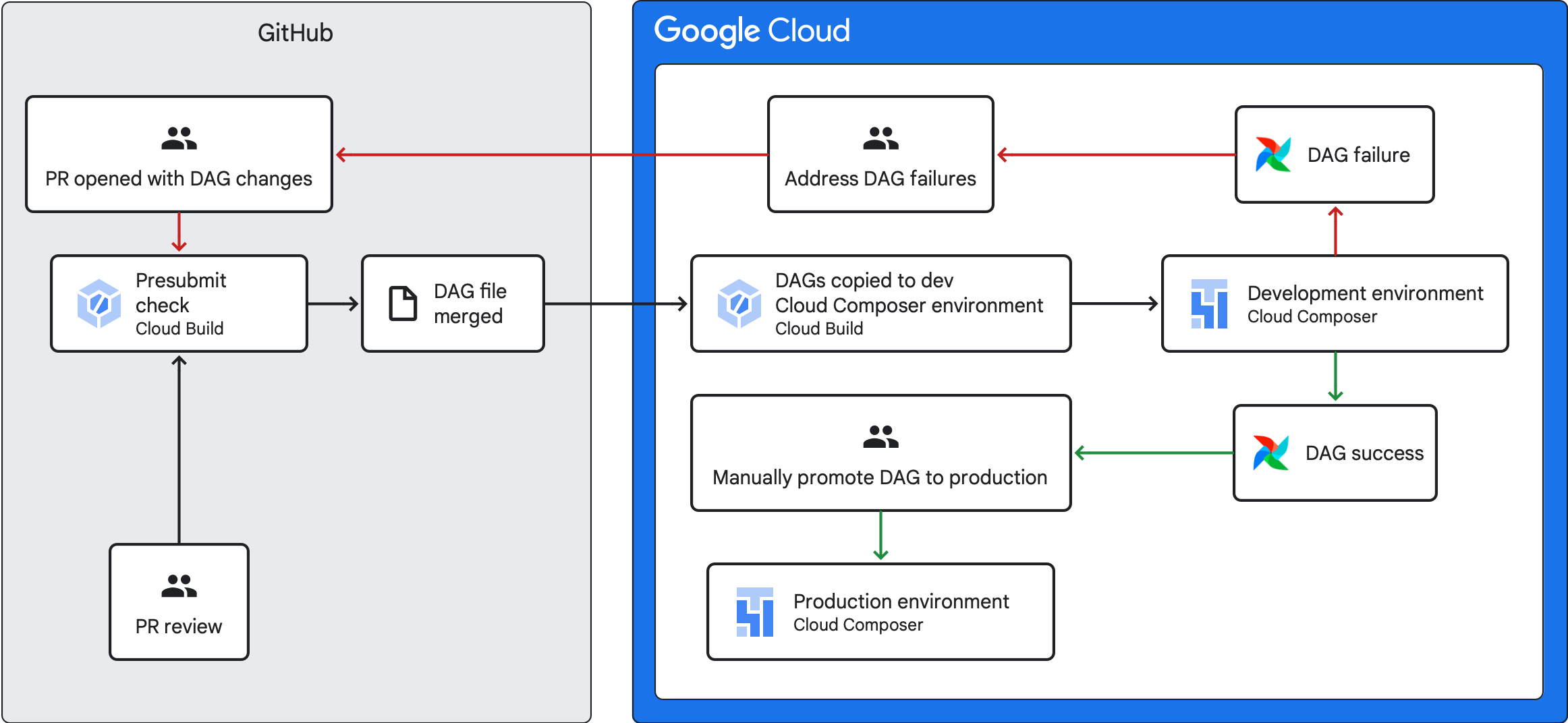

Le pipeline CI/CD qui permet de tester, de synchroniser et de déployer des DAG comprend les étapes suivantes :

Vous modifiez un DAG et transférez cette modification vers une branche de développement de votre dépôt.

Vous ouvrez une demande d'extraction sur la branche principale de votre dépôt.

Cloud Build exécute des tests unitaires pour vérifier la validité de votre DAG.

Votre demande d'extraction a été approuvée et fusionnée avec la branche principale de votre un dépôt de clés.

Cloud Build synchronise votre l'environnement Cloud Composer.

Vous vérifiez que le DAG se comporte comme prévu dans votre environnement de développement.

Si votre DAG fonctionne comme prévu, importez-le dans votre environnement Cloud Composer de production.

Objectifs

Avant de commencer

Ce guide part du principe que vous travaillez avec Environnements Cloud Composer: un environnement de développement et environnement de production.

Dans le cadre de ce guide, vous ne configurez qu'un pipeline CI/CD pour votre environnement de développement. Assurez-vous que l'environnement que vous utilisez n'est pas un environnement de production.

Dans ce guide, nous partons du principe que vos DAG et leurs tests sont stockés dans un dépôt GitHub un dépôt de clés.

La exemple de pipeline CI/CD illustre le contenu d'un exemple de dépôt. Les DAG et les tests sont stockés dans le répertoire

dags/, avec les fichiers de spécifications, le fichier de contraintes et les fichiers de configuration Cloud Build stockés au niveau supérieur. L'utilitaire de synchronisation des DAG et ses exigences se trouvent dans le Répertoireutils.

Créer une tâche de vérification avant envoi et des tests unitaires

Le premier job Cloud Build exécute une vérification avant envoi, qui exécute les unités pour vos DAG.

Ajouter des tests unitaires

Si ce n'est pas déjà fait,

tests unitaires pour vos DAG. Enregistrez ces tests en même temps que

DAG de votre dépôt, chacun portant le suffixe _test. Par exemple, le fichier de test du DAG dans example_dag.py est example_dag_test.py. Il s'agit des

qui s'exécutent en tant que contrôle avant envoi dans votre dépôt.

Créer une configuration YAML Cloud Build pour la vérification avant envoi

Dans votre dépôt, créez un fichier YAML nommé test-dags.cloudbuild.yaml qui

configure votre job Cloud Build pour les vérifications avant envoi. On y trouve

en trois étapes:

- Installez les dépendances requises par vos DAG.

- Installez les dépendances nécessaires à vos tests unitaires.

- Exécuter les tests du DAG

Créer le déclencheur Cloud Build pour la vérification avant envoi

Suivez les instructions pour créer des dépôts à partir de GitHub. pour créer un déclencheur basé sur une application GitHub avec les configurations suivantes:

Nom :

test-dagsÉvénement: Demande d'extraction

Source : dépôt : sélectionnez votre dépôt.

Source - Branche de base :

^main$(remplacezmainpar le nom de la branche de base de votre dépôt, si nécessaire)Source : contrôle des commentaires : non obligatoire

Configuration de la compilation : fichier de configuration Cloud Build :

/test-dags.cloudbuild.yaml(chemin d'accès à votre fichier de compilation)

Créer un job de synchronisation des DAG et ajouter le script utilitaire des DAG

Ensuite, configurez une tâche Cloud Build qui exécute un script d'utilitaire DAG. La script utilitaire de ce job synchronise vos DAG avec votre Environnement Cloud Composer après leur fusion avec la branche principale dans votre dépôt.

Ajouter le script de l'utilitaire des DAG

Ajoutez le script d'utilitaire DAG à votre dépôt. Ce script utilitaire copie tous les fichiers DAG dans le répertoire dags/ de votre

vers un répertoire temporaire, en ignorant tous les fichiers Python non DAG. Le script utilise ensuite la bibliothèque cliente Cloud Storage pour importer tous les fichiers de ce répertoire temporaire dans le répertoire dags/ du bucket de votre environnement Cloud Composer.

Créer une configuration YAML Cloud Build pour synchroniser les DAG

Dans votre dépôt, créez un fichier YAML nommé

add-dags-to-composer.cloudbuild.yaml qui configure votre instance Cloud Build

de synchronisation des DAG. Il comporte deux étapes:

Installez les dépendances requises par le script de l'utilitaire des DAG.

Exécutez le script de l'utilitaire pour synchroniser les DAG de votre dépôt avec votre Cloud Composer.

Créer le déclencheur Cloud Build

Suivez le guide Créer des dépôts à partir de GitHub pour créer un déclencheur basé sur une application GitHub avec les configurations suivantes :

Nom :

add-dags-to-composerÉvénement: Déployer sur une branche

Source – Dépôt: choisissez votre dépôt

Source : branche de base :

^main$(remplacezmainpar le nom de votre branche de base du dépôt, si nécessaire)Source – Filtre de fichiers inclus (glob):

dags/**Configuration de la compilation – Fichier de configuration Cloud Build:

/add-dags-to-composer.cloudbuild.yaml(chemin d'accès à votre fichier de compilation)

Dans la configuration avancée, ajoutez deux variables de substitution :

_DAGS_DIRECTORY: répertoire dans lequel se trouvent les dags dans votre dépôt. Si vous utilisez l'exemple de dépôt de ce guide, il s'agit dedags/._DAGS_BUCKET: bucket Cloud Storage contenant le répertoiredags/dans votre environnement de développement Cloud Composer. Omettez le préfixegs://. Par exemple,us-central1-example-env-1234ab56-bucket.

Tester votre pipeline CI/CD

Dans cette section, vous allez suivre un flux de développement de DAG qui utilise vos nouvelles les déclencheurs Cloud Build créés.

Exécuter un job de présoumission

Créez une demande d'extraction sur votre branche principale pour tester votre build. Recherchez votre vérification préalable à l'envoi sur la page. Cliquez sur Détails et sélectionnez Affichez plus d'informations sur Google Cloud Build pour consulter vos journaux de compilation dans le console Google Cloud.

Si la vérification préalable à l'envoi a échoué, consultez Résoudre les échecs de compilation.

Vérifier que votre DAG fonctionne dans votre environnement Cloud Composer de développement

Une fois votre demande d'extraction approuvée, fusionnez-la avec votre branche principale. Utilisez la console Google Cloud pour afficher les résultats de votre compilation. Si vous disposez de nombreux déclencheurs Cloud Build, vous pouvez filtrer vos compilations en fonction du nom du déclencheur add-dags-to-composer.

Une fois la tâche de synchronisation Cloud Build terminée, le DAG synchronisé apparaît dans votre environnement Cloud Composer de développement. Vous pouvez alors vérifier que le DAG fonctionne comme prévu.

Ajouter le DAG à votre environnement de production

Une fois que le DAG fonctionne comme prévu, ajoutez-le manuellement à votre environnement de production

environnement. Pour ce faire, importez le fichier DAG dans le répertoire dags/ du bucket de votre environnement Cloud Composer de production.

Si votre job de synchronisation de DAG a échoué ou si votre DAG ne se comporte pas comme prévu dans votre dans l'environnement Cloud Composer de développement, consultez Corriger les échecs de compilation

Résoudre les échecs de compilation

Cette section explique comment résoudre les scénarios courants d'échec de compilation.

Que faire si la vérification préalable à l'envoi a échoué ?

Dans votre demande de tirage, cliquez sur Détails, puis sélectionnez Afficher plus d'informations sur Google Cloud Build pour afficher vos journaux de compilation dans la console Google Cloud. Utilisez ces journaux pour vous aider à déboguer le problème lié à votre DAG. Une fois les problèmes résolus, validez la correction et déployez-la ou une autre branche. La vérification avant l'envoi est à nouveau exécutée, et vous pouvez continuer à itérer en utilisant les journaux comme outil de débogage.

Que faire si mon travail de synchronisation DAG a échoué ?

Utilisez la console Google Cloud pour afficher les résultats de votre compilation. Si vous disposez de nombreux déclencheurs Cloud Build, vous pouvez filtrer vos compilations en fonction du nom du déclencheur add-dags-to-composer. Examinez les journaux de la tâche de compilation et corrigez les erreurs. Si vous avez besoin d'aide supplémentaire pour résoudre les erreurs, utilisez les canaux d'assistance.

Que faire si mon DAG ne fonctionne pas correctement dans mon environnement Cloud Composer ?

Si votre DAG ne fonctionne pas comme prévu dans votre processus de développement dans l'environnement Cloud Composer, ne promouvez pas manuellement le DAG l'environnement Cloud Composer de production. Effectuez plutôt l'une des opérations suivantes :

- Annuler la demande d'extraction avec les modifications qui ont interrompu votre DAG afin de le restaurer à l'état immédiatement avant vos modifications (cela annule également tous les autres fichiers inclus dans cette demande d'extraction).

- Créez une nouvelle demande d'extraction pour annuler manuellement les modifications apportées au DAG défectueux.

- Créez une demande d'extraction pour corriger les erreurs dans votre DAG.

Le fait de suivre l'une de ces étapes déclenche une nouvelle vérification avant l'envoi. Lors de la fusion, le job de synchronisation du DAG.

Étape suivante

- Exécuter des environnements Airflow locaux

- Écrire des DAG

- Planifier et déclencher des DAG

- Tester les DAG