Como avaliar modelos

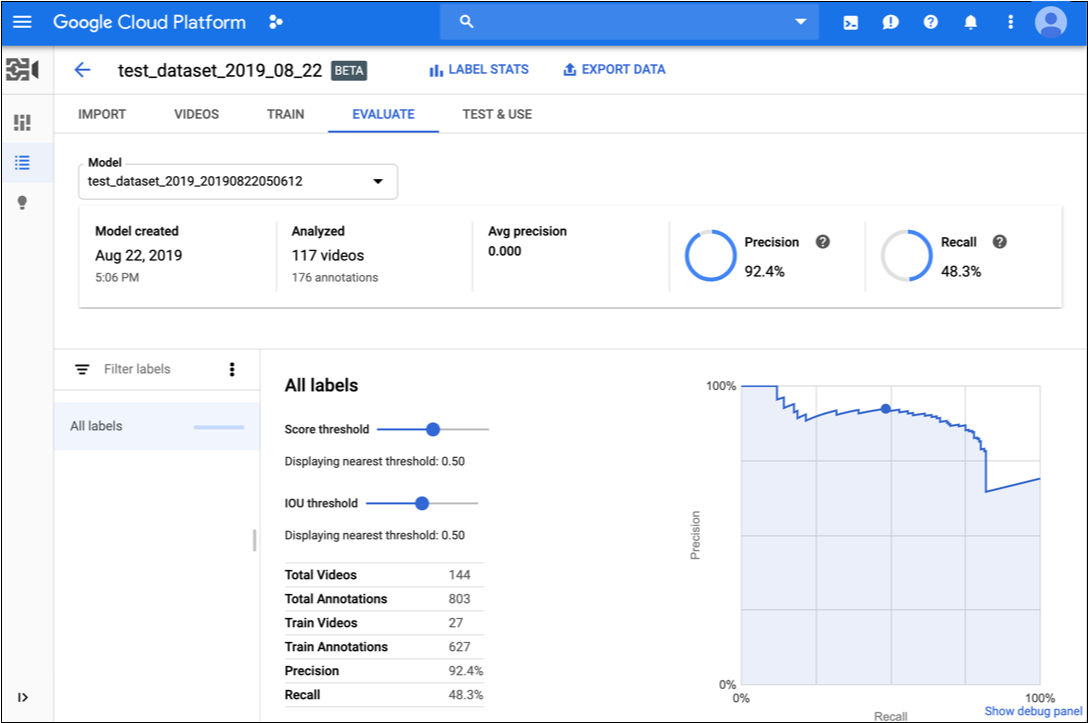

Depois de treinar um modelo, o rastreamento de objetos do AutoML Video Intelligence usa itens do conjunto TEST para avaliar a qualidade e a precisão deste modelo.

No rastreamento de objetos do AutoML Video Intelligence, há um conjunto agregado de métricas de avaliação que indicam o desempenho geral do modelo, bem como as métricas de avaliação de cada rótulo de categoria, indicando o desempenho do modelo para esse rótulo.

IoU: Intersecção sobre União, uma métrica usada no rastreamento de objetos para medir a sobreposição de uma caixa delimitadora prevista versus real para uma instância de objeto em um frame de vídeo. Quanto mais próximos os valores previstos da caixa delimitadora estiverem dos valores reais, maior será a interseção e o valor de IoU.

AuPRC: área sob a curva de recall/precisão, também conhecida como "precisão média". Normalmente entre 0,5 e 1. Valores mais altos indicam modelos mais precisos.

As curvas de limite de confiança mostram como diferentes limites de confiança podem afetar a precisão, o recall e as taxas de resultados verdadeiros e falsos positivos. Leia sobre a relação entre precisão e recall.

Use esses dados para avaliar a prontidão do seu modelo. Baixa pontuação de AUC ou baixas pontuações de precisão e recall podem indicar que o modelo precisa de dados de treinamento extras ou tem rótulos inconsistentes. Uma pontuação AUC muito alta e precisão e recall perfeitos podem indicar que os dados são fáceis demais e têm pouca capacidade de generalização.

Conseguir valores de avaliação do modelo

IU da Web

-

Abra a página Modelos na interface de usuário de rastreamento de objetos do AutoML Video.

-

Clique na linha do modelo que você quer avaliar.

-

Clique na guia Avaliar.

Se o treinamento do modelo tiver sido concluído, o rastreamento de objetos de vídeo do AutoML mostrará as métricas de avaliação.

- Para visualizar as métricas de um rótulo específico, selecione o nome dele na lista na parte inferior da página.

REST

Antes de usar os dados da solicitação, faça as substituições a seguir:

- model-id: substitua pelo identificador do modelo;

- project-number: o número do seu projeto

- location-id: a região do Cloud em que a anotação deve ocorrer. As regiões de nuvem compatíveis são:

us-east1,us-west1,europe-west1easia-east1. Se nenhuma região for especificada, uma região será determinada com base na localização do arquivo de vídeo.

Método HTTP e URL:

GET https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/models/model-id:modelEvaluations

Para enviar a solicitação, escolha uma destas opções:

curl

execute o seguinte comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-number" \

"https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/models/model-id:modelEvaluations"

PowerShell

execute o seguinte comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-number" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1beta1/projects/project-number/locations/location-id/models/model-id:modelEvaluations" | Select-Object -Expand Content

8703337066443674578.

Java

Para autenticar o rastreamento de objetos de vídeo do AutoML, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Node.js

Para autenticar o rastreamento de objetos de vídeo do AutoML, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Python

Para autenticar o rastreamento de objetos de vídeo do AutoML, configure o Application Default Credentials. Para mais informações, consulte Configurar a autenticação para um ambiente de desenvolvimento local.

Iterar o modelo

Se você não estiver satisfeito com os níveis de qualidade, volte às etapas anteriores para melhorá-los:

- Talvez seja necessário adicionar diferentes tipos de vídeo, como ângulo amplo, resolução maior ou menor ou pontos de vista diferentes.

- Remova todos os rótulos se não houver vídeos de treinamento suficientes.

- Lembre-se de que a máquina não consegue ler o nome do rótulo. É apenas uma string aleatória de letras para ela. Se você tem um rótulo que diz "porta" e outro que diz "porta_com_maçaneta", a máquina não tem como descobrir a nuance além dos vídeos fornecidos.

- Aumente seus dados com mais exemplos de positivos e negativos verdadeiros. Exemplos especialmente importantes são aqueles que estão próximos da fronteira de decisão.

Depois de fazer as alterações, treine e avalie um novo modelo até atingir um nível de qualidade alto o suficiente.