LangChain di Vertex AI (Pratinjau) memungkinkan Anda menggunakan library open source LangChain untuk mem-build aplikasi AI Generatif kustom dan menggunakan Vertex AI untuk model, alat, dan deployment. Dengan LangChain di Vertex AI (Pratinjau), Anda dapat melakukan hal berikut:

- Pilih model bahasa besar (LLM) yang ingin Anda gunakan.

- Menentukan alat untuk mengakses API eksternal.

- Strukturkan antarmuka antara pengguna dan komponen sistem dalam framework orkestrasi.

- Deploy framework ke runtime terkelola.

Manfaat

- Dapat disesuaikan: Dengan memanfaatkan antarmuka standar LangChain, LangChain di Vertex AI dapat digunakan untuk membuat berbagai jenis aplikasi. Anda dapat menyesuaikan logika aplikasi dan menggabungkan framework apa pun, yang memberikan tingkat fleksibilitas yang tinggi.

- Menyederhanakan deployment: LangChain di Vertex AI menggunakan API yang sama dengan LangChain untuk berinteraksi dengan LLM dan mem-build aplikasi. LangChain di Vertex AI menyederhanakan dan mempercepat deployment dengan LLM Vertex AI karena runtime Reasoning Engine mendukung deployment sekali klik untuk menghasilkan API yang mematuhi berdasarkan library Anda.

- Integrasi dengan ekosistem Vertex AI: Reasoning Engine untuk LangChain di Vertex AI menggunakan infrastruktur dan penampung bawaan Vertex AI untuk membantu Anda men-deploy aplikasi LLM. Anda dapat menggunakan Vertex AI API untuk berintegrasi dengan model Gemini, Panggilan Fungsi, dan Ekstensi.

- Aman, pribadi, dan skalabel: Anda dapat menggunakan satu panggilan SDK, bukan mengelola proses pengembangan sendiri. Runtime terkelola Reasoning Engine membebaskan Anda dari tugas seperti pengembangan server aplikasi, pembuatan penampung, dan konfigurasi autentikasi, IAM, dan penskalaan. Vertex AI menangani penskalaan otomatis, perluasan regional, dan kerentanan penampung.

Kasus penggunaan

Untuk mempelajari LangChain di Vertex AI dengan contoh menyeluruh, lihat referensi berikut:

| Kasus Penggunaan | Deskripsi | Link |

|---|---|---|

| Membangun aplikasi AI generatif dengan terhubung ke API publik | Mengonversi antar-mata uang. Buat fungsi yang terhubung ke aplikasi pertukaran mata uang, sehingga model dapat memberikan jawaban yang akurat untuk kueri seperti "Berapa rasio pertukaran euro ke dolar hari ini?" |

Notebook Vertex AI SDK untuk Python - Pengantar Mem-build dan Men-deploy Agen dengan Reasoning Engine |

| Mendesain project panel surya komunitas. Identifikasi lokasi potensial, cari kantor pemerintah dan pemasok yang relevan, serta tinjau citra satelit dan potensi tenaga surya di wilayah dan bangunan untuk menemukan lokasi optimal untuk memasang panel surya Anda. |

Notebook Vertex AI SDK untuk Python - Mem-build dan Men-deploy Agen Google Maps API dengan Vertex AI Reasoning Engine | |

| Membangun aplikasi AI generatif dengan menghubungkan ke database | Integrasi dengan AlloyDB dan CloudSQL PostgreSQL. | Postingan blog - Mengumumkan LangChain di Vertex AI untuk AlloyDB dan Cloud SQL untuk PostgreSQL Notebook Vertex AI SDK untuk Python - Men-deploy Aplikasi RAG dengan Cloud SQL untuk PostgreSQL ke LangChain di Vertex AI Notebook Vertex AI SDK untuk Python - Men-deploy Aplikasi RAG dengan AlloyDB ke LangChain di Vertex AI |

| Buat kueri dan pahami datastore terstruktur menggunakan bahasa alami. | Notebook Vertex AI SDK for Python - Membuat Agen Penelusuran Percakapan dengan Vertex AI Reasoning Engine dan RAG di Vertex AI Search | |

| Membuat kueri dan memahami database grafik menggunakan bahasa alami | Postingan blog - Agen AI dan GraphRAG GenAI menggunakan Vertex AI Reasoning Engine dengan LangChain dan Neo4j | |

| Membuat kueri dan memahami penyimpanan vektor menggunakan natural language | Postingan blog - Menyederhanakan RAG GenAI dengan MongoDB Atlas dan Vertex AI Reasoning Engine | |

| Membangun aplikasi AI generatif dengan framework OSS | Mem-build dan men-deploy agen menggunakan framework open source OneTwo. | Postingan blog - OneTwo dan Vertex AI Reasoning Engine: menjelajahi pengembangan agen AI lanjutan di Google Cloud |

| Mem-build dan men-deploy agen menggunakan framework open source LangGraph. | Notebook Vertex AI SDK untuk Python - Mem-build dan Men-deploy Aplikasi LangGraph dengan Vertex AI Reasoning Engine | |

| Men-debug dan mengoptimalkan aplikasi AI generatif | Membuat dan melacak agen menggunakan OpenTelemetry dan Cloud Trace. | Notebook Vertex AI SDK for Python - Men-debug dan Mengoptimalkan Agen: Panduan Pelacakan di Vertex AI Reasoning Engine |

Komponen sistem

Membangun dan men-deploy aplikasi AI generatif kustom menggunakan OSS LangChain dan Vertex AI terdiri dari empat komponen:

| Komponen | Deskripsi |

|---|---|

| LLM |

Saat Anda mengirimkan kueri ke aplikasi kustom, LLM akan memproses kueri dan memberikan respons. Anda dapat memilih untuk menentukan serangkaian alat yang berkomunikasi dengan API eksternal dan menyediakannya ke model. Saat memproses kueri, model mendelegasikan tugas tertentu ke alat. Hal ini menyiratkan satu atau beberapa panggilan model ke model dasar atau yang telah disesuaikan. Untuk mempelajari lebih lanjut, lihat Versi dan siklus proses model. |

| Alat |

Anda dapat memilih untuk menentukan serangkaian alat yang berkomunikasi dengan API eksternal (misalnya, database) dan menyediakannya ke model. Saat memproses kueri, model dapat mendelegasikan tugas tertentu ke alat. Deployment melalui runtime terkelola Vertex AI dioptimalkan untuk menggunakan alat berdasarkan Panggilan Fungsi Gemini, tetapi mendukung Panggilan Alat/Fungsi LangChain. Untuk mempelajari Panggilan Fungsi Gemini lebih lanjut, lihat Panggilan fungsi. |

| Framework orkestrasi |

LangChain di Vertex AI memungkinkan Anda menggunakan framework orkestrasi LangChain di Vertex AI. Gunakan LangChain untuk menentukan seberapa deterministik aplikasi Anda. Jika sudah menggunakan LangChain, Anda dapat menggunakan kode LangChain yang ada untuk men-deploy aplikasi di Vertex AI. Atau, Anda dapat membuat kode aplikasi Anda sendiri dan menyusunnya dalam framework orkestrasi yang memanfaatkan template LangChain Vertex AI. Untuk mempelajari lebih lanjut, lihat Mengembangkan aplikasi. |

| Runtime terkelola | LangChain di Vertex AI memungkinkan Anda men-deploy aplikasi ke runtime yang dikelola Reasoning Engine. Runtime ini adalah layanan Vertex AI yang memiliki semua manfaat integrasi Vertex AI: keamanan, privasi, visibilitas, dan skalabilitas. Anda dapat membuat aplikasi dalam skala produksi dan menskalakannya dengan panggilan API, yang dengan cepat mengubah prototipe yang diuji secara lokal menjadi deployment siap perusahaan. Untuk mempelajari lebih lanjut, lihat Men-deploy aplikasi. |

Ada banyak cara untuk membuat prototipe dan mem-build aplikasi AI Generatif kustom yang menggunakan kemampuan agen dengan menyusun alat dan fungsi kustom di atas model seperti Gemini. Saat tiba waktunya untuk memindahkan aplikasi ke produksi, Anda perlu mempertimbangkan cara men-deploy dan mengelola agen serta komponen dasarnya.

Dengan komponen LangChain di Vertex AI, tujuannya adalah untuk membantu Anda berfokus pada dan menyesuaikan aspek kemampuan agen yang paling Anda pedulikan, seperti fungsi kustom, perilaku agen, dan parameter model, sedangkan Google menangani deployment, penskalaan paket, dan versi. Jika bekerja di tingkat yang lebih rendah dalam stack, Anda mungkin perlu mengelola lebih banyak dari yang Anda inginkan. Jika bekerja di tingkat yang lebih tinggi dalam stack, Anda mungkin tidak memiliki kontrol developer sebanyak yang Anda inginkan.

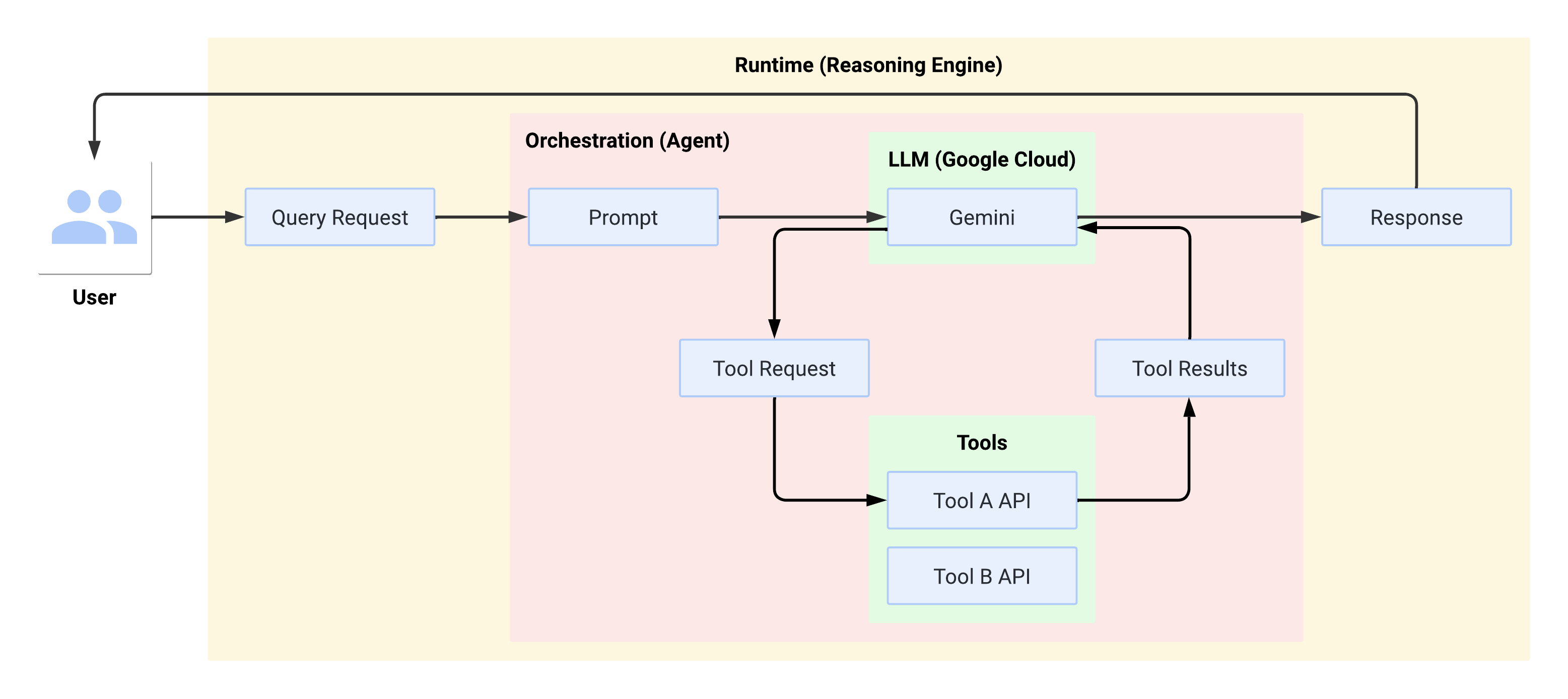

Alur sistem saat runtime

Saat pengguna membuat kueri, agen yang ditentukan akan memformatnya menjadi perintah untuk LLM. LLM memproses perintah dan menentukan apakah ingin menggunakan salah satu alat.

Jika memilih untuk menggunakan alat, LLM akan menghasilkan FunctionCall dengan nama

dan parameter yang akan digunakan untuk memanggil alat. Agen memanggil alat

dengan FunctionCall dan memberikan hasil dari alat tersebut kembali ke LLM.

Jika memilih untuk tidak menggunakan alat apa pun, LLM akan menghasilkan konten yang

diteruskan oleh agen kembali ke pengguna.

Diagram berikut mengilustrasikan alur sistem saat runtime:

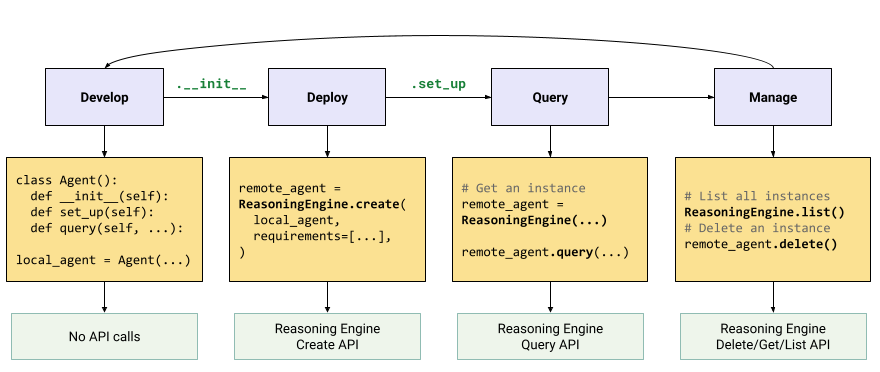

Membuat dan men-deploy aplikasi AI generatif

Alur kerja untuk membuat aplikasi AI generatif adalah:

| Langkah | Deskripsi |

|---|---|

| 1. Menyiapkan lingkungan | Siapkan project Google Anda dan instal Vertex AI SDK untuk Python versi terbaru. |

| 2. Mengembangkan aplikasi | Mengembangkan aplikasi LangChain yang dapat di-deploy di Reasoning Engine. |

| 3. Men-deploy aplikasi | Deploy aplikasi di Reasoning Engine. |

| 4. Menggunakan aplikasi | Kueri Mesin Penalaran untuk mendapatkan respons. |

| 5. Mengelola aplikasi yang di-deploy | Mengelola dan menghapus aplikasi yang telah Anda deploy ke Reasoning Engine. |

| 6. (Opsional) Menyesuaikan template aplikasi | Menyesuaikan template untuk aplikasi baru. |

Langkah-langkahnya diilustrasikan oleh diagram berikut:

Harga

Struktur harga didasarkan pada jam vCPU dan jam GiB yang digunakan selama pemrosesan permintaan, startup container, dan penonaktifan container. Artinya, Anda akan ditagih untuk resource komputasi (vCPU) dan memori yang digunakan oleh beban kerja Anda.

Sebaiknya hapus resource yang tidak digunakan untuk menghindari biaya yang tidak diinginkan.