Halaman ini memberikan ringkasan tentang penyesuaian model teks dan chat serta menyaring model teks. Anda akan mempelajari jenis penyesuaian yang tersedia dan cara kerja distilasi. Anda juga akan mempelajari manfaat penyesuaian dan distilasi, serta skenario kapan Anda mungkin ingin menyesuaikan atau menyaring model teks.

Menyesuaikan model

Anda dapat memilih salah satu metode berikut untuk menyesuaikan model teks:

Penyesuaian yang diawasi - Model pembuatan teks dan chat teks mendukung penyesuaian yang diawasi. Penyesuaian model teks yang diawasi adalah opsi yang bagus jika output model Anda tidak kompleks dan relatif mudah ditentukan. Penyesuaian yang diawasi direkomendasikan untuk klasifikasi, analisis sentimen, ekstraksi entity, peringkasan konten yang tidak kompleks, dan penulisan kueri khusus domain. Untuk model kode, penyesuaian yang diawasi adalah satu-satunya opsi. Untuk mempelajari cara menyesuaikan model teks dengan penyesuaian yang diawasi, lihat Menyesuaikan model teks dengan penyesuaian yang diawasi.

Reinforcement Learning from Human Feedback (RLHF) - Model dasar pembuatan teks dan beberapa model transformer transfer teks-ke-teks Flan (Flan-T5) mendukung penyesuaian RLHF. Penyesuaian RLHF adalah opsi yang bagus jika output model Anda kompleks. RLHF berfungsi dengan baik pada model dengan tujuan level urutan yang tidak mudah dibedakan dengan penyesuaian yang diawasi. Penyesuaian RLHF direkomendasikan untuk question answering, peringkasan konten yang kompleks, dan pembuatan konten, seperti penulisan ulang. Untuk mempelajari cara menyesuaikan model teks dengan penyesuaian RLHF, lihat Menyesuaikan model teks dengan penyesuaian RLHF.

Manfaat penyesuaian model teks

Model teks yang disesuaikan dilatih pada lebih banyak contoh daripada yang dapat dimuat dalam perintah. Oleh karena itu, setelah model yang dilatih sebelumnya disesuaikan, Anda dapat memberikan lebih sedikit contoh dalam perintah dibandingkan perintah pada model asli yang dilatih sebelumnya. Dengan diperlukannya lebih sedikit contoh, berikut manfaat yang akan diberikan:

- Latensi yang lebih rendah dalam permintaan.

- Lebih sedikit token yang digunakan.

- Latensi yang lebih rendah dan token yang lebih sedikit akan mengurangi biaya inferensi.

Distilasi model

Selain penyesuaian RLHF dan yang diawasi, Vertex AI mendukung distilasi model. Distilasi adalah proses pelatihan model siswa yang lebih kecil pada model pengajar yang lebih besar untuk meniru perilaku model yang lebih besar sekaligus memperkecil ukurannya.

Ada beberapa jenis distilasi model, termasuk:

- Berbasis respons: Melatih model siswa berdasarkan probabilitas respons model pengajar.

- Berbasis fitur: Melatih model siswa untuk meniru lapisan dalam model pengajar.

- Berbasis relasi: Melatih model siswa pada hubungan dalam data input atau output model pengajar.

- Distilasi mandiri: Model pengajar dan siswa memiliki arsitektur yang sama dan model tersebut mengajar dirinya sendiri.

Manfaat distilasi langkah demi langkah

Manfaat meringkas langkah demi langkah meliputi:

- Akurasi yang lebih baik: Memisahkan langkah demi langkah telah terbukti lebih baik daripada standar perintah singkat di LLM.

- LLM yang diringkas dapat mencapai hasil pada tugas akhir tertentu pengguna yang mirip dengan hasil dari LLM yang jauh lebih besar.

- Mengatasi kendala data. Anda dapat menggunakan DSS dengan set data perintah yang tidak berlabel hanya dengan beberapa ribu contoh.

- Jejak hosting yang lebih kecil.

- Mengurangi latensi inferensi.

Memisahkan langkah demi langkah menggunakan Vertex AI

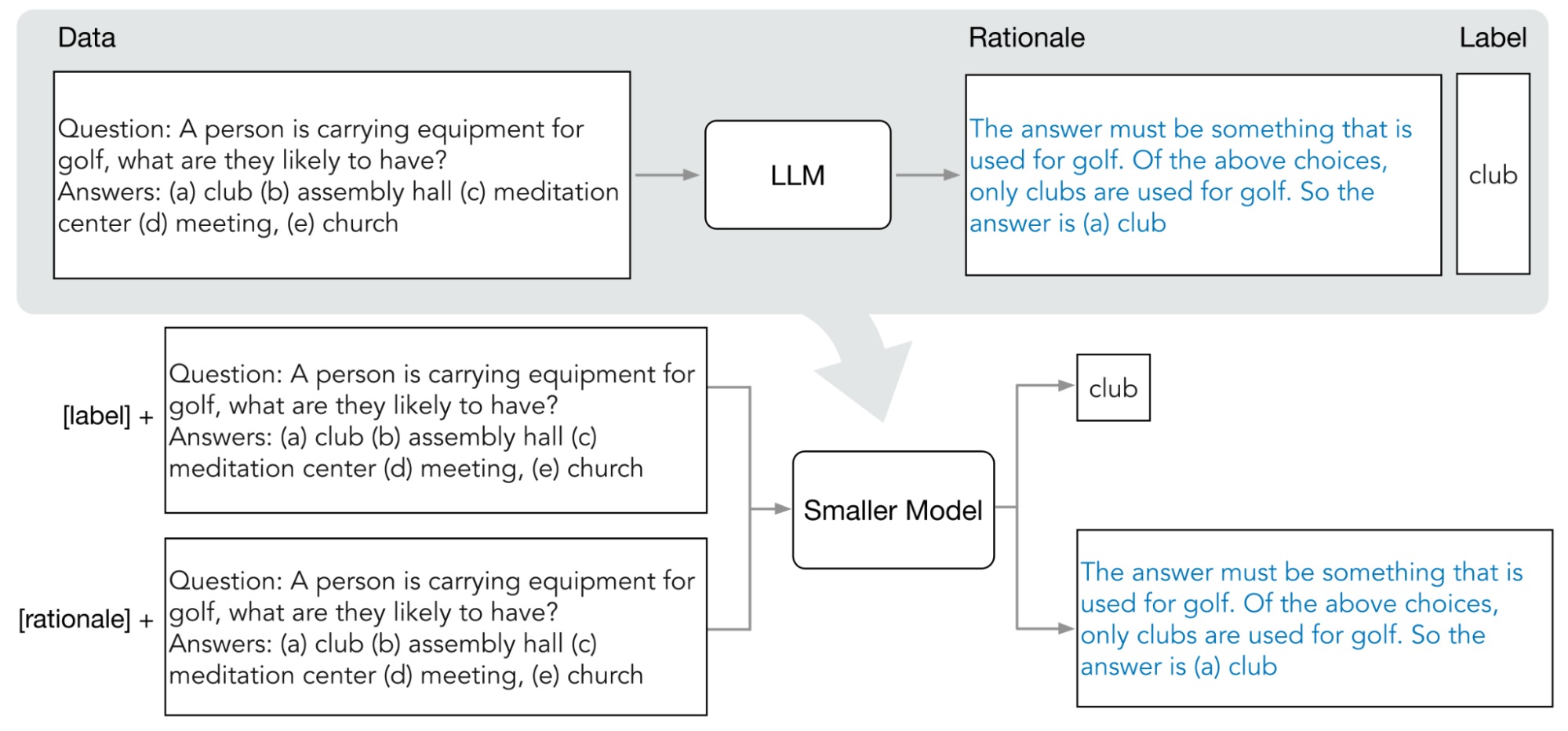

Vertex AI mendukung bentuk distilasi berbasis respons yang disebut distilling step-by-step (DSS). DSS adalah metode untuk melatih model khusus tugas yang lebih kecil melalui perintah rantai pemikiran (COT).

Untuk menggunakan DSS, Anda memerlukan set data pelatihan kecil yang terdiri dari input dan label. Jika label tidak tersedia, model pengajar akan membuat label. Alasan diekstrak oleh proses DSS, lalu digunakan untuk melatih model kecil dengan tugas pembuatan alasan dan tugas prediksi standar. Hal ini memungkinkan model kecil membuat penalaran perantara sebelum mencapai prediksi akhirnya.

Diagram berikut menunjukkan cara menyaring langkah demi langkah menggunakan perintah COT untuk mengekstrak alasan dari model bahasa besar (LLM). Alasan ini digunakan untuk melatih model khusus tugas yang lebih kecil.

Kuota

Setiap project Google Cloud memerlukan kuota yang cukup untuk menjalankan satu tugas penyesuaian, dan satu tugas penyesuaian menggunakan 8 GPU. Jika project Anda tidak memiliki cukup kuota untuk satu tugas penyesuaian, atau jika Anda ingin menjalankan beberapa tugas penyesuaian secara serentak di project, Anda harus meminta kuota tambahan.

Tabel berikut menunjukkan jenis dan jumlah kuota yang akan diminta, bergantung pada region tempat Anda menentukan penyesuaian akan dilakukan:

| Wilayah | Kuota resource | Jumlah per tugas serentak |

|---|---|---|

|

|

8 |

|

96 | |

|

|

64 |

Harga

Saat menyesuaikan atau menyaring model dasar, Anda membayar biaya untuk menjalankan pipeline penyesuaian atau distilasi. Saat men-deploy model dasar yang disesuaikan atau distilasi ke endpoint Vertex AI, Anda tidak akan dikenai biaya hosting. Untuk menayangkan prediksi, Anda membayar harga yang sama seperti yang Anda bayar saat menayangkan prediksi menggunakan model dasar yang tidak disesuaikan (untuk penyesuaian) atau model siswa (untuk penyulingan). Untuk mempelajari model dasar mana yang dapat disesuaikan dan distilasi, lihat Model dasar. Untuk mengetahui detail harga, lihat Harga AI Generatif di Vertex AI.

Langkah selanjutnya

- Pelajari cara menyesuaikan model dasar menggunakan penyesuaian yang diawasi.

- Pelajari cara menyesuaikan model dasar menggunakan penyesuaian RLHF.

- Pelajari cara menyesuaikan model kode.

- Pelajari cara membuat ringkasan model teks.