Il servizio di valutazione dell'AI generativa fornisce strumenti di livello enterprise per la valutazione oggettiva e basata sui dati dei modelli di AI generativa. Supporta e informa una serie di attività di sviluppo come le migrazioni di modelli, la modifica dei prompt e il perfezionamento.

Funzionalità di Gen AI evaluation service

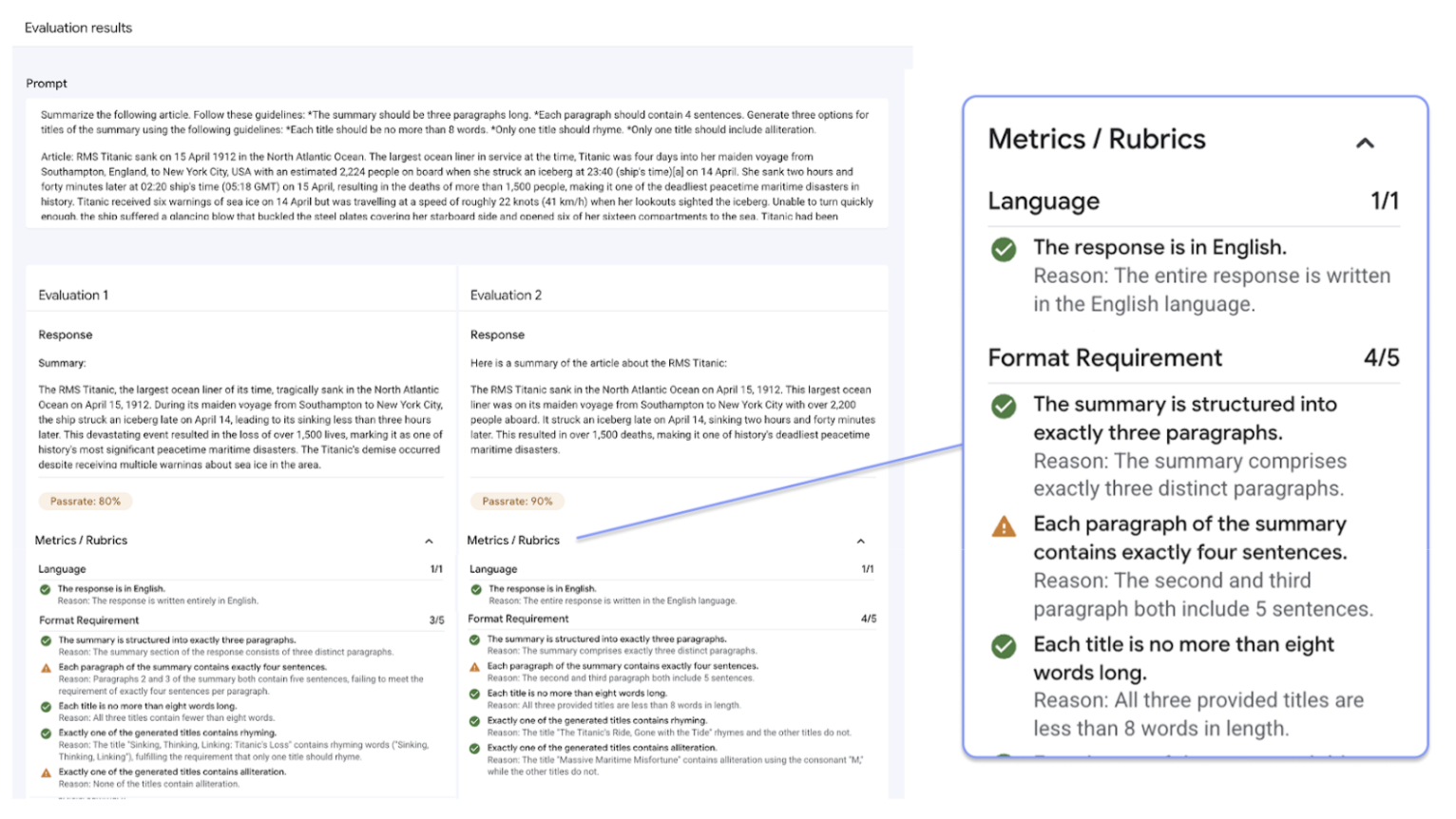

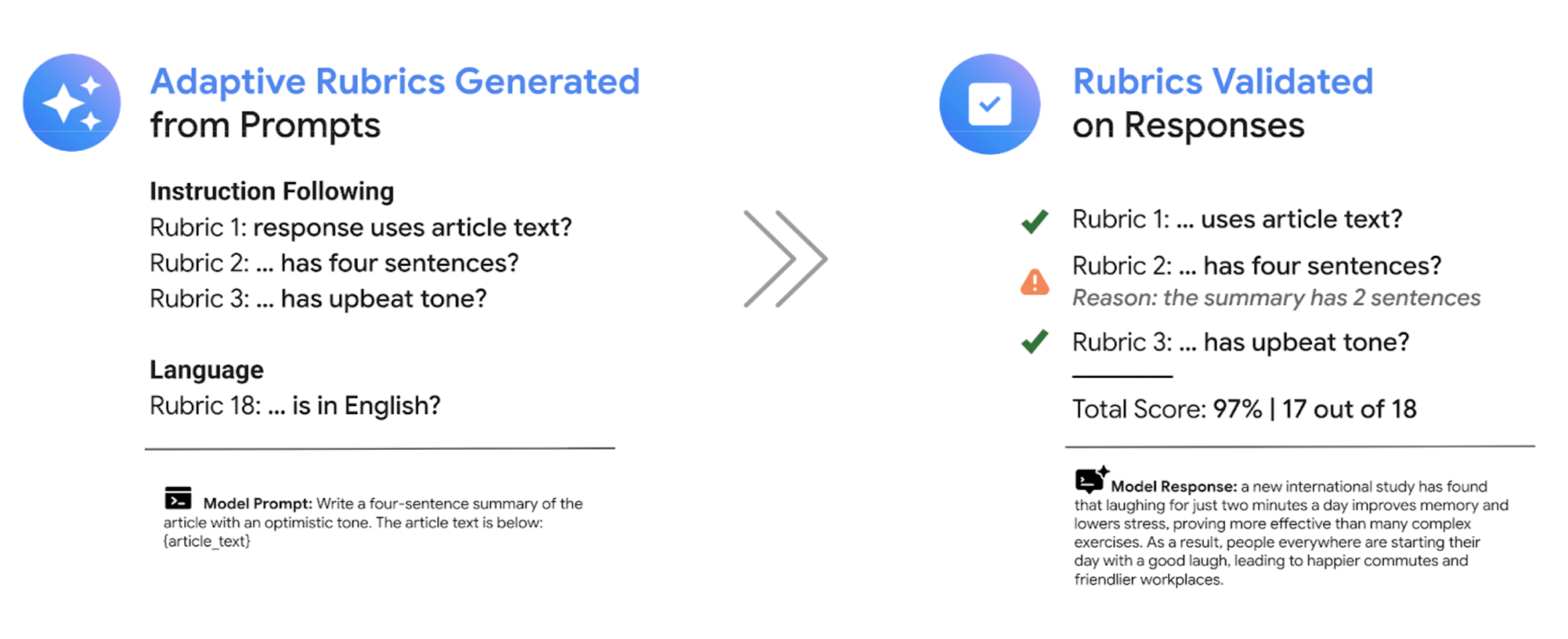

La caratteristica distintiva del servizio di valutazione dell'AI generativa è la possibilità di utilizzare griglie di valutazione adattive, un insieme di test personalizzati superati o non superati per ogni singolo prompt. Le rubriche di valutazione sono simili ai test delle unità nello sviluppo di software e mirano a migliorare le prestazioni del modello in una serie di attività.

Gen AI evaluation service supporta i seguenti metodi di valutazione comuni:

Rubriche adattive (consigliato): genera un insieme unico di rubriche superato/non superato per ogni prompt individuale nel set di dati.

Rubriche statiche: applica un insieme fisso di criteri di valutazione a tutti i prompt.

Metriche basate sul calcolo: utilizza algoritmi deterministici come

ROUGEoBLEUquando sono disponibili dati empirici reali.Funzioni personalizzate: definisci la tua logica di valutazione in Python per requisiti specializzati.

Generazione del set di dati di valutazione

Puoi creare un set di dati di valutazione nei seguenti modi:

Carica un file contenente istanze di prompt complete oppure fornisci un modello di prompt insieme a un file corrispondente di valori delle variabili per compilare i prompt completi.

Esegui il campionamento direttamente dai log di produzione per valutare l'utilizzo reale del tuo modello.

Utilizza la generazione di dati sintetici per generare un numero elevato di esempi coerenti per qualsiasi modello di prompt.

Interfacce supportate

Puoi definire ed eseguire le valutazioni utilizzando le seguenti interfacce:

Google Cloud Console: un'interfaccia utente web che fornisce un flusso di lavoro end-to-end guidato. Gestisci i tuoi set di dati, esegui valutazioni e analizza in dettaglio report e visualizzazioni interattivi. Consulta Eseguire la valutazione utilizzando la console.

SDK per Python: esegui valutazioni a livello di programmazione e visualizza confronti affiancati dei modelli direttamente nel tuo ambiente Colab o Jupyter. Consulta Eseguire la valutazione utilizzando il client GenAI nell'SDK Vertex AI

Casi d'uso

Il servizio di valutazione dell'AI generativa ti consente di vedere il rendimento di un modello in base alle tue attività specifiche e ai tuoi criteri unici, fornendo informazioni preziose che non possono essere derivate dalle classifiche pubbliche e dai benchmark generali. Ciò supporta attività di sviluppo critiche, tra cui:

Migrazioni di modelli: confronta le versioni dei modelli per comprendere le differenze comportamentali e perfezionare di conseguenza i prompt e le impostazioni.

Trovare il modello migliore: esegui confronti diretti tra i modelli di Google e di terze parti sui tuoi dati per stabilire una base di riferimento per il rendimento e identificare il modello più adatto al tuo caso d'uso.

Miglioramento dei prompt: utilizza i risultati della valutazione per guidare i tuoi sforzi di personalizzazione. L'esecuzione di nuovo di una valutazione crea un ciclo di feedback stretto, fornendo un feedback immediato e quantificabile sulle modifiche.

Ottimizzazione del modello: valuta la qualità di un modello ottimizzato applicando criteri di valutazione coerenti a ogni esecuzione.

Valutazioni con griglie di valutazione adattive

Le rubriche adattive sono il metodo consigliato per la maggior parte dei casi d'uso di valutazione e in genere sono il modo più rapido per iniziare a utilizzare le valutazioni.

Anziché utilizzare un insieme generale di griglie di valutazione come la maggior parte dei sistemi LLM-as-a-judge, il framework di valutazione basato sui test genera in modo adattivo un insieme unico di griglie di valutazione superate o non superate per ogni singolo prompt nel tuo set di dati. Questo approccio garantisce che ogni valutazione sia pertinente all'attività specifica in esame.

La procedura di valutazione per ogni prompt utilizza un sistema in due passaggi:

Generazione di rubriche: il servizio analizza innanzitutto il prompt e genera un elenco di test specifici e verificabili, le rubriche, che una buona risposta deve soddisfare.

Convalida della rubrica: dopo che il modello genera una risposta, il servizio la valuta in base a ogni rubrica, fornendo un verdetto chiaro

PassoFaile una motivazione.

Il risultato finale è un tasso di superamento aggregato e una suddivisione dettagliata delle rubriche superate dal modello, che ti fornisce insight utili per diagnosticare i problemi e misurare i miglioramenti.

Passando da punteggi soggettivi di alto livello a risultati di test granulari e oggettivi, puoi adottare un ciclo di sviluppo basato sulla valutazione e integrare le best practice di ingegneria del software nel processo di creazione di applicazioni di AI generativa.

Esempio di valutazione delle rubriche

Per capire come Gen AI evaluation service genera e utilizza le rubriche, considera questo esempio:

Prompt utente: Write a four-sentence summary of the provided article about renewable energy, maintaining an optimistic tone.

Per questo prompt, il passaggio di generazione della rubrica potrebbe produrre le seguenti rubriche:

Griglia 1: la risposta è un riepilogo dell'articolo fornito.

Rubrica 2: la risposta contiene esattamente quattro frasi.

Griglia 3: la risposta mantiene un tono ottimistico.

Il modello potrebbe produrre la seguente risposta: The article highlights significant growth in solar and wind power. These advancements are making clean energy more affordable. The future looks bright for renewables. However, the report also notes challenges with grid infrastructure.

Durante la convalida della rubrica, Gen AI evaluation service valuta la risposta in base a ogni rubrica:

Griglia 1: la risposta è un riepilogo dell'articolo fornito.

Esito:

PassMotivo: la risposta riassume con precisione i punti principali.

Rubrica 2: la risposta contiene esattamente quattro frasi.

Esito:

PassMotivo: la risposta è composta da quattro frasi distinte

Griglia 3: la risposta mantiene un tono ottimistico.

Esito:

FailMotivo: l'ultima frase introduce un punto negativo, che sminuisce il tono ottimistico.

Il tasso di superamento finale per questa risposta è del 66,7%. Per confrontare due modelli, puoi valutare le loro risposte rispetto allo stesso insieme di test generati e confrontare i tassi di superamento complessivi.

Flusso di lavoro di valutazione

Per completare una valutazione, in genere è necessario seguire i seguenti passaggi:

Crea un set di dati di valutazione: assembla un set di dati di istanze di prompt che riflettano il tuo caso d'uso specifico. Puoi includere risposte di riferimento (dati empirici reali) se prevedi di utilizzare metriche basate sul calcolo.

Definisci le metriche di valutazione: scegli le metriche che vuoi utilizzare per misurare il rendimento del modello. L'SDK supporta tutti i tipi di metrica, mentre la console supporta le rubriche adattive.

Genera risposte del modello: seleziona uno o più modelli per generare risposte per il tuo set di dati. L'SDK supporta qualsiasi modello richiamabile tramite

LiteLLM, mentre la console supporta i modelli Google Gemini.Esegui la valutazione: esegui il job di valutazione, che valuta le risposte di ogni modello in base alle metriche selezionate.

Interpreta i risultati: esamina i punteggi aggregati e le singole risposte per analizzare il rendimento del modello.

Iniziare a utilizzare le valutazioni

Puoi iniziare a utilizzare le valutazioni tramite la console.

In alternativa, il seguente codice mostra come completare una valutazione con il client GenAI nell'SDK Vertex AI:

from vertexai import Client

from vertexai import types

import pandas as pd

client = Client(project=PROJECT_ID, location=LOCATION)

# Create an evaluation dataset

prompts_df = pd.DataFrame({

"prompt": [

"Write a simple story about a dinosaur",

"Generate a poem about Vertex AI",

],

})

# Get responses from one or multiple models

eval_dataset = client.evals.run_inference(model="gemini-2.5-flash", src=prompts_df)

# Define the evaluation metrics and run the evaluation job

eval_result = client.evals.evaluate(

dataset=eval_dataset,

metrics=[types.RubricMetric.GENERAL_QUALITY]

)

# View the evaluation results

eval_result.show()

Gen AI evaluation service offre due interfacce SDK:

Client GenAI nell'SDK Vertex AI (consigliato) (anteprima)

from vertexai import clientIl client GenAI è l'interfaccia più recente e consigliata per la valutazione, a cui si accede tramite la classe client unificata. Supporta tutti i metodi di valutazione ed è progettato per i flussi di lavoro che includono il confronto dei modelli, la visualizzazione nel notebook e gli approfondimenti per la personalizzazione dei modelli.

Modulo di valutazione nell'SDK Vertex AI (GA)

from vertexai.evaluation import EvalTaskIl modulo di valutazione è l'interfaccia precedente, mantenuta per la compatibilità con le versioni precedenti con i flussi di lavoro esistenti, ma non più in fase di sviluppo attivo. Vi si accede tramite il corso

EvalTask. Questo metodo supporta le metriche standard basate su LLM-as-a-judge e sul calcolo, ma non supporta metodi di valutazione più recenti come le rubriche adattive.

Aree geografiche supportate

Per Gen AI evaluation service sono supportate le seguenti regioni:

Iowa (

us-central1)Virginia del Nord (

us-east4)Oregon (

us-west1)Las Vegas, Nevada (

us-west4)Belgio (

europe-west1)Paesi Bassi (

europe-west4)Parigi, Francia (

europe-west9)