Der GenAI Evaluation Service bietet Tools auf Unternehmensniveau für die objektive, datengestützte Bewertung von generativen KI-Modellen. Es unterstützt und informiert über eine Reihe von Entwicklungsaufgaben wie Modellmigrationen, Bearbeitung von Prompts und Feinabstimmung.

Funktionen des Bewertungsdienstes basierend auf generativer KI

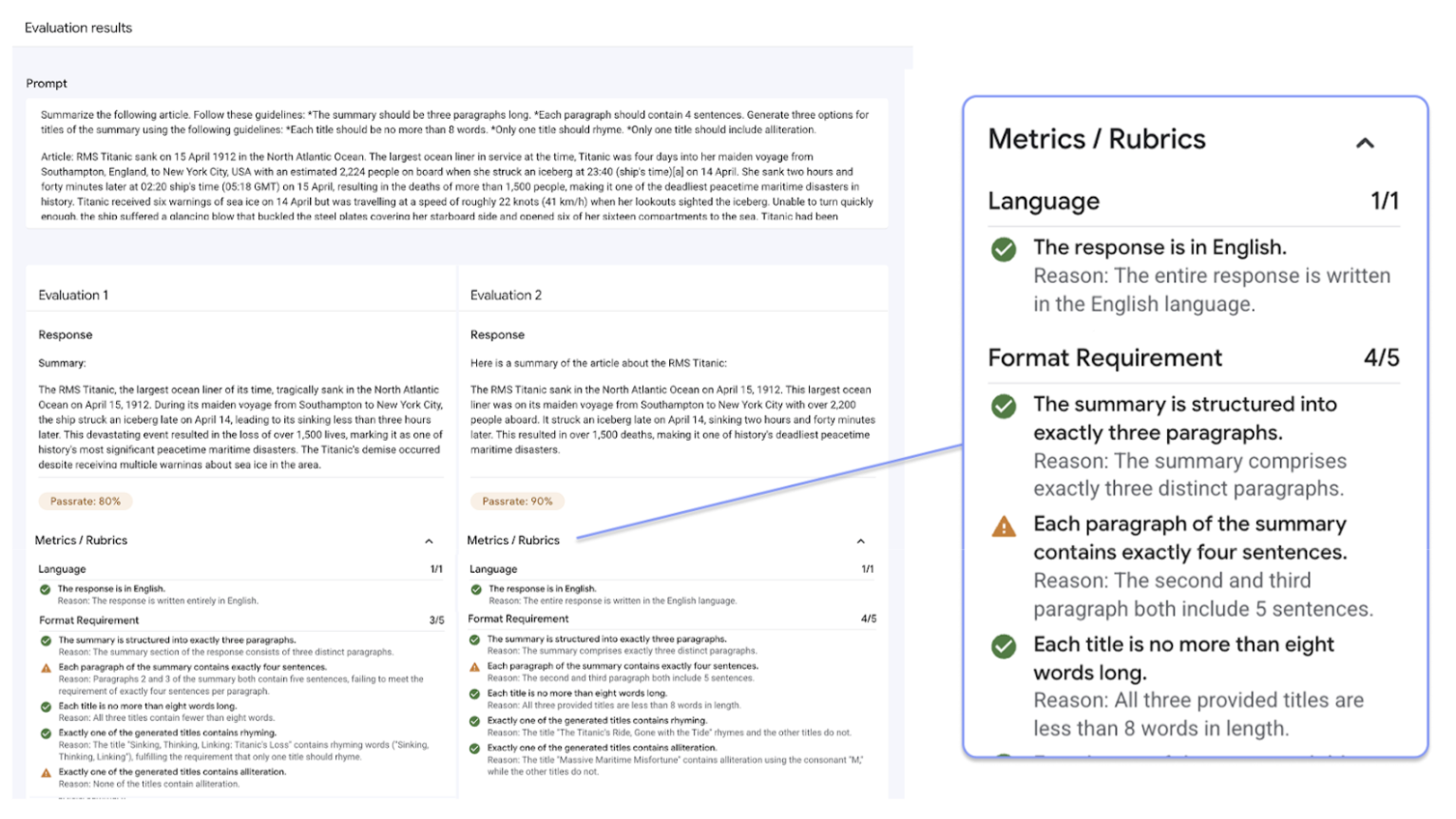

Das entscheidende Merkmal des Gen AI Evaluation Service ist die Möglichkeit, adaptive Bewertungsschemas zu verwenden. Das sind maßgeschneiderte Tests, die für jeden einzelnen Prompt festlegen, ob er bestanden oder nicht bestanden wurde. Bewertungsschemas ähneln Unittests in der Softwareentwicklung und zielen darauf ab, die Modellleistung bei einer Vielzahl von Aufgaben zu verbessern.

Der Gen AI Evaluation Service unterstützt die folgenden gängigen Bewertungsmethoden:

Adaptive Rubriken (empfohlen): Generiert für jeden einzelnen Prompt in Ihrem Dataset einen eindeutigen Satz von Rubriken für „Bestanden“ oder „Nicht bestanden“.

Statische Rubriken: Wenden Sie für alle Prompts einen festen Satz von Bewertungskriterien an.

Berechnungsbasierte Messwerte: Verwenden Sie deterministische Algorithmen wie

ROUGEoderBLEU, wenn eine Ground Truth verfügbar ist.Benutzerdefinierte Funktionen: Sie können Ihre eigene Auswertungslogik in Python für spezielle Anforderungen definieren.

Generierung von Bewertungs-Datasets

Sie haben folgende Möglichkeiten, ein Auswertungs-Dataset zu erstellen:

Laden Sie eine Datei mit vollständigen Prompt-Instanzen hoch oder stellen Sie eine Prompt-Vorlage zusammen mit einer entsprechenden Datei mit Variablenwerten bereit, um die vollständigen Prompts zu generieren.

Direkt aus Produktionslogs Stichproben ziehen, um die tatsächliche Nutzung Ihres Modells zu bewerten.

Synthetische Daten generieren, um eine große Anzahl konsistenter Beispiele für eine beliebige Promptvorlage zu erstellen.

Unterstützte Schnittstellen

Sie können Ihre Auswertungen über die folgenden Schnittstellen definieren und ausführen:

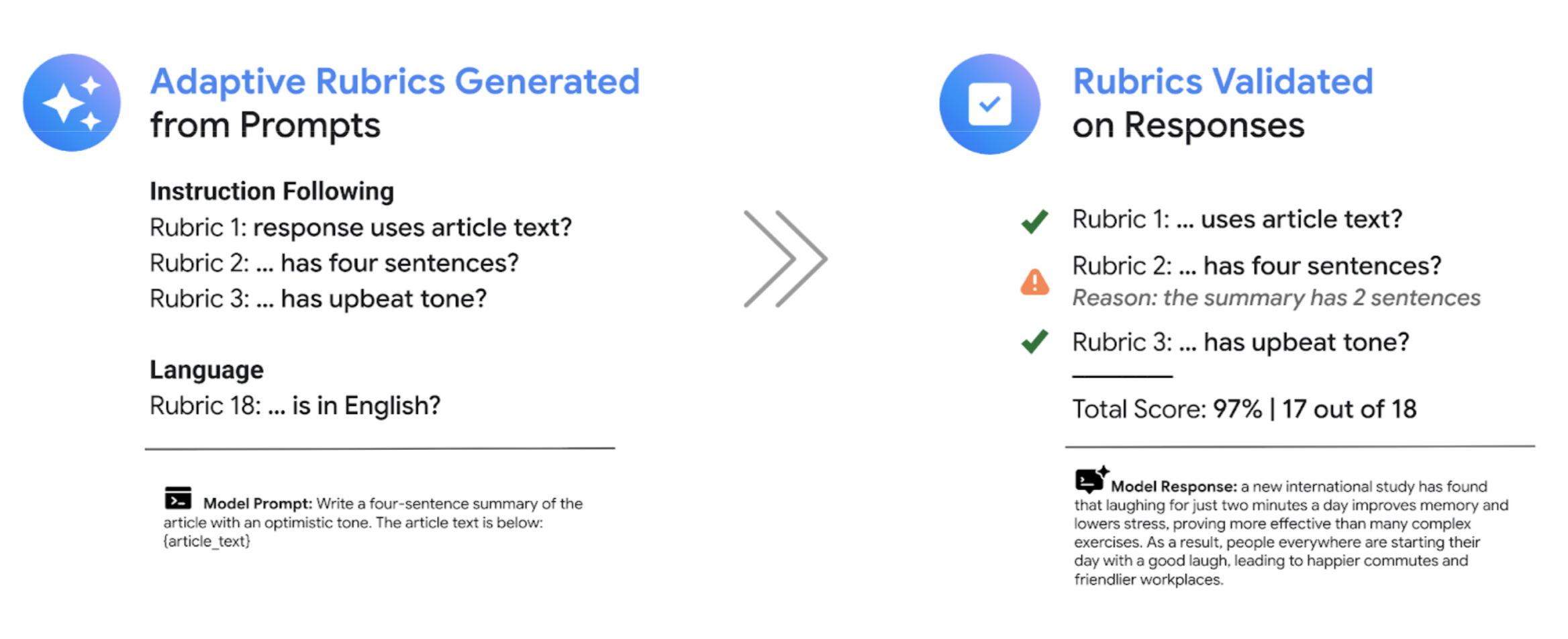

Google Cloud -Konsole: Eine Web-UI mit einem geführten End-to-End-Workflow. Datasets verwalten, Auswertungen durchführen und interaktive Berichte und Visualisierungen analysieren Weitere Informationen finden Sie unter Bewertung mit der Console durchführen.

Python SDK: Sie können Bewertungen programmatisch ausführen und nebeneinanderliegende Modellvergleiche direkt in Ihrer Colab- oder Jupyter-Umgebung rendern. Weitere Informationen finden Sie unter Bewertung mit dem GenAI-Client im Vertex AI SDK durchführen.

Anwendungsfälle

Mit dem Gen AI Evaluation Service können Sie sehen, wie ein Modell bei Ihren spezifischen Aufgaben und anhand Ihrer eigenen Kriterien abschneidet. So erhalten Sie wertvolle Informationen, die nicht aus öffentlichen Bestenlisten und allgemeinen Benchmarks abgeleitet werden können. Dies unterstützt wichtige Entwicklungsaufgaben, darunter:

Modellmigrationen: Vergleichen Sie Modellversionen, um Verhaltensunterschiede zu erkennen und Ihre Prompts und Einstellungen entsprechend anzupassen.

Bestes Modell finden: Führen Sie direkte Vergleiche von Google- und Drittanbietermodellen für Ihre Daten durch, um eine Leistungs-Baseline zu erstellen und das beste Modell für Ihren Anwendungsfall zu ermitteln.

Prompt-Optimierung: Nutzen Sie die Ergebnisse der Auswertung, um Ihre Anpassungsbemühungen zu steuern. Wenn Sie eine Bewertung noch einmal ausführen, entsteht eine enge Feedbackschleife, die sofortiges, quantifizierbares Feedback zu Ihren Änderungen liefert.

Modelloptimierung: Bewerten Sie die Qualität eines optimierten Modells, indem Sie bei jedem Lauf konsistente Bewertungskriterien anwenden.

Bewertungen mit adaptiven Bewertungsschemas

Adaptive Rubriken sind die empfohlene Methode für die meisten Anwendungsfälle für die Bewertung und in der Regel der schnellste Weg, um mit der Bewertung zu beginnen.

Anstatt wie die meisten LLM-as-a-Judge-Systeme eine allgemeine Reihe von Bewertungsrubriken zu verwenden, generiert das testgetriebene Bewertungs-Framework adaptiv eine eindeutige Reihe von Rubriken für „Bestanden“ oder „Nicht bestanden“ für jeden einzelnen Prompt in Ihrem Dataset. So wird sichergestellt, dass jede Bewertung für die jeweilige Aufgabe relevant ist.

Der Bewertungsprozess für jeden Prompt umfasst zwei Schritte:

Erstellung von Rubriken: Der Dienst analysiert zuerst Ihren Prompt und generiert eine Liste mit spezifischen, überprüfbaren Tests – den Rubriken –, die eine gute Antwort erfüllen sollte.

Rubric-Validierung: Nachdem Ihr Modell eine Antwort generiert hat, bewertet der Dienst die Antwort anhand der einzelnen Rubriken und liefert ein klares

Pass- oderFail-Ergebnis sowie eine Begründung.

Das Endergebnis ist eine aggregierte Bestehensrate und eine detaillierte Aufschlüsselung der Rubriken, die das Modell bestanden hat. So erhalten Sie umsetzbare Informationen, um Probleme zu diagnostizieren und Verbesserungen zu messen.

Wenn Sie von allgemeinen, subjektiven Bewertungen zu detaillierten, objektiven Testergebnissen wechseln, können Sie einen bewertungsgesteuerten Entwicklungszyklus einführen und die Best Practices der Softwareentwicklung in den Prozess der Entwicklung generativer KI-Anwendungen einbringen.

Beispiel für die Bewertung von Rubrics

Um zu verstehen, wie der Gen AI Evaluation Service Rubriken generiert und verwendet, sehen Sie sich dieses Beispiel an:

Nutzer-Prompt: Write a four-sentence summary of the provided article about renewable energy, maintaining an optimistic tone.

Für diesen Prompt könnten im Schritt Rubrikgenerierung die folgenden Rubriken erstellt werden:

Bewertungsschema 1: Die Antwort ist eine Zusammenfassung des bereitgestellten Artikels.

Rubrik 2: Die Antwort enthält genau vier Sätze.

Rubrik 3: Die Antwort ist optimistisch formuliert.

Ihr Modell gibt möglicherweise die folgende Antwort aus: The article highlights significant growth in solar and wind power. These advancements are making clean energy more affordable. The future looks bright for renewables. However, the report also notes challenges with grid infrastructure.

Bei der Rubrikvalidierung bewertet der Gen AI Evaluation Service die Antwort anhand jeder Rubrik:

Bewertungsschema 1: Die Antwort ist eine Zusammenfassung des bereitgestellten Artikels.

Urteil:

PassGrund: In der Antwort werden die wichtigsten Punkte korrekt zusammengefasst.

Rubrik 2: Die Antwort enthält genau vier Sätze.

Urteil:

PassGrund: Die Antwort besteht aus vier unterschiedlichen Sätzen.

Rubrik 3: Die Antwort ist optimistisch formuliert.

Urteil:

FailGrund: Im letzten Satz wird ein negativer Punkt eingeführt, der den optimistischen Ton beeinträchtigt.

Die endgültige Bestehensrate für diese Antwort beträgt 66,7%. Um zwei Modelle zu vergleichen, können Sie ihre Antworten anhand derselben Gruppe generierter Tests bewerten und ihre allgemeinen Bestehensraten vergleichen.

Bewertungs-Workflow

Für eine Bewertung sind in der Regel die folgenden Schritte erforderlich:

Bewertungs-Dataset erstellen: Stellen Sie ein Dataset mit Prompt-Instanzen zusammen, die Ihren spezifischen Anwendungsfall widerspiegeln. Wenn Sie berechnungsbasierte Messwerte verwenden möchten, können Sie Referenzantworten (Ground Truth) einfügen.

Bewertungsmesswerte definieren: Wählen Sie die Messwerte aus, mit denen Sie die Modellleistung messen möchten. Das SDK unterstützt alle Messwerttypen, während die Console adaptive Rubriken unterstützt.

Modellantworten generieren: Wählen Sie ein oder mehrere Modelle aus, um Antworten für Ihr Dataset zu generieren. Das SDK unterstützt alle Modelle, die über

LiteLLMaufgerufen werden können, während die Console Google Gemini-Modelle unterstützt.Bewertung ausführen: Führen Sie den Bewertungsjob aus, bei dem die Antworten der einzelnen Modelle anhand der ausgewählten Messwerte bewertet werden.

Ergebnisse interpretieren: Sehen Sie sich die aggregierten Werte und einzelnen Antworten an, um die Modellleistung zu analysieren.

Erste Schritte mit Bewertungen

Erste Schritte mit der Console

Alternativ können Sie die Bewertung mit dem GenAI-Client im Vertex AI SDK so abschließen:

from vertexai import Client

from vertexai import types

import pandas as pd

client = Client(project=PROJECT_ID, location=LOCATION)

# Create an evaluation dataset

prompts_df = pd.DataFrame({

"prompt": [

"Write a simple story about a dinosaur",

"Generate a poem about Vertex AI",

],

})

# Get responses from one or multiple models

eval_dataset = client.evals.run_inference(model="gemini-2.5-flash", src=prompts_df)

# Define the evaluation metrics and run the evaluation job

eval_result = client.evals.evaluate(

dataset=eval_dataset,

metrics=[types.RubricMetric.GENERAL_QUALITY]

)

# View the evaluation results

eval_result.show()

Der Gen AI Evaluation Service bietet zwei SDK-Schnittstellen:

GenAI-Client im Vertex AI SDK (Empfohlen) (Vorabversion)

from vertexai import clientDer GenAI-Client ist die neuere, empfohlene Schnittstelle für die Bewertung, auf die über die einheitliche Client-Klasse zugegriffen wird. Es unterstützt alle Bewertungsmethoden und ist für Workflows konzipiert, die Modellvergleich, In-Notebook-Visualisierung und Statistiken für die Modellanpassung umfassen.

Bewertungsmodul im Vertex AI SDK (GA)

from vertexai.evaluation import EvalTaskDas Auswertungsmodul ist die ältere Benutzeroberfläche, die zur Abwärtskompatibilität mit bestehenden Workflows beibehalten wird, aber nicht mehr aktiv weiterentwickelt wird. Der Zugriff erfolgt über die Klasse

EvalTask. Diese Methode unterstützt Standard-LLM-as-a-Judge- und rechenbasierte Messwerte, aber keine neueren Bewertungsmethoden wie adaptive Rubriken.

Unterstützte Regionen

Der Gen AI Evaluation Service wird in den folgenden Regionen unterstützt:

Iowa (

us-central1)Virginia (

us-east4)Oregon (

us-west1)Las Vegas, Nevada (

us-west4)Belgien (

europe-west1)Niederlande (

europe-west4)Paris, Frankreich (

europe-west9)